chatgpt专题

vue.js

qt

批量重命名

NAND

powershell

知识蒸馏

终端

iot

美食分享系统

harbor

eureka

恢复显示屏异常显示的方法

skill command

控制浏览器的方式

批量替换

语音小夜灯IC

主从复制

申博

语音信号处理

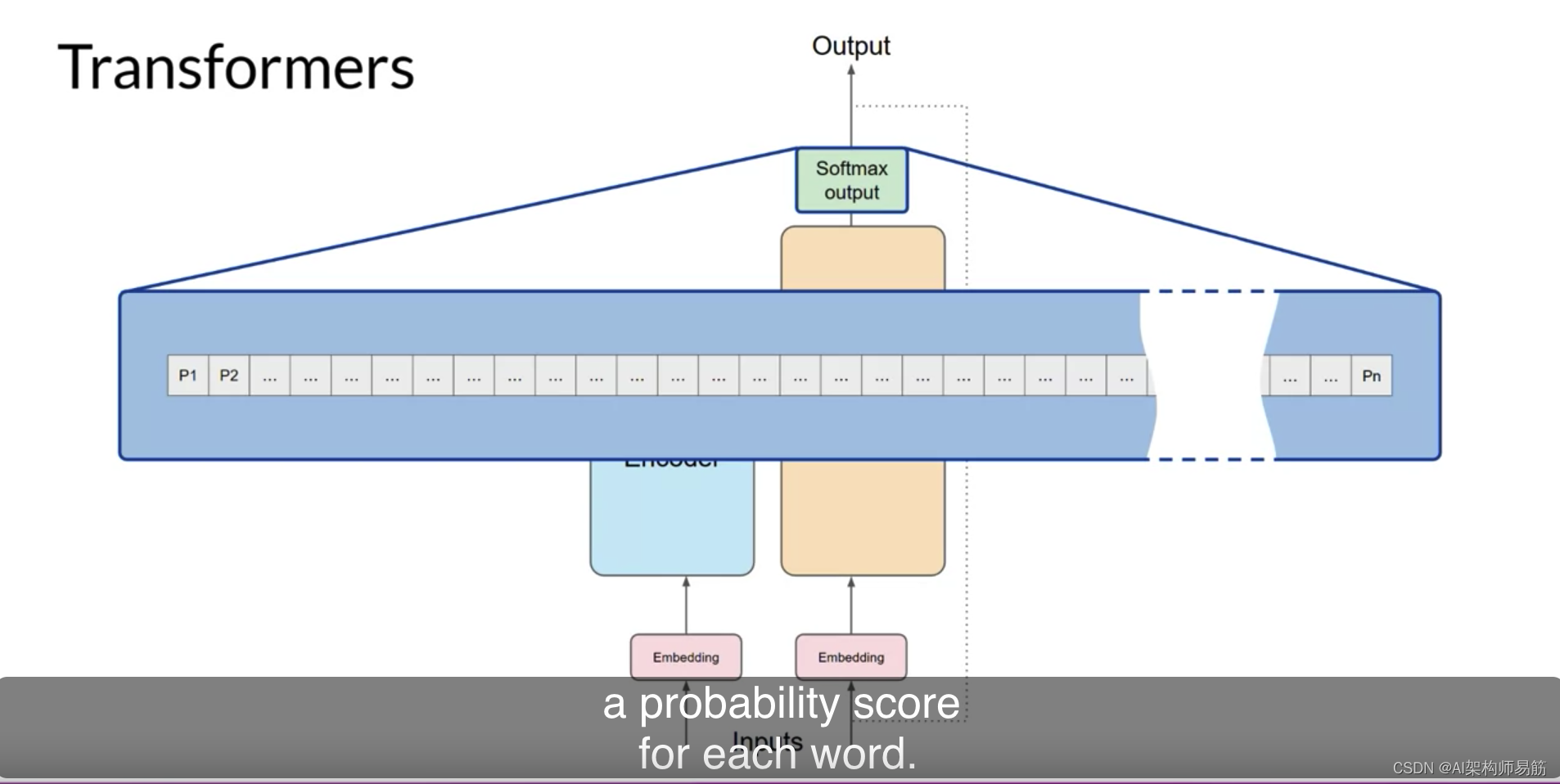

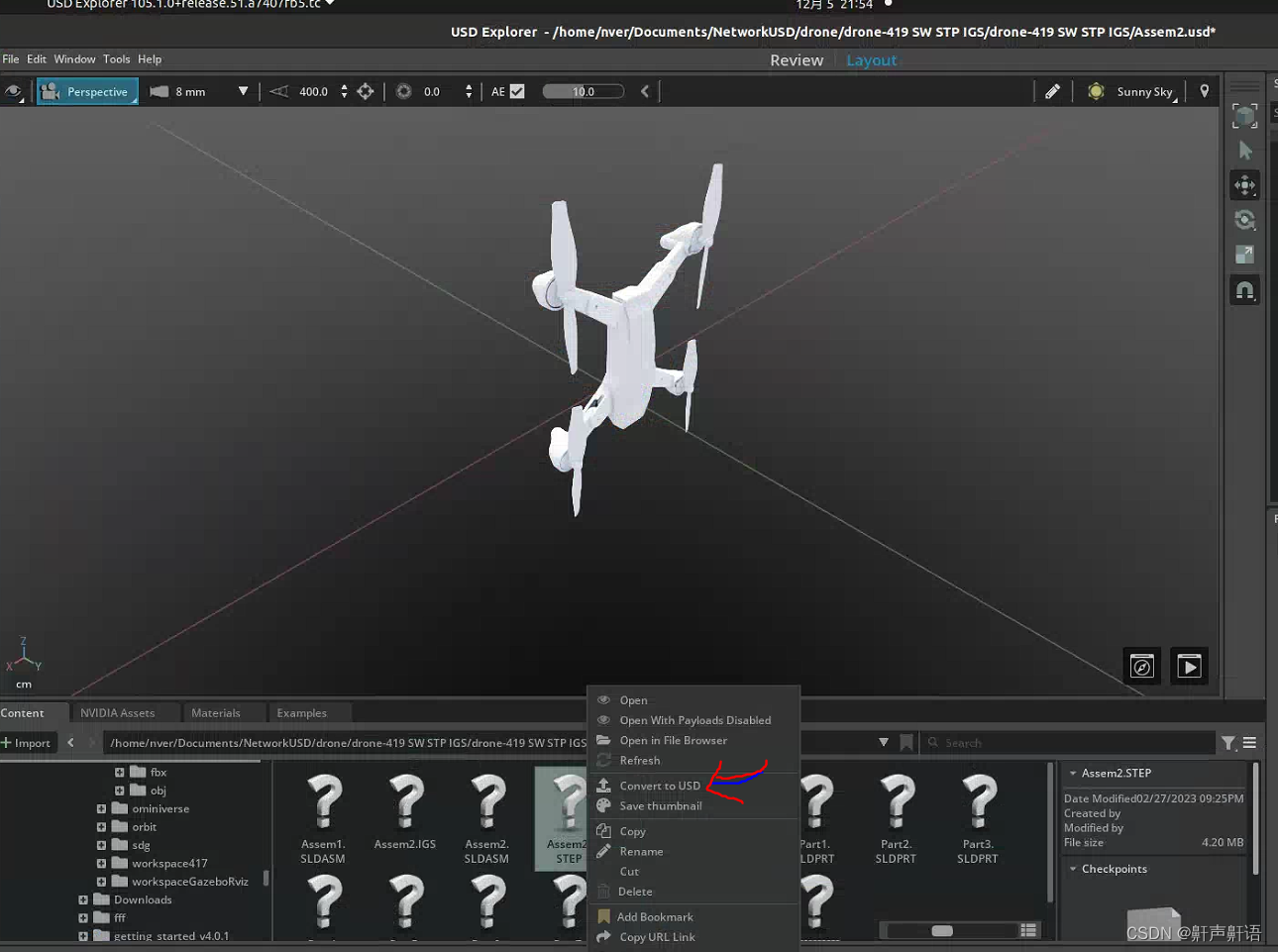

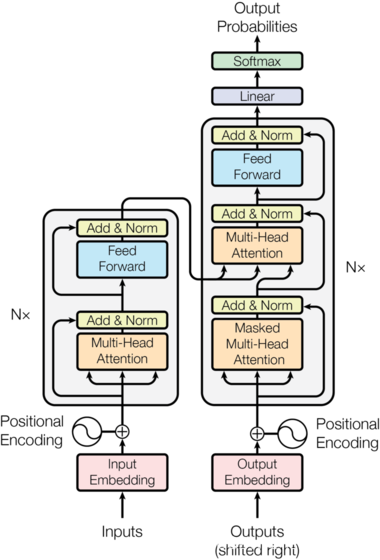

transformer

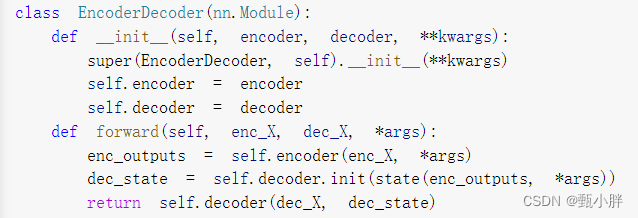

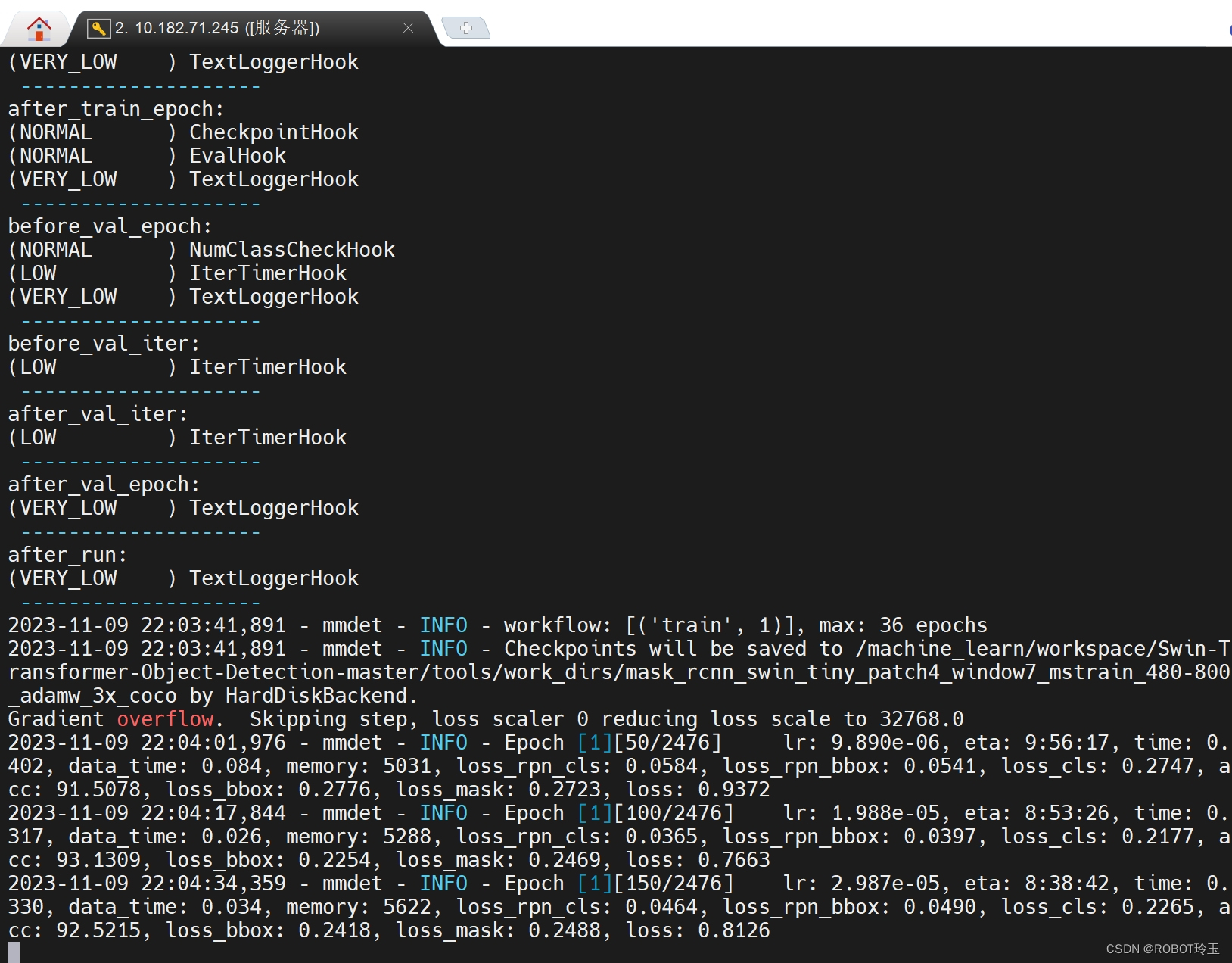

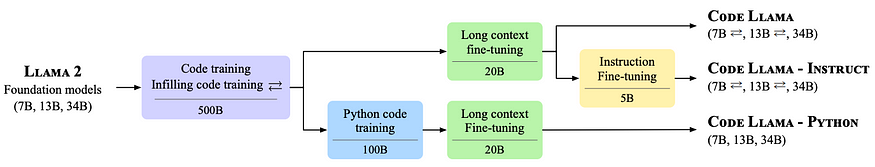

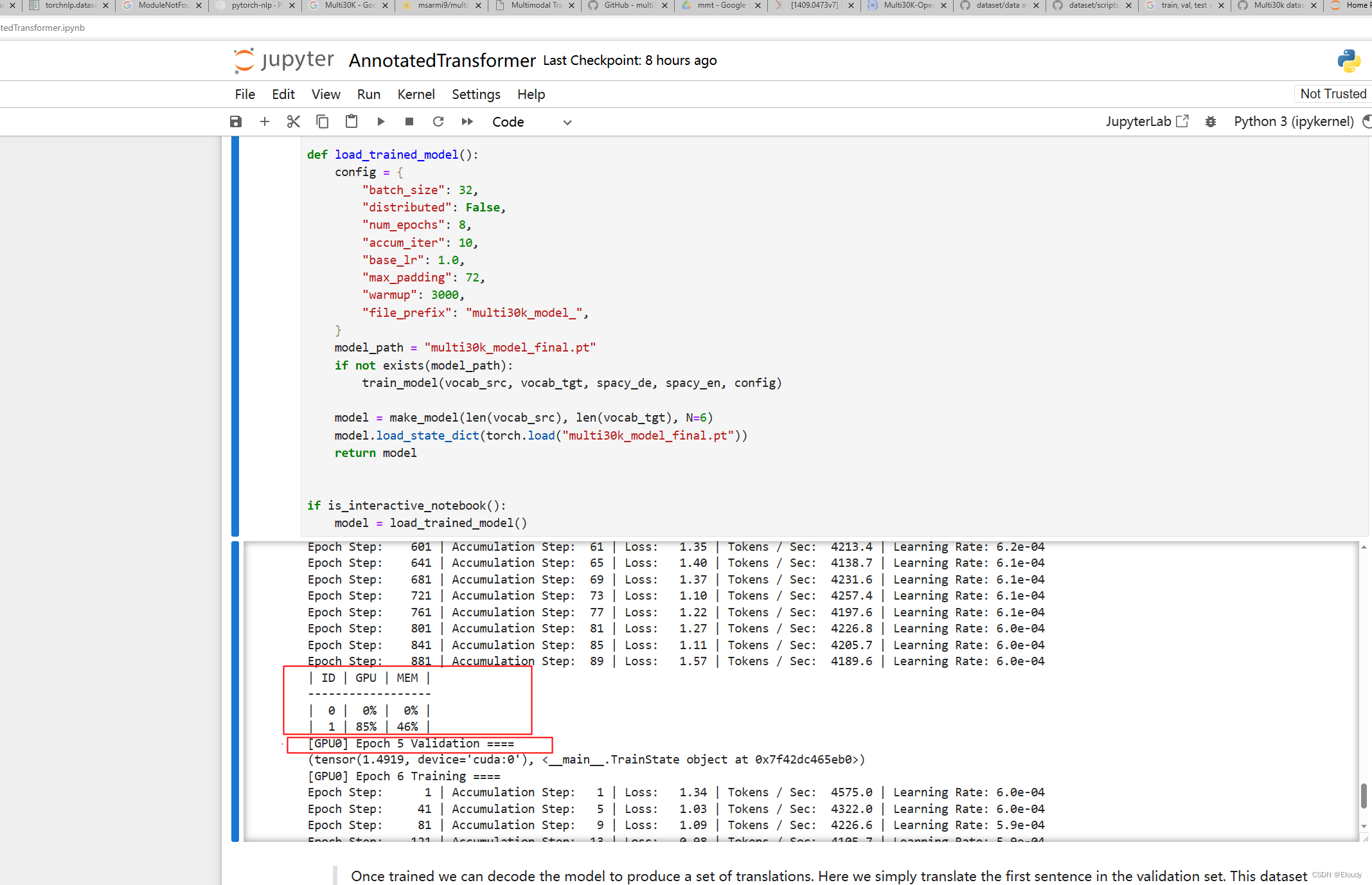

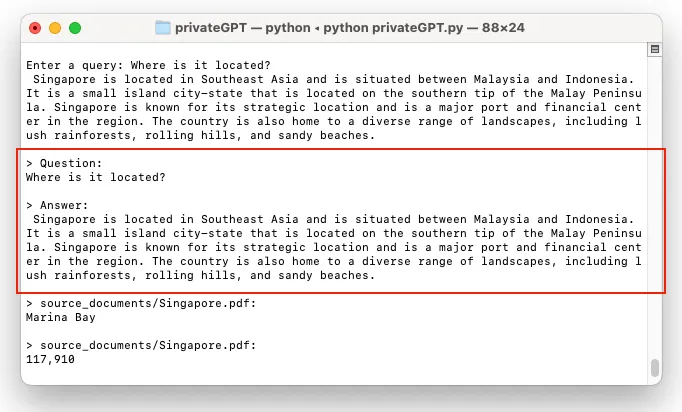

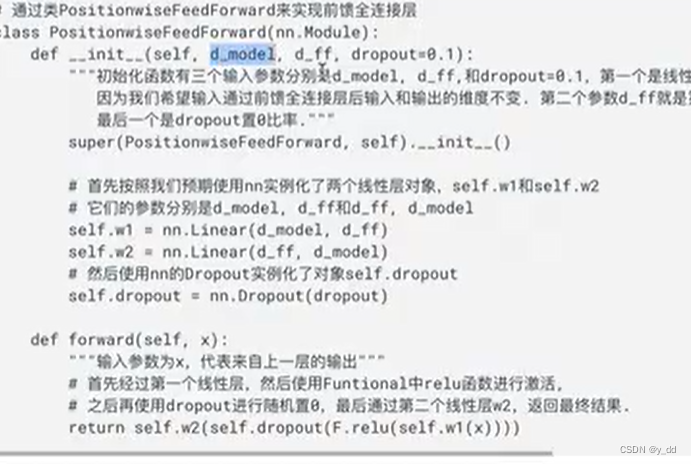

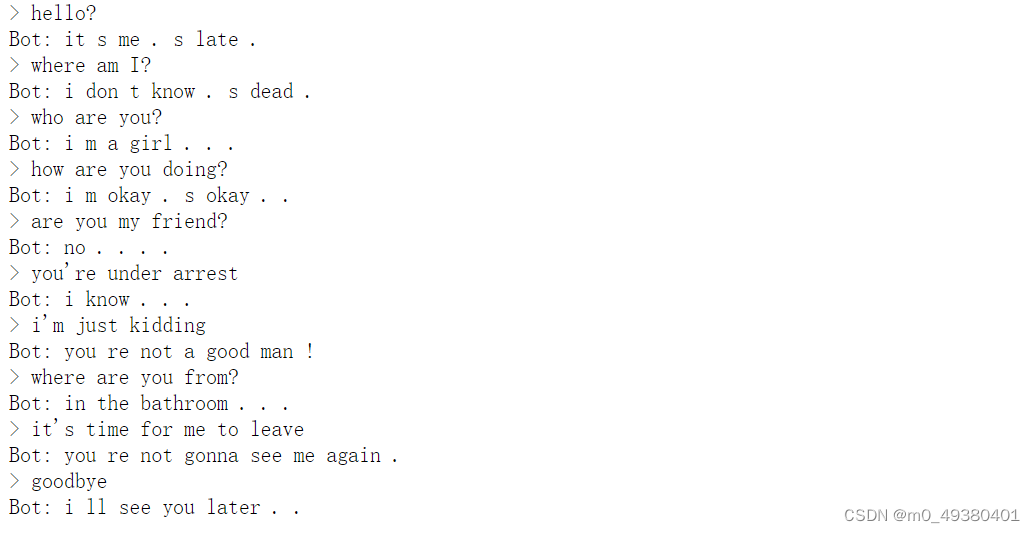

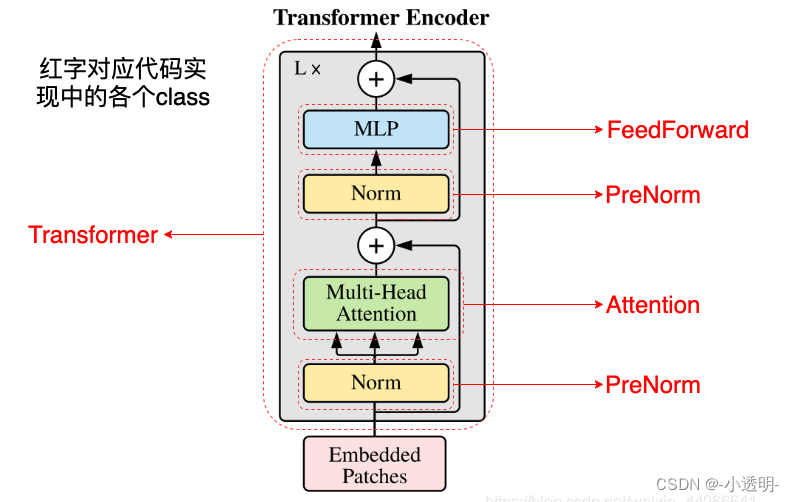

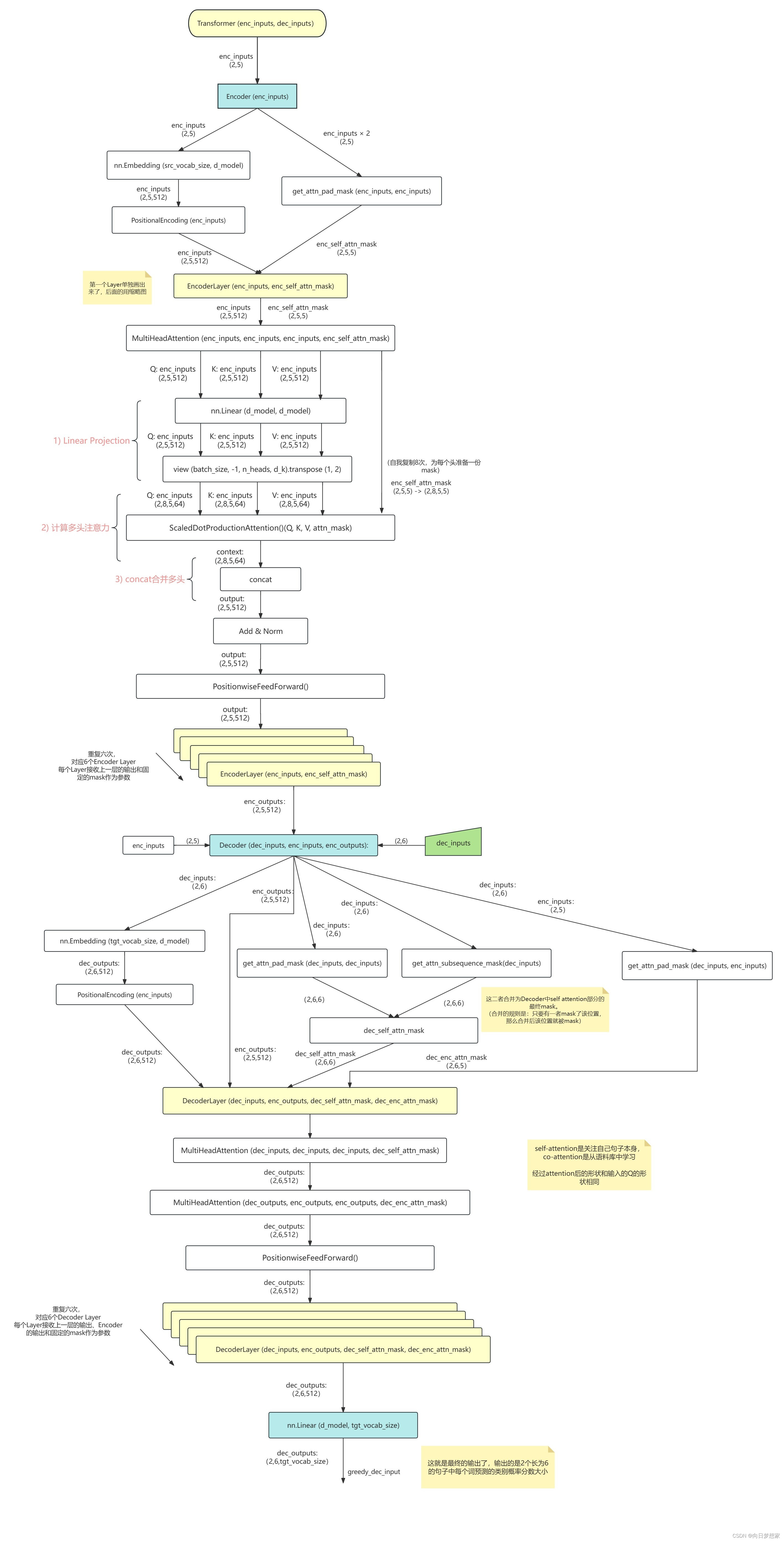

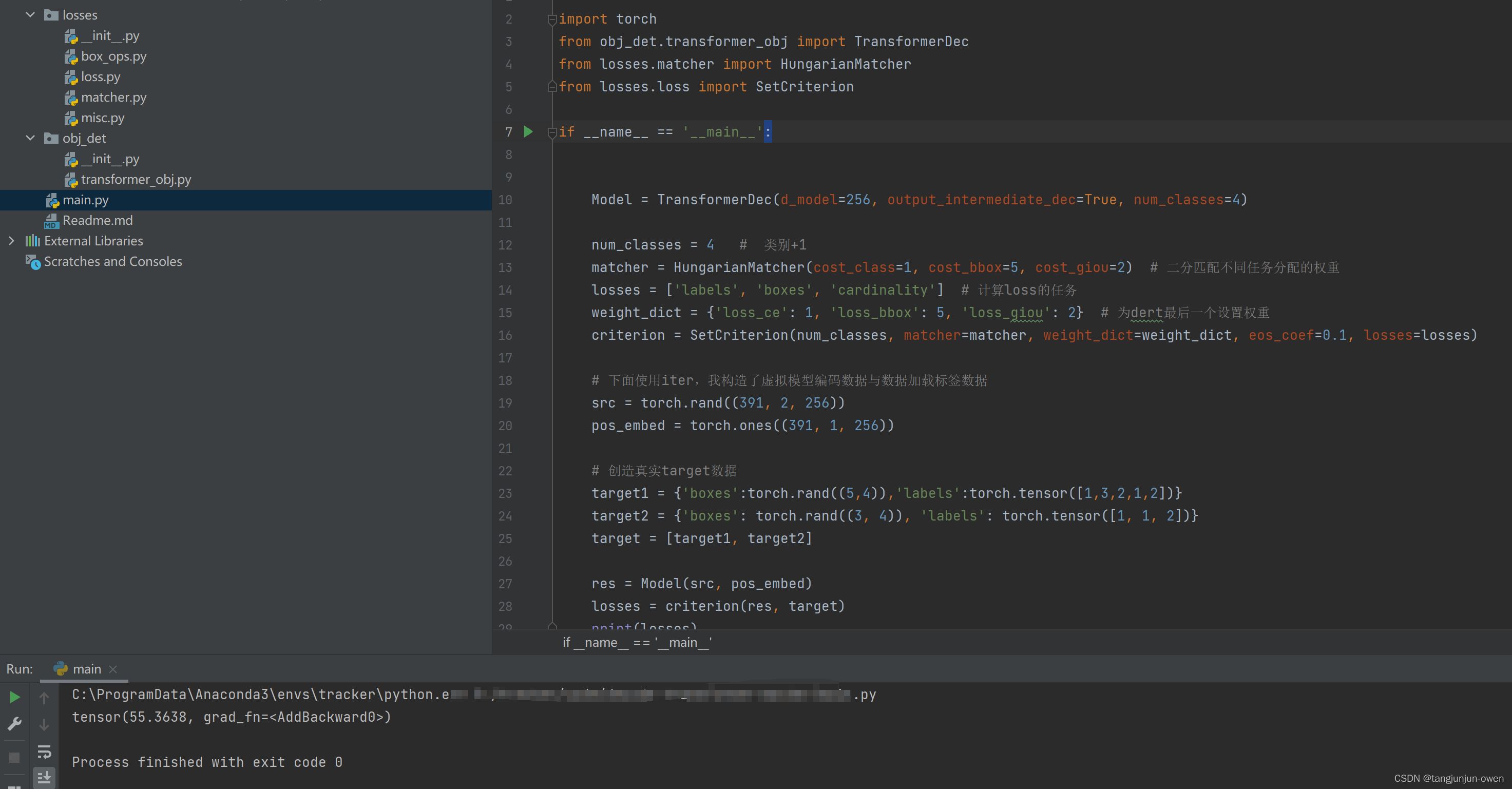

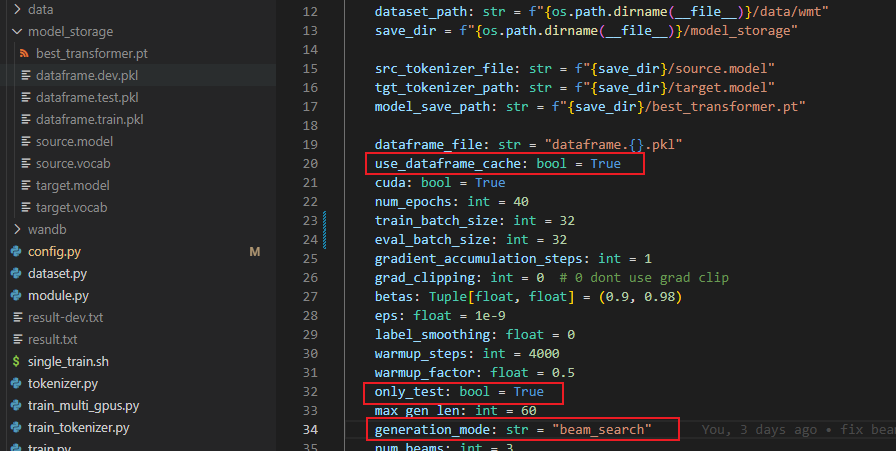

2024/4/11 15:10:07ChatGPT基础组件Transformer的代码实现(纯净版Transformer实现)

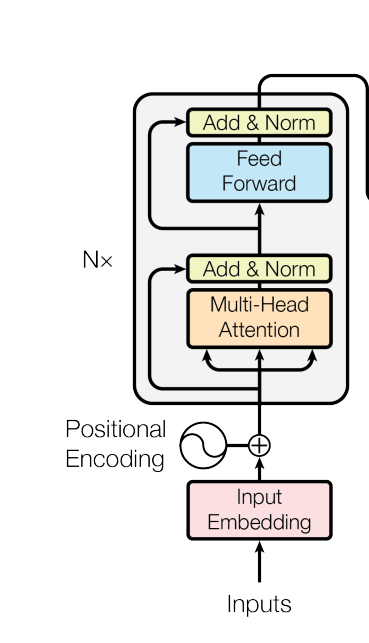

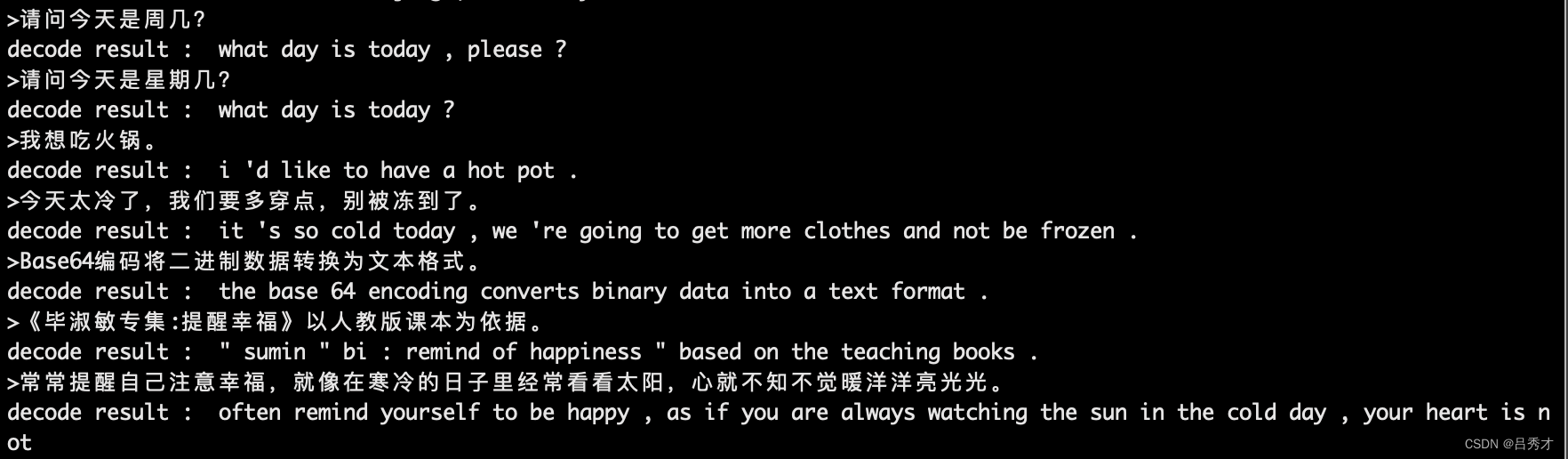

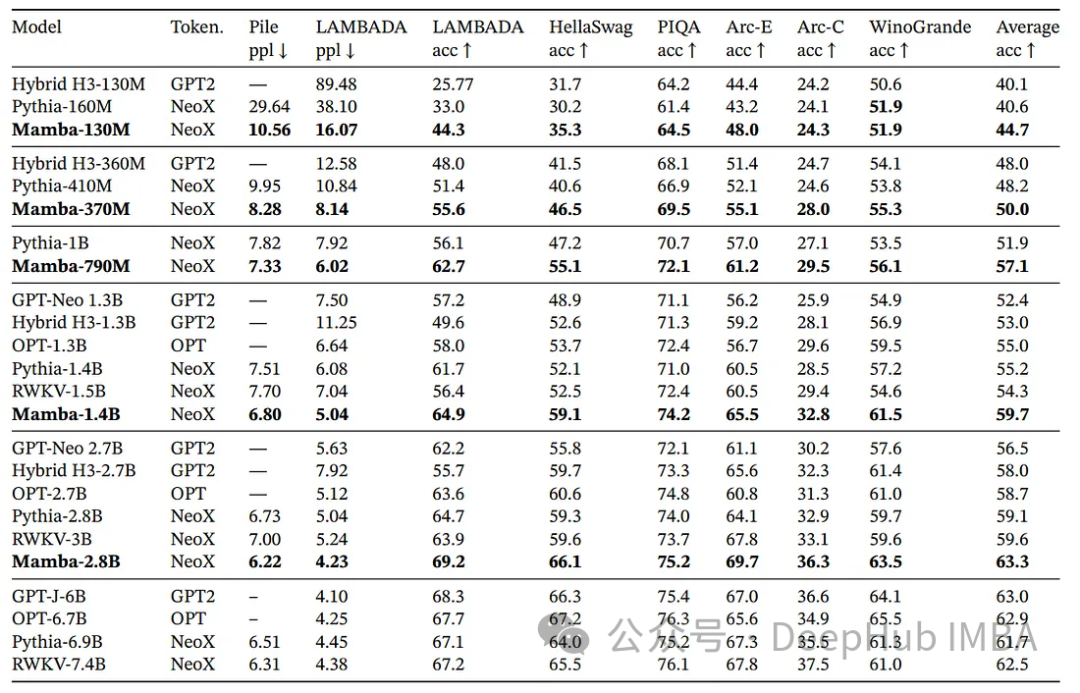

最近ChatGPT大火,其实去年11月份就备受关注了,最近火出圈了,还是这家伙太恐怖了,未来重复性的工作很危险。回归主题,ChatGPT就是由无数个(具体也不知道多少个,哈哈哈哈)Transformer语…

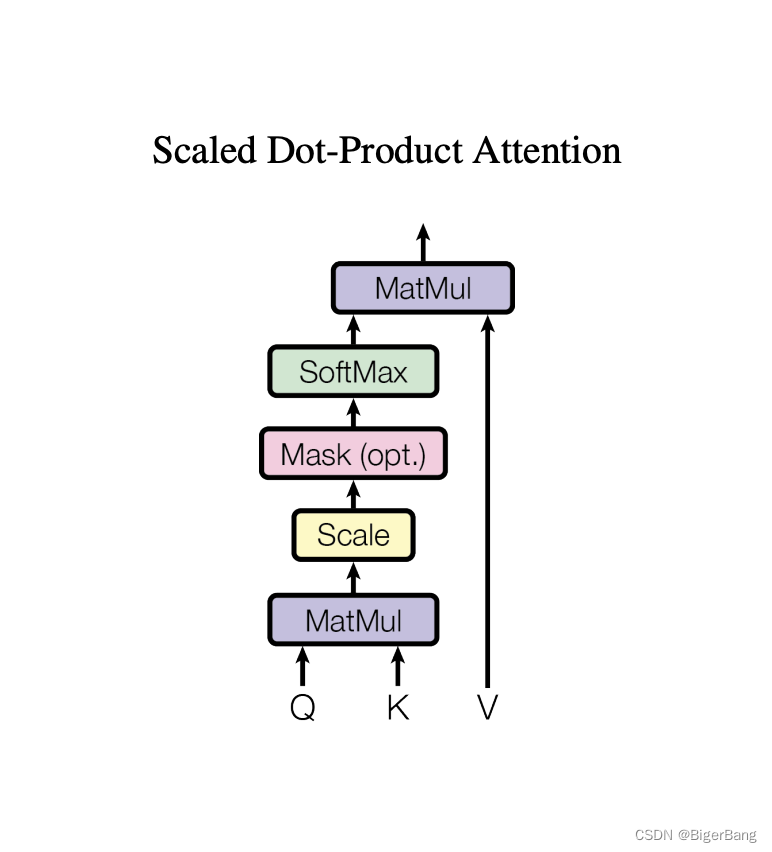

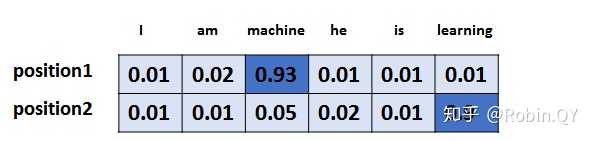

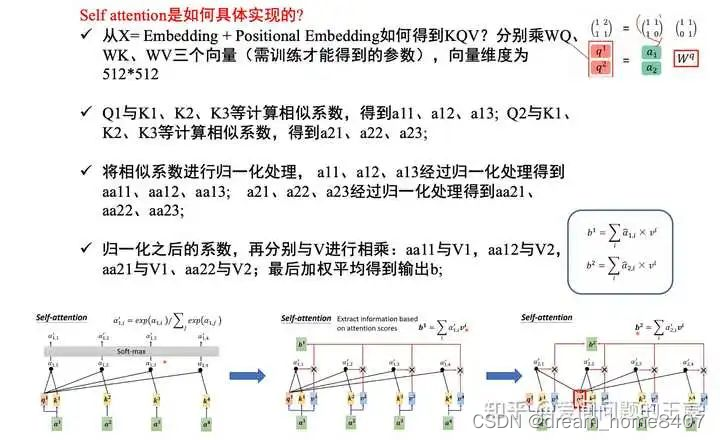

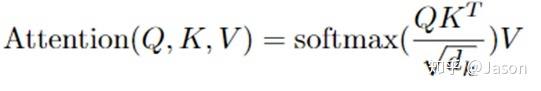

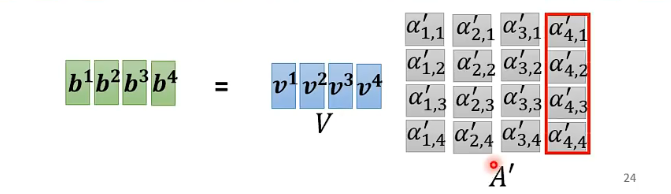

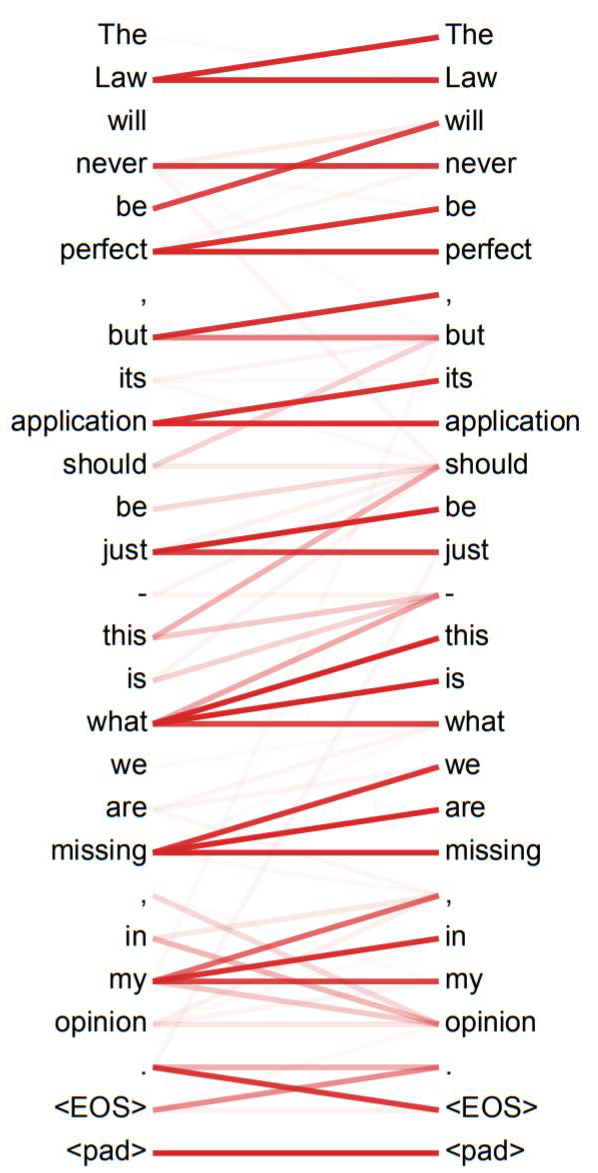

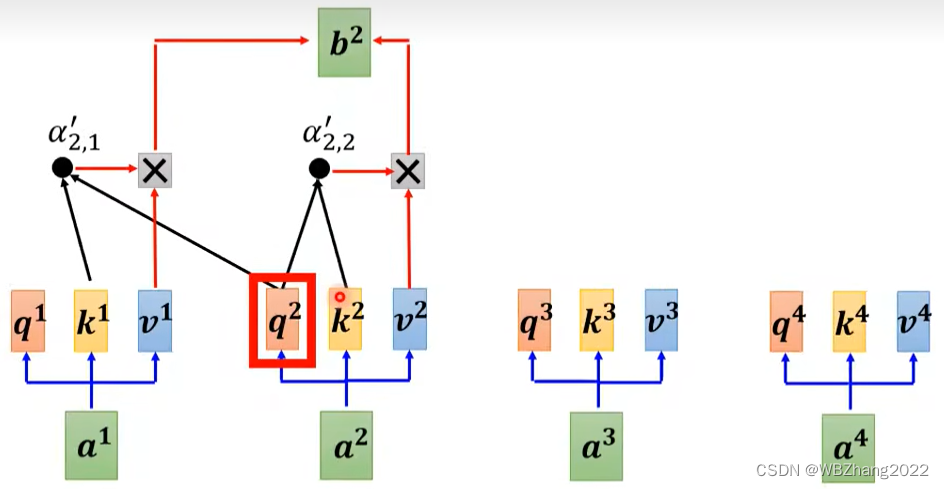

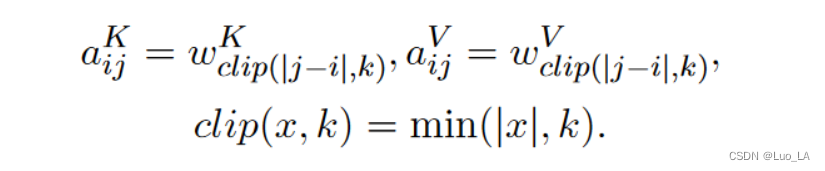

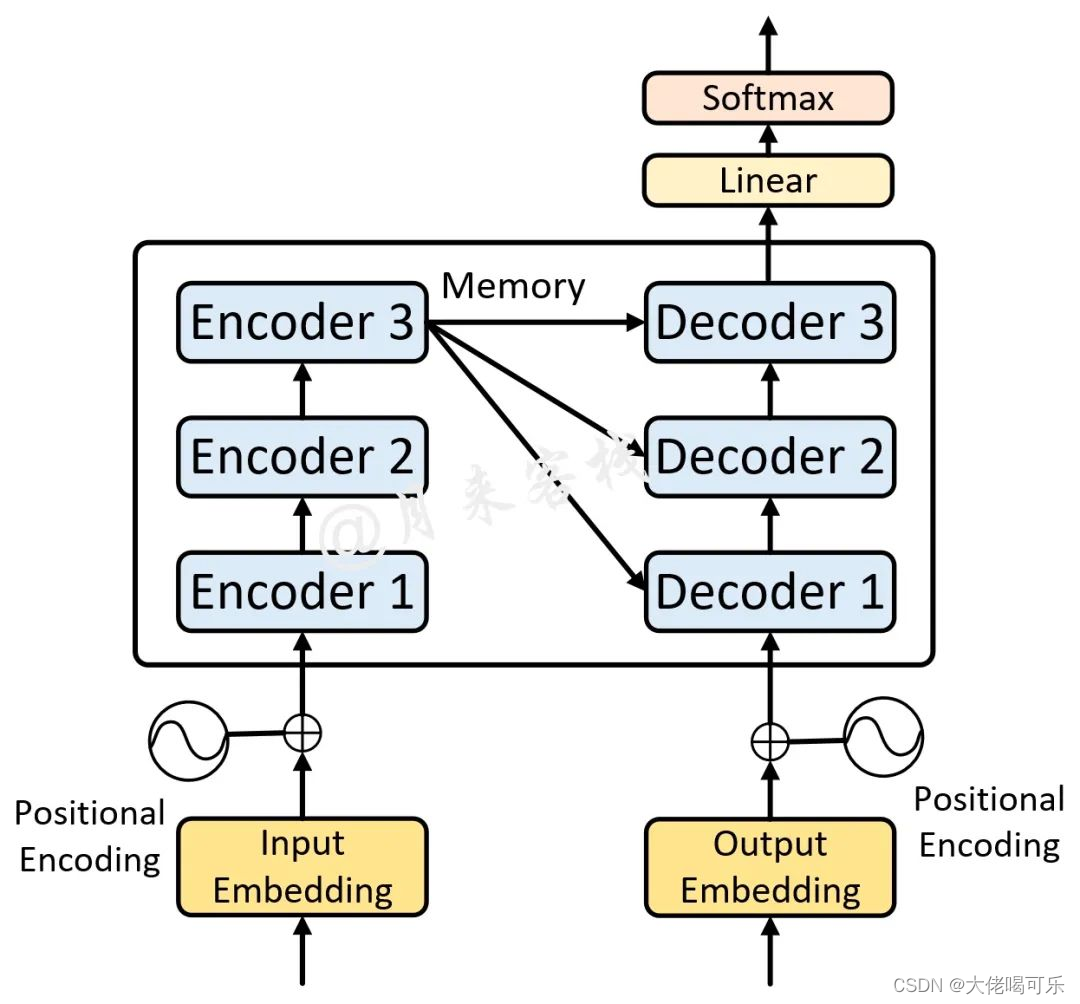

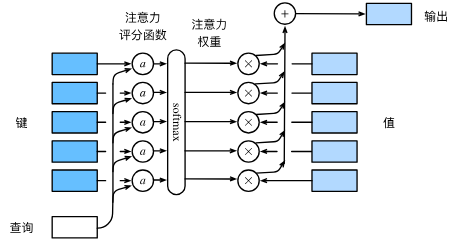

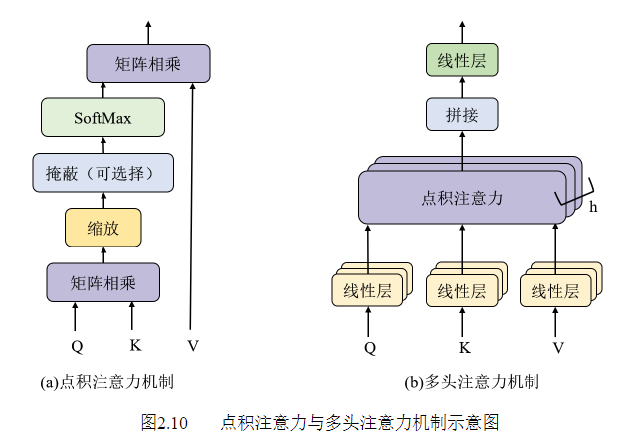

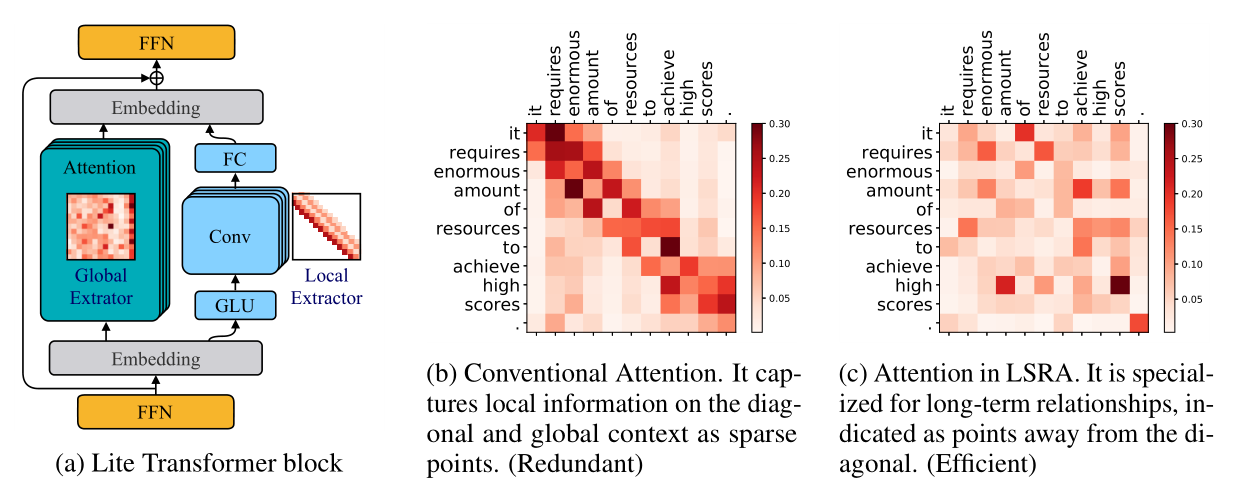

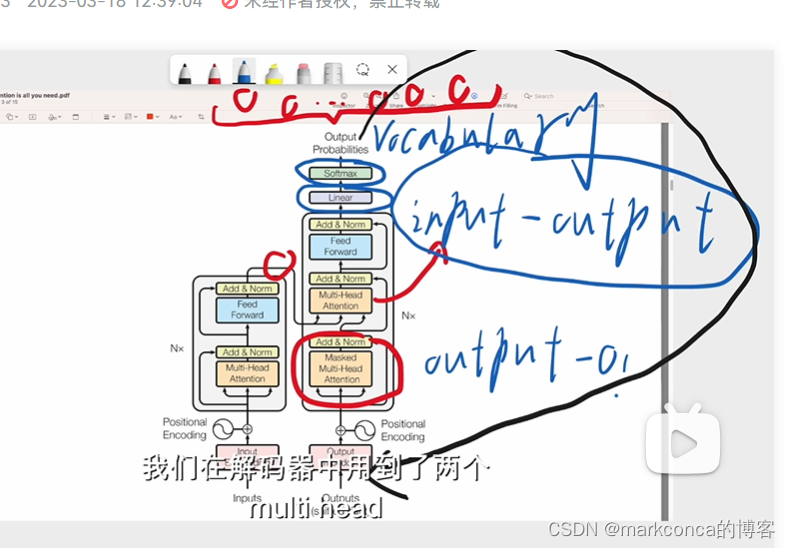

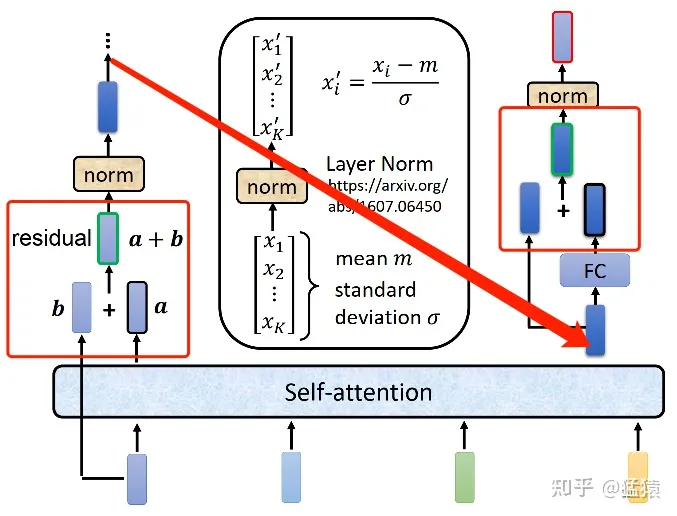

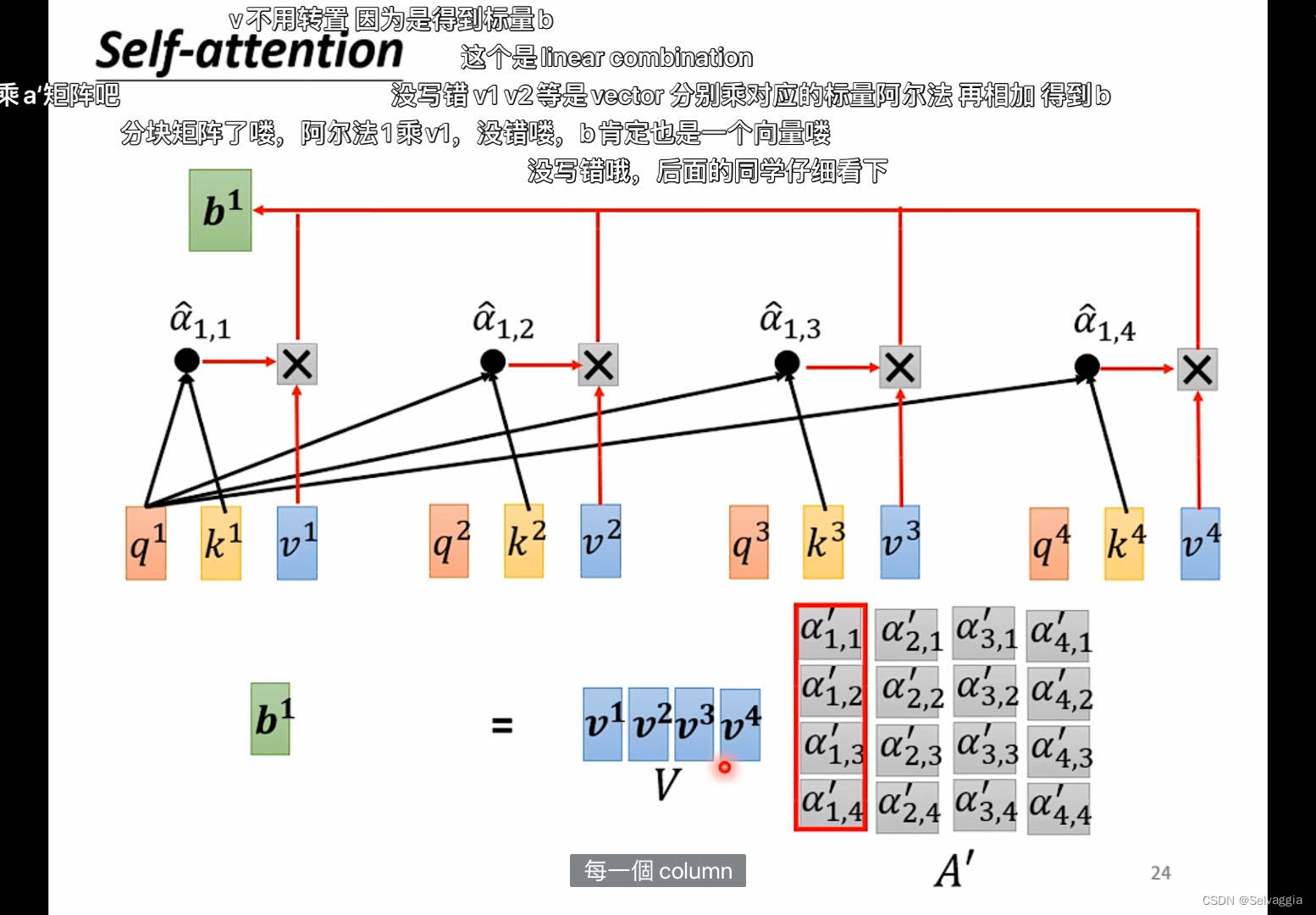

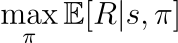

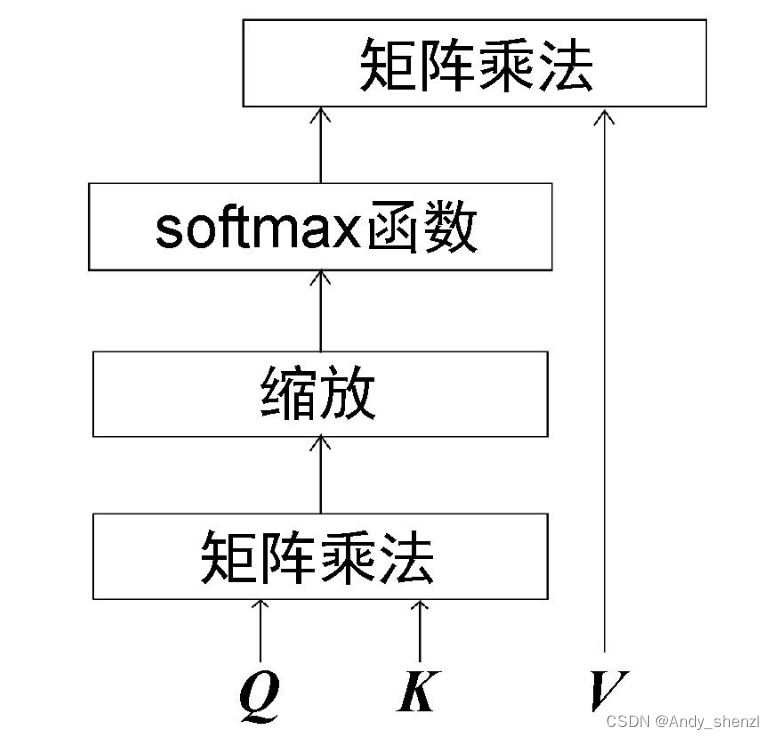

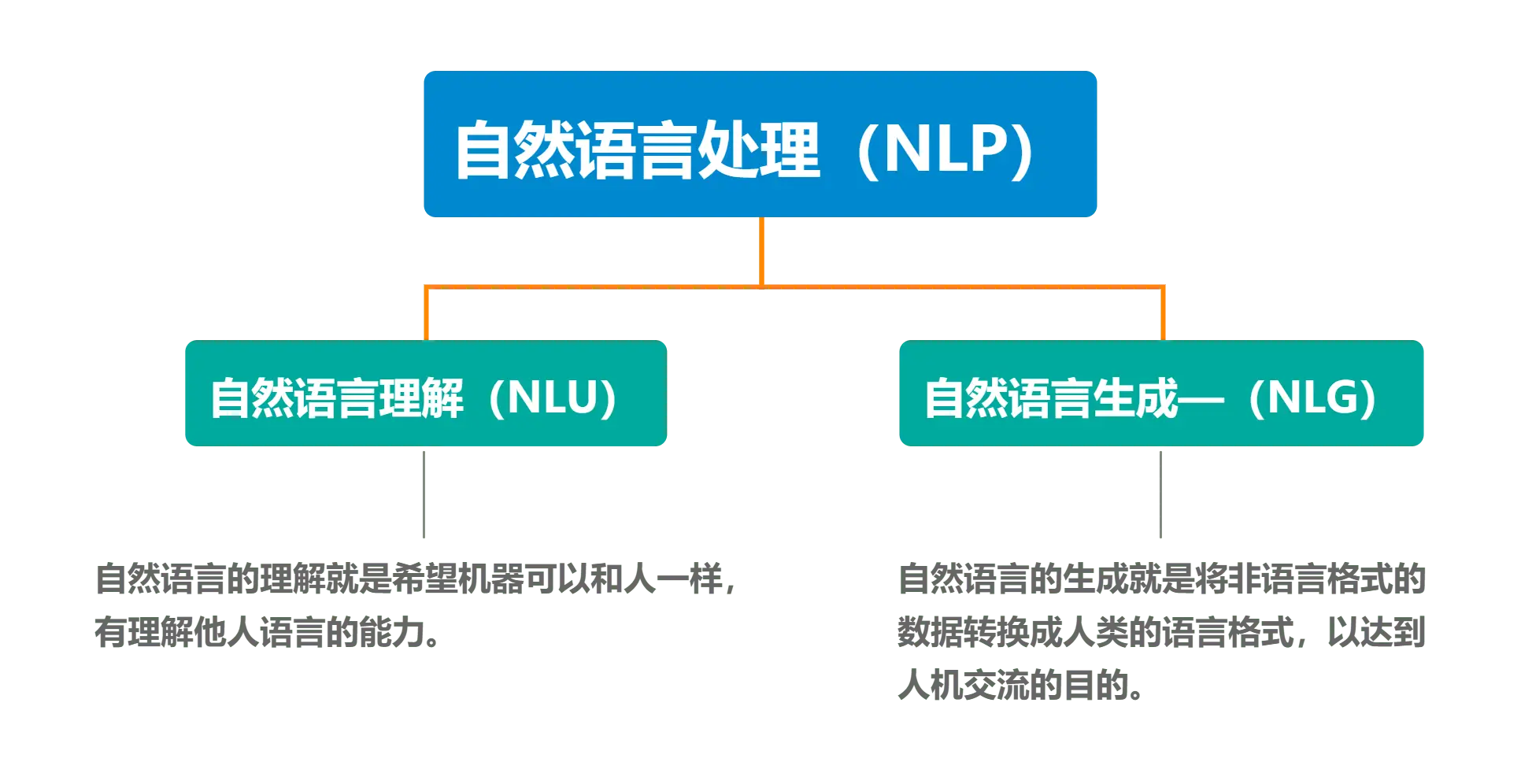

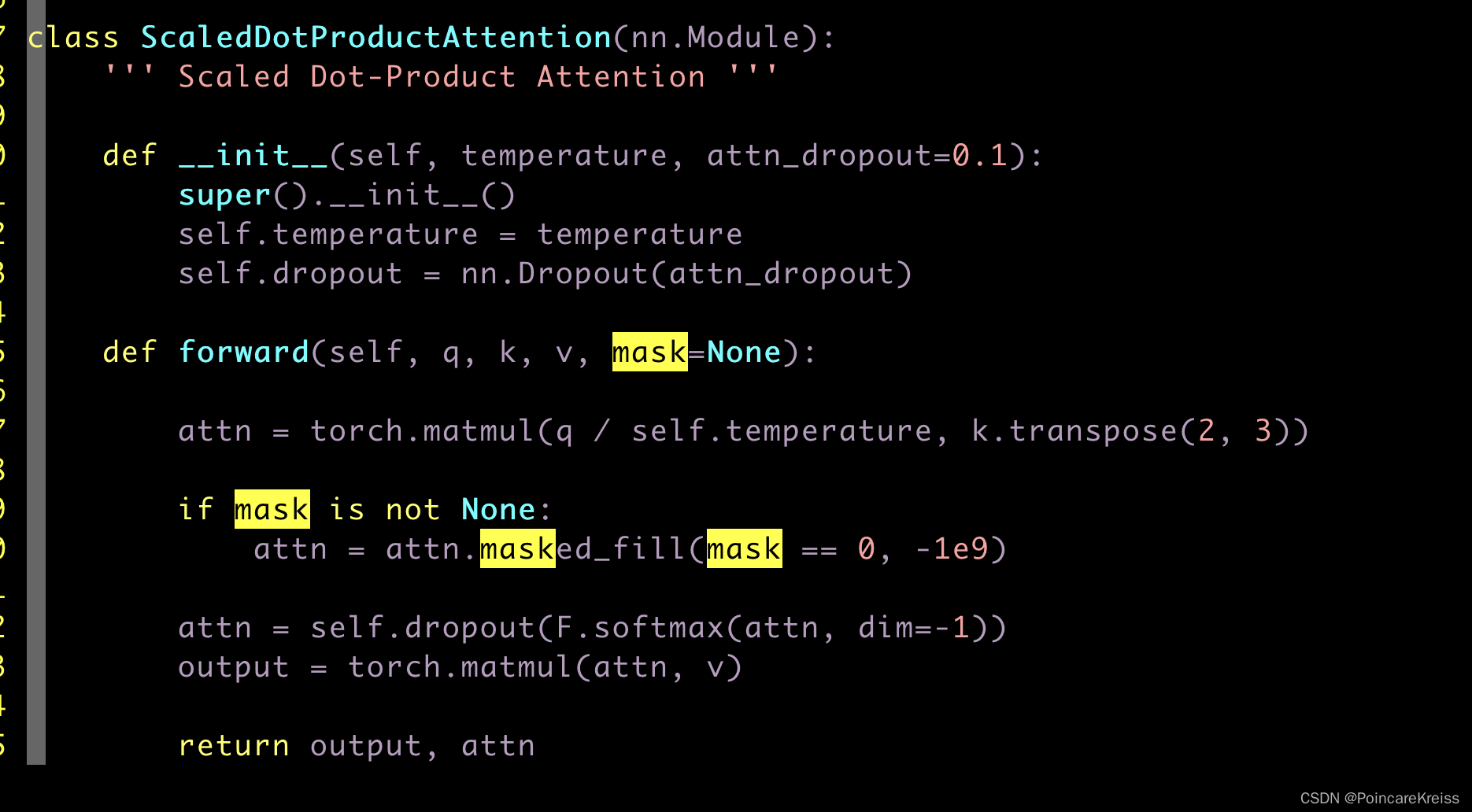

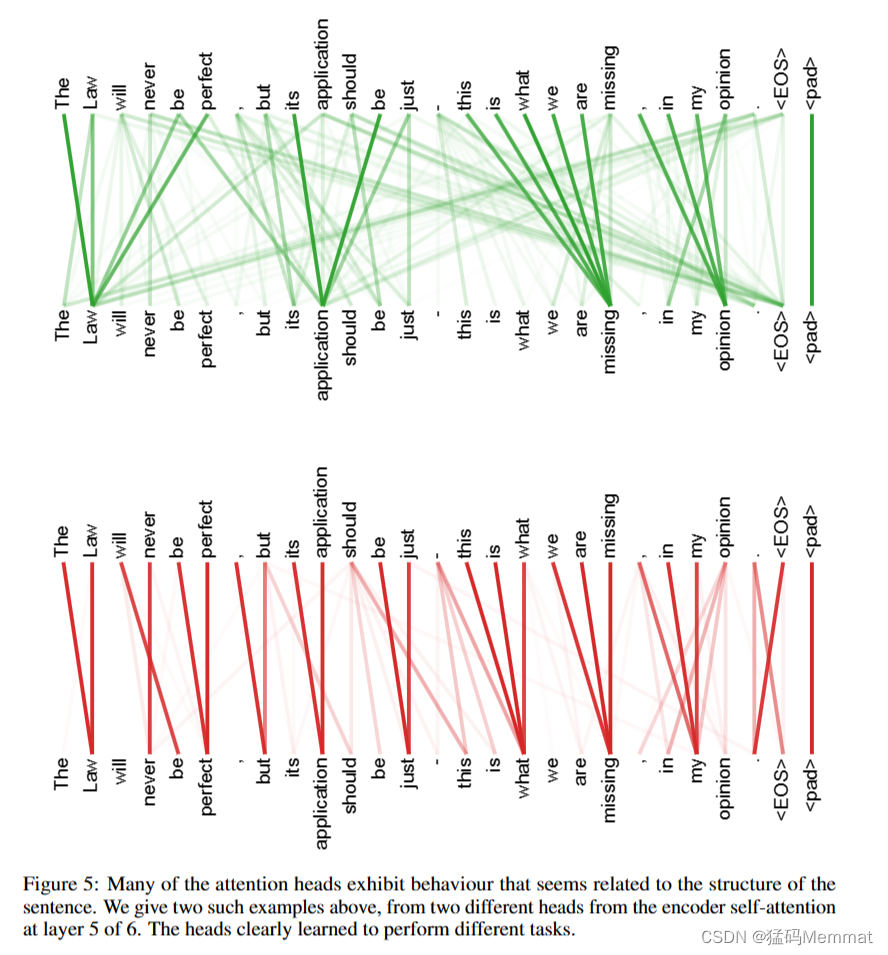

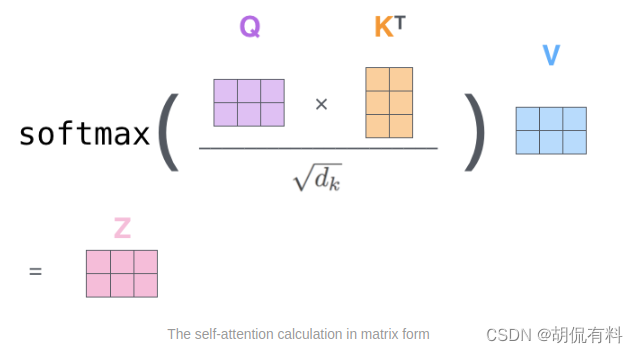

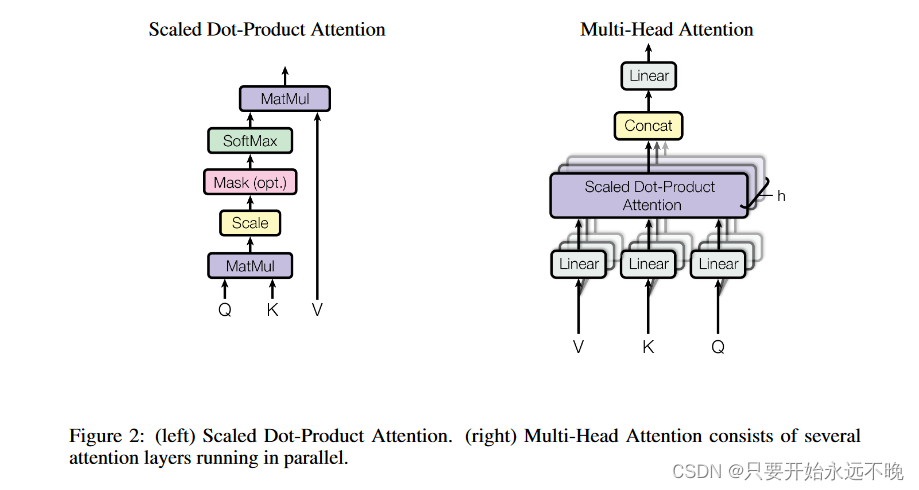

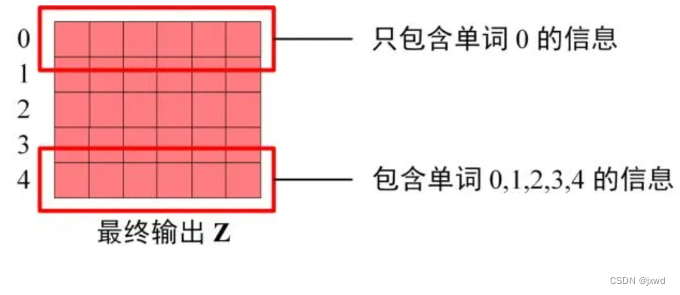

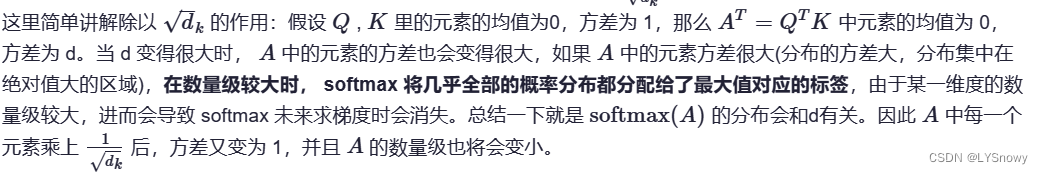

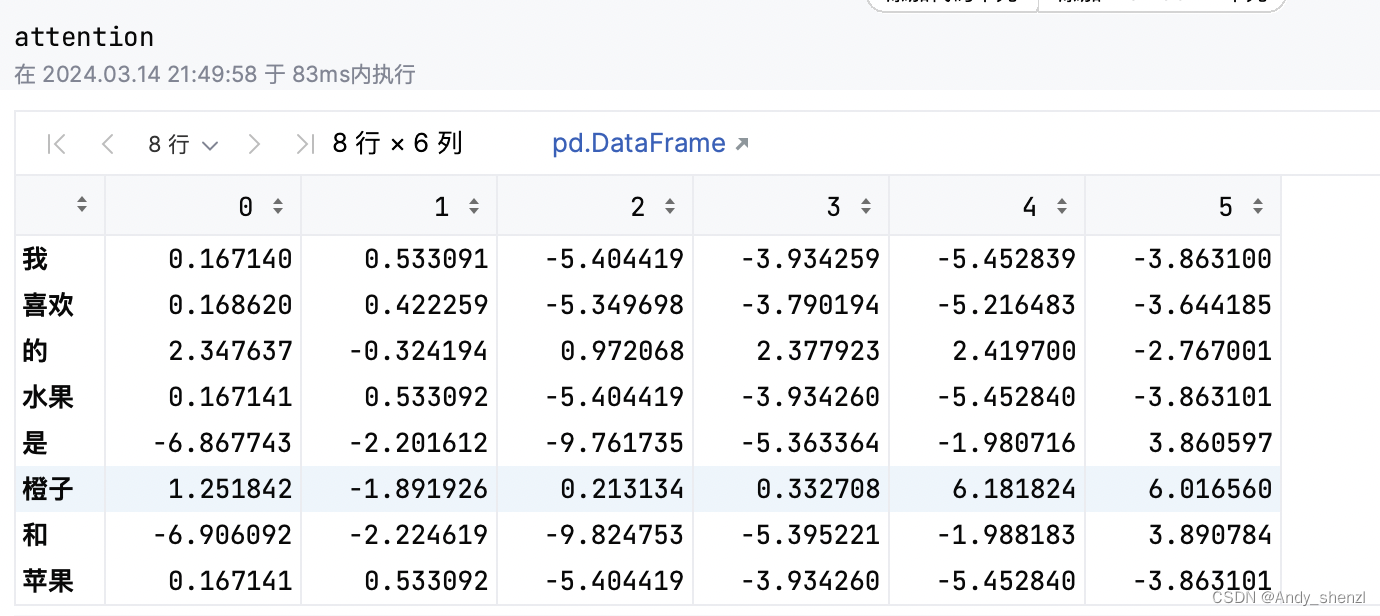

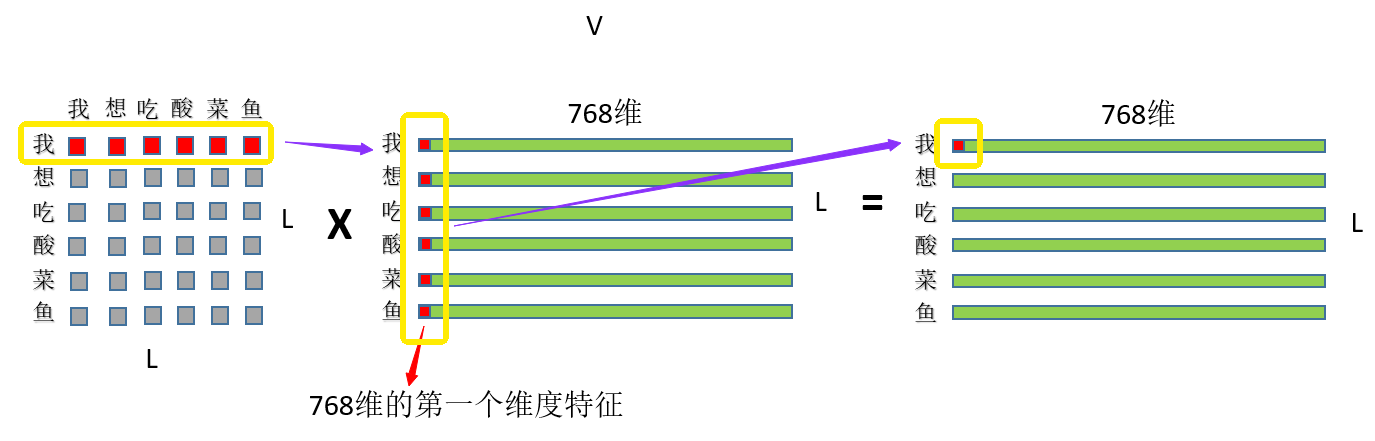

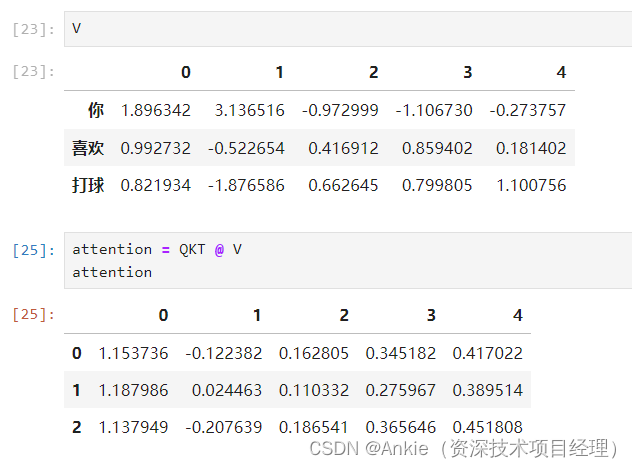

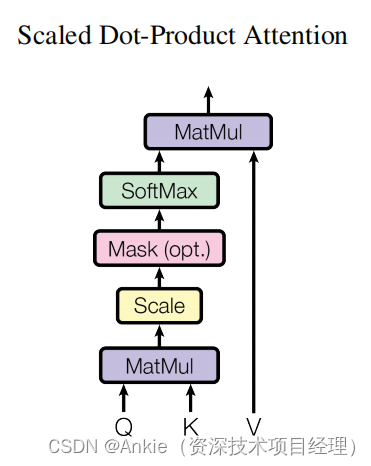

自然语言处理---Transformer机制详解之Self attention机制详解

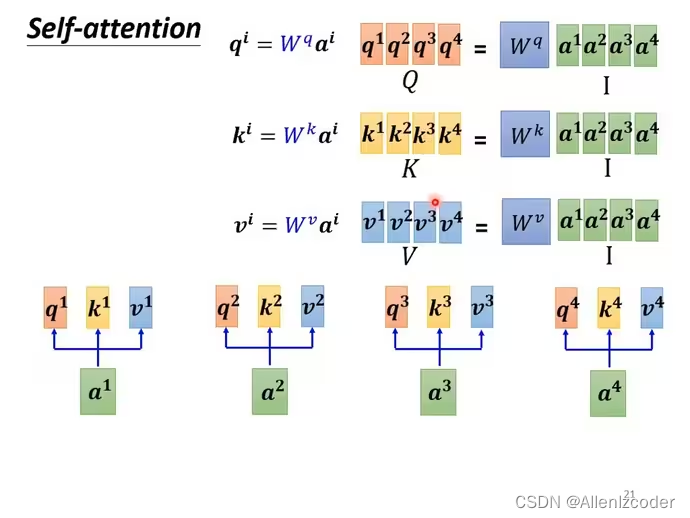

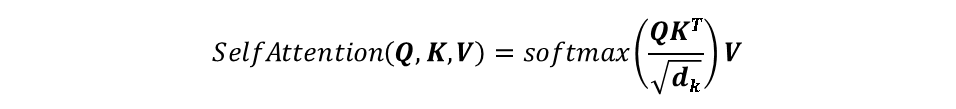

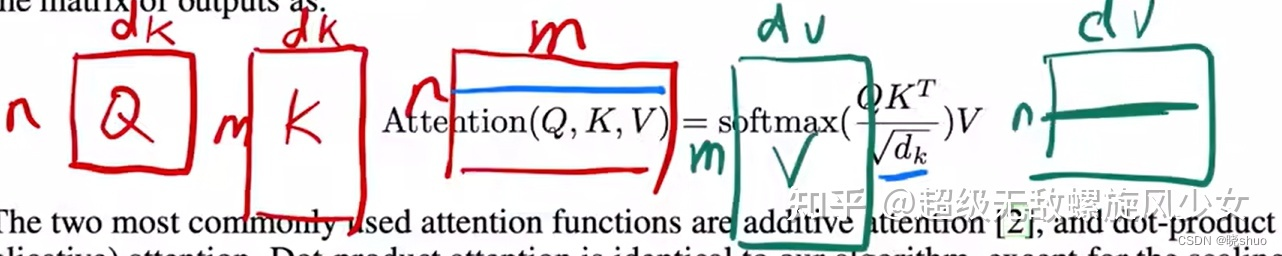

1 Self-attention的特点

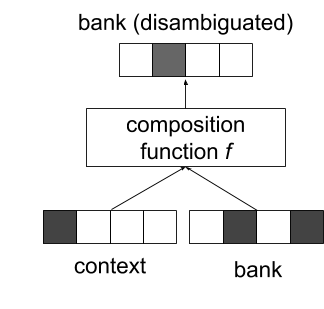

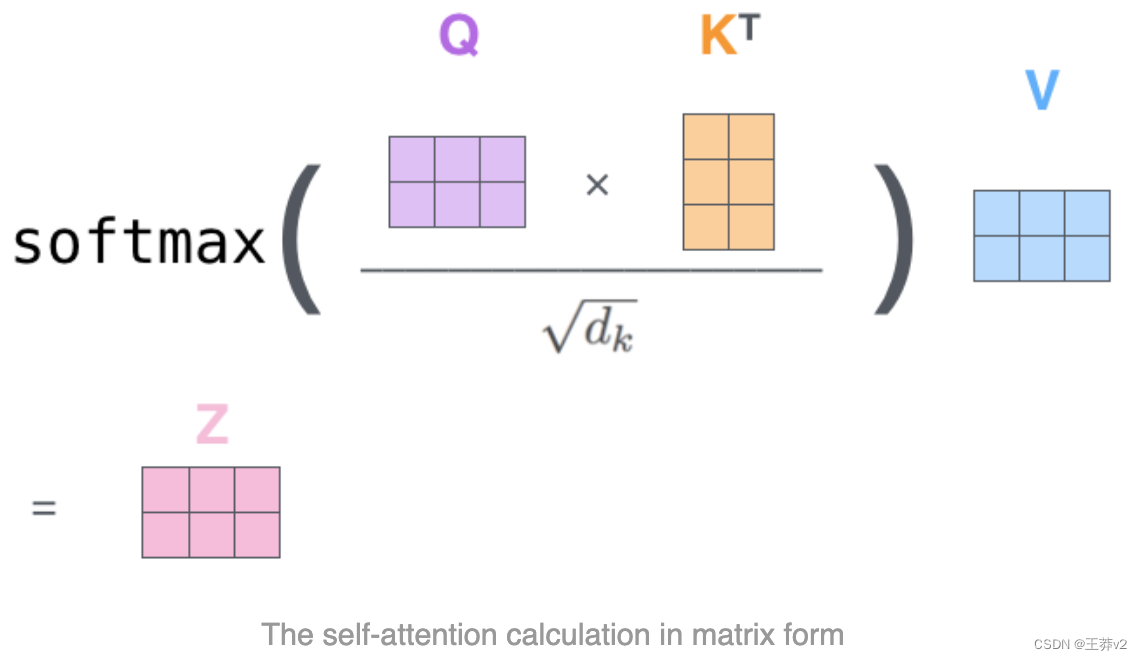

self-attention是一种通过自身和自身进行关联的attention机制, 从而得到更好的representation来表达自身.

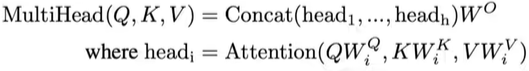

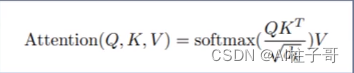

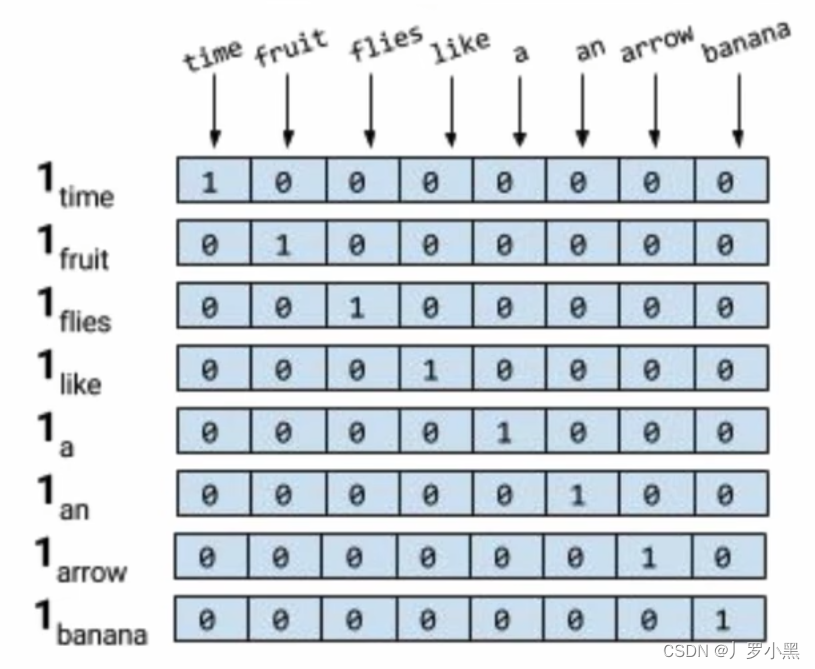

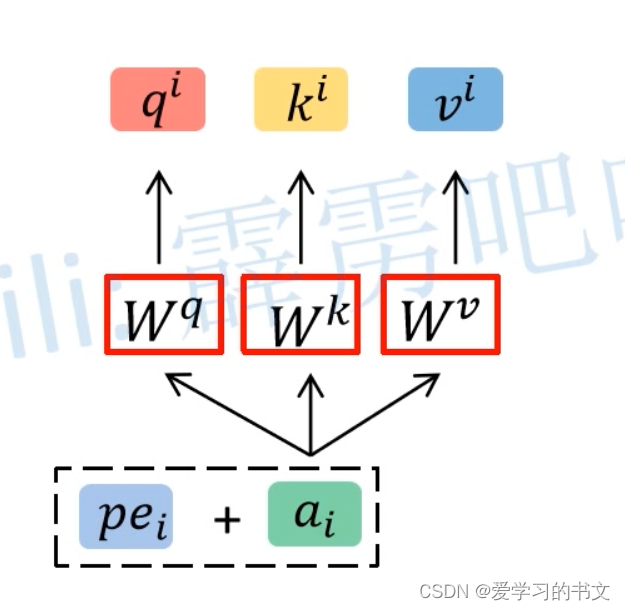

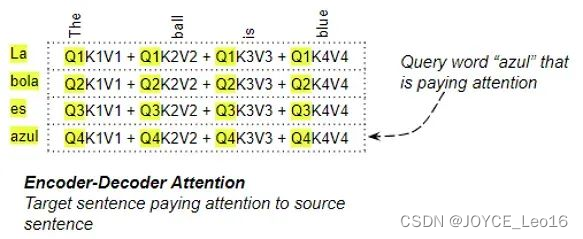

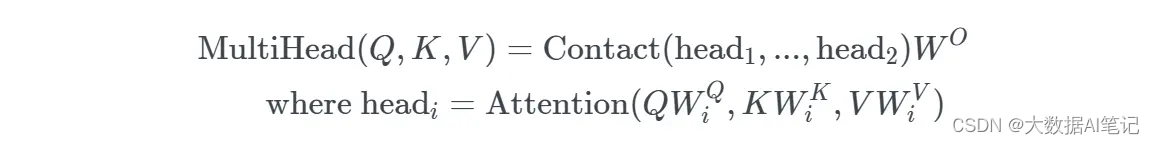

self-attention是attention机制的一种特殊情况,在self-attention中, QKV, 序列中的每个单词(token)都和该序列中的其他所有单词(to…

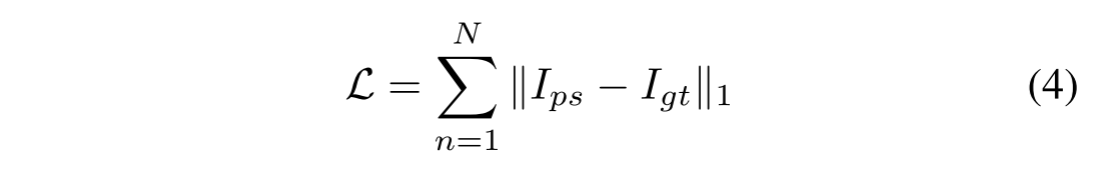

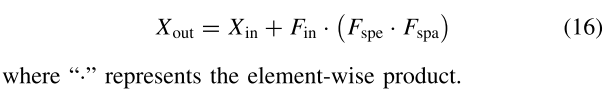

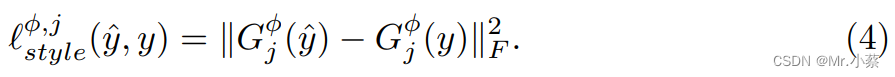

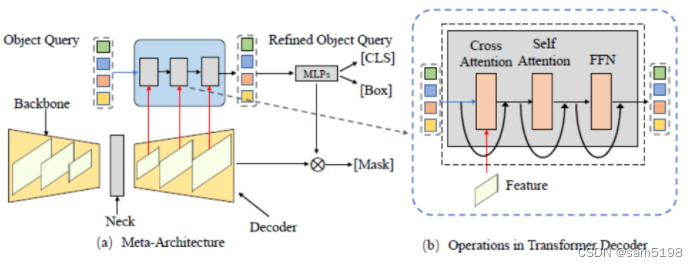

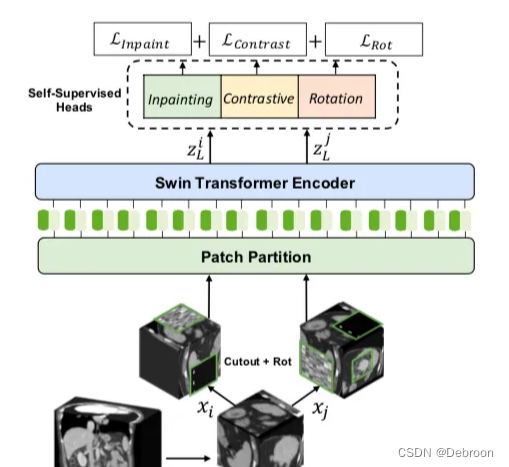

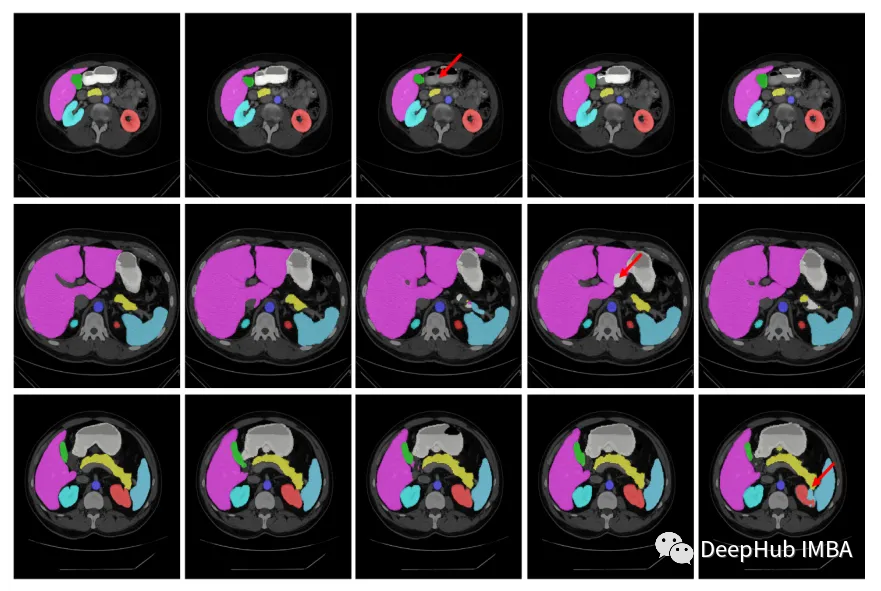

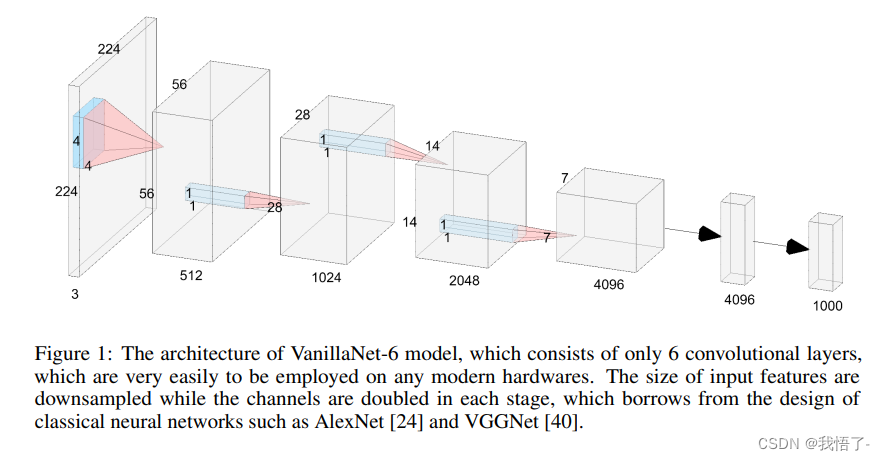

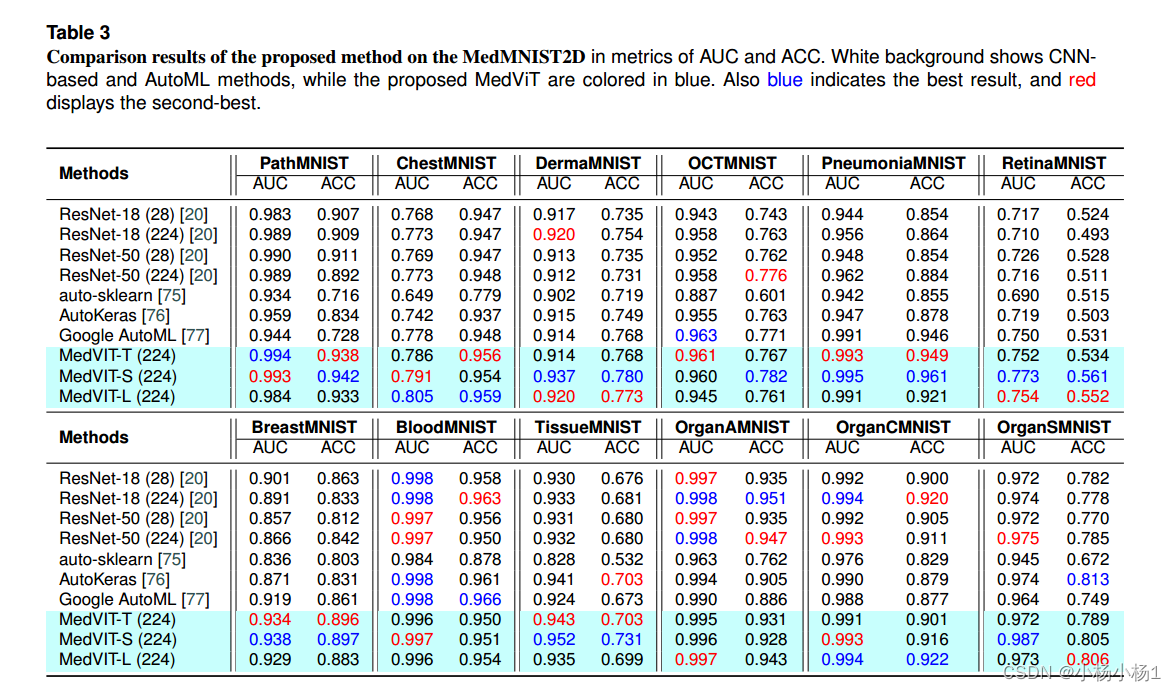

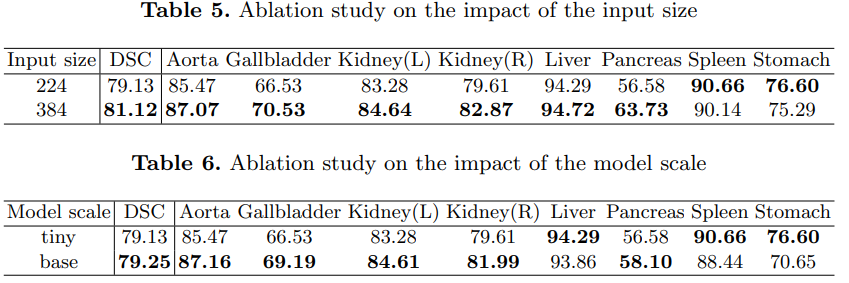

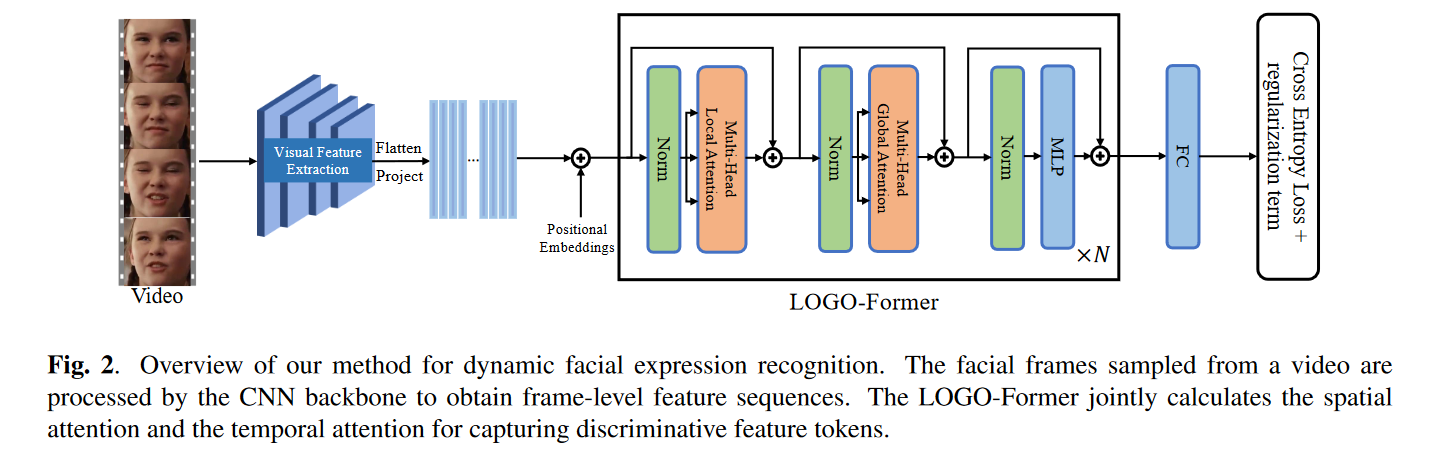

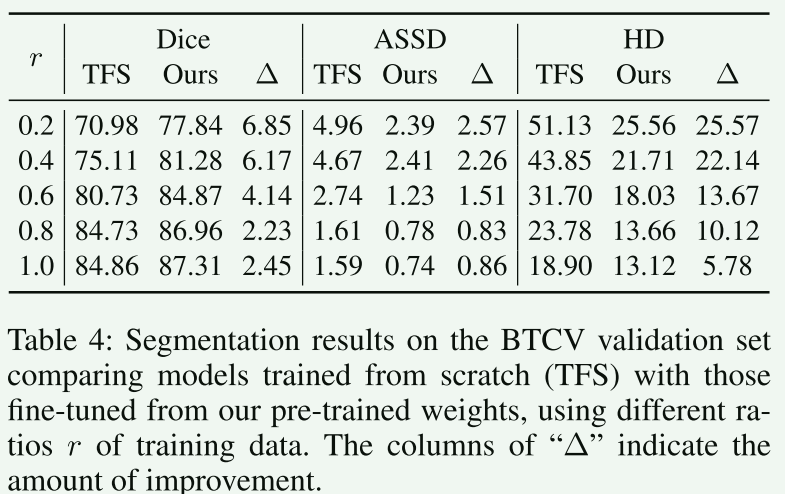

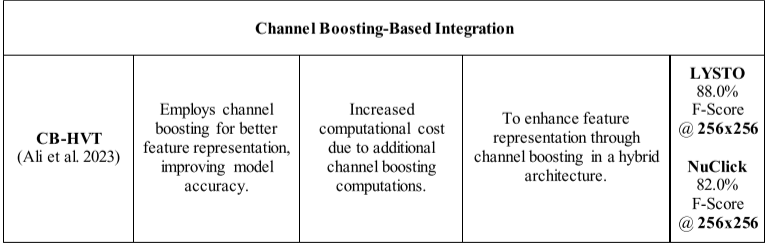

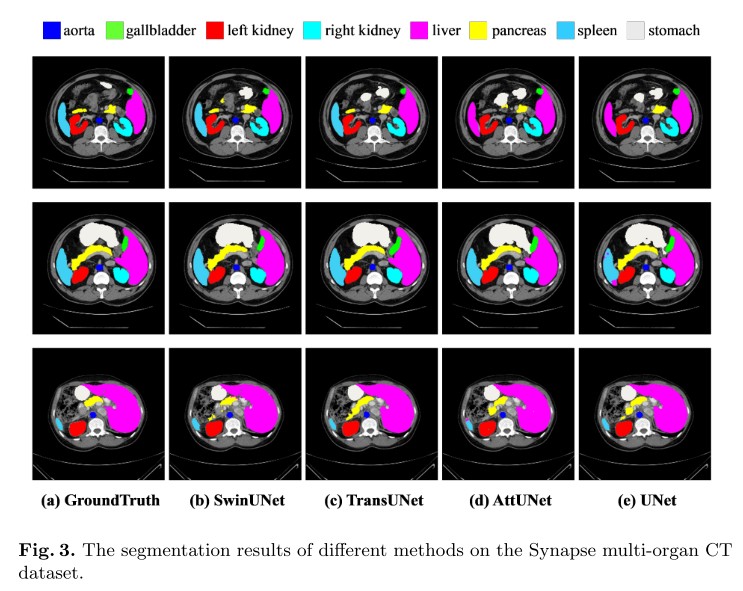

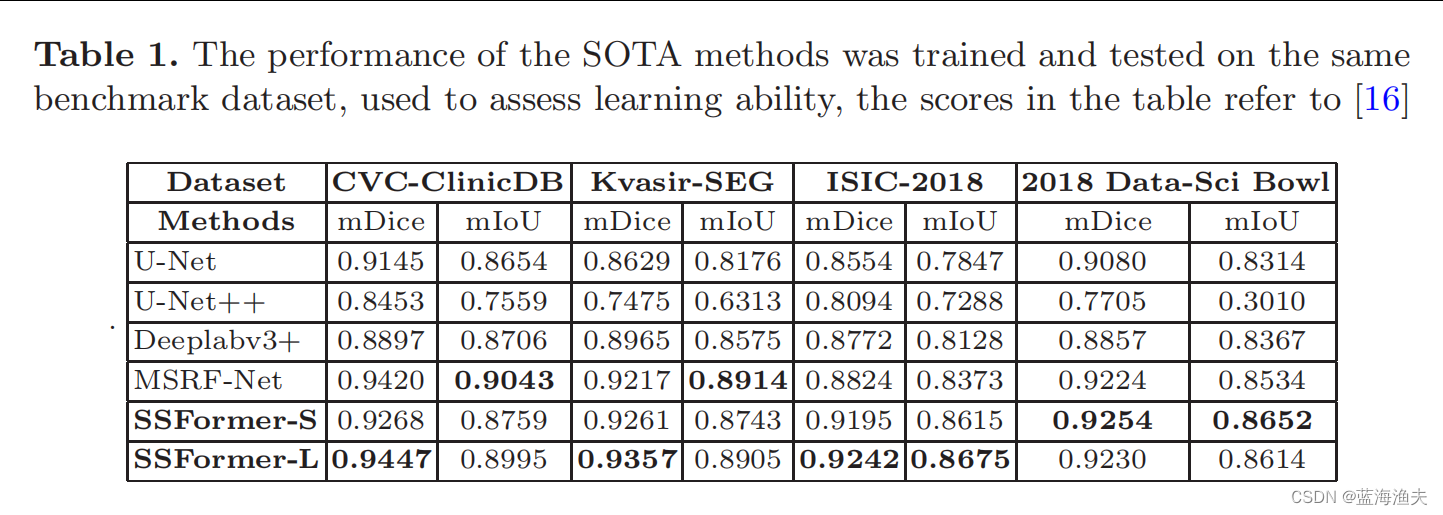

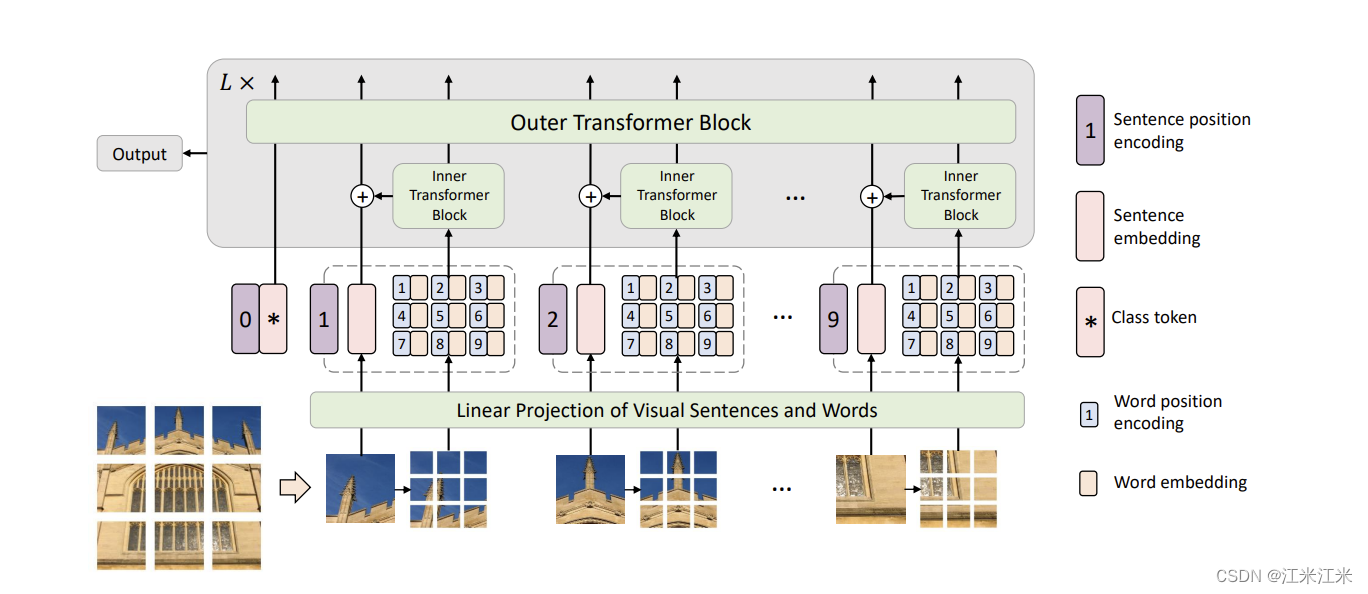

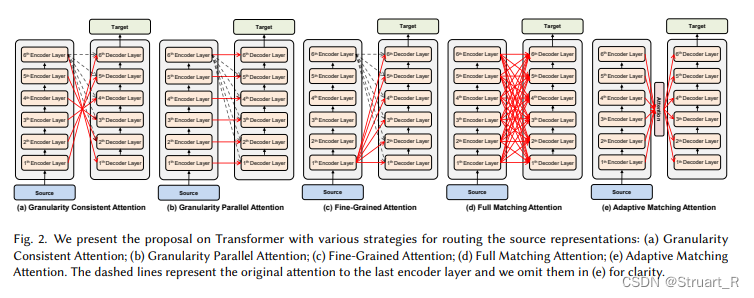

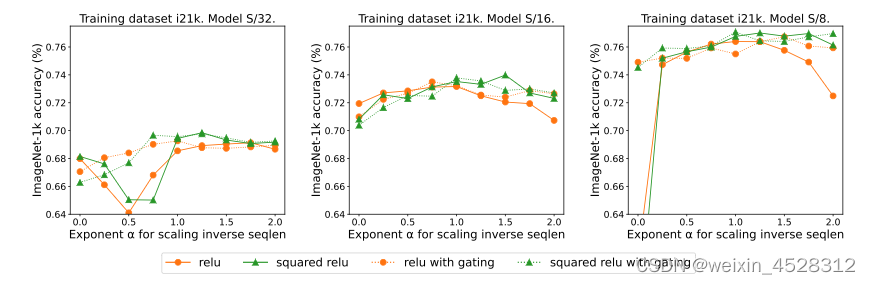

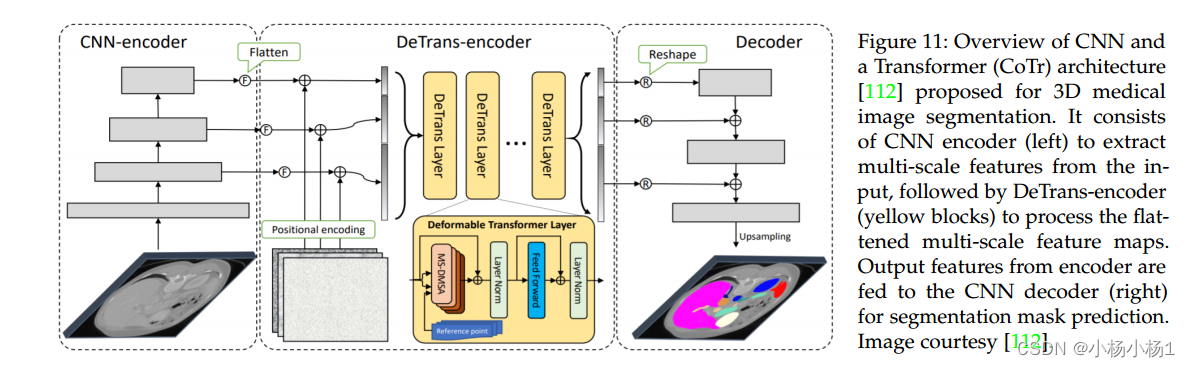

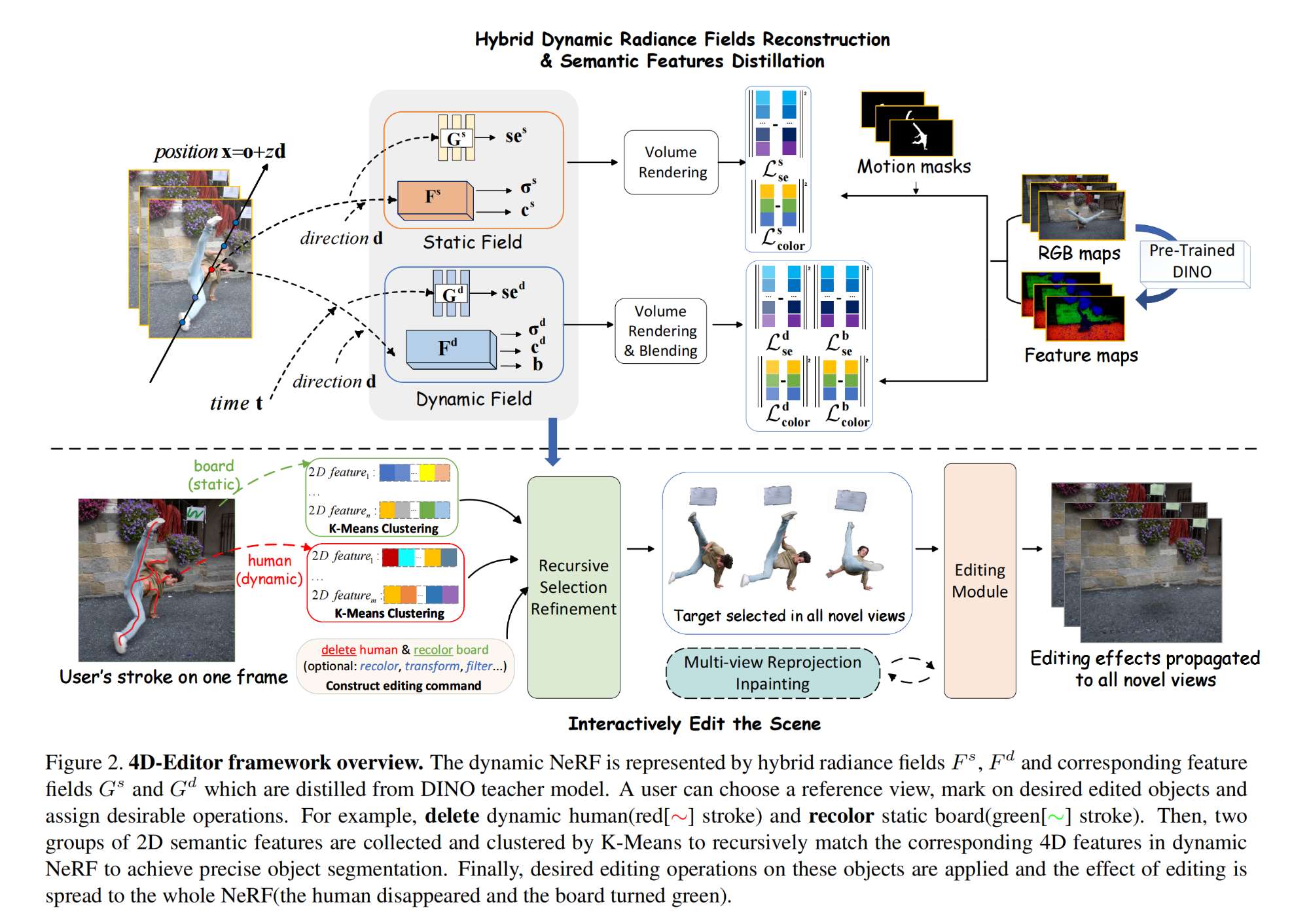

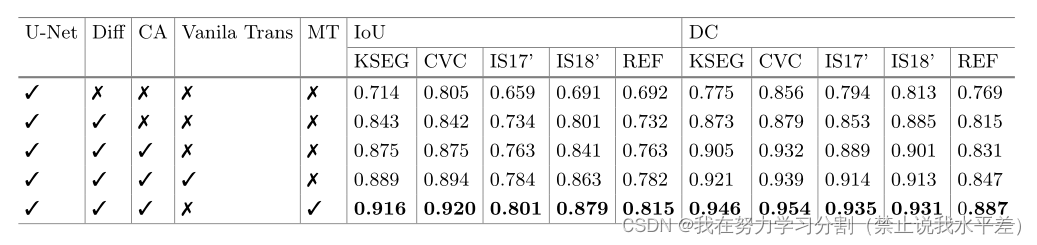

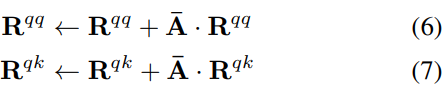

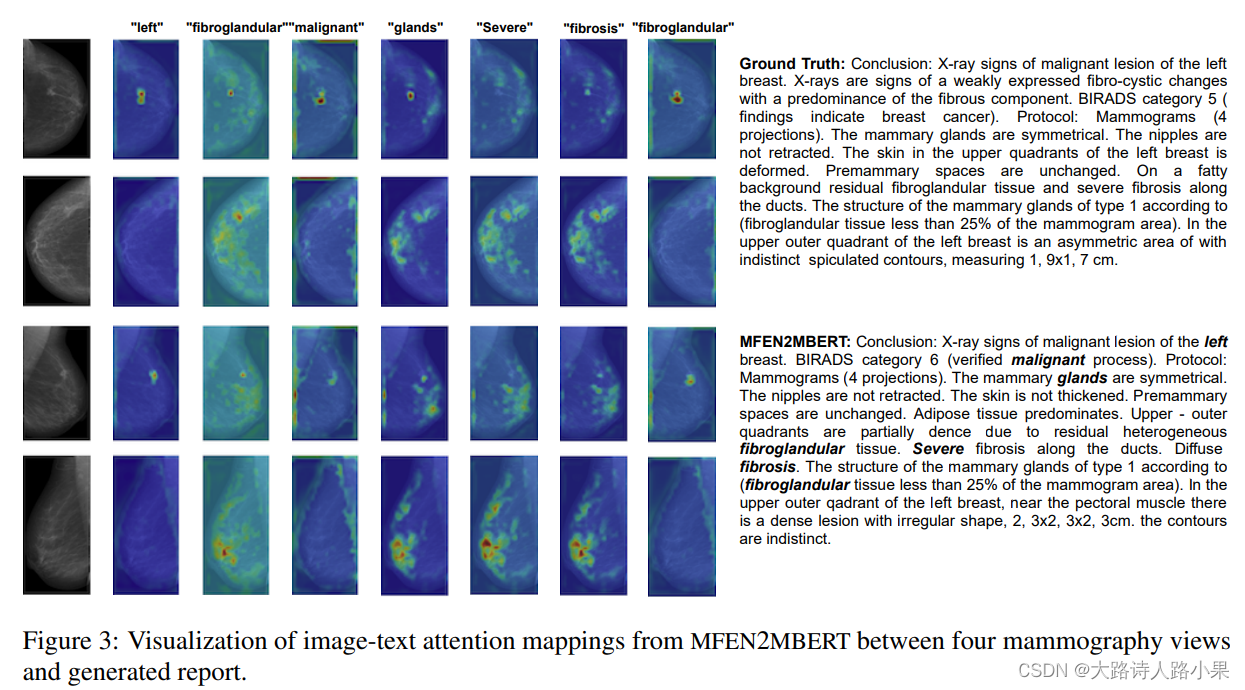

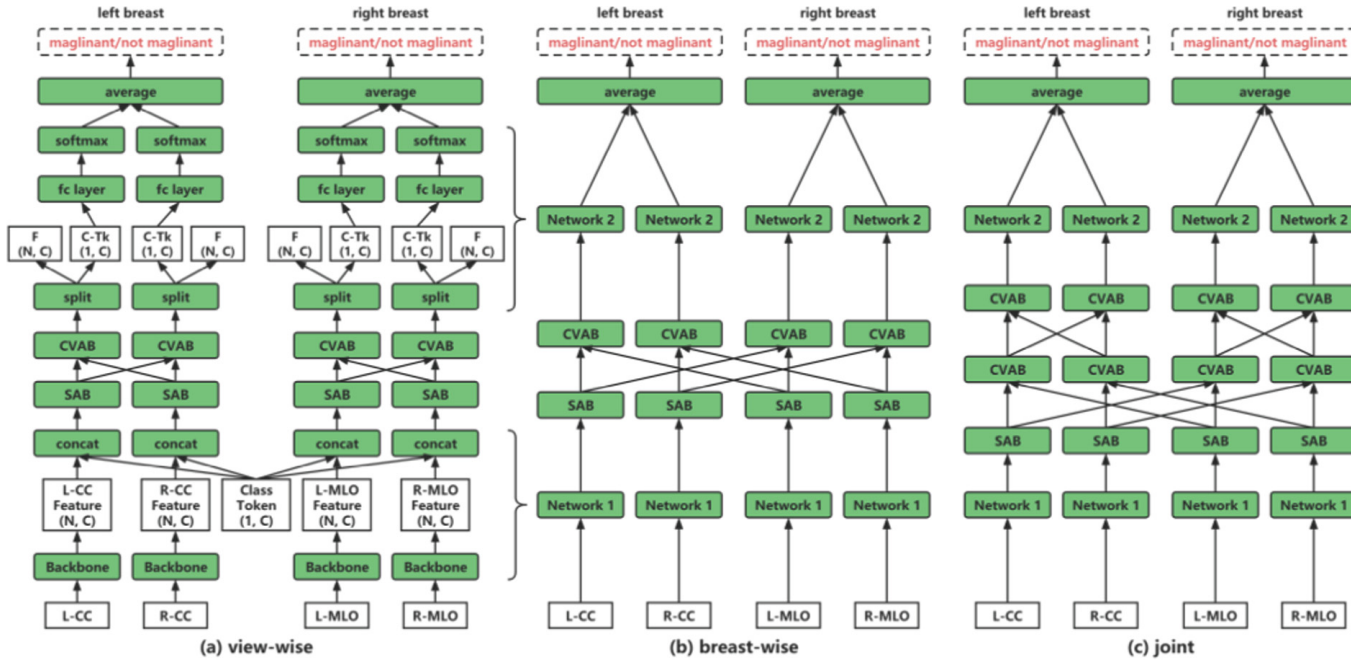

MS-Model【3】:Medical Transformer

文章目录前言1. Abstract & Introduction1.1. Abstract1.2. Introduction2. Medical Transformer (MedT)2.1. Model structure2.2. Attention2.2.1. Self-Attention Overview2.2.2. Axial-Attention2.2.3. Gated Axial-Attention2.3. Local-Global Training2.4. Loss funct…

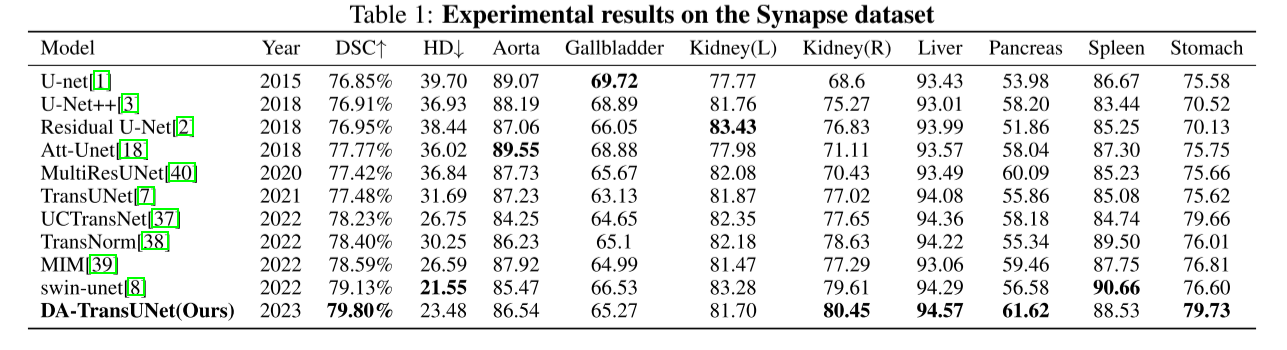

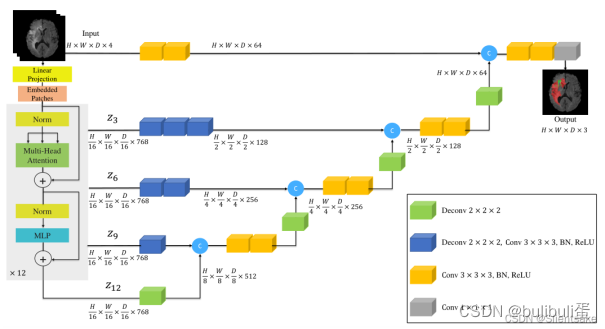

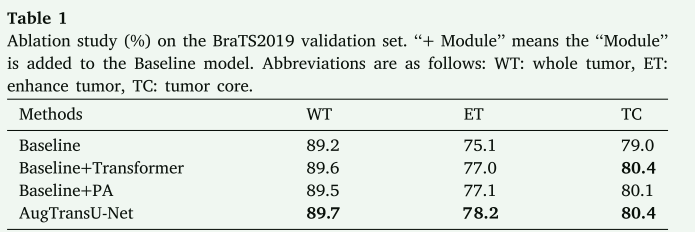

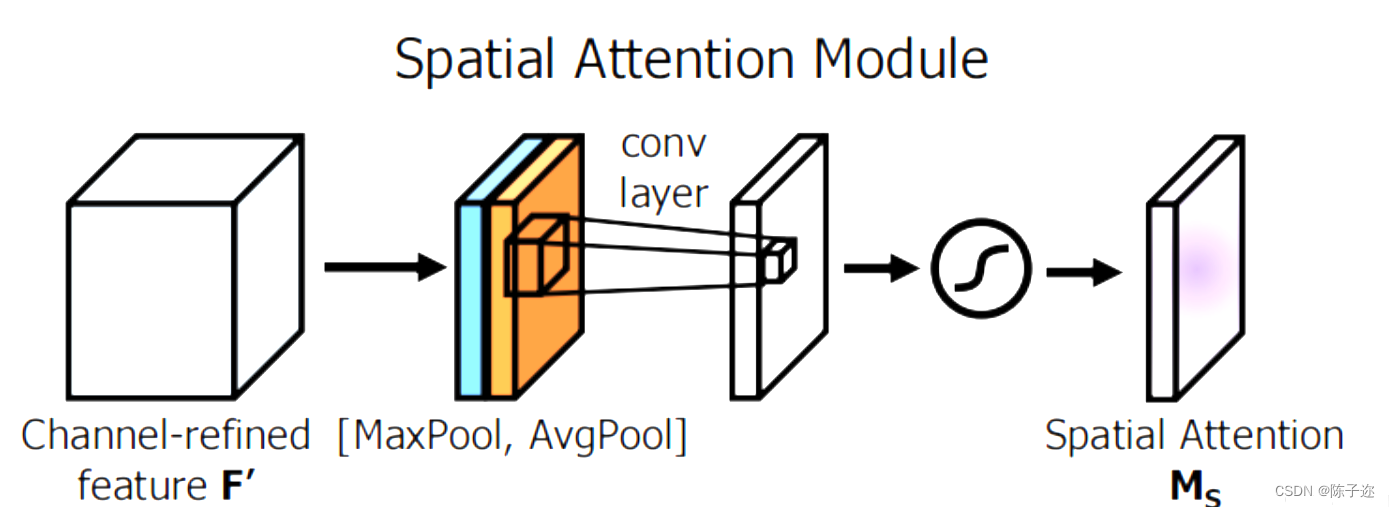

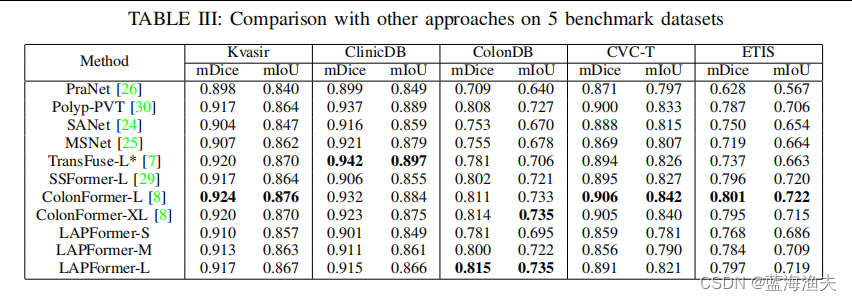

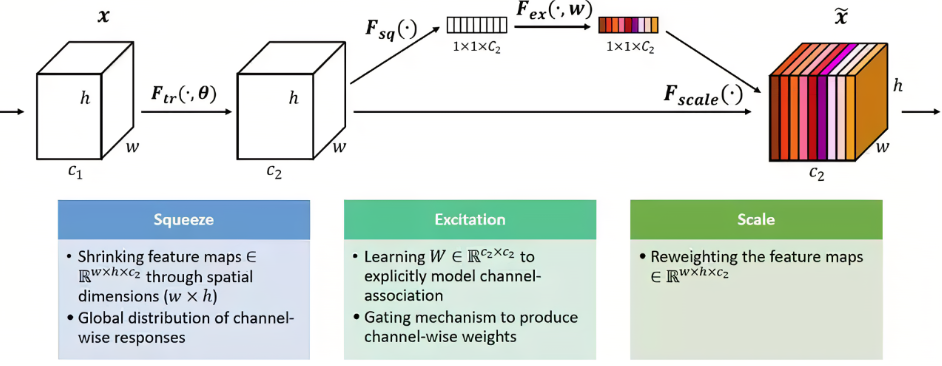

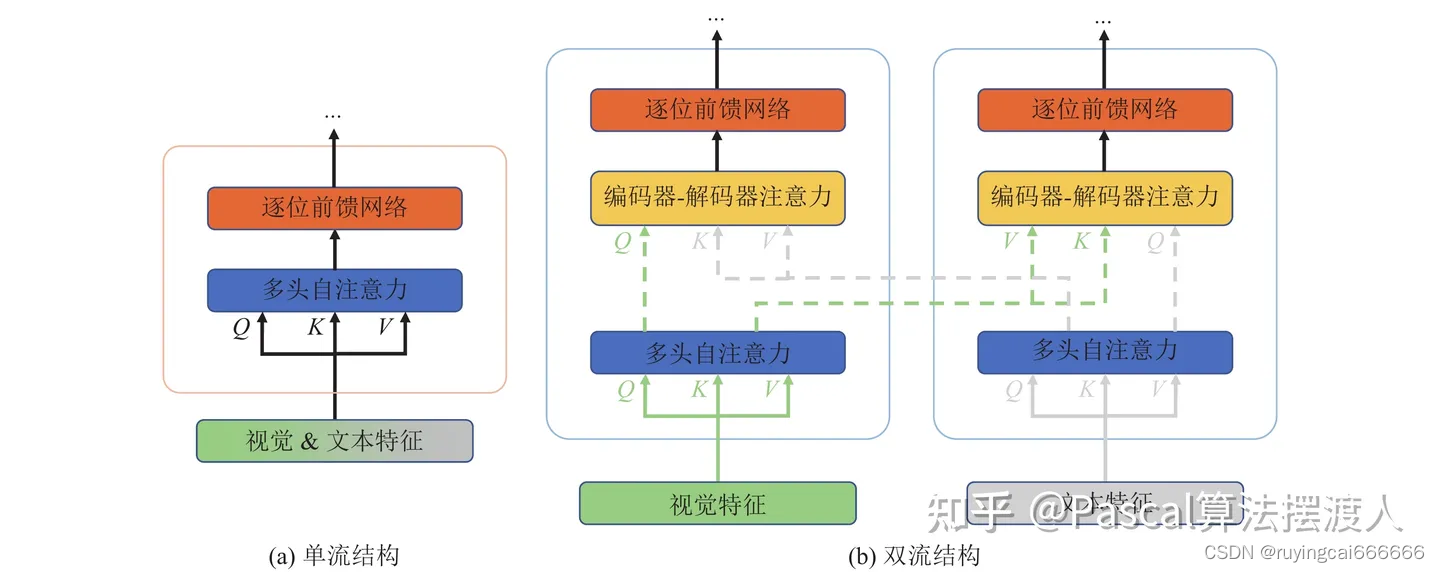

Da-transunet:将空间和通道双重关注与Transformer u-net相结合用于医学图像分割

DA-TRANSUNET: INTEGRATING SPATIAL AND CHANNEL DUAL ATTENTION WITH TRANSFORMER U-NET FOR MEDICAL IMAGE SEGMENTATION 1、方法1.1 模型1.2 双注意力模块(DA-Block)1.2.1 PAM( 位置注意力模块)1.2.2 CAM(通道注意力…

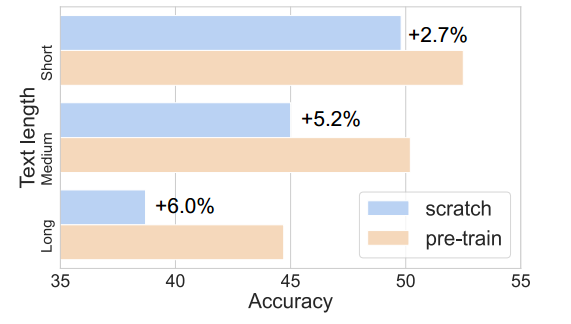

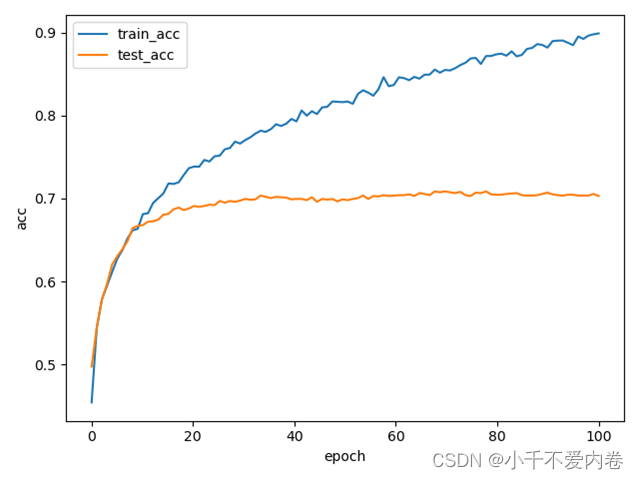

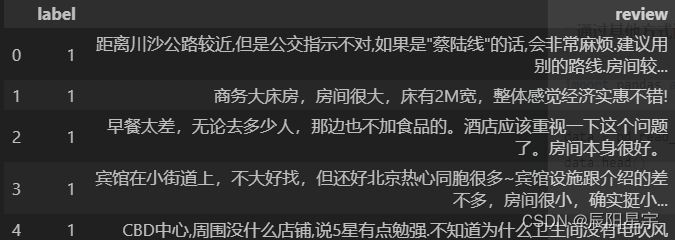

新闻文本分类任务:使用Transformer实现

❤️觉得内容不错的话,欢迎点赞收藏加关注😊😊😊,后续会继续输入更多优质内容❤️👉有问题欢迎大家加关注私戳或者评论(包括但不限于NLP算法相关,linux学习相关,读研读博…

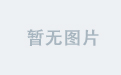

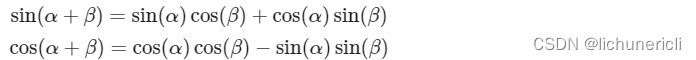

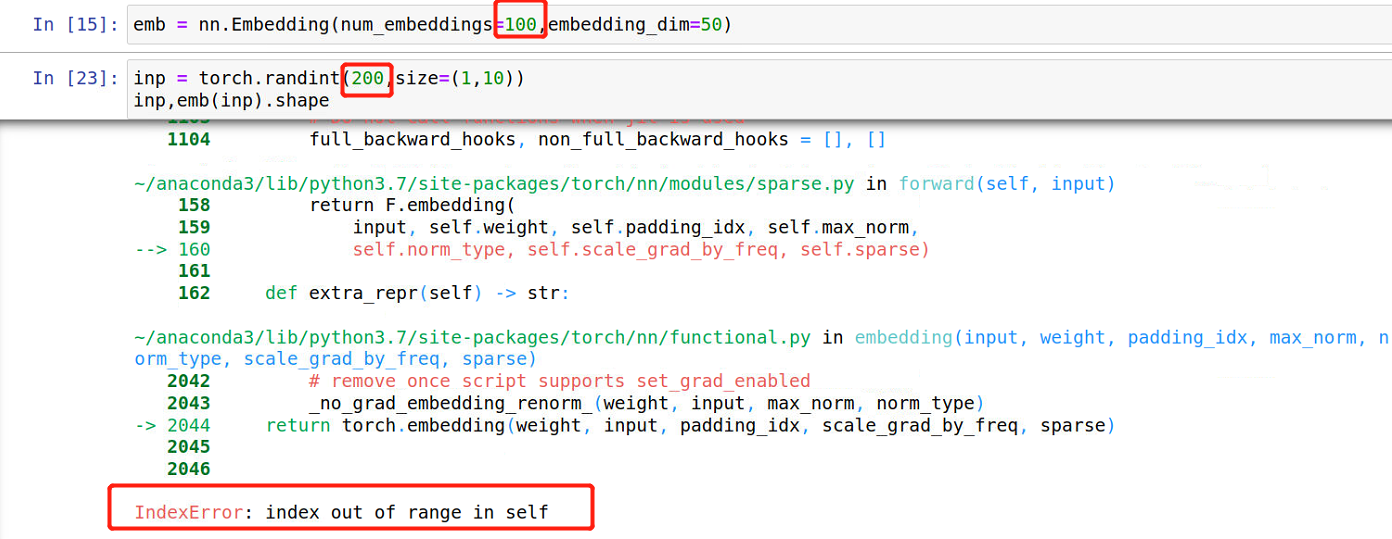

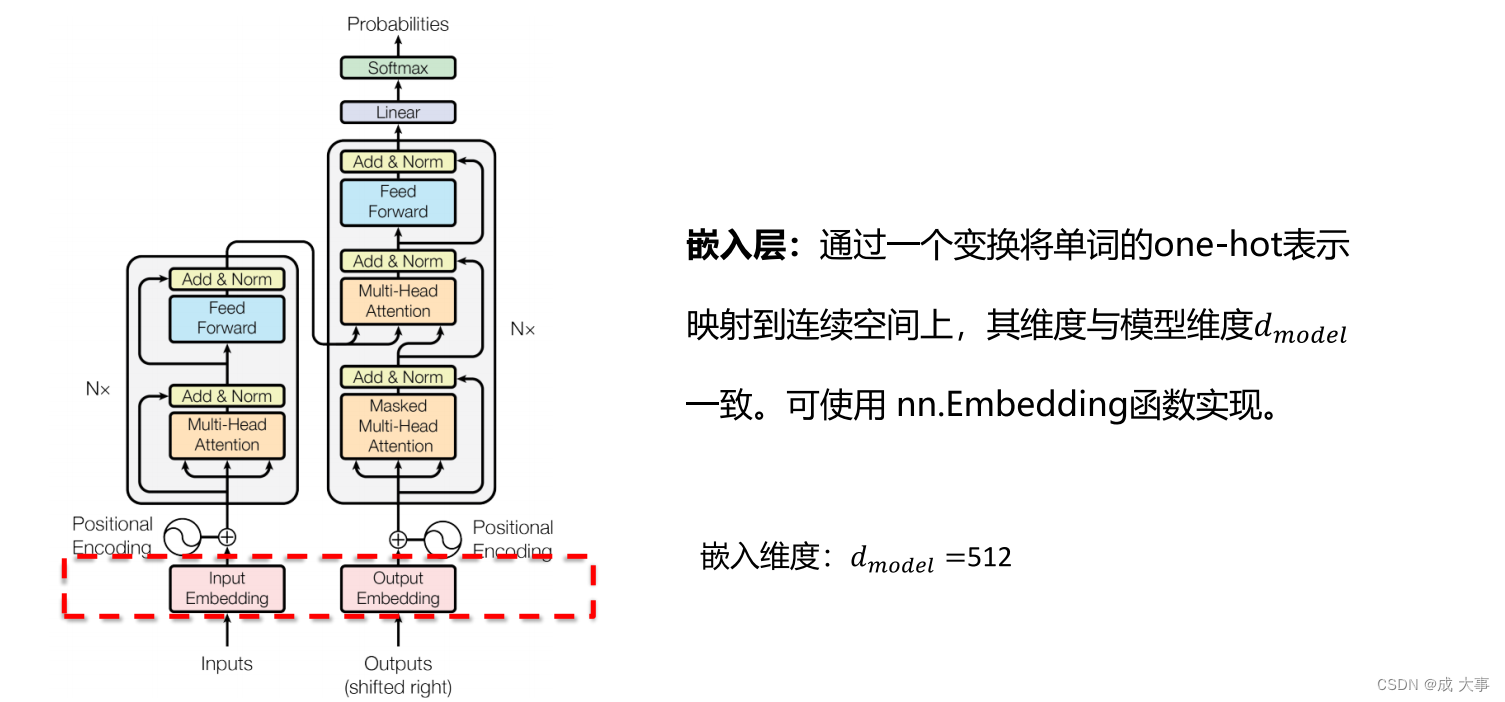

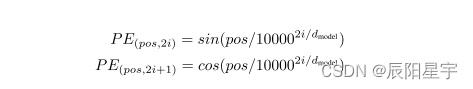

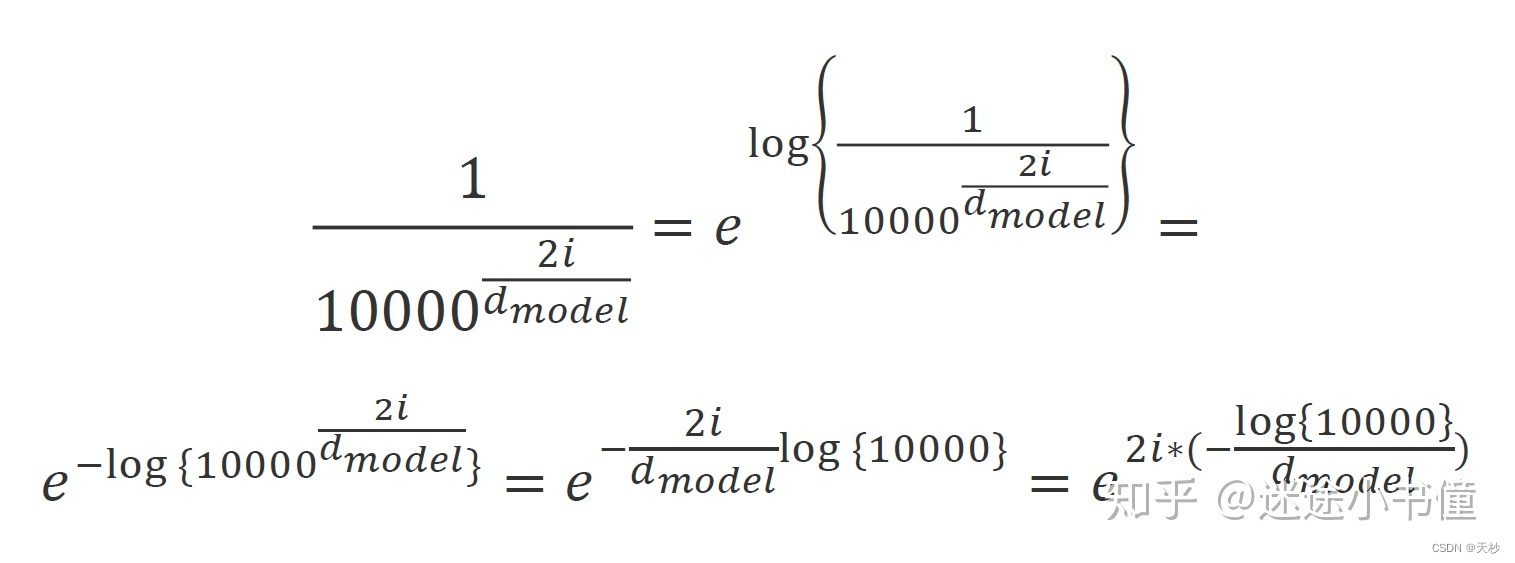

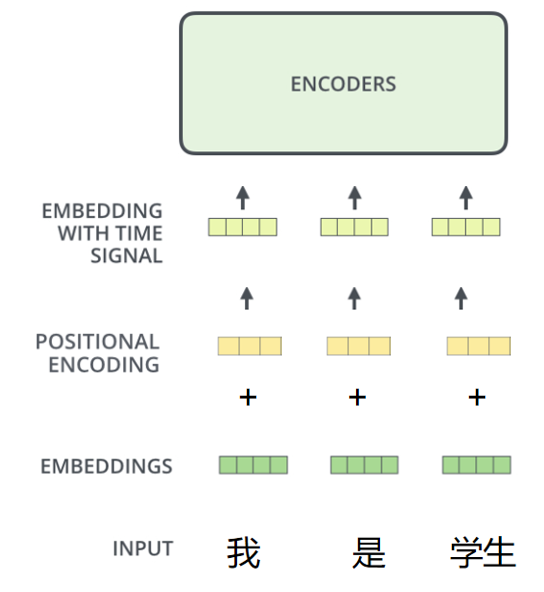

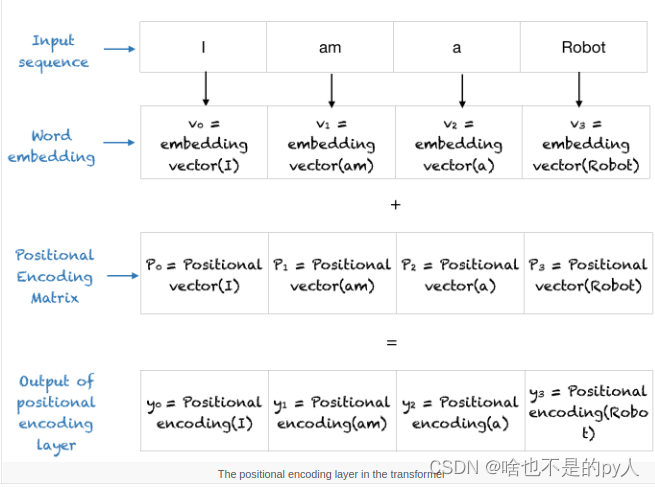

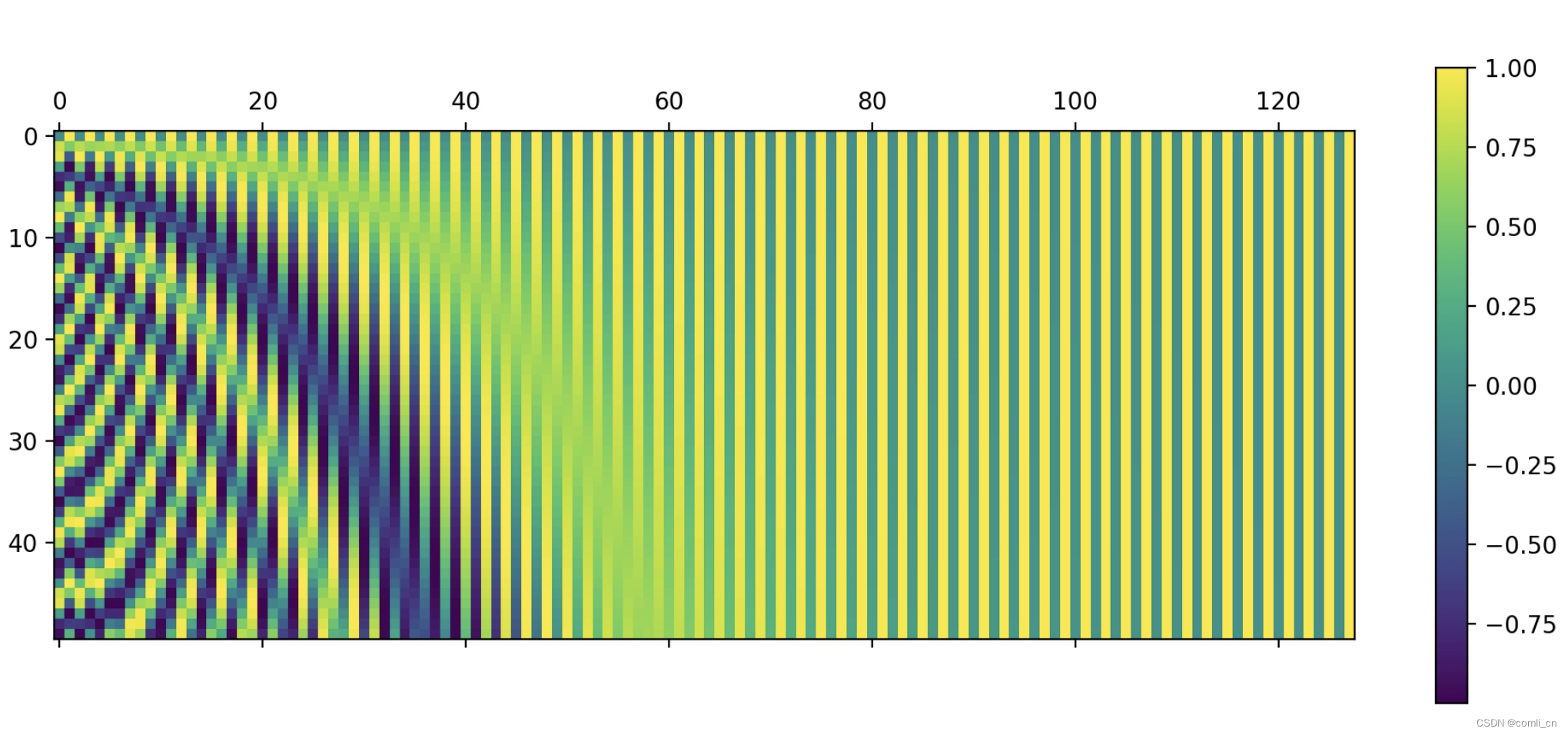

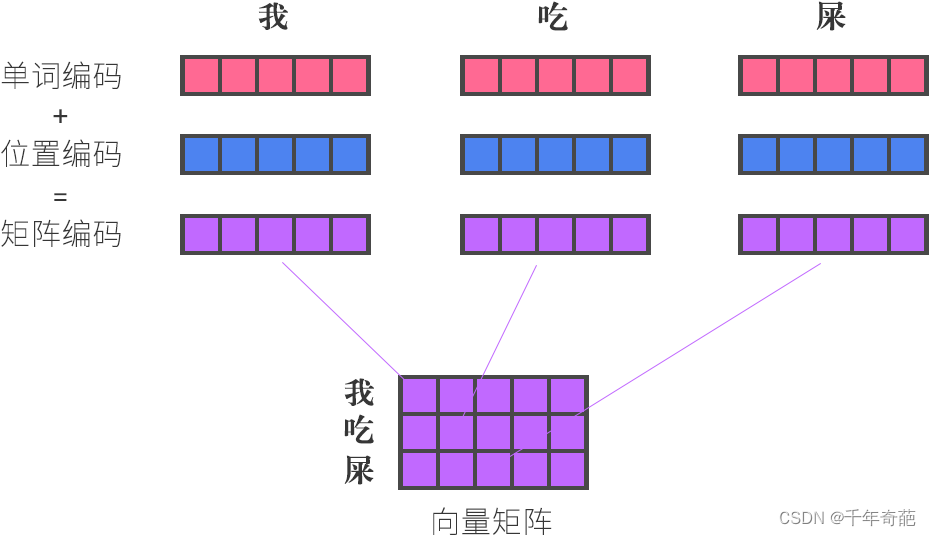

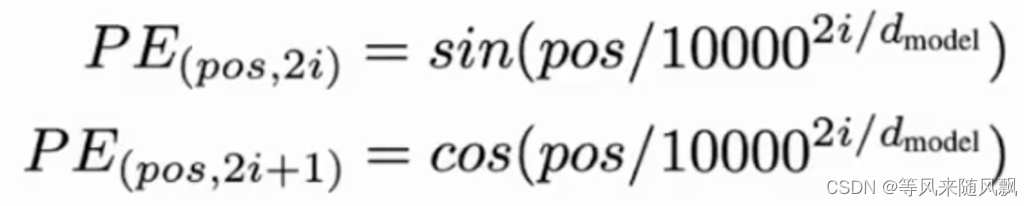

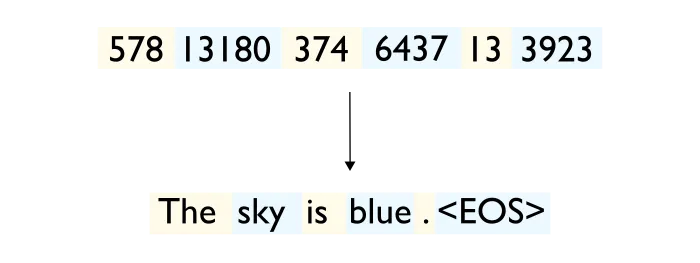

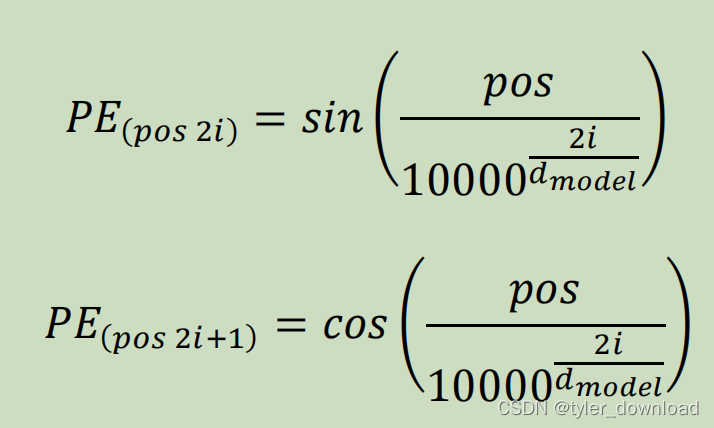

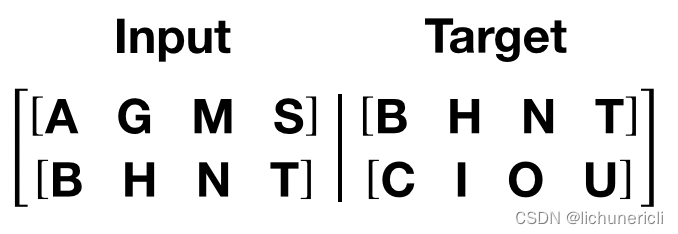

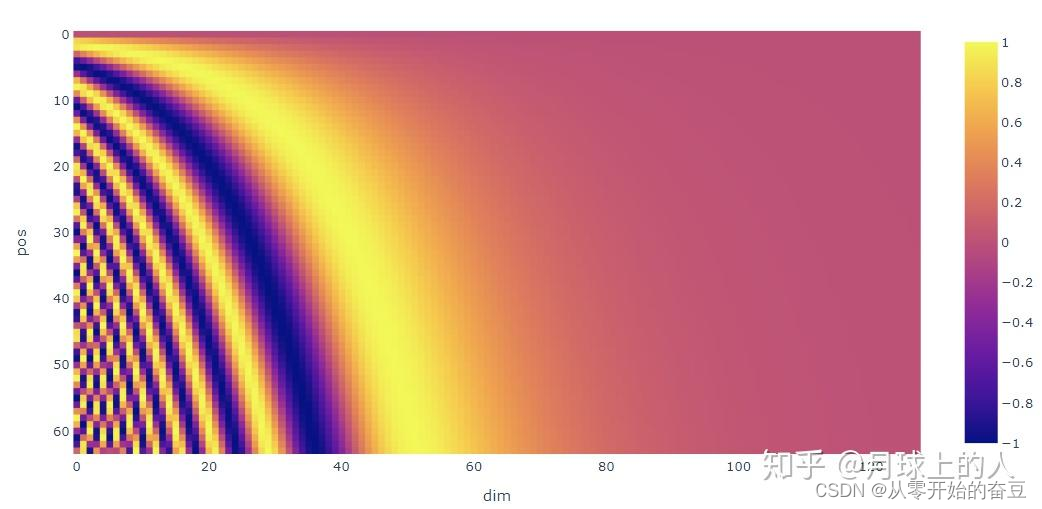

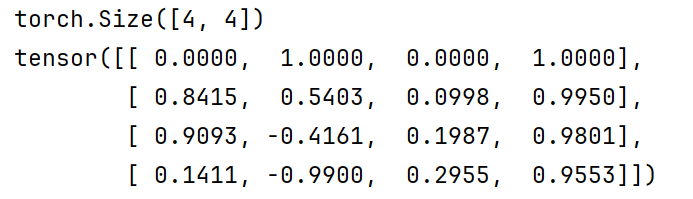

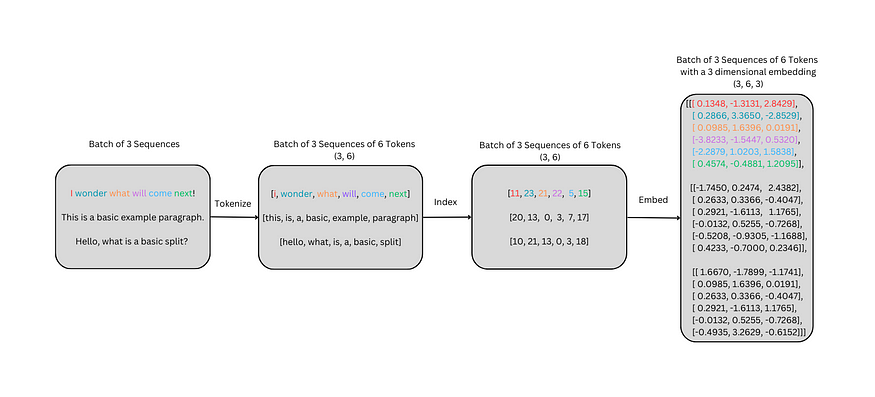

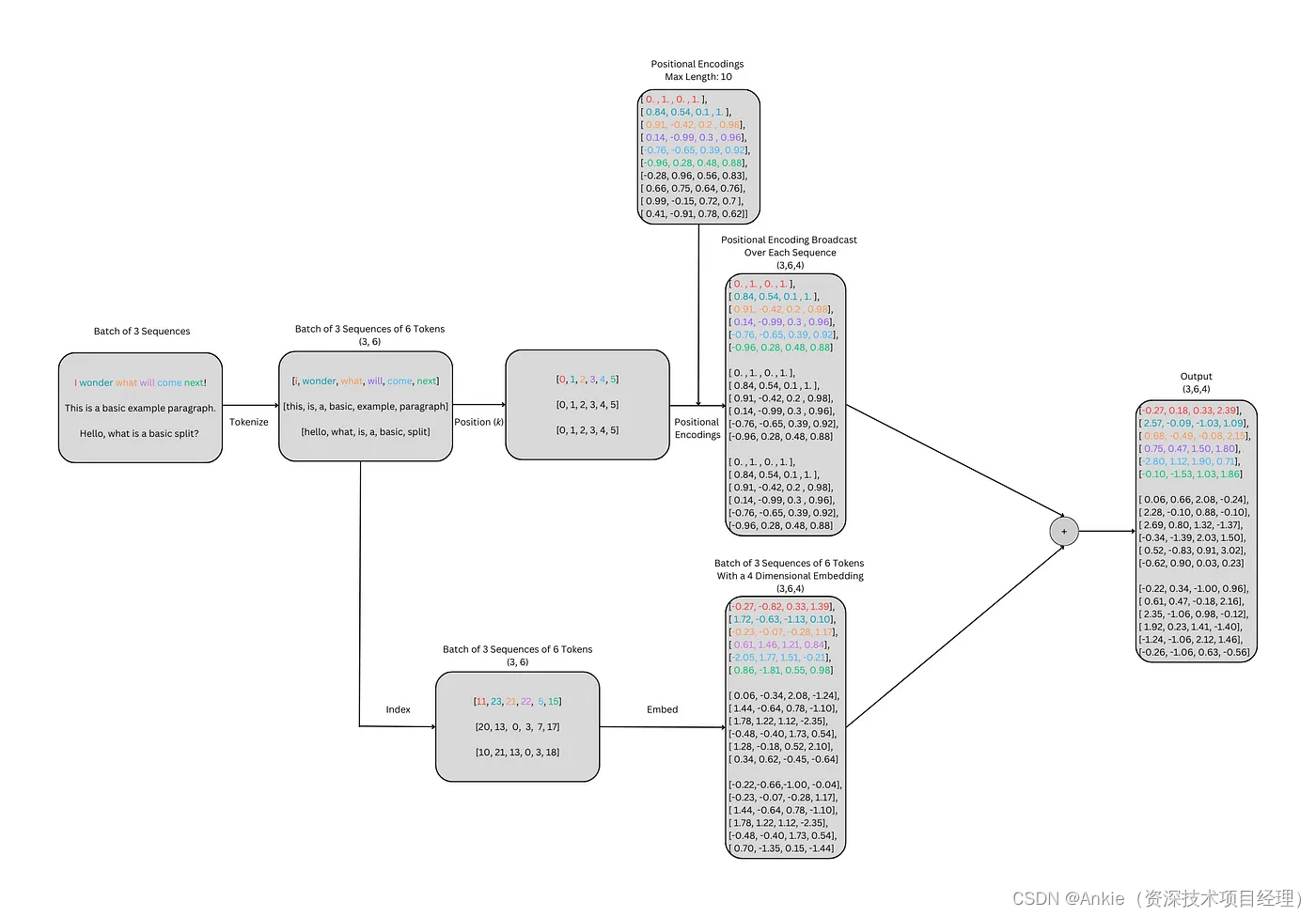

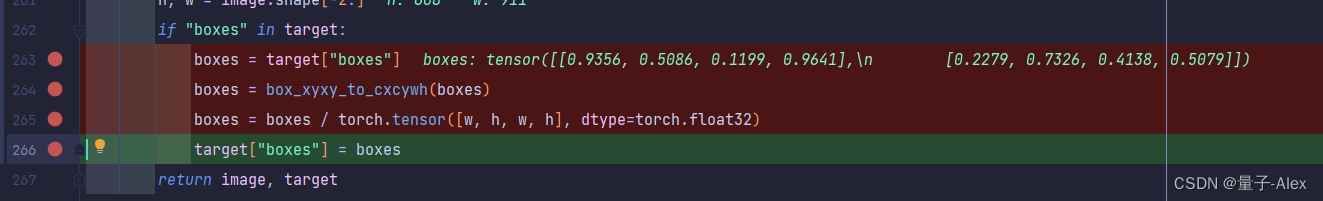

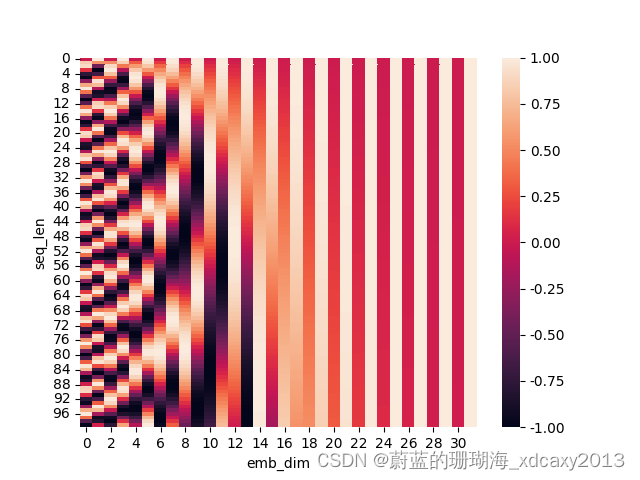

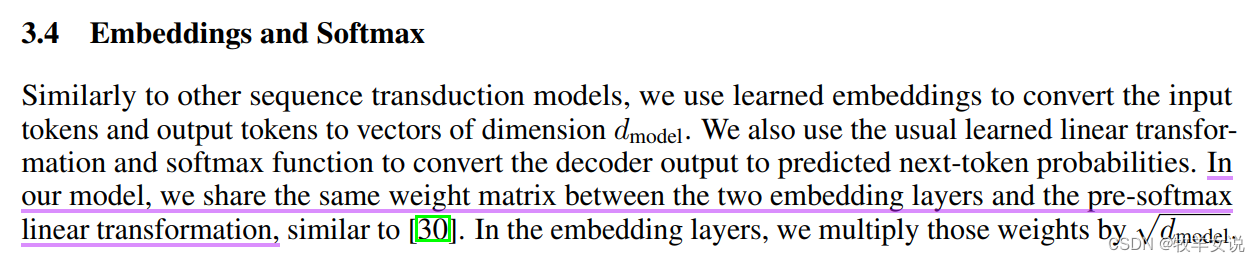

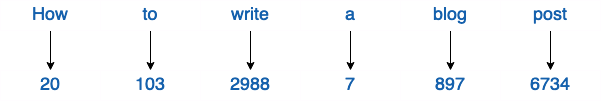

【nlp】3.2 Transformer论文复现:1. 输入部分(文本嵌入层和位置编码器)

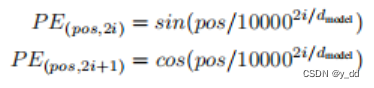

Transformer论文复现:输入部分(文本嵌入层和位置编码器) 1 输入复现1.1 文本嵌入层1.1.1 文本嵌入层的作用1.1.2 文本嵌入层的代码实现1.1.3 文本嵌入层中的注意事项1.2 位置编码器1.2.1 位置编码器的作用1.2.2 位置编码器的代码实现1.2.3 位置编码器中的注意事项1 输入复现…

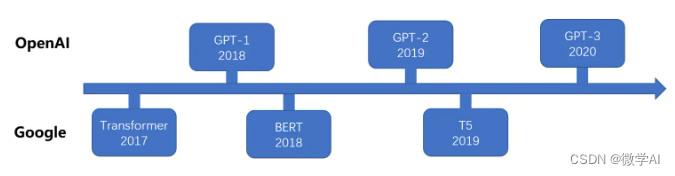

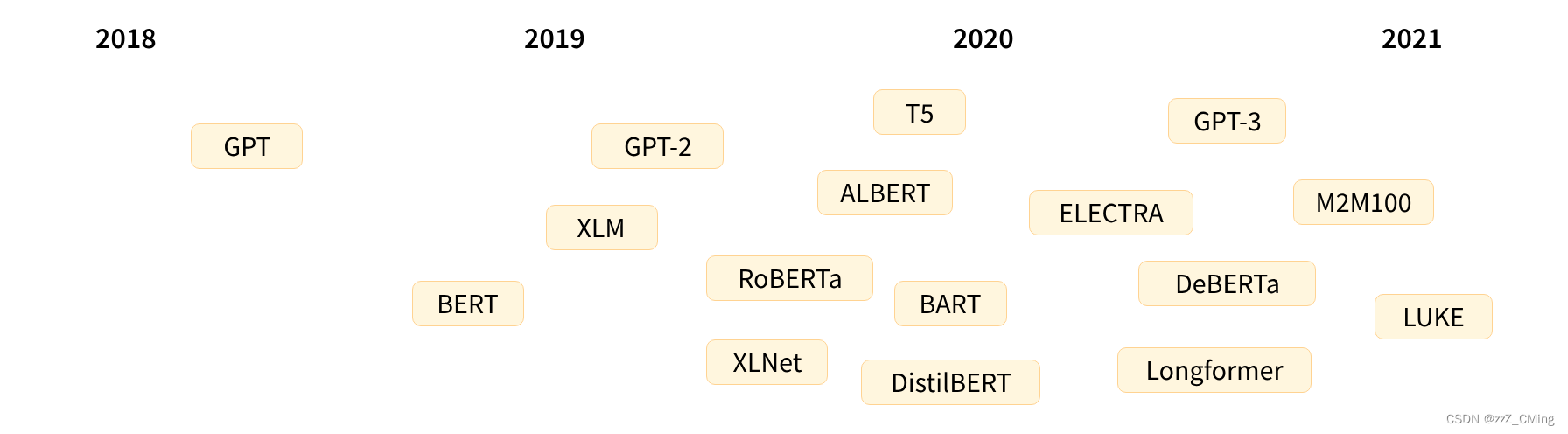

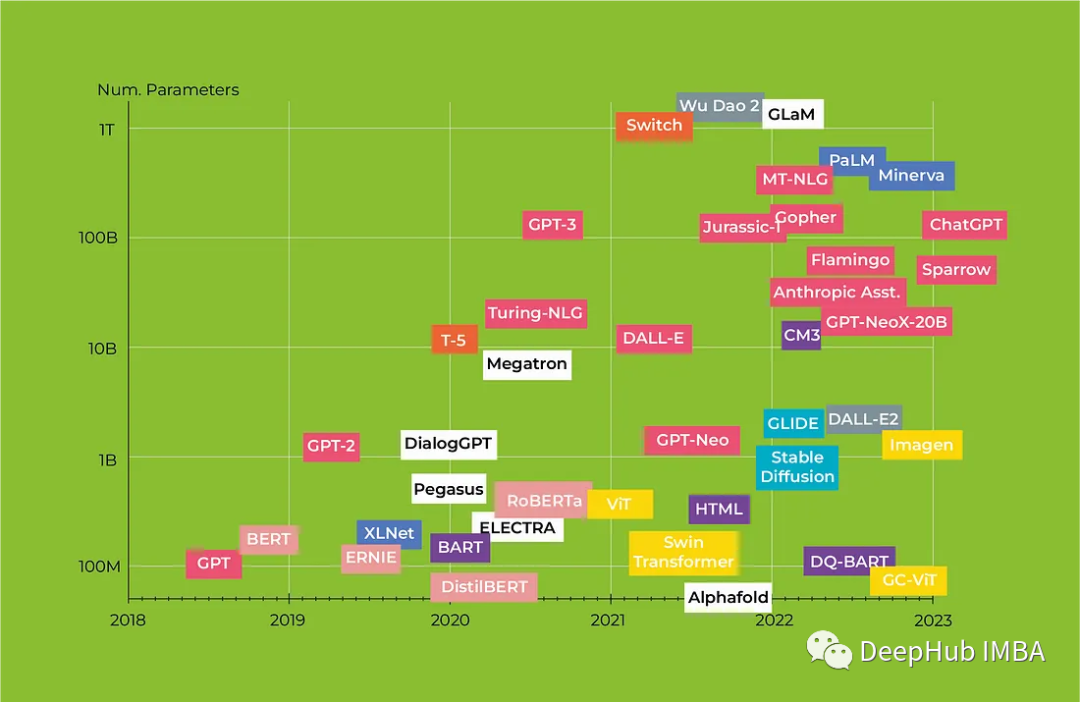

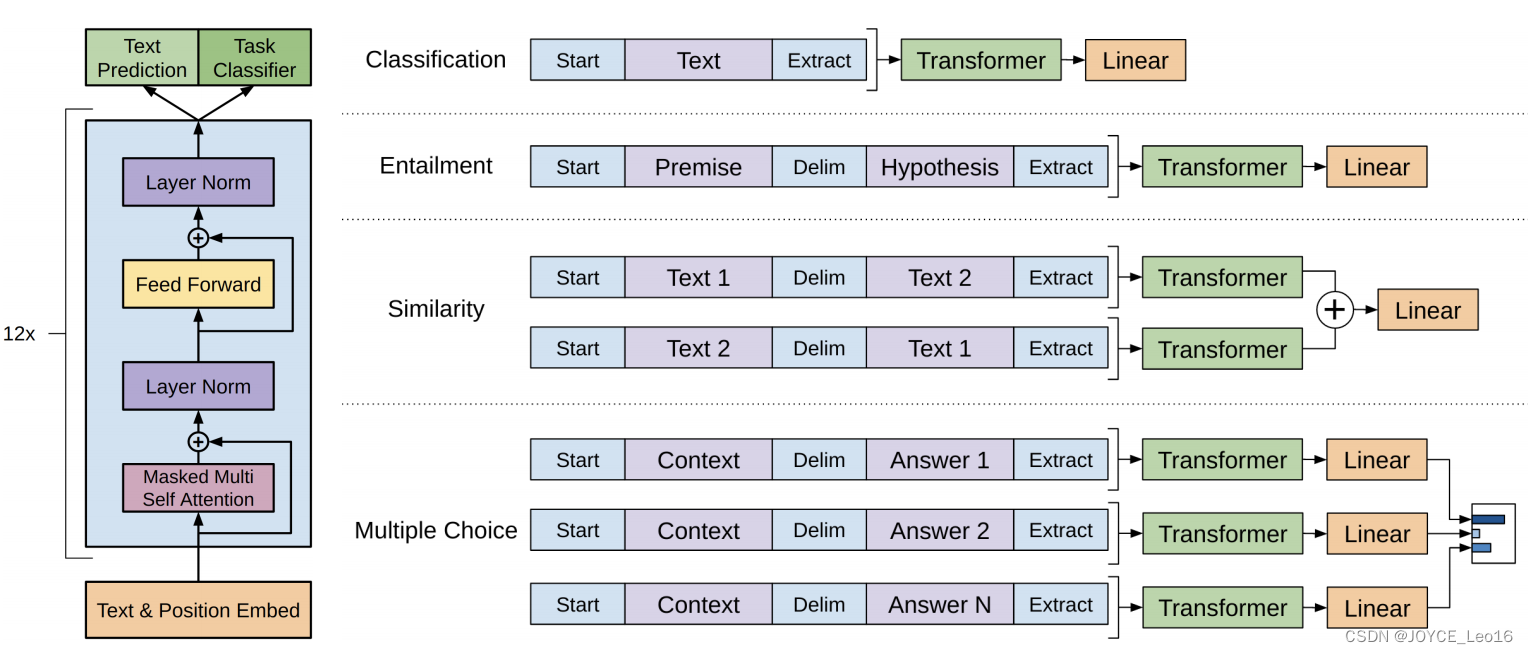

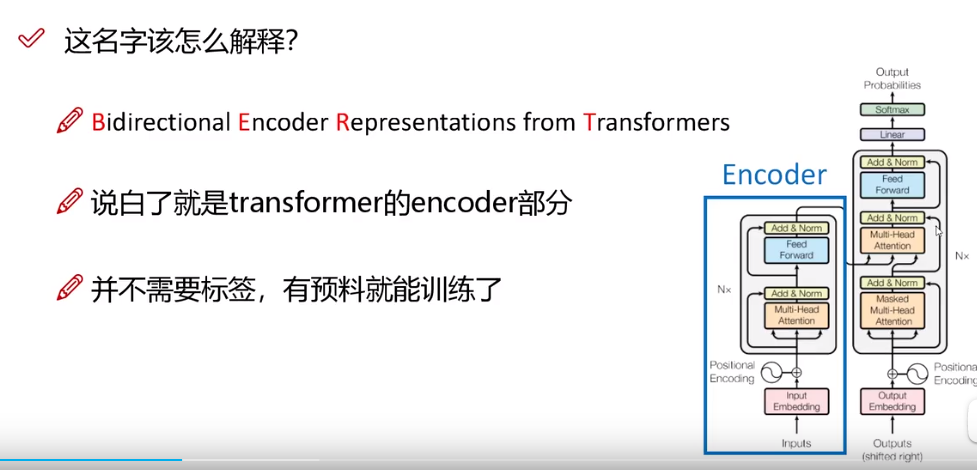

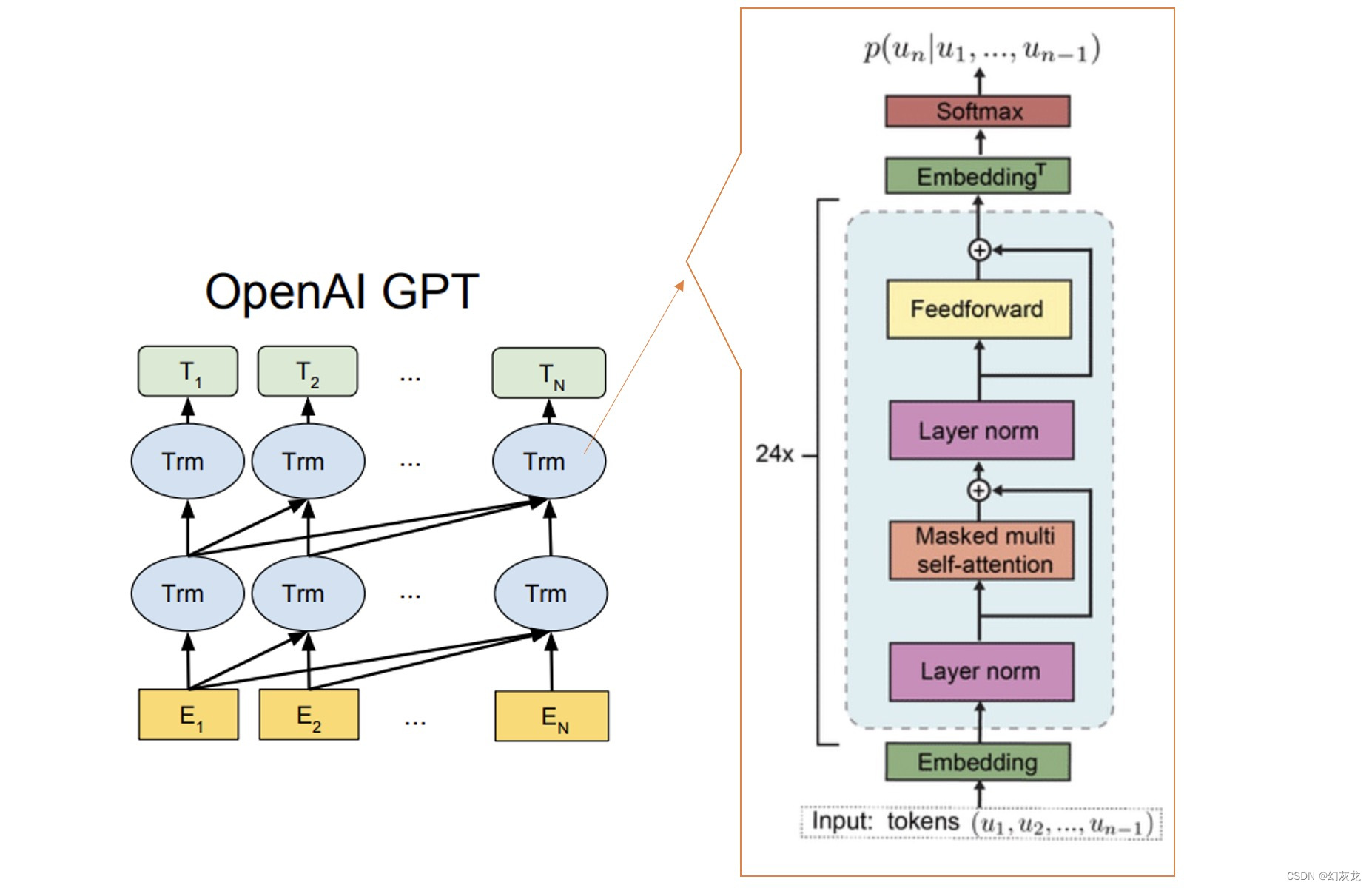

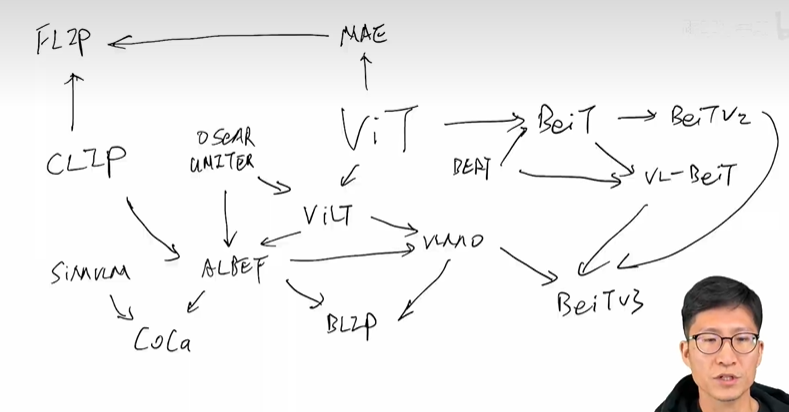

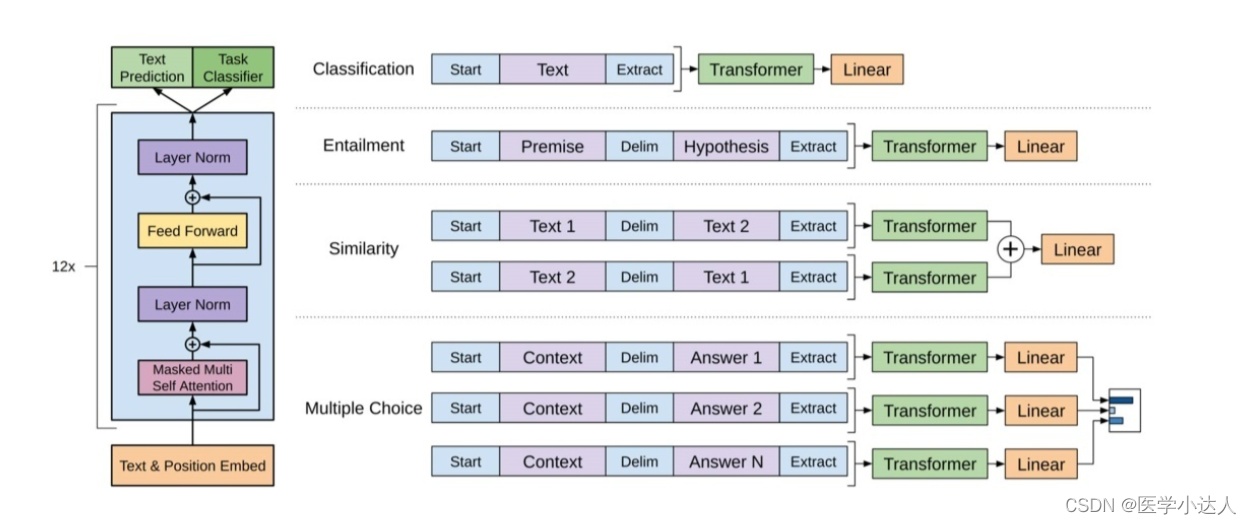

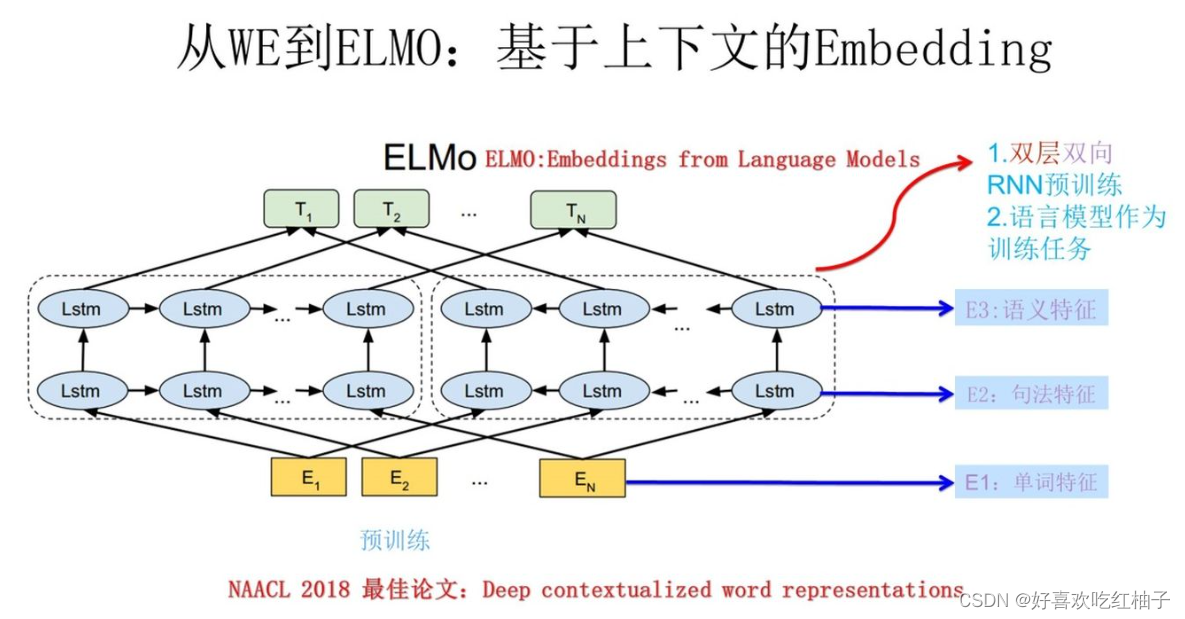

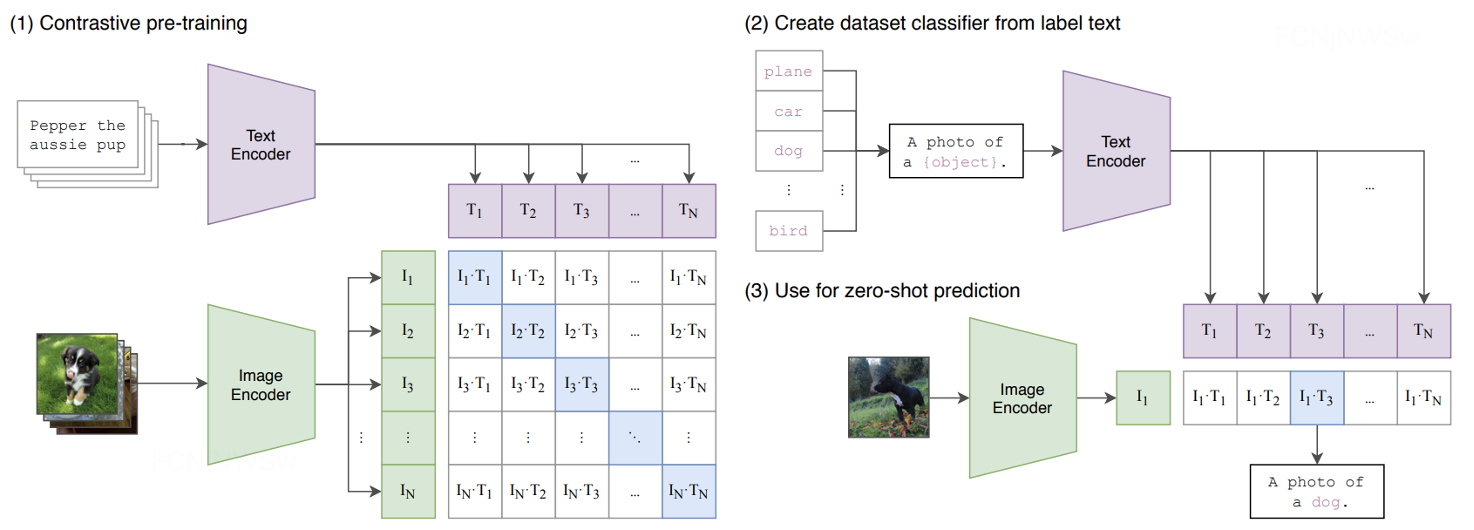

自然语言处理的bert, GPT, GPT-2, transformer, ELMo, attention机制都是些何方神圣???

2018年是NLP领域巨变的一年,这个好像我们都知道,但是究竟是哪里剧变了,哪里突破了?经常听大佬们若无其事地抛出一些高级的概念,你却插不上嘴,隐隐约约知道有这么个东西,刚要开口:噢&…

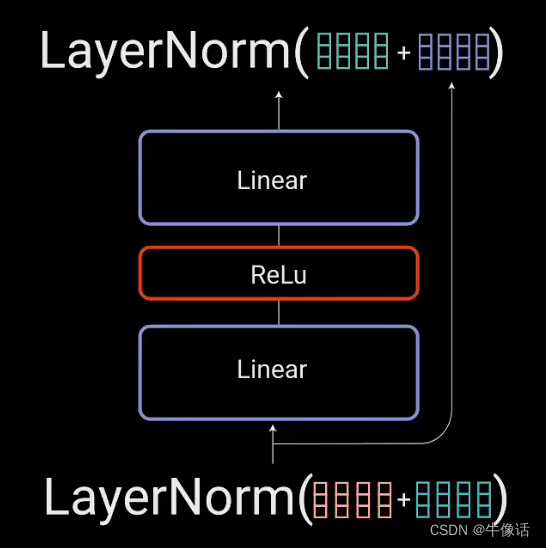

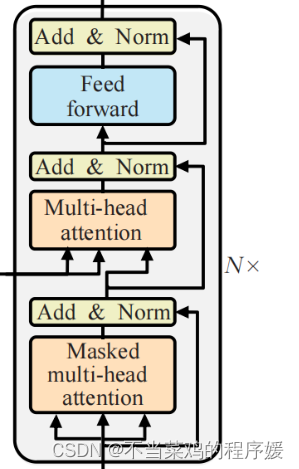

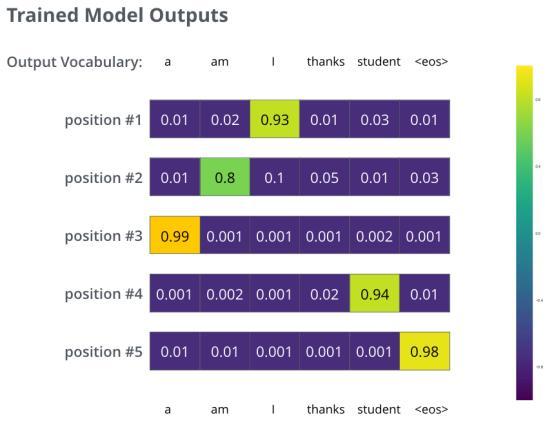

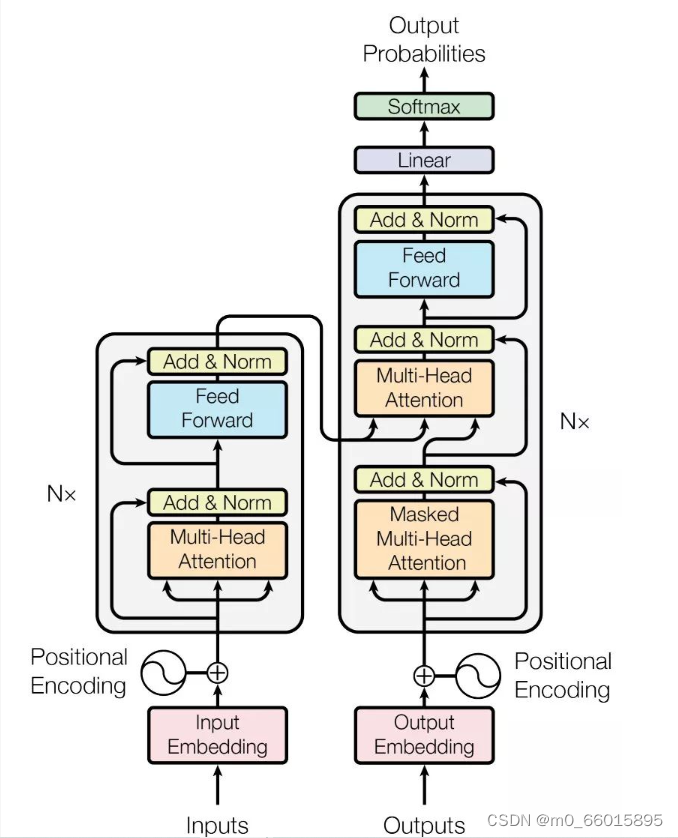

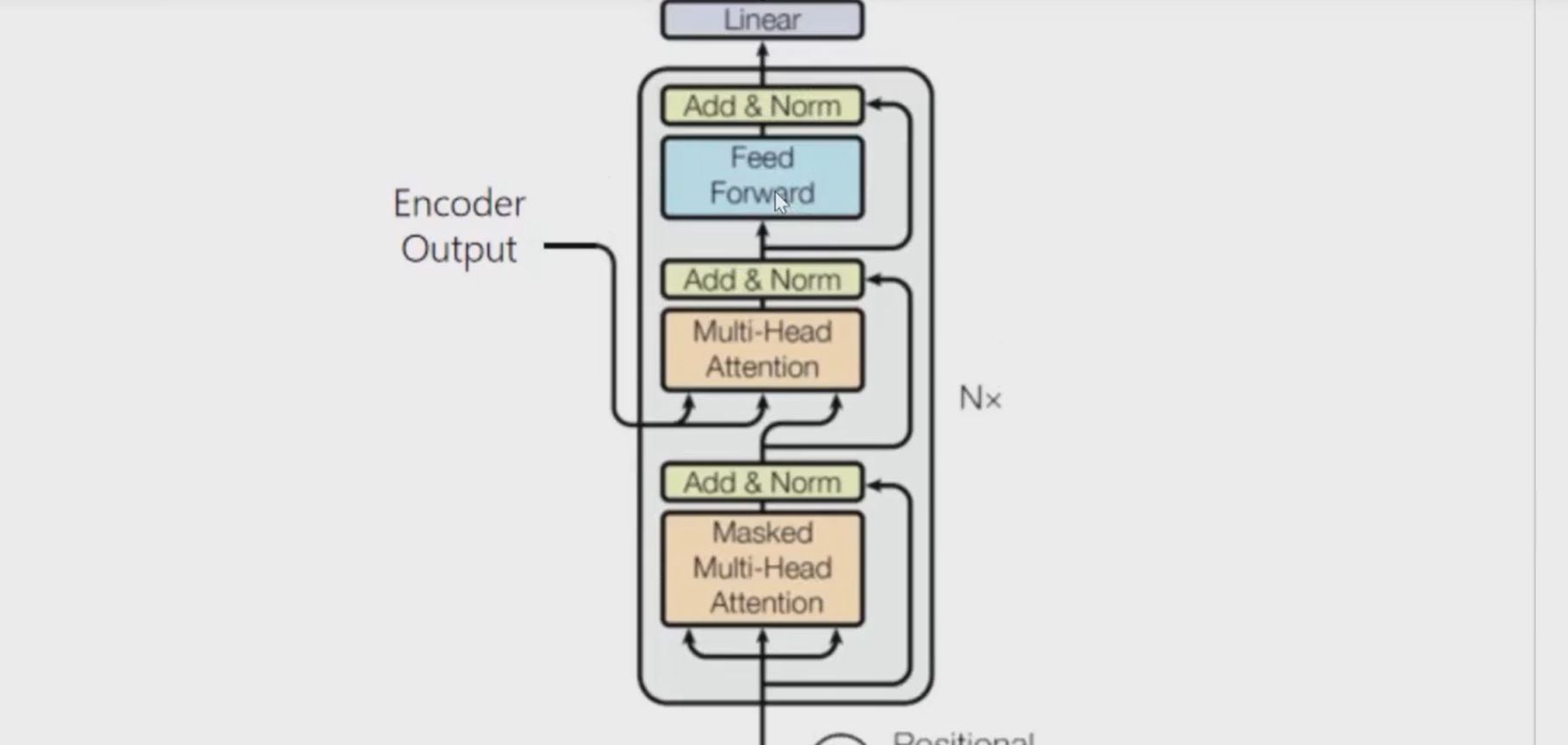

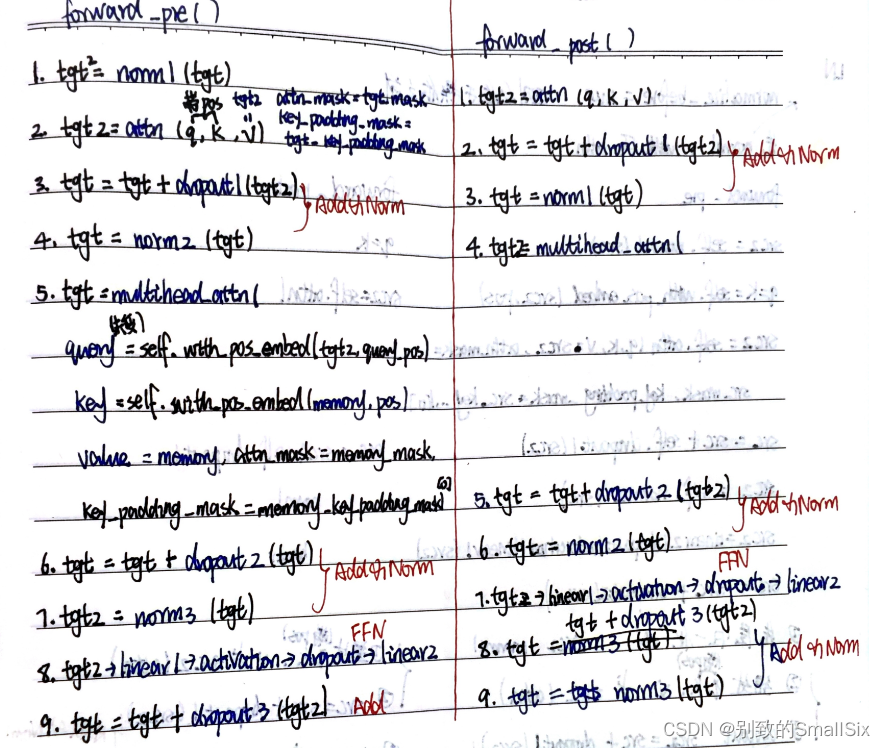

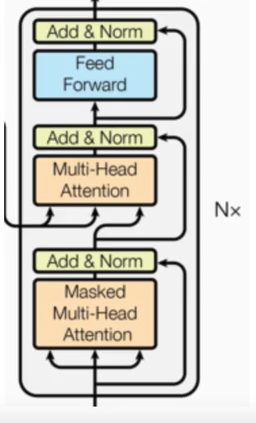

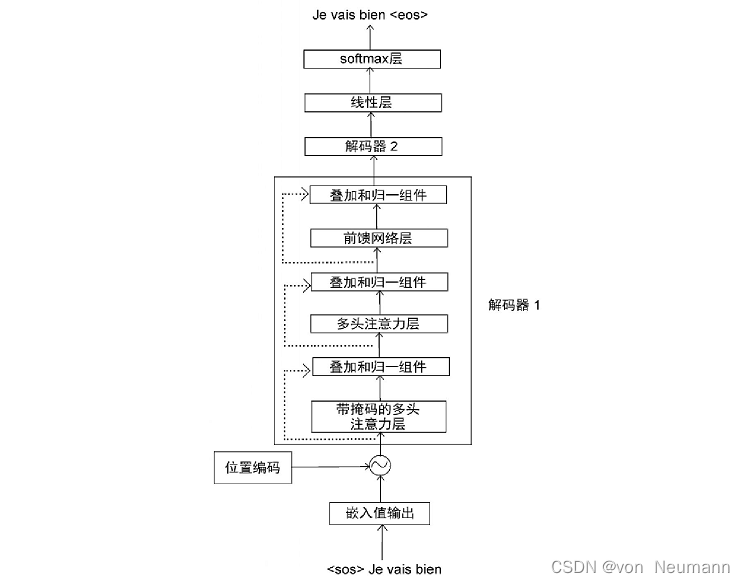

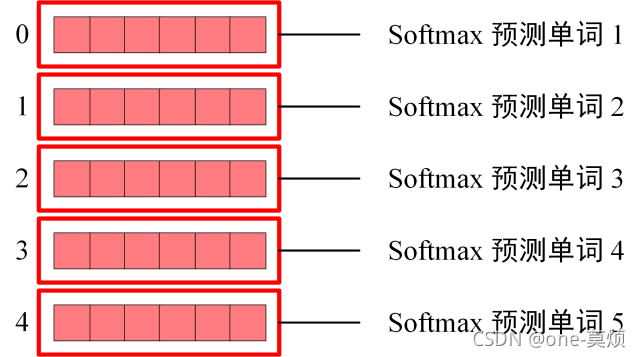

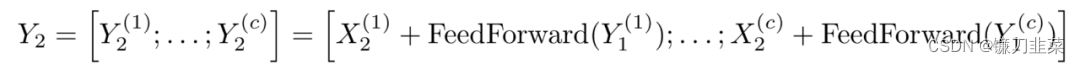

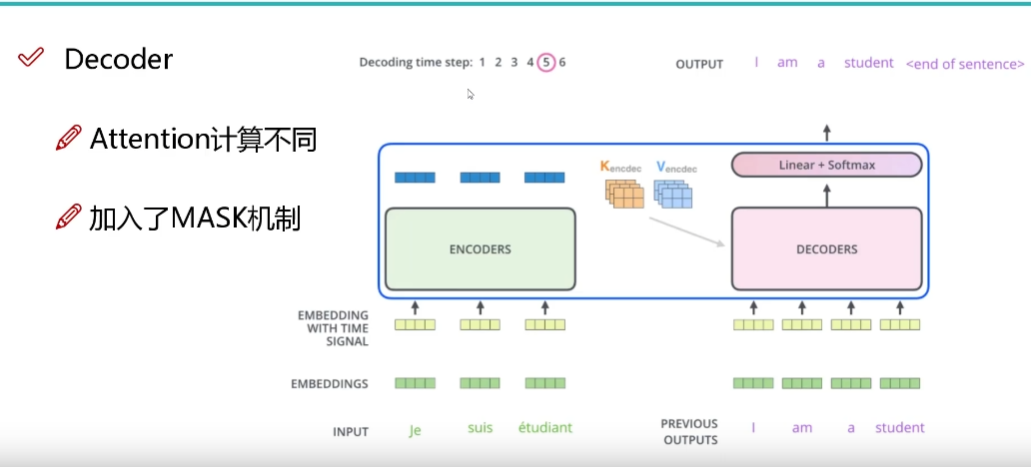

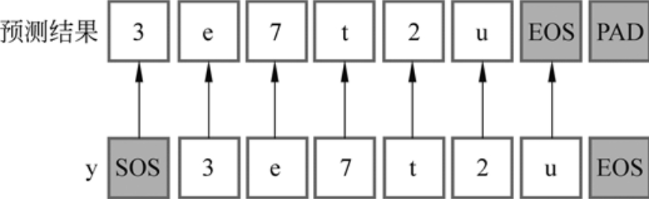

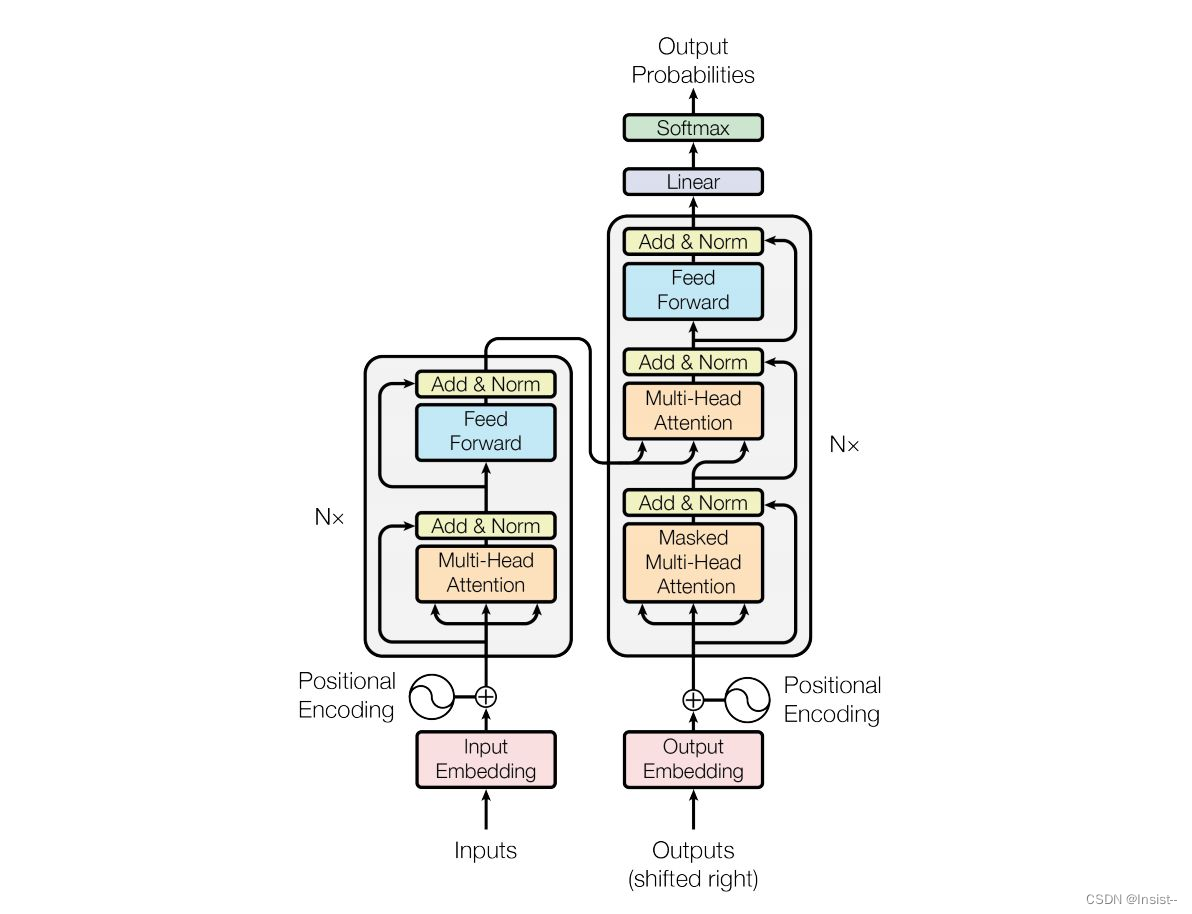

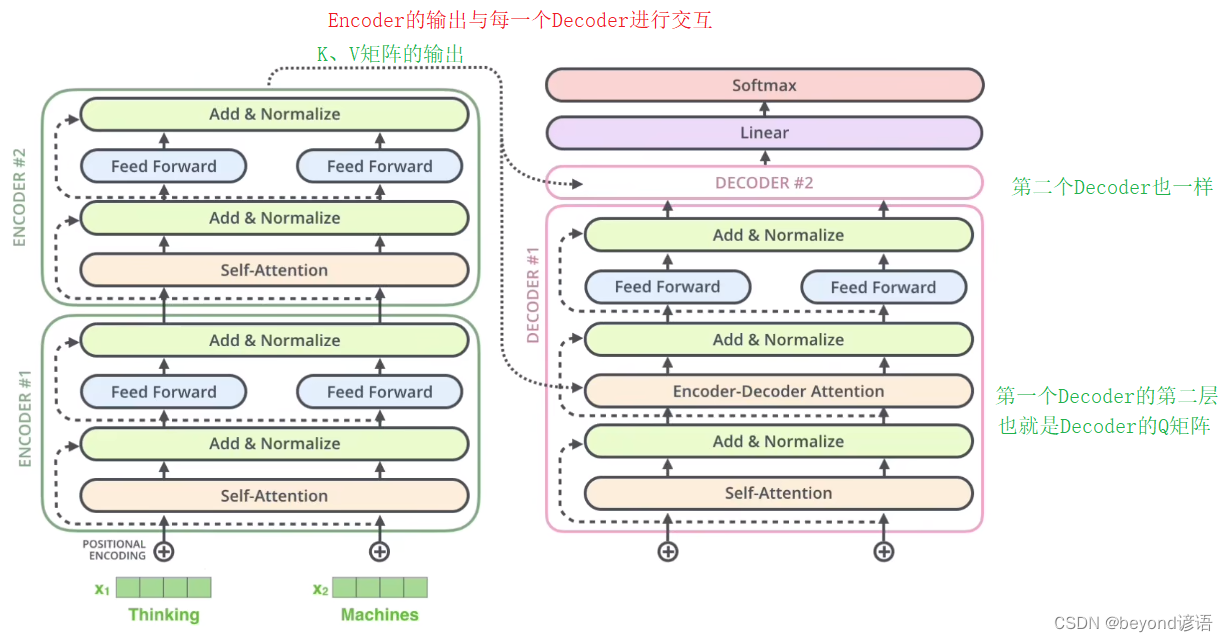

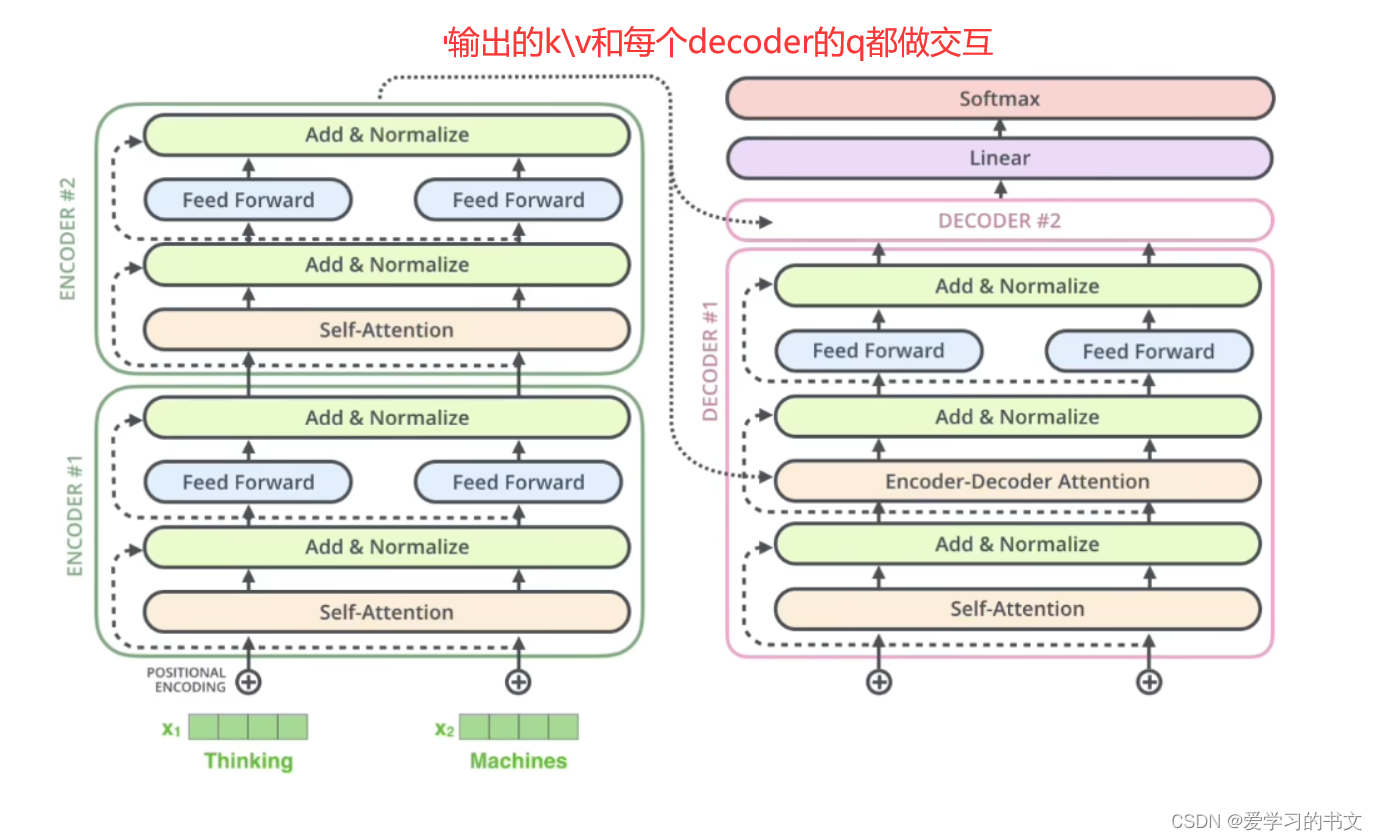

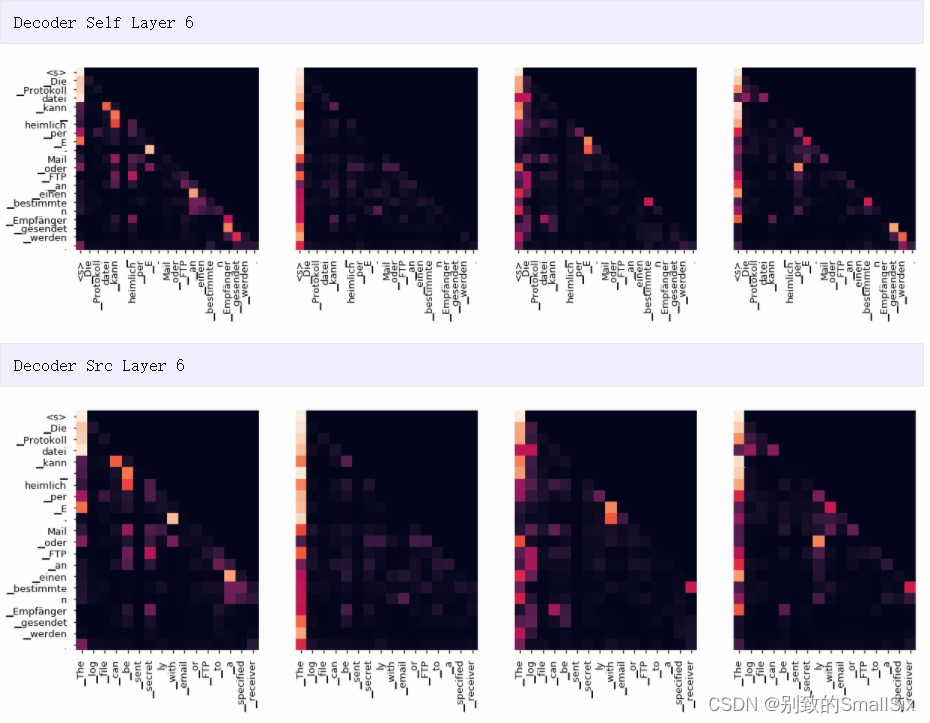

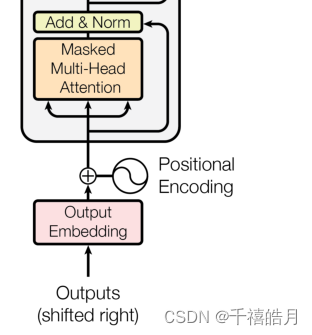

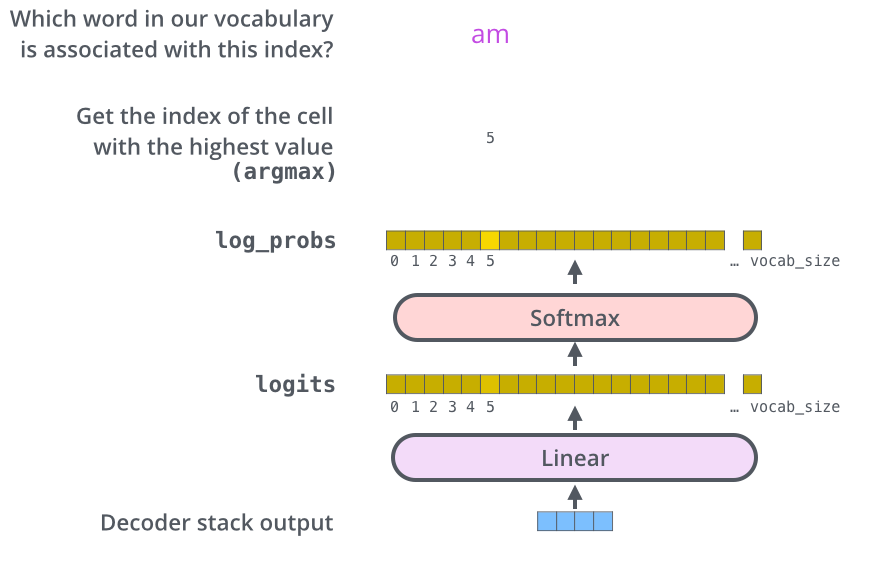

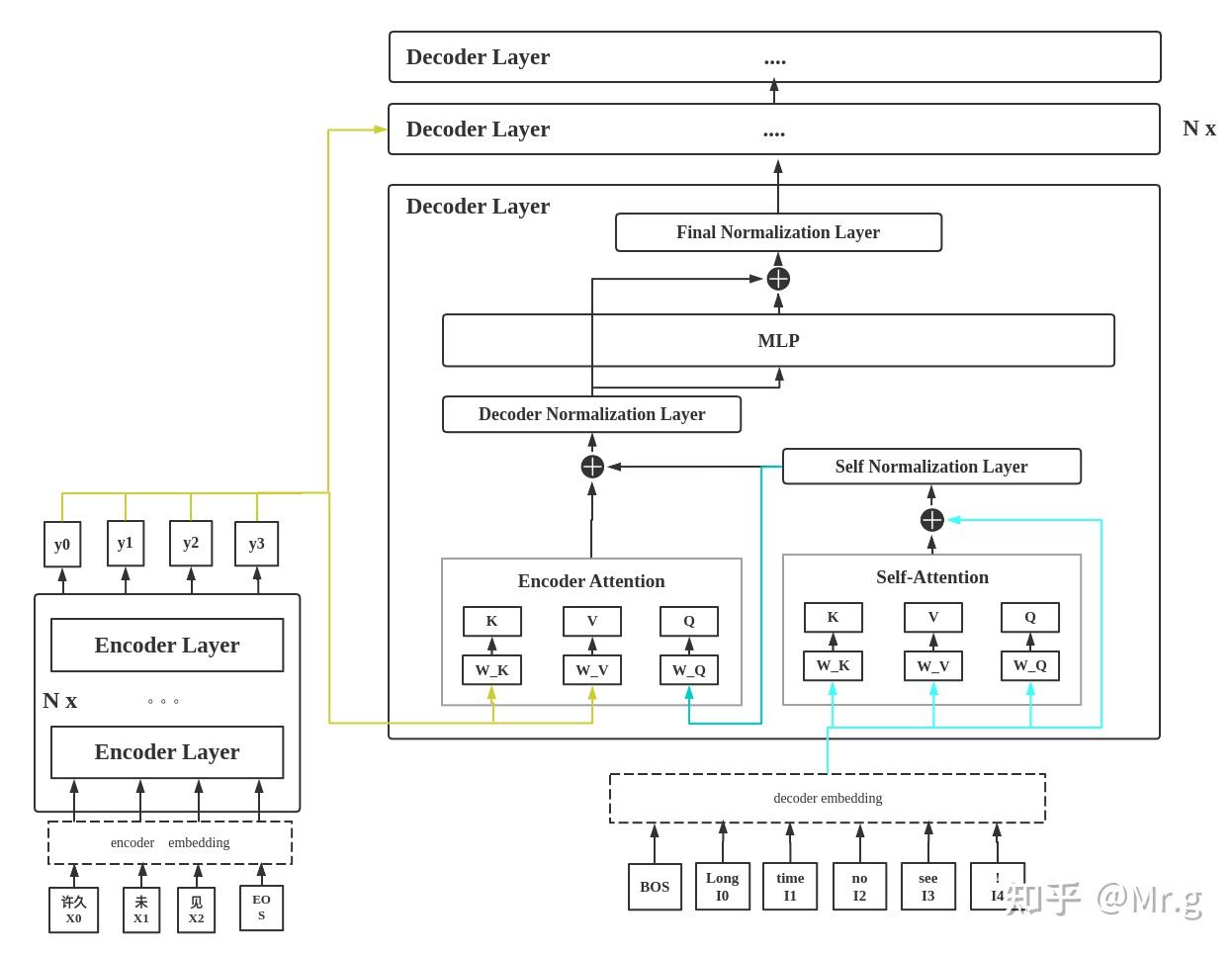

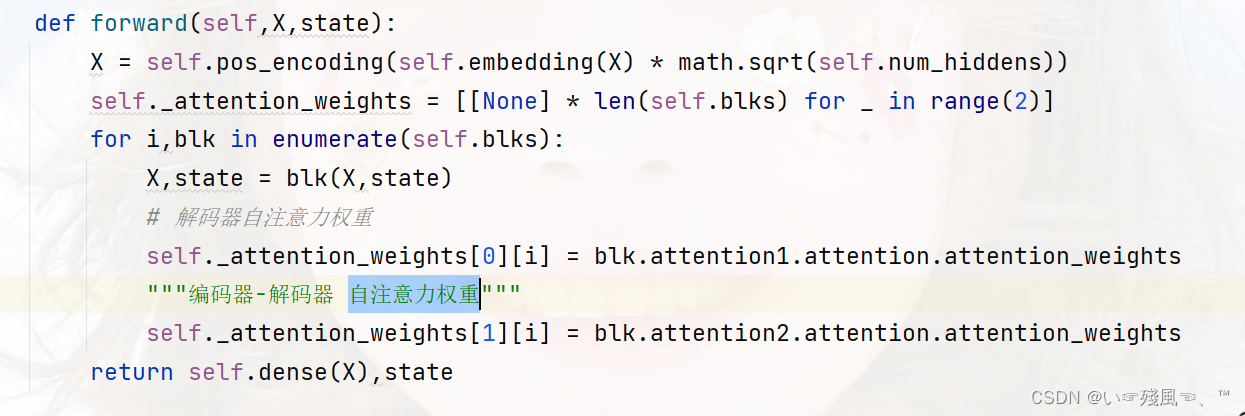

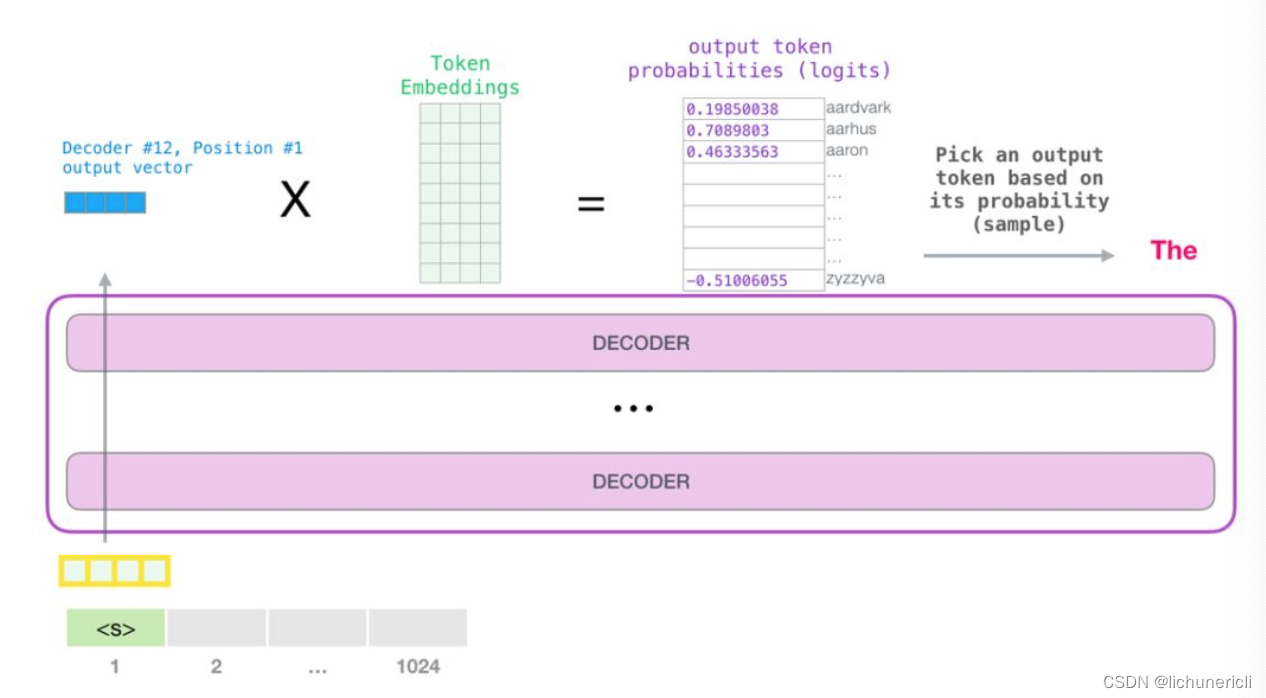

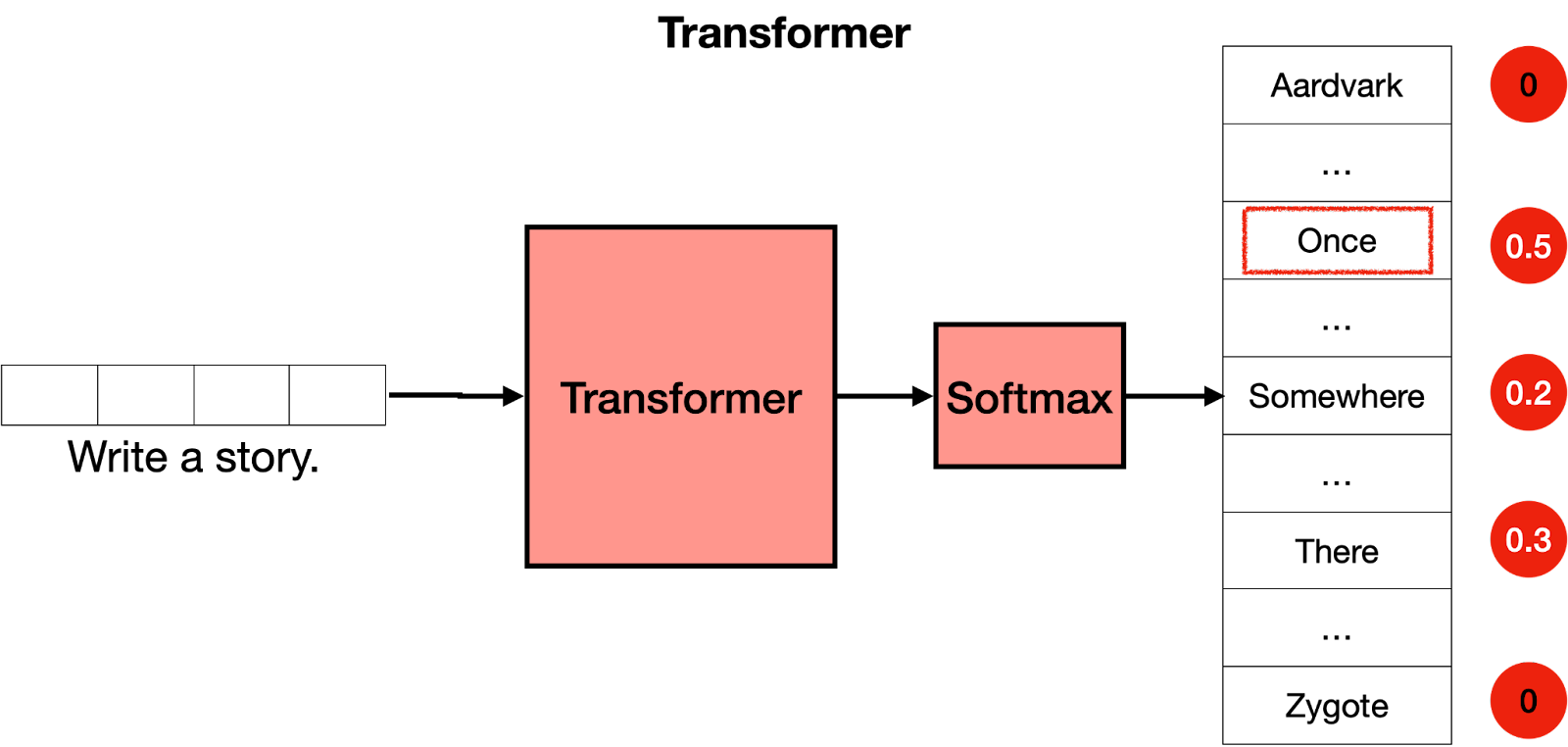

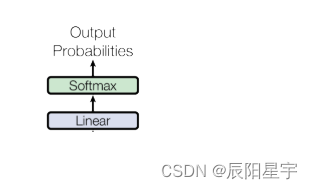

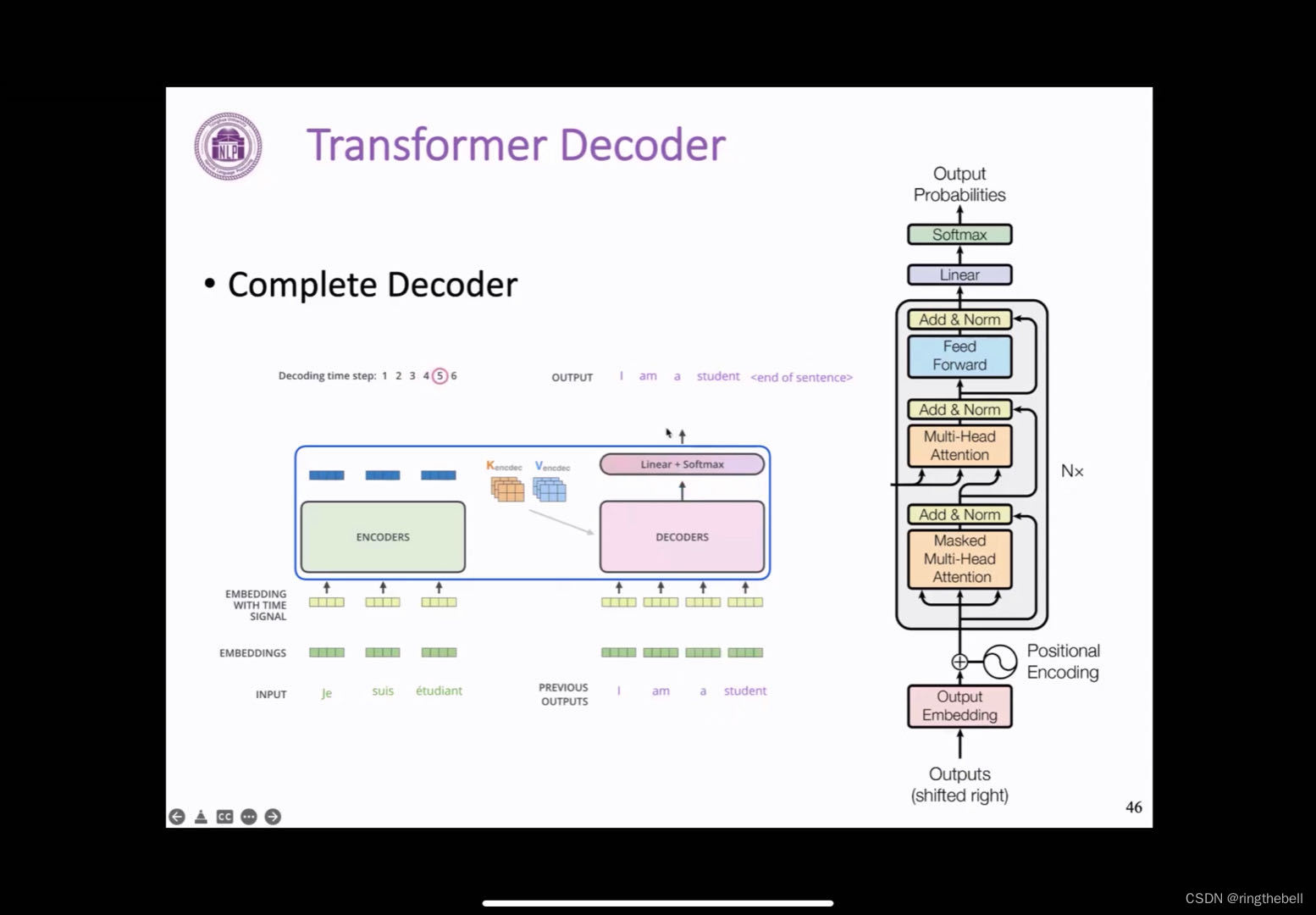

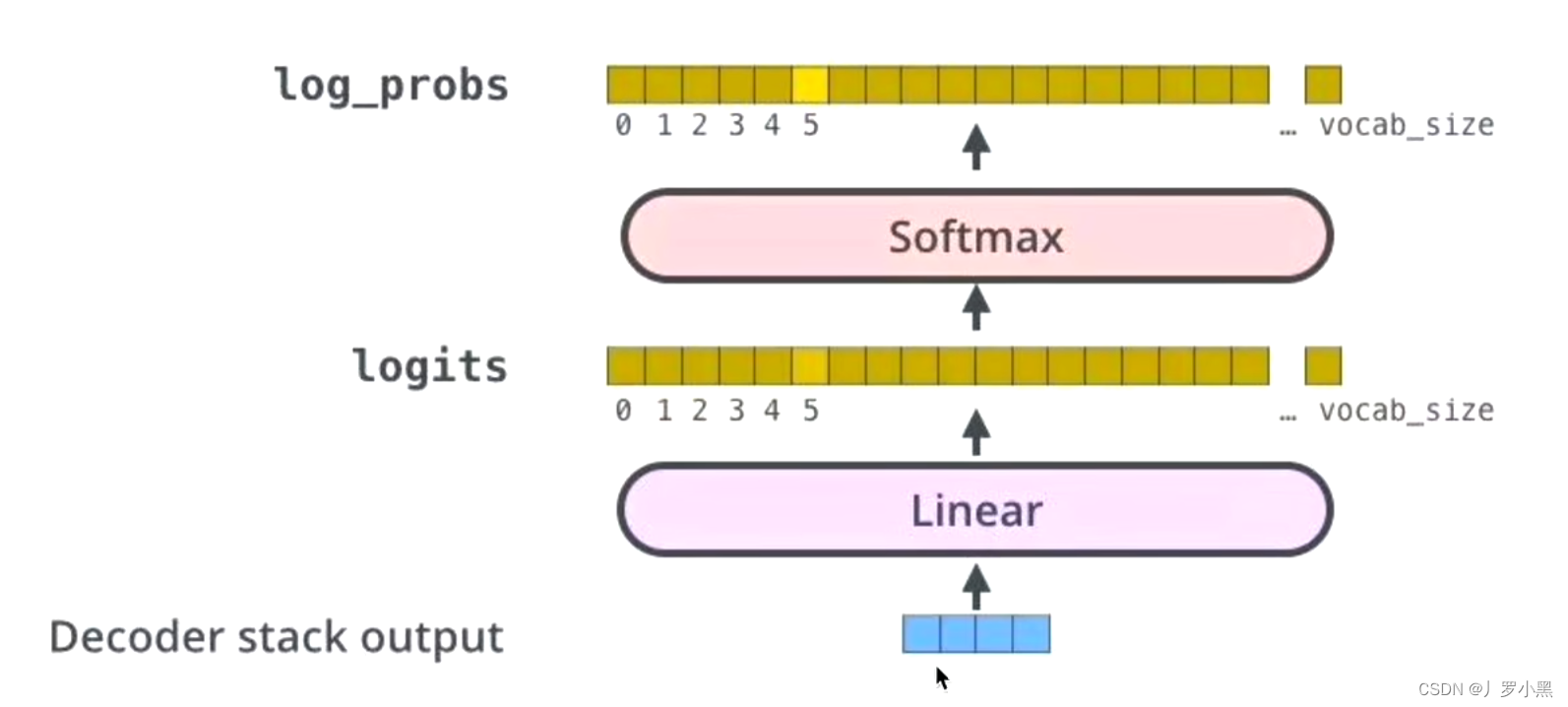

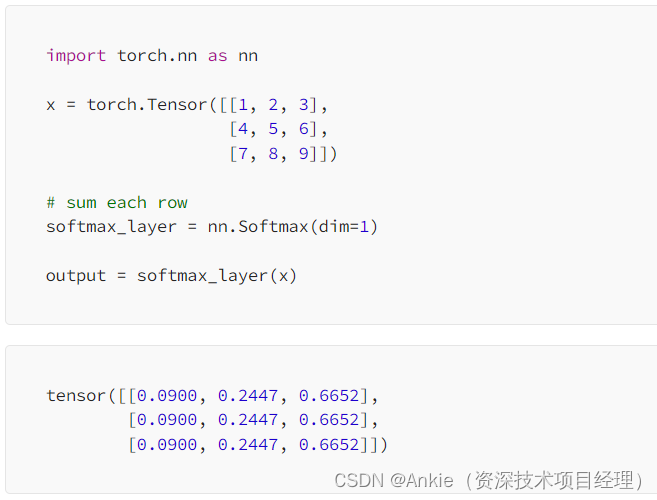

【nlp】3.5 Transformer论文复现:3.解码器部分(解码器层)和4.输出部分(线性层、softmax层)

Transformer论文复现:3.解码器部分(解码器层)和4.输出部分(线性层、softmax层) 3.1 解码器介绍3.2 解码器层3.2.1 解码器层的作用3.2.2 解码器层的代码实现3.2.3 解码器层总结3.3 解码器3.3.1 解码器的作用3.3.2 解码器的代码实现3.3.3 解码器总结4.1 输出部分介绍4.2 线性…

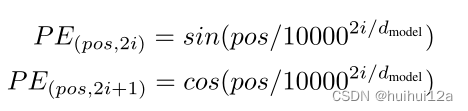

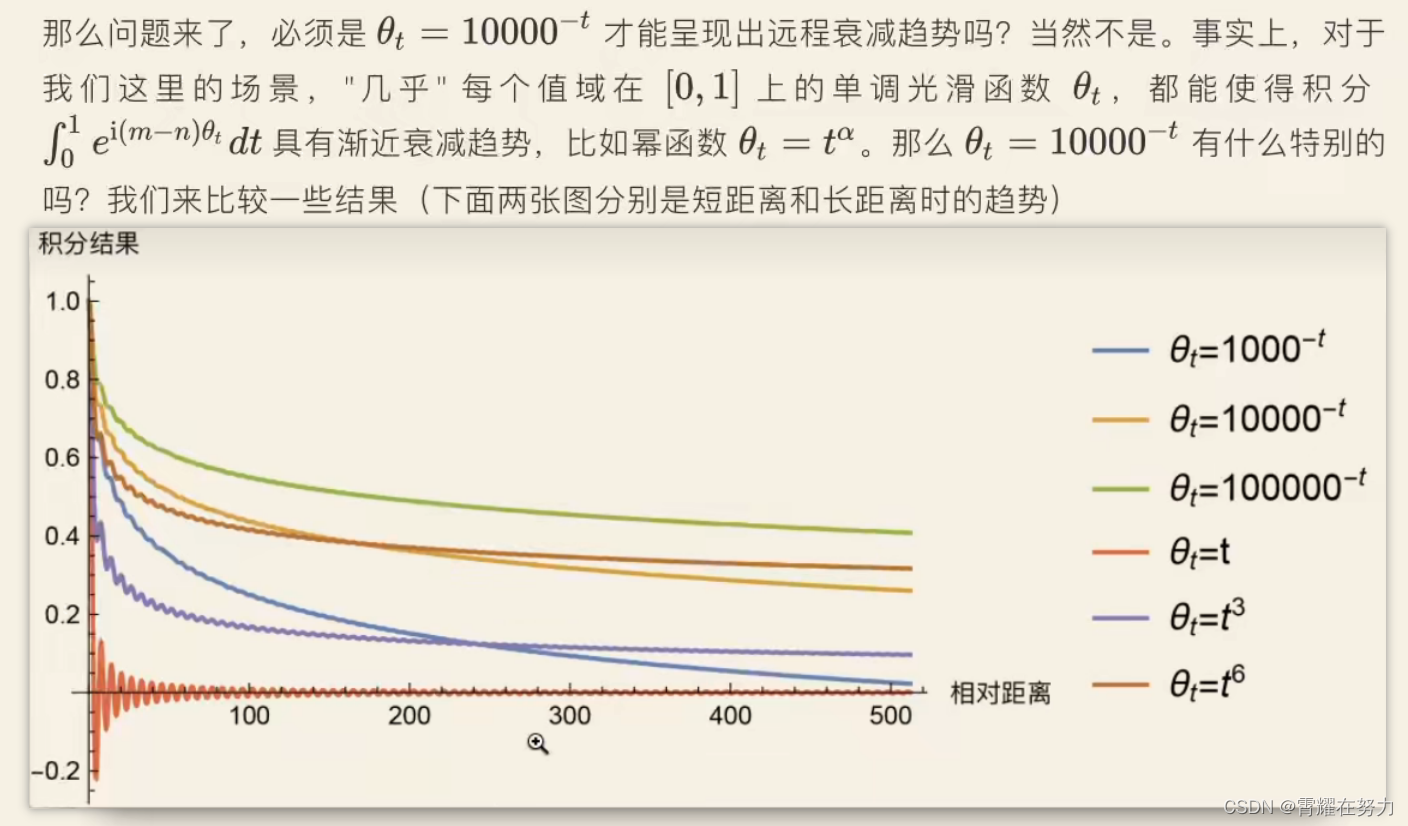

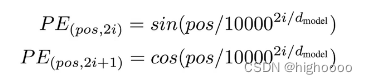

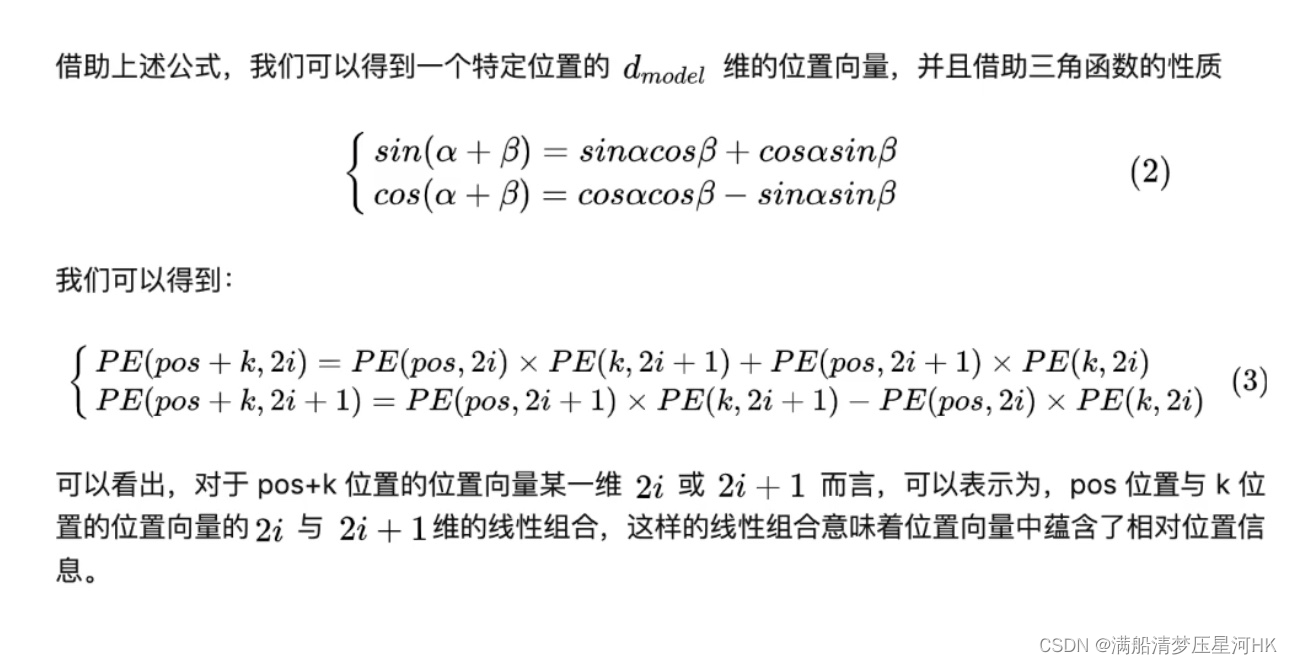

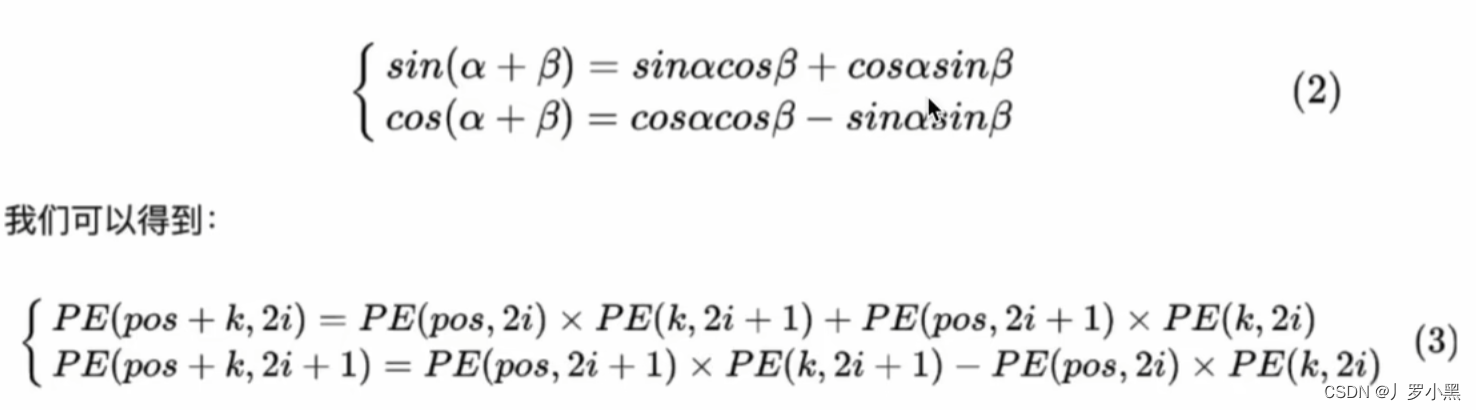

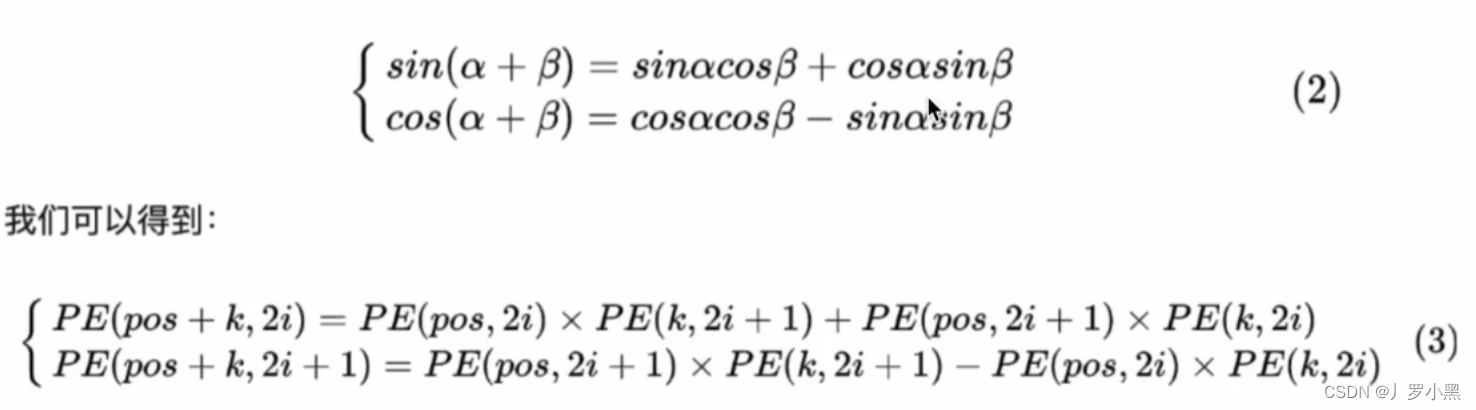

1401 位置编码公式详细理解补充

博客配套视频链接: https://space.bilibili.com/383551518?spm_id_from=333.1007.0.0 b 站直接看 配套 github 链接:https://github.com/nickchen121/Pre-training-language-model 配套博客链接:https://www.cnblogs.com/nickchen121/p/15105048.html Self-Attention:对于每…

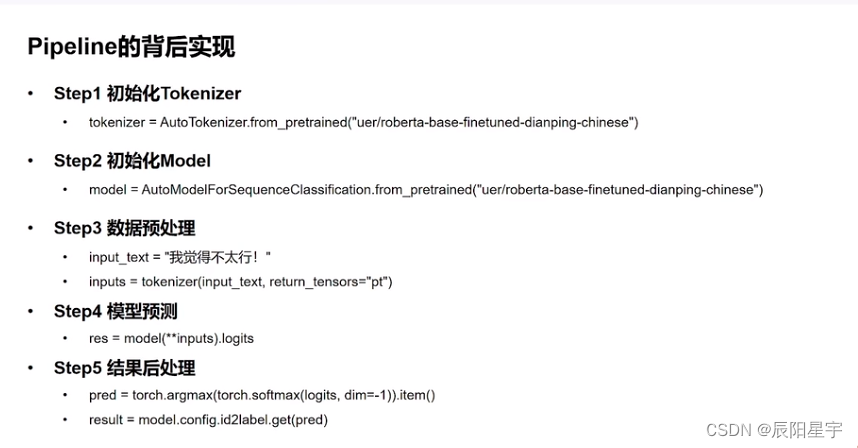

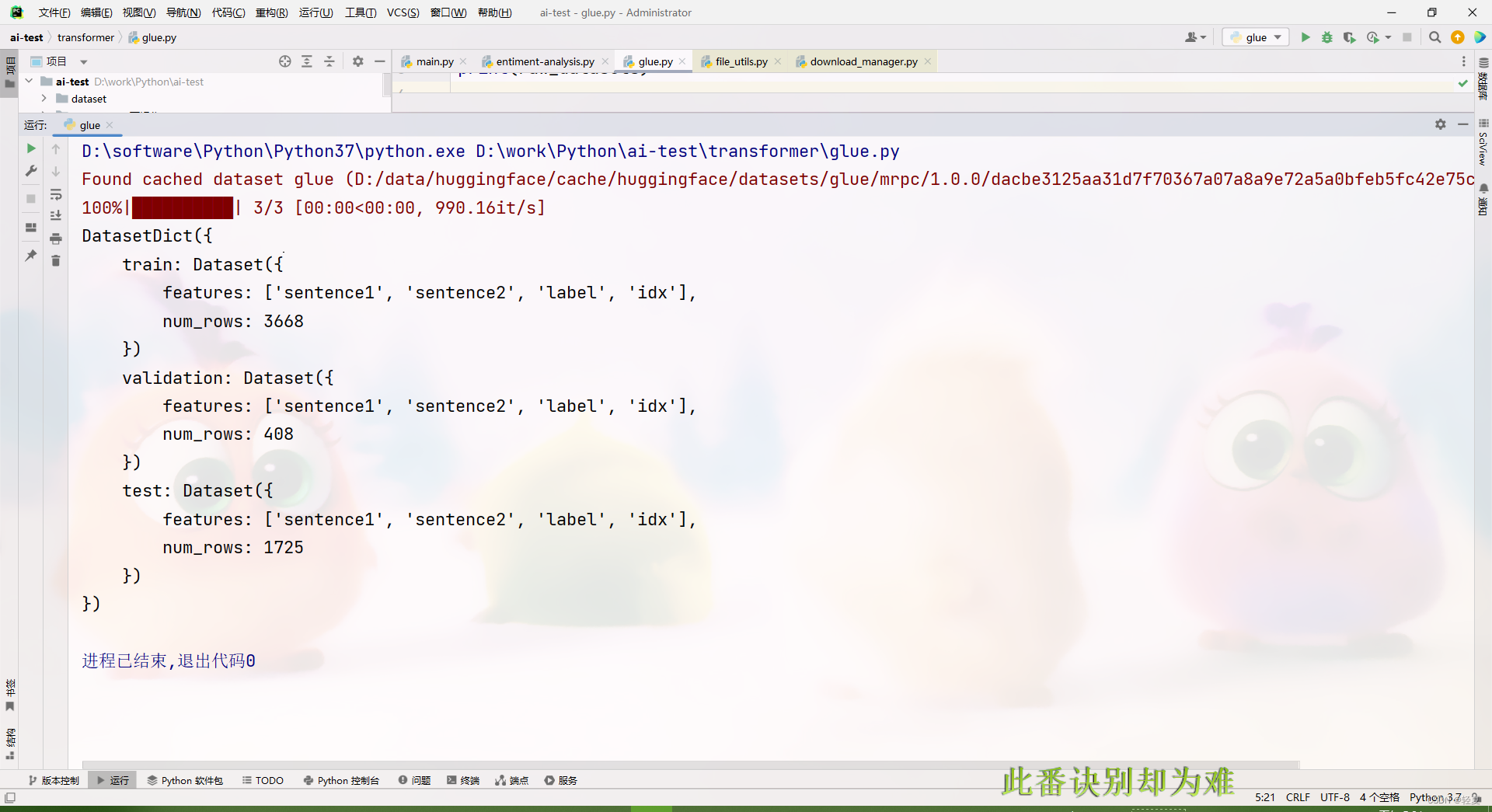

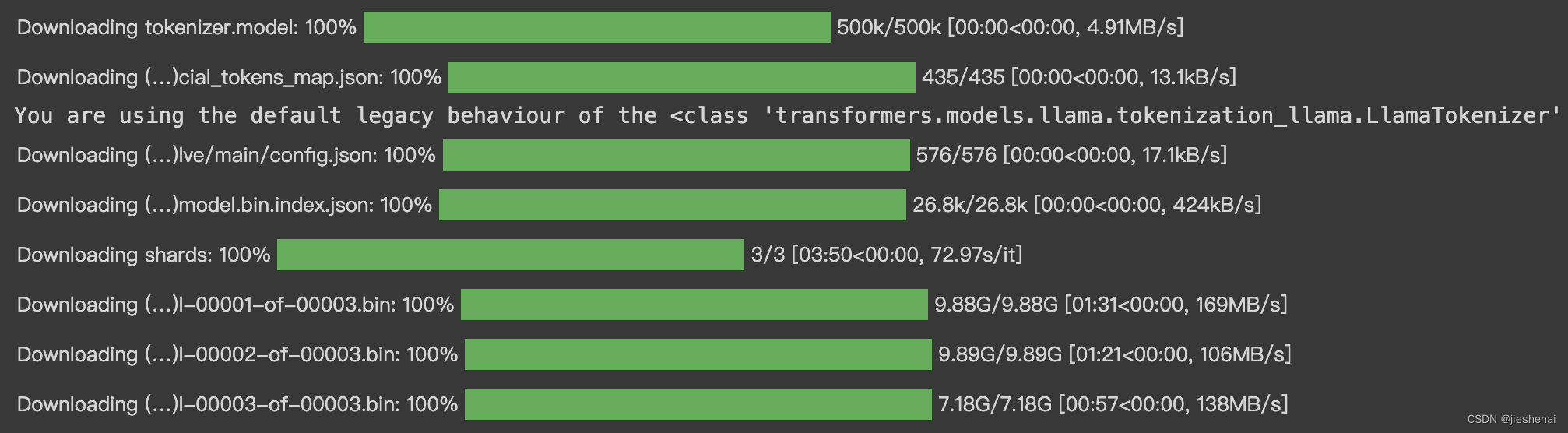

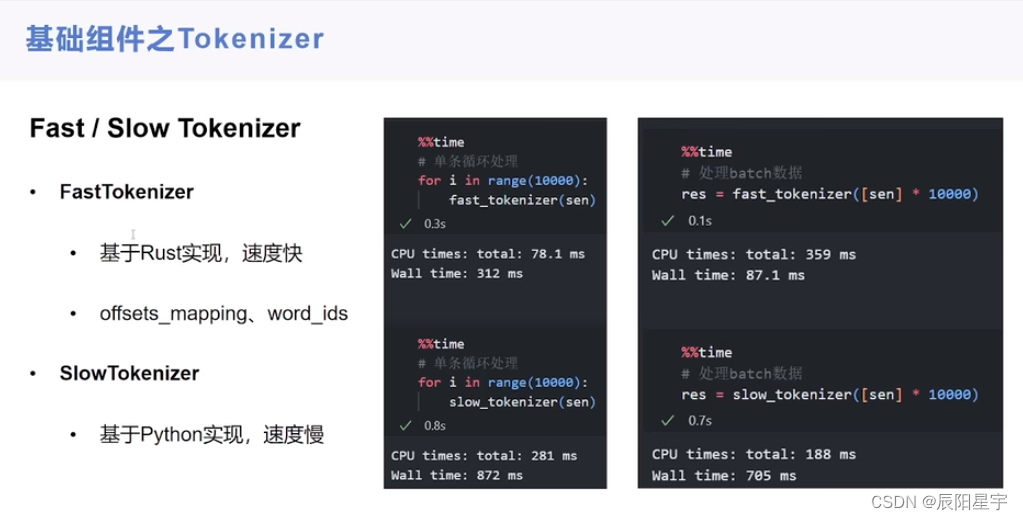

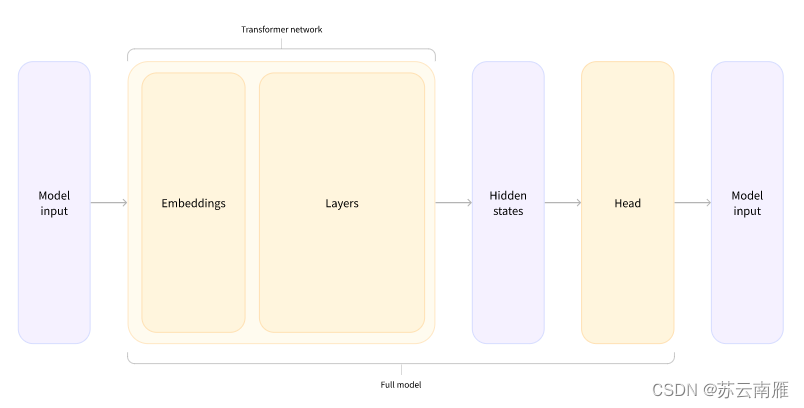

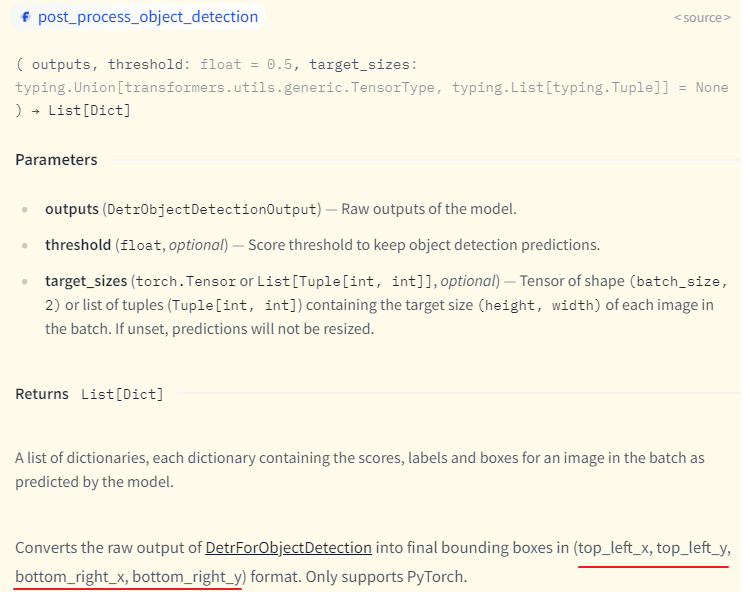

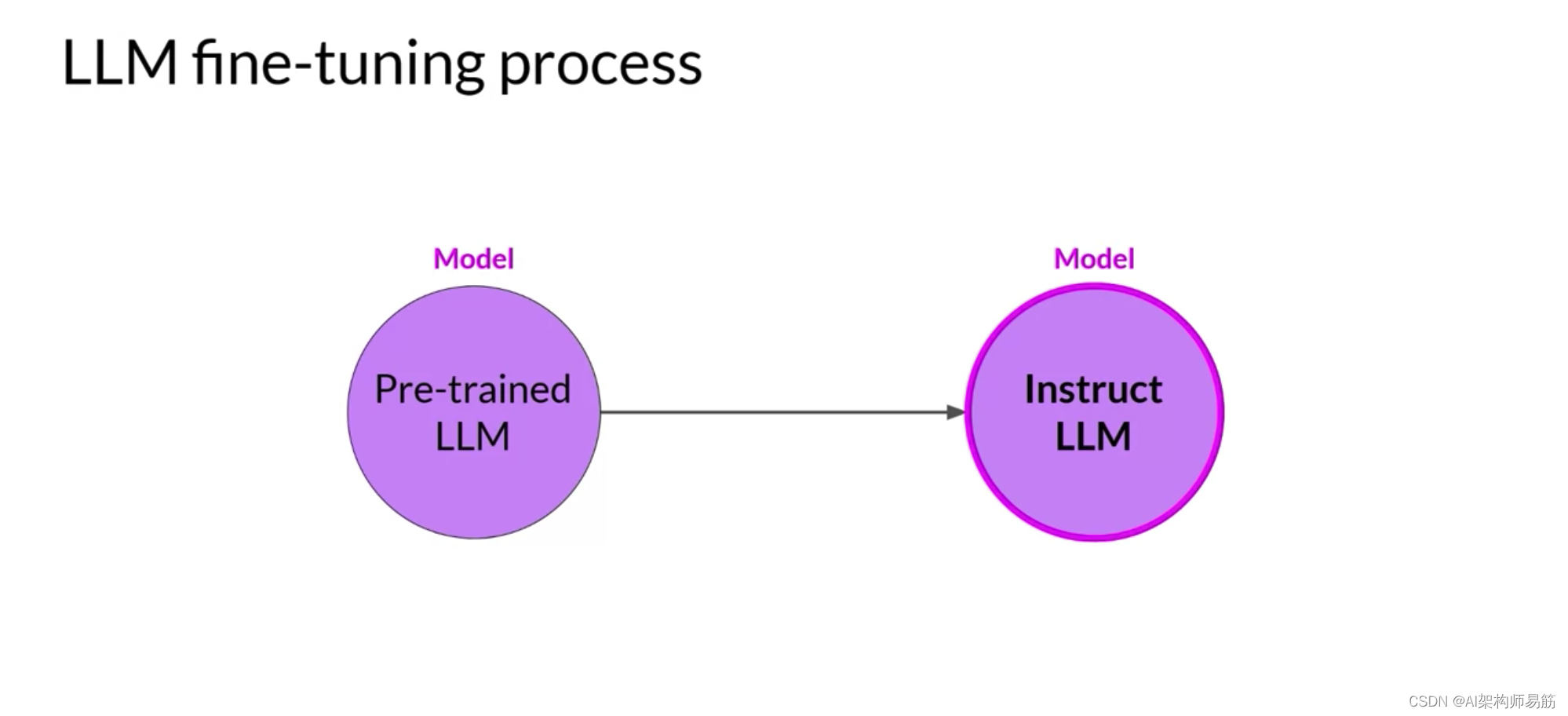

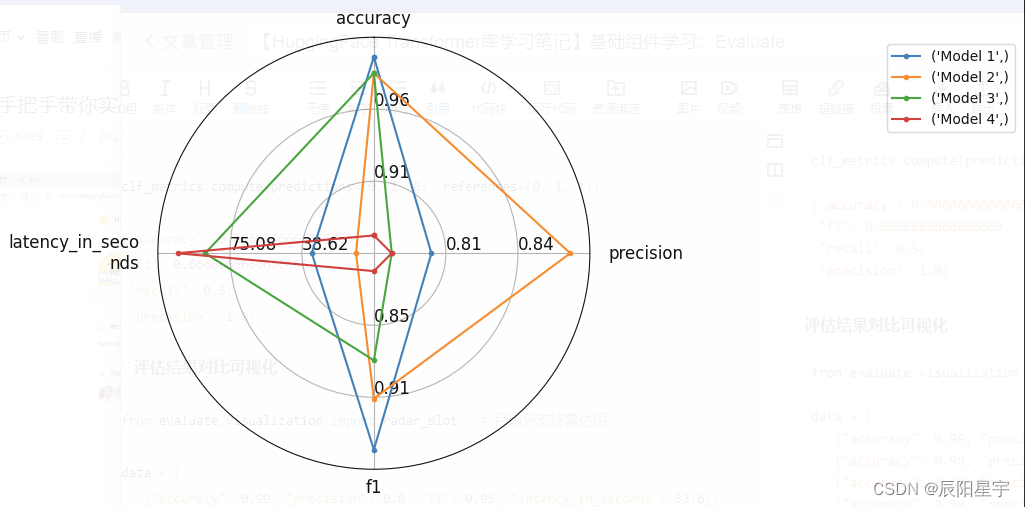

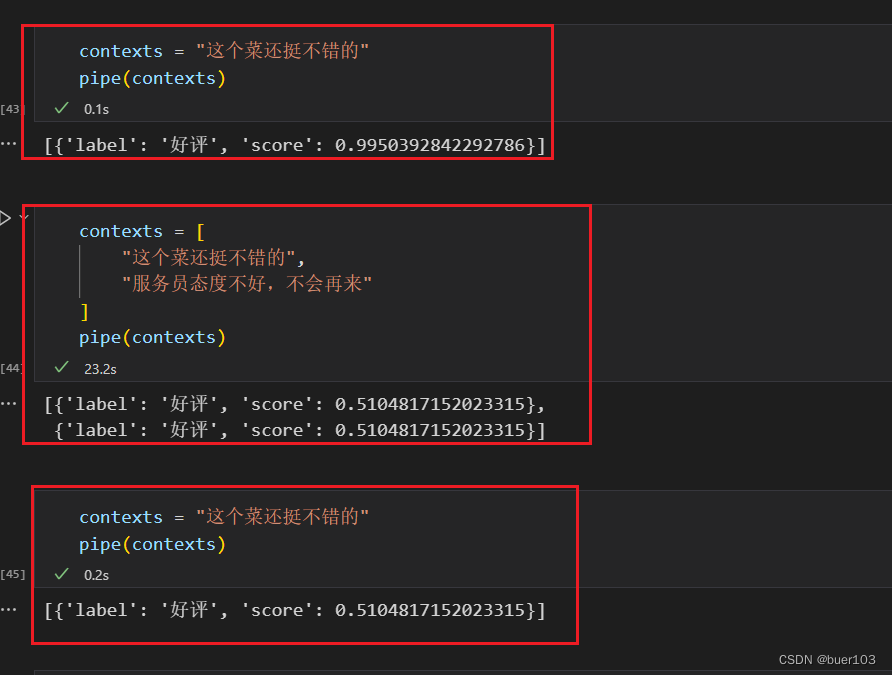

【HuggingFace Transformer库学习笔记】基础组件学习:pipeline

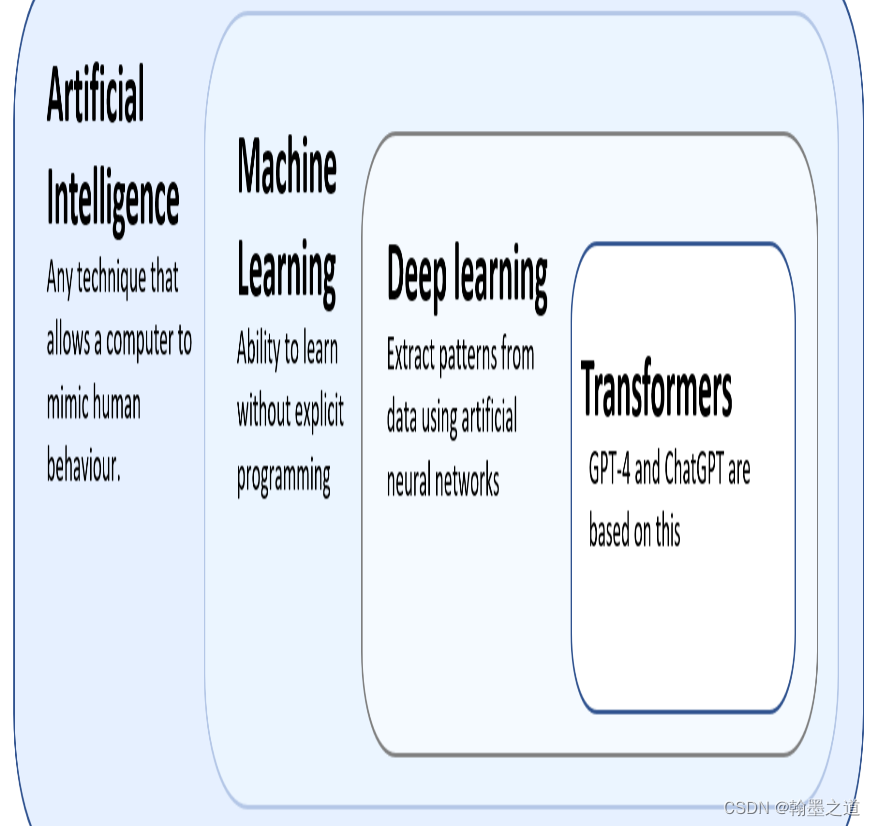

一、Transformer基础知识 pip install transformers datasets evaluate peft accelerate gradio optimum sentencepiece

pip install jupyterlab scikit-learn pandas matplotlib tensorboard nltk rouge在host文件里添加途中信息,可以避免运行代码下载模型时候报错…

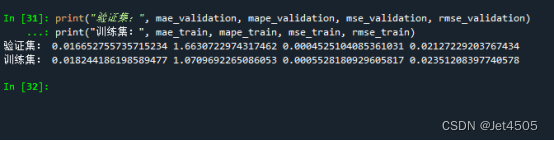

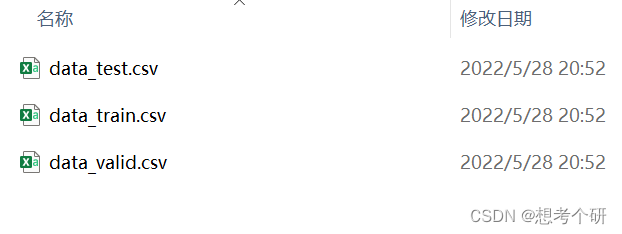

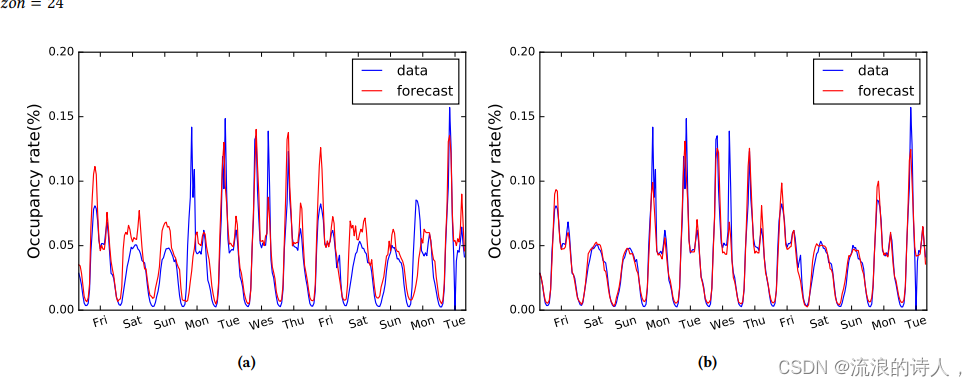

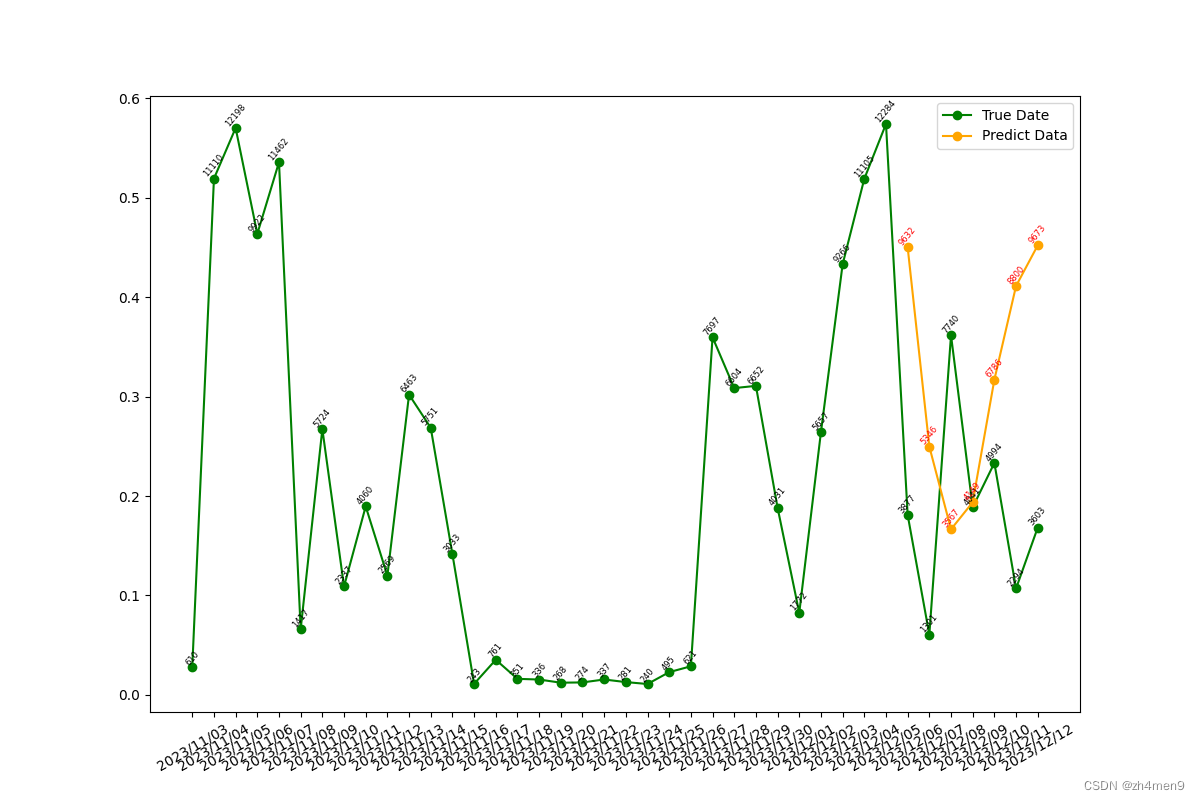

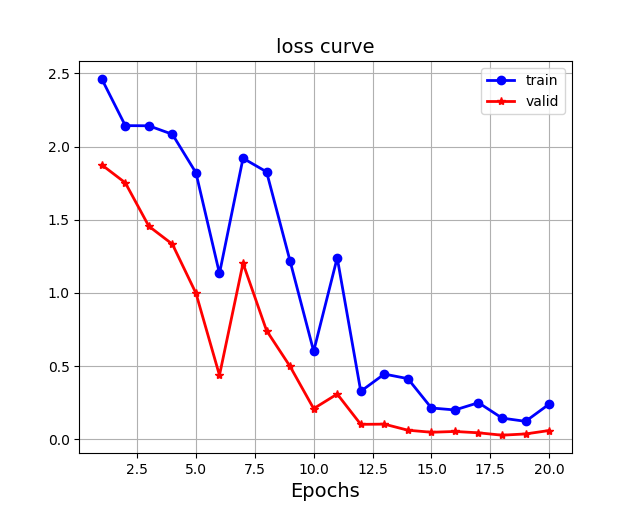

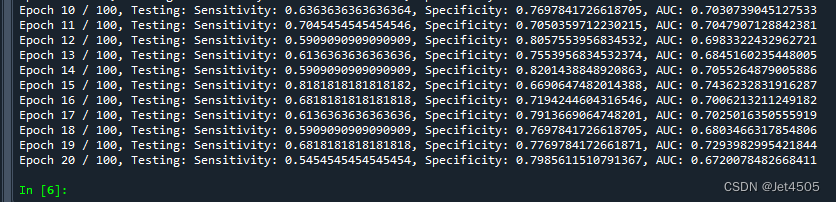

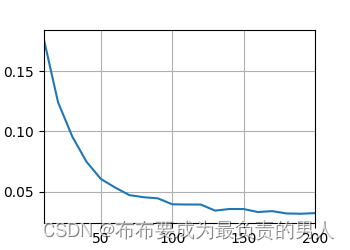

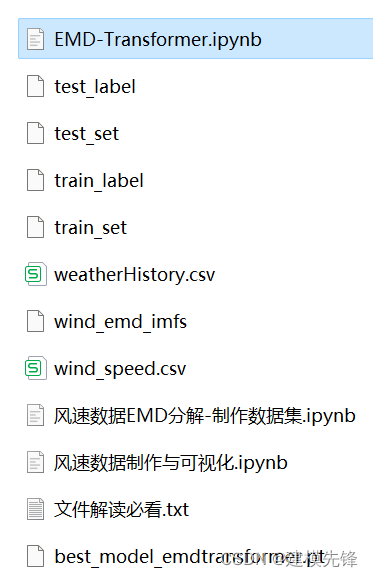

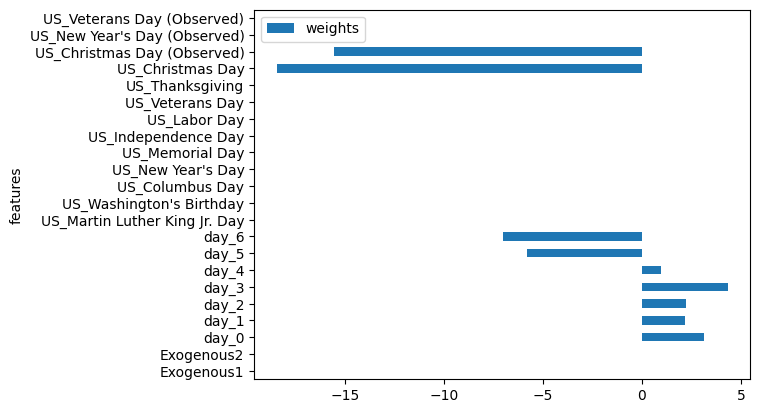

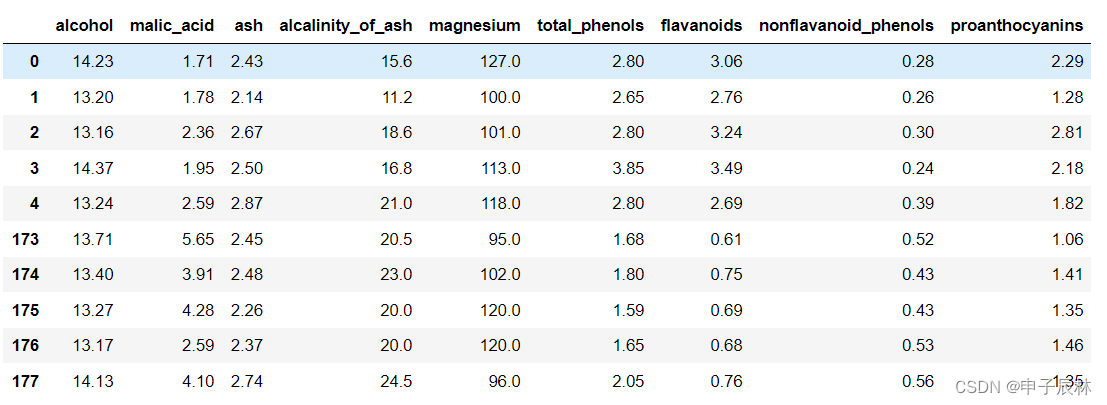

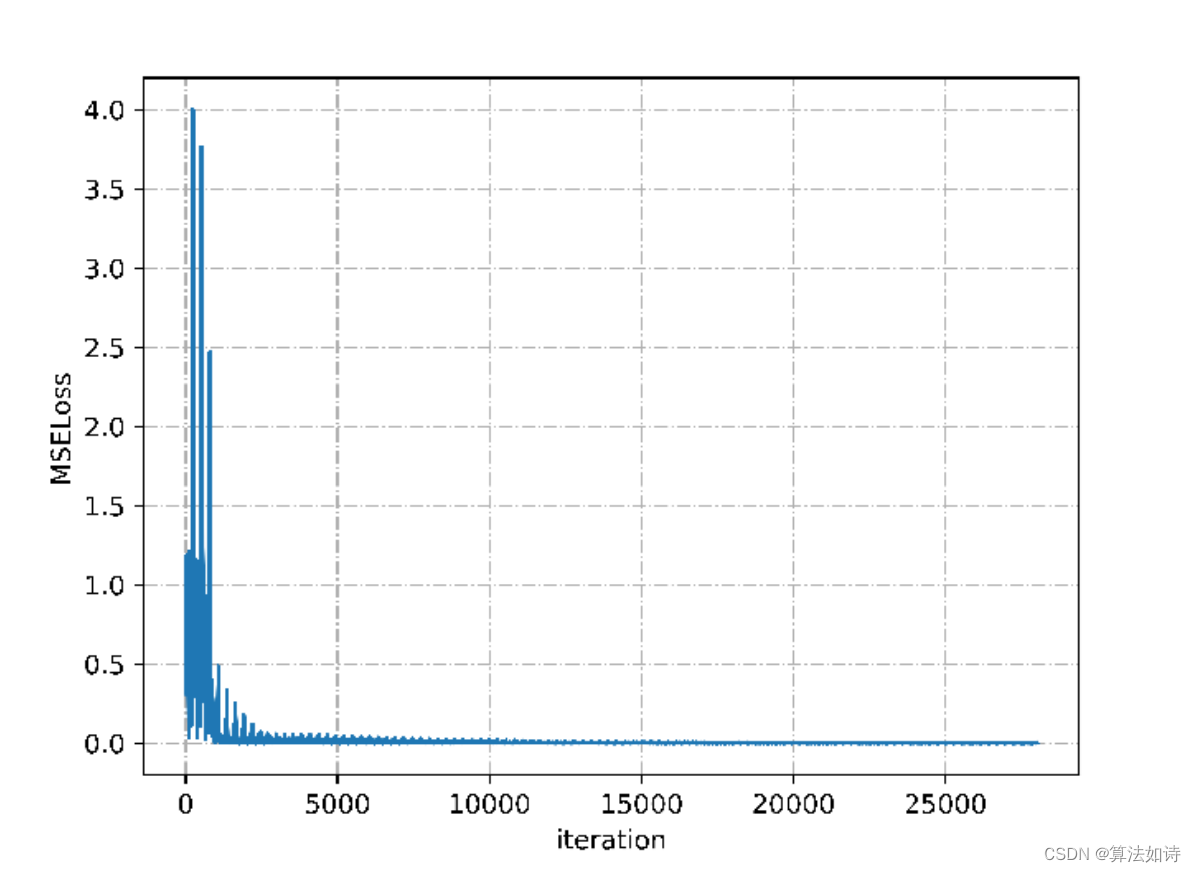

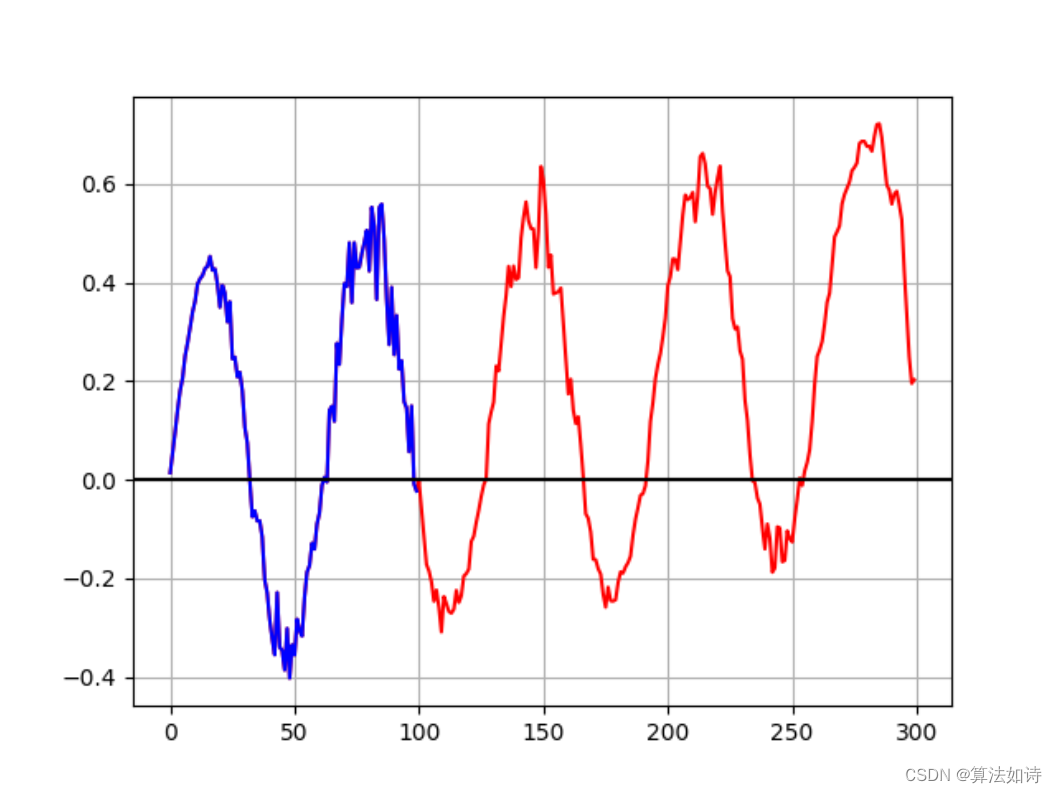

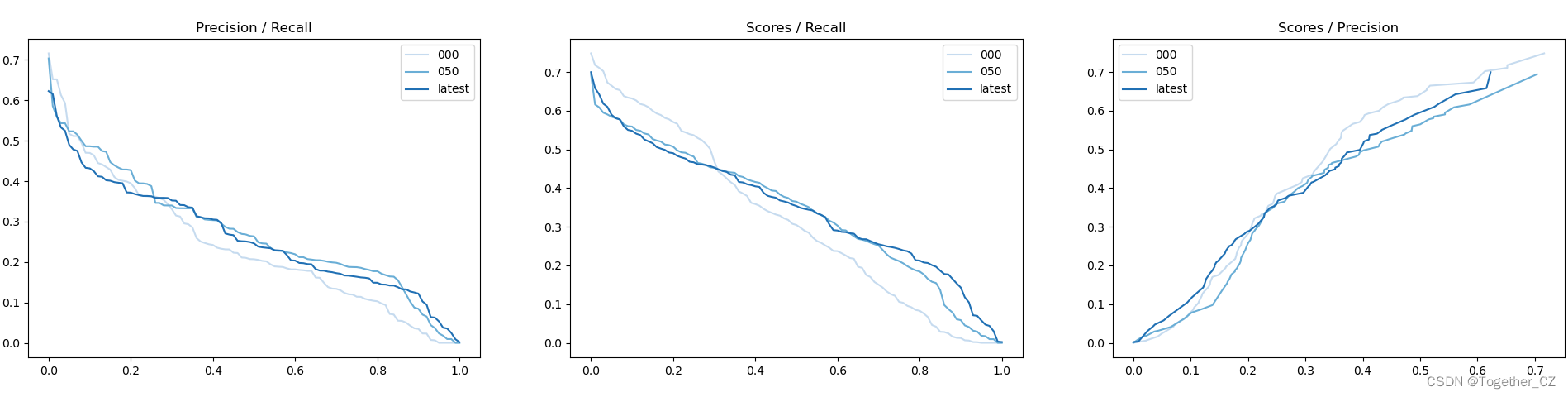

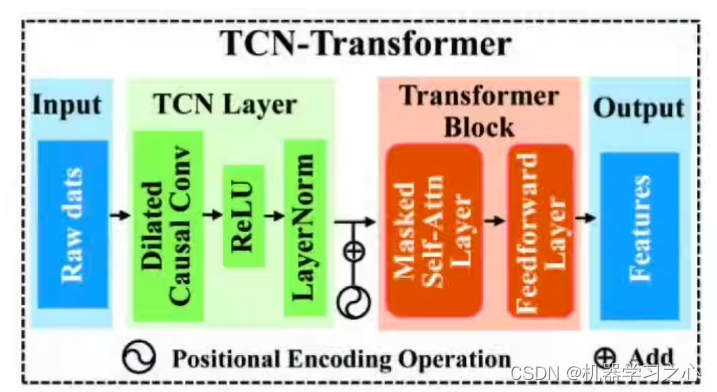

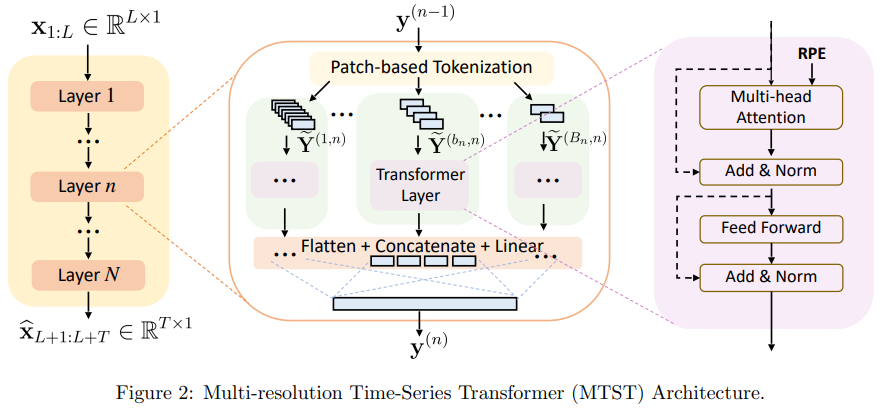

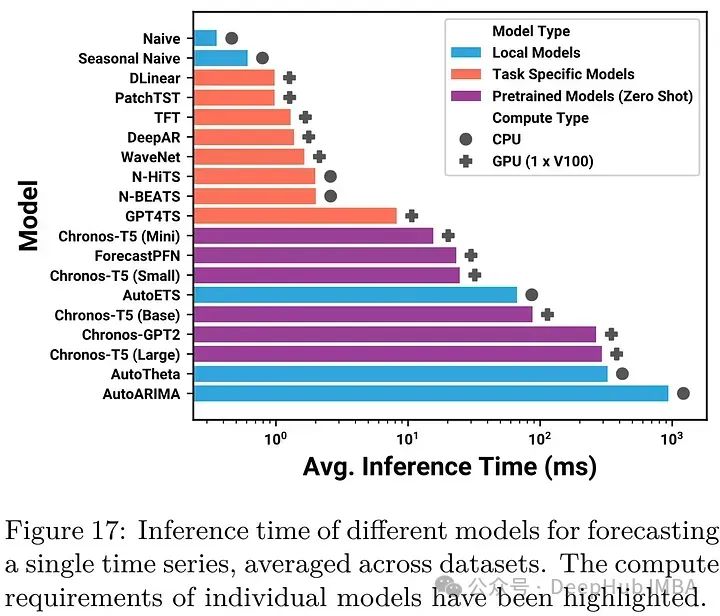

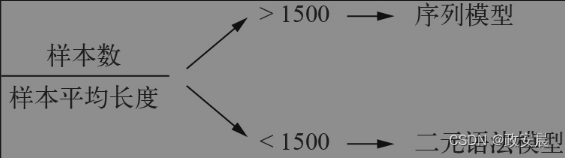

第86步 时间序列建模实战:Transformer回归建模

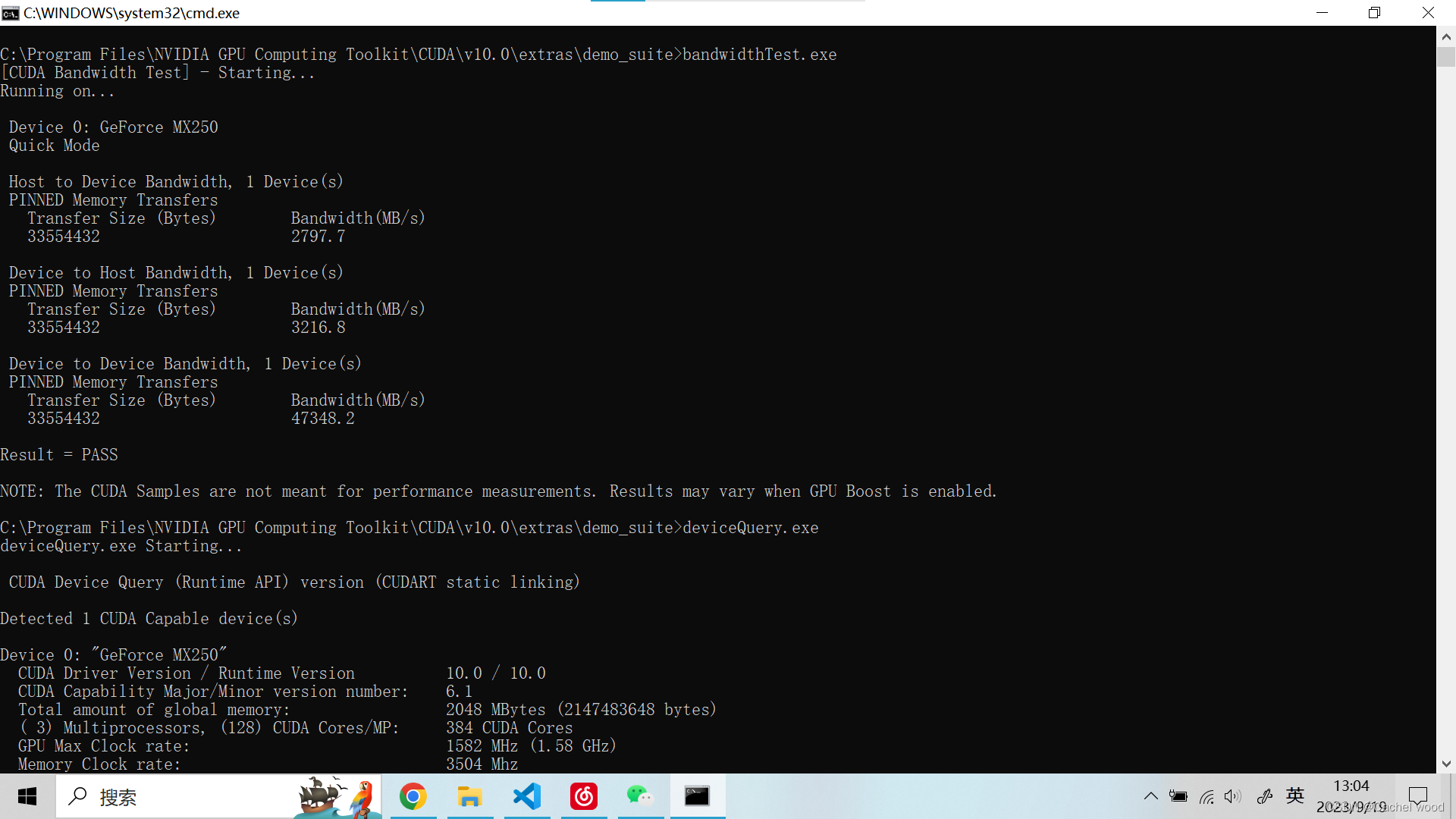

基于WIN10的64位系统演示

一、写在前面

这一期,我们介绍Transformer回归。

同样,这里使用这个数据:

《PLoS One》2015年一篇题目为《Comparison of Two Hybrid Models for Forecasting the Incidence of Hemorrhagic Fever with Renal Sy…

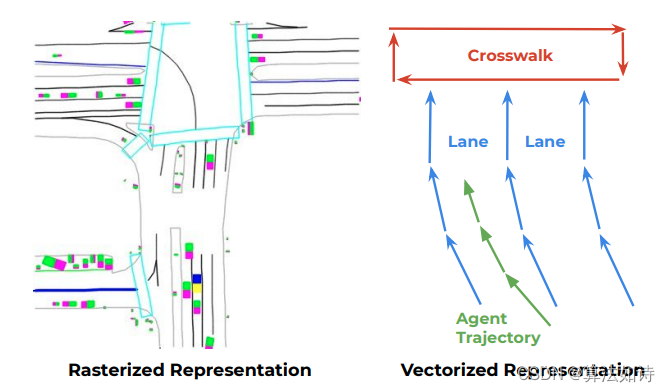

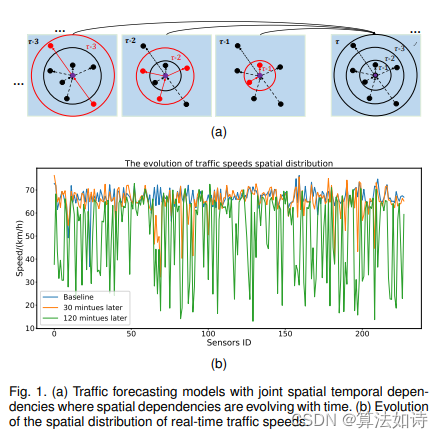

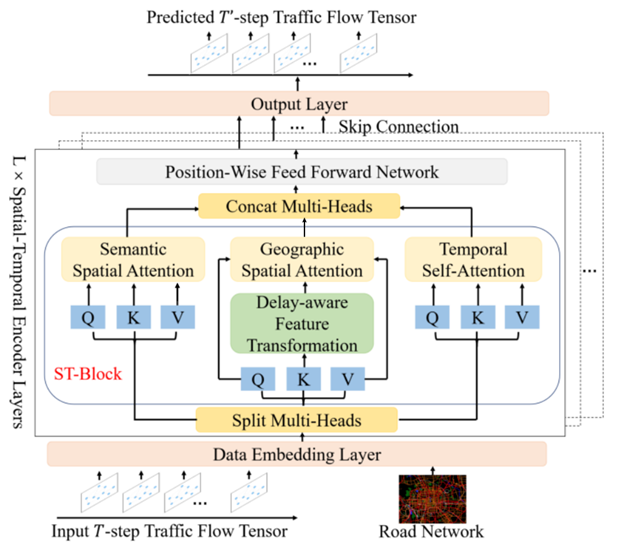

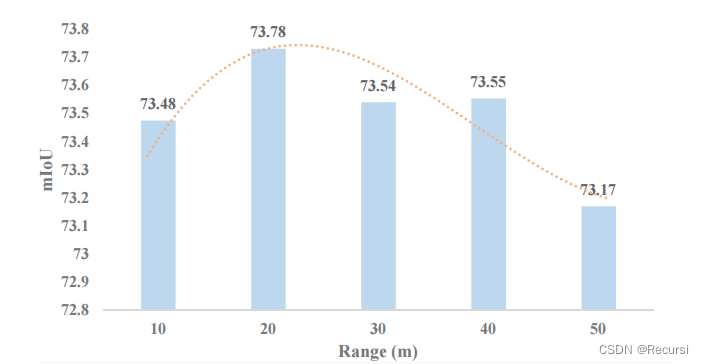

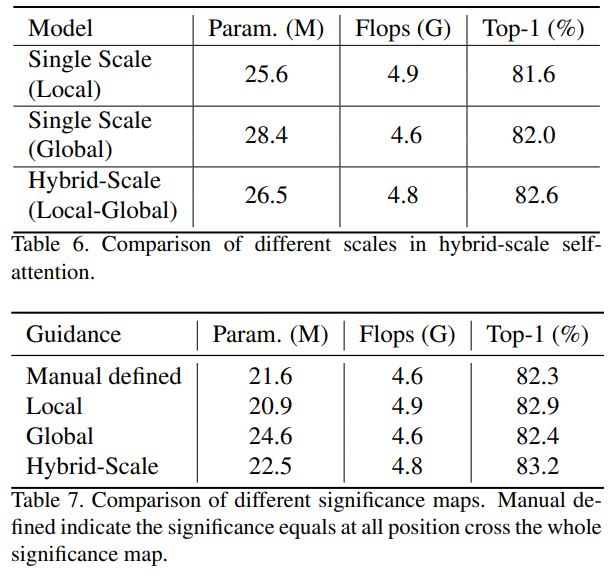

Transformer模型 | 基于双向时空自适应Transformer的城市交通流预测

城市交通流预测是智能交通系统的基石。现有方法侧重于时空依赖建模,而忽略了交通预测问题的两个内在特性。首先,不同预测任务的复杂性在不同的空间(如郊区与市中心)和时间(如高峰时段与非高峰时段)上分布不均匀。其次,对过去交通状况的回忆有利于对未来交通状况的预测。基于…

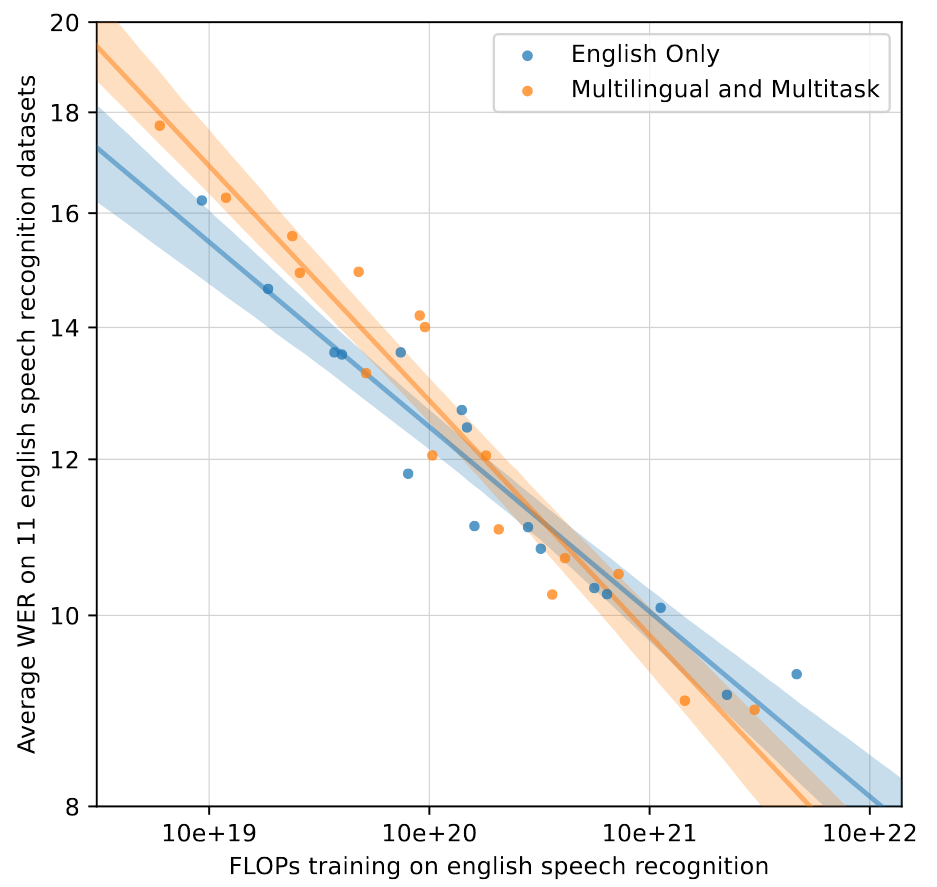

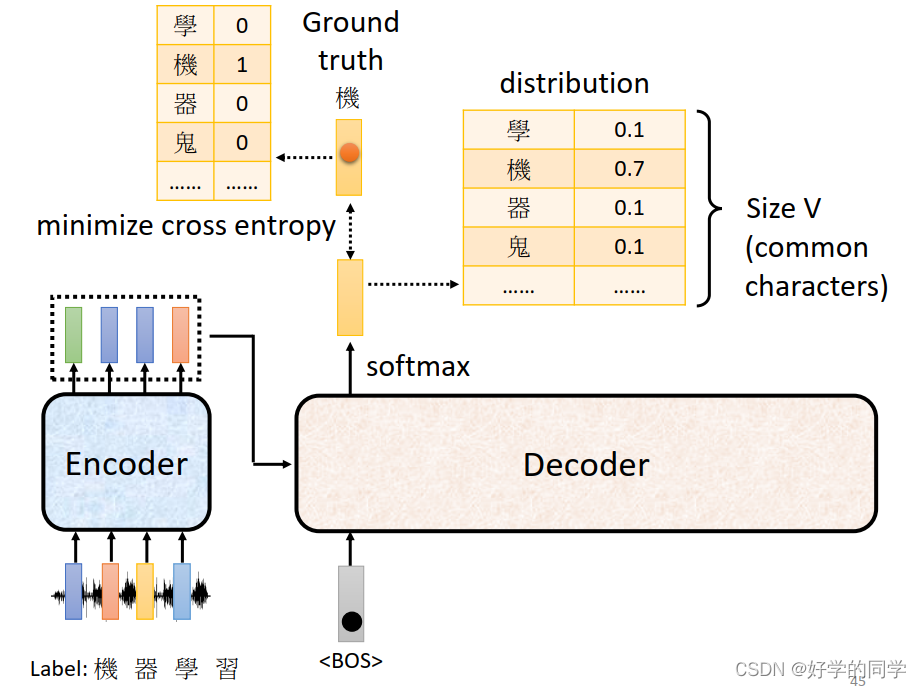

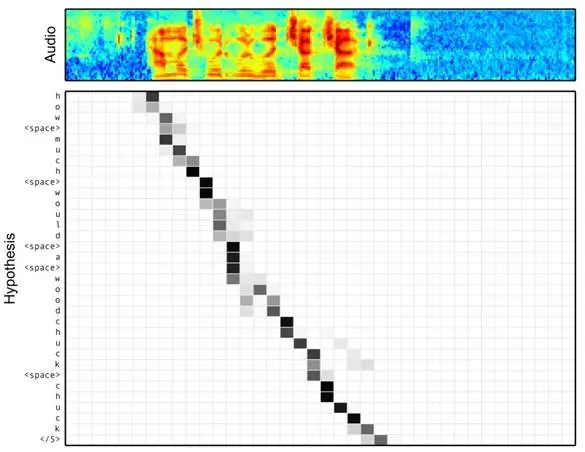

【论文精读】Robust Speech Recognition via Large-Scale Weak Supervision

Robust Speech Recognition via Large-Scale Weak Supervision 前言Abstract1. Introduction2. Approach2.1. Data Processing2.2. Model2.3. Multitask Format2.4. Training Details 3. Experiments3.1. Zero-shot Evaluation3.2. Evaluation Metrics3.3. English Speech Reco…

Transformer模型 | Transformer时间序列预测,单步、多步(Python)

(1)原理

Transformer框架原本是为NLP任务,特别是机器翻译而设计的。但由于其独特的自注意力机制,Transformer在处理顺序数据时表现出色,因此被广泛应用于各种序列数据任务,包括回归任务。

(a)回归任务中的Transformer:

(a1)在回归任务中,Transformer可以捕捉数据…

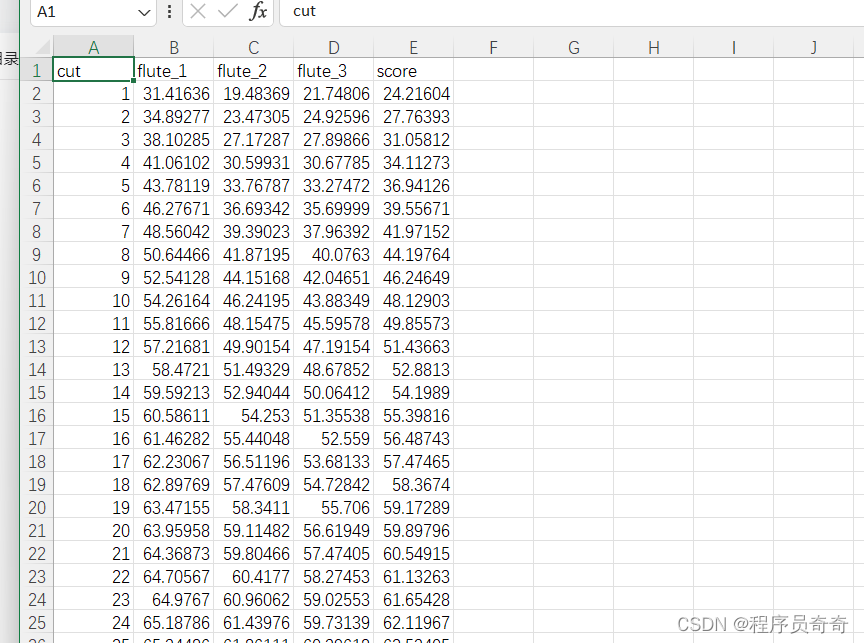

Lstm+transformer的刀具磨损预测

视频讲解:

基于Lstm+transformer的刀具磨损预测实战_哔哩哔哩_bilibili

结果展示: 数据展示: 主要代码:

# pip install openpyxl -i https://pypi.tuna.tsinghua.edu.cn/simple/

# pip install optuna -i https://pypi.tuna.tsinghua.edu.cn/simple/

import numpy as np…

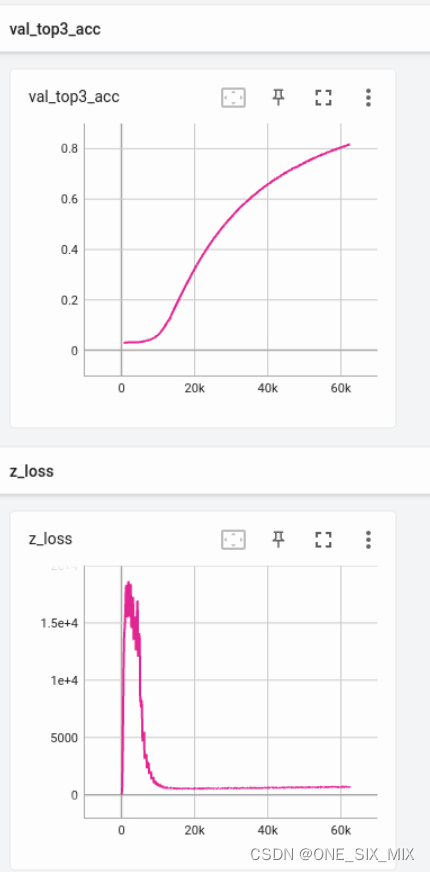

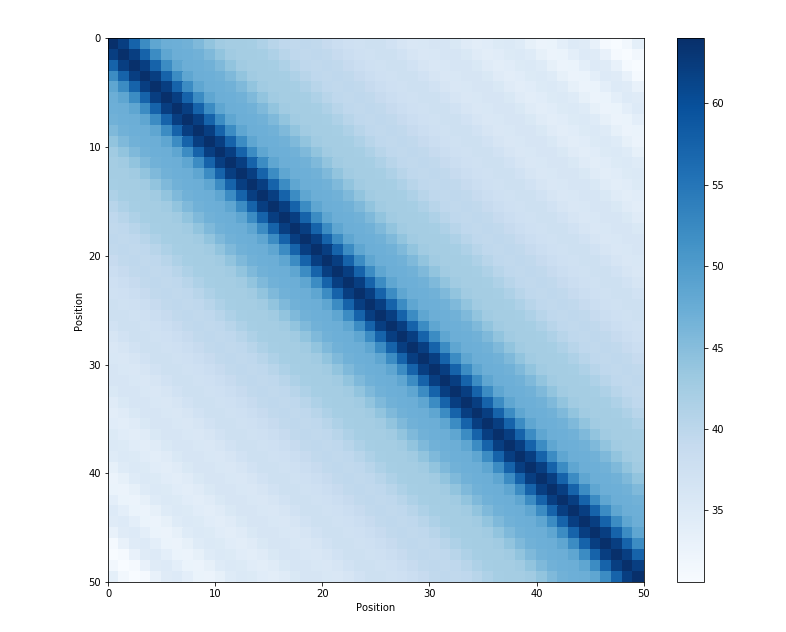

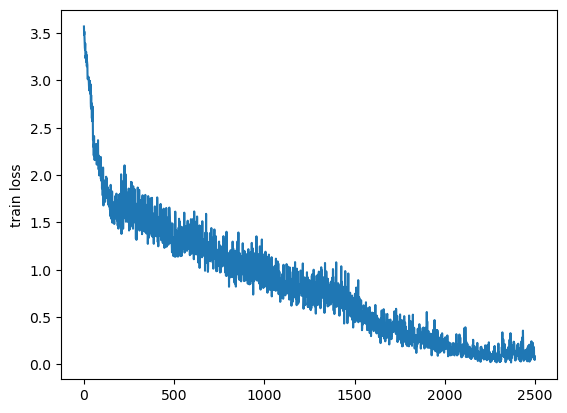

记录:自回归 模型在记忆 全随机序列 的潜变量 统计量爆炸现象

只是一个记录

8层12头512维度的 GPT 模型,使用它来记忆 10000 条 512长度 的无序序列,vocab_size 为100。

模型要自回归生成这些序列,不可能依赖局部推理,必须依赖全局视野,即记住前面的序列。

然后统计 最后一个no…

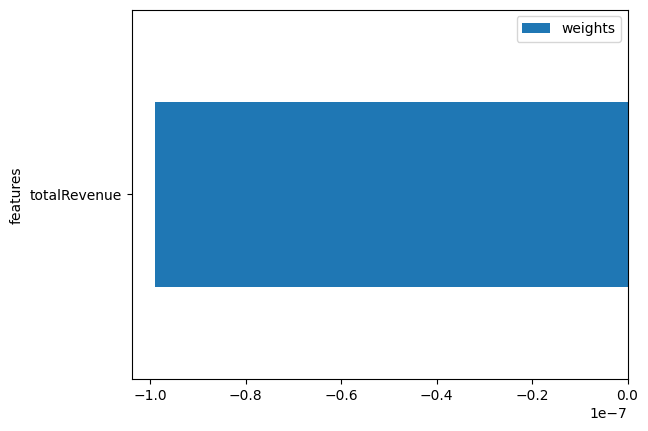

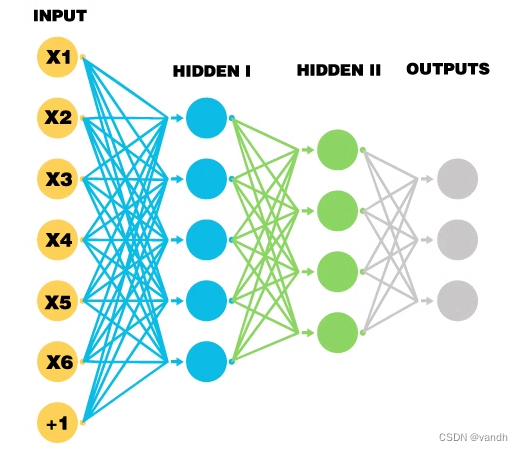

机器学习笔记 - 数据科学中基于 Scikit-Learn、Tensorflow、Pandas 和 Scipy的7种最常用的特征工程技术

一、概述 特征工程描述了制定相关特征的过程,这些特征尽可能准确地描述底层数据科学问题,并使算法能够理解和学习模式。换句话说:您提供的特征可作为将您自己对世界的理解和知识传达给模型的一种方式。 每个特征描述一种信息“片段”。这些部分的总和允许算法得出有关目标变…

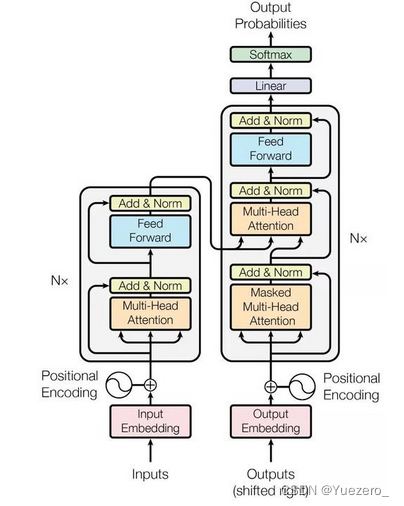

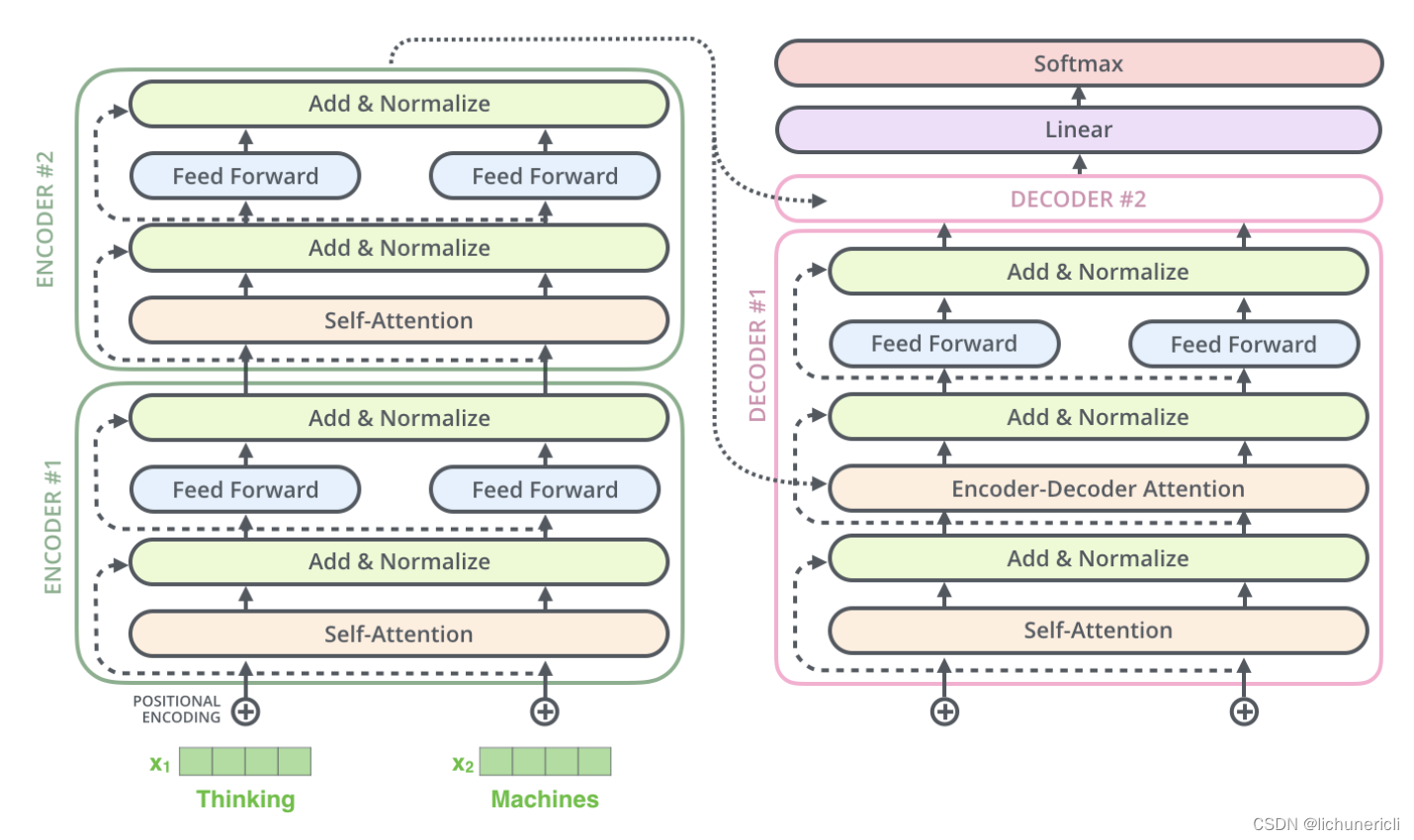

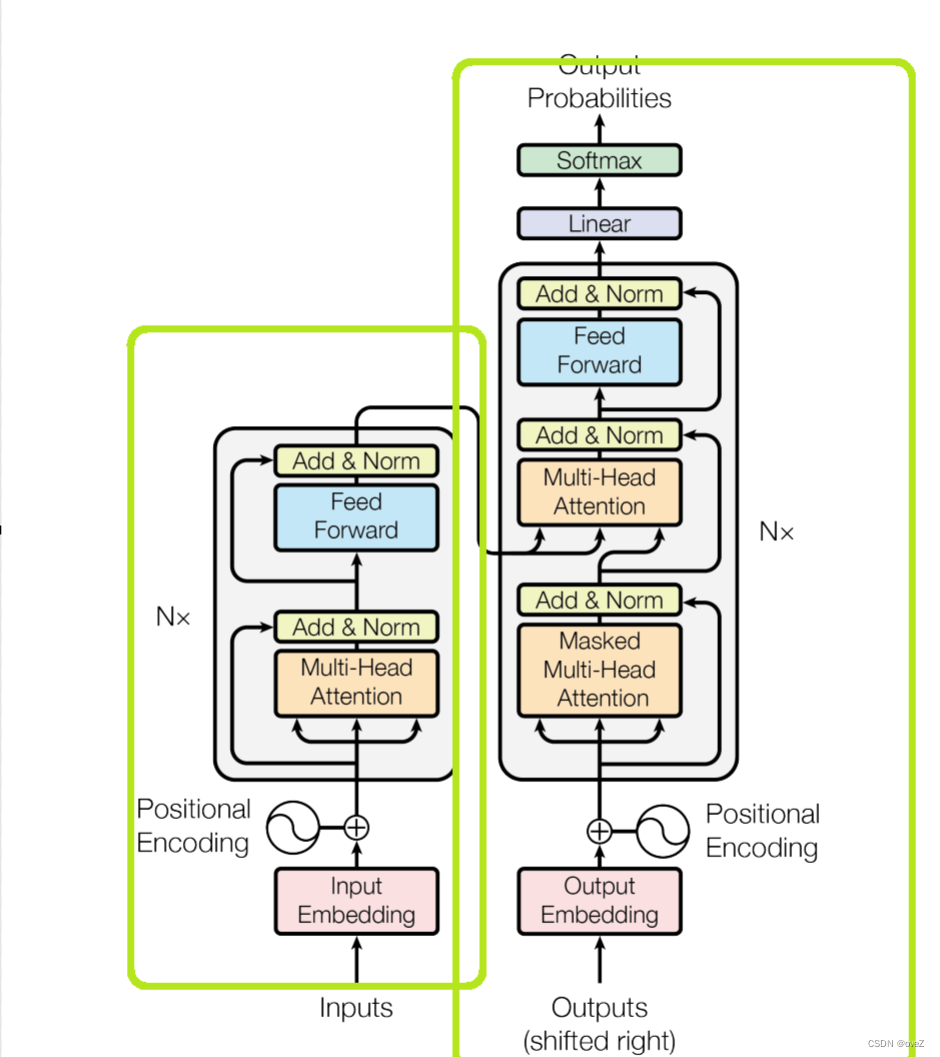

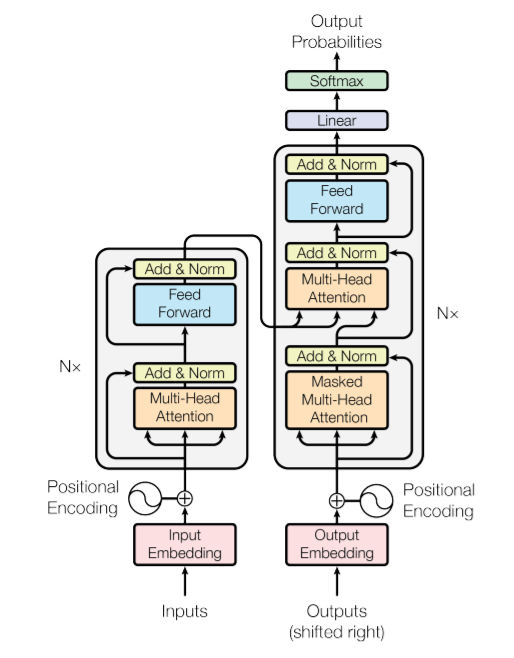

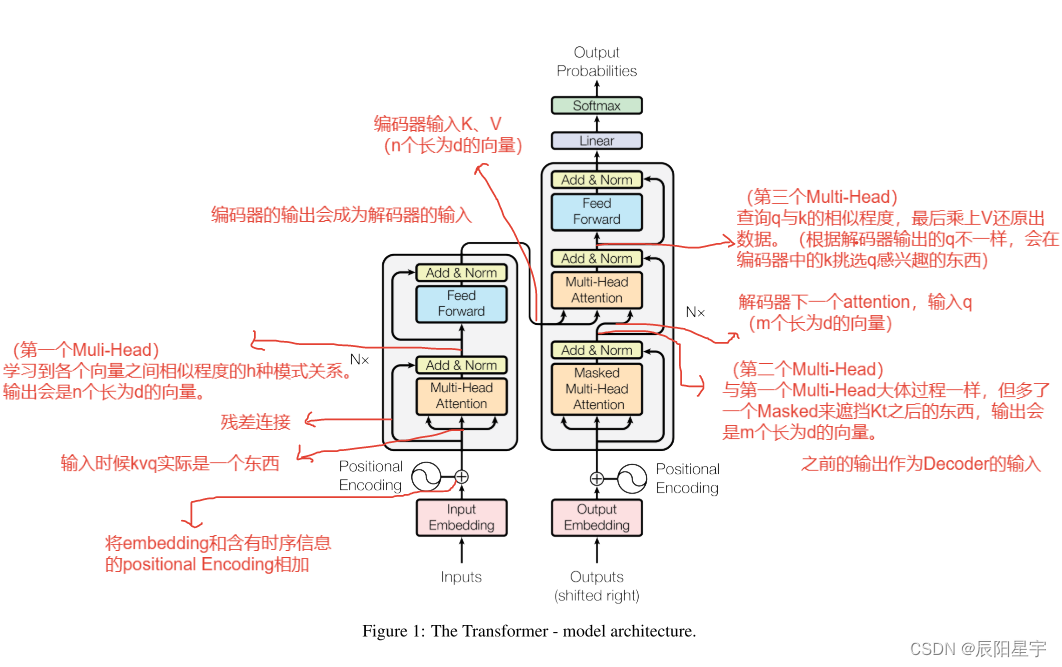

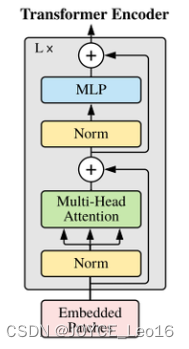

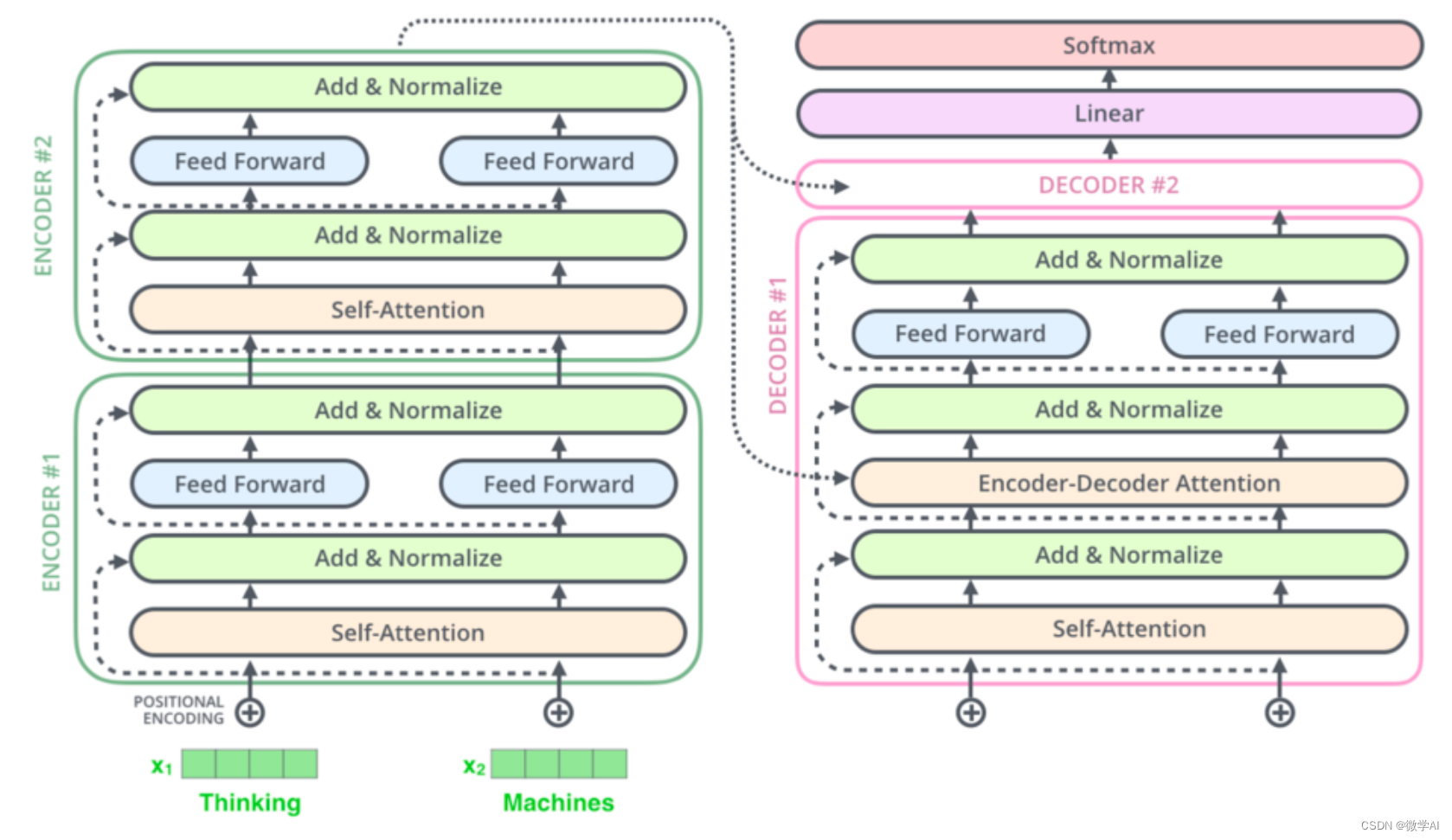

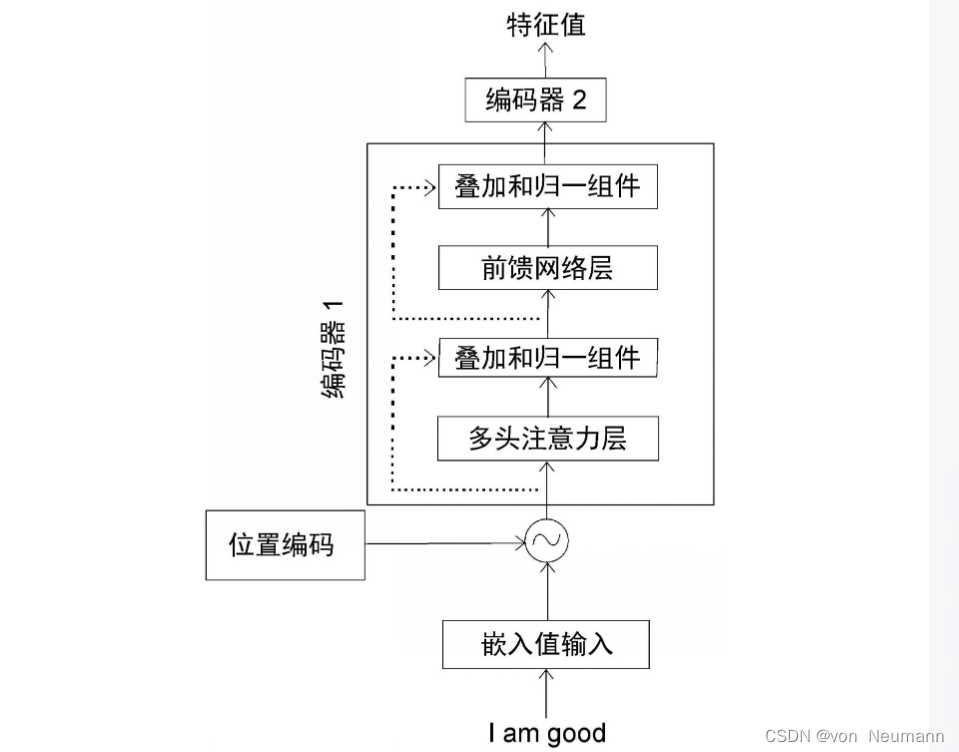

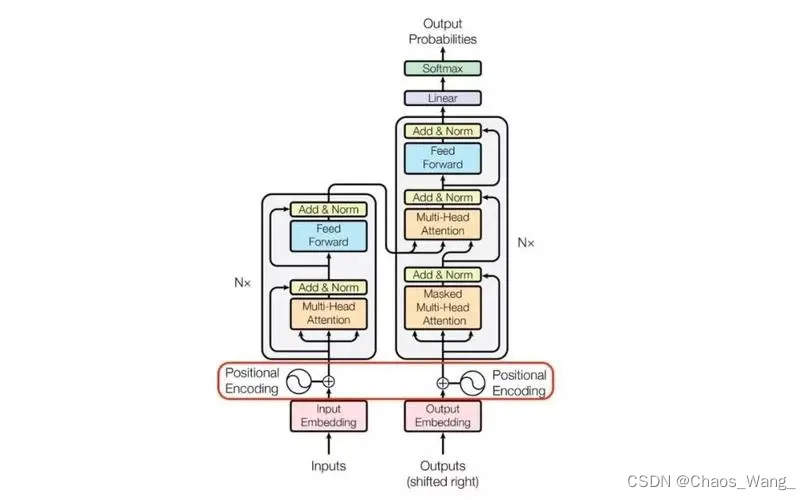

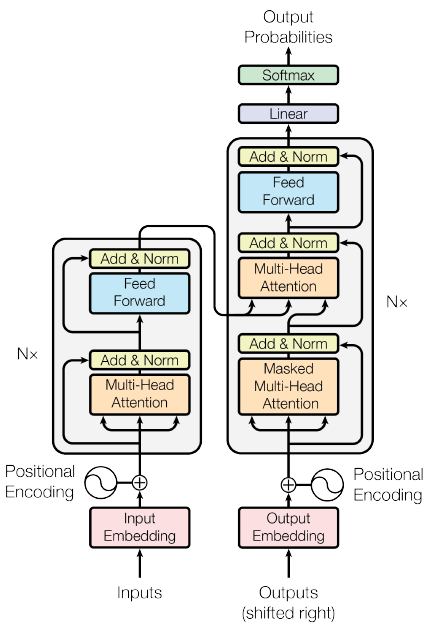

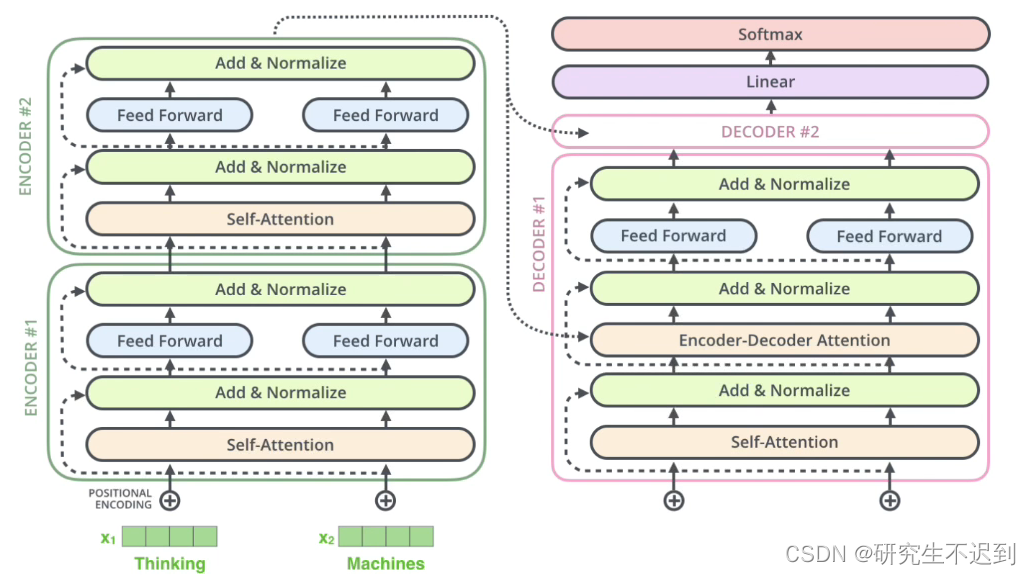

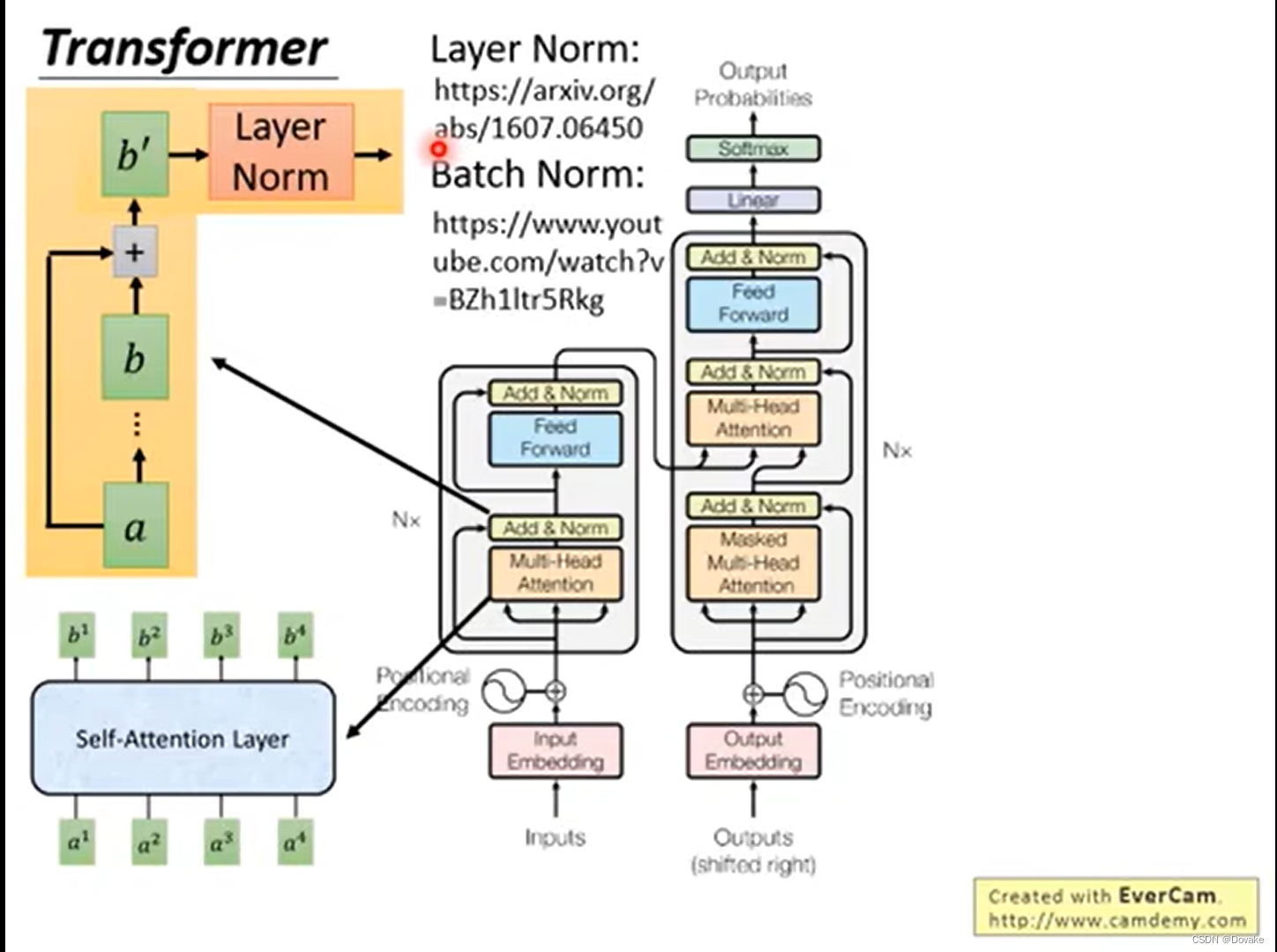

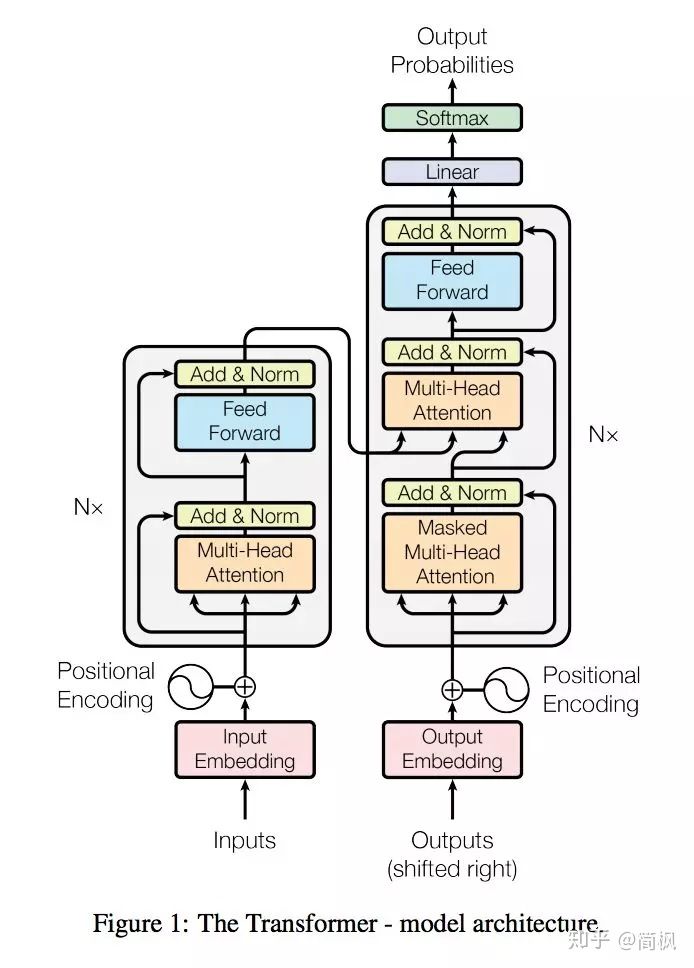

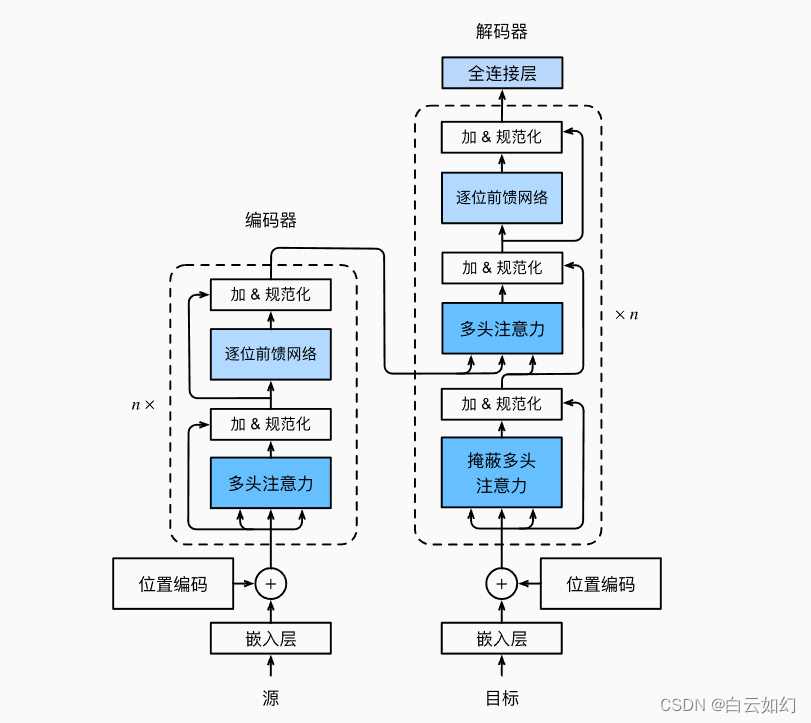

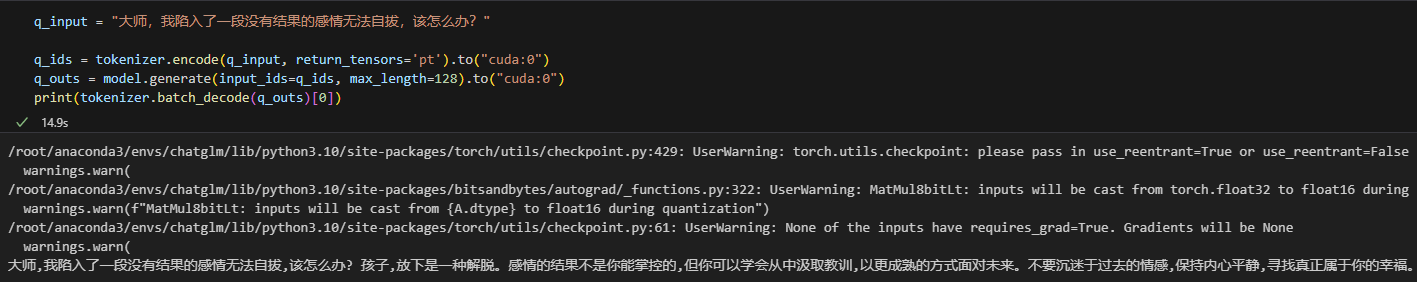

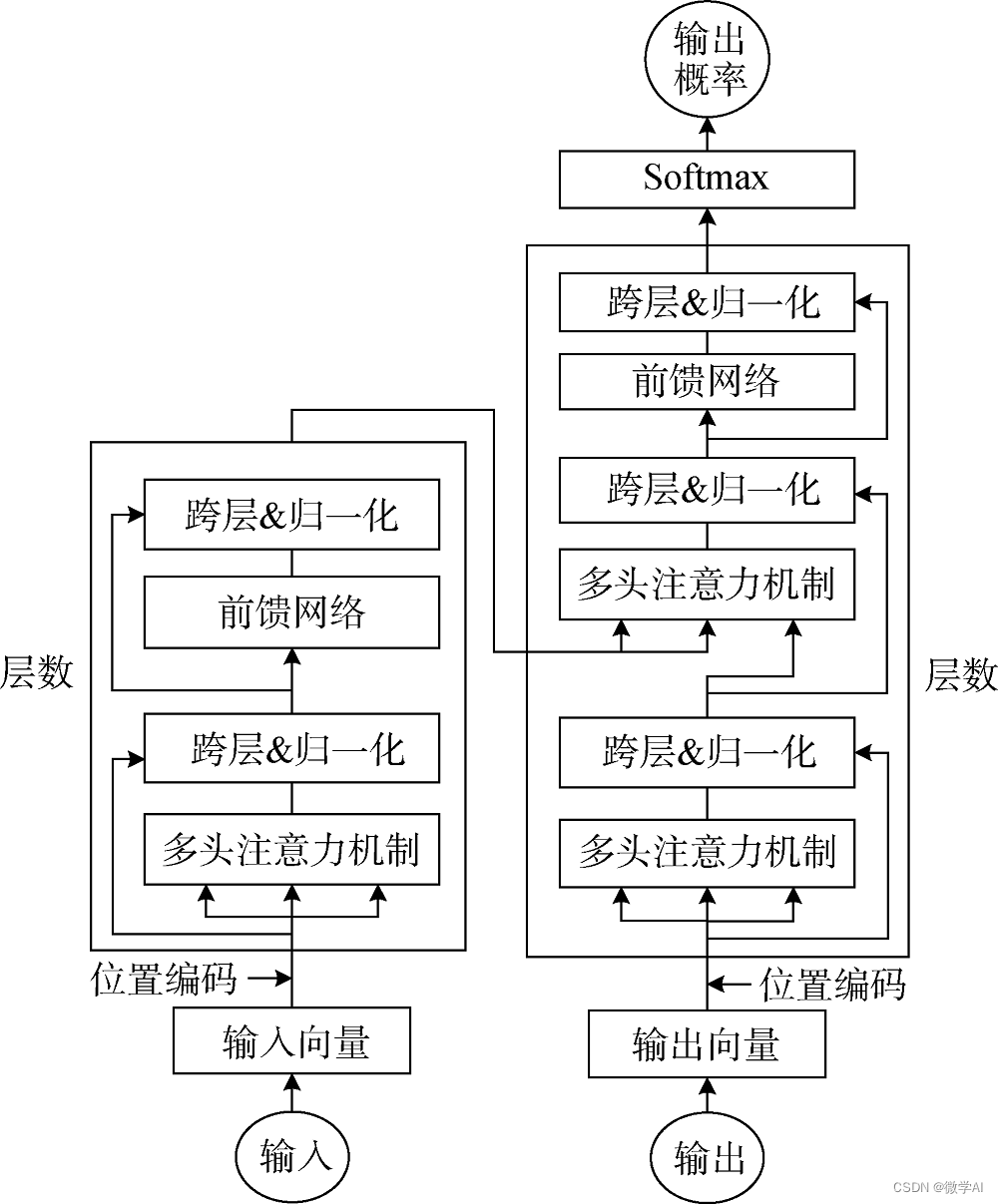

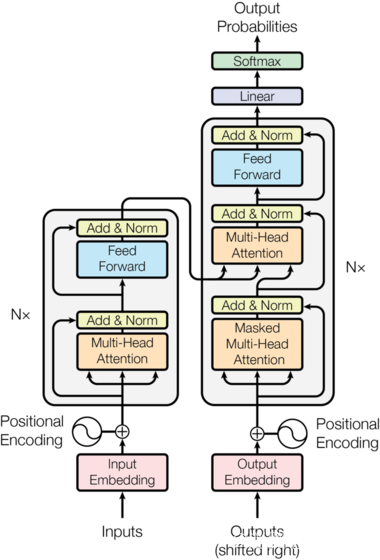

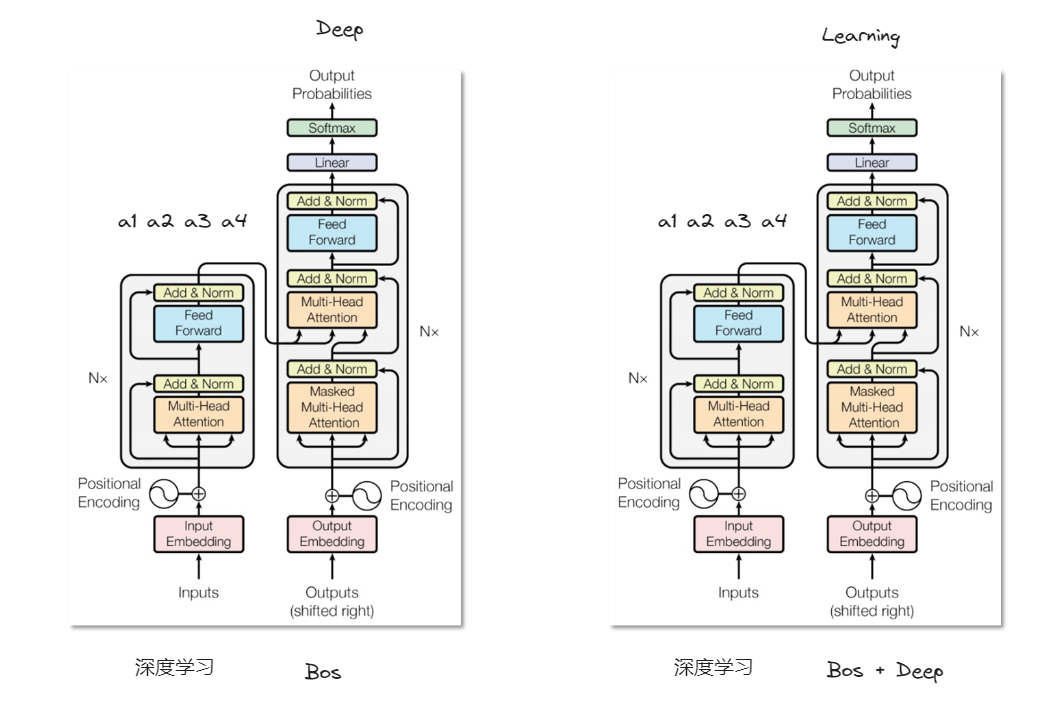

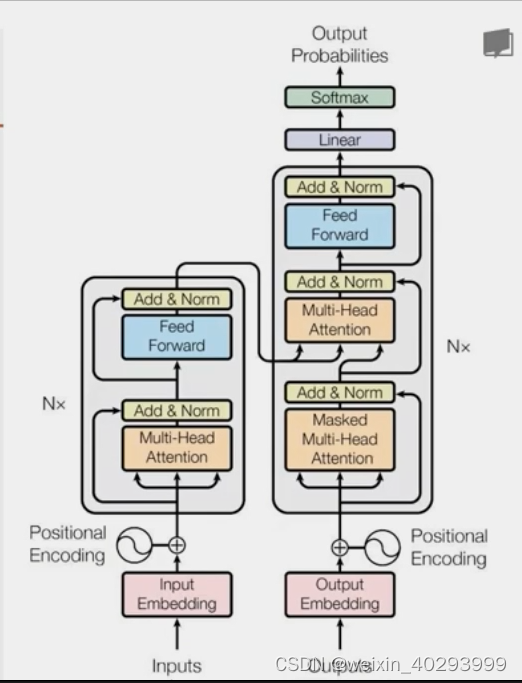

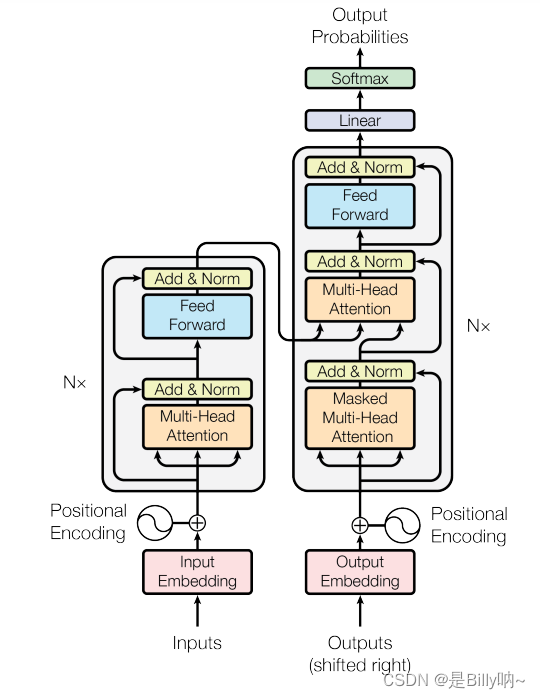

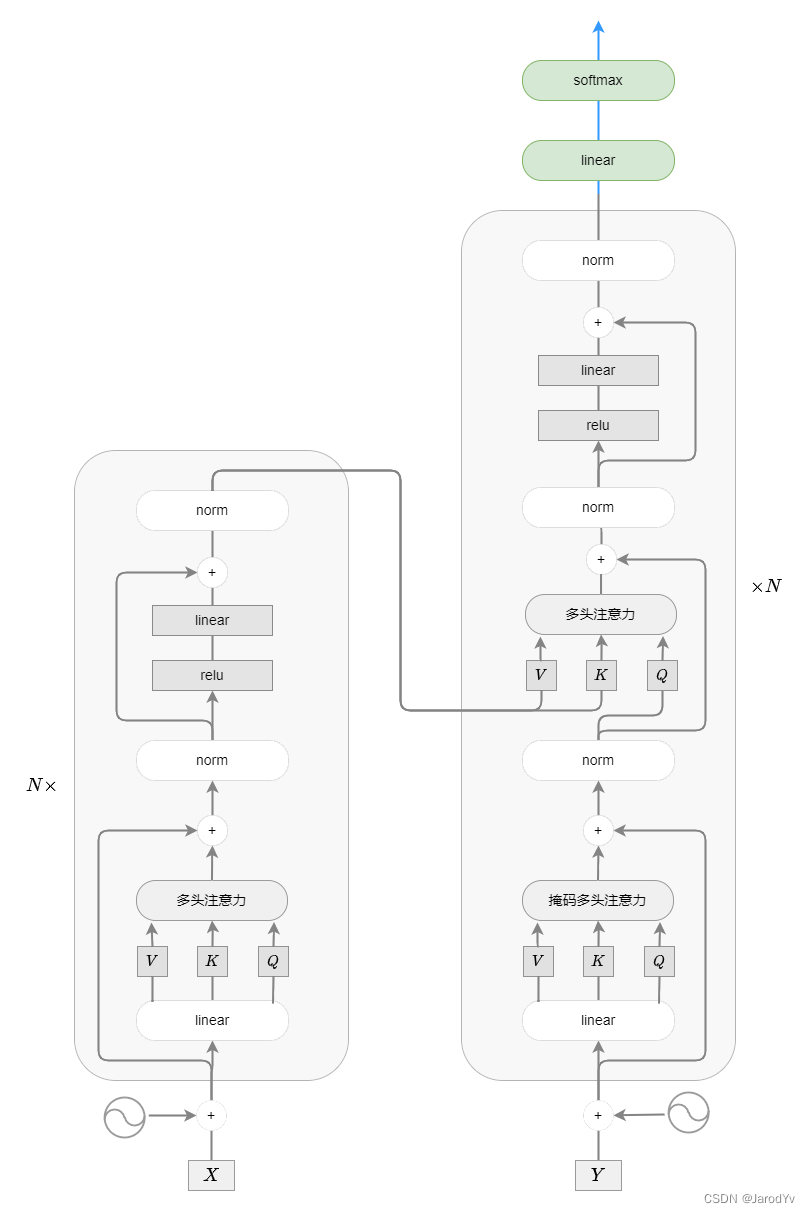

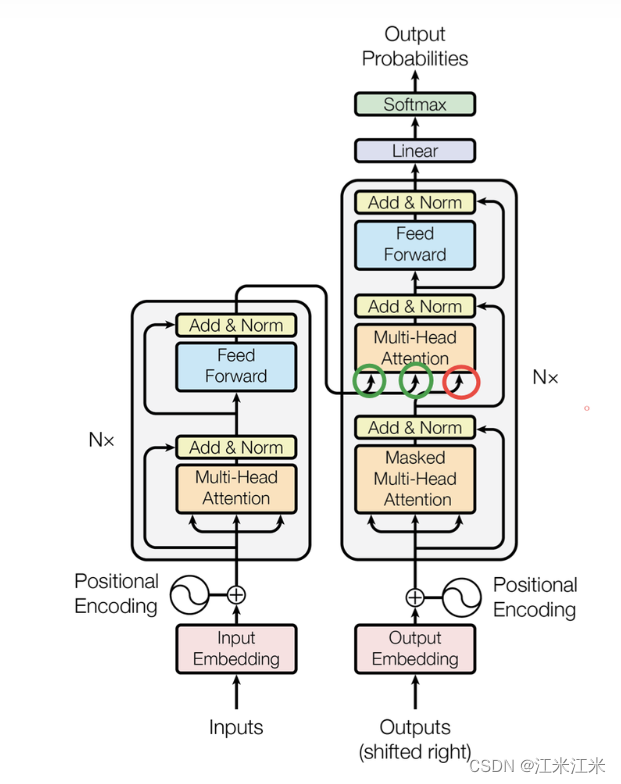

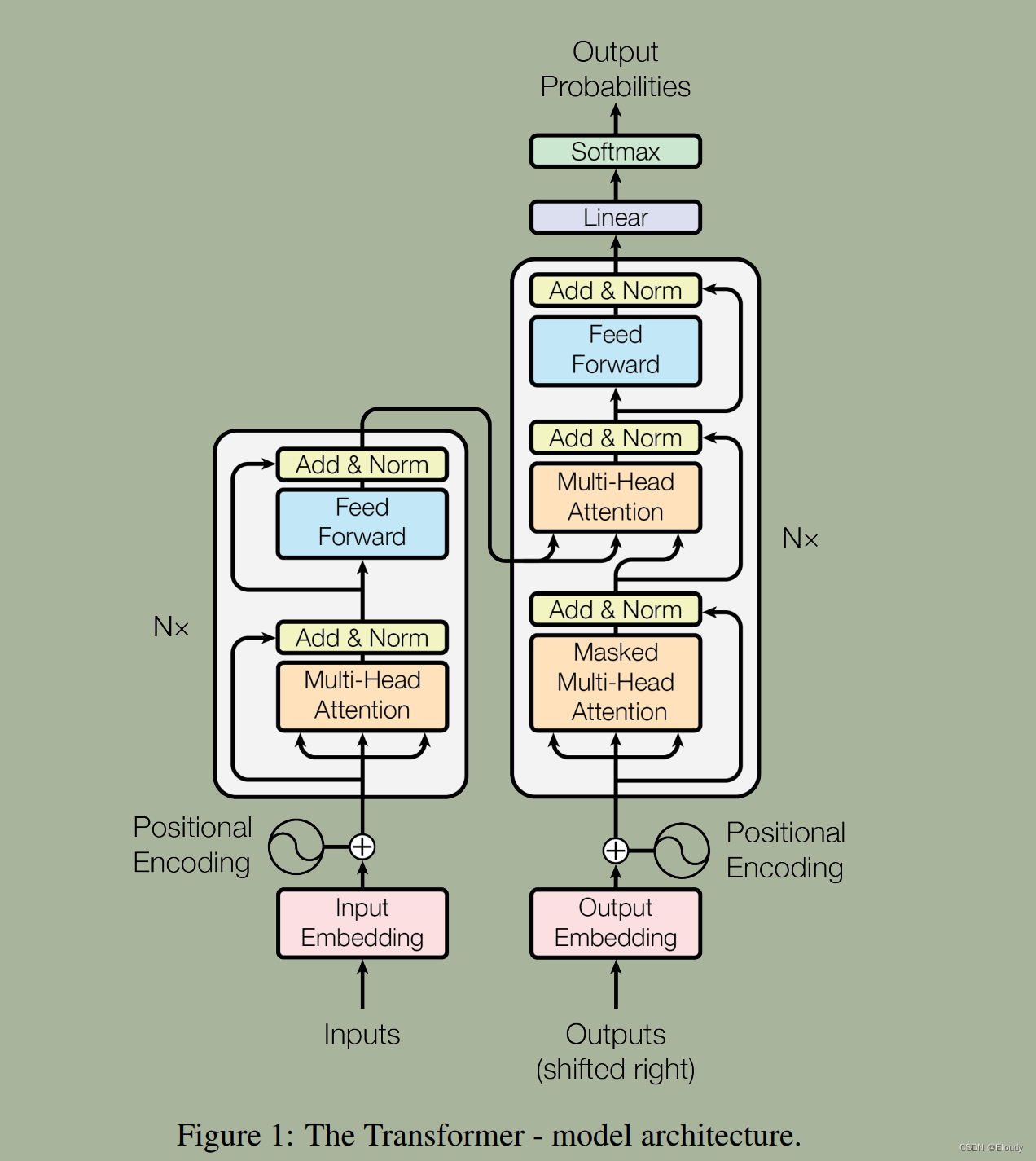

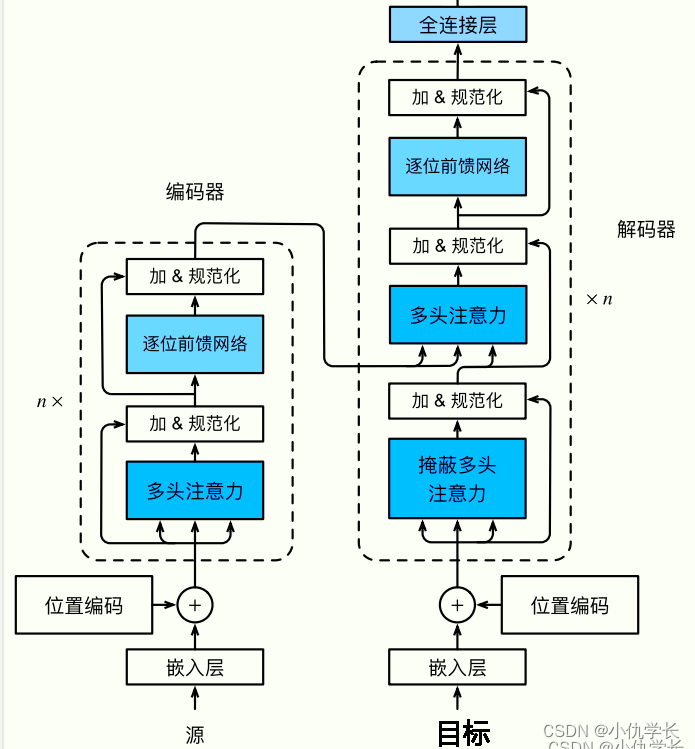

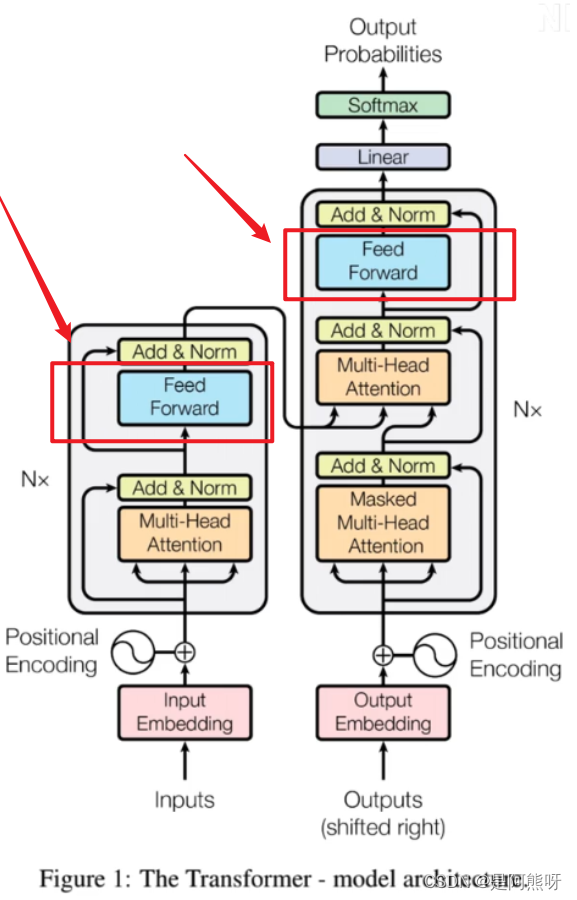

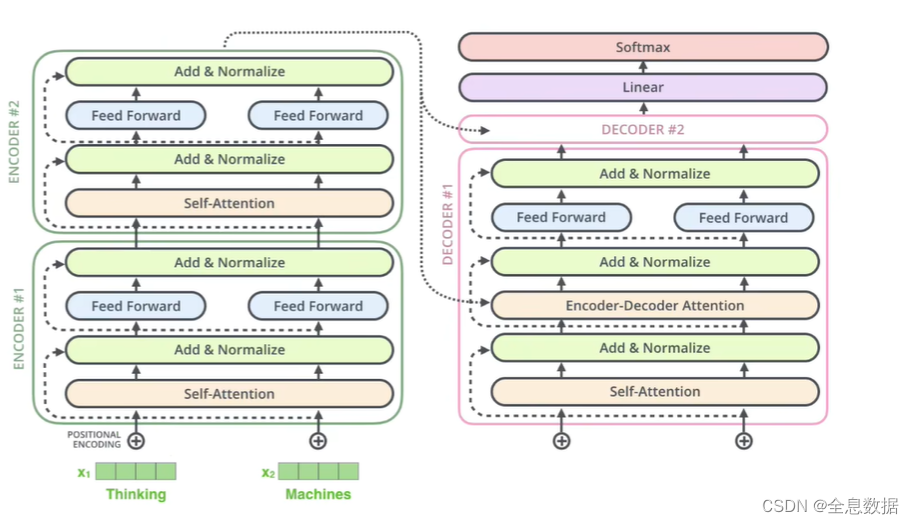

【nlp】3.1 Transformer背景介绍及架构

Transformer背景介绍 1 Transformer的诞生2 Transformer的优势3 Transformer的市场4 Transformer架构4.1 Transformer模型的作用4.2 Transformer总体架构图4.2.1 输入部分4.2.2 输出部分包含4.2.3 编码器部分4.2.4 解码器部分1 Transformer的诞生

2018年10月,Google发出一篇论…

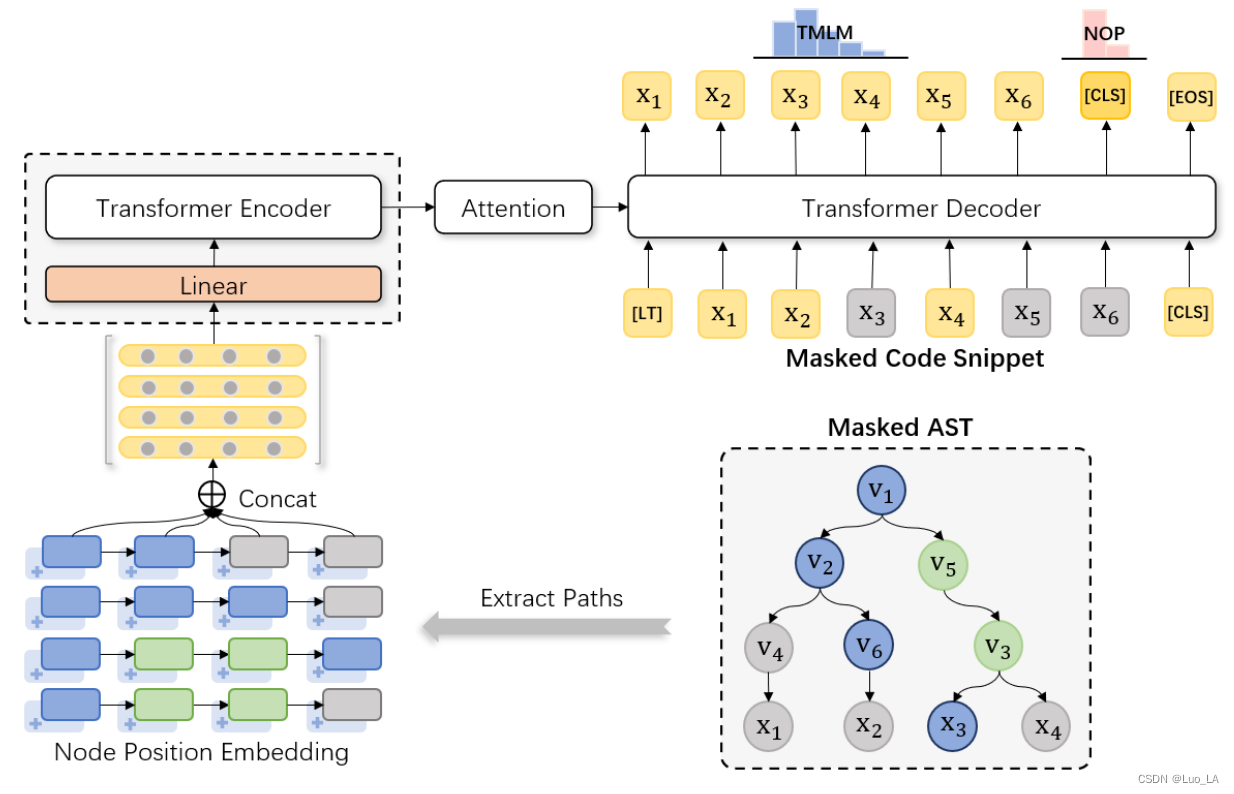

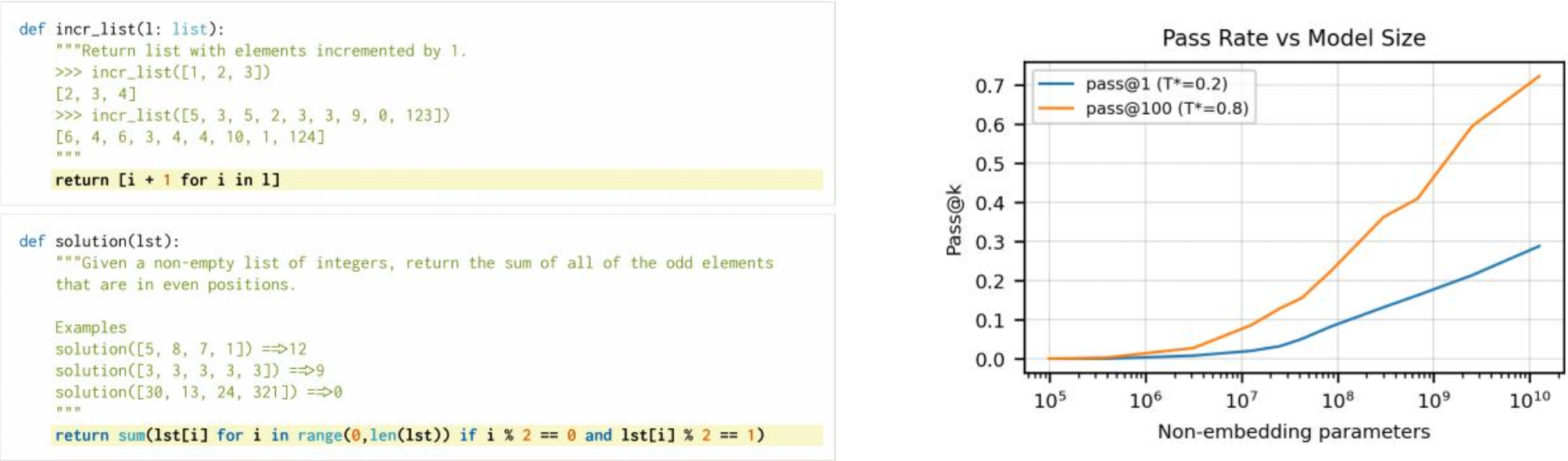

TreeBERT:基于树的编程语言预训练模型。

TreeBERT

https://arxiv.org/abs/2105.12485

Comments: Accepted by UAI2021 Subjects: Machine Learning (cs.LG); Programming Languages (cs.PL) Cite as: arXiv:2105.12485 [cs.LG]

1 Introduction

现有挑战: 设计适当的机制来学习程序的语法结构 代码是强结…

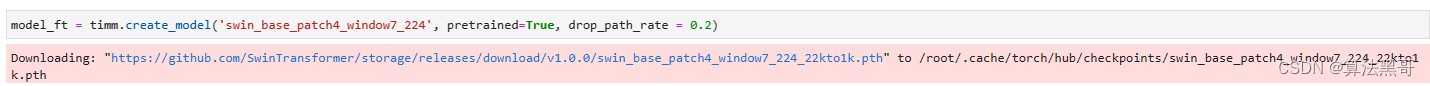

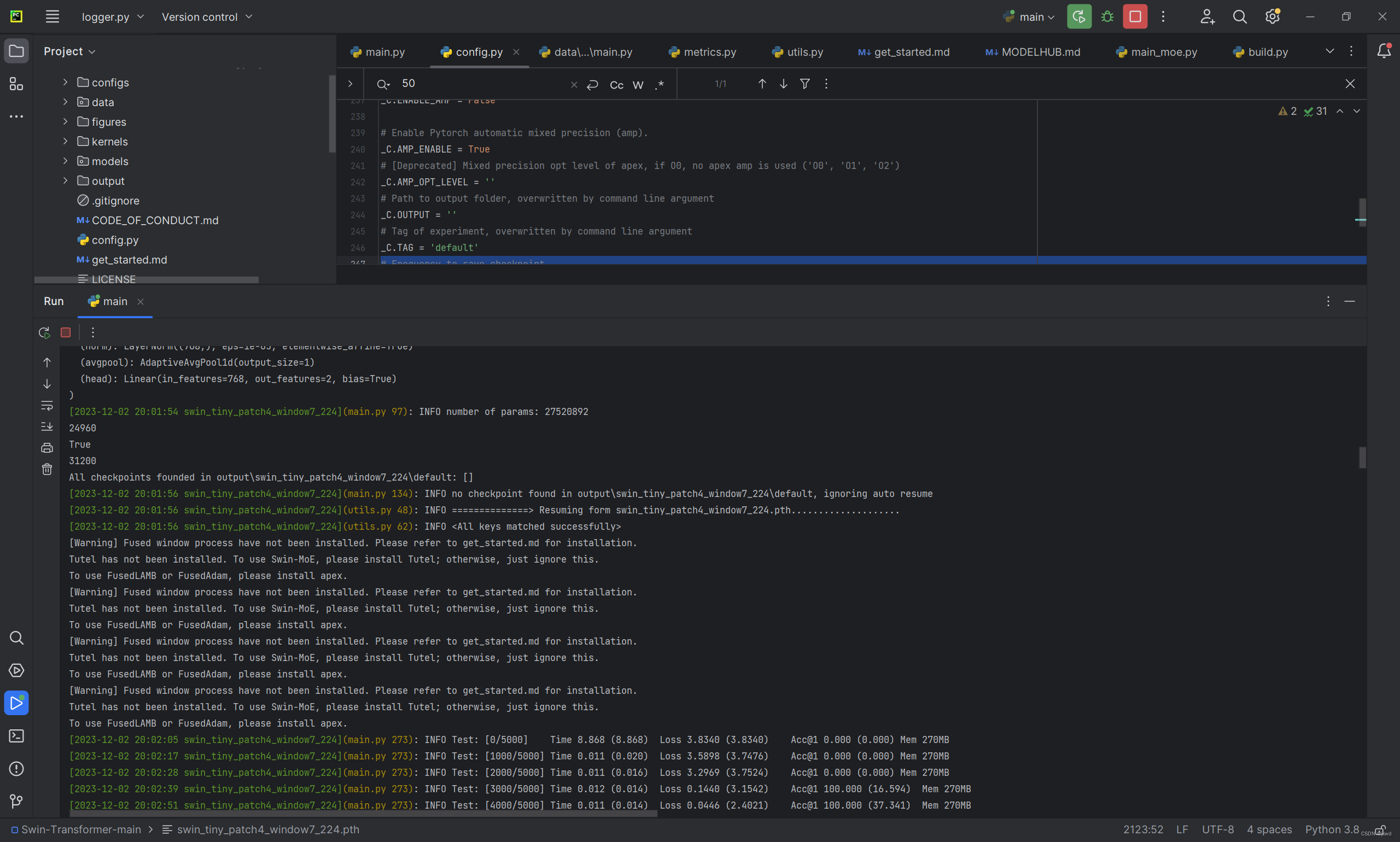

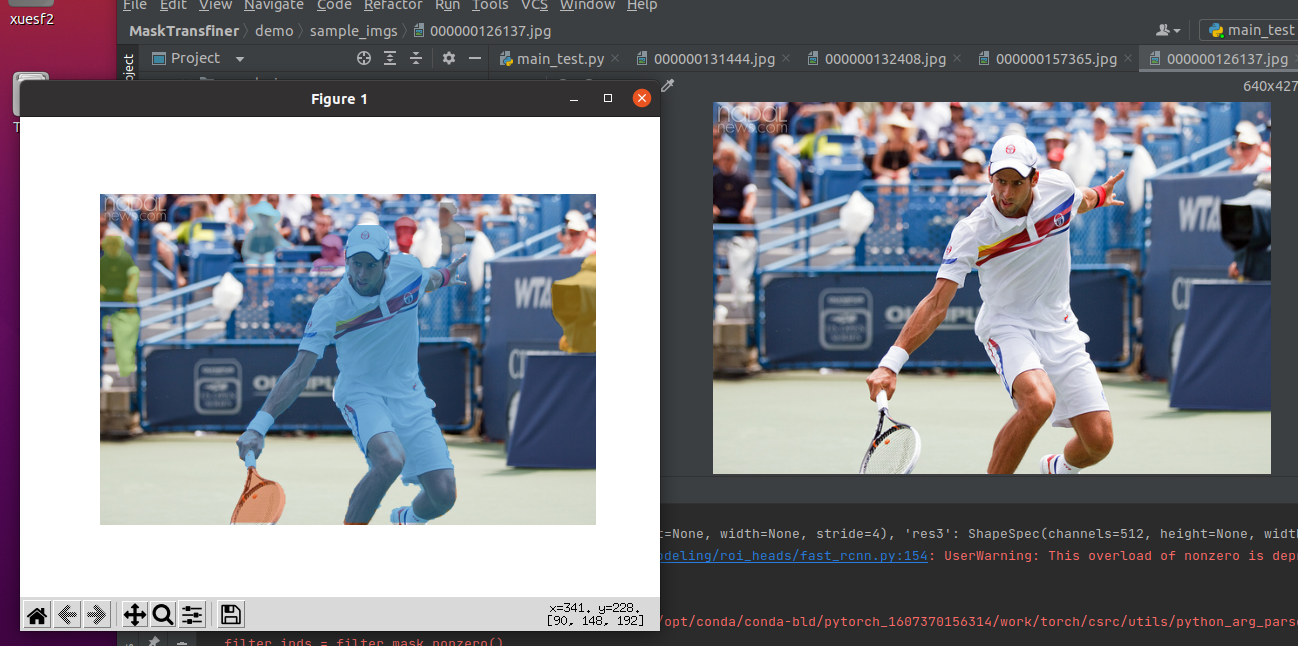

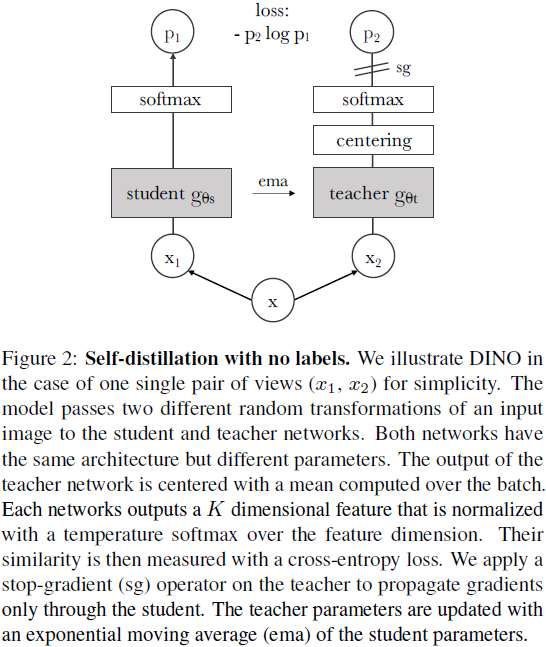

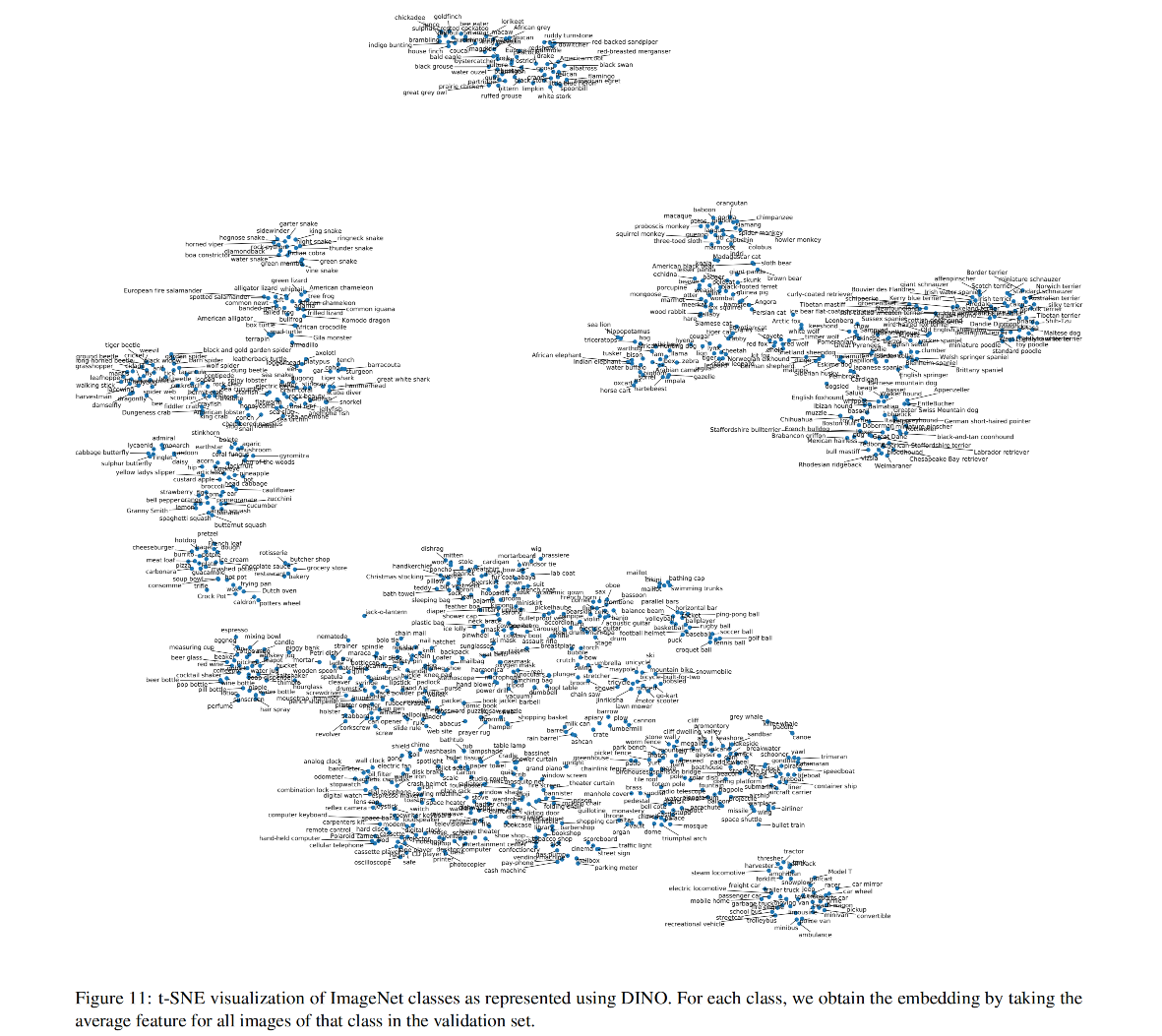

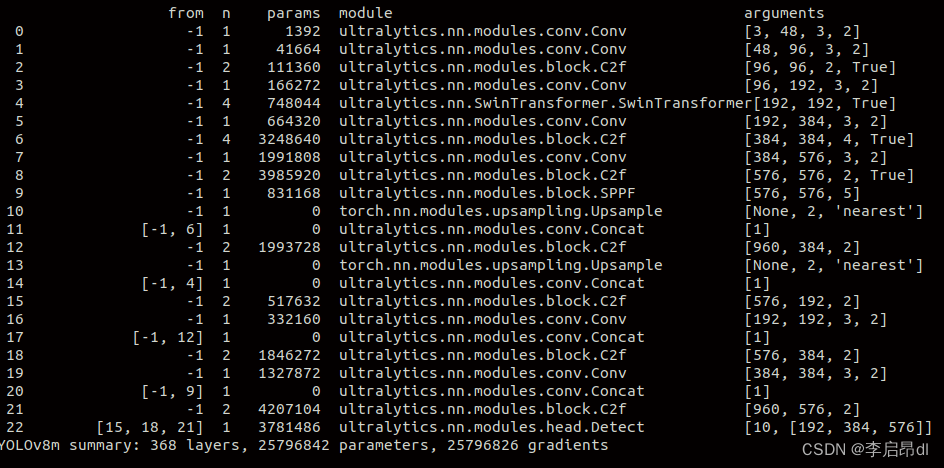

DINO训练自己的数据集(swin transformer backbone)

源码:https://github.com/IDEA-Research/DINO

数据集:coco格式

COCODIR/├── train2017/├── val2017/└── annotations/├── instances_train2017.json└── instances_val2017.json

环境配置

1. 下载代码

git clone https://github.com/…

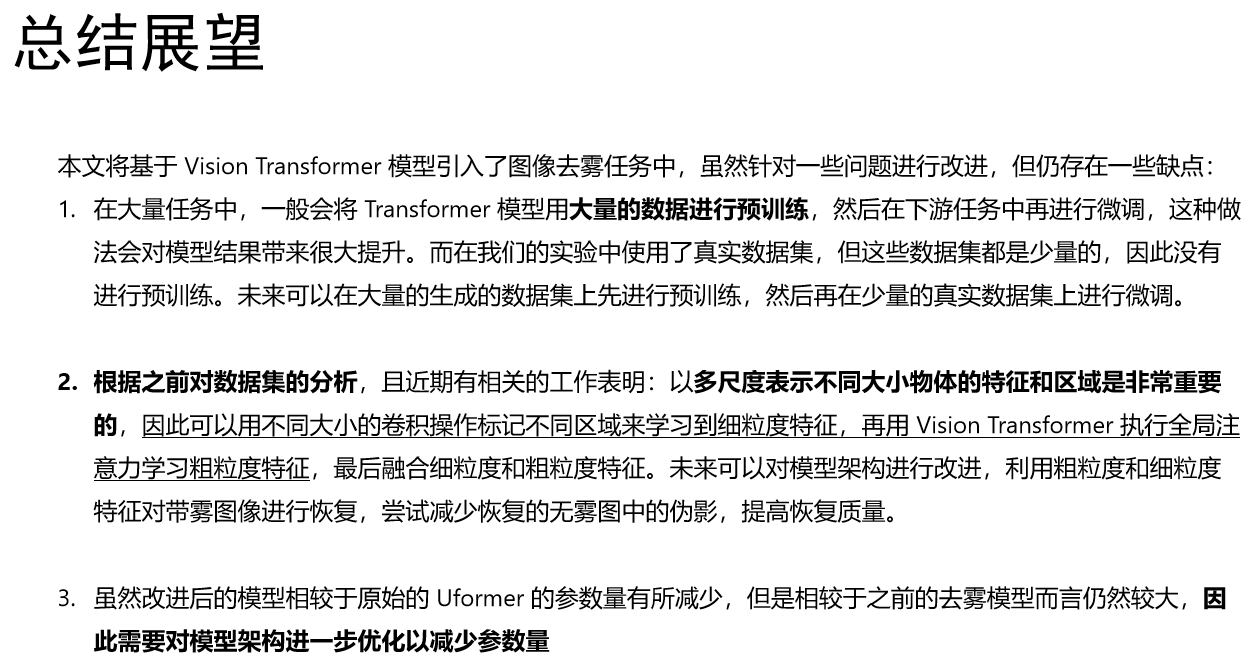

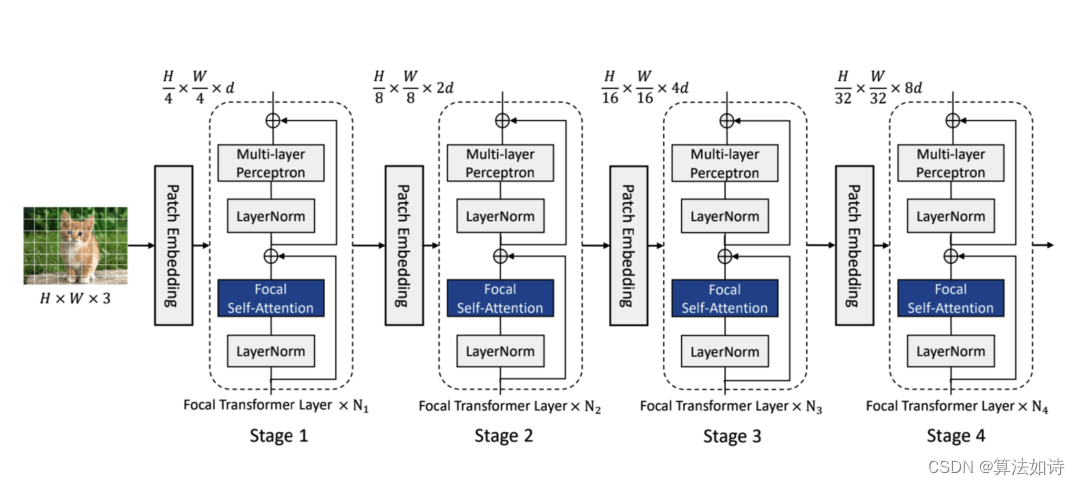

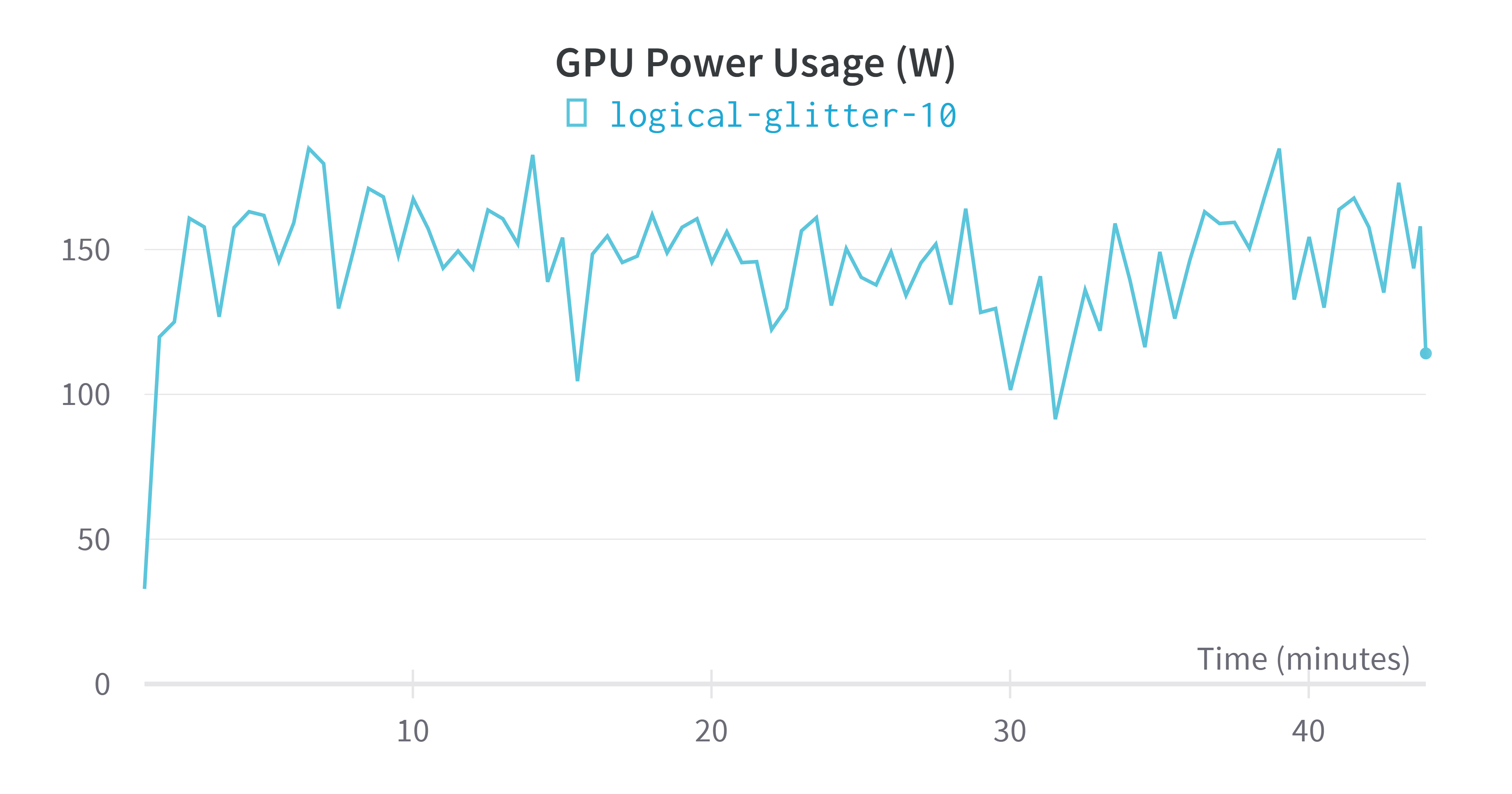

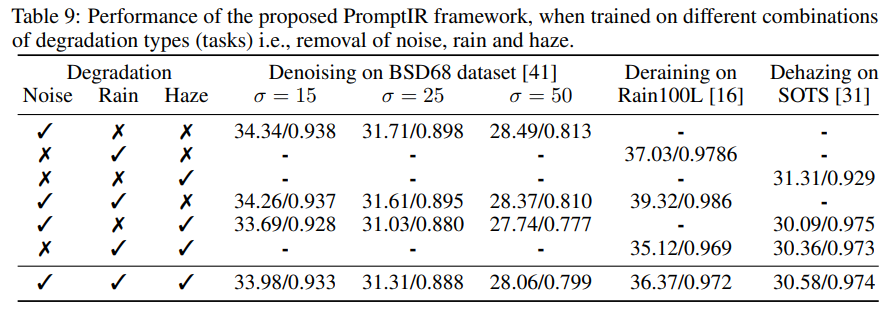

基于Vision Transformer的图像去雾算法研究与实现(附源码)

基于Vision Transformer的图像去雾算法研究与实现

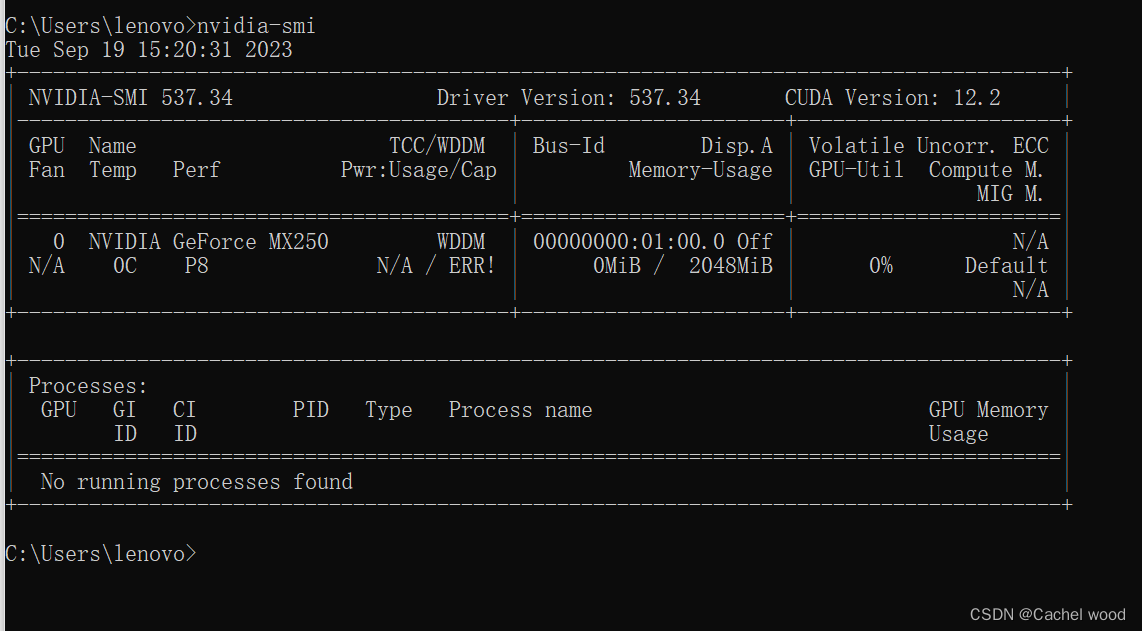

0. 服务器性能简单监控

\LOG_USE_CPU_MEMORY\文件夹下的use_memory.py文件可以实时输出CPU使用率以及内存使用率,配合nvidia-smi监控GPU使用率

可以了解服务器性能是否足够;运行时在哪一步使用率突然…

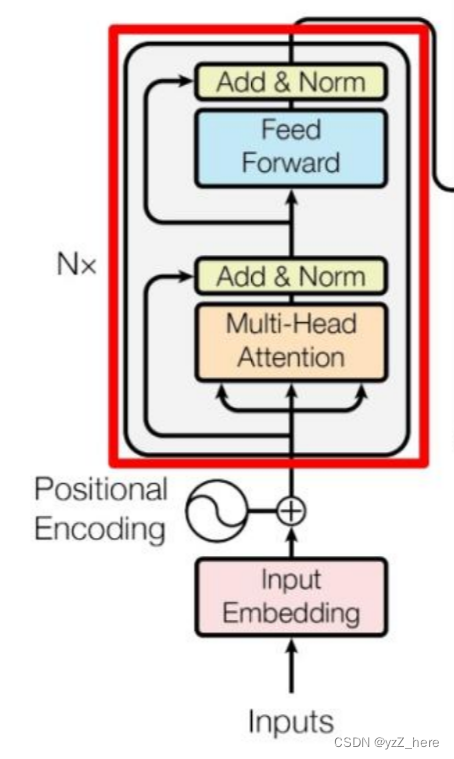

Transformer模型 | Transformer模型原理

基本原理

Transformer 是一种使用注意力机制(attention mechanism)的神经网络模型,能够有效地处理序列数据,如句子或文本。

它的设计灵感来自于人类在理解上下文时的方式。

简单来说,Transformer 会将输入的序列分成若干个小块,并通过计算注意力得分来决定每个块在输出…

【Pytorch】Transformer原理及其Pytorch实现

Seq-to-Seq (encoderattentiondecoder) CNN RNN transformer

Transformer class Transformer α1{\alpha}_1α1就是q1q_1q1和k1k_1k1做点积然后softmax得到。

self-attention 以q2q_2q2为例 q2q_2q2和别的kkk做点积,得到α1....αm{\alpha}_1...…

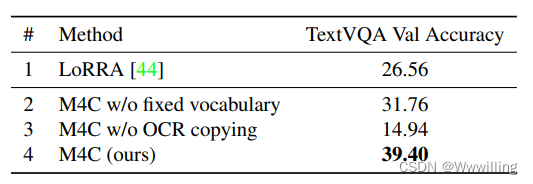

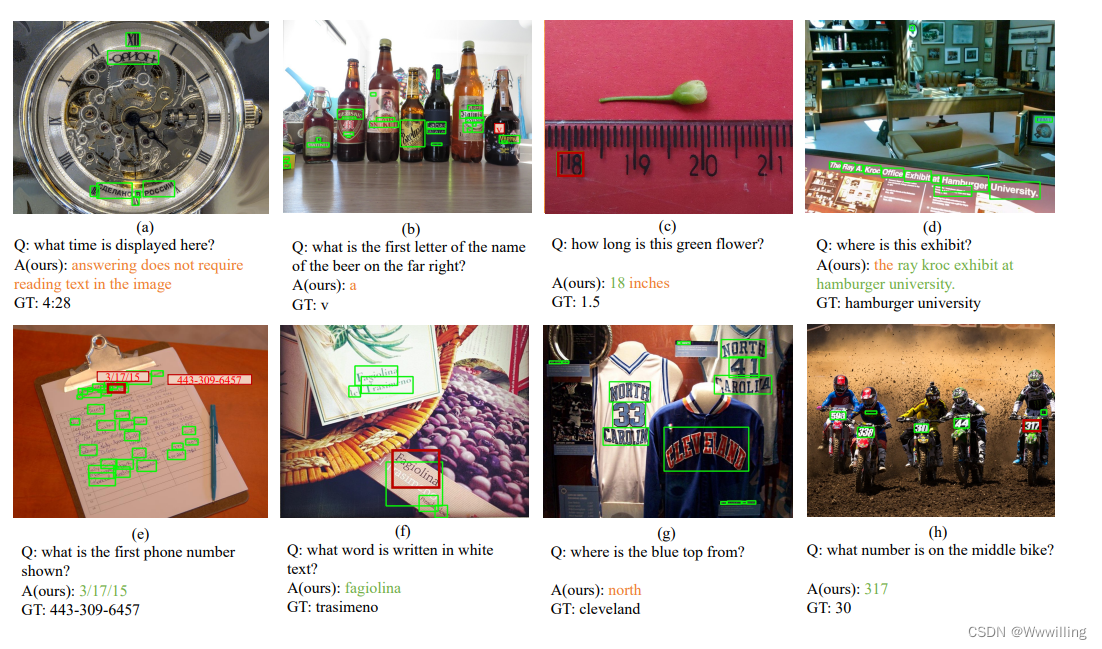

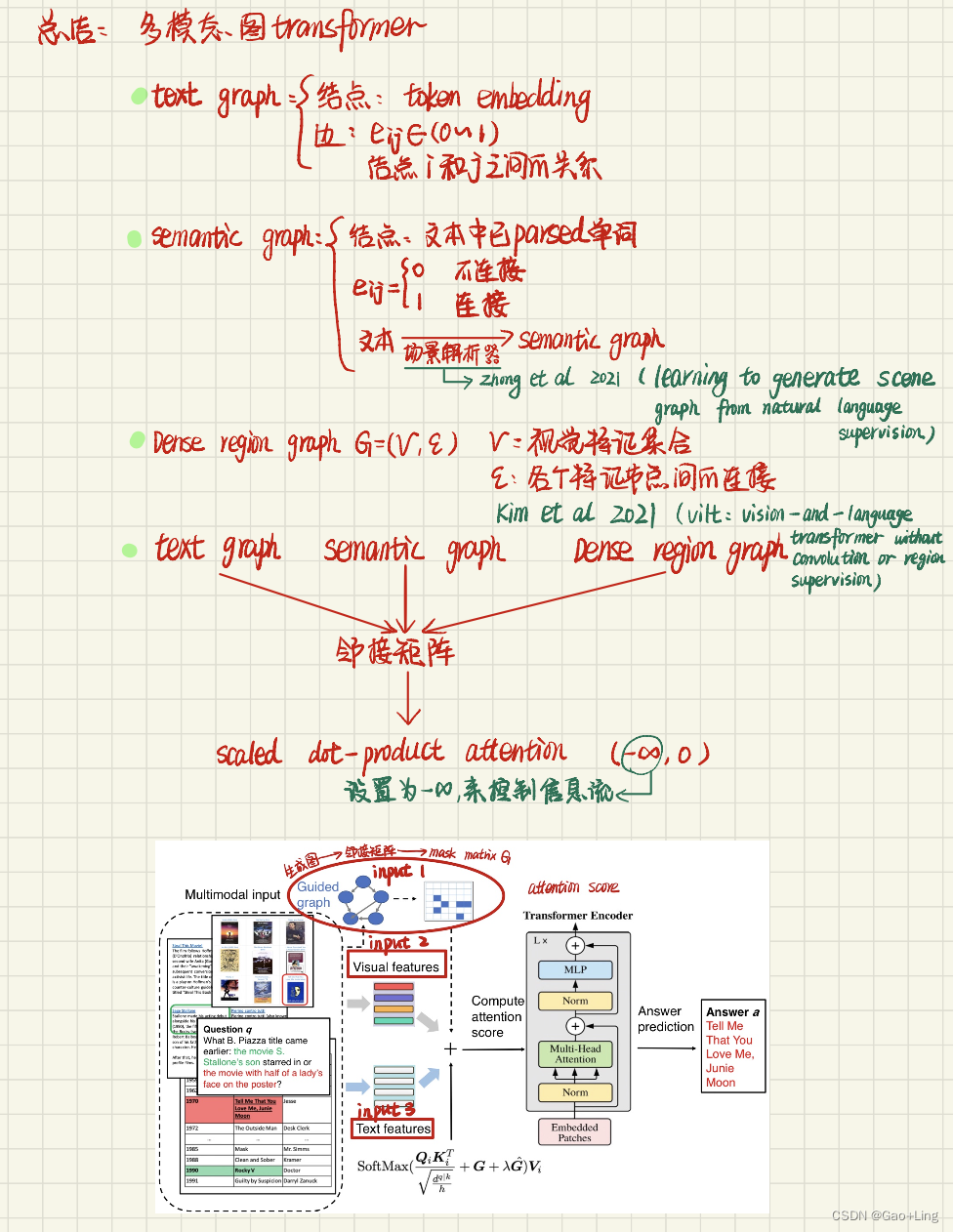

【Transformer论文】用于 TextVQA 的指针增强多模态变换器的迭代答案预测

文献题目:Iterative Answer Prediction with Pointer-Augmented Multimodal Transformers for TextVQA文献时间:2020

摘要

许多视觉场景包含带有关键信息的文本,因此理解图像中的文本对于下游推理任务至关重要。例如,警告标志上…

【Transformer论文】CMKD:用于音频分类的基于 CNN/Transformer 的跨模型知识蒸馏

文献题目:CMKD: CNN/Transformer-Based Cross-Model Knowledge Distillation for Audio Classification文献时间:2022

摘要

音频分类是一个活跃的研究领域,具有广泛的应用。 在过去十年中,卷积神经网络 (CNN) 已成为端到端音频分…

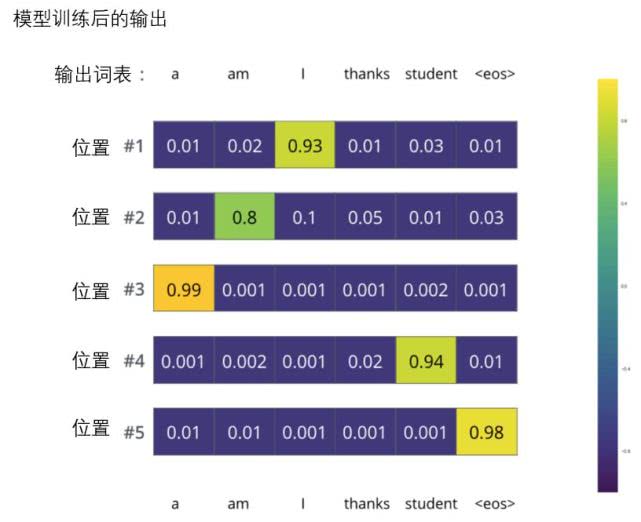

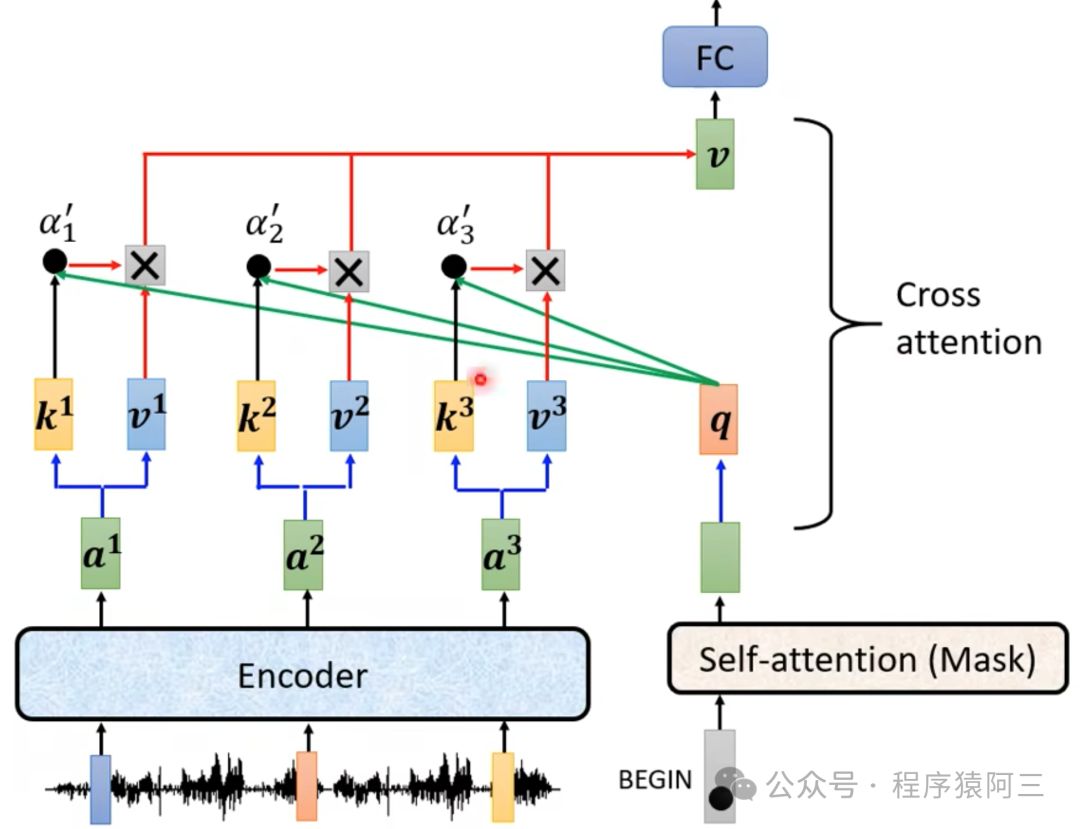

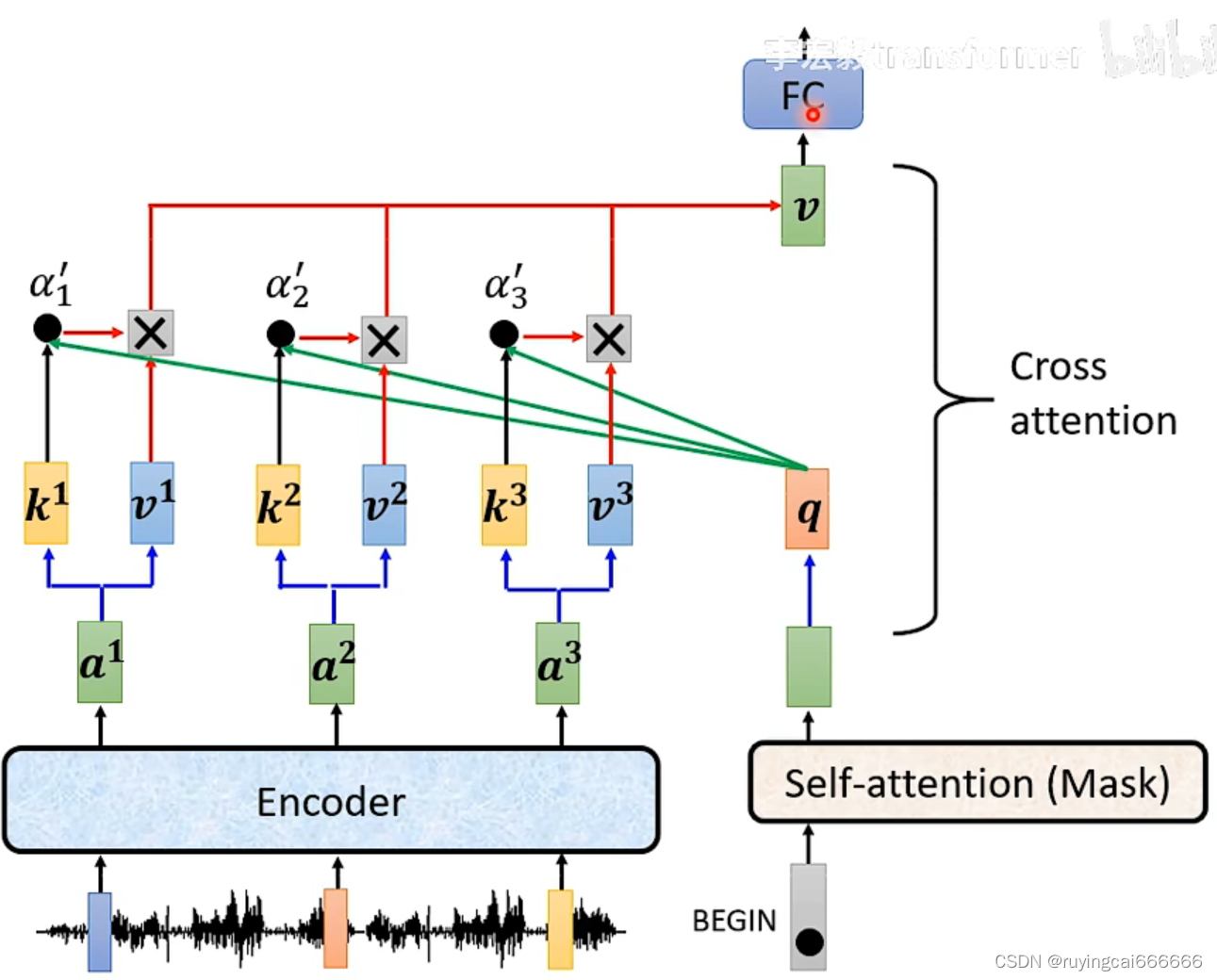

17 Transformer 的解码器(Decoders)——我要生成一个又一个单词

Transformer 编码器

编码器在干吗:词向量、图片向量,总而言之,编码器就是让计算机能够更合理地(不确定性的)认识人类世界客观存在的一些东西

Transformer 解码器

解码器会接收编码器生成的词向量,然后通…

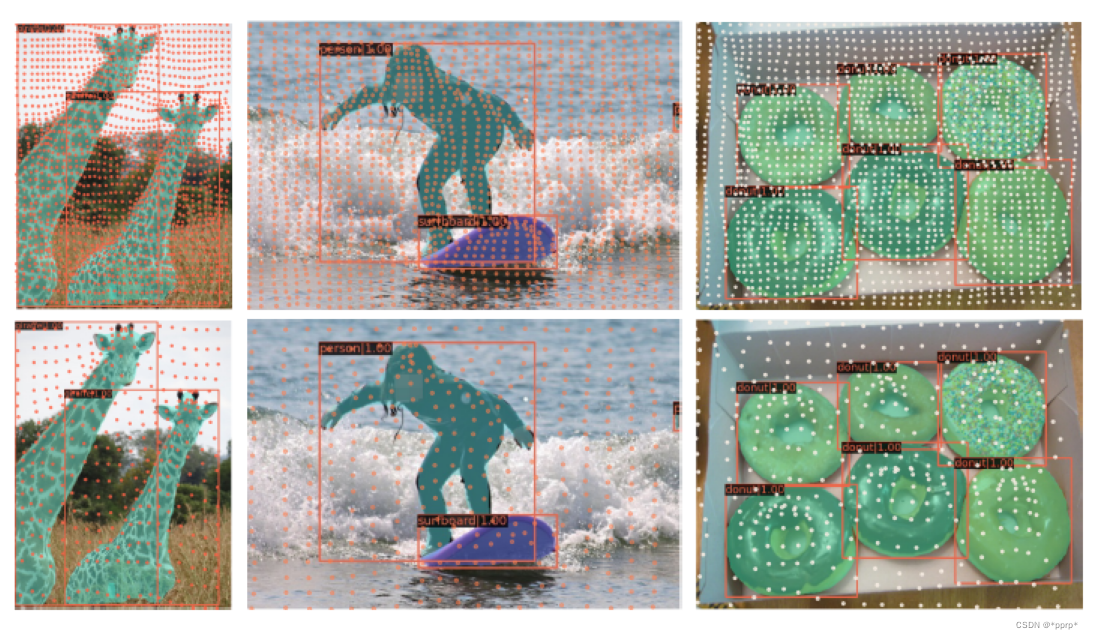

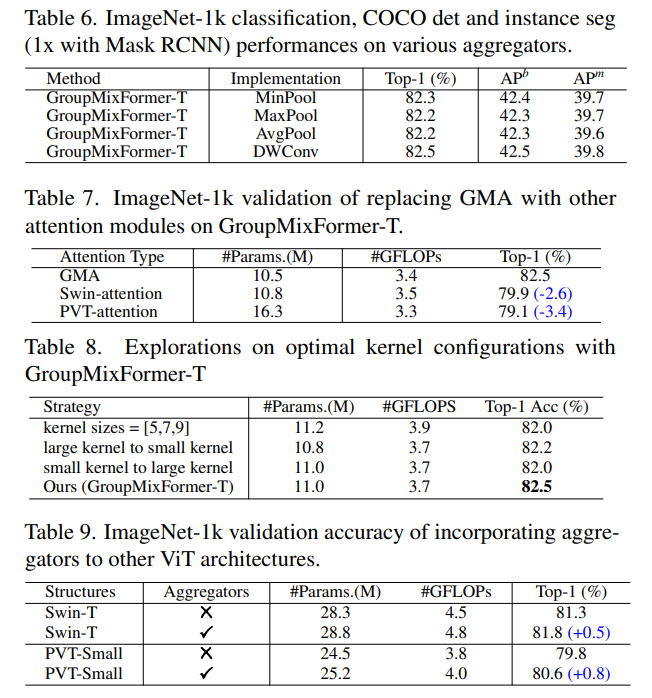

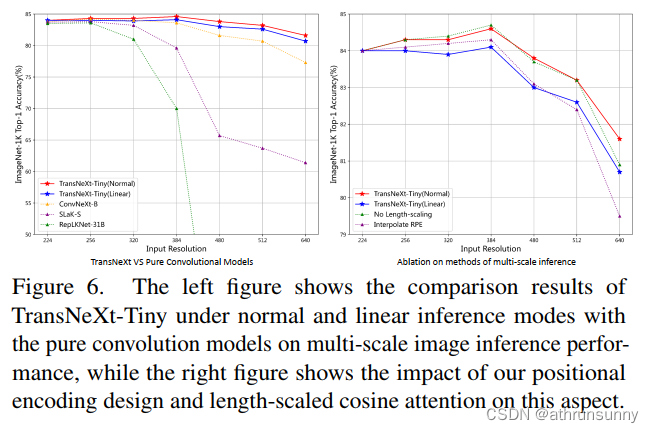

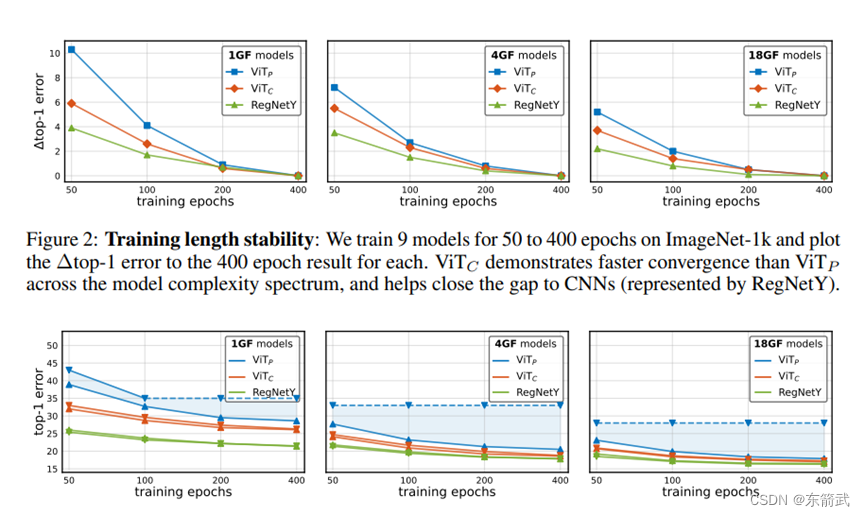

YoloV8改进策略:EfficientViT,高效的视觉transformer与级联组注意力提升YoloV8的速度和精度,打造高效的YoloV8

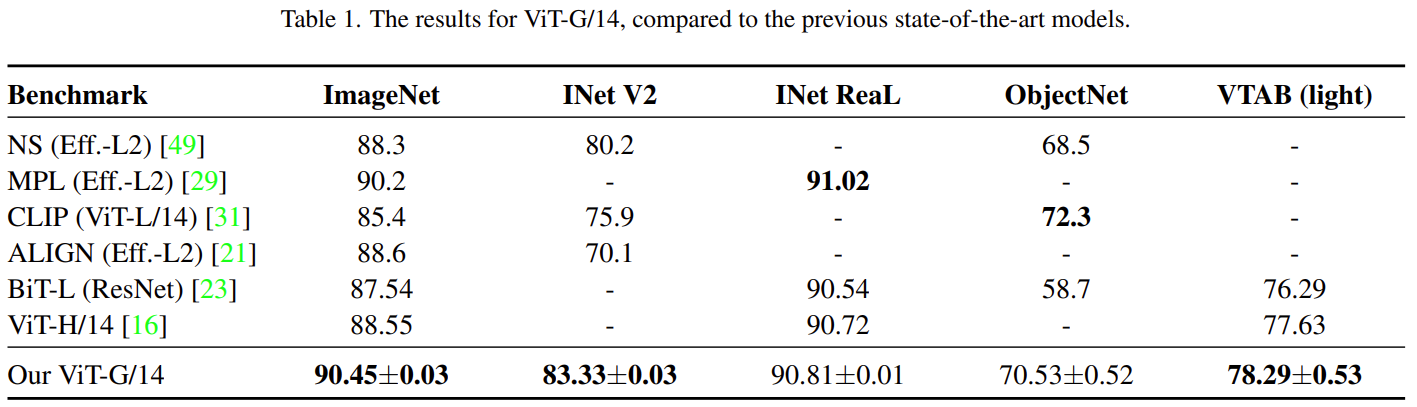

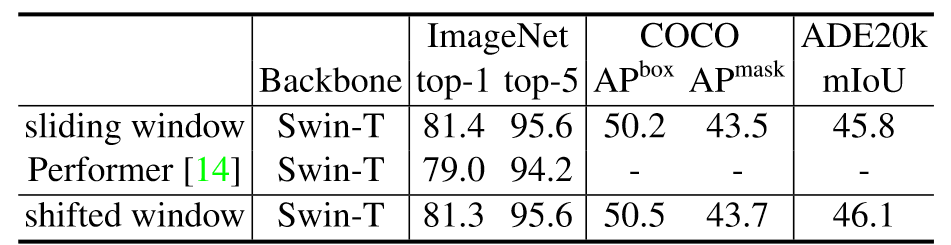

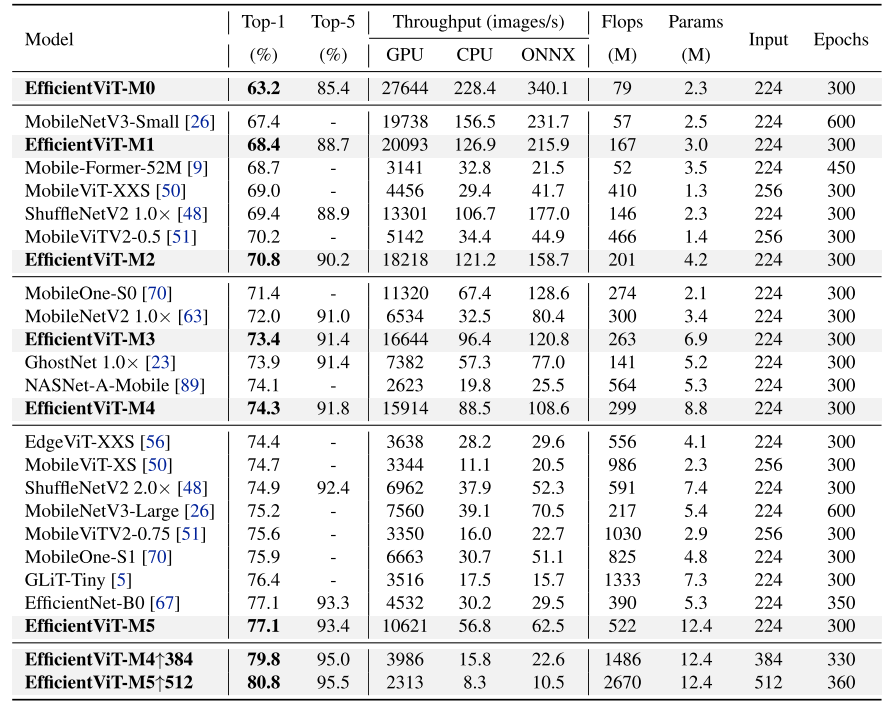

文章目录 摘要论文:《EfficientViT:高效视觉transformer与级联组注意力》1、简介2、用视觉transformer加速2.1. 内存效率2.2. 计算效率2.3. 参数效率3、高效视觉Transformer3.1. EfficientViT的构建块3.2、EfficientViT网络架构4、实验4.1. 实现细节4.2. ImageNet上的结果4.3…

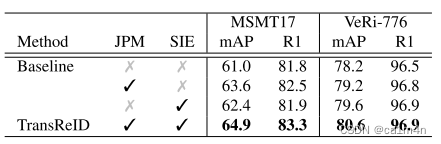

TransReID | 首次将transformer应用于行人重识别

0x00 什么是Transformer

Transformer由Attention is all you need论文提出。

摘要

优势的序列转换模型基于复杂的递归或卷积神经网络,包括一个编码器和一个解码器。性能最好的模型还通过注意力机制连接编码器和解码器。我们提出了一种新的简单网络架构࿰…

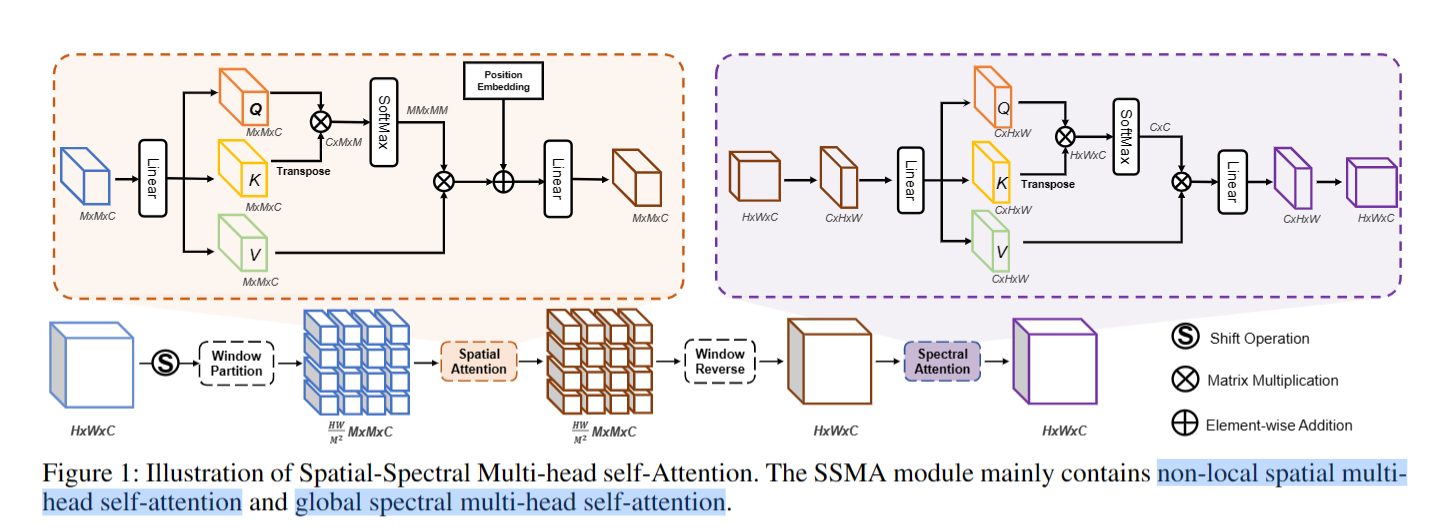

【AAAI2023】Spatial-Spectral Transformer for Hyperspectral Image Denoising

论文:https://readpaper.com/paper/4694783227240398849 代码:https://github.com/MyuLi/SST 1、总体介绍

高光谱图像(HSI)去噪是后续HSI应用的关键预处理过程,但是基于CNN的方法需要在计算效率与非局部特征建模能力之…

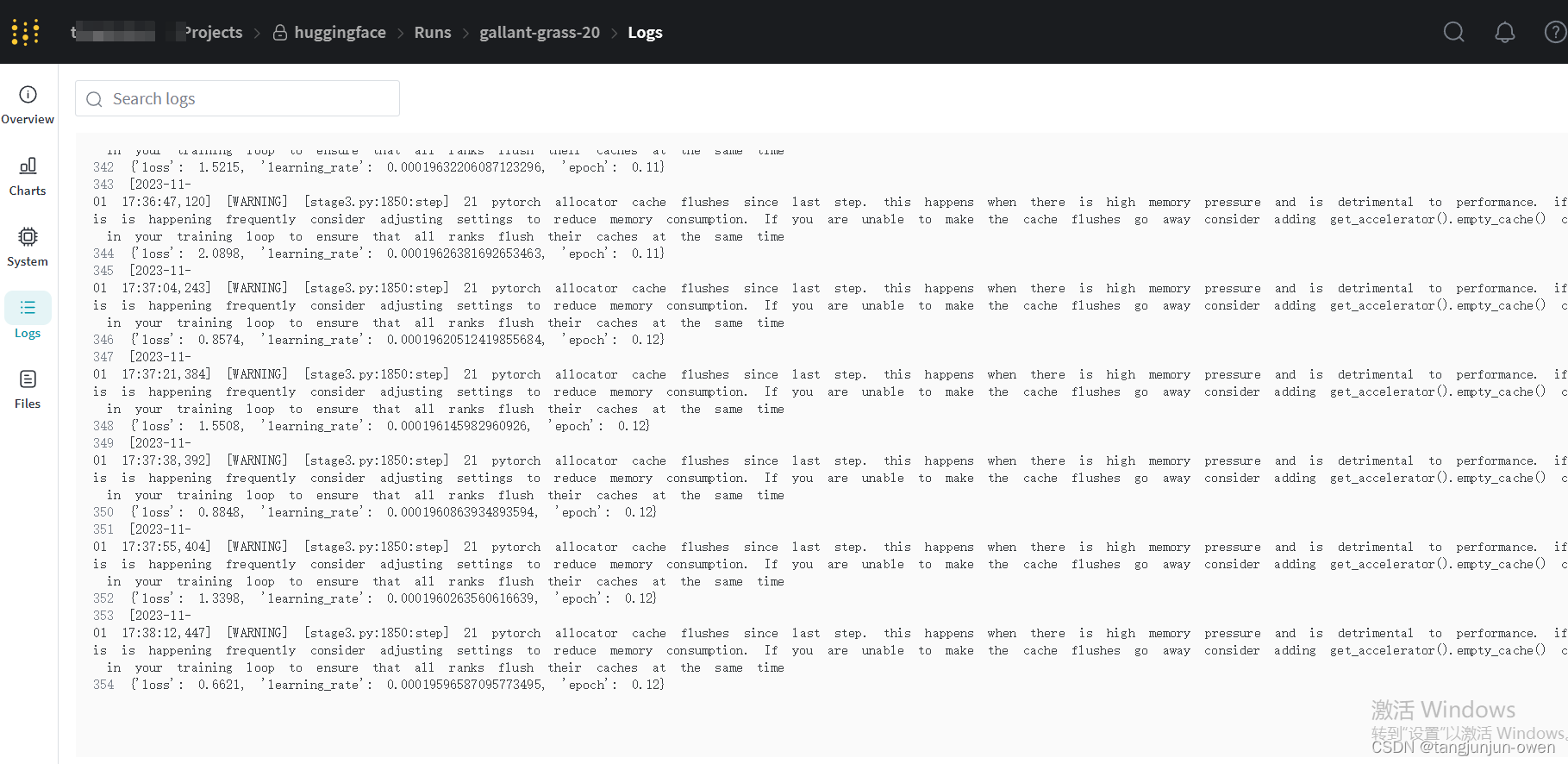

全套解决方案:基于pytorch、transformers的中文NLP训练框架,支持大模型训练和文本生成,快速上手,海量训练数据!

全套解决方案:基于pytorch、transformers的中文NLP训练框架,支持大模型训练和文本生成,快速上手,海量训练数据!

1.简介

目标:基于pytorch、transformers做中文领域的nlp开箱即用的训练框架,提…

【深度学习】Transformer简介

近年来,Transformer模型在自然语言处理(NLP)领域中横扫千军,以BERT、GPT为代表的模型屡屡屠榜,目前已经成为了该领域的标准模型。同时,在计算机视觉等领域中,Transformer模型也逐渐得到了重视&a…

【万字长文】深度解析 Transformer 和注意力机制(含完整代码实现)

深度解析 Transformer 和注意力机制 在《图解NLP模型发展:从RNN到Transformer》一文中,我介绍了 NLP 模型的发展演化历程,并用直观图解的方式为大家展现了各技术的架构和不足。有读者反馈图解方式虽然直观,但深度不足。考虑到 Tra…

Yolov8轻量化:EMO,结合 CNN 和 Transformer 的现代倒残差移动模块设计,性能优于EdgeViT、Mobile-former等网络

论文: https://arxiv.org/pdf/2301.01146.pdf 🏆🏆🏆🏆🏆🏆Yolo轻量化模型🏆🏆🏆🏆🏆🏆 重新思考了 MobileNetv2 中高效的倒残差模块 Inverted Residual Block 和 ViT 中的有效 Transformer 的本质统一,归纳抽象了 MetaMobile Block 的一般…

LSTM已死,Transformer永生(面试问答RNN/LSTM/Transformer)

计算机视觉面试题-Transformer相关问题总结:https://zhuanlan.zhihu.com/p/554814230 计算机视觉面试31题 CV面试考点,精准详尽解析:https://zhuanlan.zhihu.com/p/257883797

1. 循环神经网络(Recurrent Neural Networks, RNN&am…

gradio使用transformer模块demo介绍1:Text Natural Language Processing

文章目录 文本生成 Text Generation自动完成 Autocomplete情感分析 Sentiment Analysis命名实体识别 Name Entity Recognition NER多语种翻译文本生成 Text Generation

import gradio as gr

from transformers import pipelinegenerator = pipeline(text-generation, model=&l…

深度学习一点通:PyTorch Transformer 预测股票价格,虚拟数据,chatGPT同源模型

预测股票价格是一项具有挑战性的任务,已引起研究人员和从业者的广泛关注。随着深度学习技术的出现,已经提出了许多模型来解决这个问题。其中一个模型是 Transformer,它在许多自然语言处理任务中取得了最先进的结果。在这篇博文中,…

chatgpt技术总结(包括transformer,注意力机制,迁移学习,Ray,TensorFlow,Pytorch)

最近研读了一些技术大咖对chatgpt的技术研讨,结合自己的一些浅见,进行些许探讨。 我们惊讶的发现,chatgpt所使用的技术并没有惊天地泣鬼神的创新,它只是将过去的技术潜能结合现在的硬件最大化的发挥出来,也正因如此&am…

Transformer模型 | Transformer模型描述

谷歌推出的BERT模型在11项NLP任务中夺得SOTA结果,引爆了整个NLP界。而BERT取得成功的一个关键因素是Transformer的强大作用。谷歌的Transformer模型最早是用于机器翻译任务,当时达到了SOTA效果。Transformer改进了RNN最被人诟病的训练慢的缺点,利用self-attention机制实现快…

Transformer——encoder

本文参考了b站的Eve的科学频道中的深入浅出解释Transformer原理和DASOU讲AI中的Transformer从零详解。 入浅出解释Transformer原理 Transformer从零详解

前言:

在自然语言识别中,之前讲过lstm,但是lstm有明显的缺陷,就是当文本过…

从统计语言模型到预训练语言模型---预训练语言模型(Transformer)

预训练模型的概念在计算机视觉领域并不陌生, 通常我们可以在大规模图像数据集上预先训练出一个通用 模型, 之后再迁移到类似的具体任务上去, 这样在减少对图像样本需求的同时, 也加速了模型的开发速度。计 算机视觉领域采用 Image…

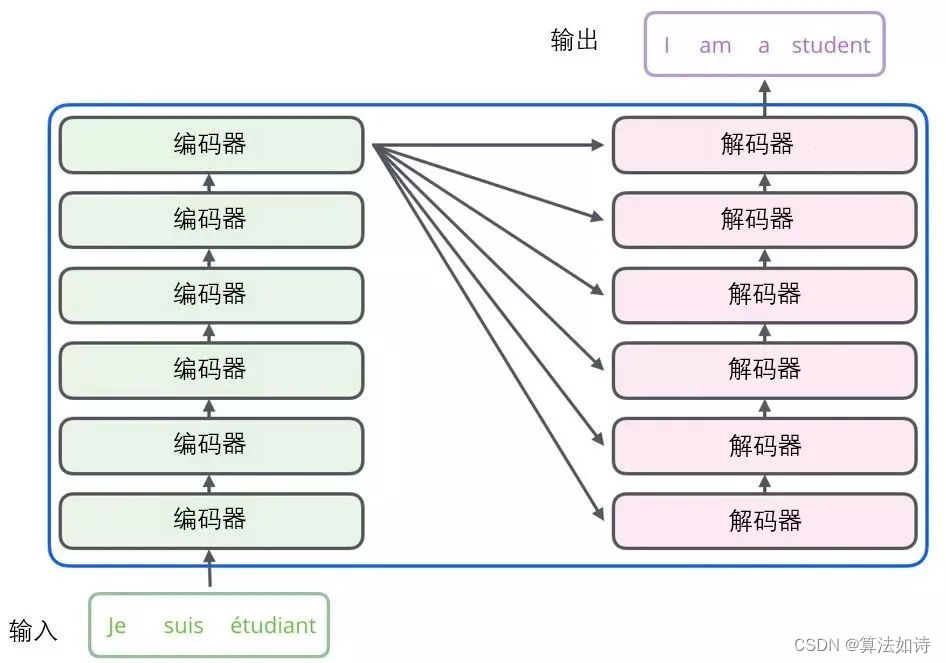

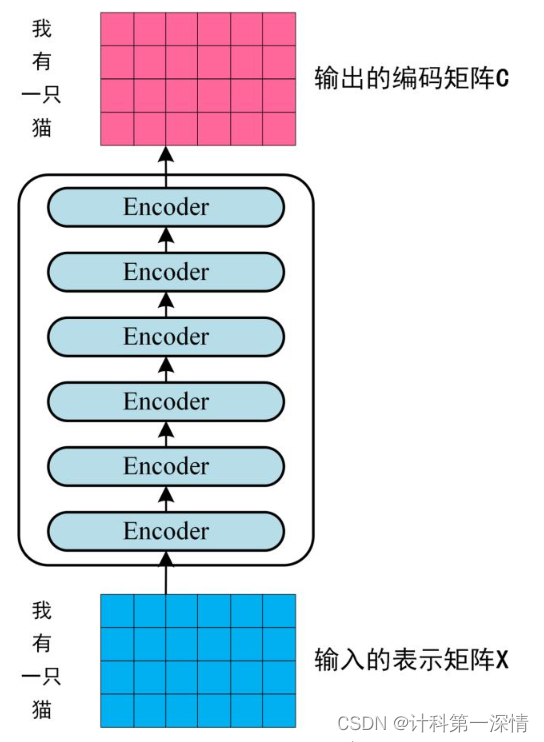

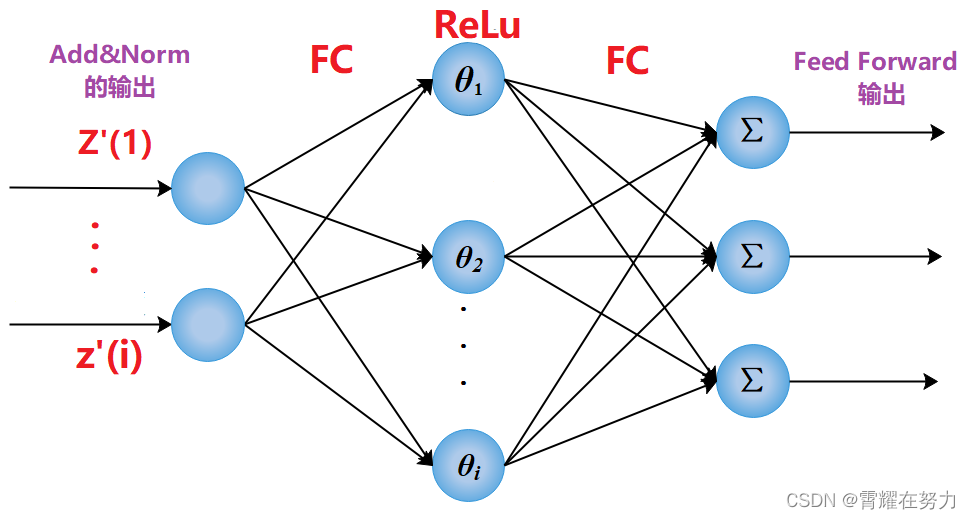

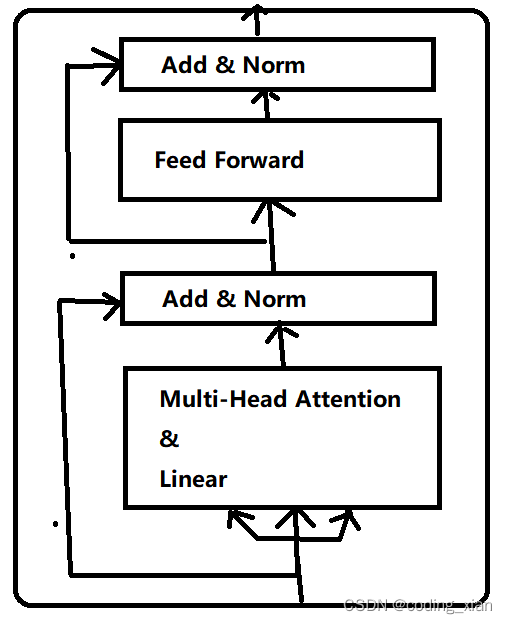

自然语言处理---Tr ansformer机制详解之Transformer结构

1 Encoder模块

1.1 Encoder模块的结构和作用

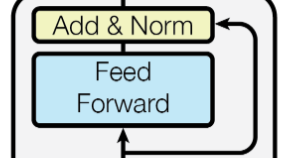

经典的Transformer结构中的Encoder模块包含6个Encoder Block.每个Encoder Block包含一个多头自注意力层,和一个前馈全连接层.

1.2 Encoder Block

在Transformer架构中,6个一模一样的Encoder …

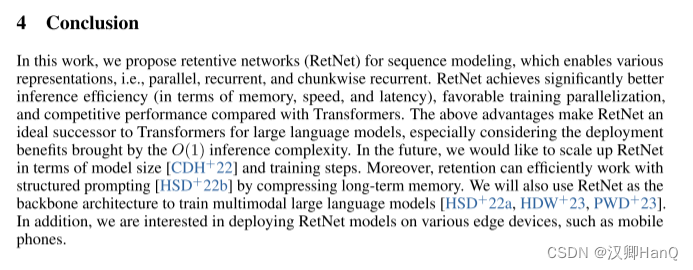

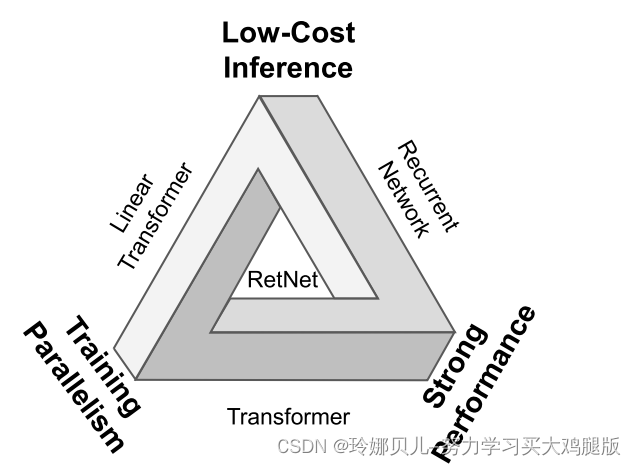

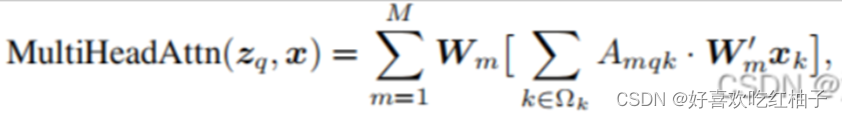

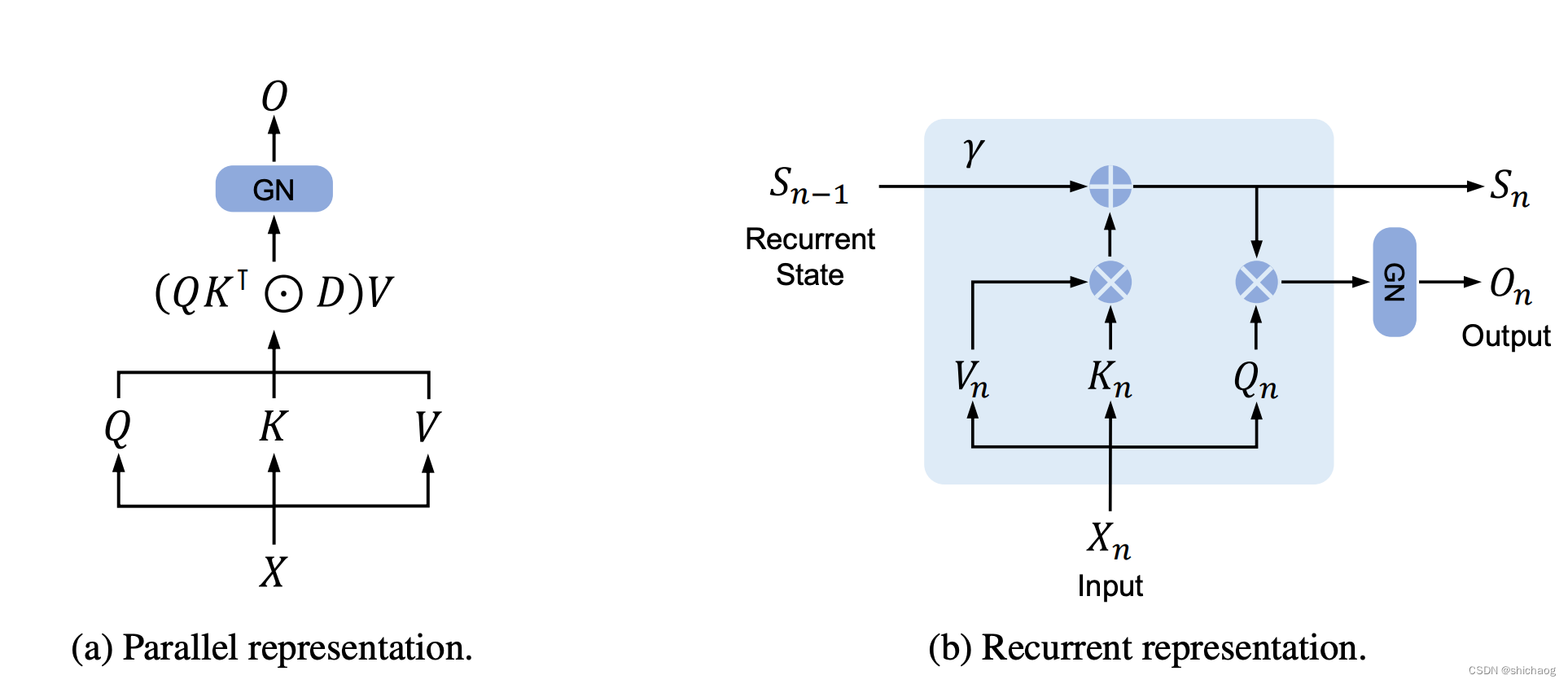

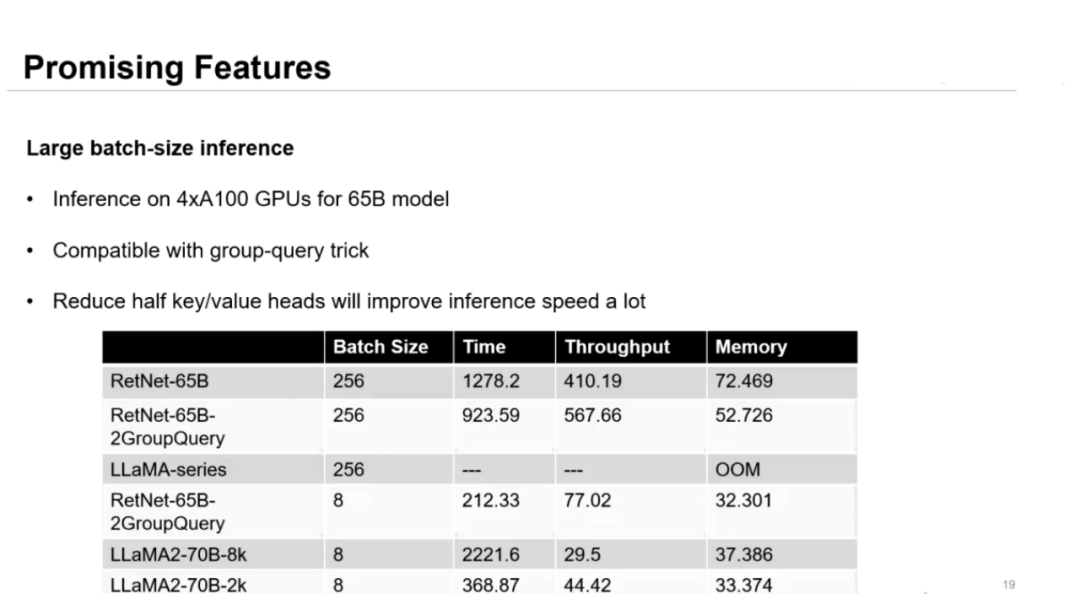

P12-Retentive NetWork-RetNet挑战Transformer

论文地址:https://arxiv.org/abs/2307.08621 目录 Abstract

一.Introduction

二.Retentive Networks

2.1Retention

2.2Gated Multi-Scale Retention

2.3Overall Architecture of Retention Networks

2.4Relation to and Differences from Previous Methods

三.Experime…

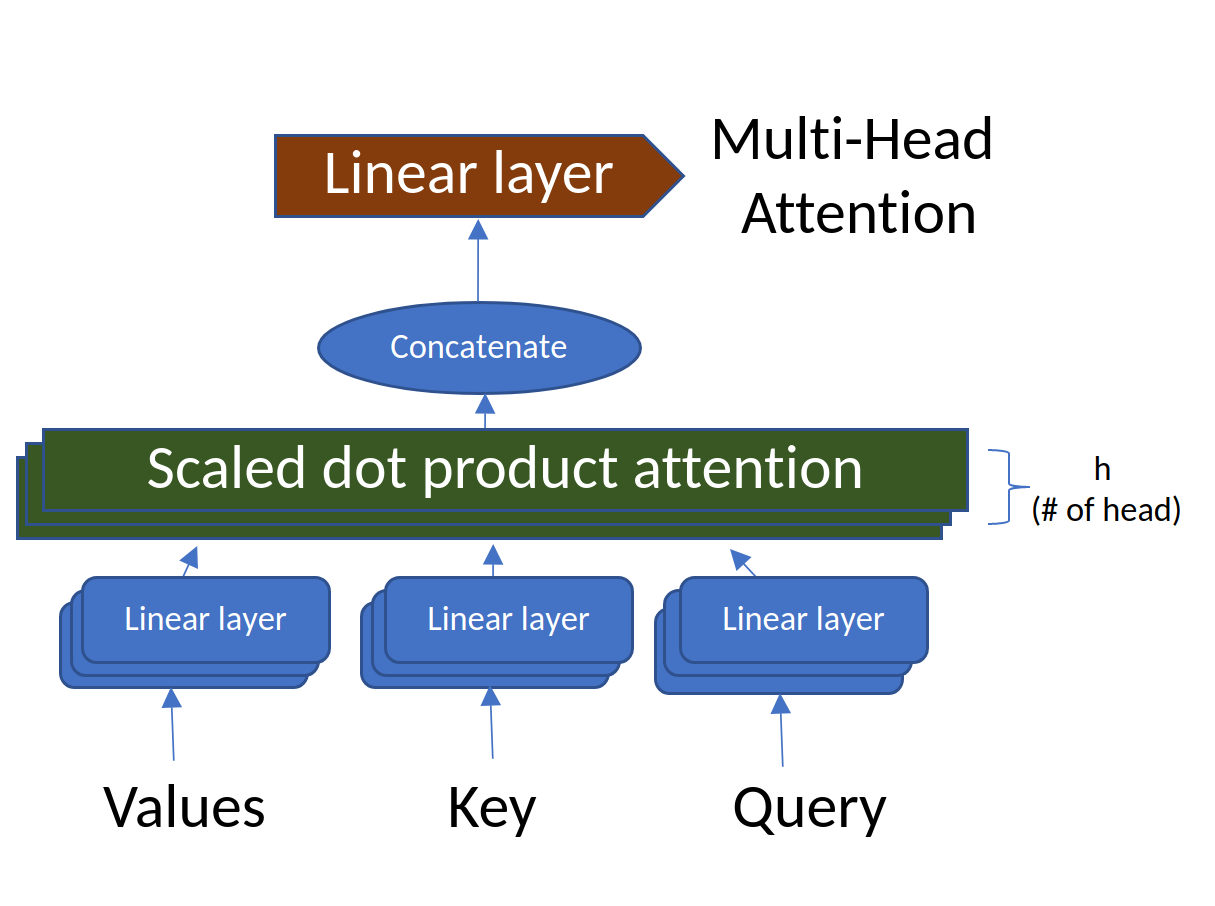

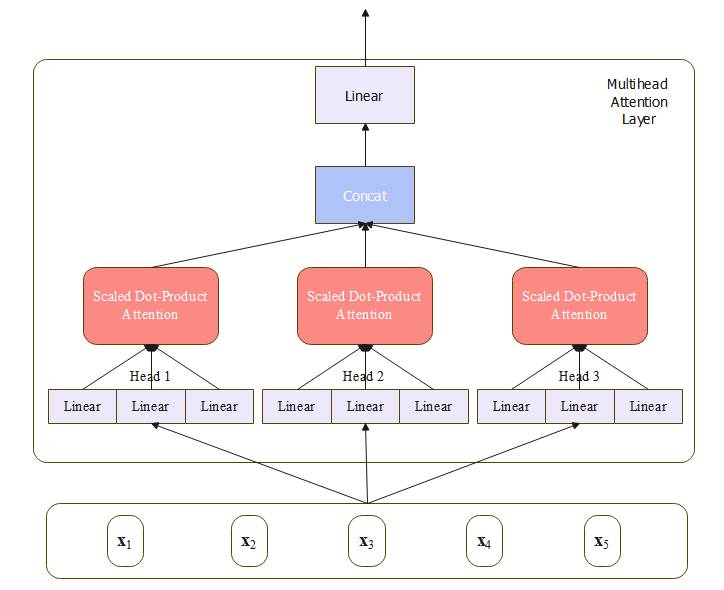

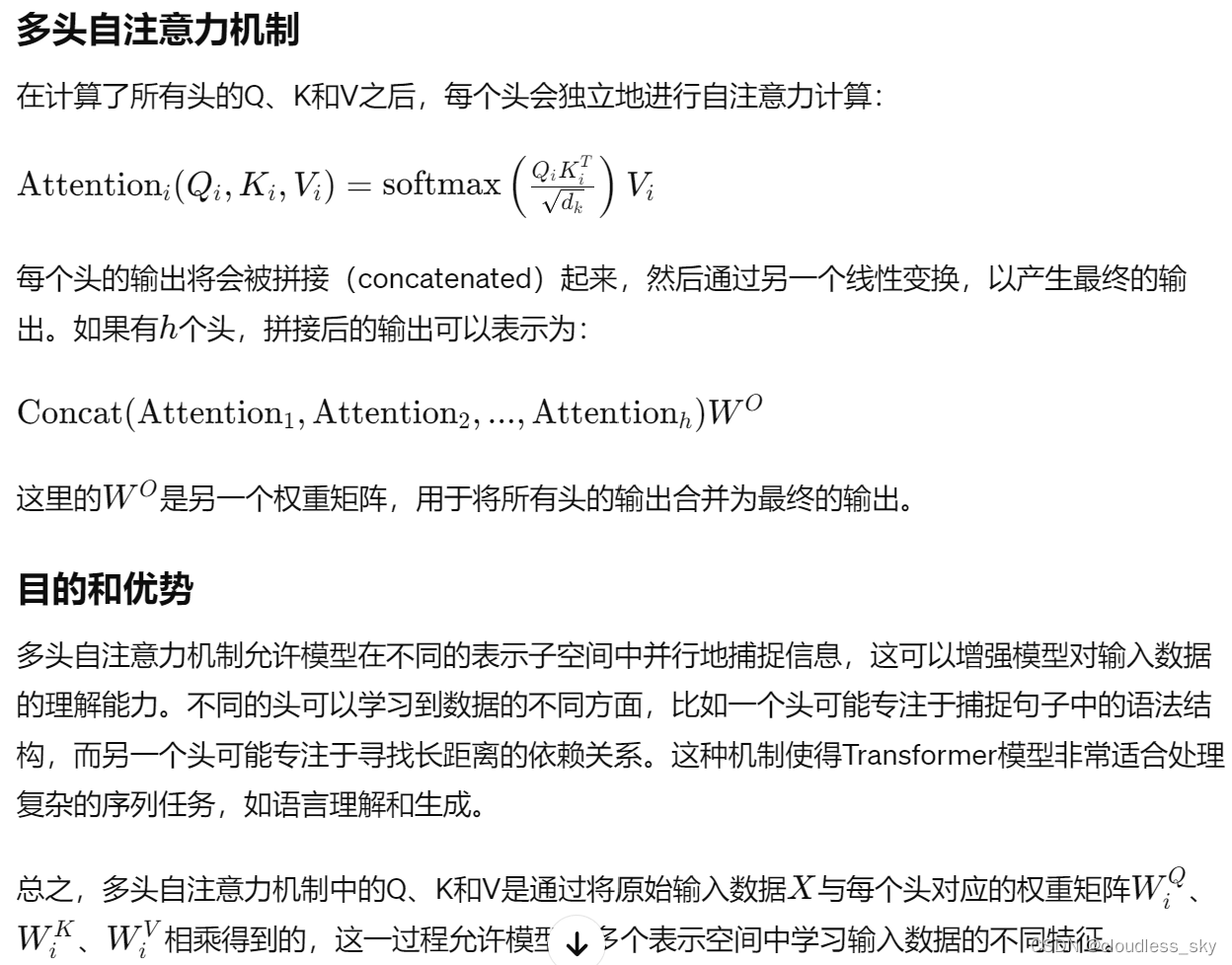

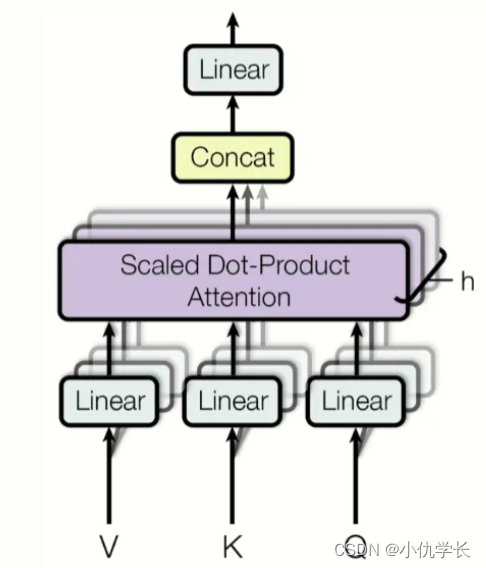

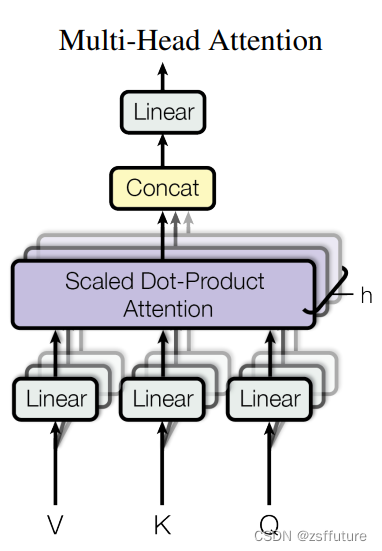

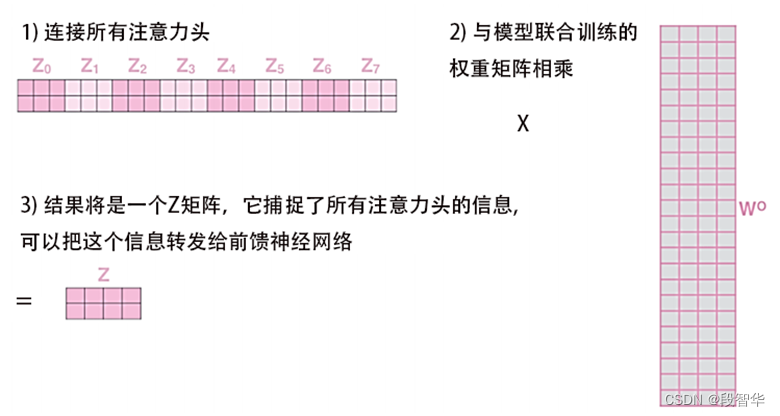

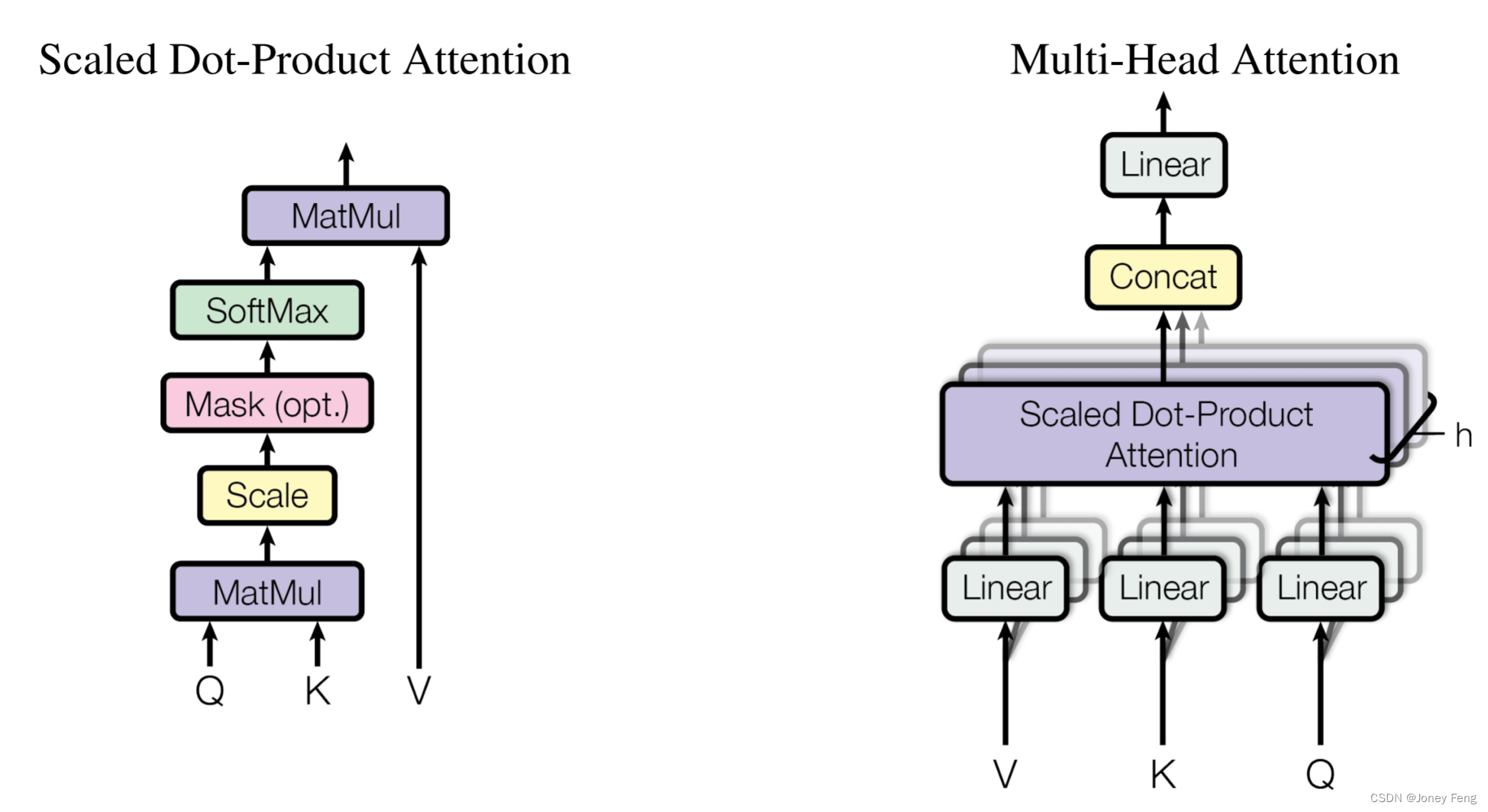

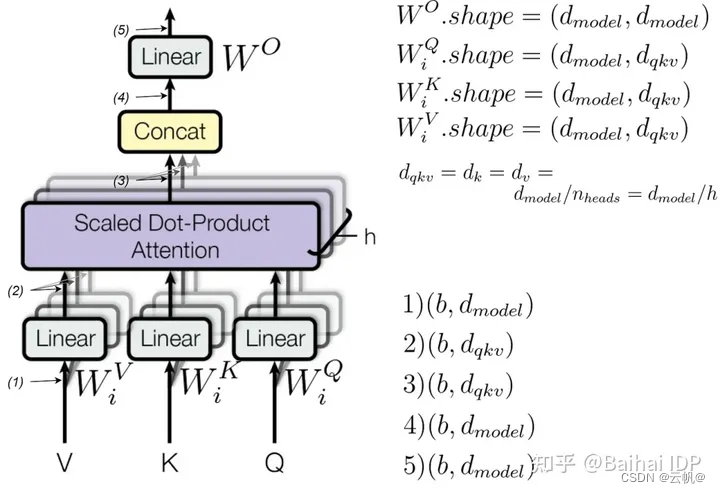

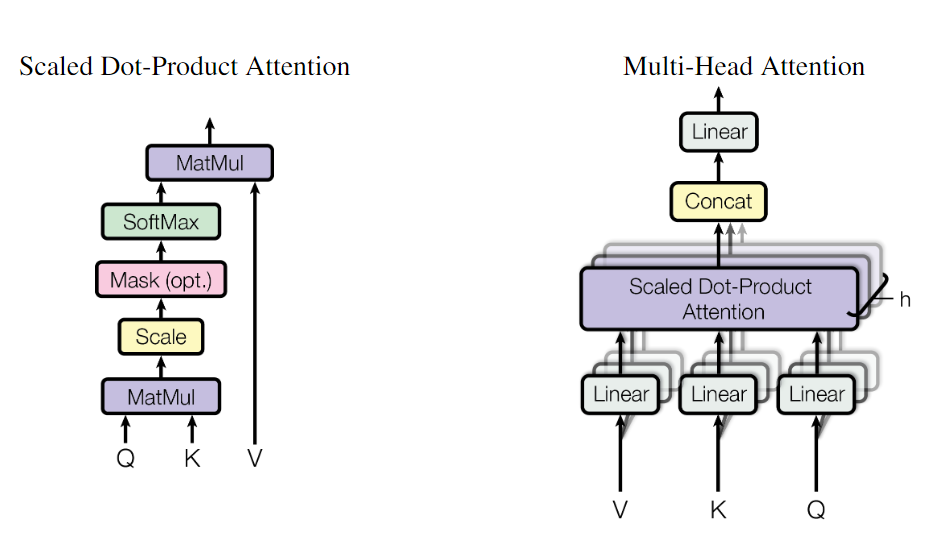

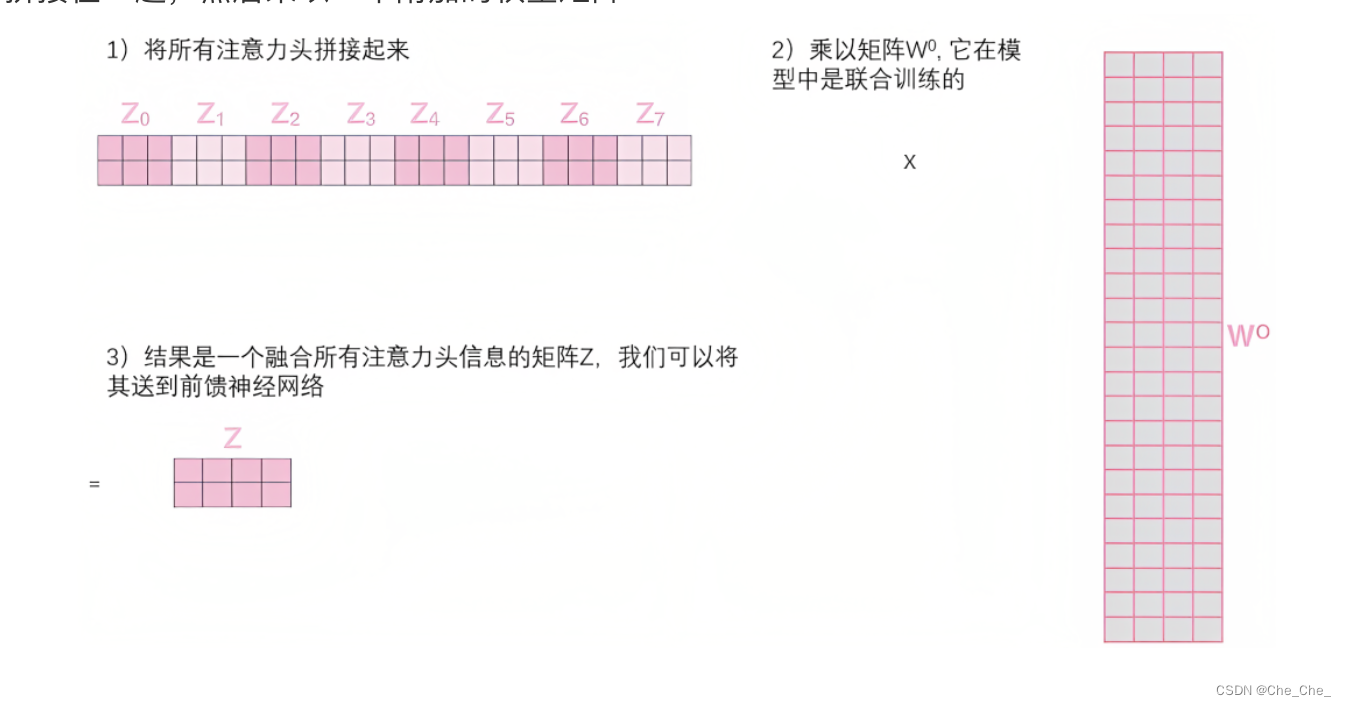

Transformer中的多头注意力机制-为什么需要多头?

Transformer为什么使用多头注意力机制呢?

多头可以学习到不同维度的特征和信息。为什么可以学习到不同维度的信息呢?

答案是:多头注意力机制的组成是有单个的self attention,由于self attention通过产生QKV矩阵来学习数据特征&a…

使用 Transformer 模型进行自然语言处理

自然语言处理是一项重要的人工智能技术,旨在帮助计算机理解人类语言。在过去的几年中,Transformer 模型已经成为自然语言处理领域的一种非常流行的模型。在本文中,我们将介绍 Transformer 模型的原理和实现,并展示如何使用 Transf…

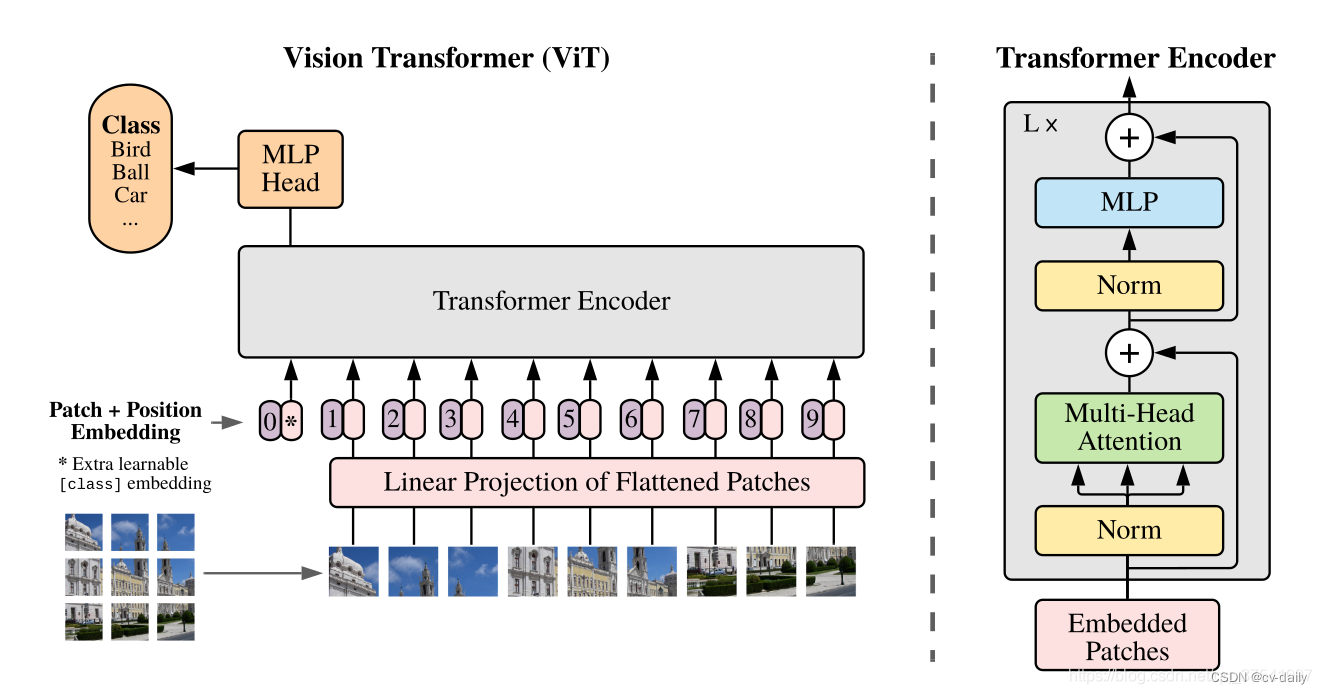

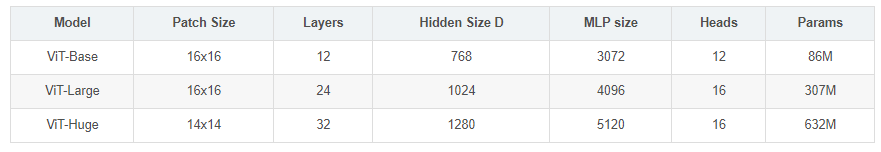

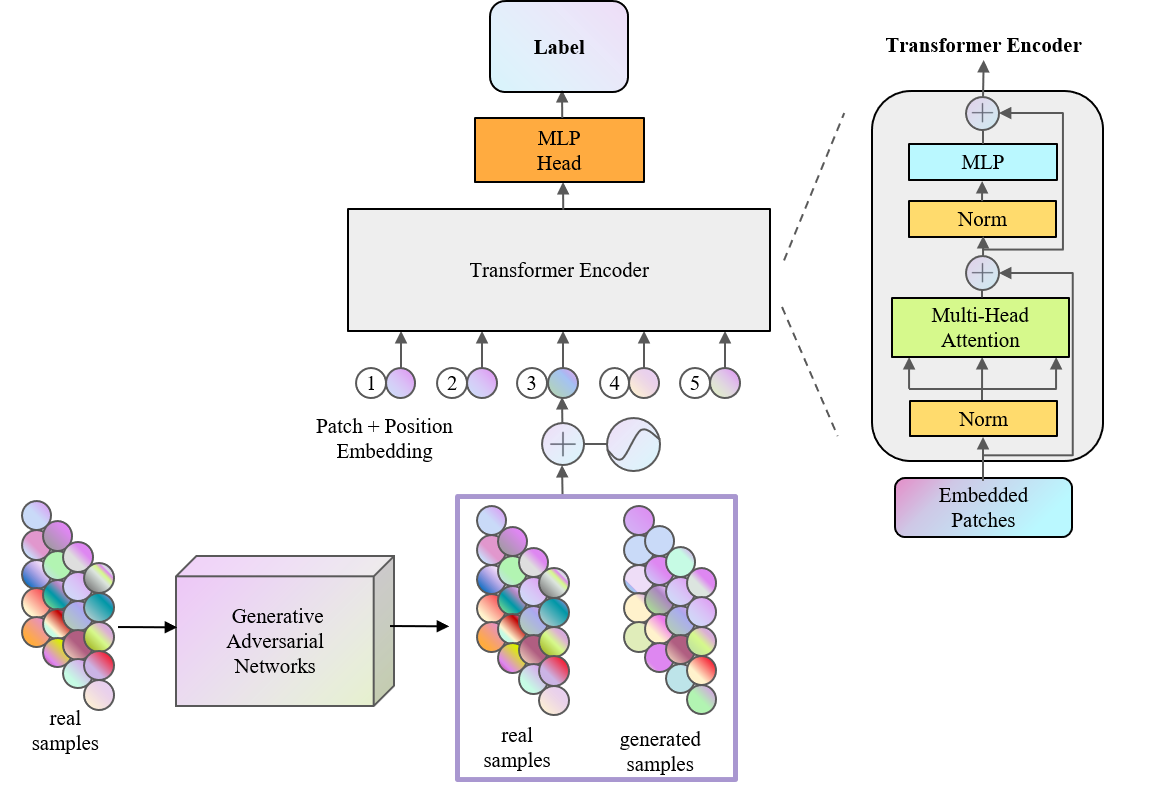

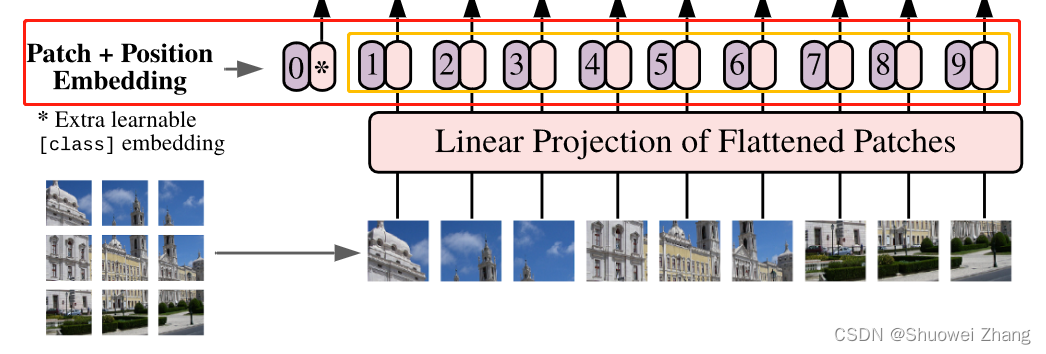

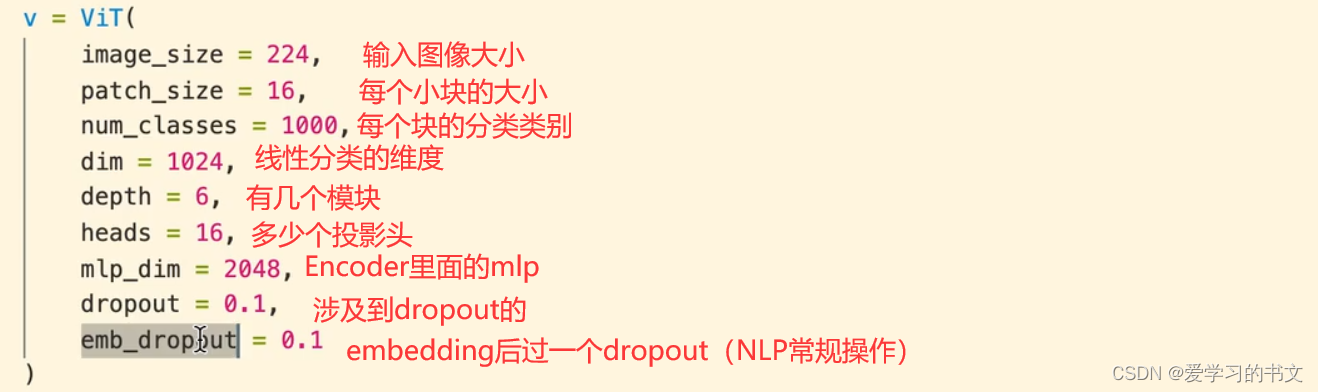

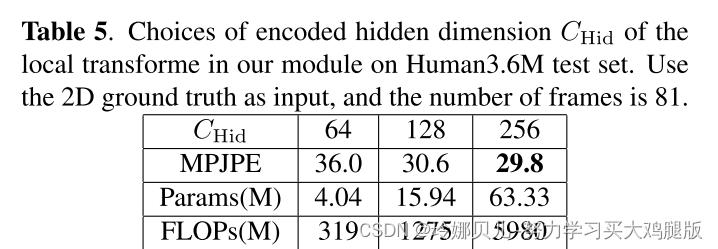

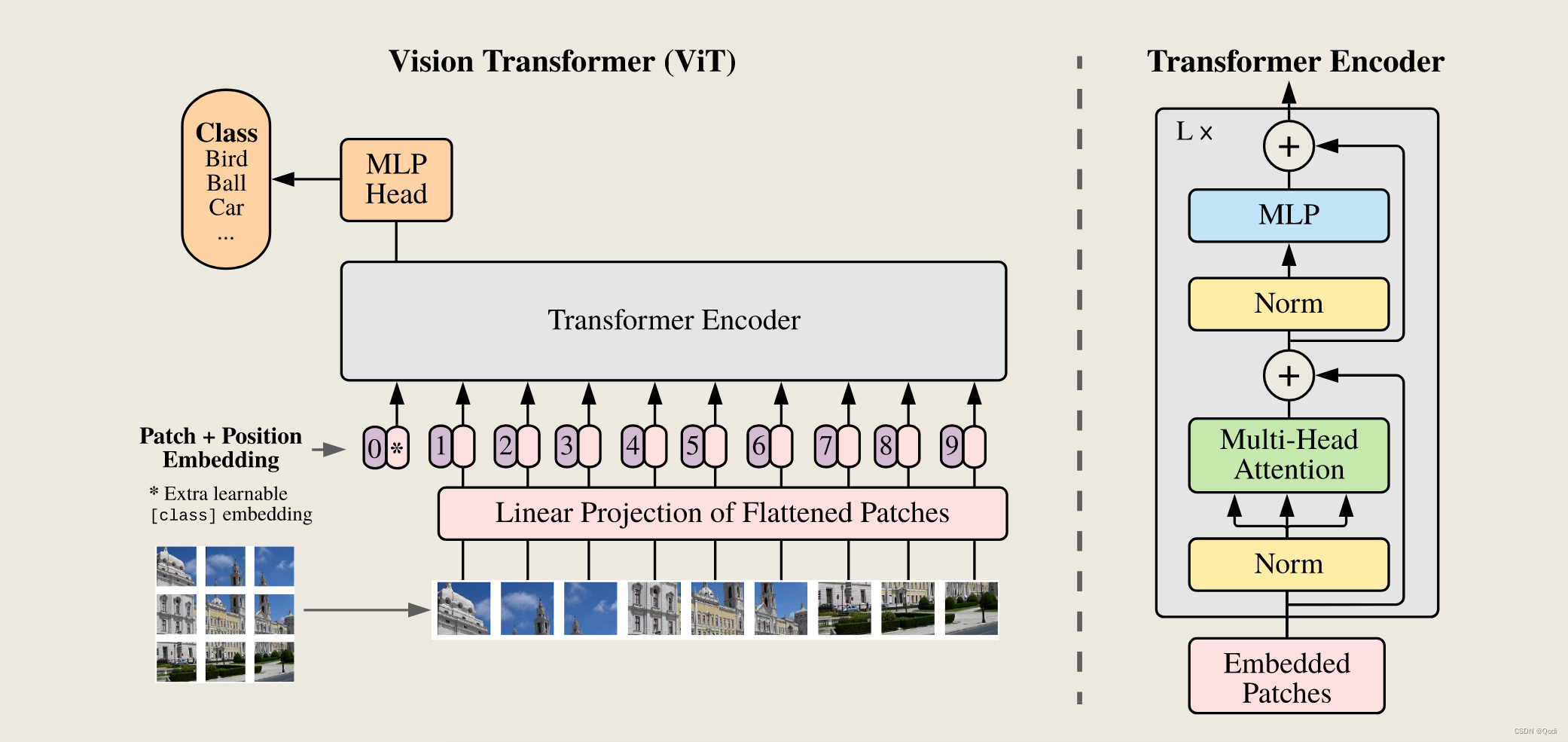

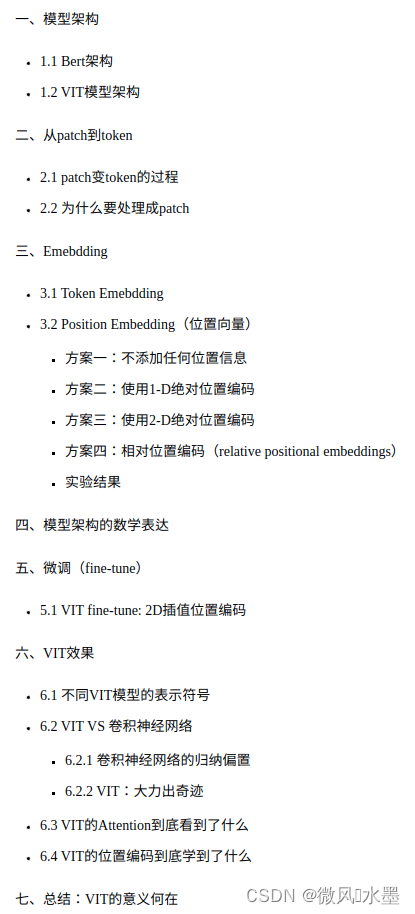

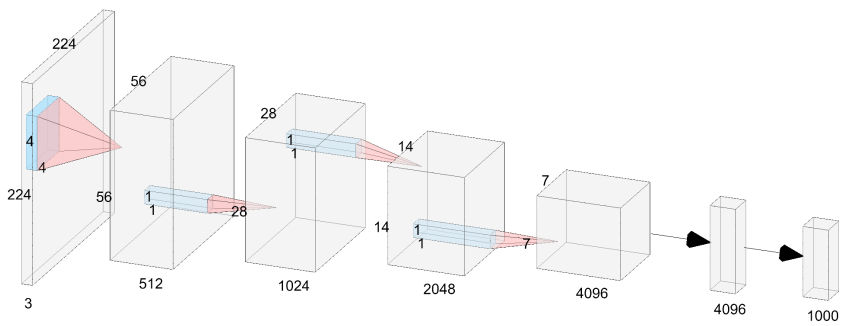

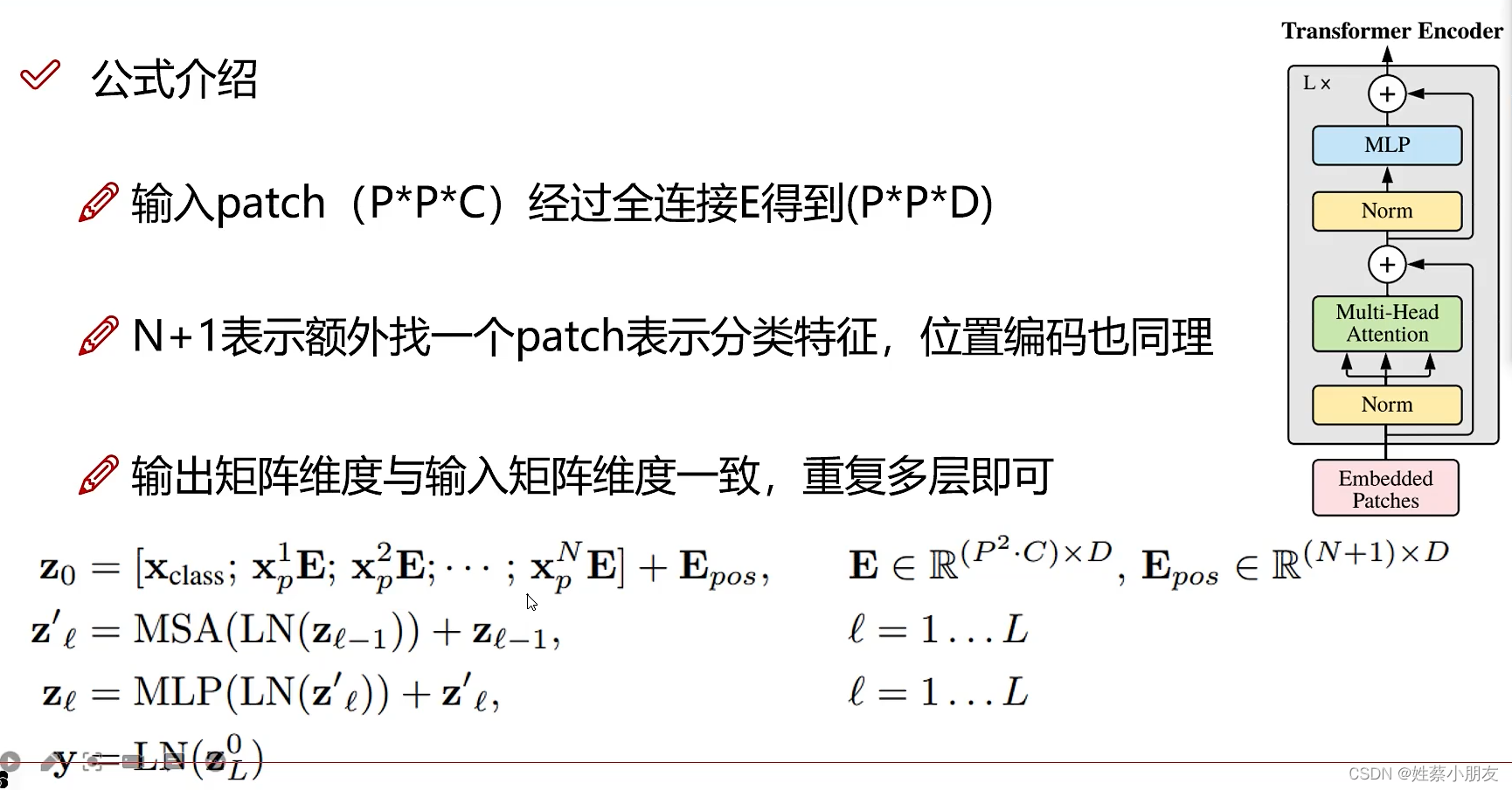

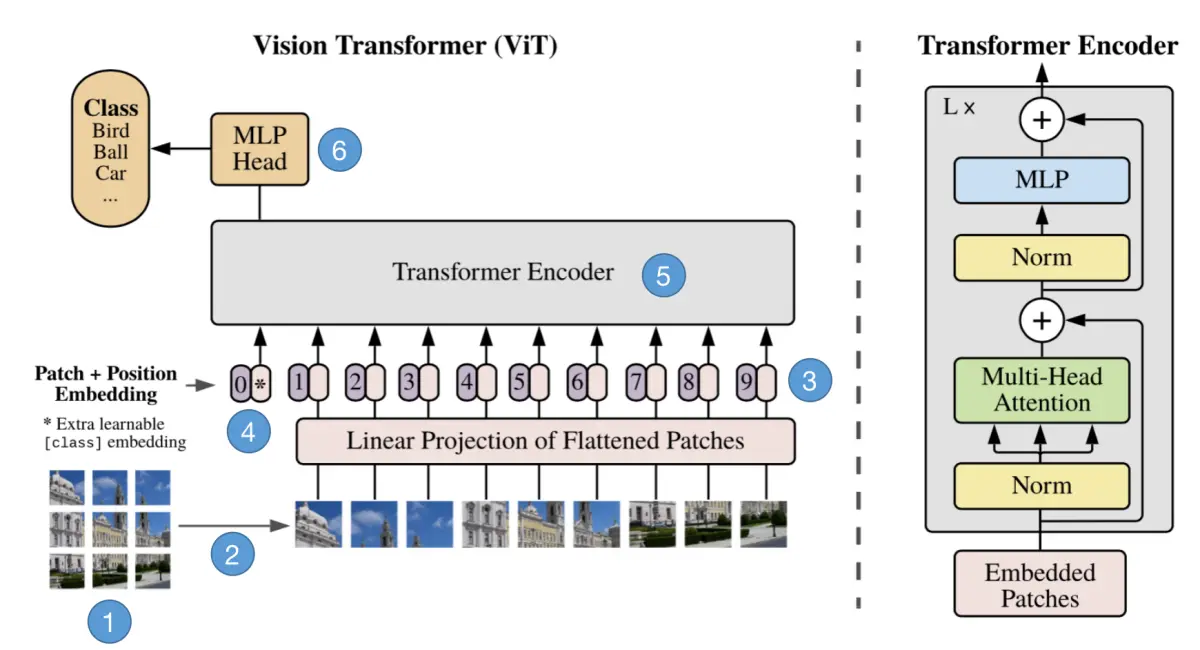

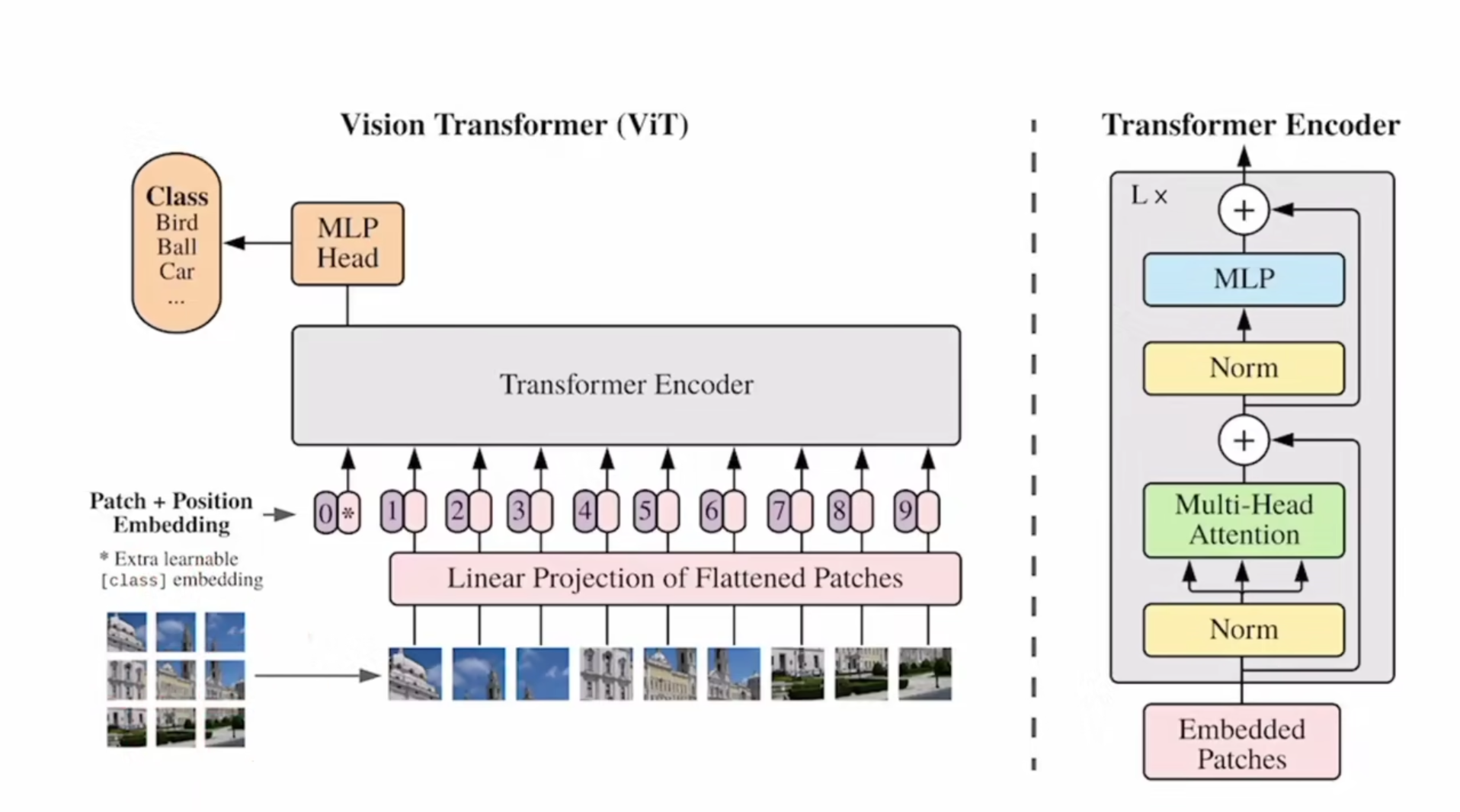

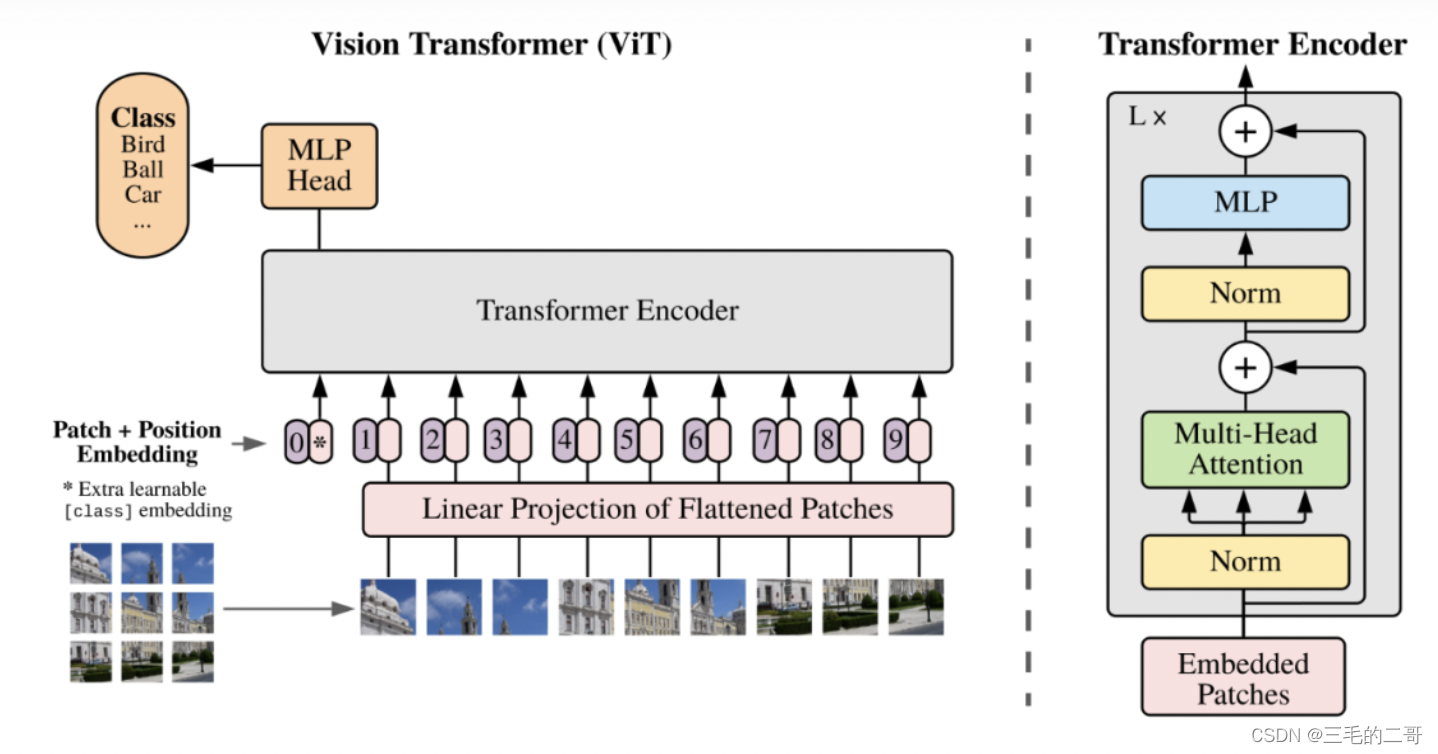

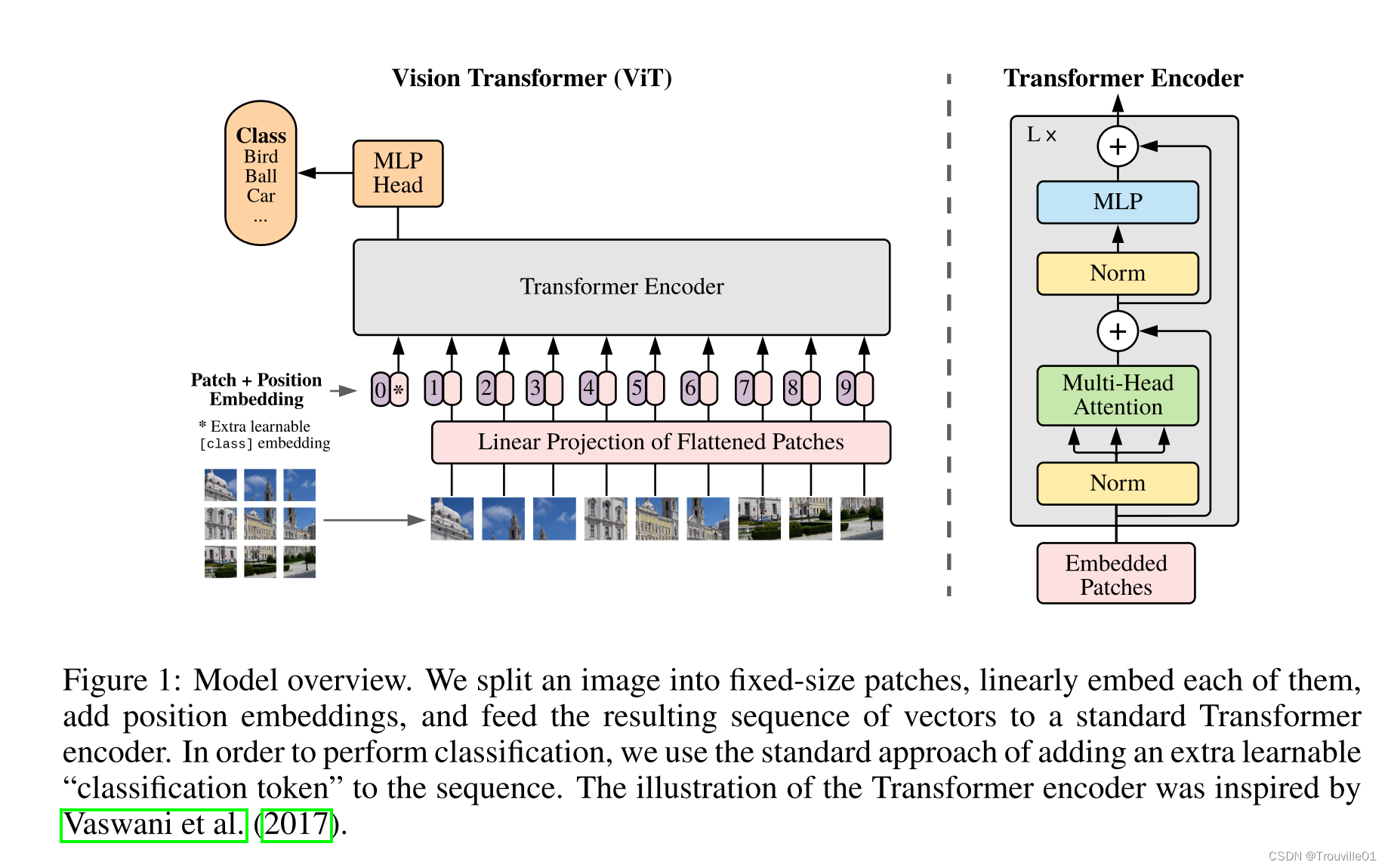

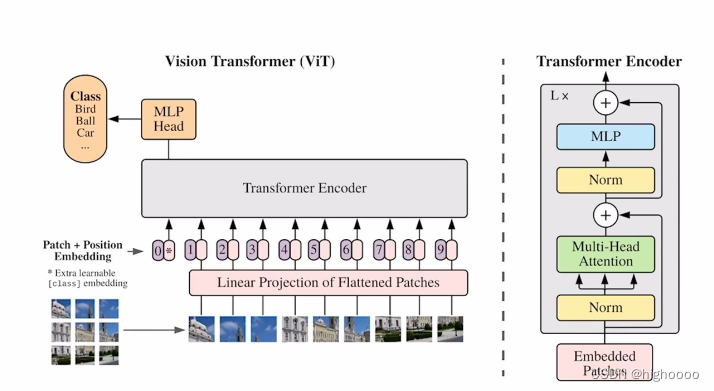

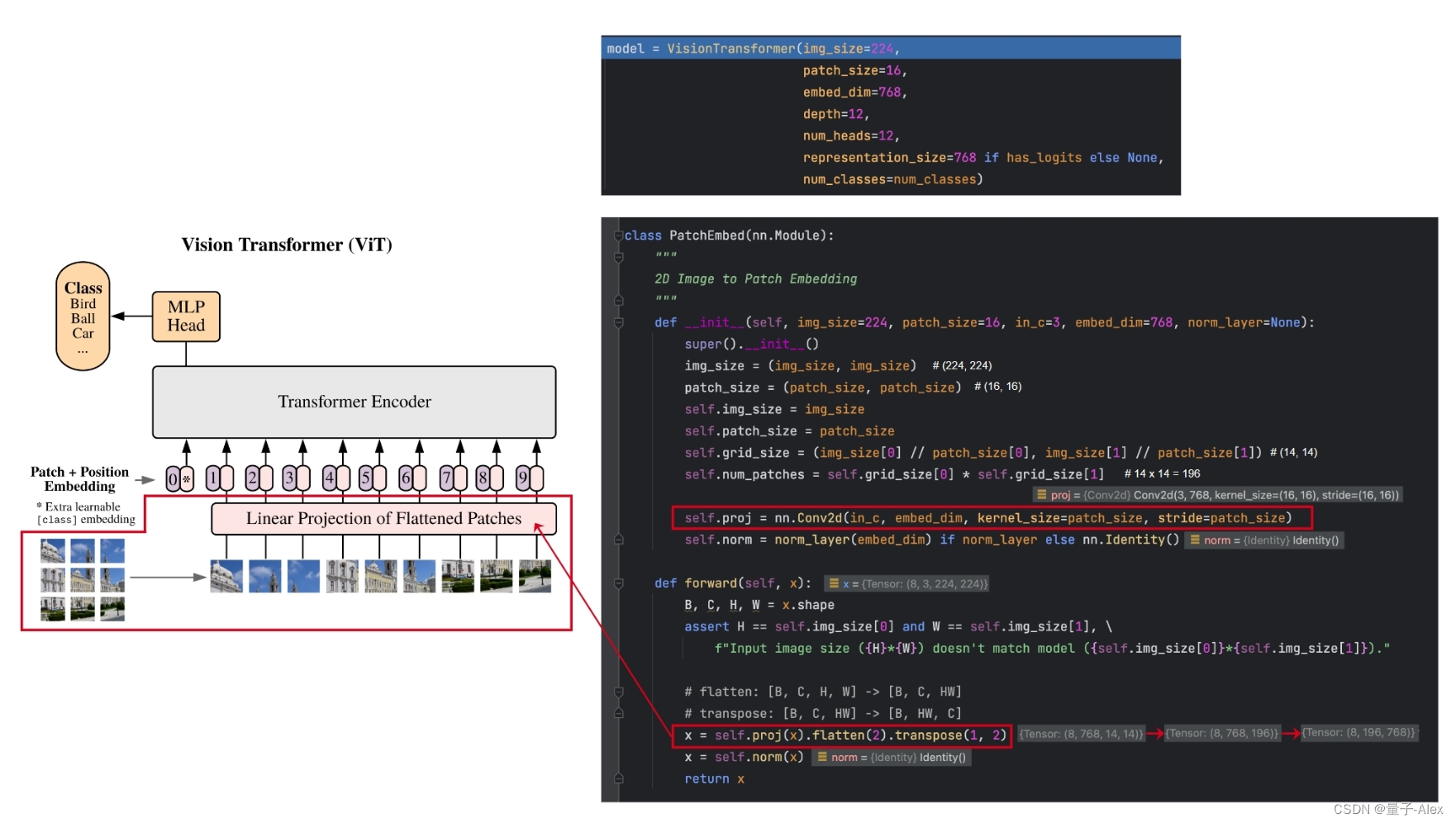

VIT 和Swin Transformer

VIT:https://blog.csdn.net/qq_37541097/article/details/118242600 Swin Transform:https://blog.csdn.net/qq_37541097/article/details/121119988 一、VIT 模型由三个模块组成: Linear Projection of Flattened Patches(Embedding层) Tran…

【10大专题,2.8w字详解】:从张量开始到GPT的《动手学深度学习》要点笔记

🚀 《动手学深度学习PyTorch版》复习要点全记录 📘 🎯 专注于查漏补缺、巩固基础,这份笔记将带你深入理解深度学习的核心概念。通过一系列精心整理的小专题,逐步构建起你的AI知识框架。 🧠 从最基础的张量操…

Vision Transformer(ViT) 2: 应用及代码讲解

文章目录1. 代码讲解1.1 PatchEmbed类1)__init__ 函数2) forward 过程1.2 Attention类1)__init__ 函数2)forward 过程1.3 MLP类1)__init__ 函数2)forward函数1.4 Block类1)__init__ 函数2)forwa…

Word2Pix: Word to Pixel Cross Attention Transformer in Visual Grounding,2021

**本文内容仅代表个人理解,如有错误,欢迎指正**

1. Problem

本篇论文主要解决的问题:将query编码成一个holistic sentence embedding,忽略了每个词对于Visual grounding框选的重要性,从而降低了模型的…

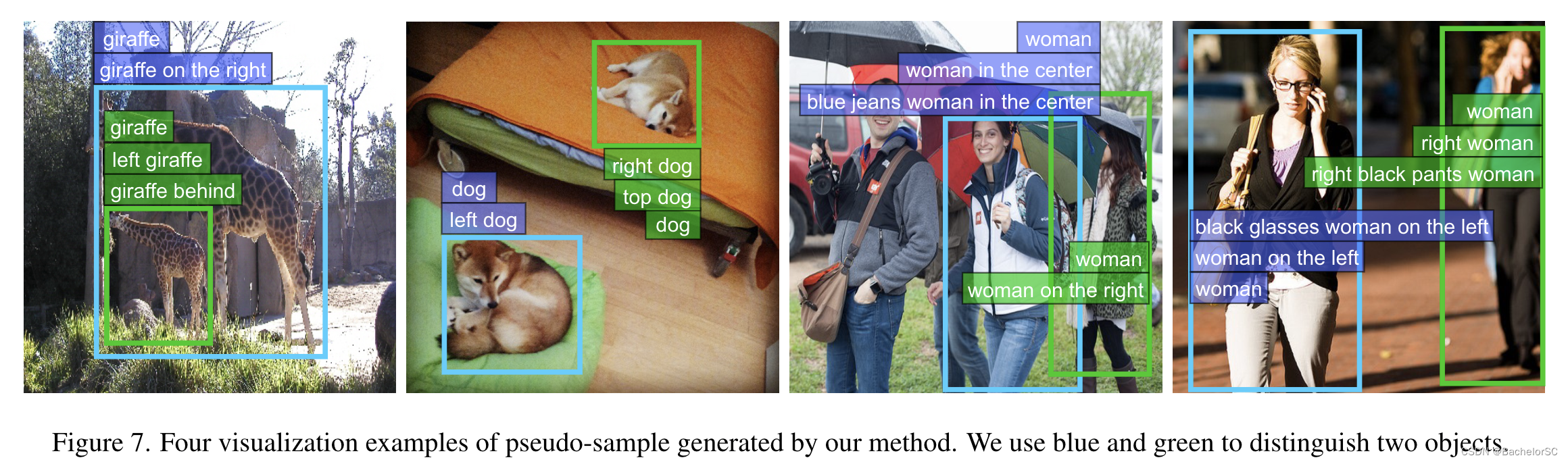

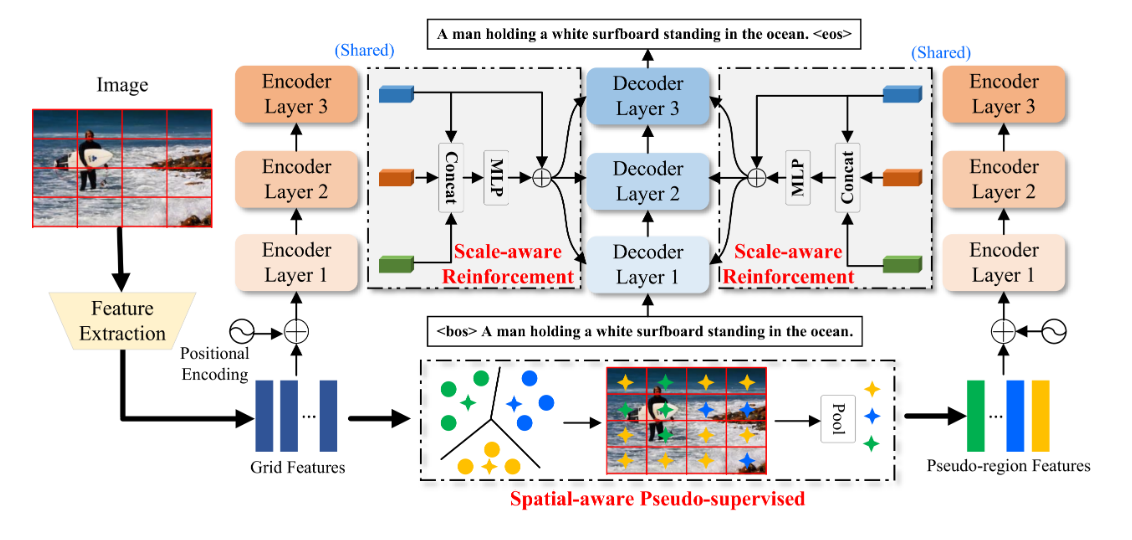

Pseudo-Q: Generating Pseudo Language Queries for Visual Grounding, 2022 CVPR

**本文内容仅代表个人理解,如有错误,欢迎指正**

1. Problem & Background Information

1.1 Problem

- 目前,人们基本上都采用基于深度学习的方法来解决Visual grounding任务。不论是全监督学习还是弱监督学习,都十分依赖人…

Vision Transformer(ViT)论文解读与代码实践(Pytorch)

Vision Transformer

Vision Transformer(ViT)是一种基于Transformer架构的神经网络模型,用于处理计算机视觉任务。传统的计算机视觉模型如卷积神经网络(CNN)在处理图像任务时取得了很大的成功,但CNN存在一…

esbuild中文文档-路径解析配置项(Path resolution - External、Main fields)

文章目录 路径解析配置项 Path resolution外部模块 External主字段 Main fields对于包的开发者 结语 哈喽,大家好!我是「励志前端小黑哥」,我带着最新发布的文章又来了! 老规矩,小手动起来~点赞关注不迷路!…

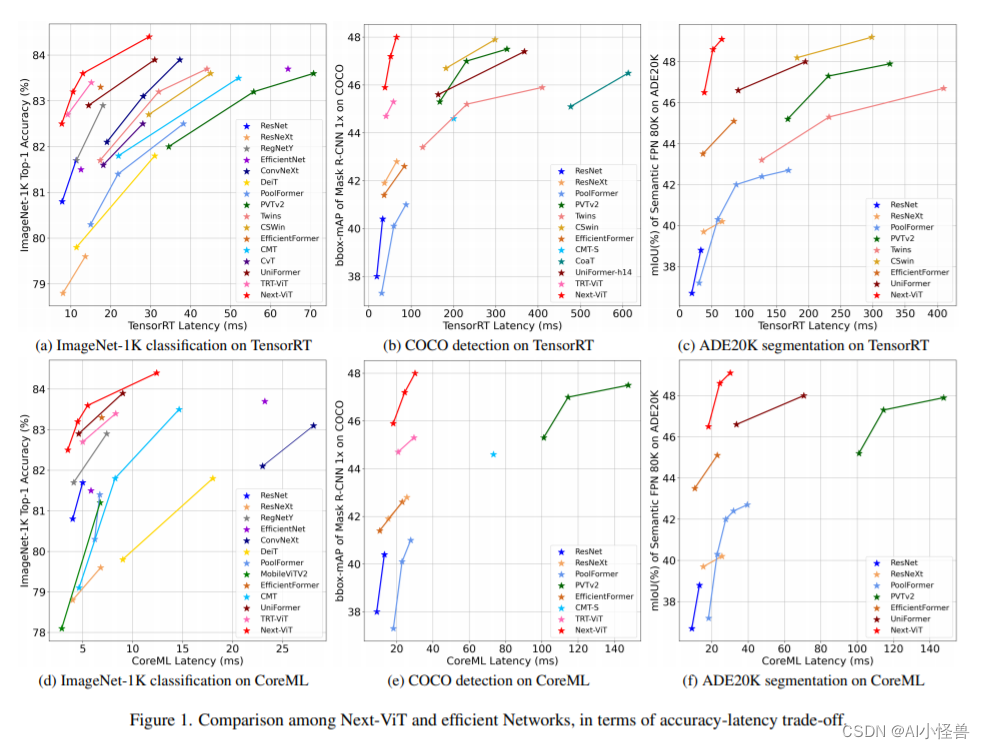

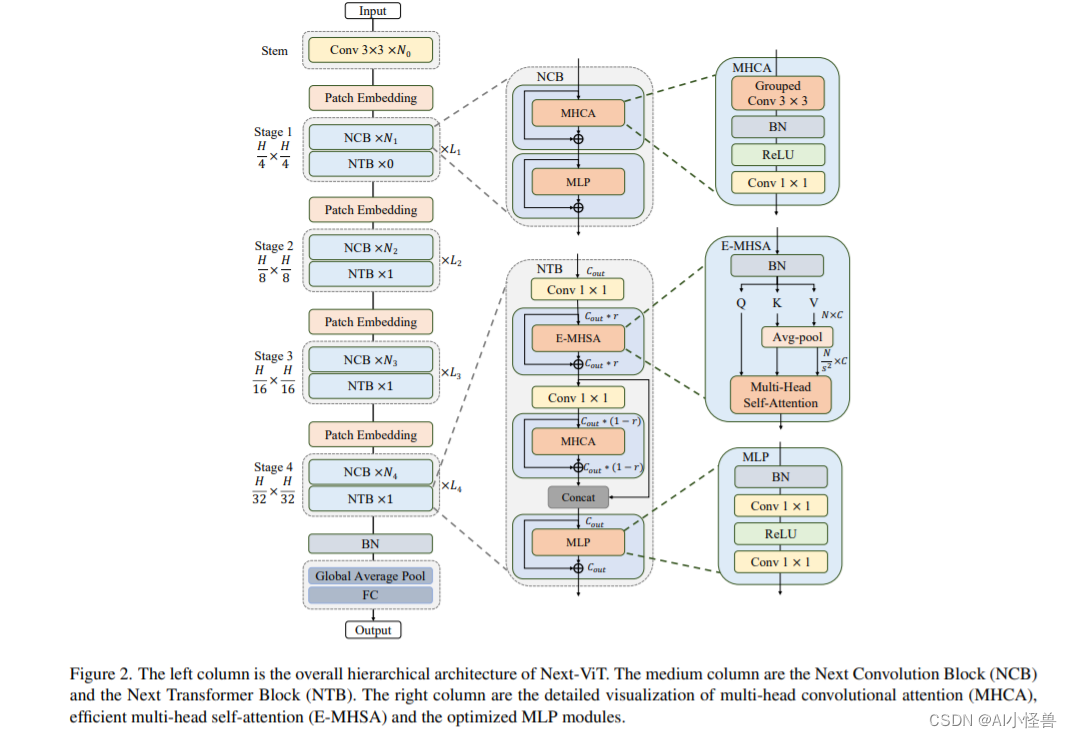

Yolov8轻量级:Next-vit,用于现实工业场景的下一代视觉 Transformer

1.Next-vit介绍

论文:https://arxiv.org/pdf/2207.05501.pdf 由于复杂的注意力机制和模型设计,大多数现有的视觉 Transformer(ViT)在现实的工业部署场景中不能像卷积神经网络(CNN)那样高效地执行。这就带来了一个问题:视觉神经网络能否像 CNN 一样快速推断并像 ViT 一样…

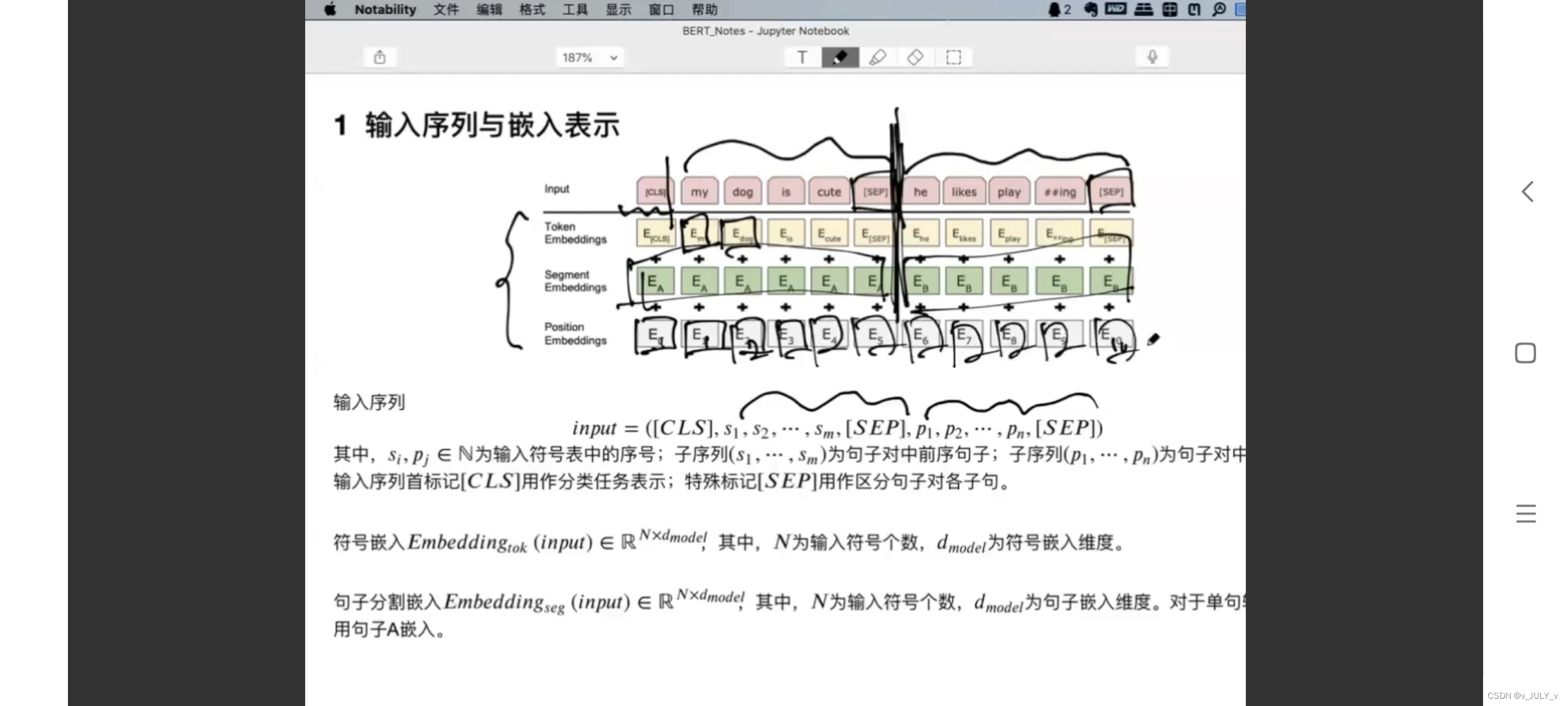

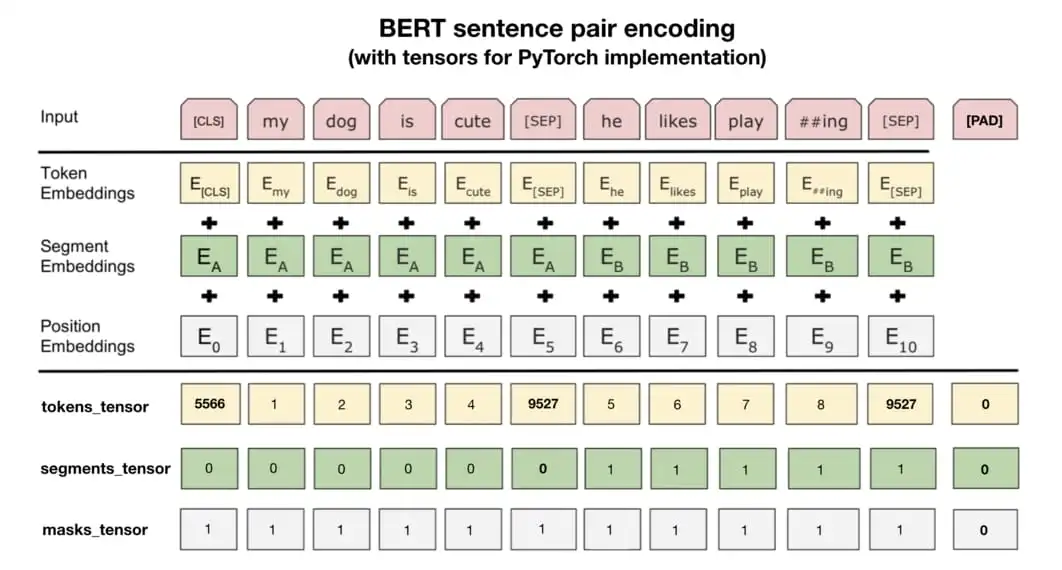

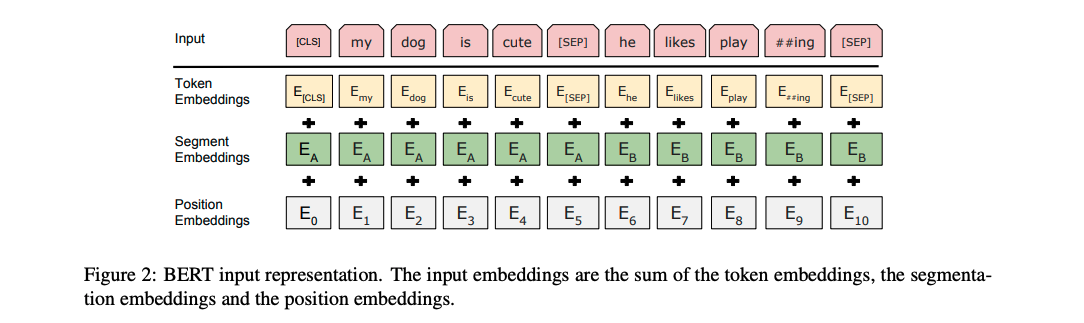

读书笔记:多Transformer的双向编码器表示法(Bert)-4

多Transformer的双向编码器表示法

Bidirectional Encoder Representations from Transformers,即Bert;

第二部分 探索BERT变体 从本章开始的诸多内容,以理解为目标,着重关注对音频相关的支持(如果有的话)…

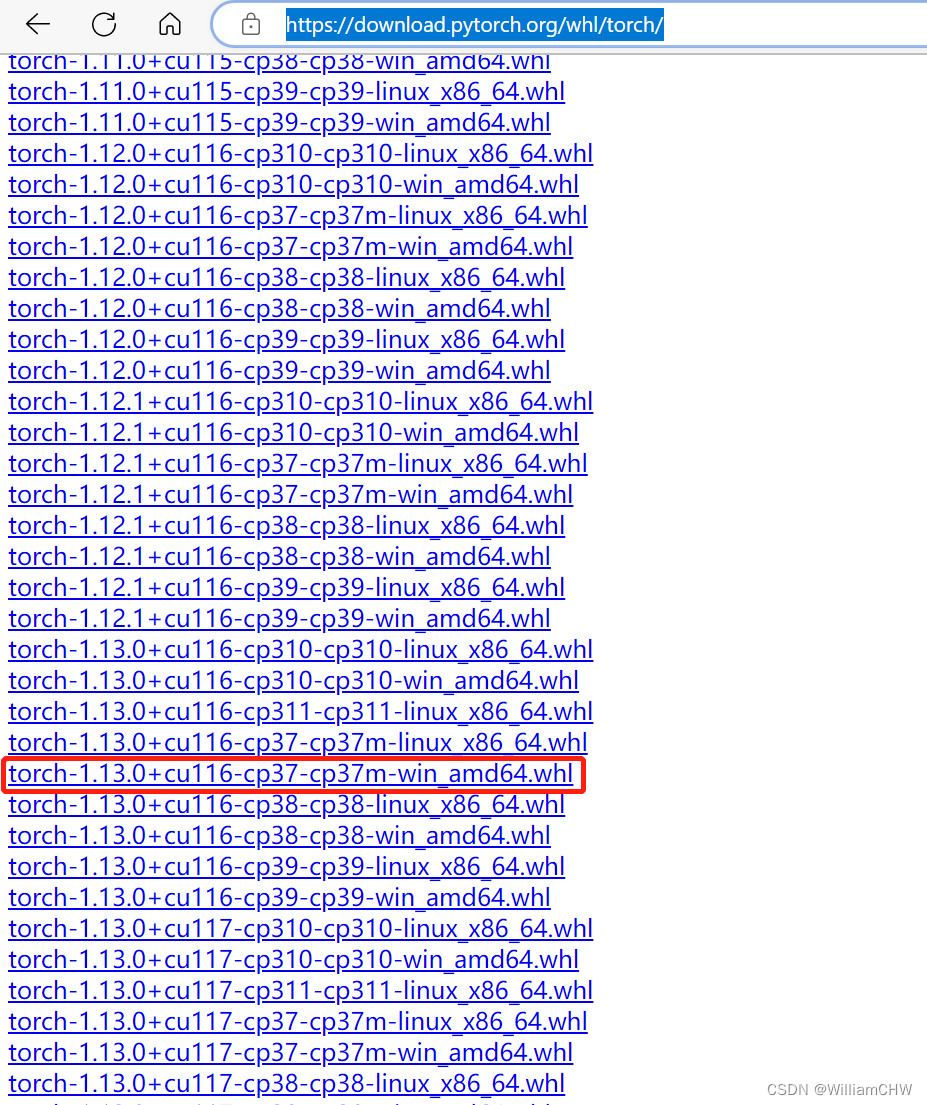

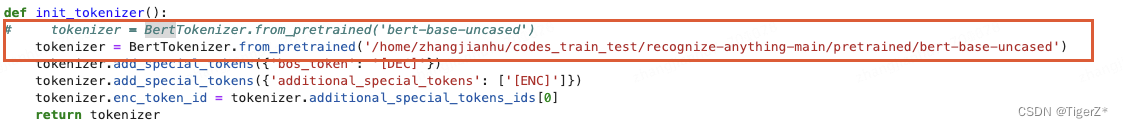

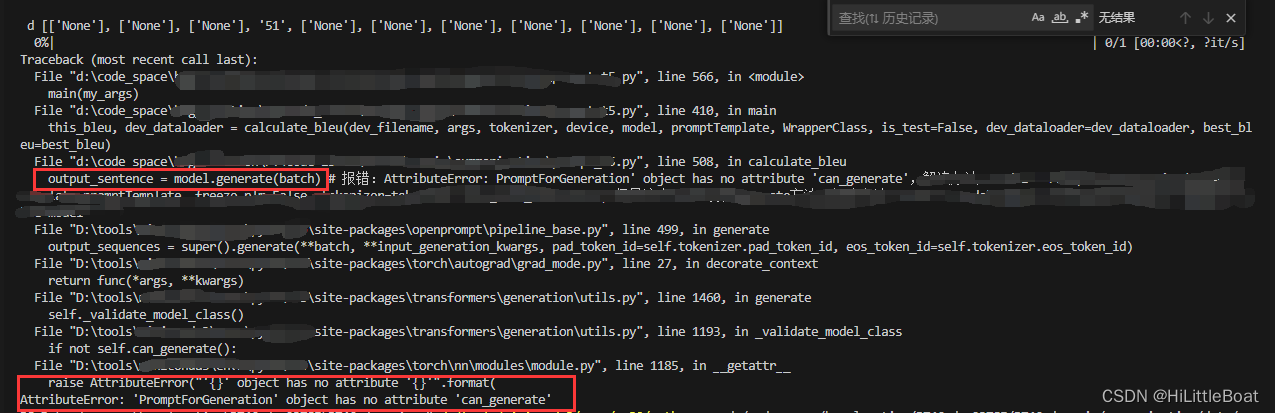

bert 环境搭建之PytorchTransformer 安装

这两天跑以前的bert项目发现突然跑不了,报错信息如下:

Step1 transformer 安装

RuntimeError: Failed to import transformers.models.bert.modeling_bert because of the following error (look up to see its traceback): module signal has no att…

【Transformer系列】深入浅出理解Positional Encoding位置编码

一、参考资料

一文教你彻底理解Transformer中Positional Encoding Transformer Architecture: The Positional Encoding The Annotated Transformer Master Positional Encoding: Part I 如何理解Transformer论文中的positional encoding,和三角函数有什么关系&…

【基于transformer:PanSharpening】

PANFORMER: A TRANSFORMER BASED MODEL FOR PAN-SHARPENING

(PANFORMER:一种基于transformer的PAN锐化模型)

全色锐化的目的是从同一颗卫星获取的低分辨率(LR)多光谱(MS)图像及其对应的全色&a…

论文浅尝 | 利用知识图谱增强的Transformer进行跨领域方面抽取

笔记整理:沈小力,东南大学硕士,研究方向为知识图谱链接:https://dl.acm.org/doi/pdf/10.1145/3511808.3557275动机情感分析是自然语言处理的基础任务,它包含介绍了细粒度情感分析中的一个常见任务——基于方面的情感分…

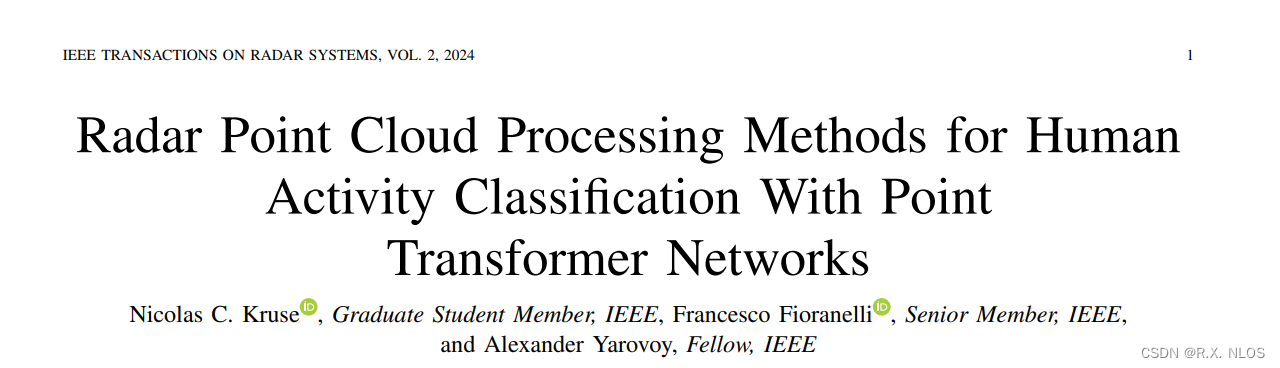

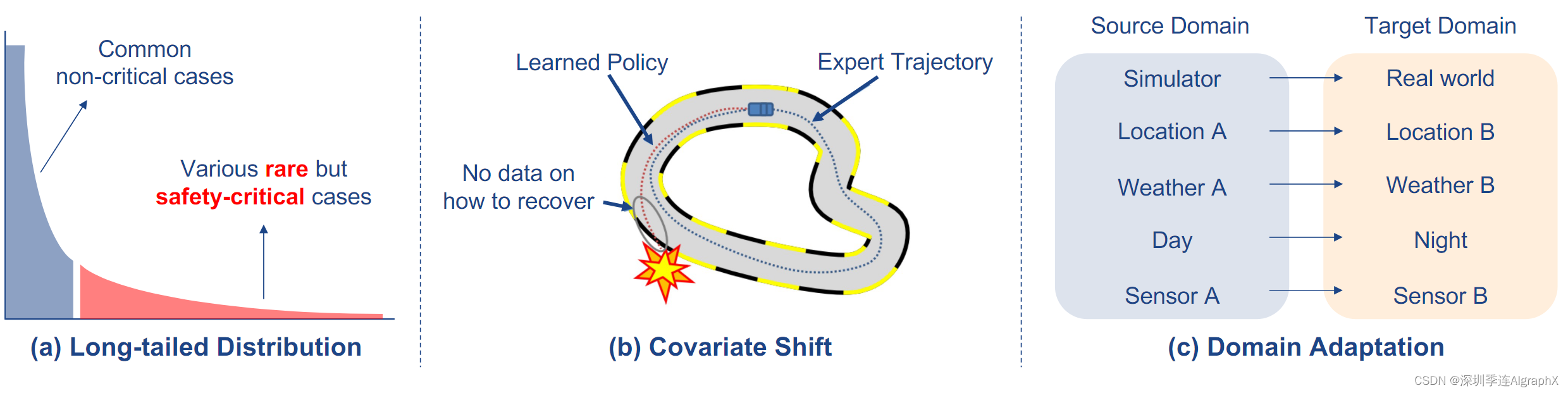

Online Decision Transformer

摘要

最近的工作表明,离线强化学习 (RL) 可以表述为序列建模问题 (Chen et al., 2021; Janner et al., 2021),并通过类似于大规模语言建模的方法来解决。 然而,RL 的任何实际实例化还涉及在线组件,其中在被动离线数据集上预训练的…

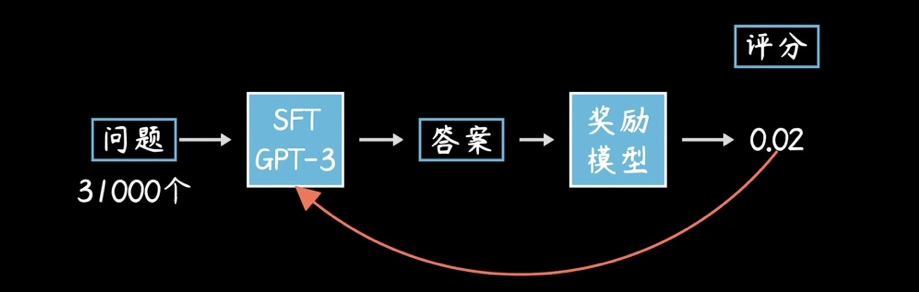

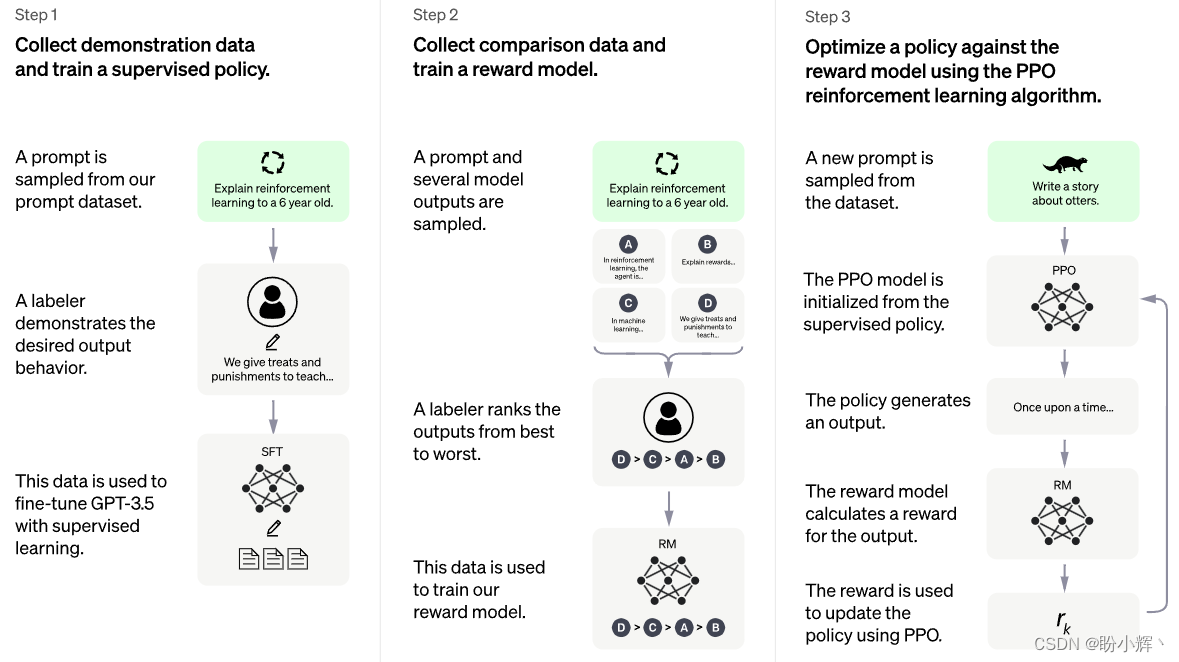

【原创】AIGC之ChatGPT工作原理

AIGC是什么 AIGC - AI Generated Content (AI生成内容),对应我们的过去的主要是 UGC(User Generated Content)和 PGC(Professional user Generated Content)。 AIGC就是说所有输出内容是通过AI机…

YoloV5改进策略:EfficientViT,高效的视觉transformer与级联组注意力提升YoloV5的速度和精度,打造高效的YoloV5

文章目录 摘要论文:《EfficientViT:高效视觉transformer与级联组注意力》1、简介2、用视觉transformer加速2.1. 内存效率2.2. 计算效率2.3. 参数效率3、高效视觉Transformer3.1. EfficientViT的构建块3.2、EfficientViT网络架构4、实验4.1. 实现细节4.2. ImageNet上的结果4.3…

SwiftFormer:基于Transformer的高效加性注意力用于实时移动视觉应用的模型

自注意力已经成为各种视觉应用中捕获全局上下文的默认选择。然而,相对于图像分辨率来说,它的二次计算复杂性限制了它在实时应用中的使用,尤其是在资源受限的移动设备上的部署。尽管已经提出了混合方法来结合卷积和自注意力的优点以获得更好的…

综述----知识蒸馏

4.1 模型改进

未来的研究可以集中在改进无图学习模型的性能和泛化能力。例如,可以研究更有效的知识表示和传递方法,以提高学生模型对教师模型知识的理解和利用能力。此外,可以探索新的模型结构和训练算法,以提高模型的效率和稳定…

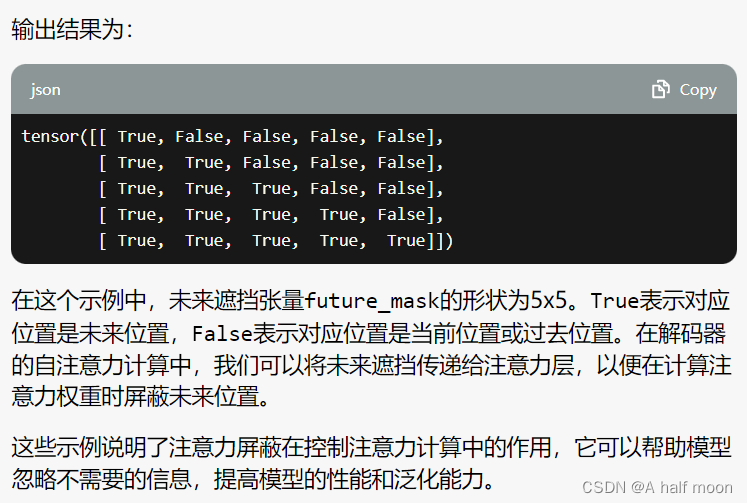

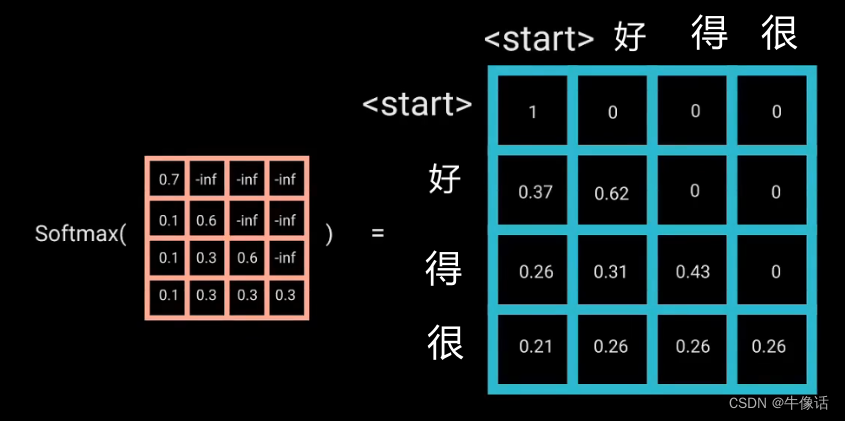

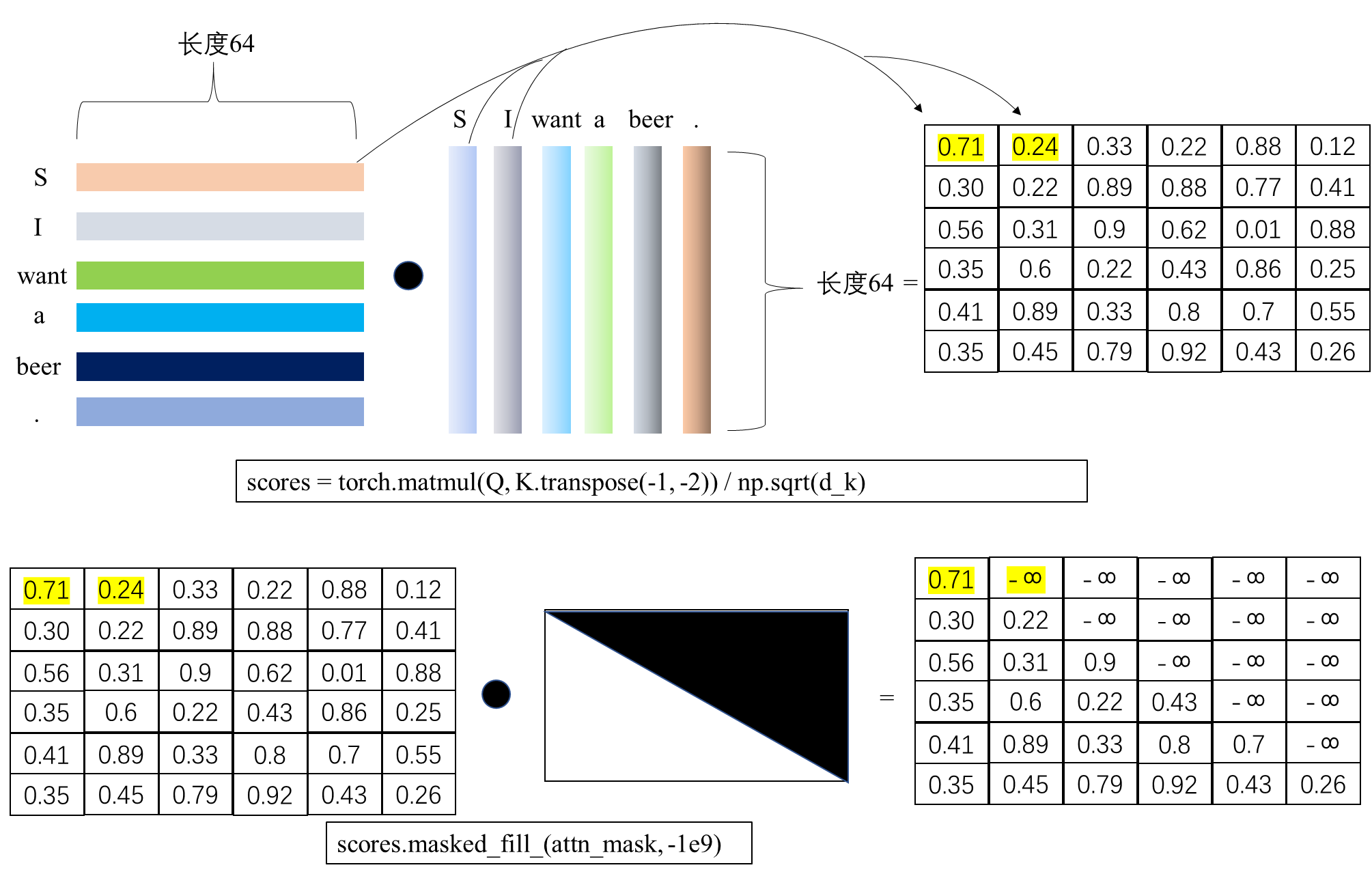

注意力屏蔽(Attention Masking)在Transformer中的作用 【gpt学习记录】

填充遮挡(Padding Masking): 未来遮挡(Future Masking):

使用 Hugging Face Transformer 创建 BERT 嵌入

介绍 最初是为了将文本从一种语言更改为另一种语言而创建的。BERT 极大地影响了我们学习和使用人类语言的方式。它改进了原始 Transformer 模型中理解文本的部分。创建 BERT 嵌入尤其擅长抓取具有复杂含义的句子。它通过检查整个句子并理解单词如何连接来做到这一点。Hugging F…

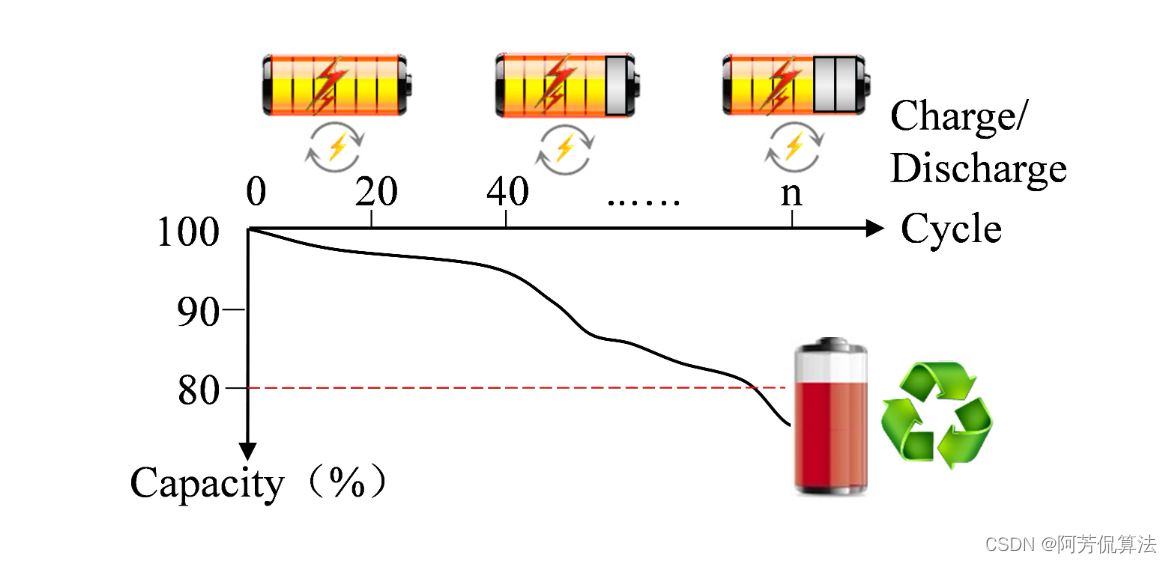

Transformer预测 | Pytorch实现基于Transformer的锂电池寿命预测(NASA数据集)

文章目录 效果一览文章概述模型描述程序设计参考资料效果一览 文章概述 Pytorch实现基于Transformer 的锂电池寿命预测,环境为pytorch 1.8.0,pandas 0.24.2 随着充放电次数的增加,锂电池的性能逐渐下降。电池的性能可以用容量来表示,故寿命预测 (RUL) 可以定义如下: SOH(t…

【读点论文】FMViT: A multiple-frequency mixing Vision Transformer-期待源码

FMViT: A multiple-frequency mixing Vision Transformer

Abstract transformer模型近年来在计算机视觉任务中得到了广泛的应用。然而,由于自关注的时间和内存复杂度是二次的,并且与输入token的数量成正比,大多数现有的(Vision transformer,…

DETR纯代码分享(五)__init__.py(datasets)

一、导入各种包

import torch.utils.data

import torchvisionfrom .coco import build as build_coco

这段代码导入了PyTorch中的数据加载和视觉工具库(torch.utils.data和torchvision),以及一个名为build的自定义模块(build_co…

YOLOv8-Seg改进:Backbone改进 |Next-ViT堆栈NCB和NTB 构建先进的CNN-Transformer混合架构

🚀🚀🚀本文改进:Next-ViT堆栈NCB和NTB 构建先进的CNN-Transformer混合架构,包括nextvit_small, nextvit_base, nextvit_large,相比较yolov8-seg各个版本如下: layersparametersgradientsGFLOPsnextvit_small61033841075

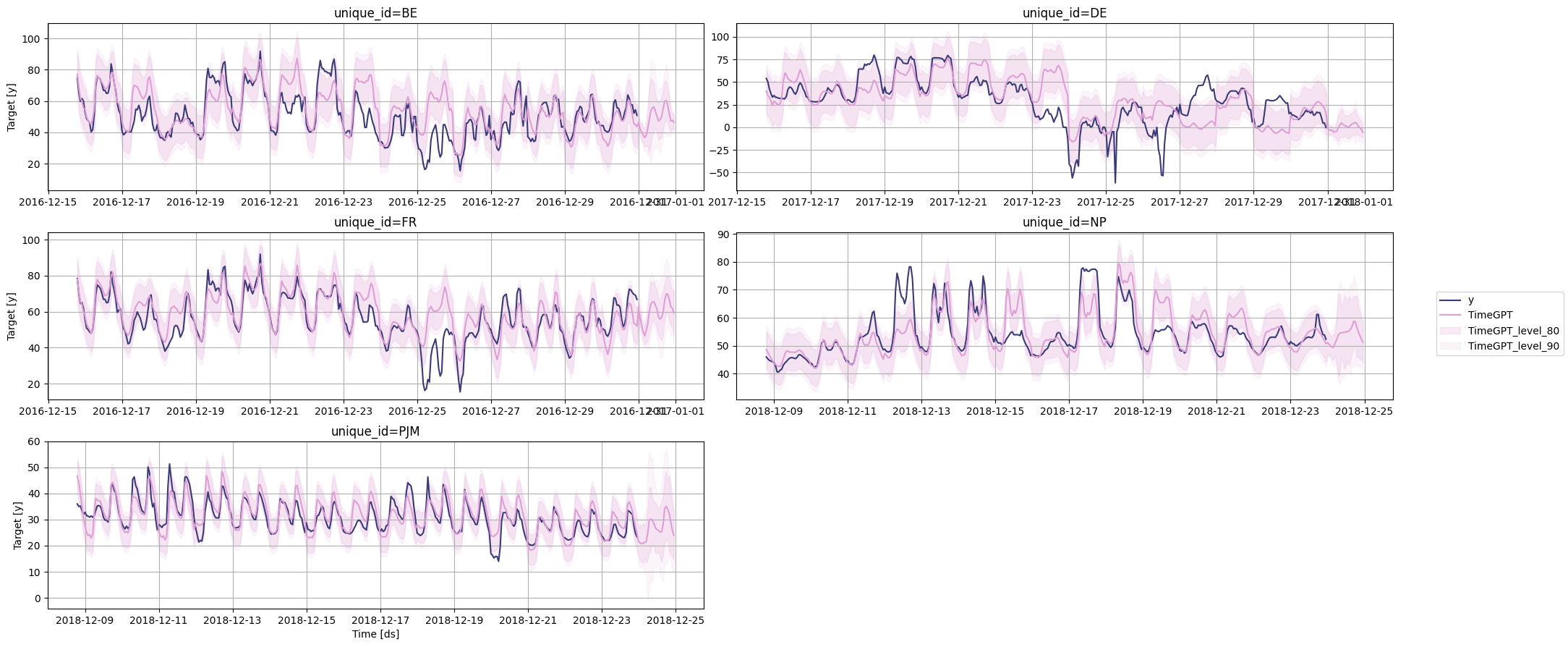

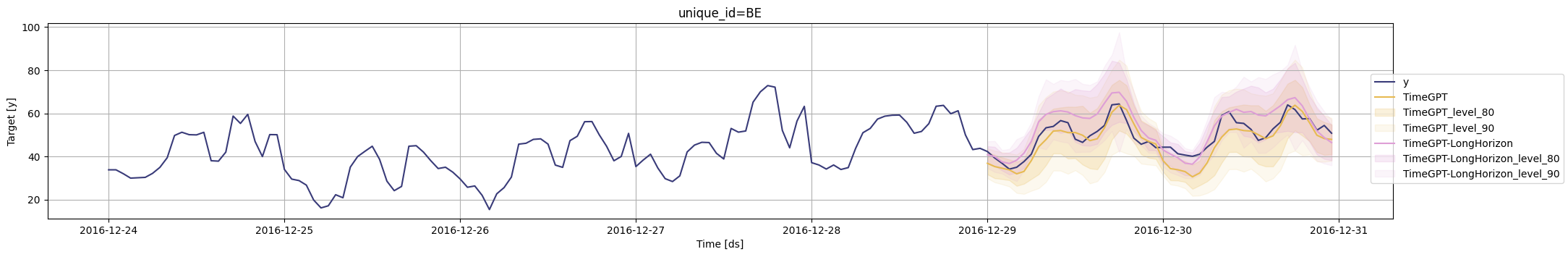

工具系列:TimeGPT_(3)处理假期和特殊日期

日历变量和特殊日期是预测应用中最常见的外生变量类型之一。它们为时间序列的当前状态提供了额外的上下文信息,特别是对于基于窗口的模型(如TimeGPT-1)而言。这些变量通常包括添加每个观测的月份、周数、日期或小时数的信息。例如,…

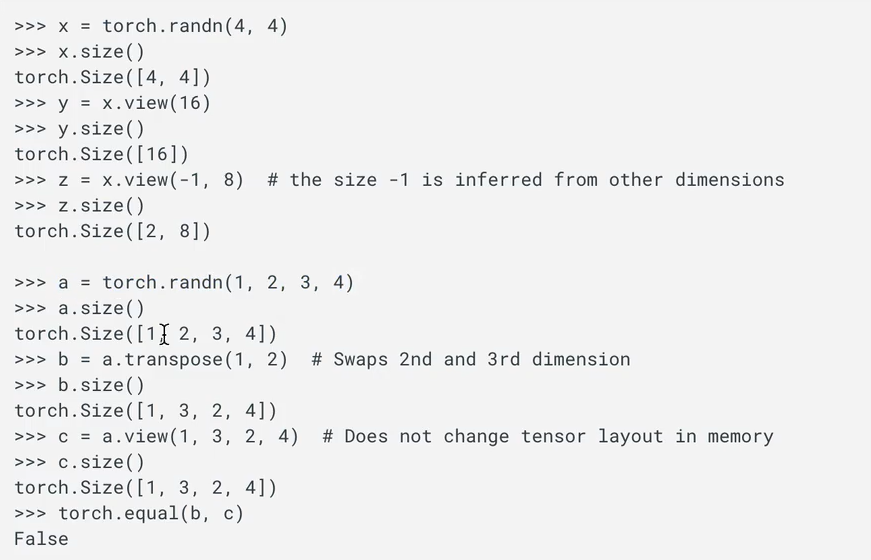

从原理到实践 | Pytorch tensor 张量花式操作

文章目录 1.张量形状与维度1.1标量(0维张量):1.2 向量(1维张量):1.3矩阵(2维张量):1.4高维张量: 2. 张量其他创建方式2.1 创建全零或全一张量:2.2…

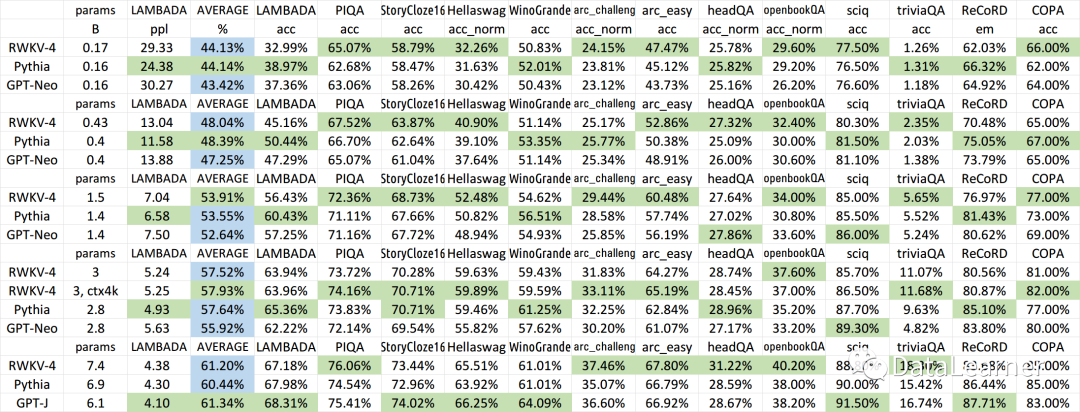

HF宣布在transformers库中引入首个RNN模型:RWKV,一个结合了RNN与Transformer双重优点的模型

RWKV是一个结合了RNN与Transformer双重优点的模型架构。由香港大学物理系毕业的彭博首次提出。简单来说,RWKV是一个RNN架构的模型,但是可以像transformer一样高效训练。今天,HuggingFace官方宣布在transformers库中首次引入RNN这样的模型&…

人工智能并行计算,很大程度提升了语言模型的训练速度

循环智能最早的三位创始人陈麒聪、杨植麟与张宇韬相识于清华大学的知识工程实验室,都有一股「用AI创造社会价值」的热血。三人都是技术出身,后来因为业务发展,循环智能在2018年又引入了另一位擅长技术产品运营的「第四把手」揭发。 自成立…

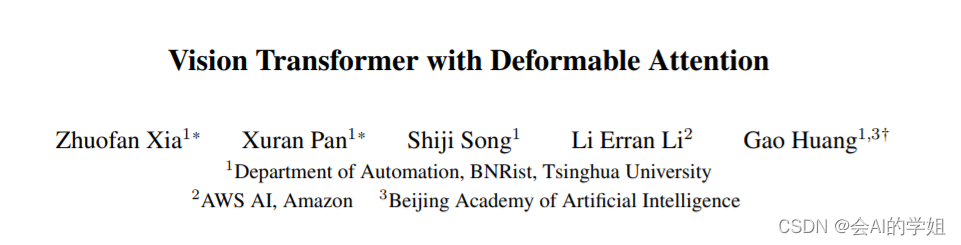

YOLOv8-seg改进:注意力系列篇 | 一种简单有效的可变形的自注意力模块DAT | CVPR 2022

🚀🚀🚀本文改进:Deformable Attention Transformer,一种简单有效的可变形的自注意力模块,增强sparse attention 的表征能⼒;

🚀🚀🚀DAT小目标分割&复杂场景首选,实现涨点 🚀🚀🚀YOLOv8-seg创新专栏:http://t.csdnimg.cn/KLSdv

学姐带你学习YOL…

【Image captioning】Meshed-memory transformer自有数据集的文件预处理

Meshed-memory transformer自有数据集的文件预处理

作者:安静到无声 个人主页 目录 Meshed-memory transformer自有数据集的文件预处理生成与coco_detections.hdf5相似的特征文件生成训练、测试和验证对应的JSON和字幕ID推荐专栏生成与coco_detections.hdf5相似的特征文件

c…

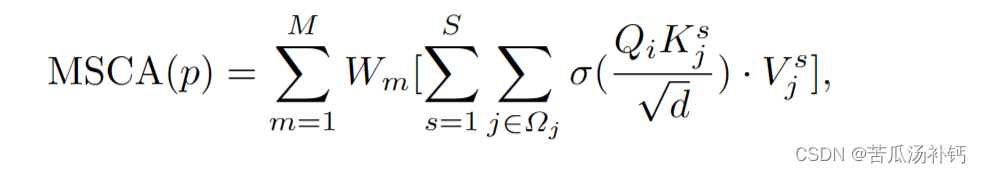

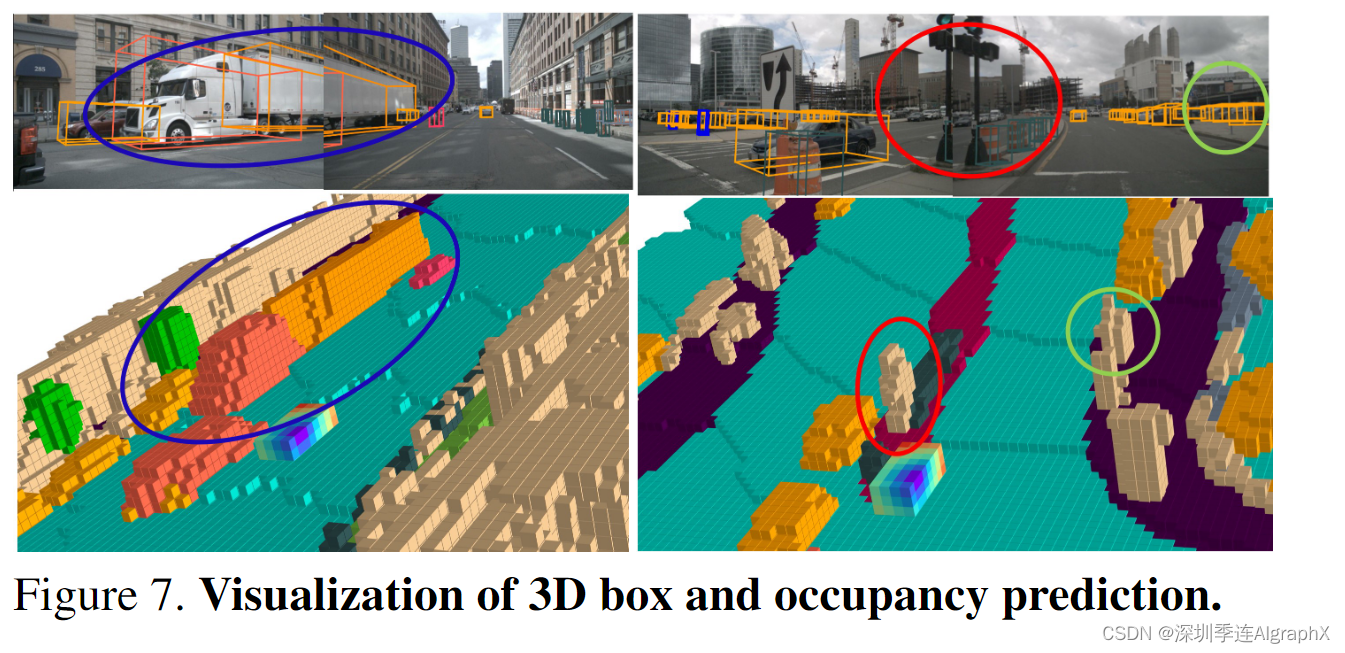

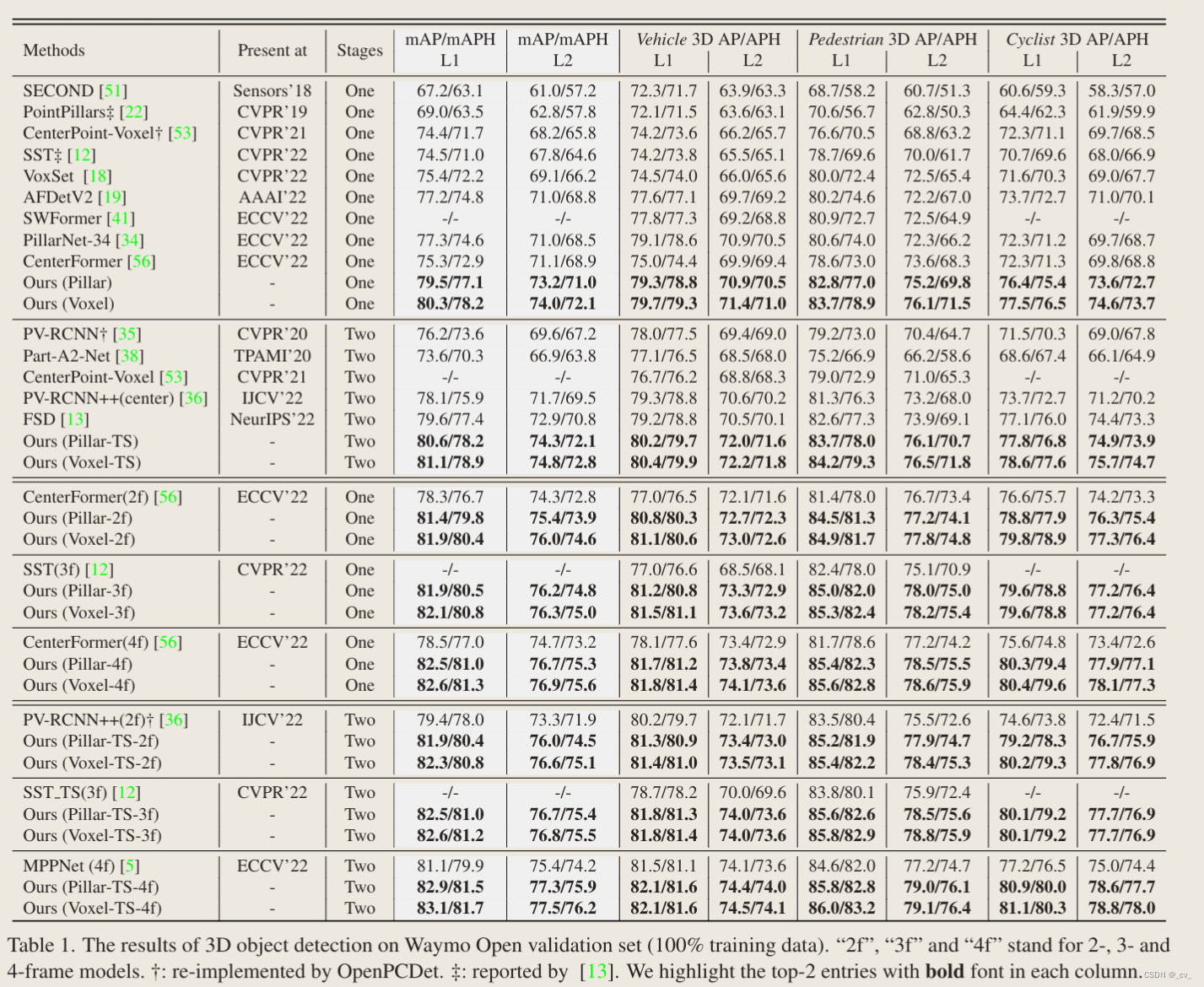

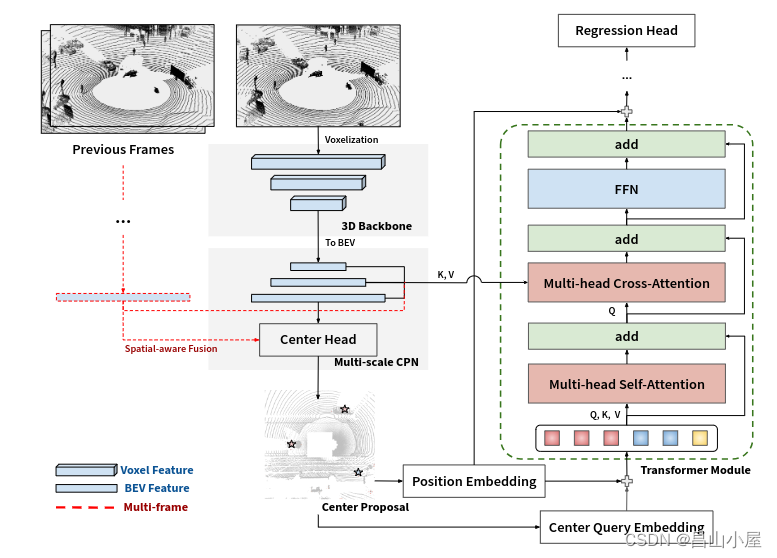

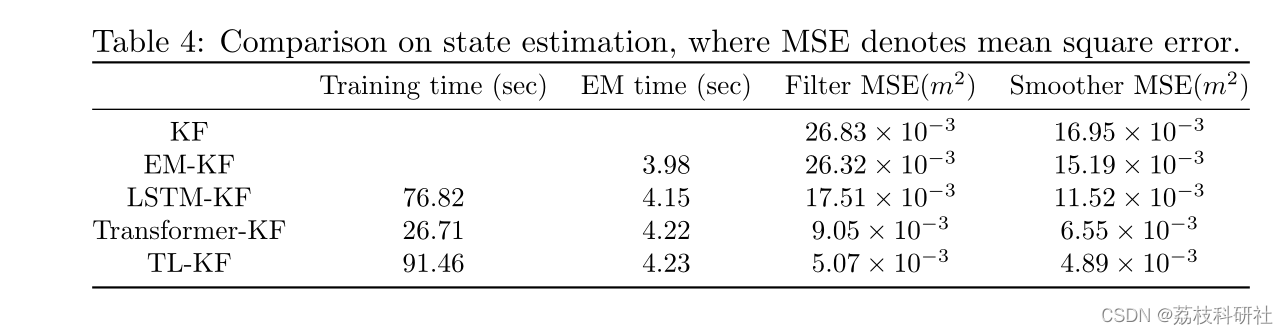

论文阅读:CenterFormer: Center-based Transformer for 3D Object Detection

目录

概要

Motivation

整体架构流程

技术细节

Multi-scale Center Proposal Network

Multi-scale Center Transformer Decoder

Multi-frame CenterFormer

小结 论文地址:[2209.05588] CenterFormer: Center-based Transformer for 3D Object Detection (arx…

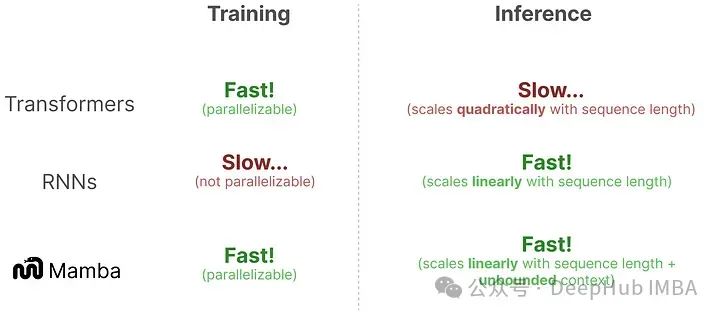

Transformer和RNN的区别?

Transformer和循环神经网络(RNN)是两种不同的序列建模模型,它们在结构和工作原理上有一些重要的区别。 结构: Transformer:Transformer模型是一种基于自注意力机制的序列建模模型。它主要由编码器和解码器组成…

Transformer预测 | Pytorch实现基于mmTransformer多模态运动预测(堆叠Transformer)

文章目录 文章概述程序设计参考资料文章概述 Transformer预测 | Pytorch实现基于mmTransformer多模态运动预测(堆叠Transformer) 程序设计 Initialize virtual environment: conda create -n mmTrans python=3.7# -*- coding: utf-8 -*-

import argparse

import os

Transformer 模型中常见的特殊符号

Transformer 模型中常见的特殊符号 通过代码一起理解一下 Transformer 模型中常见的特殊符号,

示例代码,

special_tokens{unk_token: [UNK], sep_token: [SEP], pad_token: [PAD], cls_token: [CLS], mask_token: [MASK]}这段代码是定义了一个字典spec…

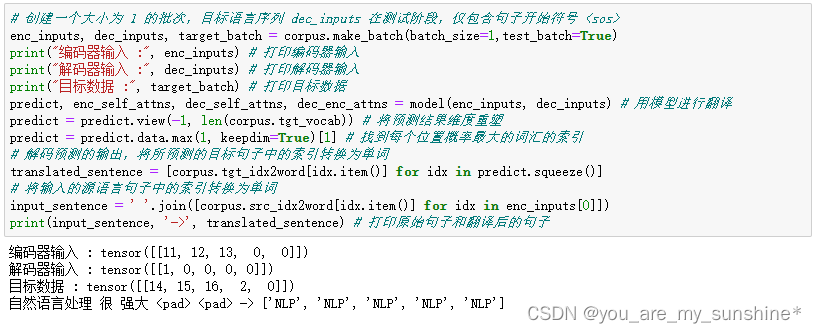

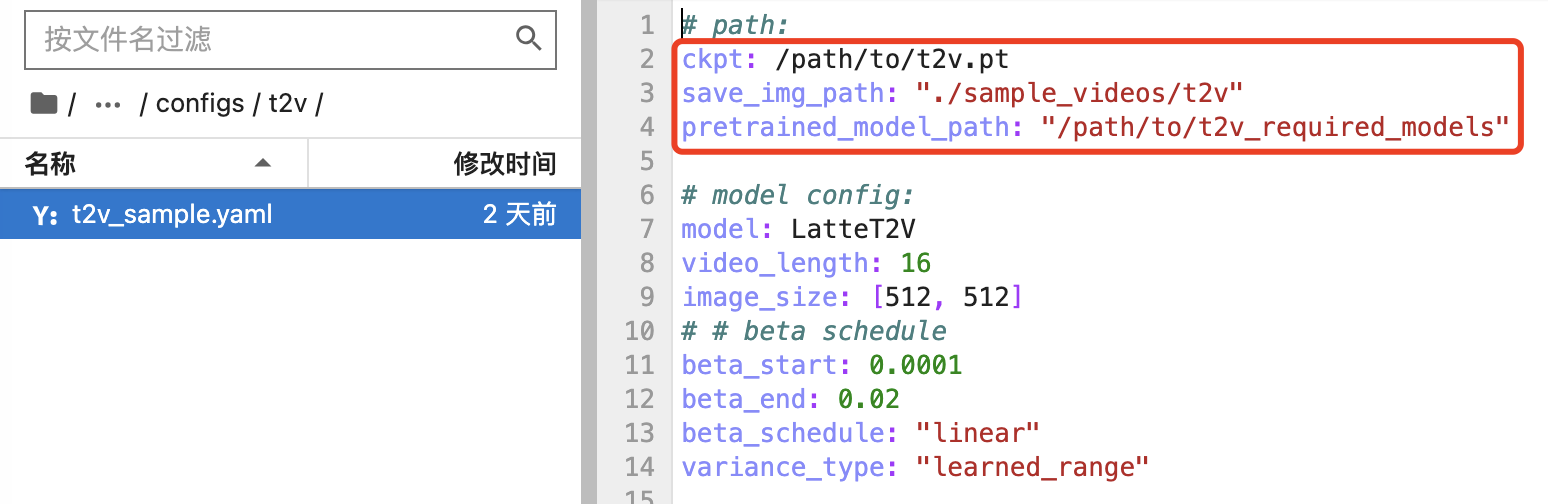

云端部署ChatGLM-6B

大模型这里更新是挺快的,我参考的视频教程就和我这个稍微有些不一样,这距离教程发布只过去4天而已… 不过基本操作也差不多 AutoDL算力云:https://www.autodl.com/home ChatGLM3:https://github.com/THUDM/ChatGLM3/tree/main Hug…

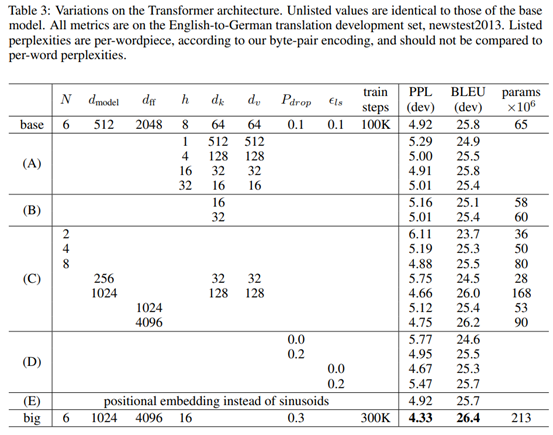

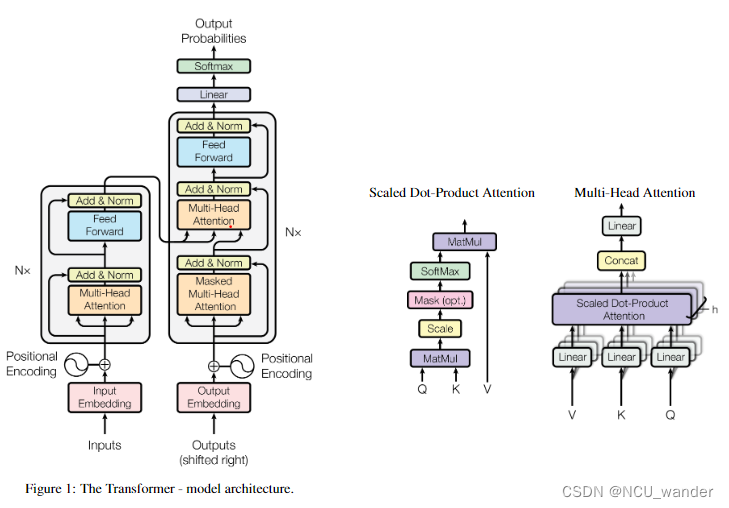

Attention is all your need——Transformer论文

摘要

此序列转录模型仅仅依赖于注意力机制,而不使用循环或者是卷积,将循环全部换成了multi-headed self- attention

介绍

RNN的特点、并行程度低。

Attention在RNN上的应用。

引入注意力机制,提高并行度。

背景

使用卷积对长的序列难以…

Transformer结构细节

一、结构

Transformer 从大的看由 编码器输入、编码器、解码器、解码器输入和解码器输出构成。

编码器中包含了词嵌入信息编码、位置编码、多头注意力、Add&Norm层以及一个全连接层;

解码器中比编码器多了掩码的多头注意力层。

二、模块

2.1 Input Embeddi…

解析Transformer基本结构与实现

1.基本结构

Transformer总体架构可分为4个部分: 输入部分-输出部分-编码器部分-解码器部分 输入部分包含:

原文本嵌入层(Input embedding)及其位置编码(position encoding)目标文本嵌入层及其位置编码器 文本嵌入层的作…

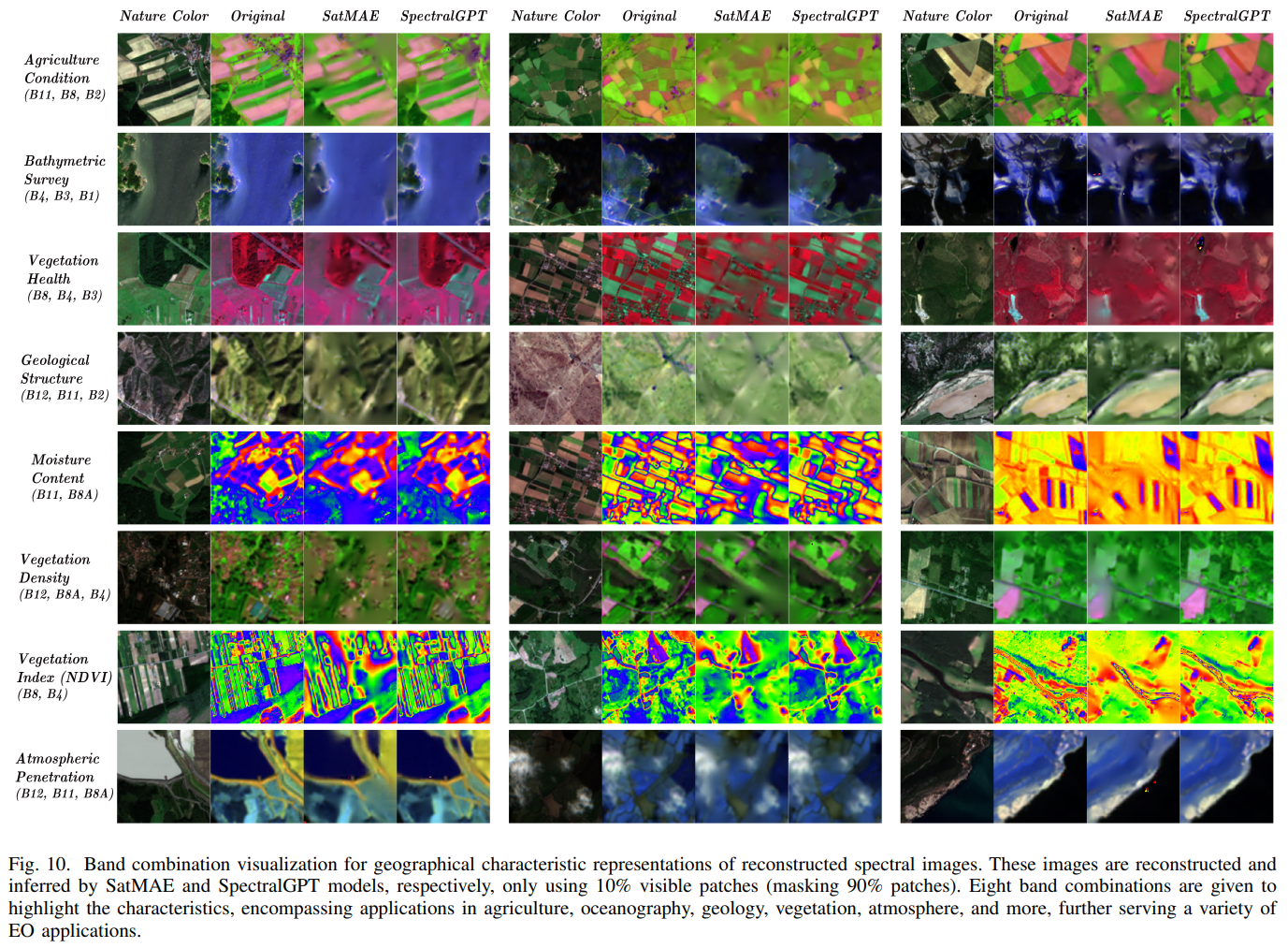

【基于卷积和Transformer:多光谱图像光谱重建】

Spectral Reconstruction From Satellite Multispectral Imagery Using Convolution and Transformer Joint Network

(基于卷积和Transformer联合网络的卫星多光谱图像光谱重建)

基于卫星多光谱(MS)图像的光谱重建(S…

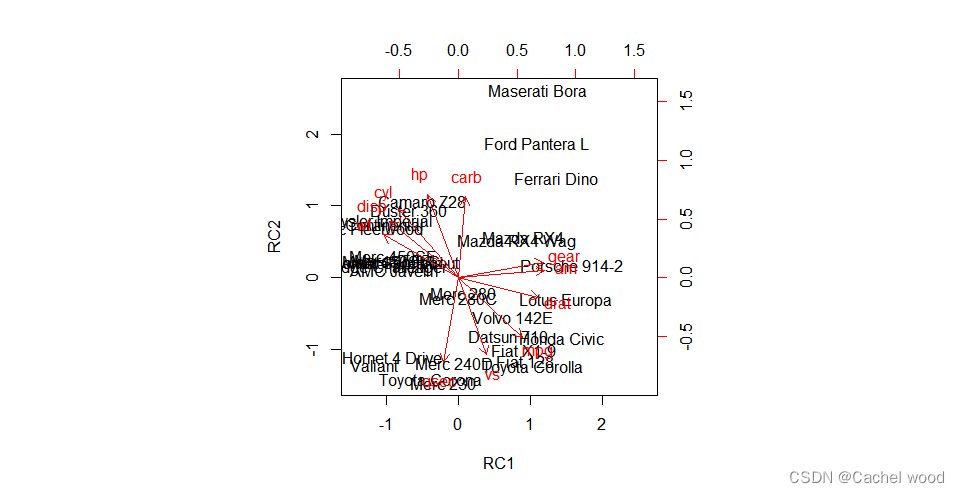

R语言:因子分析 factor analysis

文章目录 因子分析数据集处理步骤主成分法做因子分析最大似然法做因子分析 因子分析 因子分析的用途与主成分分析类似,它也是一种降维方法。由于因子往往比主成分更易得到解释,故因子分析比主成分分析更容易成功,从而有更广泛的应用。 从方法…

NLP系列——Transformer源码解析(TensorFlow版)

目录前言1. \__init\__()2. encode()2. decode()3. linear projection4. 代码地址前言 这篇博客是对transformer源码的解析,这个源码并非官方的,但是比官方代码更容易理解。 采用TensorFlow框架,下面的解析过程只针对模型构建过程&#x…

Transformer预测 | Python实现基于Transformer的股票价格预测(tensorflow)

文章目录 效果一览文章概述程序设计参考资料效果一览 文章概述 Transformer预测 | Python实现基于Transformer的股票价格预测(tensorflow) 程序设计 import numpy as np

import matplotlib.pyplot

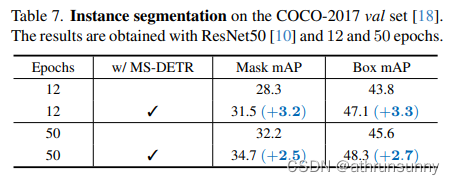

RepViT:从ViT视角重新审视移动CNN

文章目录 摘要1、简介2、相关工作3、方法论3.1、初步3.2、Block设计3.3、宏观设计3.4、微观设计3.5、网络架构4、实验4.1、图像分类4.2、目标检测与实例分割4.3、语义分割5、结论A. RepViTs架构一些名词的理解mobile-friendlinessEarly Convolutions摘要

https://arxiv.org/pd…

Congested Crowd Instance Localization with Dilated Convolutional Swin Transformer阅读笔记

Abstract

研究如何在高密度人群场景中实现精准的实例定位,以及如何缓解传统模型由于目标遮挡、图像模糊等而降低特征提取能力的问题。为此,我们提出了一 Dilated Convolutional Swin Transformer(DCST)对于拥挤的人群场景

Speci…

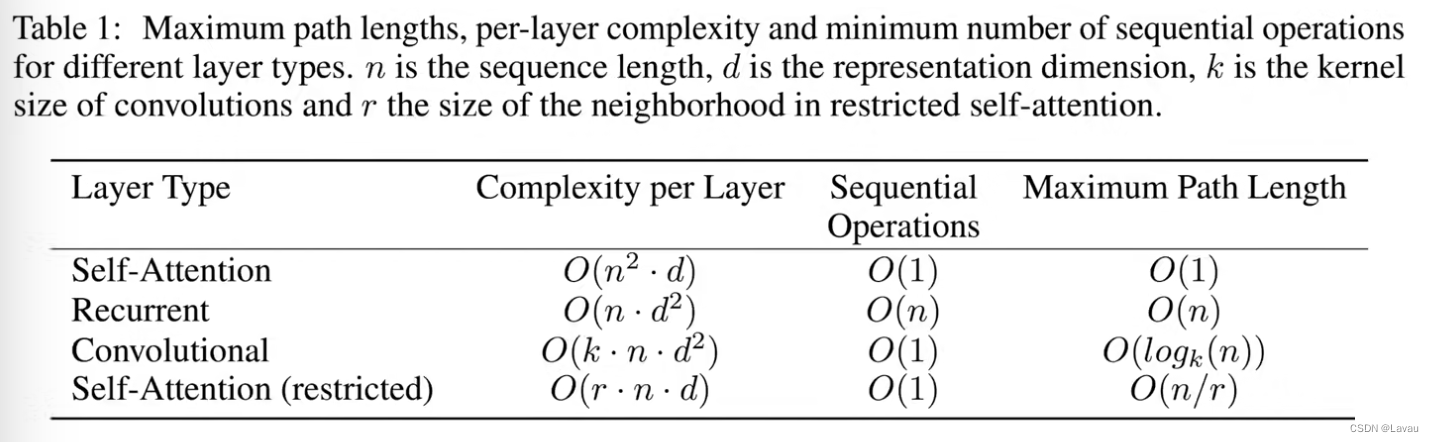

自然语言处理---Transformer机制详解之Transformer优势

1 Transformer的并行计算

对于Transformer比传统序列模型RNN/LSTM具备优势的第一大原因就是强大的并行计算能力.

对于RNN来说,任意时刻t的输入是时刻t的输入x(t)和上一时刻的隐藏层输出h(t-1),经过运算后得到当前时刻隐藏层的输出h(t),这个…

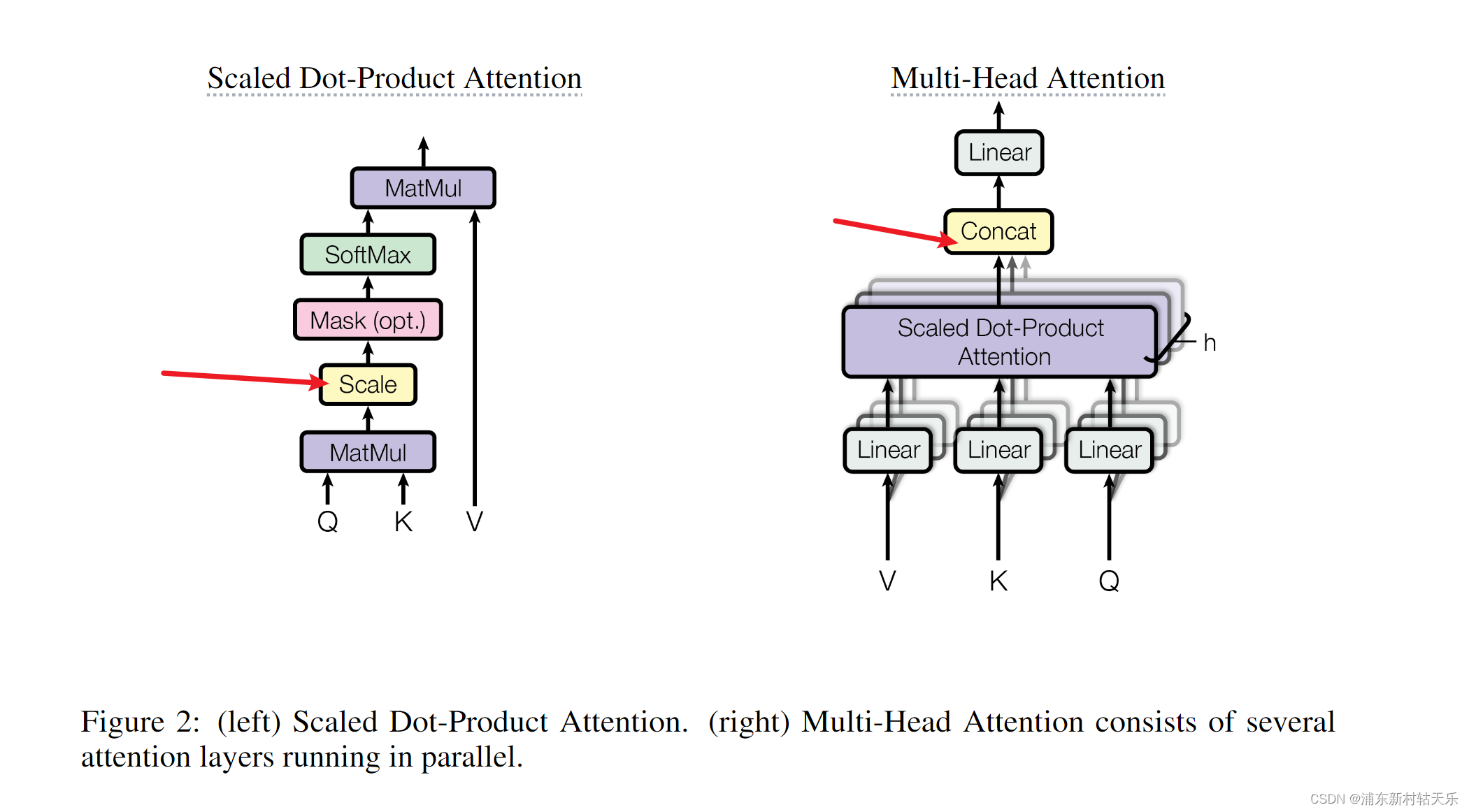

Vision Transformer

论文名称: An Image is Worth 16x16 Words: Transformers for Image Recognition at Scale

一、Patch Embedding模块 class PatchEmbed(nn.Module): # 对应Patch Embedding模块def __init__(self, img_size224, patch_size16, in_c3, embed_dim768, norm_layerNone…

为什么要引入Attention机制?

Attention mechanism在序列学习任务上具有巨大的提升作用,在编解码器框架内,通过在编码段加入Attention模型,对源数据序列进行数据加权变换,或者在解码端引入Attention 模型,对目标数据进行加权变化,可以有…

CrossCLR: Cross-modal Contrastive Learning for Multi-modal Video Representations, 2021 ICCV

**本文内容仅代表个人理解,如有错误,欢迎指正**

1. Points

这篇论文主要解决两个问题

1. 跨模态对比学习(Cross-modal Contrastive learning)更注重于不同模态下的数据,而非同一模态下的数据。

- 也就是说,将不同模态下的数据…

Transformer回顾与细节

我们在《Seq2seq Attention模型详解》中,详细地回顾了以 RNN 为基础模块的Seq2seq模型。本文所讲述的Transformer也采用Seq2seq式的编码器-解码器结构,不过它摒弃了经典的 RNN,采用 self-Attention。由于并行计算、长时序建模、模型容量大等优…

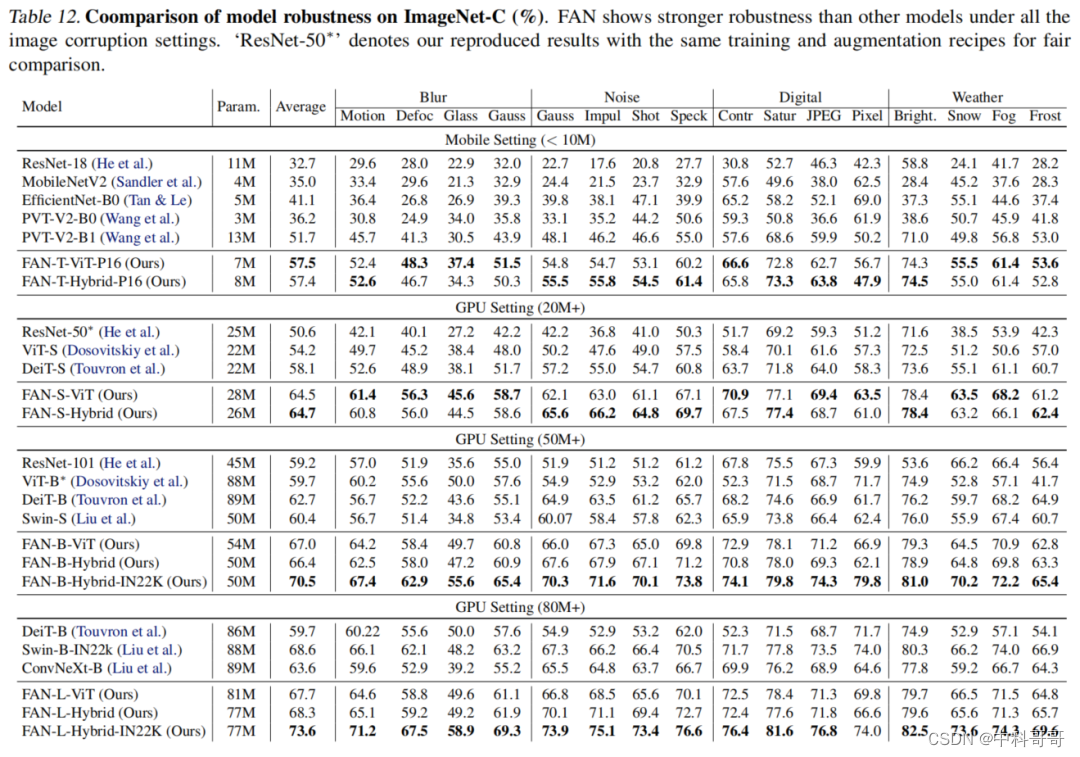

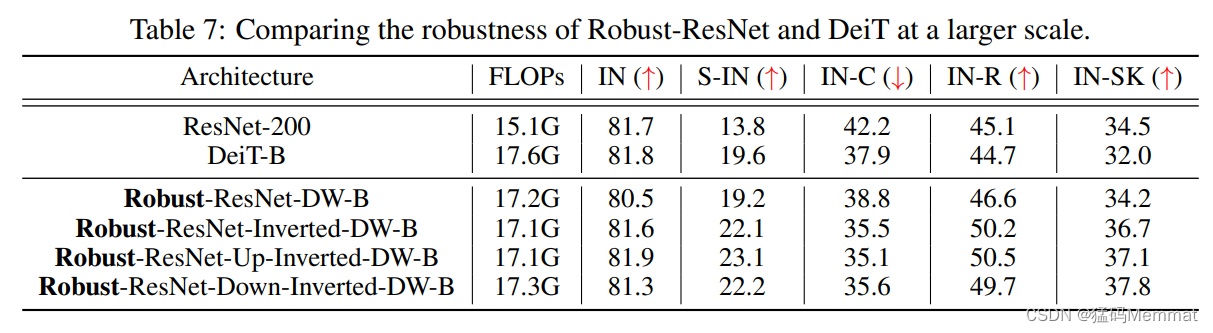

FAN(Understanding The Robustness in Vision Transformers)论文解读,鲁棒性和高效性超越ConvNeXt、Swin

FAN(Understanding The Robustness in Vision Transformers)论文解读,鲁棒性和高效性超越ConvNeXt、Swin < center > < center >

最近的研究表明,Vision Transformers对各种Corruptions表现出很强的鲁棒性。虽然这一特性部分归…

风格转换模型style_transformer项目实例 pytorch实现

风格转换模型style_transformer项目实例 pytorch实现

有没有想过,利用机器学习来画画,今天,我将手把手带大家进入深度学习模型neural style的代码实战当中。 neural-style模型是一个风格迁移的模型,是GitHub上一个超棒的项目&…

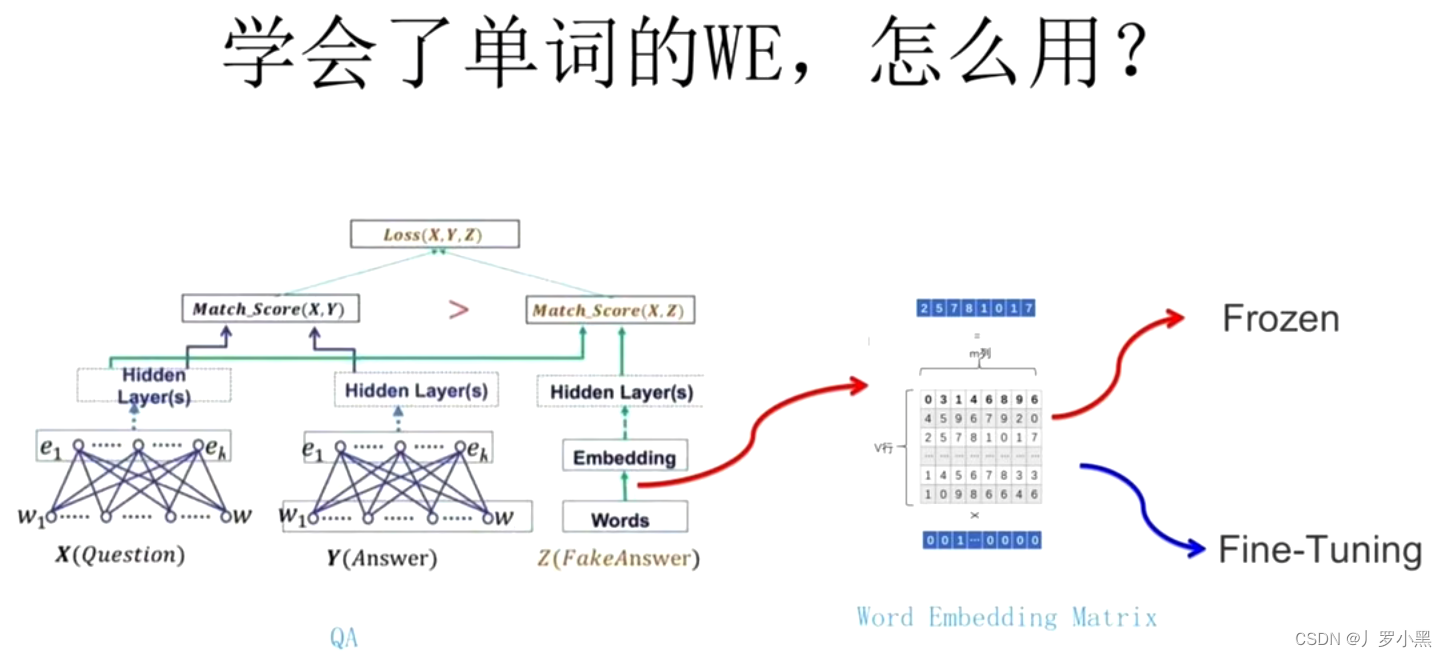

Attention——Transformer——Bert——FineTuning——Prompt

目录 一、Attention机制

二、Transformer模型

三、Bert模型

四、Fine-Tuning微调

五、Prompt 一、Attention机制

1、核心逻辑:从关注全部到关注重点;

2.计算attention公式: 3.优点:

(1)参数少&#…

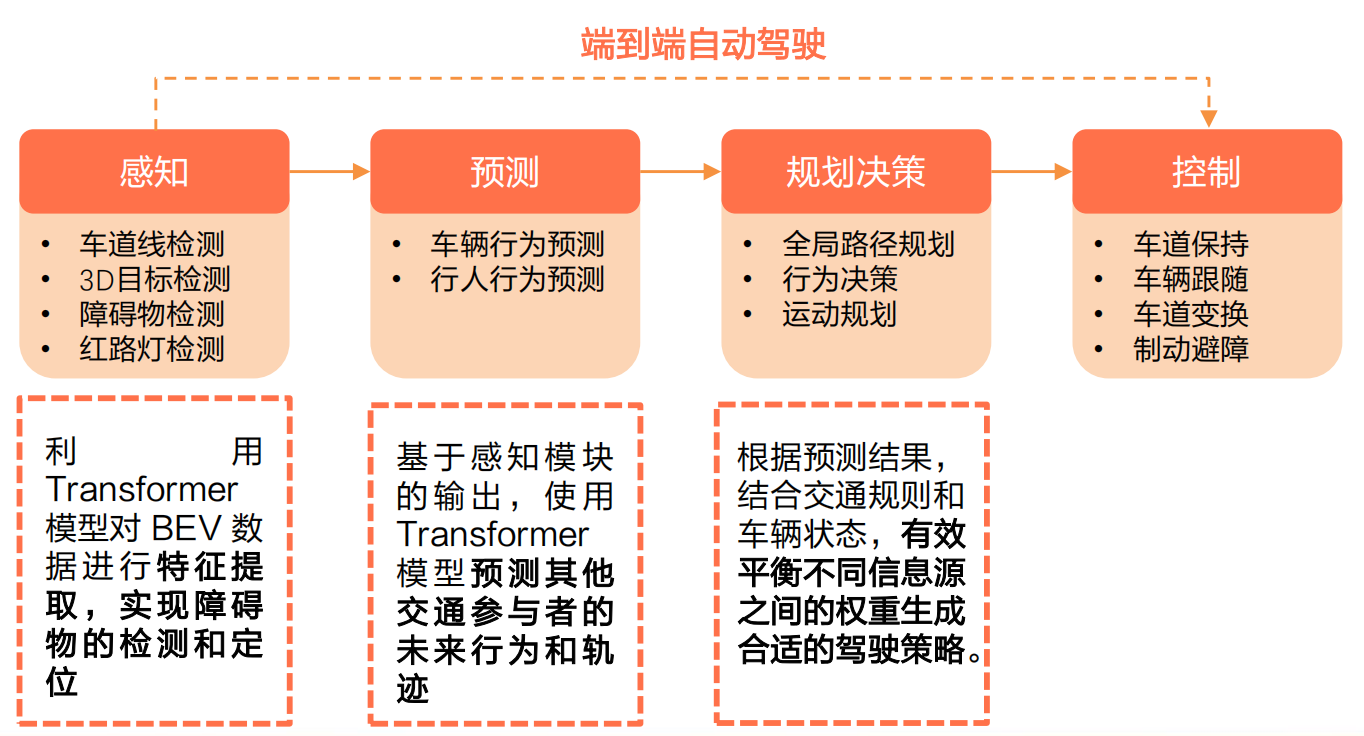

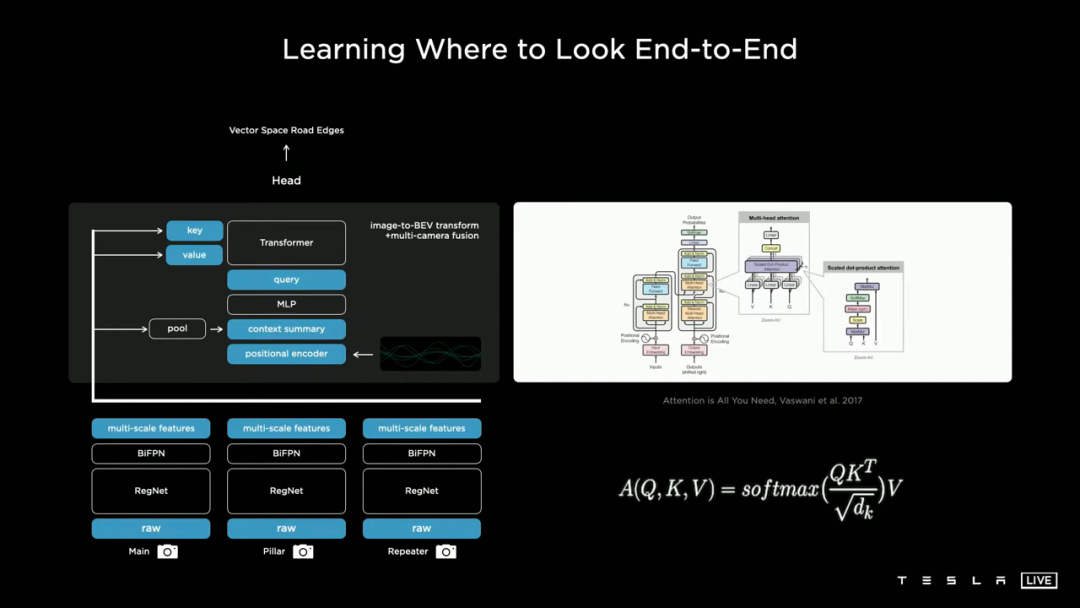

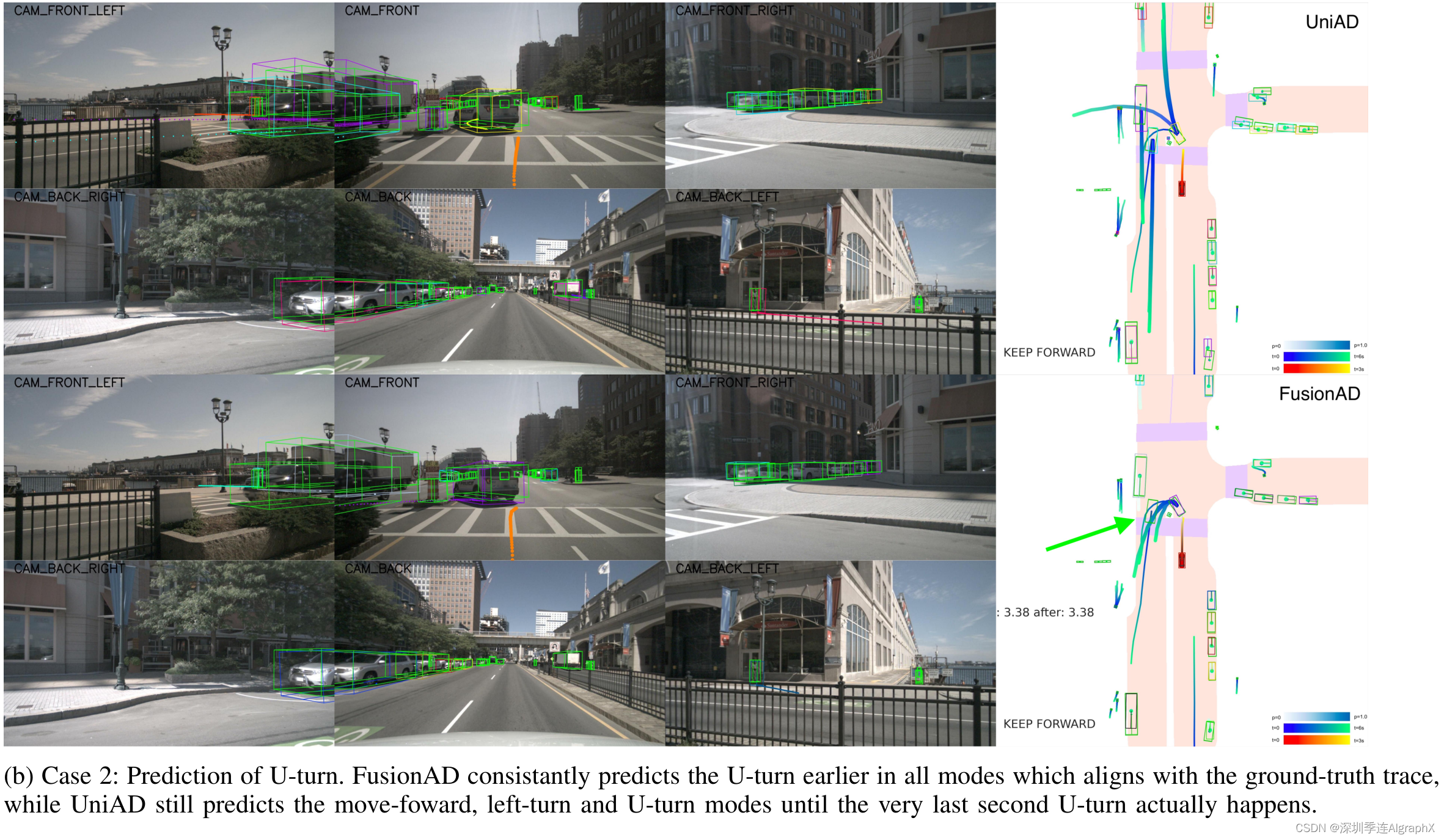

【Transformer系列论文】TransFuser:端到端自动驾驶的多模态融合Transformer

Article

作者:Aditya Prakash, Kashyap Chitta, Andreas Geiger文献题目:TransFuser:端到端自动驾驶的多模态融合Transformer文献时间:2021文献链接:https://arxiv.org/abs/2104.09224

摘要

互补传感器的表征应该如…

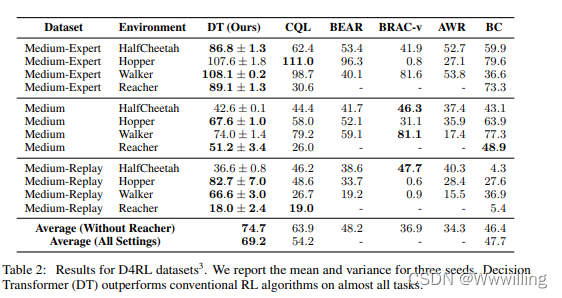

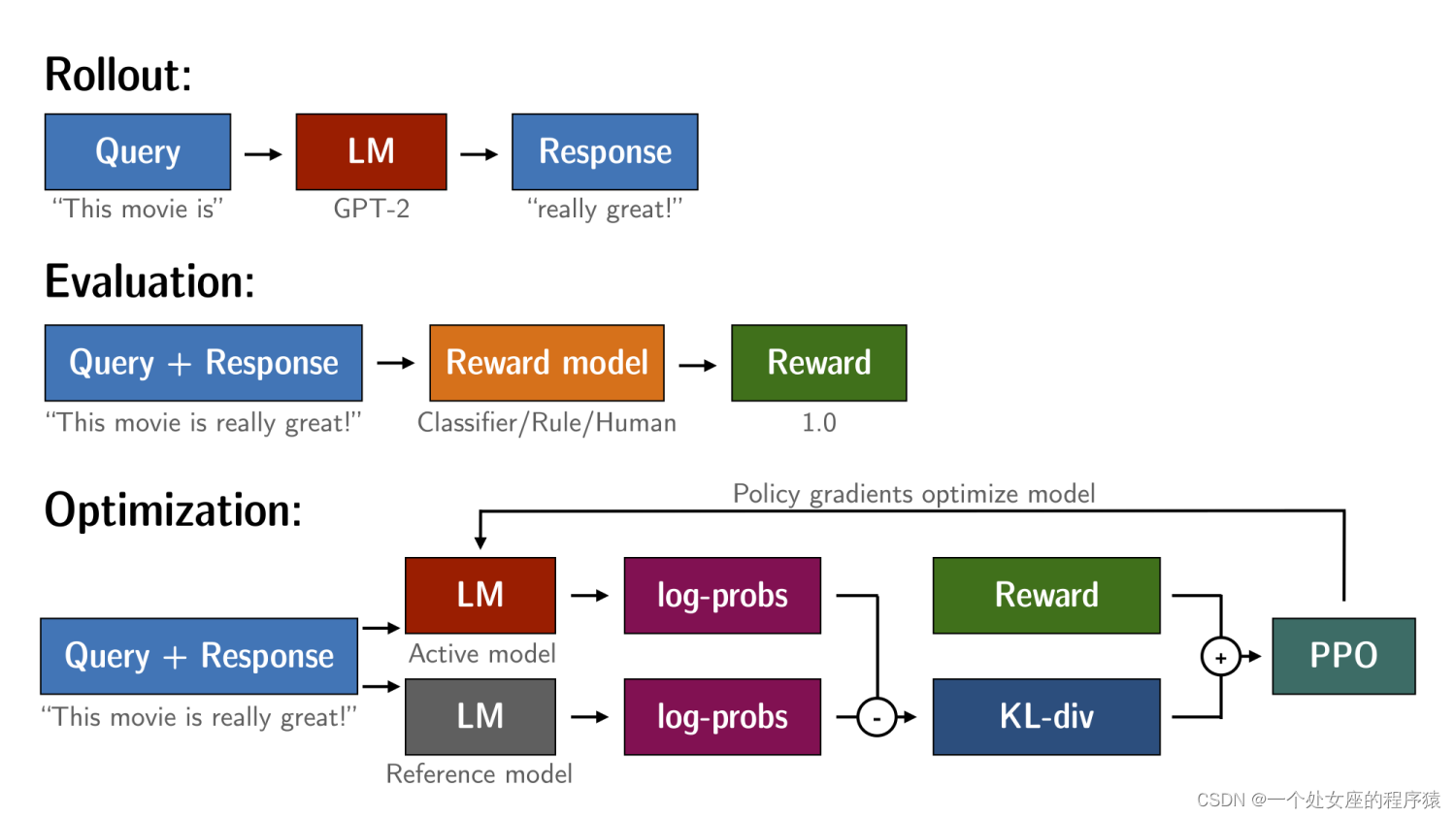

【强化学习论文】Decision Transformer:通过序列建模进行强化学习

Article

文献题目:Decision Transformer: Reinforcement Learning via Sequence Modeling 文献时间:2021

摘要

我们引入了一个将强化学习(RL)抽象为序列建模问题的框架。 这使我们能够利用 Transformer 架构的简单性和可扩展性…

TrOCR – 基于 Transformer 的 OCR 入门

一、TrOCR 架构 近些年,光学字符识别 (OCR) 出现了多项创新。它对零售、医疗保健、银行和许多其他行业的影响是巨大的。与深度学习的许多其他领域一样,OCR领域也看到了Transformer 神经网络的重要性和影响。如今,出现了像TrOCR(Transformer OCR)这样的模型,它在准确性方面…

t5模型为什么可以通过传入past_key和past_value值来进行优化模型

t5模型是常用于文本生成部分的一个模型,也是目前我看到的各个nlp模型之中,唯一完整地使用transformer的所有完整结构(encoder部分加上decoder部分)的一个模型,接下来聊一下t5模型的生成优化过程。

优化的部分

首先对于生成这一块࿰…

[bug][未解决] transformer encoder对不同的输入,输出全部一样

多标签分类问题,输入是蛋白质特征,输出是蛋白质的功能(即,一个由标签组成的DAG)

motivation:输入是一个有multi-hot向量组成的张量,multi-hot的每一位代表着某一种特征。

考虑到不同特征之间可…

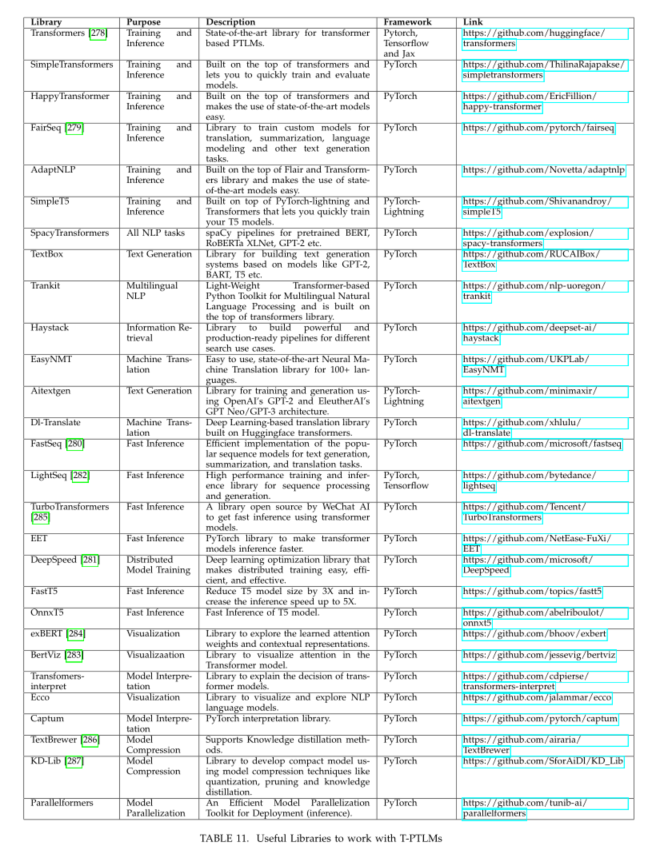

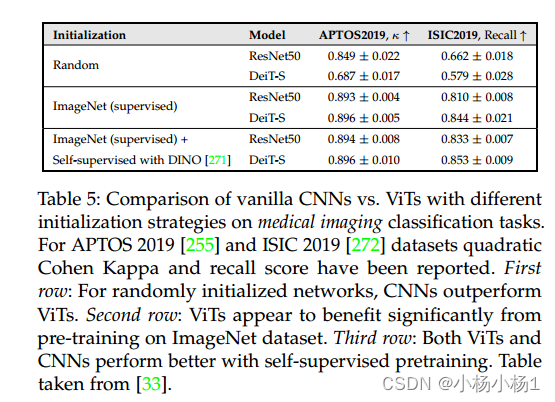

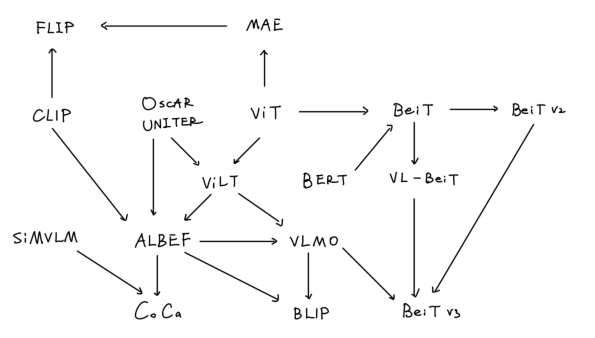

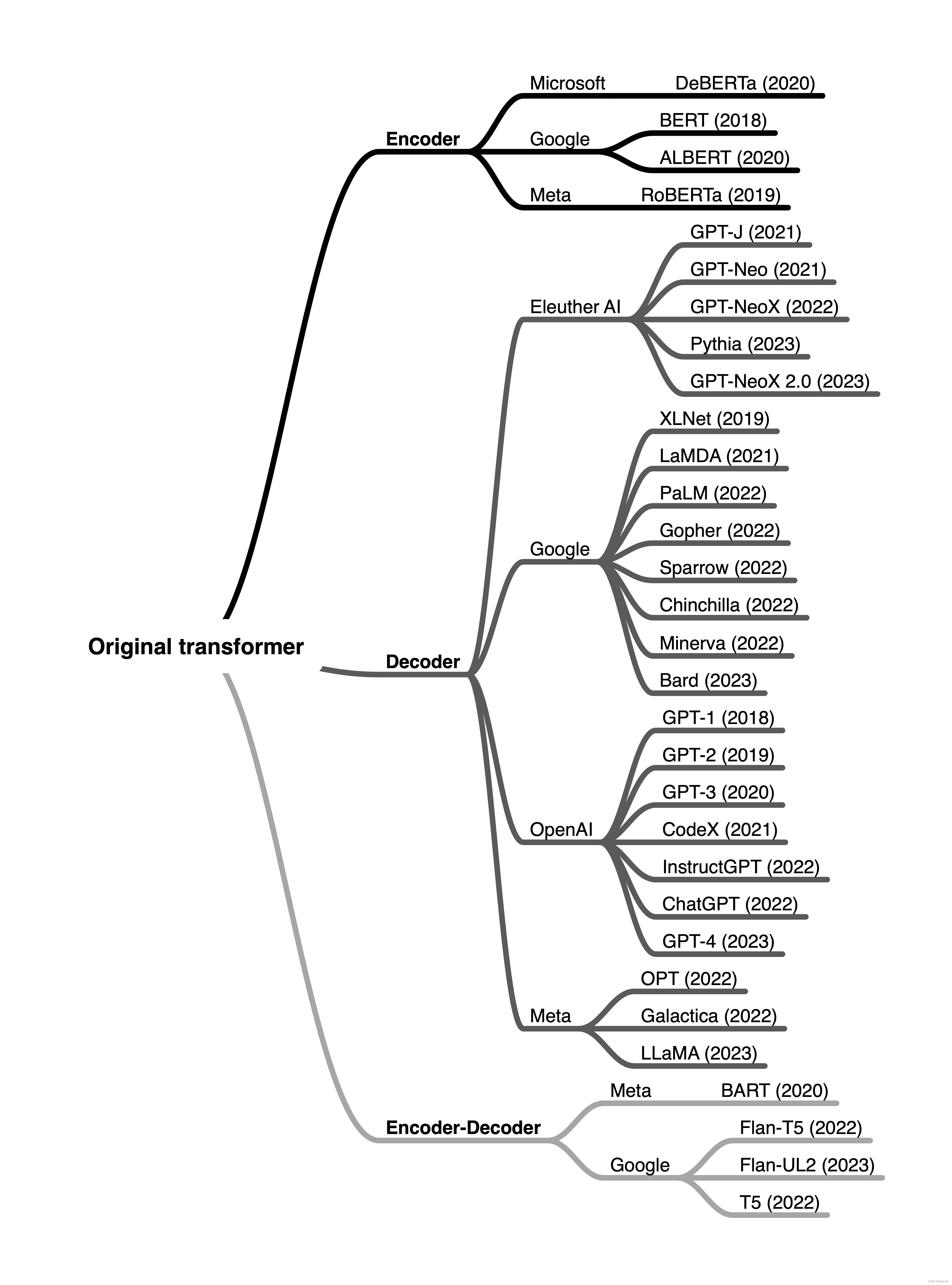

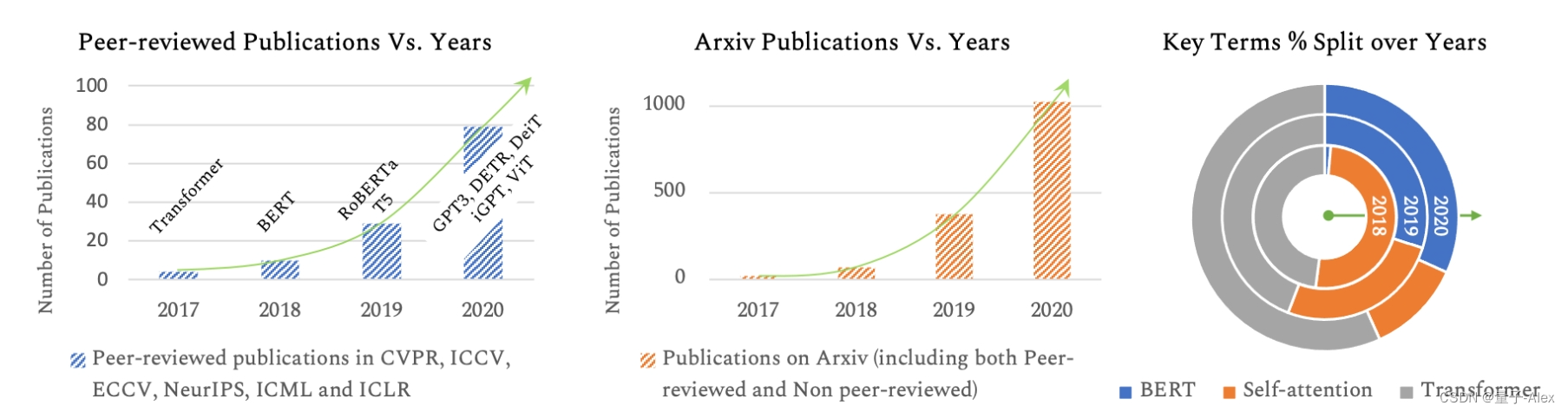

Transformer-based模型的综述:AMMUS : A Survey of Transformer-based Pretrained Models in NLP

论文地址: https://arxiv.org/abs/2108.055421 导言 预训练的来源 最开始是基于规则的学习,后来被机器学习取代早期机器学习需要特征工程,需要专业领域的知识,耗时由于硬件和词嵌入的发展,类似于CNN、RNN的深度学习模型…

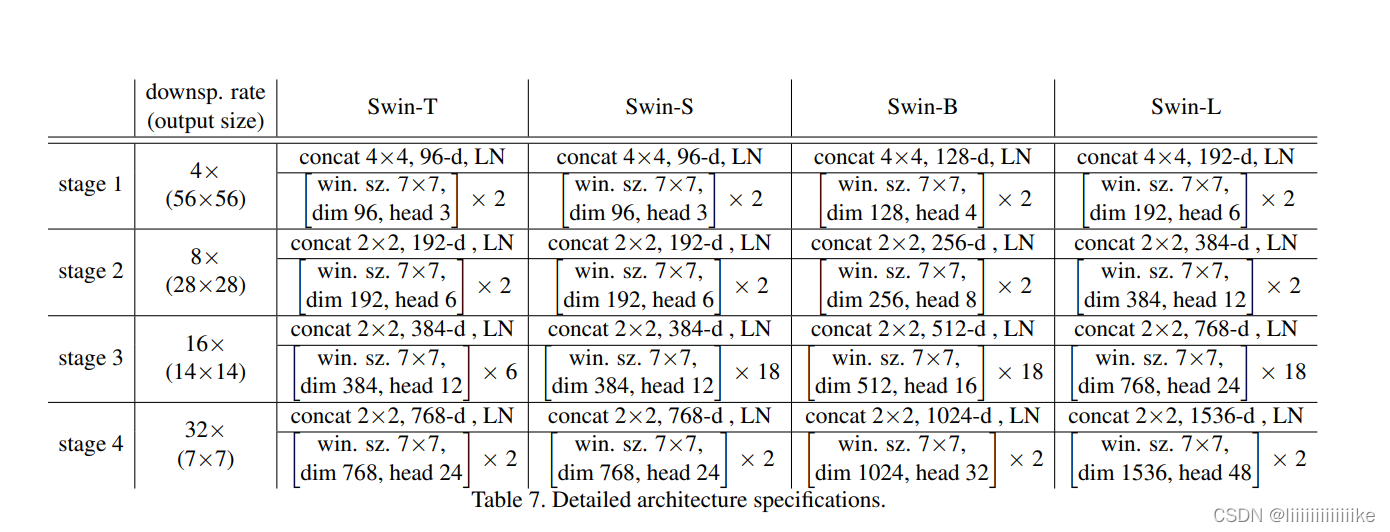

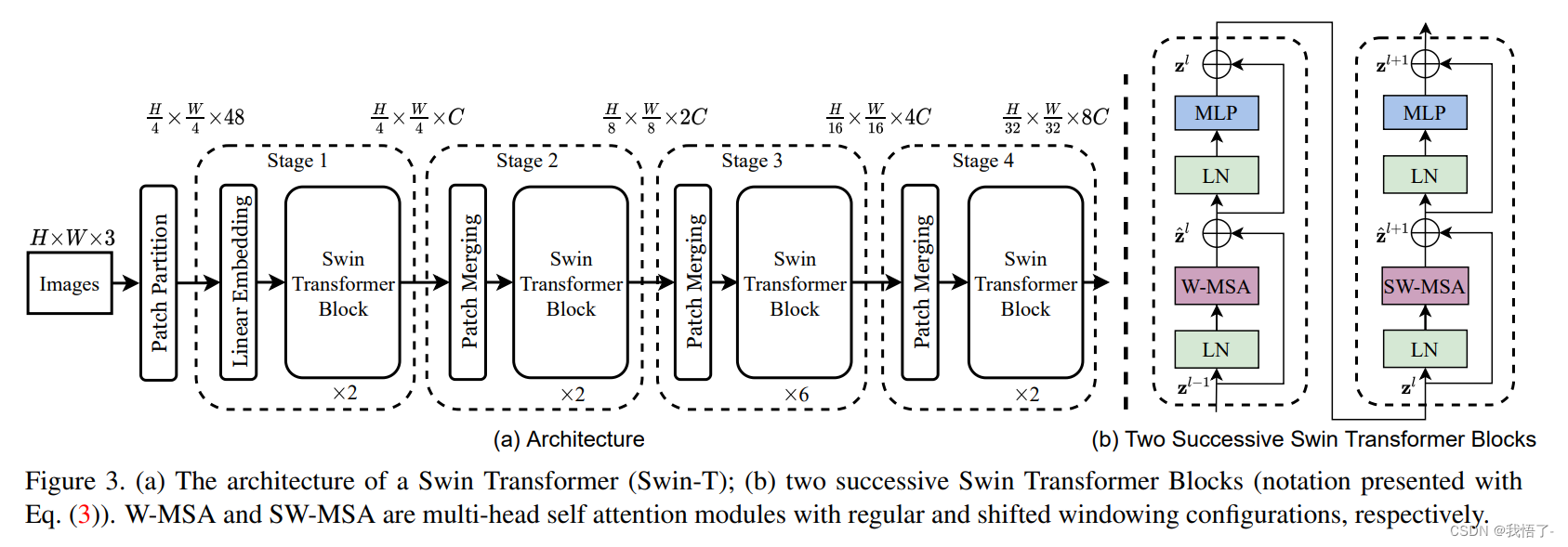

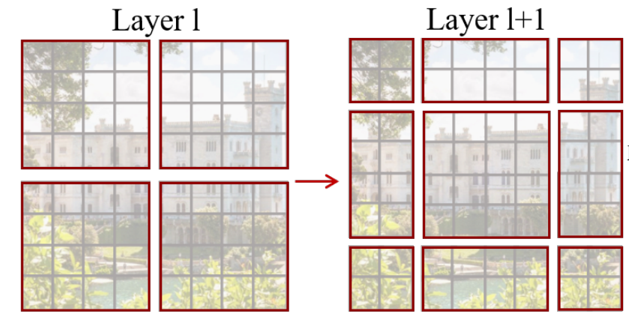

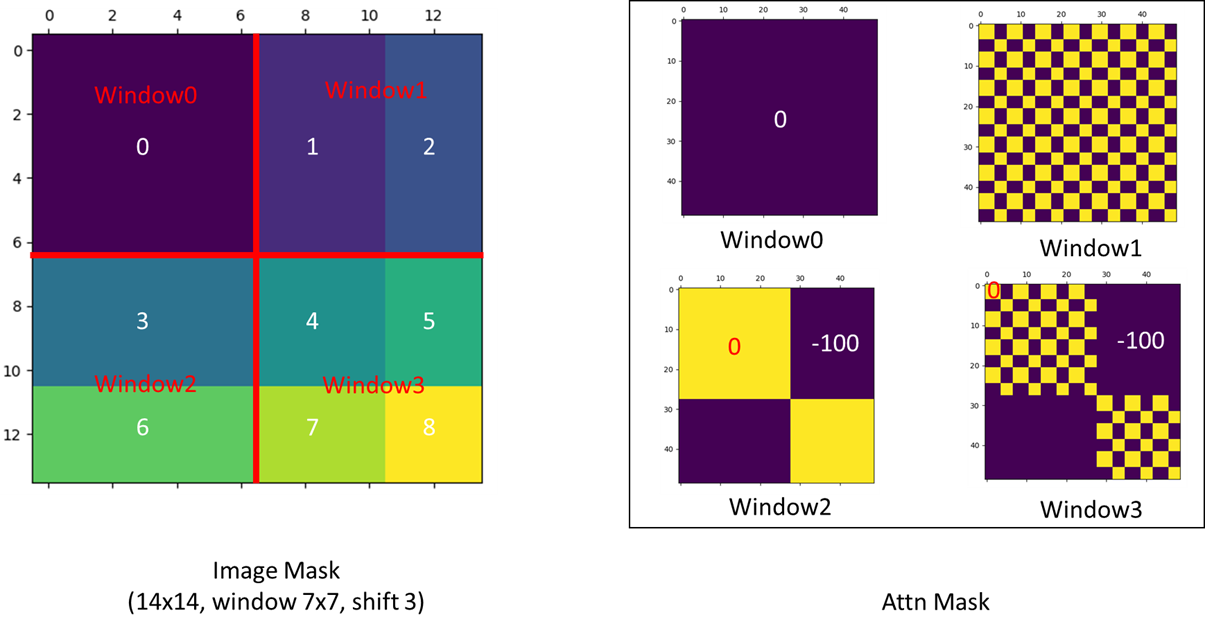

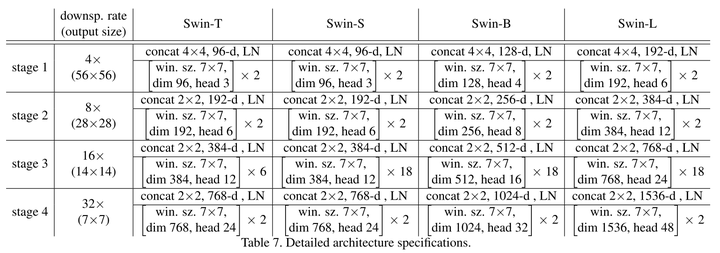

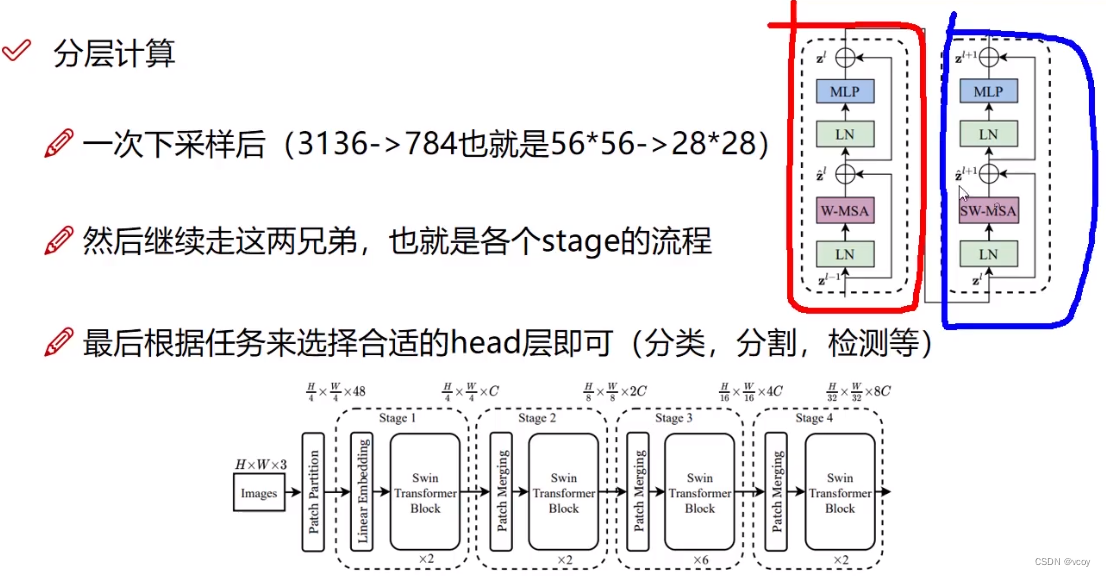

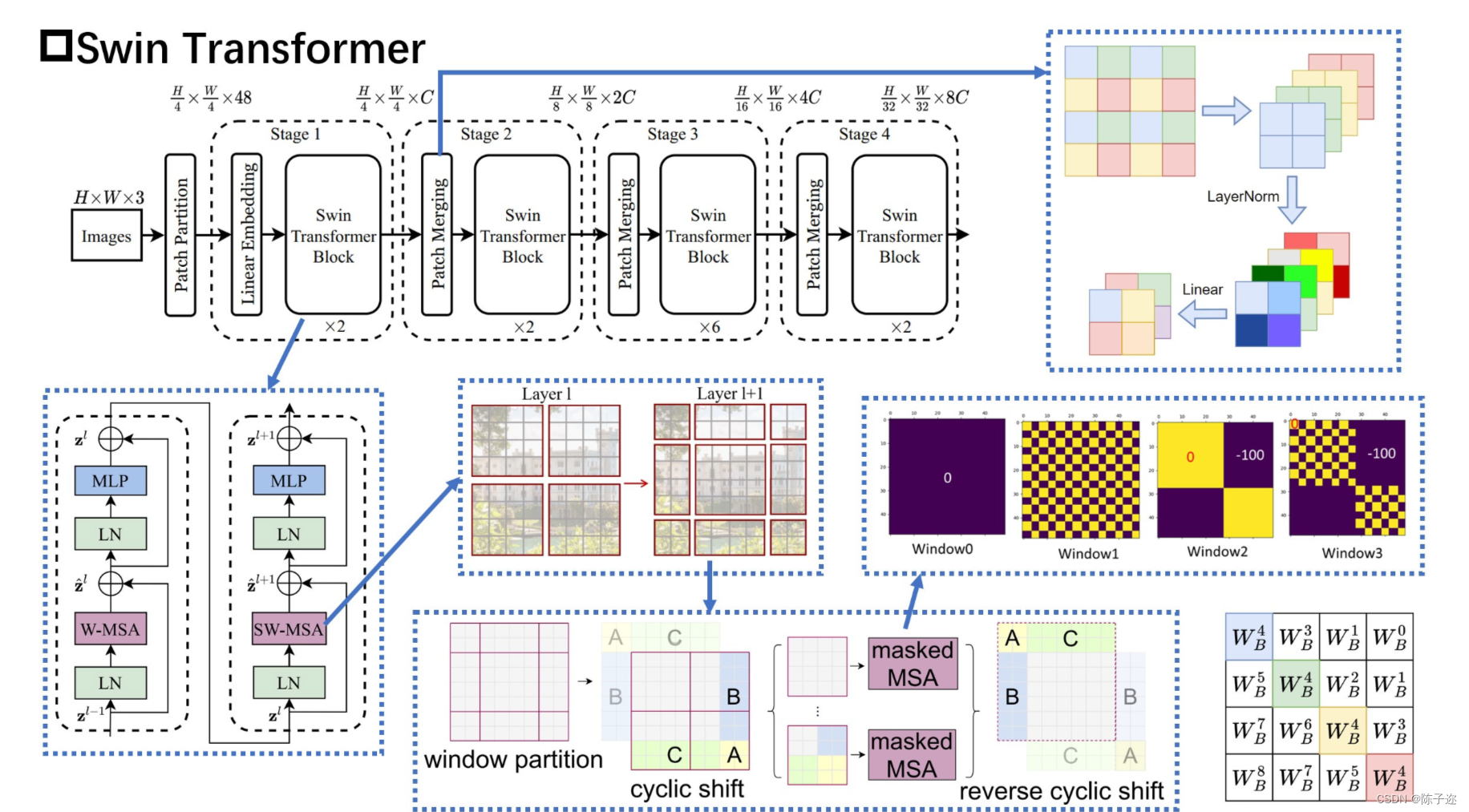

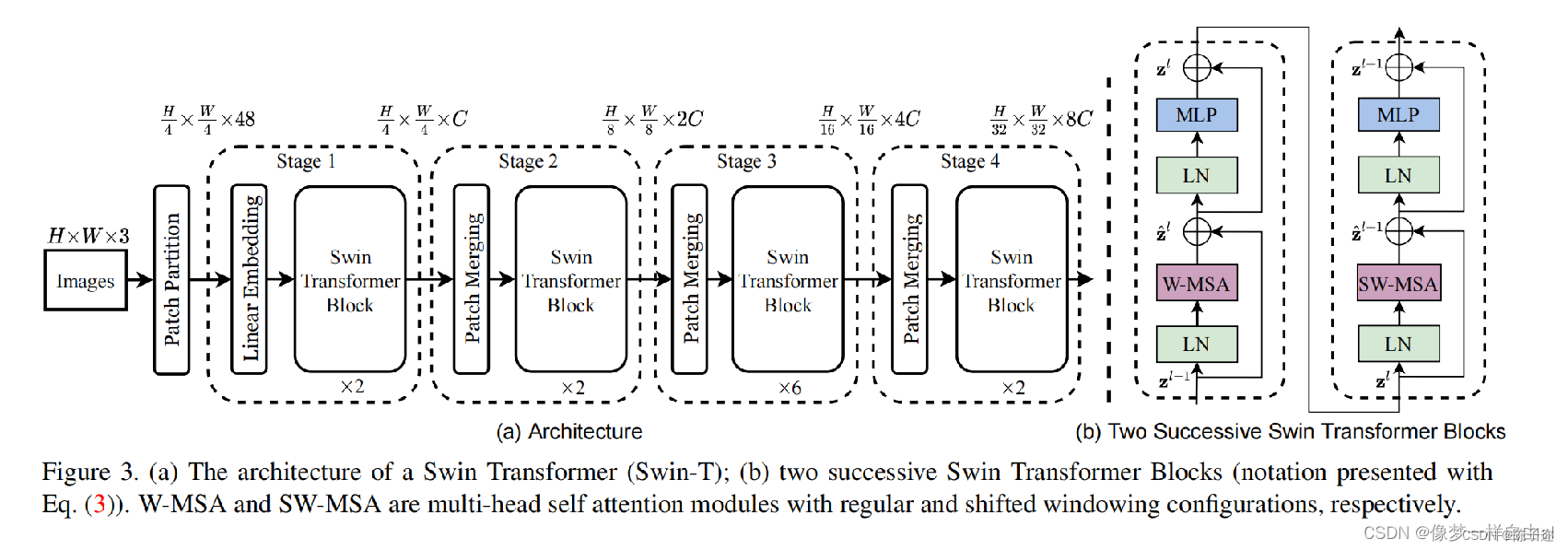

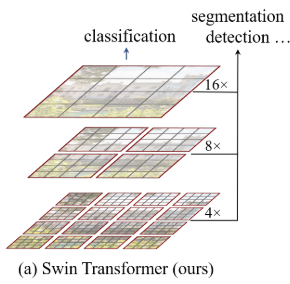

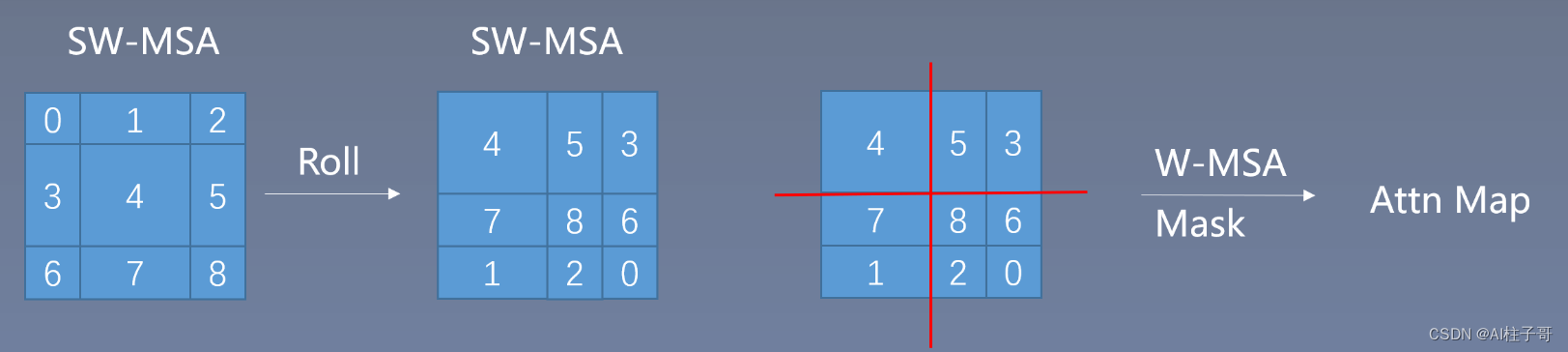

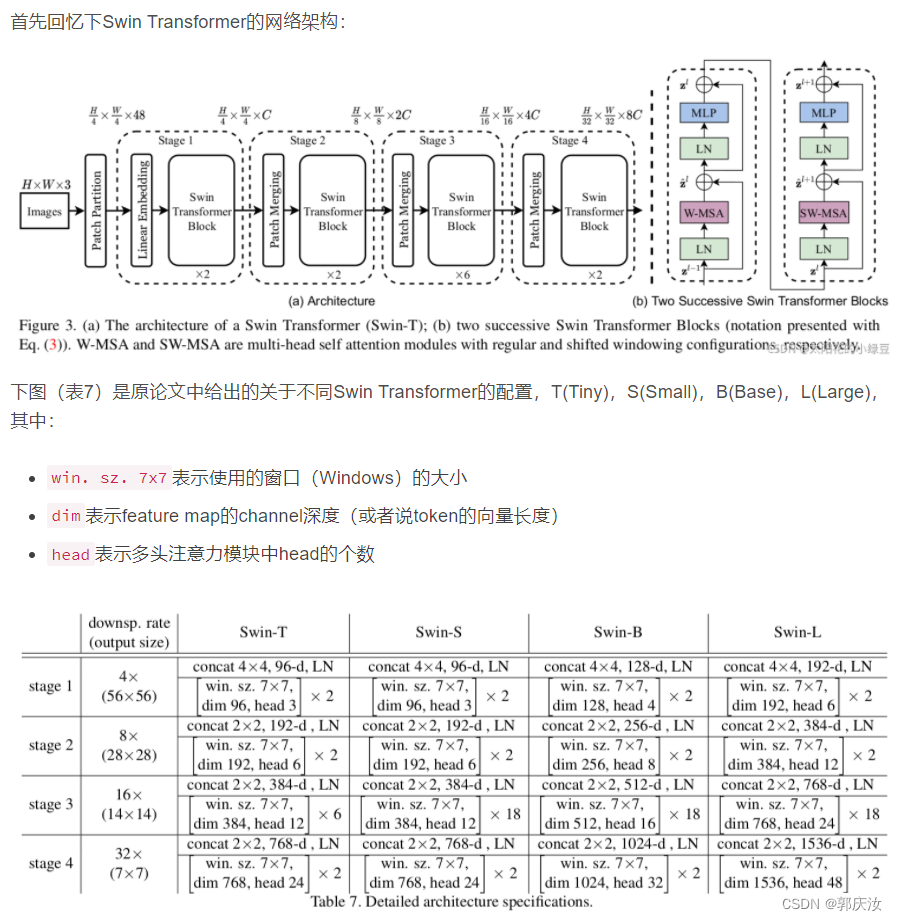

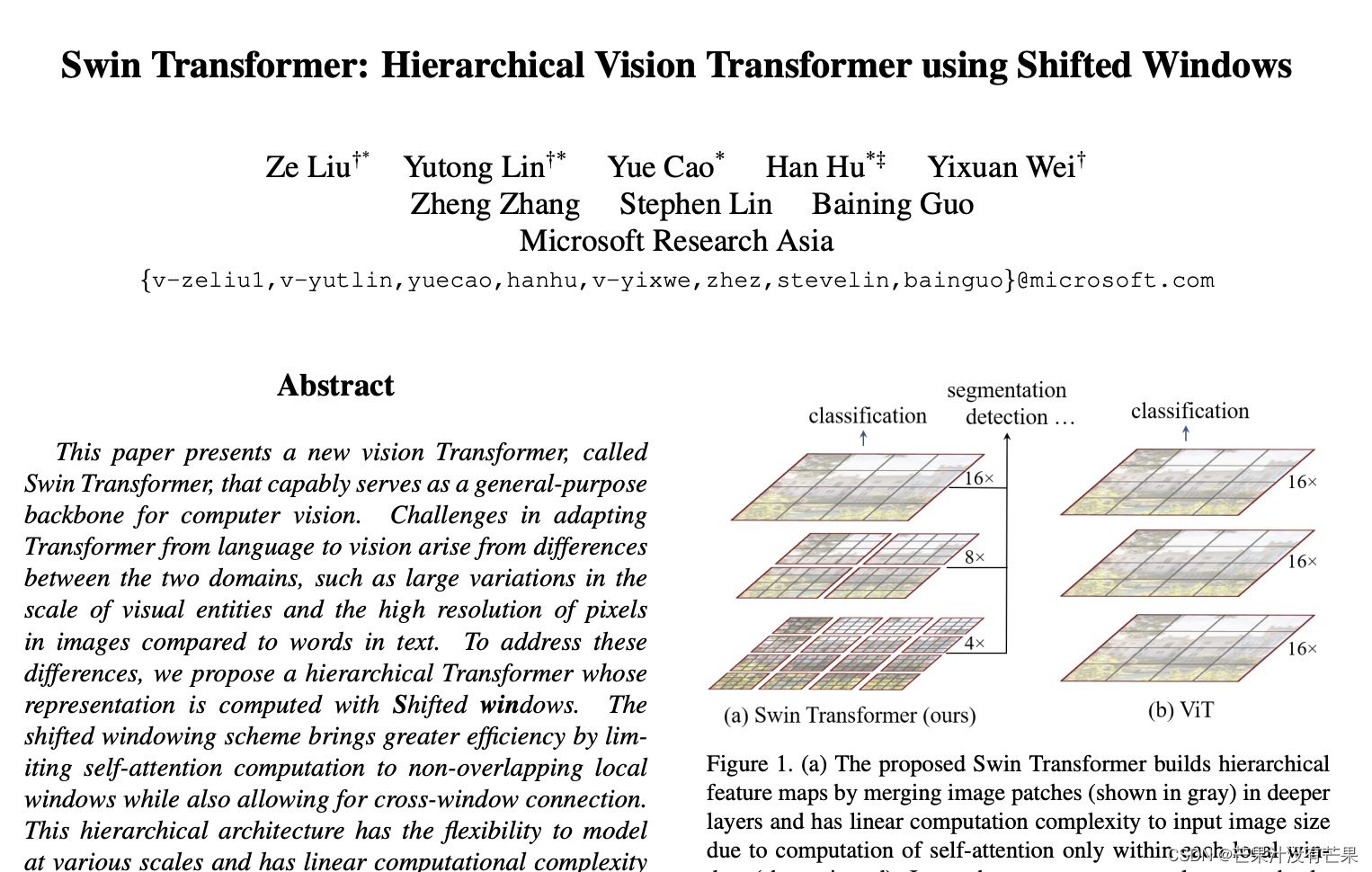

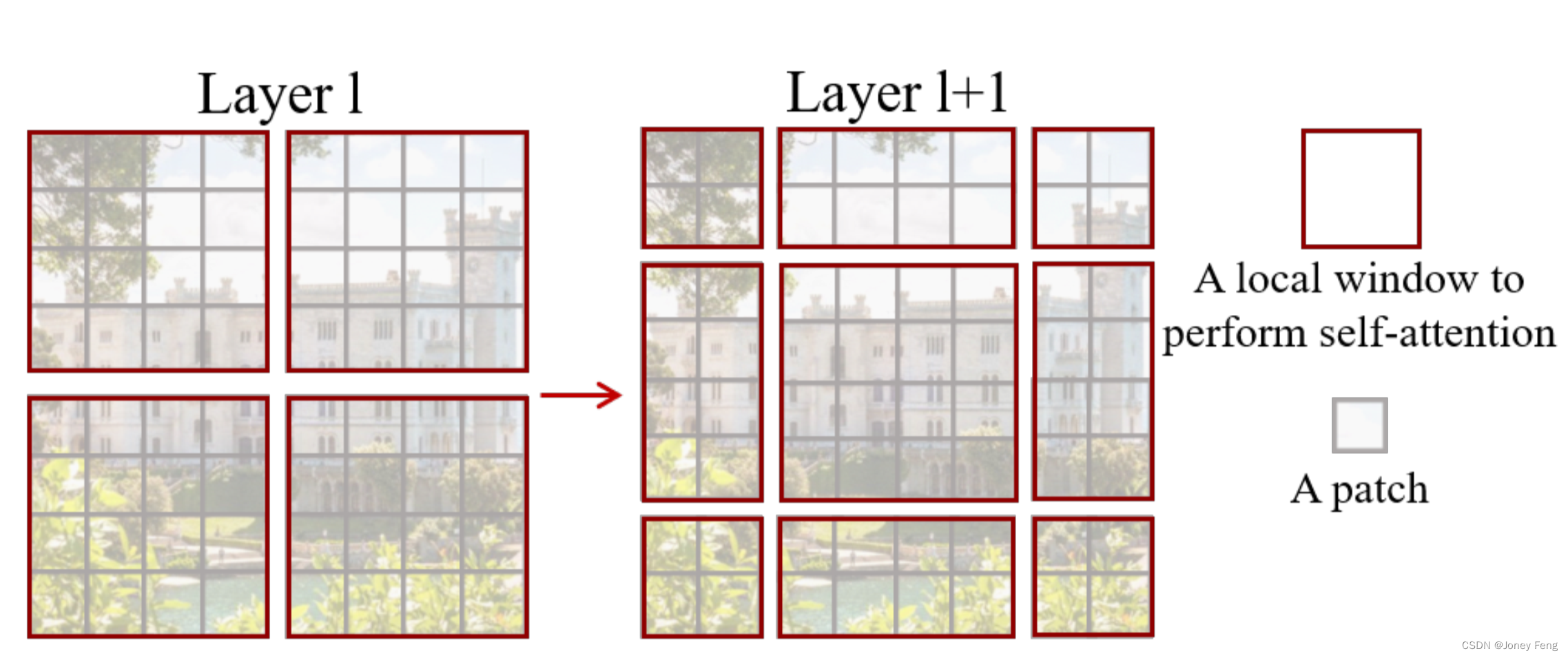

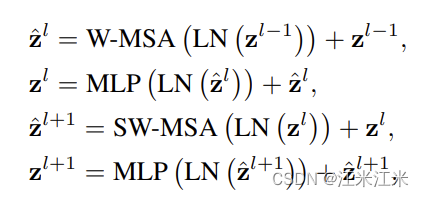

Swin Transformer网络架构、相应改进模块的理解

swin-Transformer

Transformer越来越火,个人感觉基于Transformer来做视觉真是把矩阵用得出神入化!! Swin-Transformer相较于VIT改进的方法:

SwinT使用类似CNN中层次化构建方法,这样的backbone有助于在此基础上构建检…

Transformer面试题总结

1.框架 Transformer和seq2seq一样由解码器和编码器组成,用多头注意力替换编码器和解码器架构中最常用的循环层 1.1 编码器:编码器有一堆N6的相同层组成,每一层有两个子层,第一个子层包含多头注意力机制,第二个子层是前…

层层剥开Transformer;Windows Copilot初版非常简陋

🦉 AI新闻

🚀 微软Win11引入Windows Copilot功能,但初版非常简陋

摘要:微软在Win11 Build 23493预览版更新中引入了Windows Copilot功能,该功能在任务栏上新增了一个图标按钮。点击按钮后,屏幕右侧会跳出…

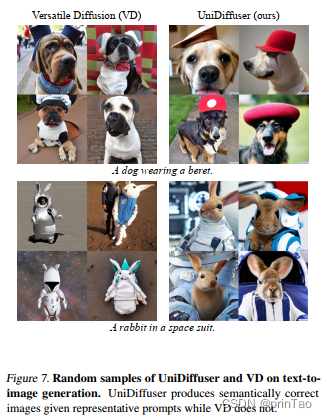

【论文阅读】UniDiffuser: Transformer+Diffusion 用于图、文互相推理

而多模态大模型将能够打通各种模态能力,实现任意模态之间转化,被认为是通用式生成模型的未来发展方向。

最近看到不少多模态大模型的工作,有医学、金融混合,还有CV&NLP。

今天介绍: One Transformer Fits All Di…

pytorch 使用 xformers 库 加速多头注意力计算 和 大幅节省显存

效果概览: 好处:使用 google PALM 架构的小模型做 生成任务,改为 xformers 实现后,加速比为 2倍,显存消耗为原来的 1/3 ,非常给力。 缺点:相比pytorch的原生实现,误差略大。。。

xf…

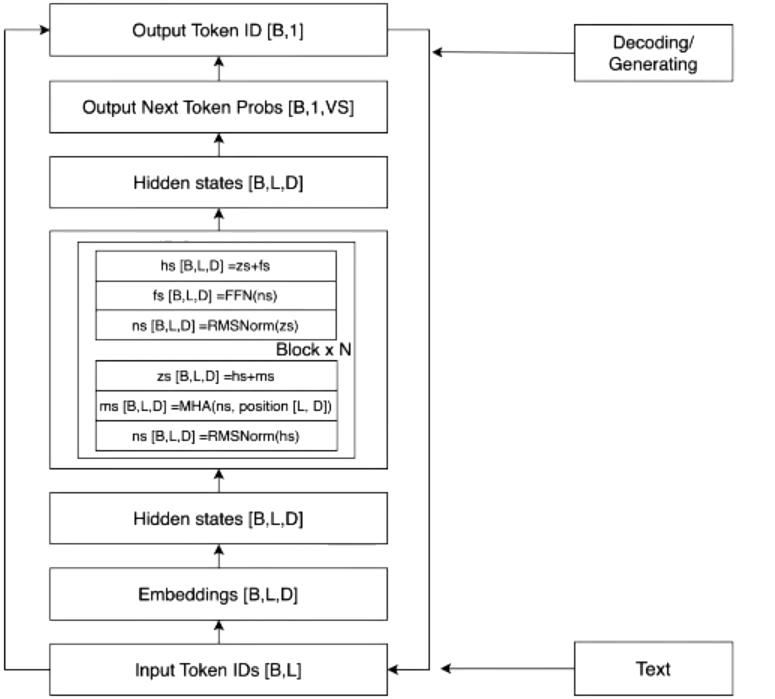

基于PyTorch的Transformer组件实现

最近看了不少介绍LLM工作原理的文章,发现每一篇都会试图跟读者讲明白作为baseline的Transformer架构到底长啥样。但是好像比较少有代码实现的示例和具体的例子帮助理解。于是自己也想尝试着写一篇含有代码实现和具体例子解释的文章,希望能够给喜欢编程朋…

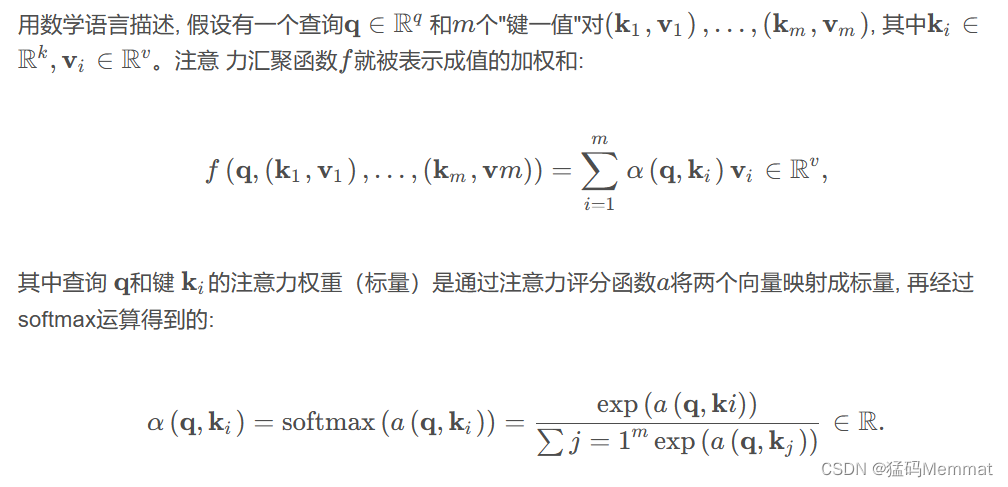

36k字从Attention讲解Transformer及其在Vision中的应用(pytorch版)

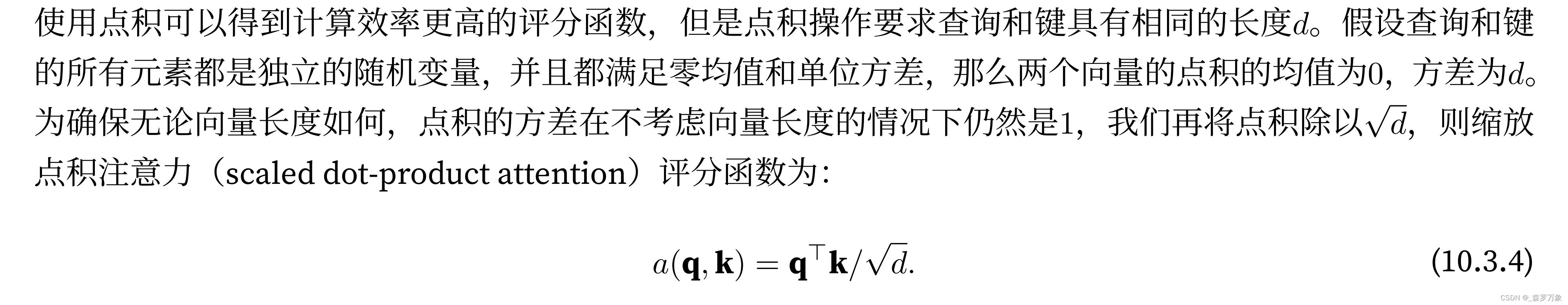

文章目录 0.卷积操作1.注意力1.1 注意力概述(Attention)1.1.1 Encoder-Decoder1.1.2 查询、键和值1.1.3 注意力汇聚: Nadaraya-Watson 核回归1.2 注意力评分函数1.2.1 加性注意力1.2.2 缩放点积注意力1.3 自注意力(Self-Attention)1.3.1 自注意力的定义和计算1.3.2 自注意…

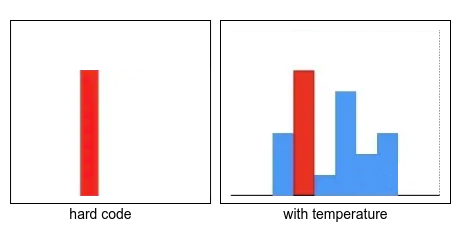

(2021|NIPS,)CogView:通过 Transformer 掌握文本到图像的生成

CogView: Mastering Text-to-Image Generation via Transformers

公众号:EDPJ(添加 VX:CV_EDPJ 或直接进 Q 交流群:922230617 获取资料) 0. 摘要

通用领域中的文本到图像生成长期以来一直是一个悬而未决的问题&#…

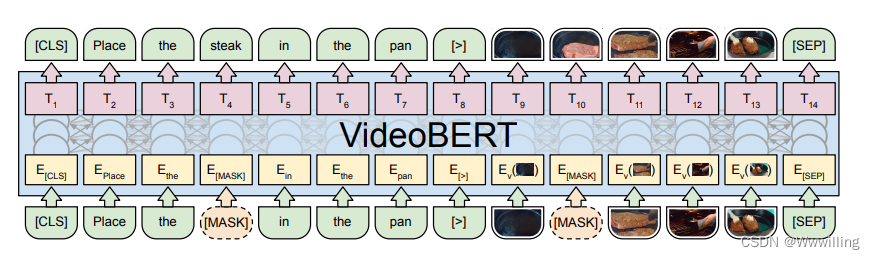

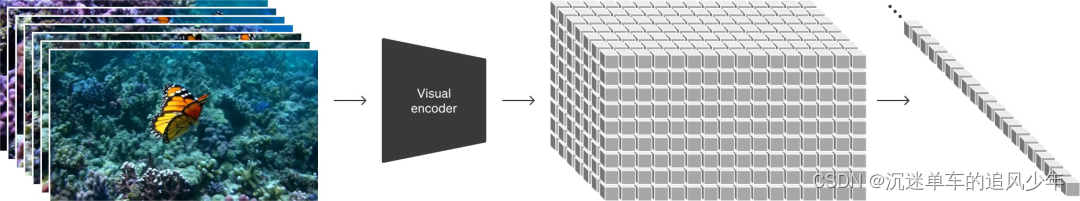

【Transformer论文】VideoBERT:视频和语言表示学习的联合模型

文献题目:VideoBERT: A Joint Model for Video and Language Representation Learning代码:https://github.com/ammesatyajit/VideoBERT

摘要

自我监督学习对于利用 YouTube 等平台上可用的大量未标记数据变得越来越重要。尽管大多数现有方法都学习低级…

【Transformer论文】使用 Transformer 网络的会话感知项目组合推荐

文献题目:Session-aware Item-combination Recommendation with Transformer Network

摘要

在本文中,我们详细描述了我们的 IEEE BigData Cup 2021 解决方案:基于 RL 的 RecSys(Track 1:Item Combination Prediction…

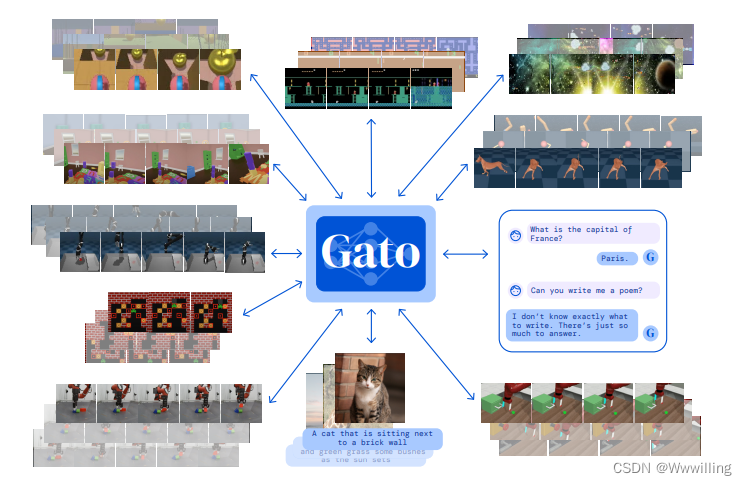

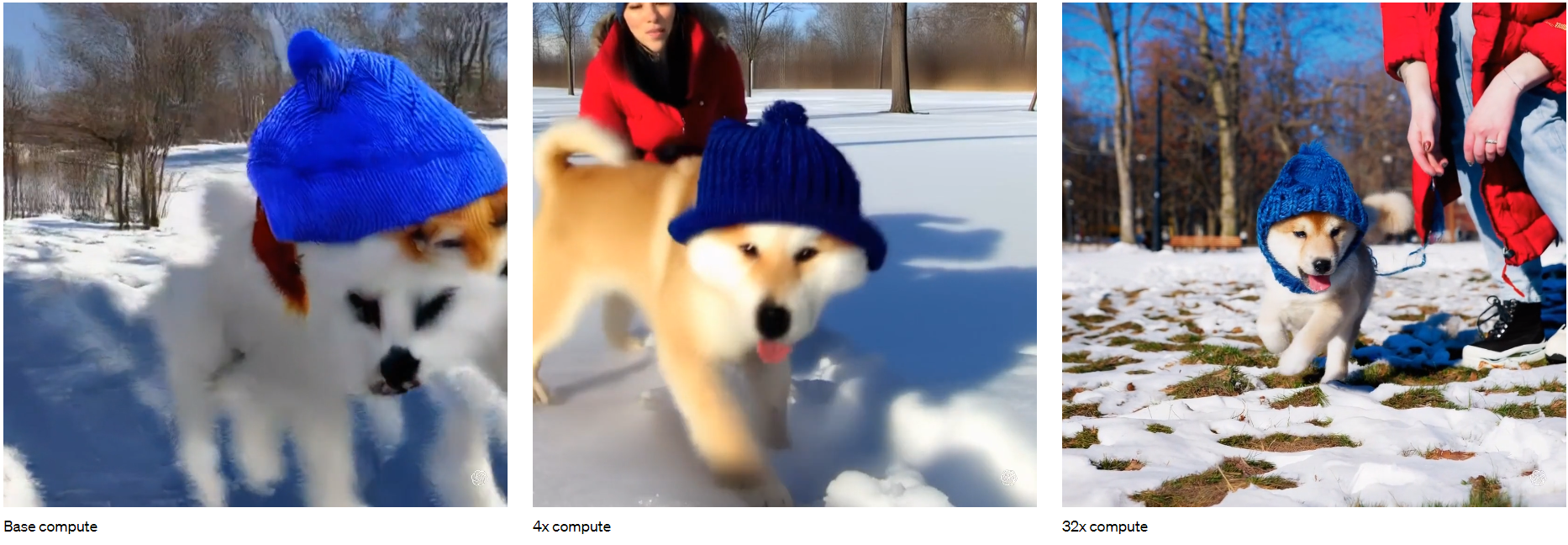

【Transformer论文】通用代理

文章题目:A Generalist Agent

摘要

受大规模语言建模进展的启发,我们应用了类似的方法来构建超越文本输出领域的单一通才代理。 代理,我们称之为 Gato,作为一种多模式、多任务、多实施的通才策略工作。 具有相同权重的相同网络可…

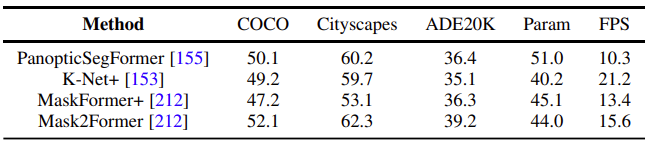

基于Transformer视觉分割综述

基于Transformer视觉分割综述

SAM (Segment Anything )作为一个视觉的分割基础模型,在短短的 3 个月时间吸引了很多研究者的关注和跟进。如果你想系统地了解 SAM 背后的技术,并跟上内卷的步伐,并能做出属于自己的 SAM…

Transformer理解实现

注意力机制是一种在现代深度学习模型中无处不在的方法,它有助于提高神经机器翻译应用程序性能的概念。在本文中,我们将介绍Transformer这种模型,它可以通过注意力机制来提高训练模型的速度。在特定任务中,Transformer的表现优于Go…

transformer通俗理解

Transformer是一个利用注意力机制来提高模型训练速度的模型。trasnformer可以说是完全基于自注意力机制的一个深度学习模型,因为它适用于并行化计算,和它本身模型的复杂程度导致它在精度和性能上都要高于之前流行的RNN循环神经网络。

那什么是transform…

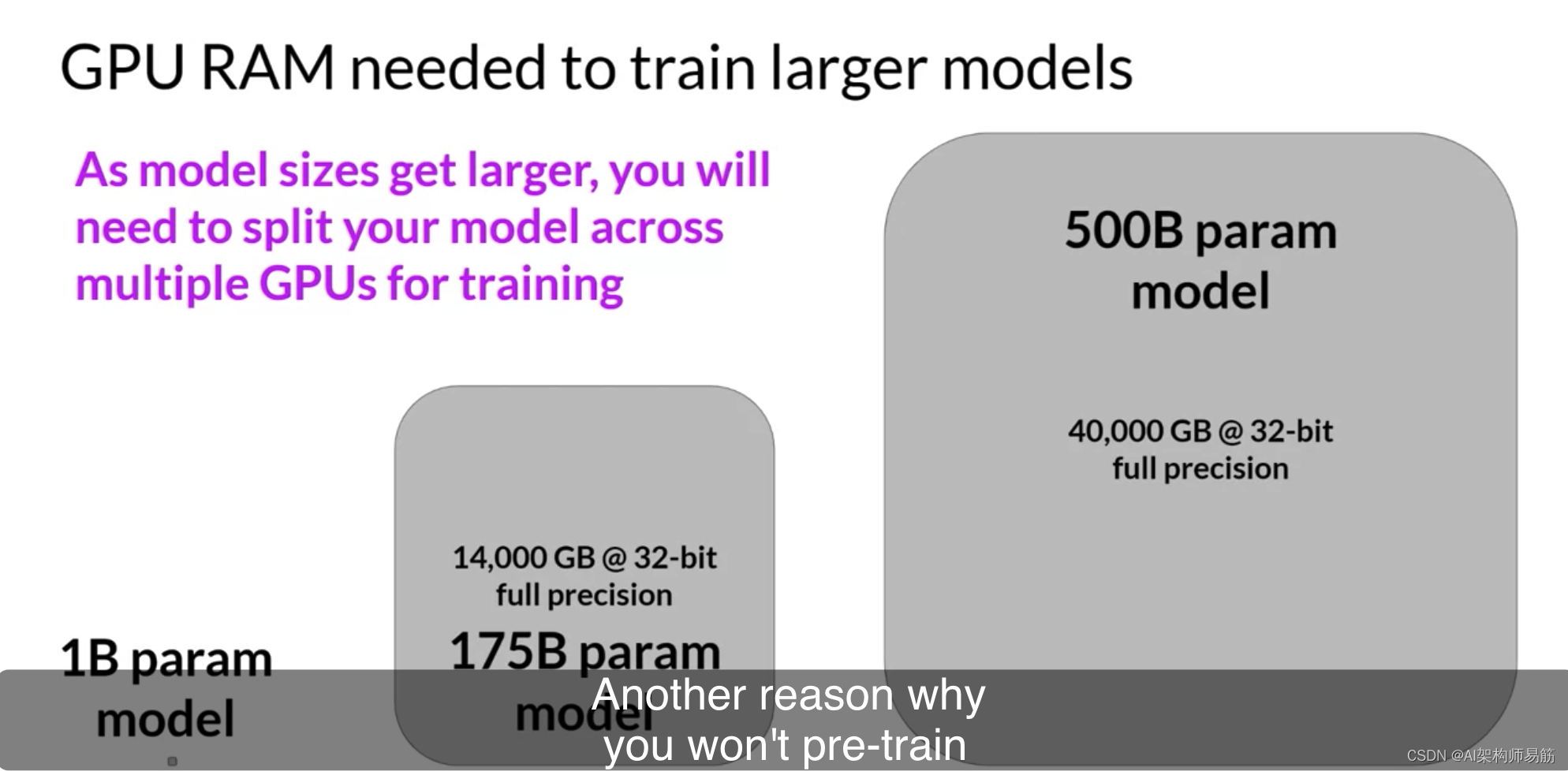

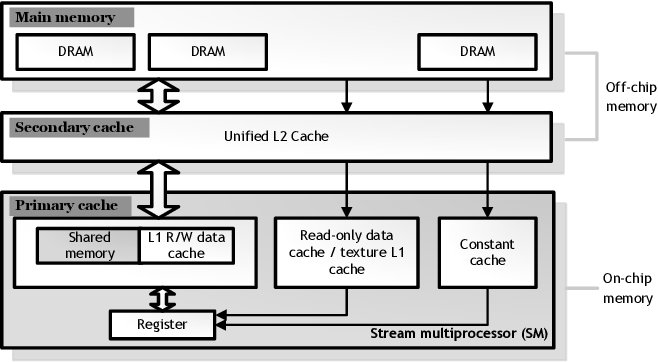

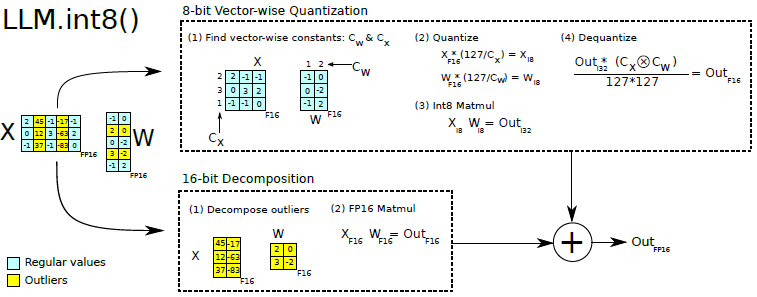

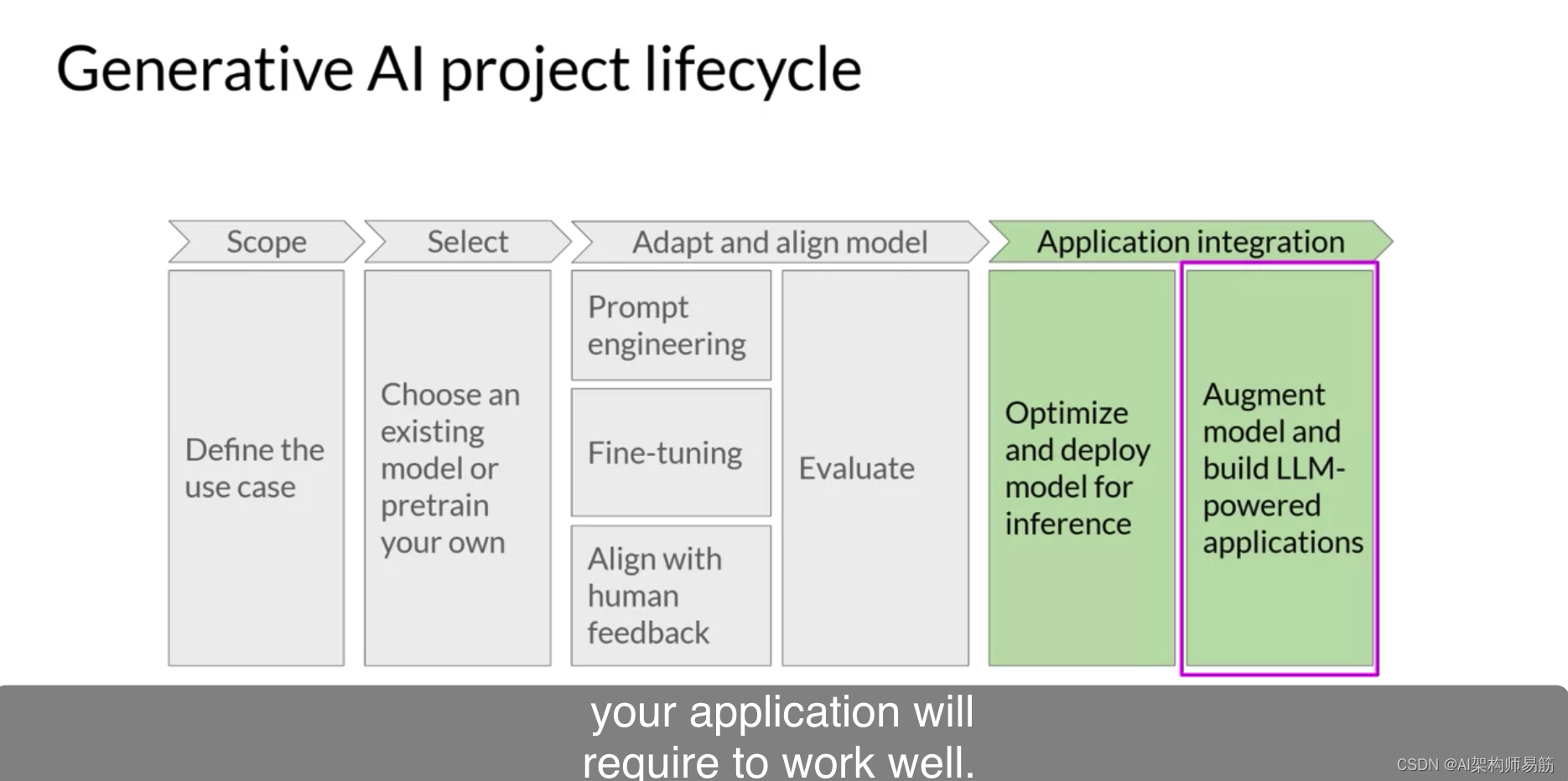

LLMs训练的算力优化Computational challenges of training LLMs

当您尝试训练大型语言模型时,您仍然经常遇到的最常见问题之一是内存不足。如果您曾尝试在Nvidia GPU上训练或甚至只是加载模型,那么这个错误消息可能看起来很熟悉。

CUDA,即Compute Unified Device Architecture的缩写,是为Nvid…

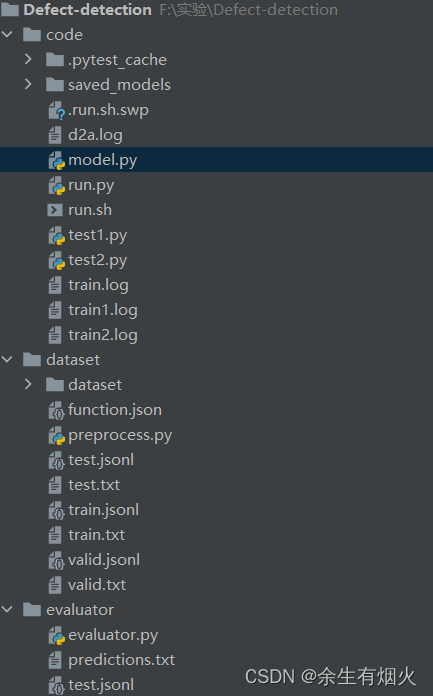

微调codebert、unixcoder、grapghcodebert完成漏洞检测代码

文件结构如下所示: mode.py # Copyright (c) Microsoft Corporation.

# Licensed under the MIT License.

import torch

import torch.nn as nn

import torch

from torch.autograd import Variable

import copy

from torch.nn import CrossEntropyLoss, MSELosscl…

简单实现Transformer(Pytorch)

相关文章: 加性注意(原理)加性注意(复现)乘性注意(原理)乘性注意(复现) 1 理论

该模型的特点:完全基于注意力机制,完全摒弃了递归和卷积。

它是一种模型架构,避免了递归,而是完全依赖于注意力机制来绘制输入和输出之…

LSTM已死,Transformer当立(LSTM is dead. Long Live Transformers! ):上

回想一下在Seq2seq模型中,如何使用Attention。这里简要回顾一下【1】介绍的方法2(并以此为基础展开对Transformer的讨论)。

下图中包含一个encoder(左)和一个decoder(右)。对于decoder来说,给定一个输入,得到输出,如何进一步得到context vector 呢?

我们需要根据和…

【Transformer从零开始代码实现 pytoch版】(五)总架构类的实现

Transformer总架构 在实现完输入部分、编码器、解码器和输出部分之后,就可以封装各个部件为一个完整的实体类了。

【Transformer从零开始代码实现 pytoch版】(一)输入部件:embeddingpositionalEncoding

【Transformer从零开始代…

【亲测】Swin-Transformer 自定义数据集图像分类

Swin-Transformer是当前热门的深度学习框架,适用于多种视觉任务,相关的原理,网上有很多资源,大家可自行查看,这里主要介绍其在图像分类方面的代码调试经验,方便各位快速上手实验。Swin-Transformer代码链接…

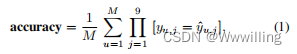

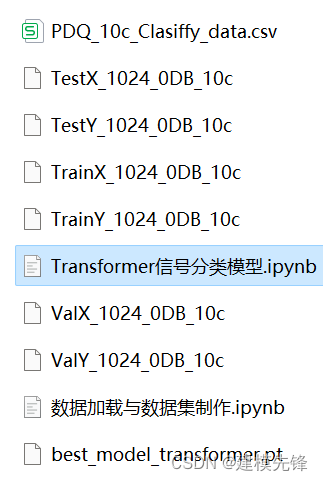

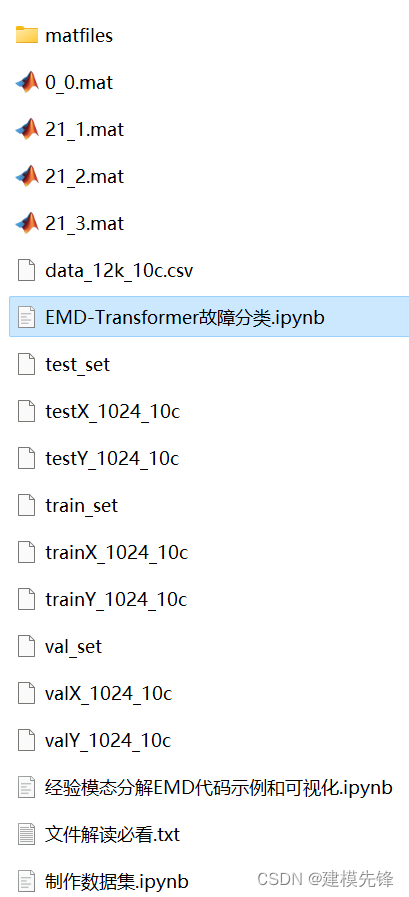

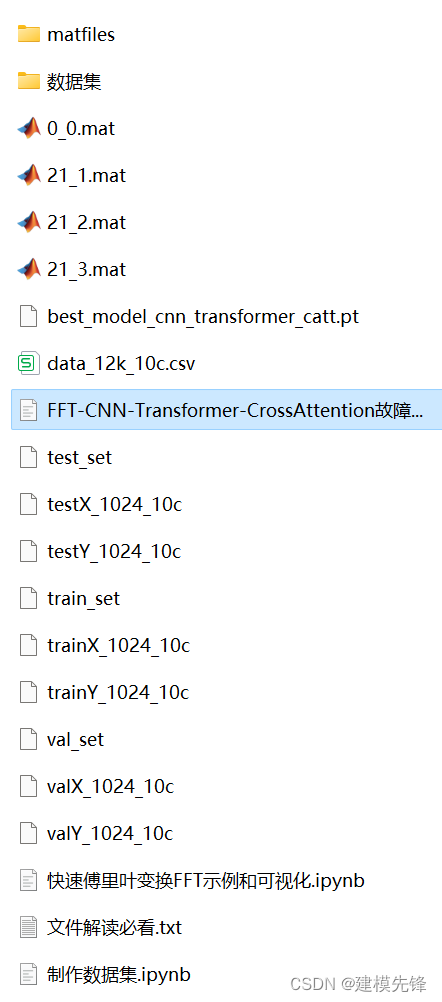

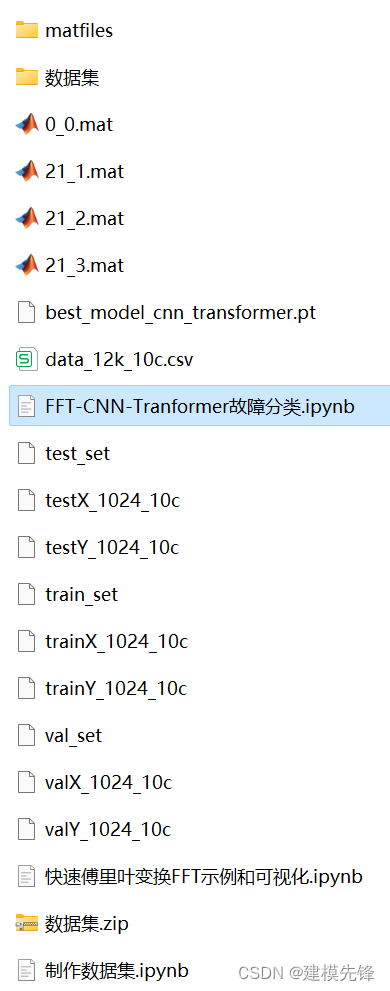

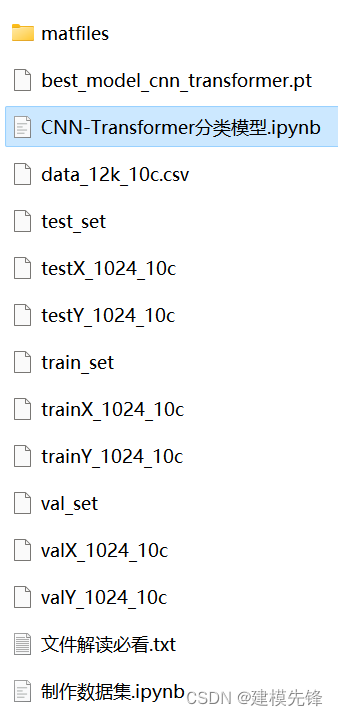

Pytorch-Transformer轴承故障一维信号分类(三)

目录

前言

1 数据集制作与加载

1.1 导入数据

第一步,导入十分类数据

第二步,读取MAT文件驱动端数据

第三步,制作数据集

第四步,制作训练集和标签

1.2 数据加载,训练数据、测试数据分组,数据分batch…

Transformer从菜鸟到新手(六)

引言

上篇文章介绍了如何在多GPU上分布式训练,本文介绍大模型常用的一种推理加速技术——KV缓存。

KV Cache

KV缓存(KV Cache)是在大模型推理中常用的一种技巧。我们知道在推理阶段,Transformer也只能像RNN一样逐个进行预测,也称为自回归。…

Transformer:Attention is All You Need

【Transformer论文逐段精读【论文精读】】 https://www.bilibili.com/video/BV1pu411o7BE/?share_sourcecopy_web&vd_source30e93e9c70e5a43ae75d42916063bc3b论文地址:[1706.03762] Attention Is All You Need (arxiv.org)Transformer第一个完全依靠自我注意来…

Transformer模型中前置Norm与后置Norm的区别

主要介绍原始Transformer和Vision Transformer中的Norm层不同位置的区别。 文章目录 前言 不同位置的作用 总结 前言

在讨论Transformer模型和Vision Transformer (ViT)模型中归一化层位置的不同,我们首先需要理解归一化层(Normalization)在…

深聊性能测试,从入门到放弃之:Locust性能自动化(七)HAR-files→locustfiles自动转换 :Transformer的使用

Transformer 使用1、引言2、安装及调用2.1 介绍2.2 安装2.3 使用2.3.1 保存HAR files2.3.2 命令行工具2.3.3 作为库被调用3、 创建HAR-file3.1 简介3.2 录制场景3.3 保存HAR3.4 特定场景3.4.1 制定权重3.4.2 分层方案3.4.3 忽略特定URL1、引言

在使用Locust时, 都会…

TRB 2024论文分享:基于生成对抗网络和Transformer模型的交通事件检测混合模型

TRB(Transportation Research Board,美国交通研究委员会,简称TRB)会议是交通研究领域知名度最高学术会议之一,近年来的参会人数已经超过了2万名,是参与人数和国家最多的学术盛会。TRB会议几乎涵盖了交通领域…

36k字从Attention解读Transformer及其在Vision中的应用(pytorch版)

文章目录 0.卷积操作1.注意力1.1 注意力概述(Attention)1.1.1 Encoder-Decoder1.1.2 查询、键和值1.1.3 注意力汇聚: Nadaraya-Watson 核回归1.2 注意力评分函数1.2.1 加性注意力1.2.2 缩放点积注意力1.3 自注意力(Self-Attention)1.3.1 自注意力的定义和计算1.3.2 自注意…

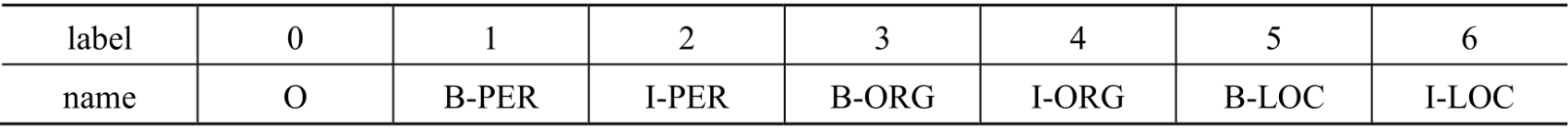

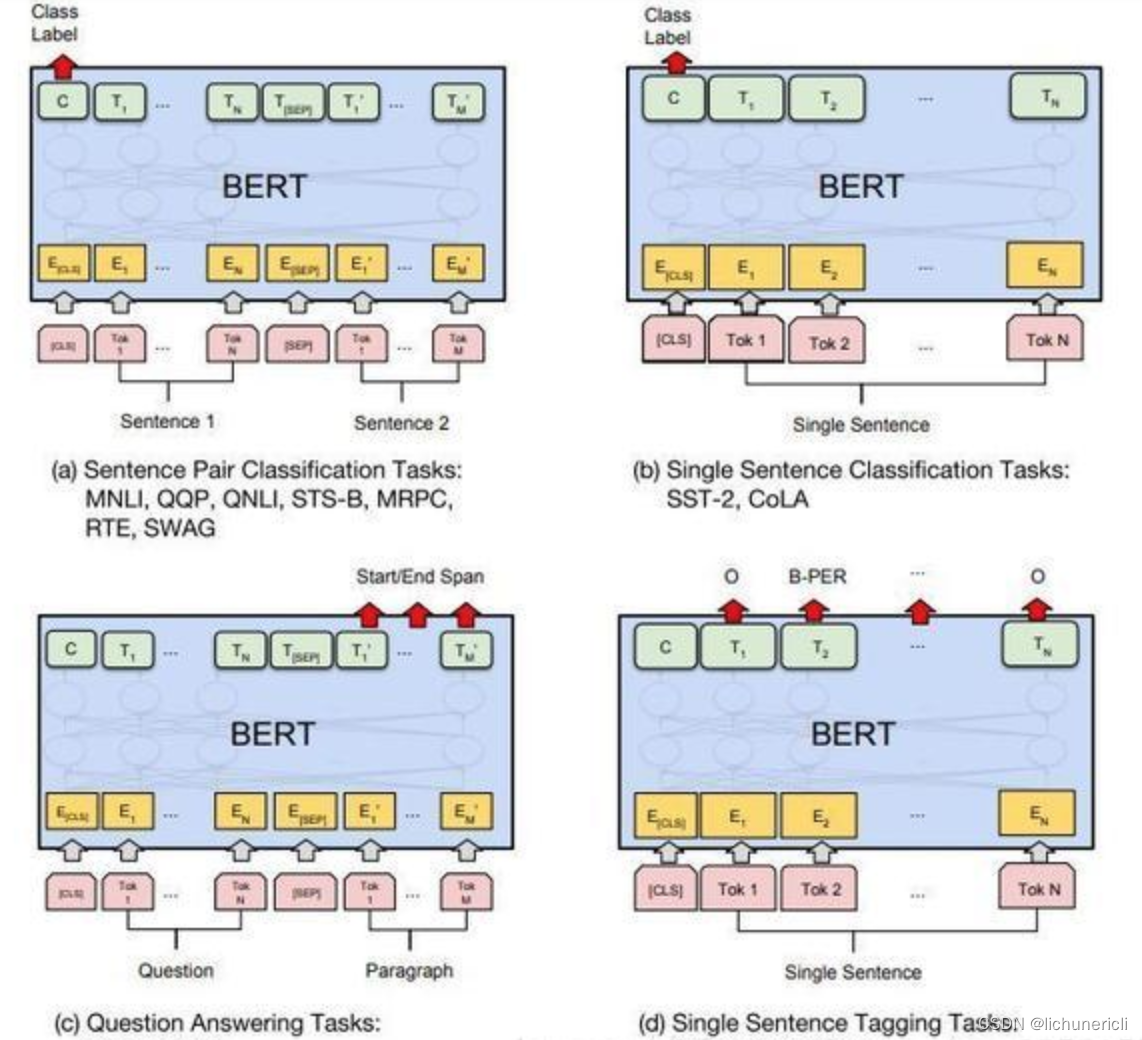

【HuggingFace文档学习】Bert的token分类与句分类

BERT特性:

BERT的嵌入是位置绝对(position absolute)的。BERT擅长于预测掩码token和NLU,但是不擅长下一文本生成。

1.BertForTokenClassification

一个用于token级分类的模型,可用于命名实体识别(NER)、部分语音标记…

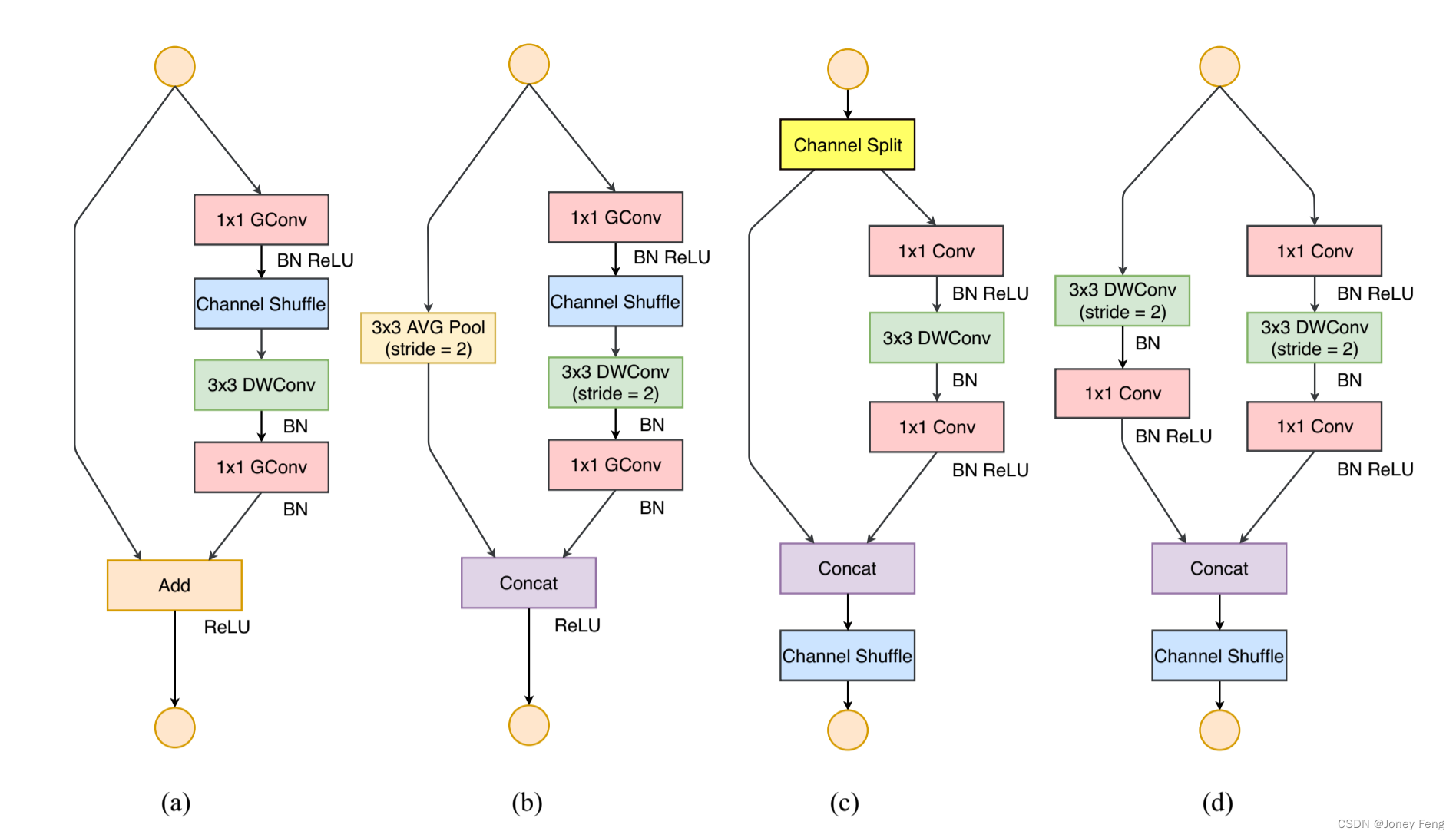

目标检测算法改进系列之Backbone替换为Swin Transformer

Swin Transformer简介

《Swin Transformer: Hierarchical Vision Transformer using Shifted Windows》作为2021 ICCV最佳论文,屠榜了各大CV任务,性能优于DeiT、ViT和EfficientNet等主干网络,已经替代经典的CNN架构,成为了计算机…

NLP | 简单学习一下NLP中的transformer的pytorch代码

经典transformer的学习文章转自微信公众号【机器学习炼丹术】作者:陈亦新(已授权)联系方式: 微信cyx645016617欢迎交流,共同进步 文章目录代码细讲transformerEmbeddingEncoder_MultipleLayersEncoder完整代码代码细讲

transform…

详细介绍如何微调 T5 Transformer 模型:用于构建 Stack Overflow 标签生成器的 Text2Text 传输转换器-含源码

在不断发展的自然语言处理 (NLP) 领域,T5(文本到文本传输转换器)模型已成为一种多功能模型。针对特定任务对该模型进行微调可以释放其全部潜力,使其成为人工智能爱好者和专业人士的一项关键技能。本文深入研究了T5 Transformer 模型的微调,特别是针对基于 Stack Overflow …

transformer 4 RuntimeError: Expected tensor for argument #1 ‘indices‘ to have scalar type Long

在使用transformer 4.0时,报错误提示RuntimeError: Expected tensor for argument #1 indices to have scalar type Long; but got torch.IntTensor instead (while checking arguments for embedding)。该问题主要时由于tensor的类型导致的,解决方法是在…

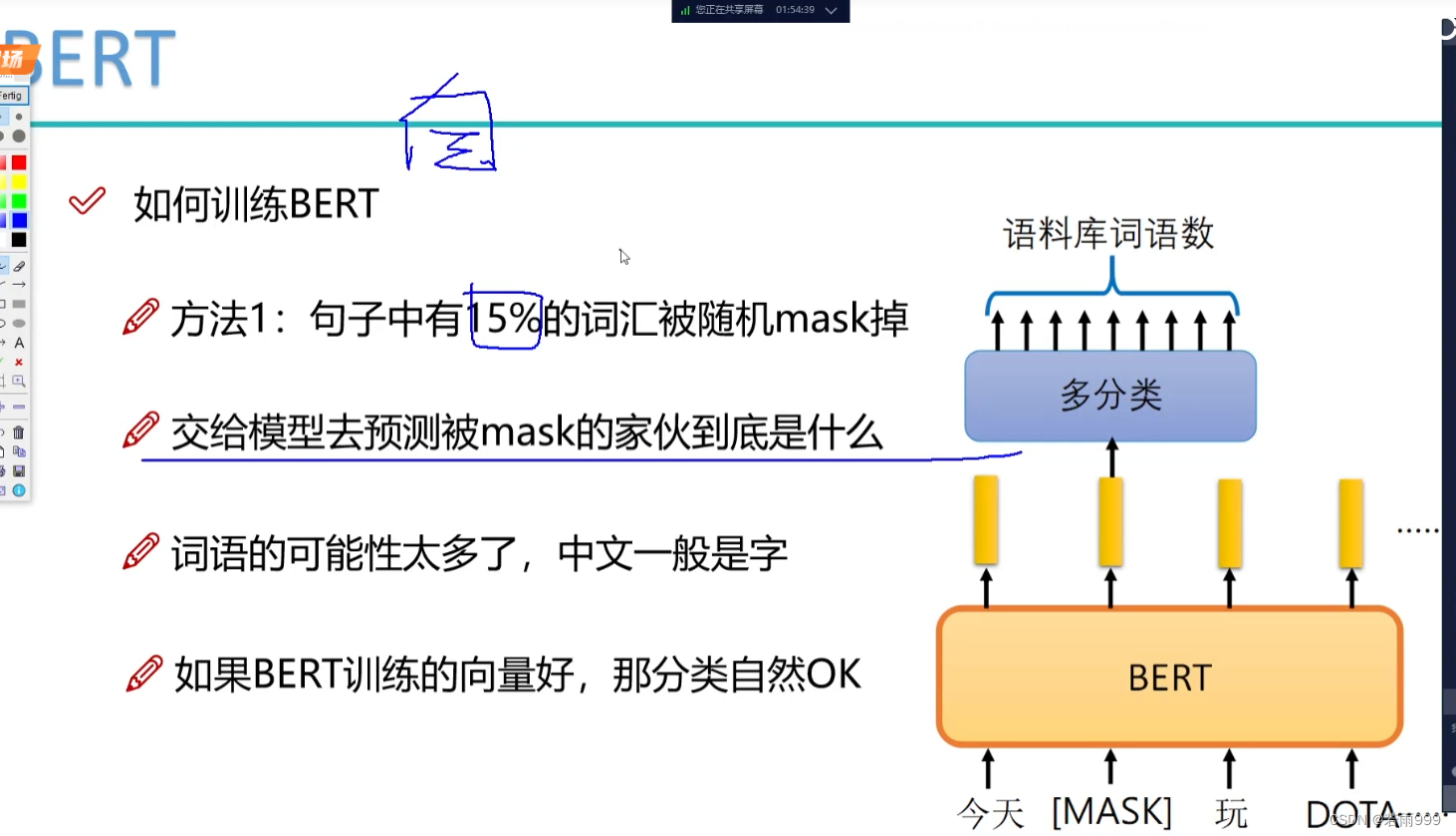

Self-attention Transformer

参考资料:

《机器学习》李宏毅

1 Self-attention

当模型输入为长度不定的向量序列时(如一段文字、一段语音、图模型),要求模型输出为等长的向量序列(序列标注)时,可以使用 Self-attention

S…

EMA和自动混合精度(AMP)

EMA:指数移动平均,用于优化权重更新

参考自:https://blog.csdn.net/Newt_Scamander/article/details/122268929

AMP:自动混合精度,用于加快模型训练,其思想在于使得模型处理数据的时候,自动控制数据在tor…

pytorch图片分割原理

自从transformer应用到cv领域以后,对图片的分割需求便越加重了,但是图像分割说起来容易,实际操作起来还是有很多地方不懂(主要还是code能力太弱)。

我们知道,对张量的处理一般又两种,一种是vie…

UNETR:用于三维医学图像分割的Transformer

论文链接:https://arxiv.org/abs/2103.10504

代码链接: https://monai.io/research/unetr

机构:Vanderbilt University, NVIDIA 最近琢磨不出来怎么把3d体数据和文本在cnn中融合,因为确实存在在2d里面用的transformer用在3d里面…

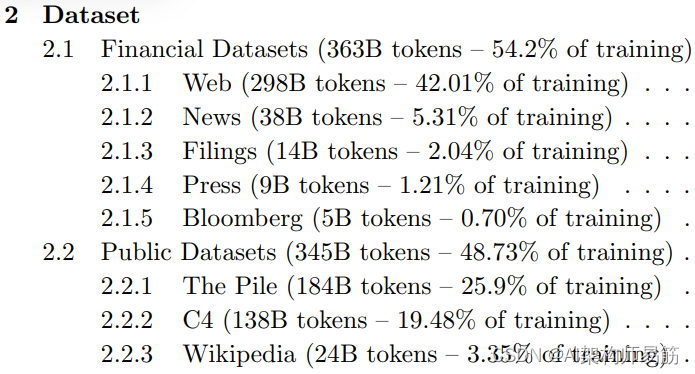

LLMs参考资料第一周以及BloombergGPT特定领域的训练 Domain-specific training: BloombergGPT

1. 第1周资源

以下是本周视频中讨论的研究论文的链接。您不需要理解这些论文中讨论的所有技术细节 - 您已经看到了您需要回答讲座视频中的测验的最重要的要点。

然而,如果您想更仔细地查看原始研究,您可以通过以下链接阅读这些论文和文章。

1.1 Trans…

DETR纯代码分享(六)detr.py

一、导入模块

"""

DETR model and criterion classes.

"""

import torch

import torch.nn.functional as F

from torch import nnfrom util import box_ops

from util.misc import (NestedTensor, nested_tensor_from_tensor_list,accuracy, ge…

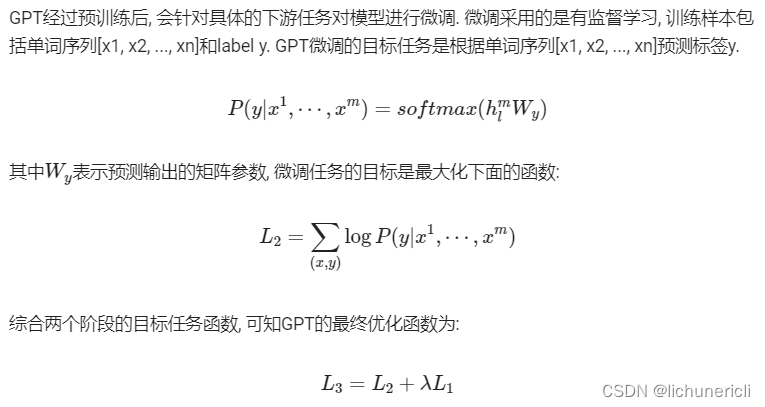

自然语言处理:Transformer与GPT

Transformer和GPT(Generative Pre-trained Transformer)是深度学习和自然语言处理(NLP)领域的两个重要概念,它们之间存在密切的关系但也有明显的不同。

1 基本概念

1.1 Transformer基本概念

Transformer是一种深度学…

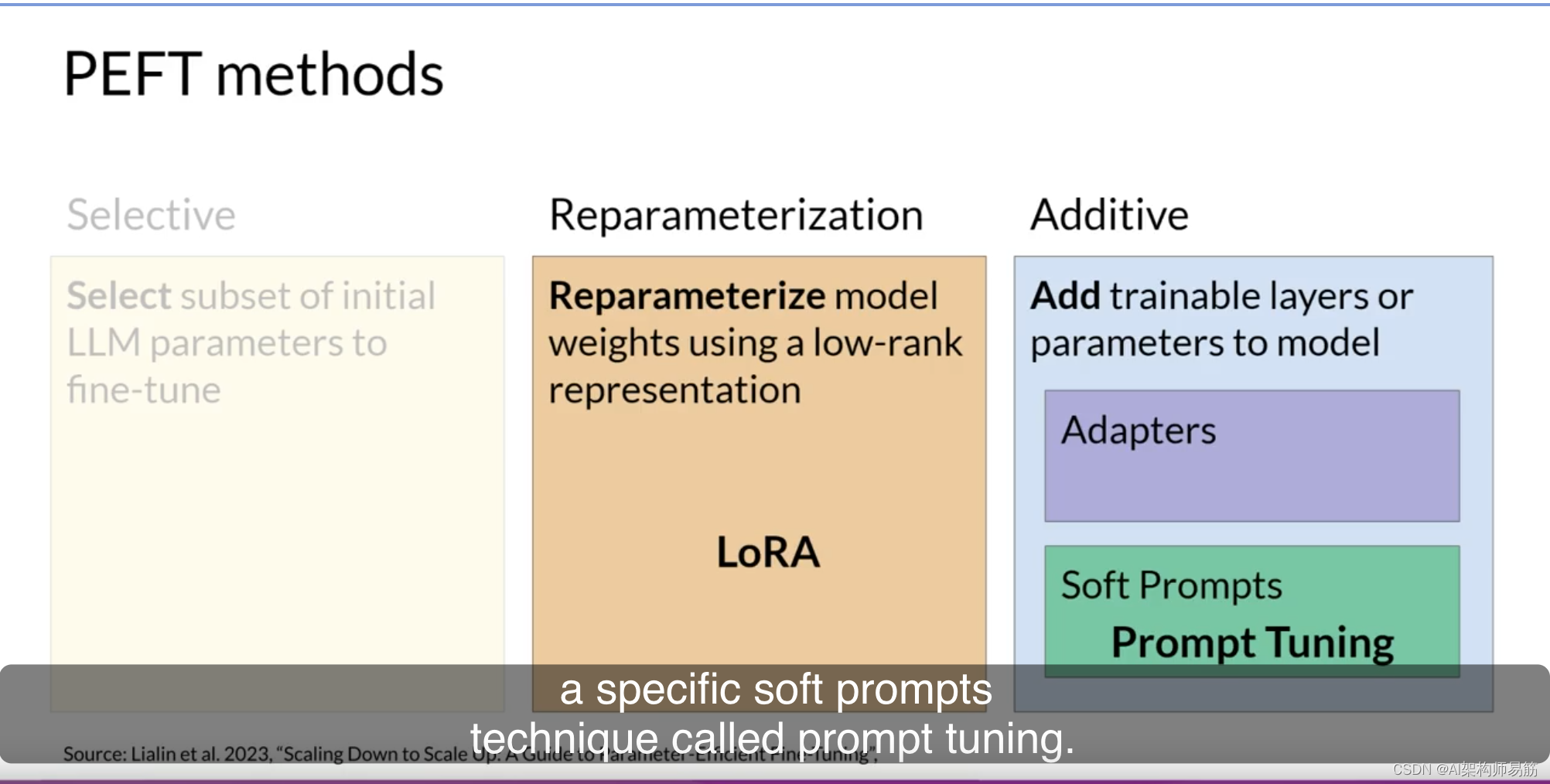

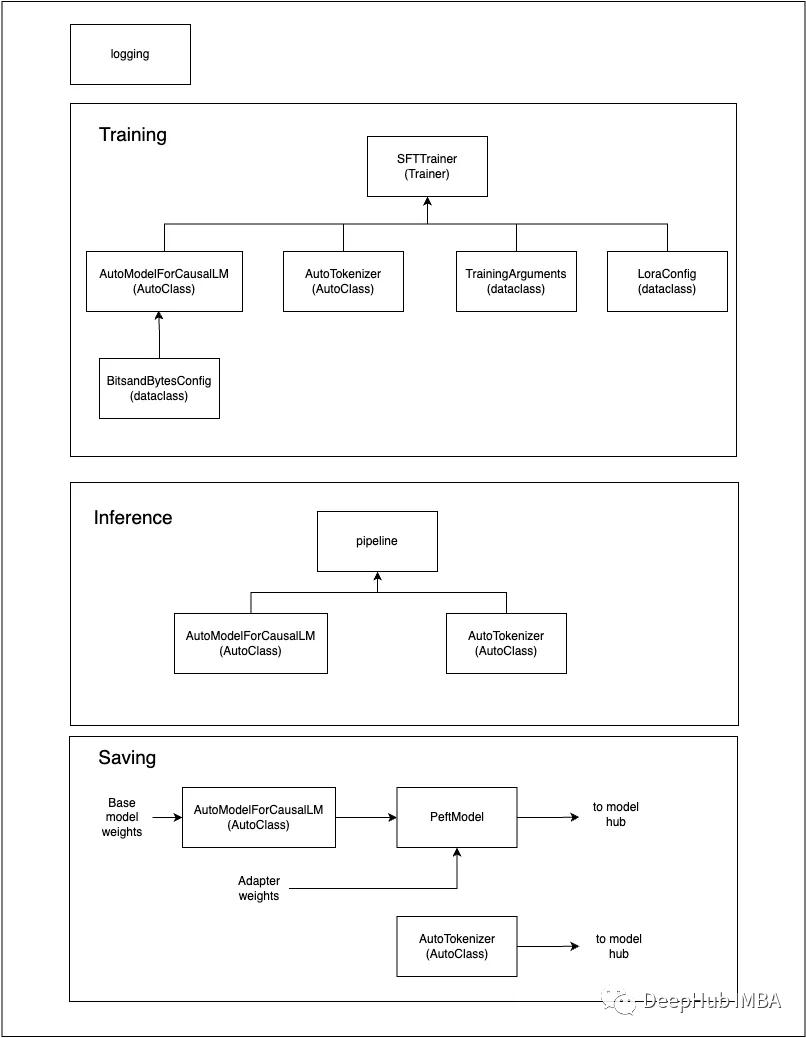

LLMs参数高效微调(PEFT) Parameter efficient fine-tuning (PEFT)

正如你在课程的第一周所看到的,训练LLMs需要大量的计算资源。完整的微调不仅需要内存来存储模型,还需要在训练过程中使用的各种其他参数。

即使你的计算机可以容纳模型权重,最大模型的权重现在已经达到几百GB,你还必须能够为优化…

图像分割(三)—— Swin-Unet: Unet-like Pure Transformer for Medical Image Segmentation

swin-unetsAbstractIntroductionMethod3.1 Architecture overview3.2 Swin Transformer blockAbstract

在过去的几年中,卷积神经网络(CNNs)在医学图像分析中取得了里程碑。特别是基于u型结构和跳跃连接的深度神经网络在各种医学图像任务中得到了广泛的应用。然而&a…

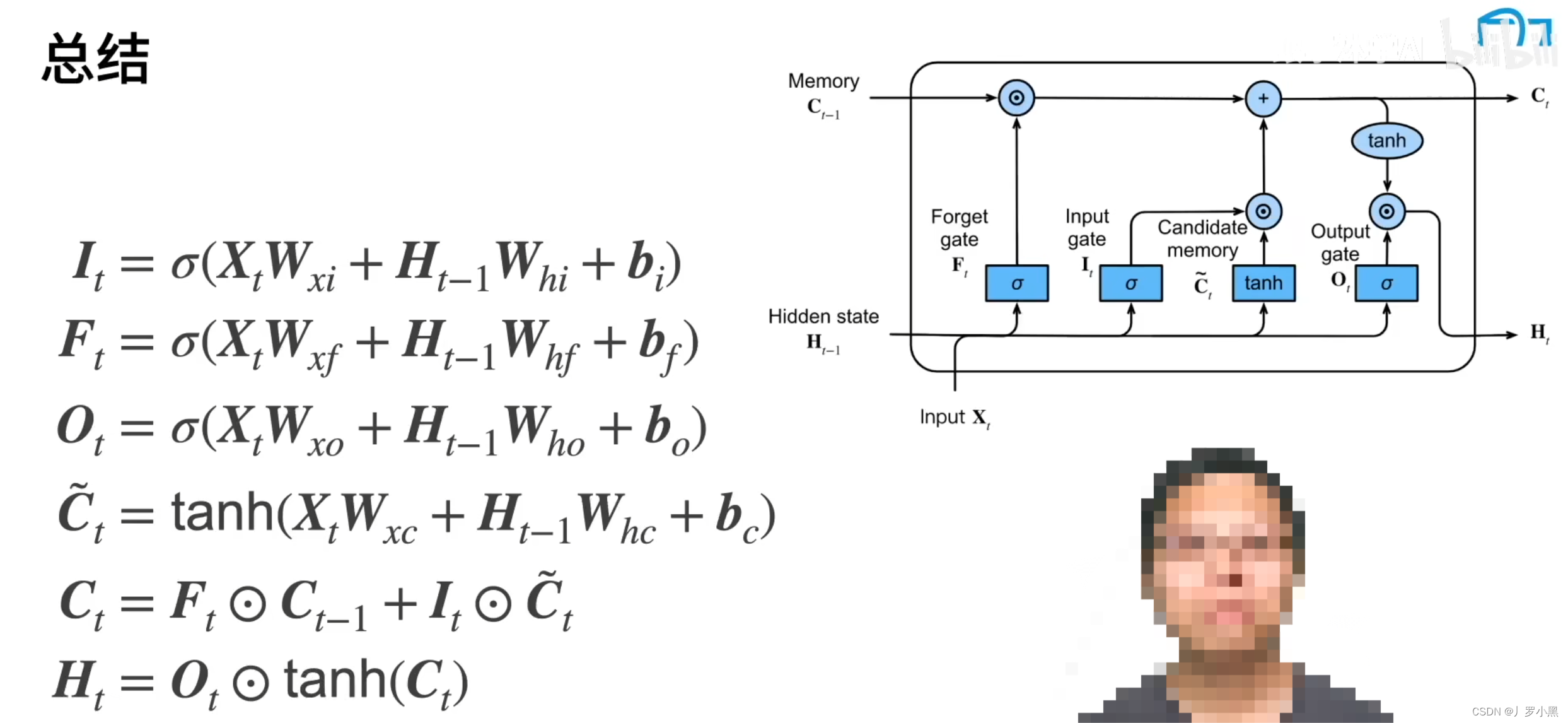

第三十九周:文献阅读+Transformer

目录

摘要

Abstract

文献阅读:CNN与LSTM在水质预测中的应用

现有问题

提出方法

相关模型

CNN

LSTM

CNN-LSTM神经网络模型

模型框架

CNN-LSTM神经网络

研究实验

数据集

模型评估指标

数据预处理

实验设计与结果

研究贡献

Transformer

Encoder-Dec…

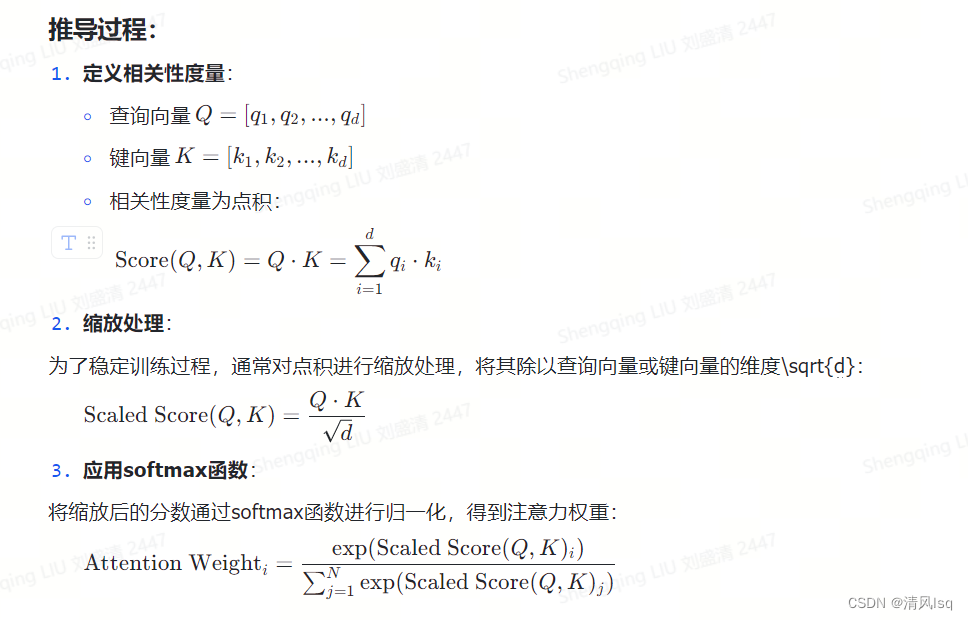

神经网络 || 注意力机制的算法图示和推导

文章目录1 注意力机制是什么?2 多输入怎么处理?3 self-attention的图示4 自己整理一下self-attention的算法过程1 注意力机制是什么?

注意力模型,最近几年在深度学习各个领域都有应用。注意力机制是深度学习常用的一个小技巧&…

【深度学习 | Transformer】释放注意力的力量:探索深度学习中的 变形金刚,一文带你读通各个模块 —— Positional Encoding(一)

🤵♂️ 个人主页: AI_magician 📡主页地址: 作者简介:CSDN内容合伙人,全栈领域优质创作者。 👨💻景愿:旨在于能和更多的热爱计算机的伙伴一起成长!!&…

Retentive Network: A Successor to Transformer for Large Language Models

论文链接:

https://arxiv.org/pdf/2307.08621.pdf

代码链接:

https://github.com/microsoft/unilm/tree/master/retnet

引言

transformer的问题就是计算成本太高 RetNet使“不可能三角形”成为可能,同时实现了训练并行性,良好…

Transformer 位置编码

✅作者简介:人工智能专业本科在读,喜欢计算机与编程,写博客记录自己的学习历程。 🍎个人主页:小嗷犬的个人主页 🍊个人网站:小嗷犬的技术小站 🥭个人信条:为天地立心&…

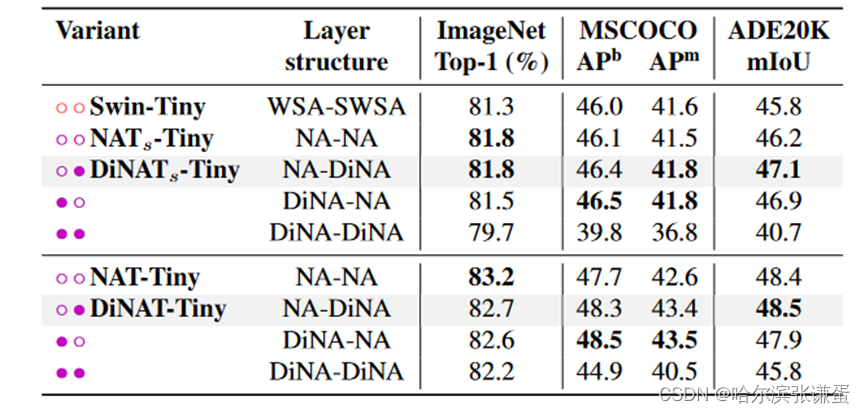

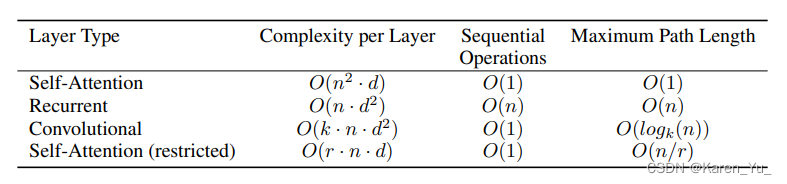

《动手学深度学习 Pytorch版》 10.7 Transformer

自注意力同时具有并行计算和最短的最大路径长度这两个优势。Transformer 模型完全基于注意力机制,没有任何卷积层或循环神经网络层。尽管 Transformer 最初是应用于在文本数据上的序列到序列学习,但现在已经推广到各种现代的深度学习中,例如语…

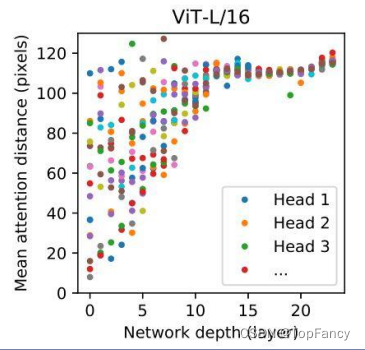

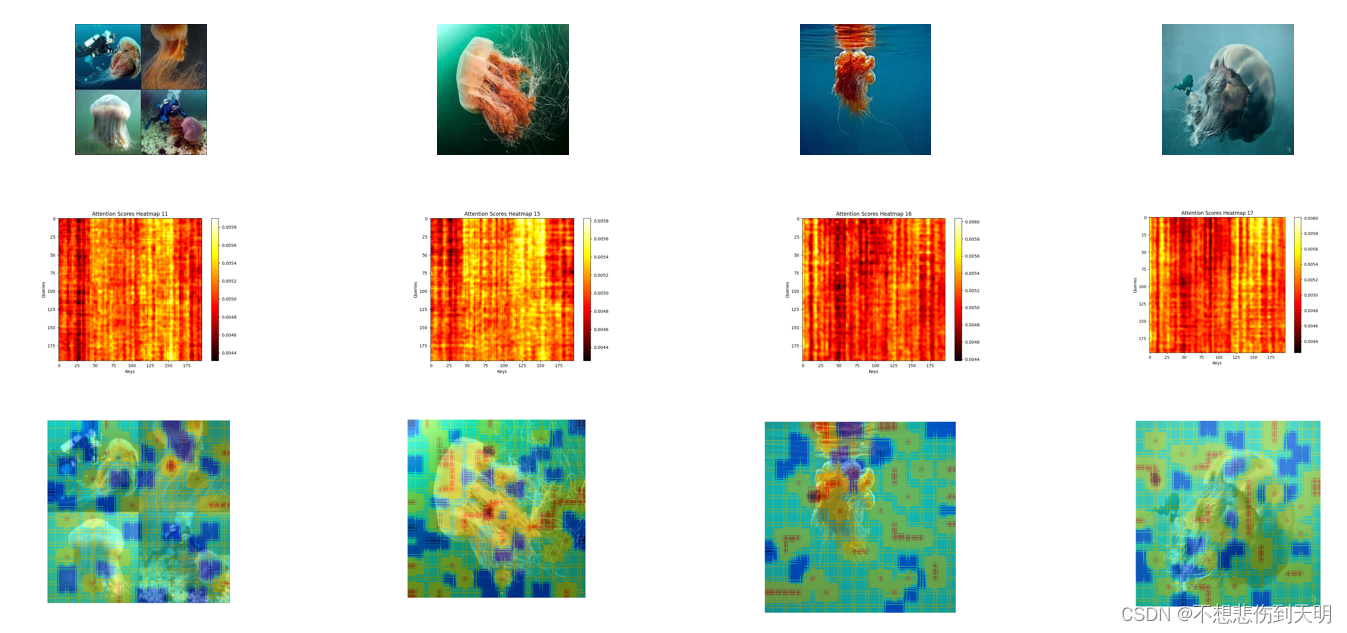

机器学习笔记 - 在 Vision Transformer 中可视化注意力

2022 年,视觉变换器(ViT) 成为卷积神经网络(CNN) 的有力竞争对手,后者现已成为计算机视觉领域的最先进技术,并广泛应用于许多图像识别应用中。在计算效率和准确性方面,ViT 模型超过了当前最先进的 (CNN) 几乎四倍。

一、视觉转换器 (ViT) 如何工作? 视觉转换器模型的性能…

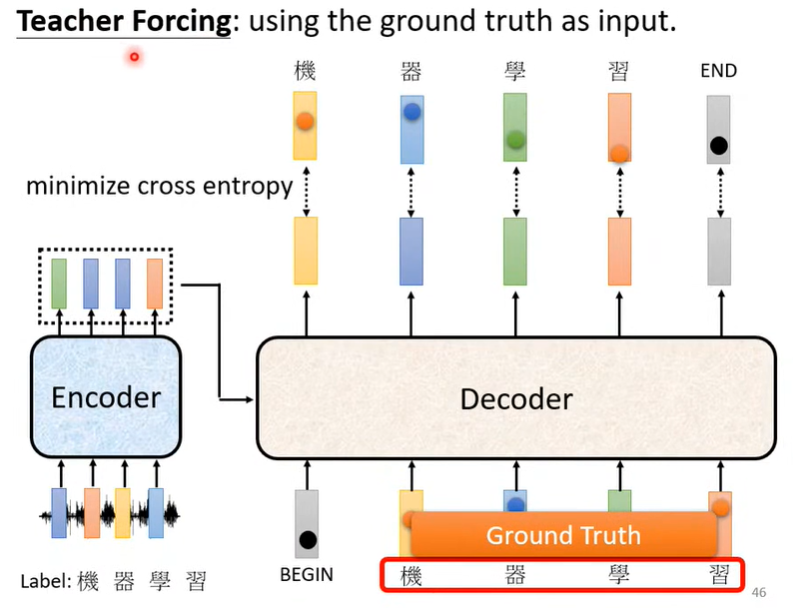

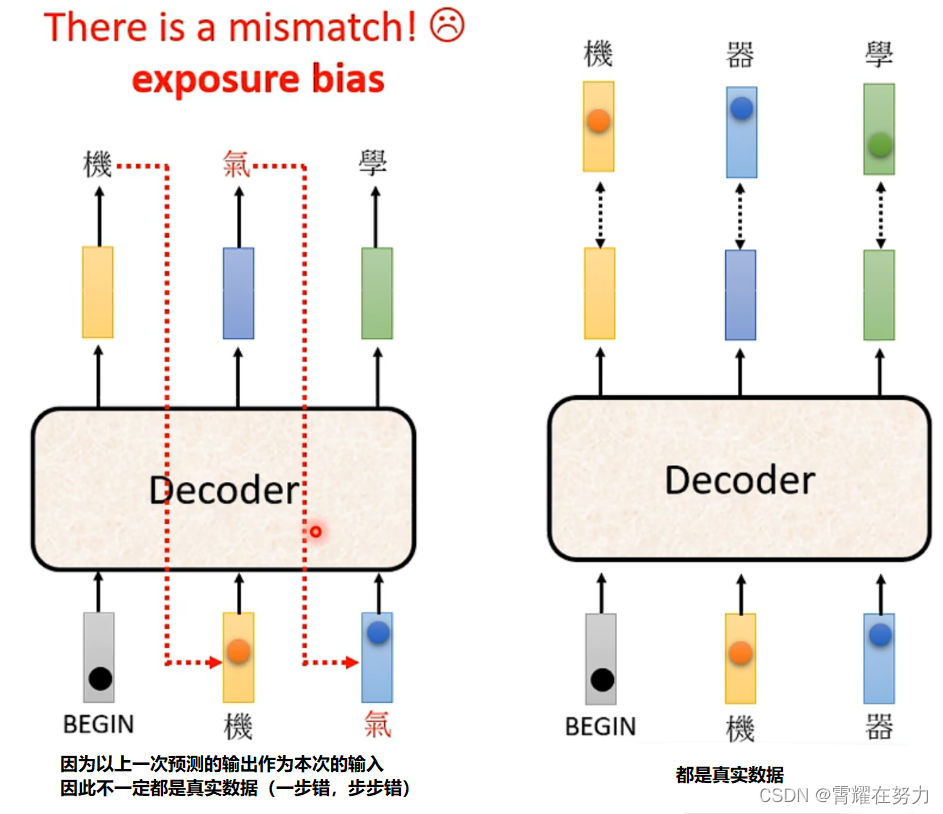

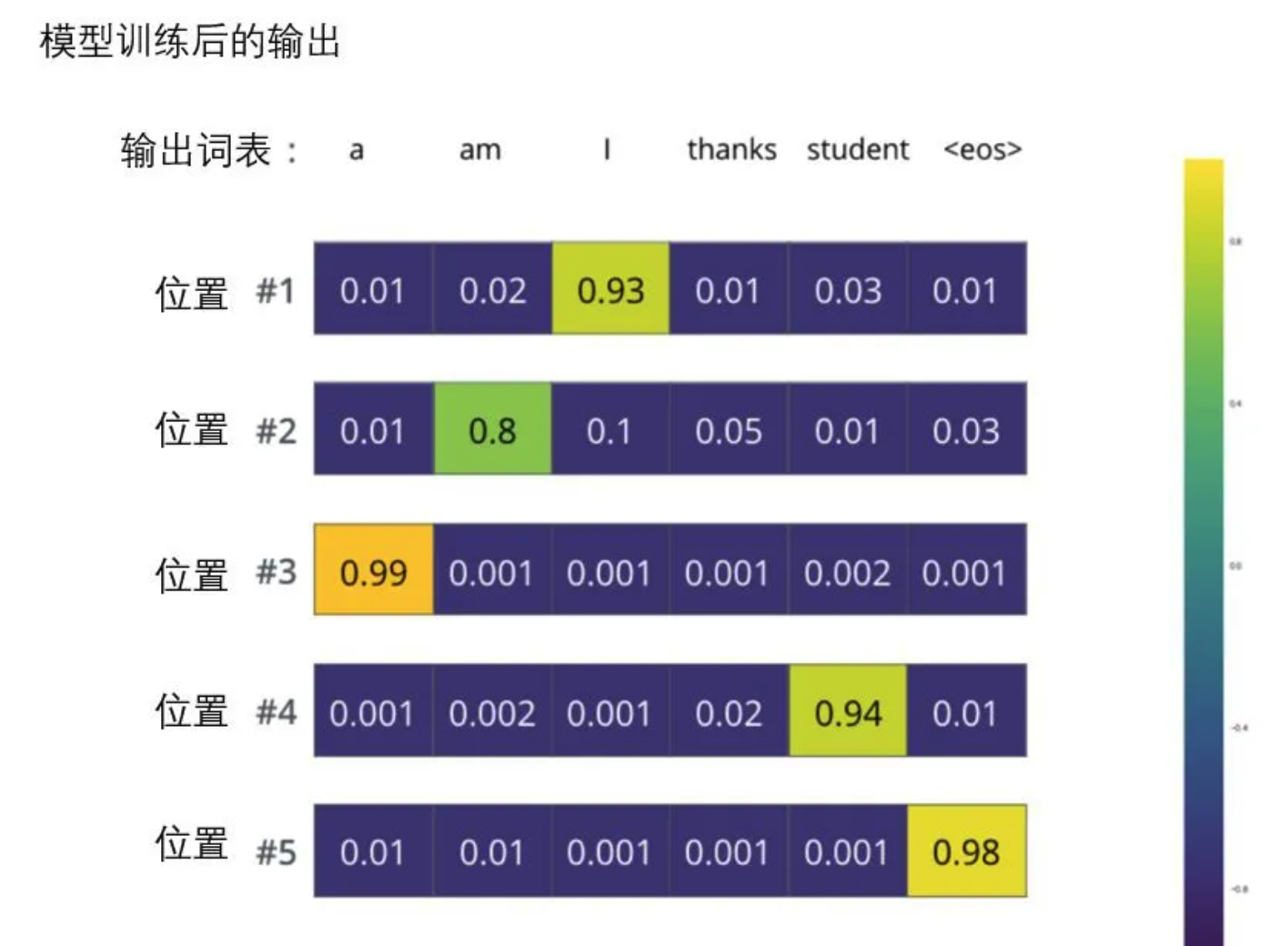

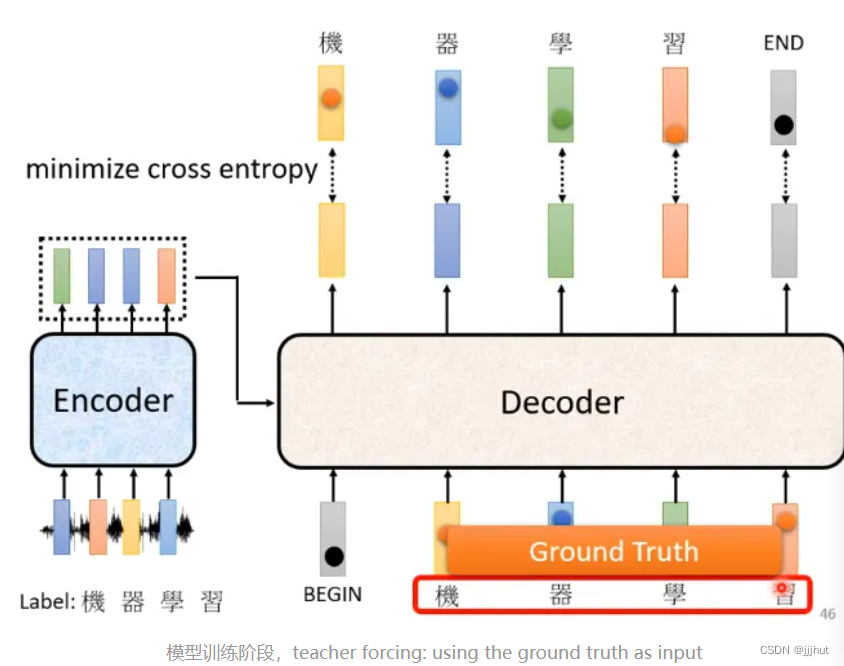

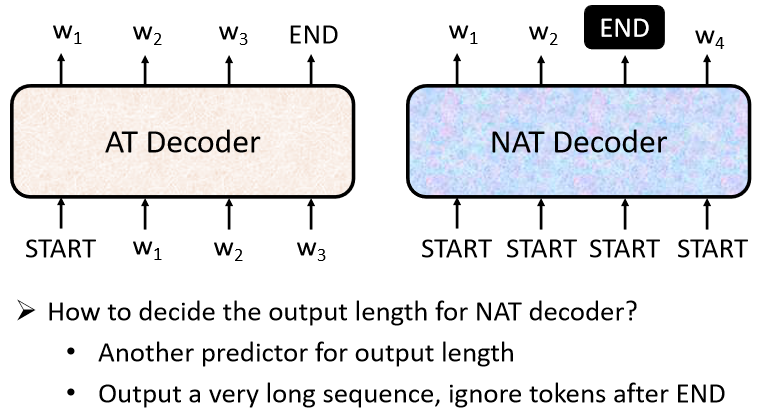

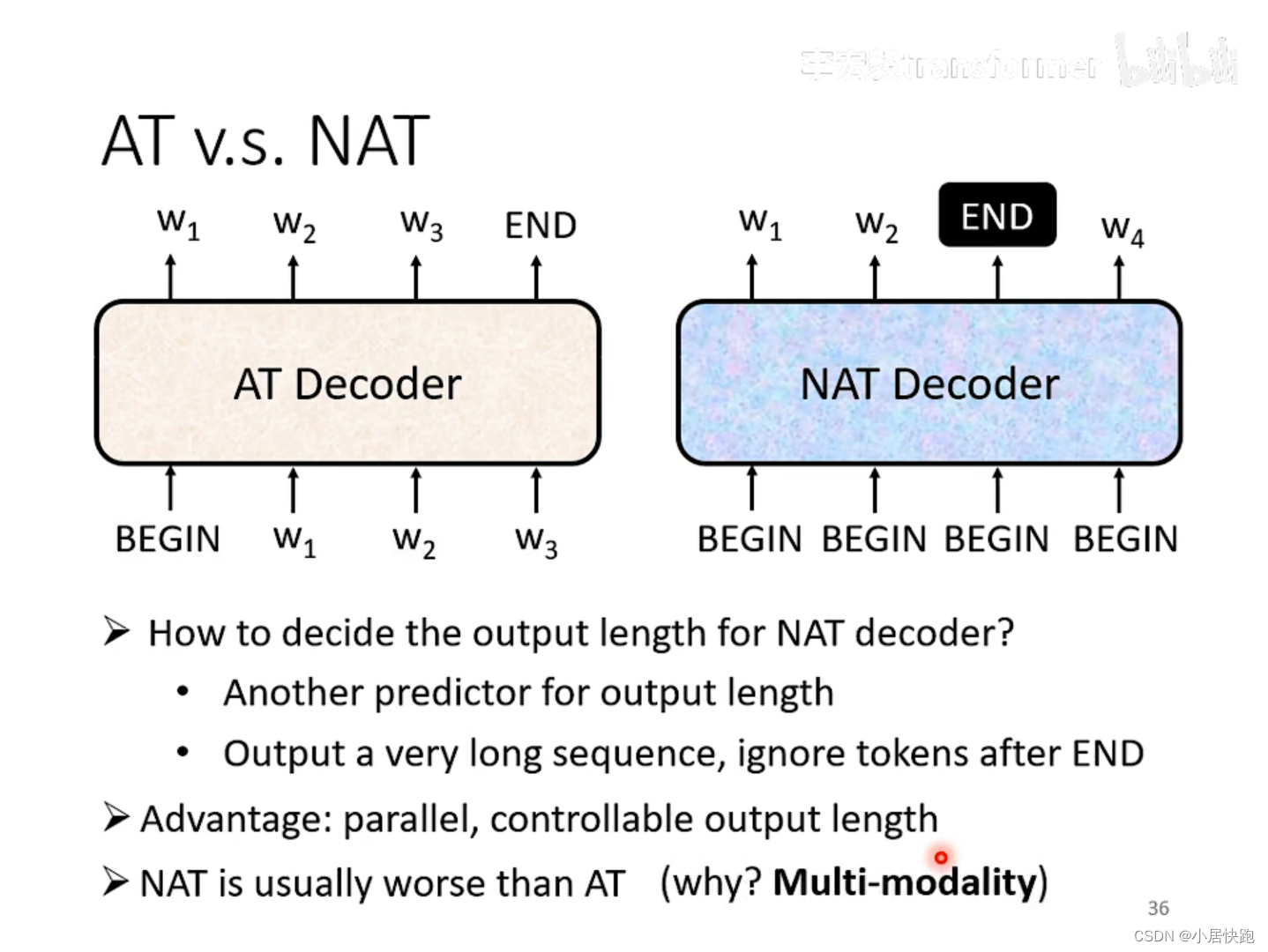

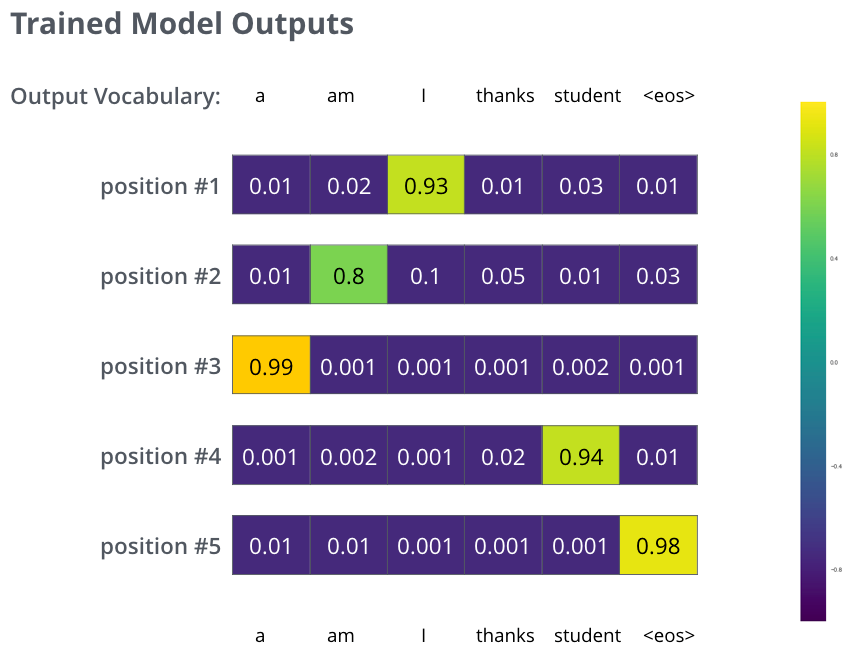

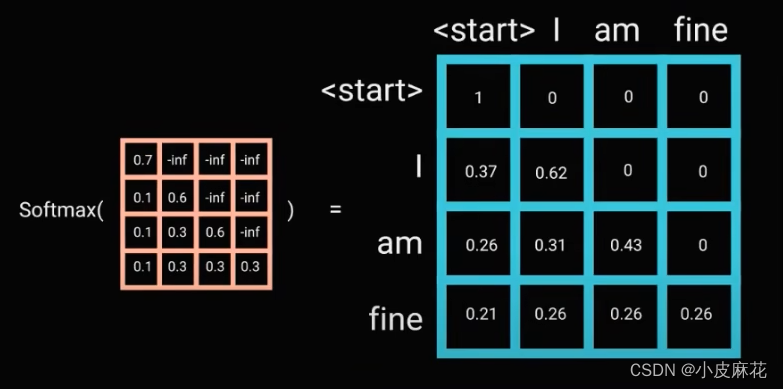

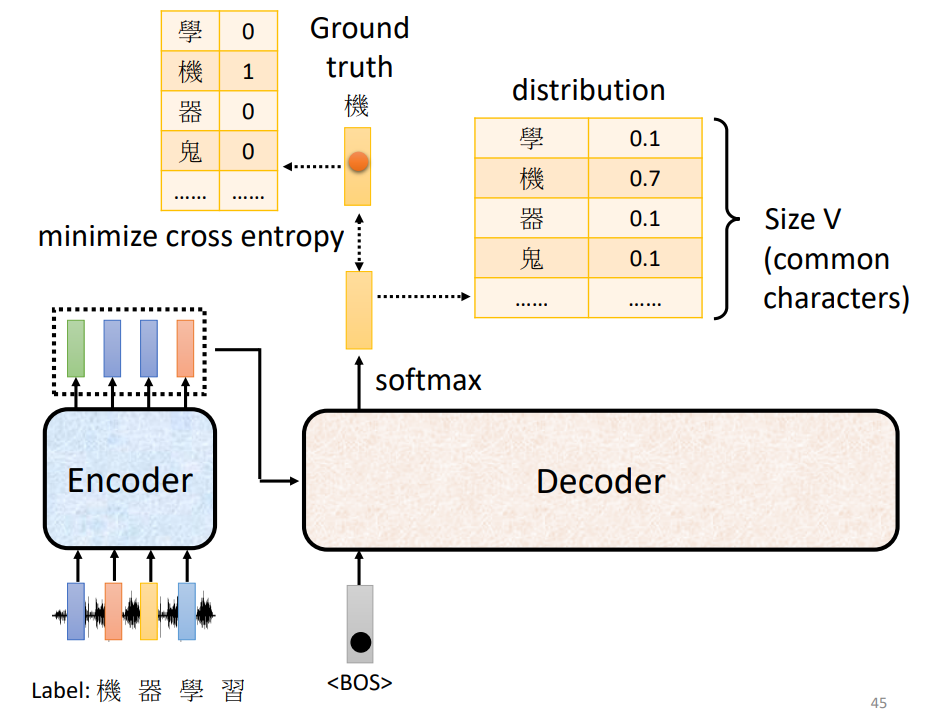

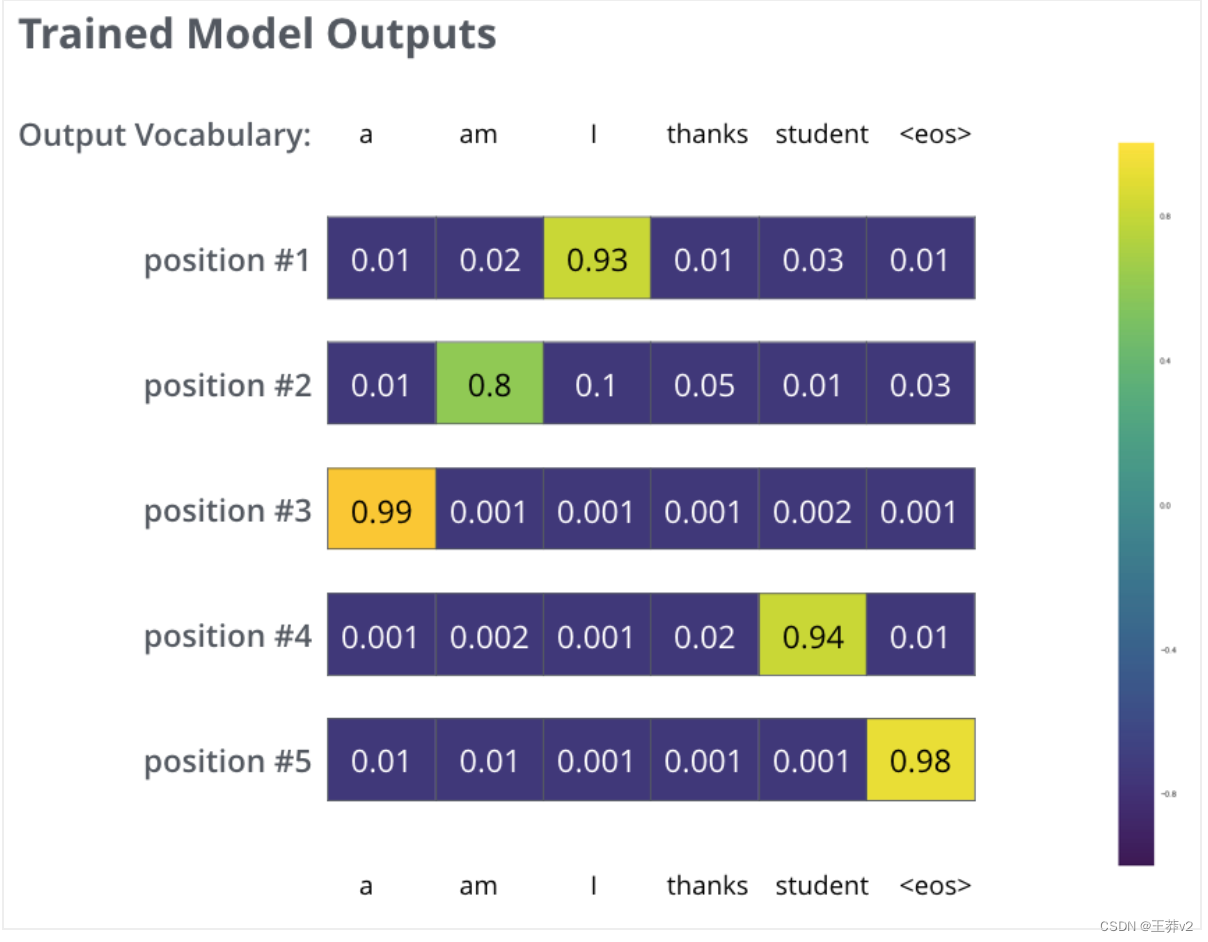

Decoder如何工作、Transformer如何训练、以及exposure bias问题

一、Decoder工作部分(以一个例子介绍工作流程,以及Decoder输出结果是什么样的)Decoder是如何工作的(这也是Decoder与Encoder之间的连接)?Decoder的工作主要涉及到交互注意力,所谓交互注意力是指…

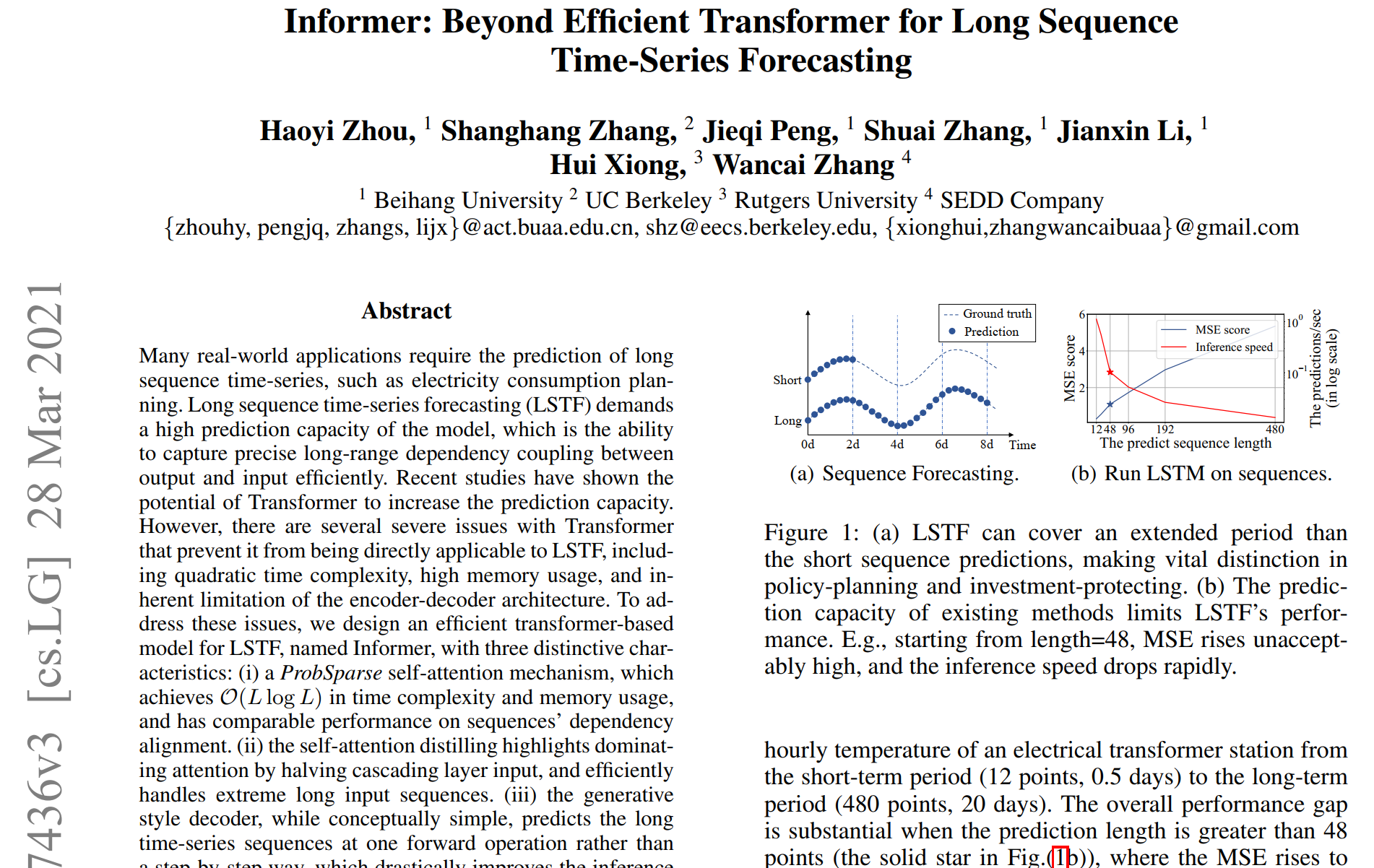

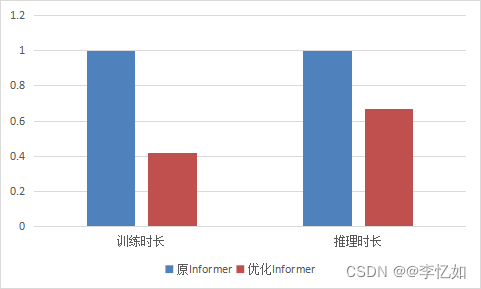

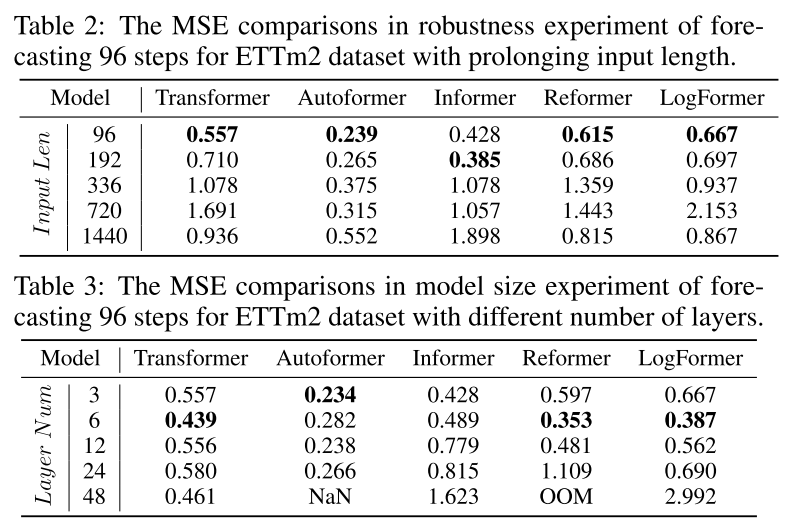

时间序列预测模型实战案例(八)(Informer)BestPaper论文模型Informer代码实战讲解

论文地址->Informer论文地址PDF点击即可阅读

代码地址-> 论文官方代码地址点击即可跳转下载GIthub链接 本文介绍

本篇博客带大家看的是Informer模型进行时间序列预测的实战案例,它是在2019年被提出并在ICLR 2020上被评为Best Paper,可以说Inform…

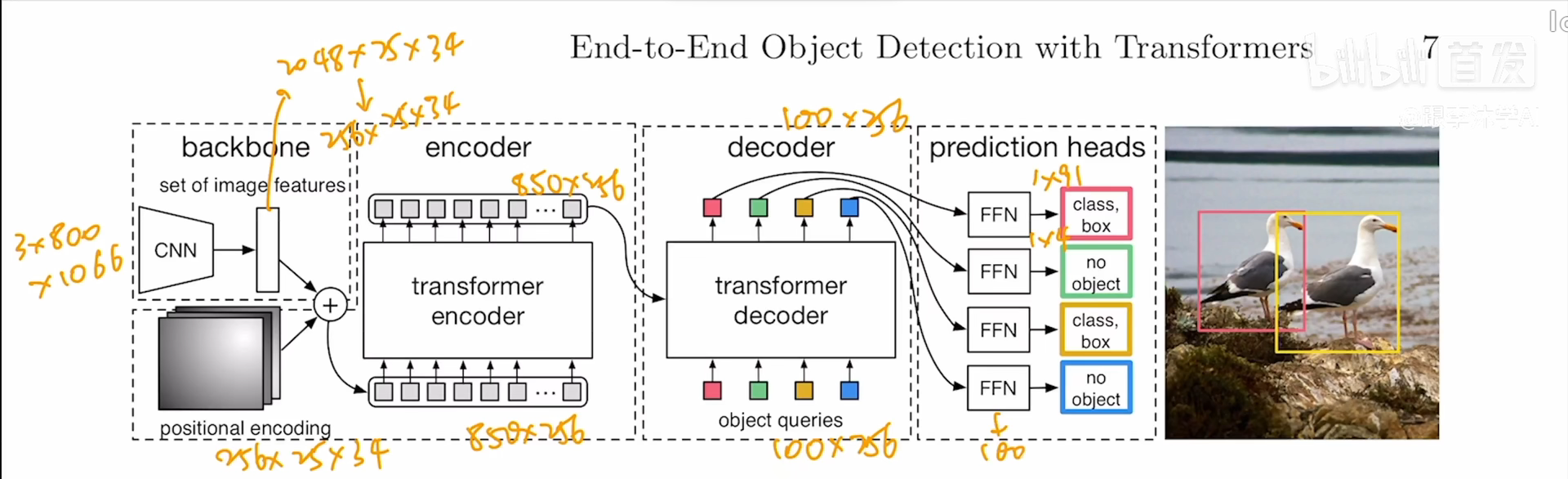

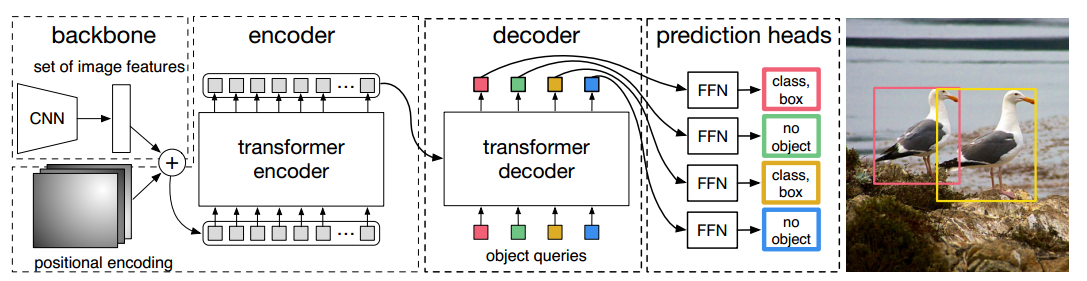

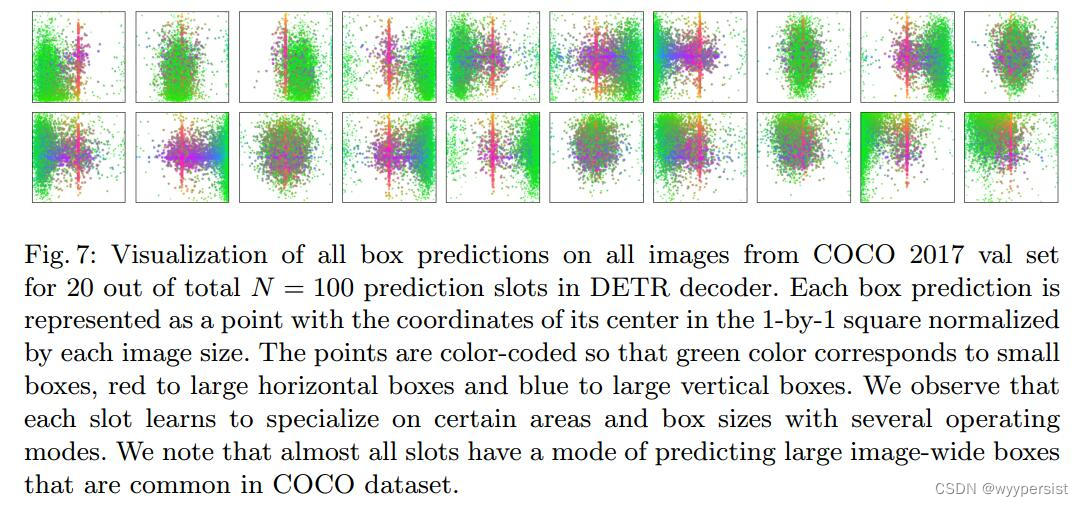

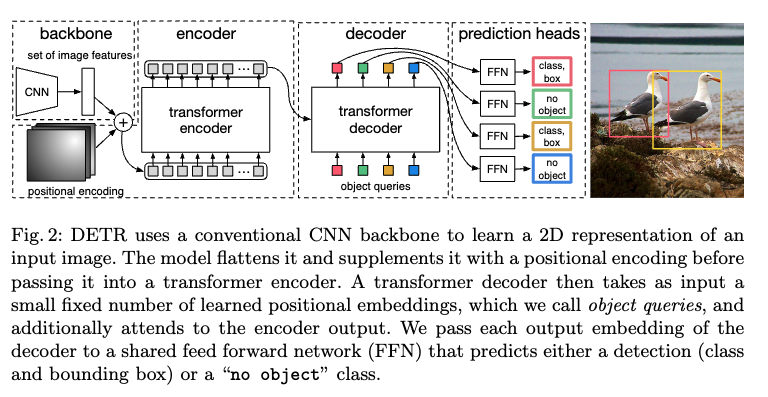

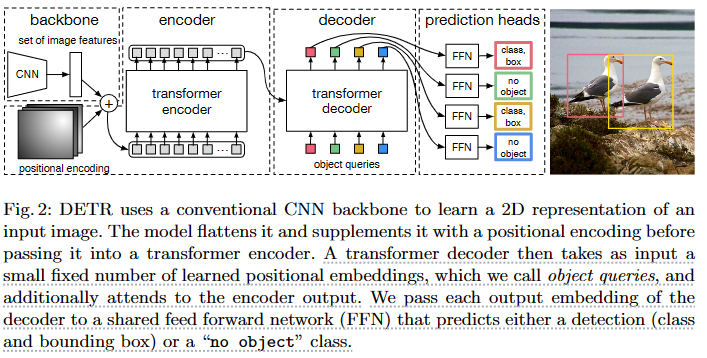

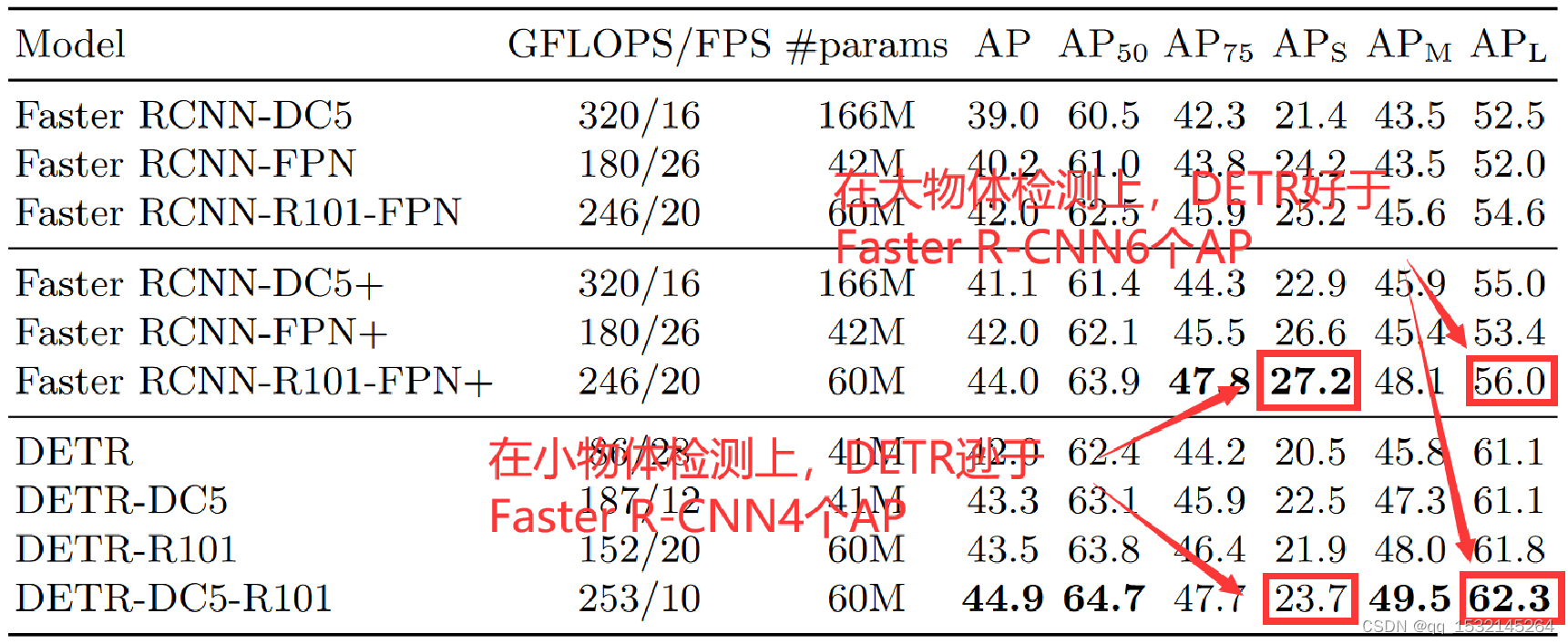

目标检测DETR:End-to-End Object Detection with Transformers

NMS

对一个目标生成了多个检测窗口,但是事实上这些窗口中大部分内容都是重复的,找到目标检测最优的窗口

选取多个检测窗口中分数最高的窗口,剔除掉其他同类型的窗口

anchor generator

首先在该点生成scale512, aspect ratio{1:2ÿ…

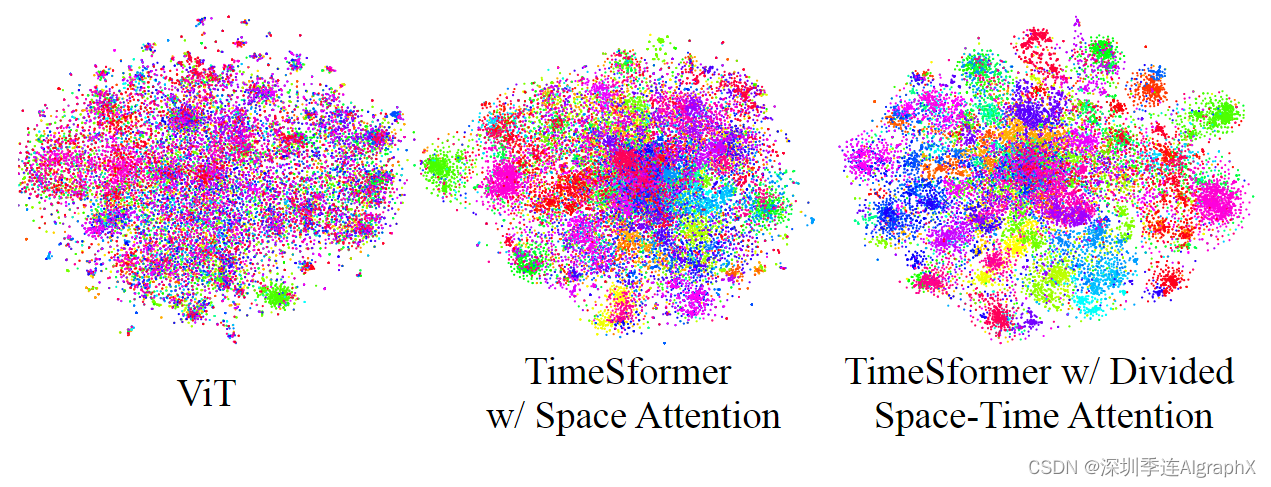

【Code Reading】Transformer in vision and video

文章目录 1. vit2. Swin-t3. vit_3D4. TimeSformer First🚀🚀5. vivit 1. vit

详细解释 在论文的Table1中有给出三个模型(Base/ Large/ Huge)的参数,在源码中除了有Patch Size为16x16的外还有32x32的。其中的Layers就…

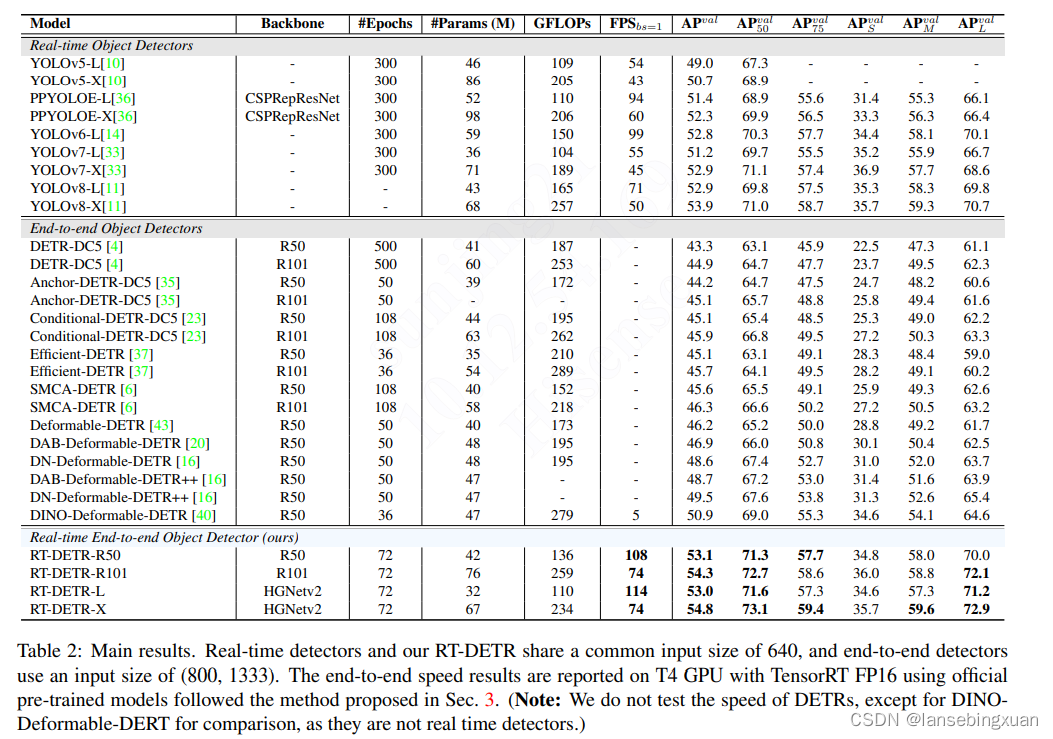

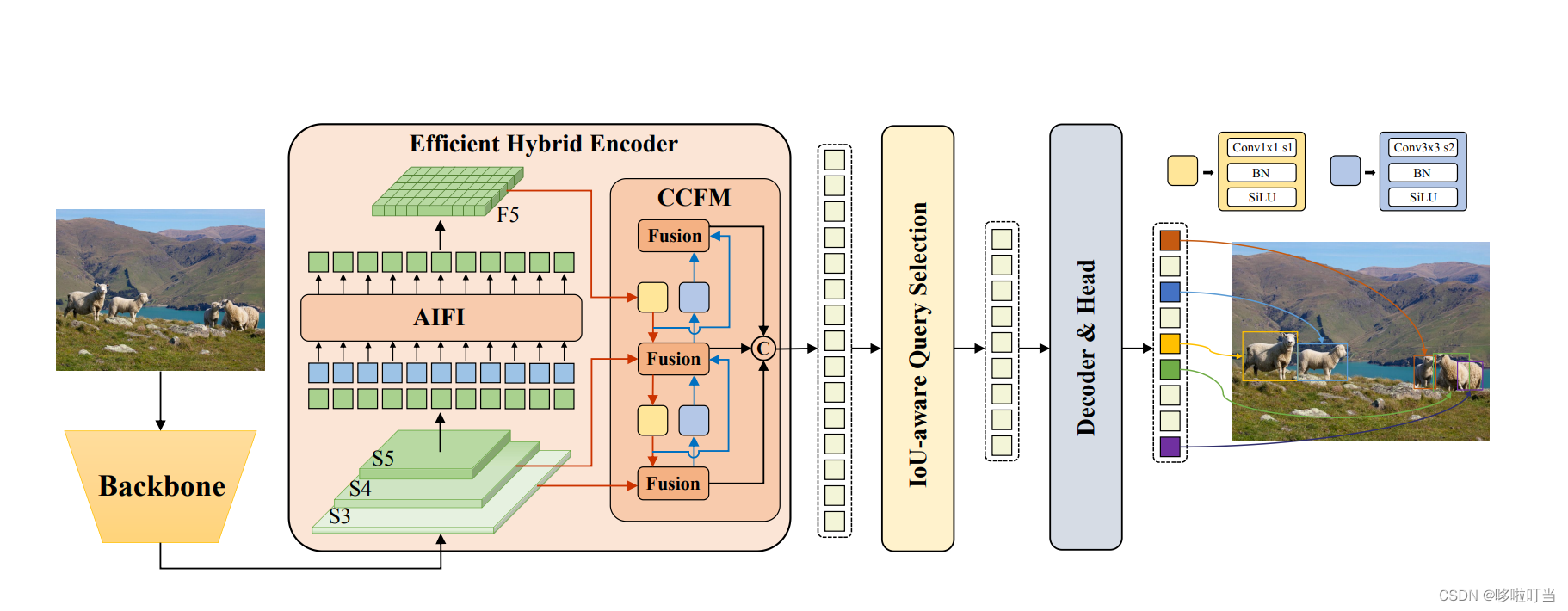

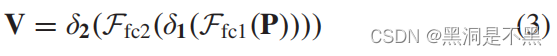

DETR系列:RT-DETR(一) 论文解析

论文:《DETRs Beat YOLOs on Real-time Object Detection》 2023.4

DETRs Beat YOLOs on Real-time Object Detection:https://arxiv.org/pdf/2304.08069.pdf

源码地址:https://github.com/PaddlePaddle/PaddleDetection/tree/develop/conf…

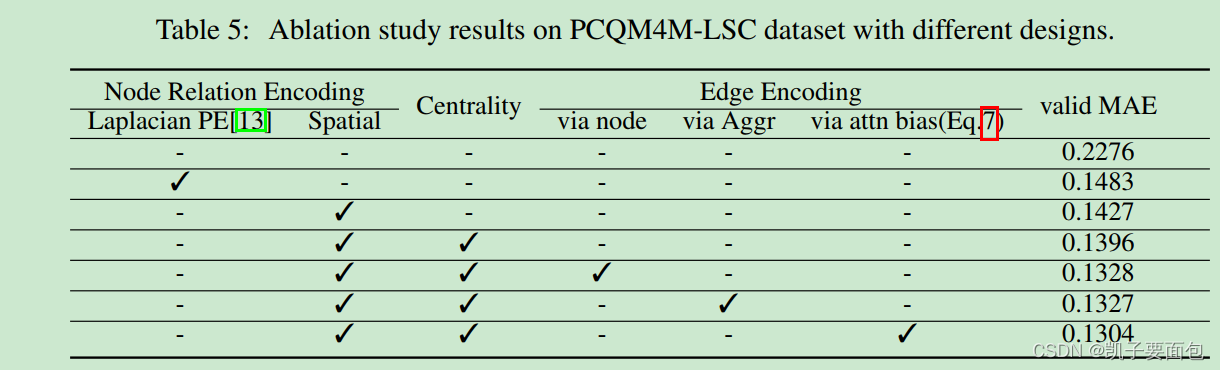

《Do Transformers Really Perform Bad for Graph Representation?》论文笔记

引言

论文提出 Graphormer 对“图数据结构”进行表征学习,Graphormer 是基于标准 Transformer 模型结构, 通过加入 Centrality Encoding、Spatial Encoding 、Edge Encoding 技术编码图结构信息, Centrality Encoding 主要用于编码节点的重要…

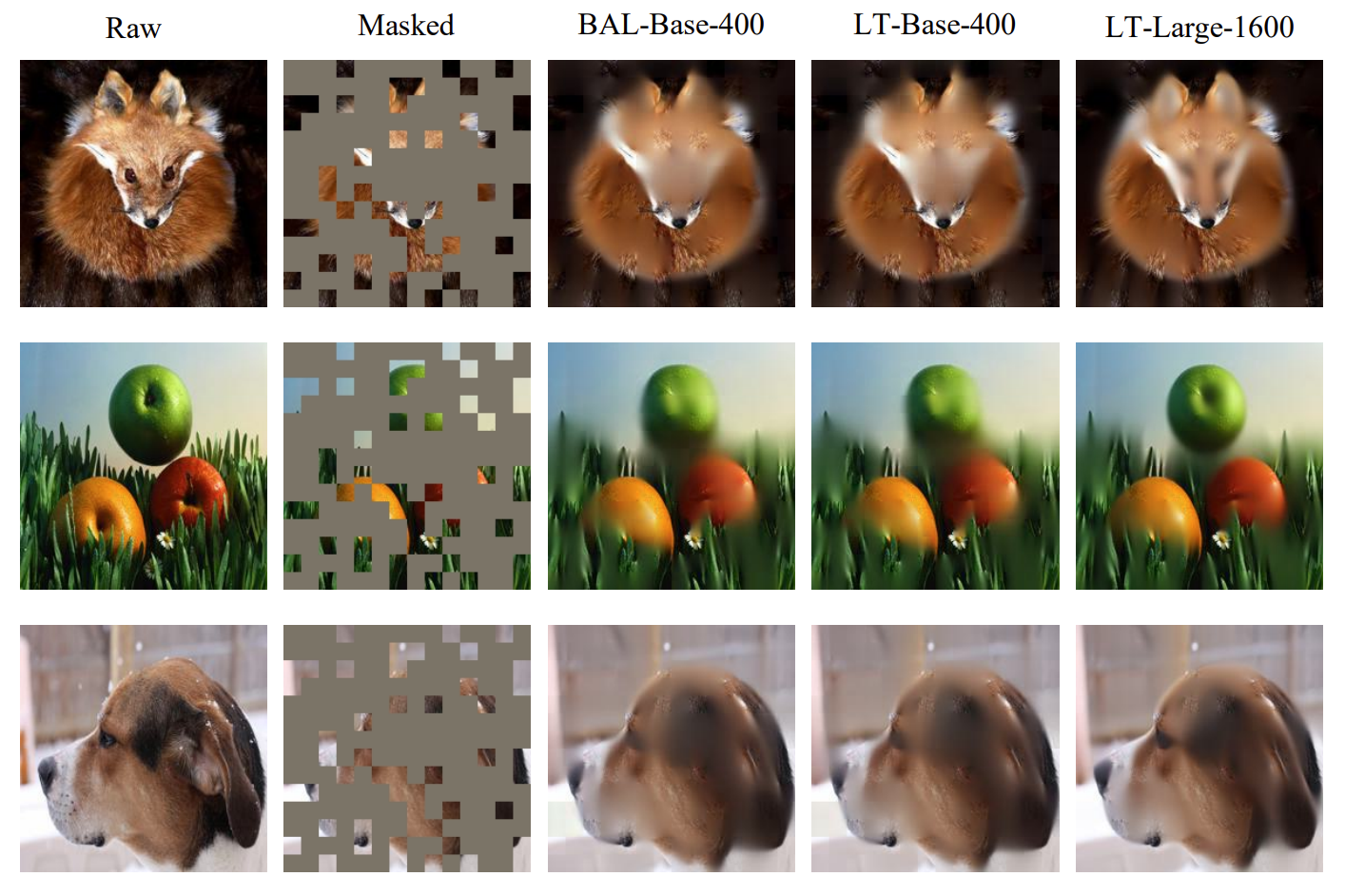

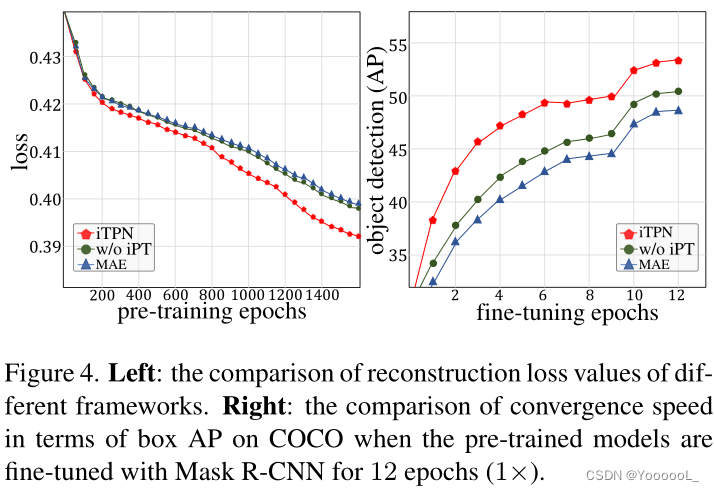

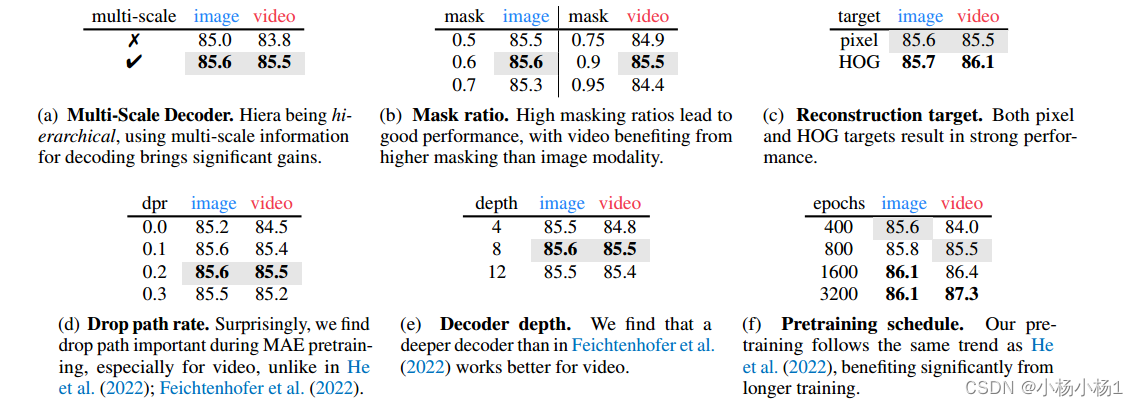

何凯明最新一作:Masked Autoencoders Are Scalable Vision Learners

Masked Autoencoders Are Scalable Vision Learners 何凯明大神最新一作,mask输入图像的随机patch,并重建移除的像素。 主要提出两点: 1.提出一种非对称的编码器-解码器 2.mask高比例的输入图像patch将变成一个不错且有意义的自监督任务 摘要…

文献阅读:DeepNet: Scaling Transformers to 1,000 Layers

文献阅读:DeepNet: Scaling Transformers to 1,000 Layers 1. 文章简介2. 核心技术点 1. DeepNet整体结构2. 参数初始化考察3. DeepNorm考察 3. 实验考察 1. 可行性考察2. 有效性考察 4. 结论 & 思考 文献链接:https://arxiv.org/abs/2203.00555

1…

Transformer模型简介

简介

Transformer 是 Google 团队在 17 年 6 月提出的 NLP 经典之作, 由 Ashish Vaswani 等人在 2017 年发表的论文 Attention Is All You Need 中提出。

Transformer 在机器翻译任务上的表现超过了 RNN,CNN,只用 encoder-decoder 和 atten…

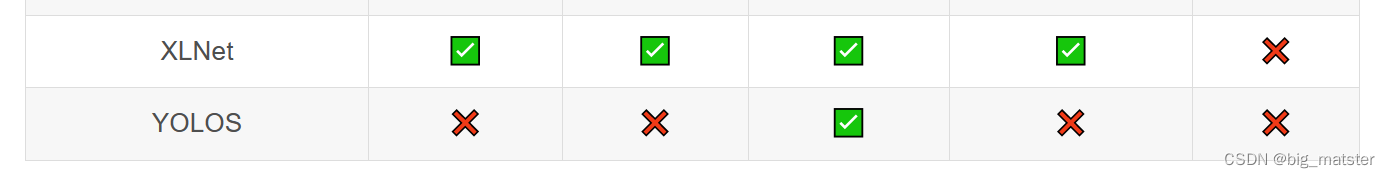

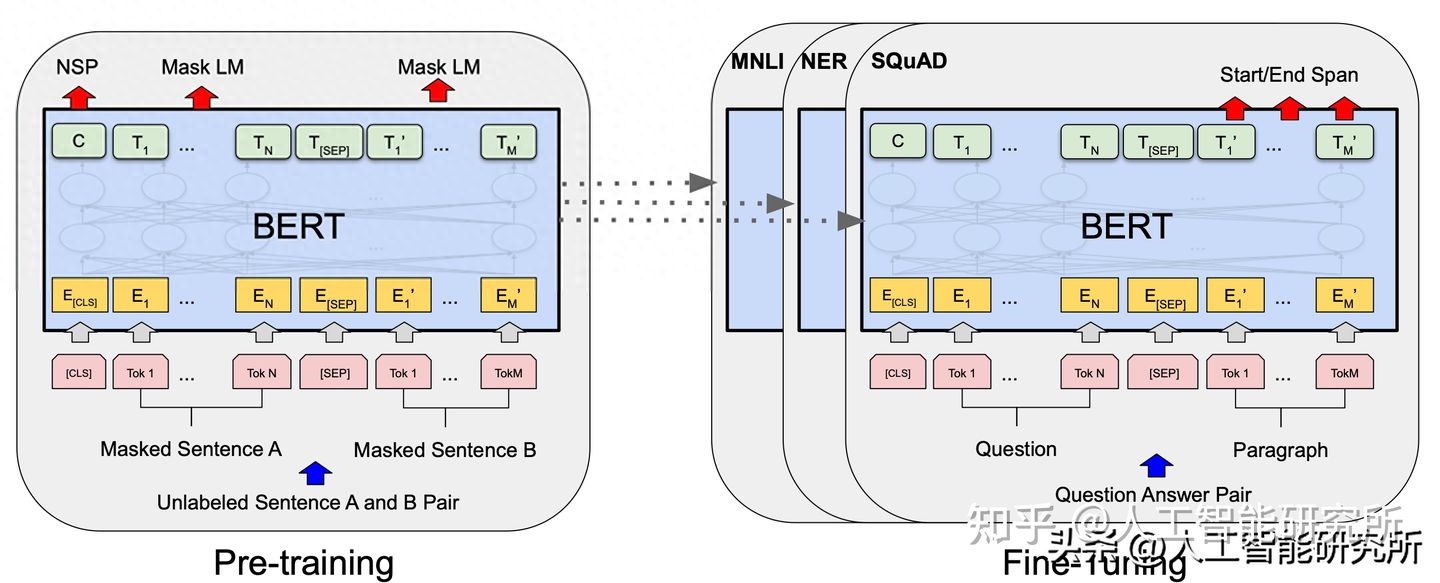

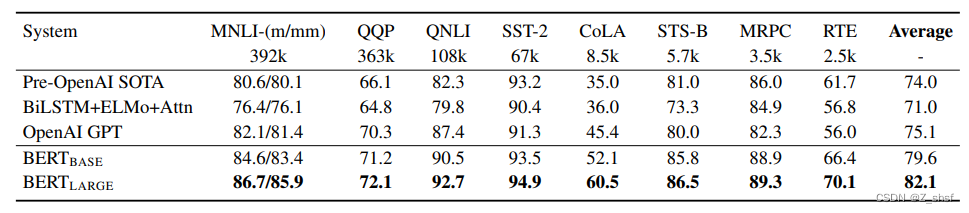

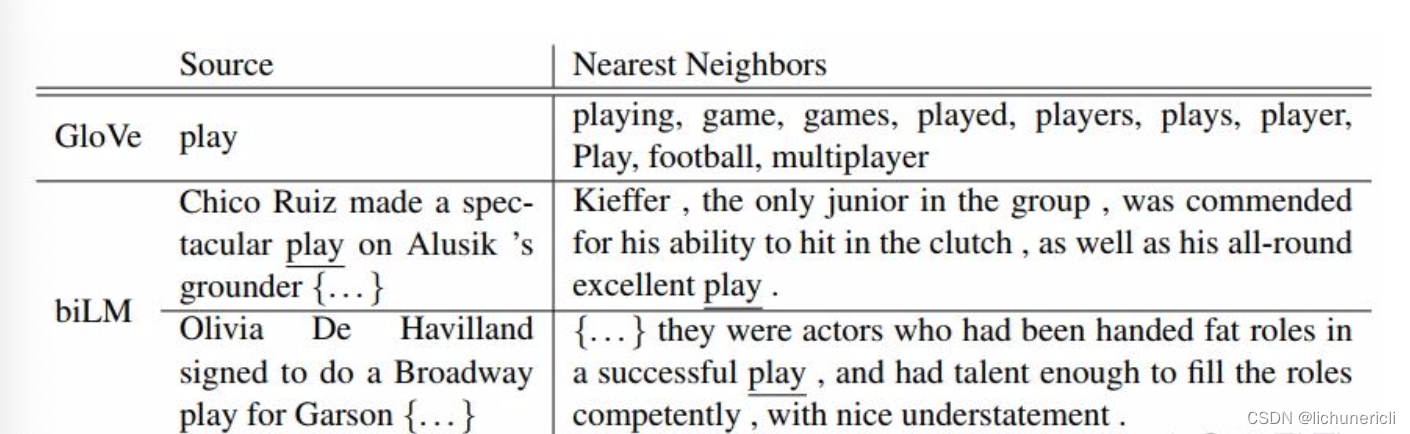

自然语言处理---Transformer机制详解之BERT GPT ELMo模型的对比

1 BERT、GPT、ELMo的不同点 关于特征提取器: ELMo采用两部分双层双向LSTM进行特征提取, 然后再进行特征拼接来融合语义信息.GPT和BERT采用Transformer进行特征提取.很多NLP任务表明Transformer的特征提取能力强于LSTM, 对于ELMo而言, 采用1层静态token embedding 2层LSTM, 提取…

LLMs多任务指令微调Multi-task instruction fine-tuning

多任务微调是单任务微调的扩展,其中训练数据集包括多个任务的示例输入和输出。在这里,数据集包含指导模型执行各种任务的示例,包括摘要、评论评分、代码翻译和实体识别。

您在这个混合数据集上训练模型,以便它可以同时提高模型在…

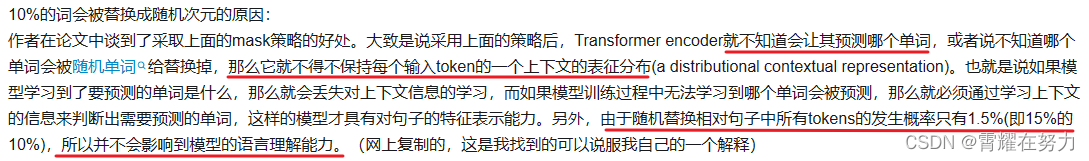

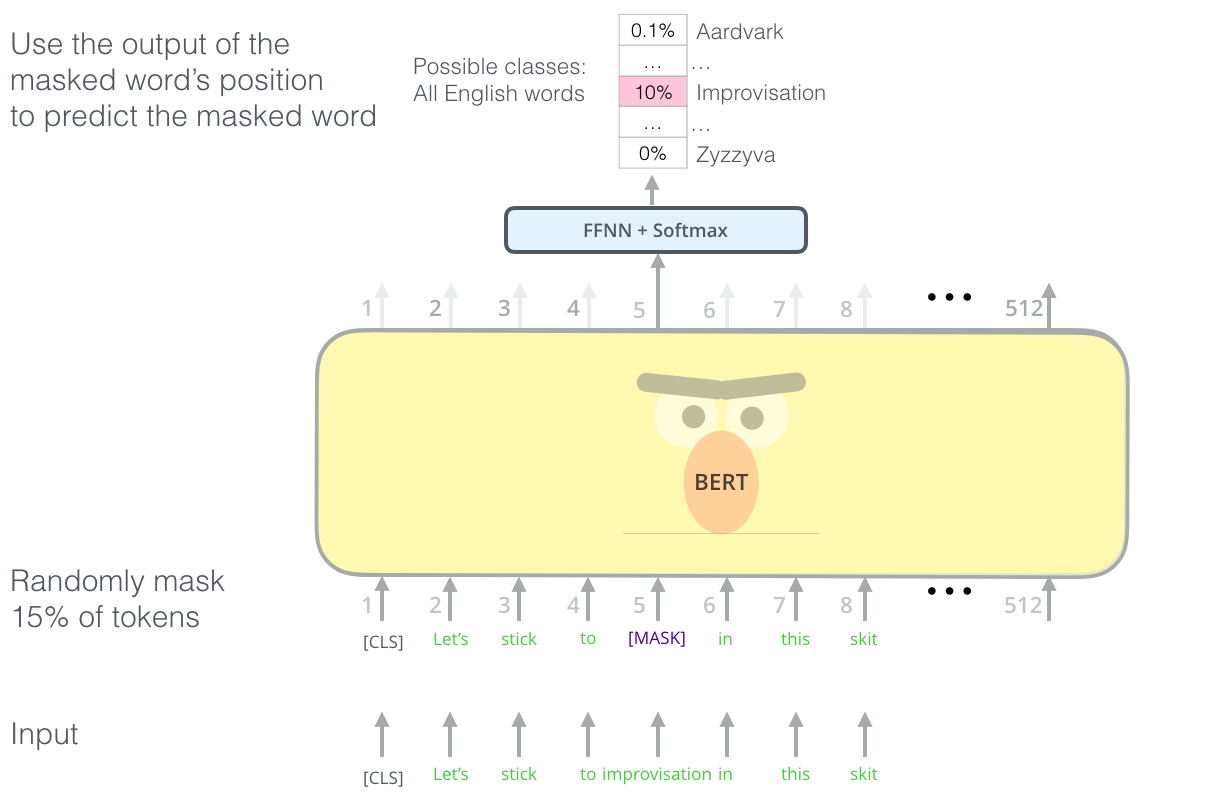

bert中为什么要这么msdk(80% mask, 10% 随机替换,10% 保持原词)

bert在训练阶段不是将15%的词汇MASK掉,从而采用自监督的方式训练模型,那我直接将这15%mask掉不就好了吗,为什么又要进行80% mask,10% 随机替换,10% 保持原词呢?起初我看到的时候也比较迷惑,下面…

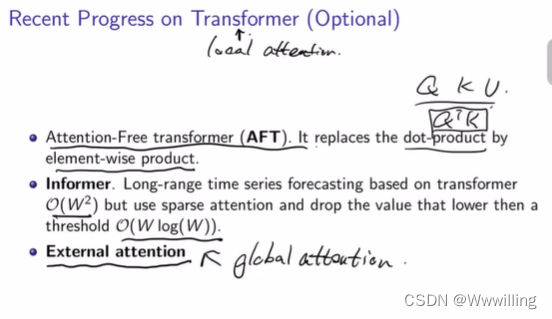

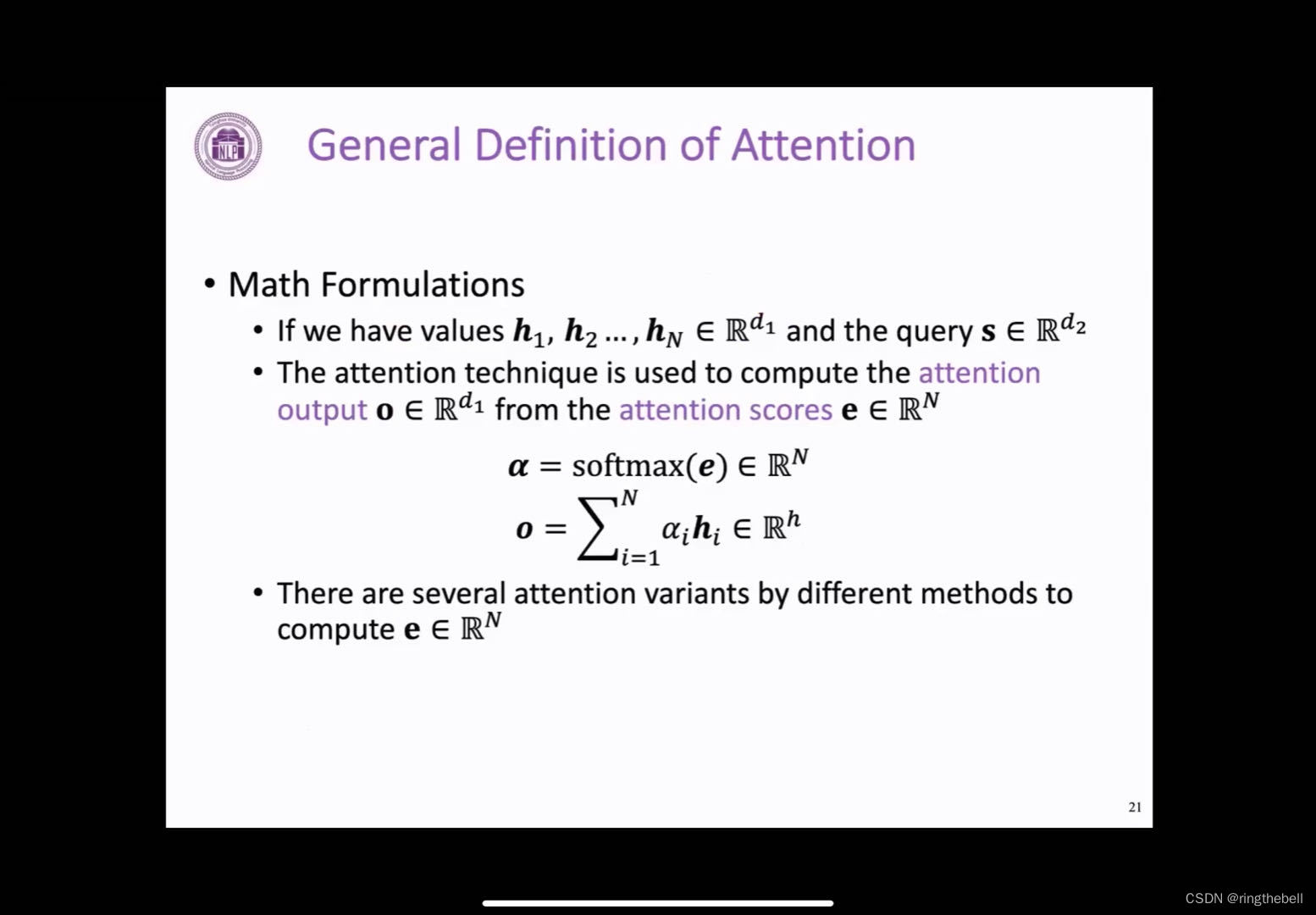

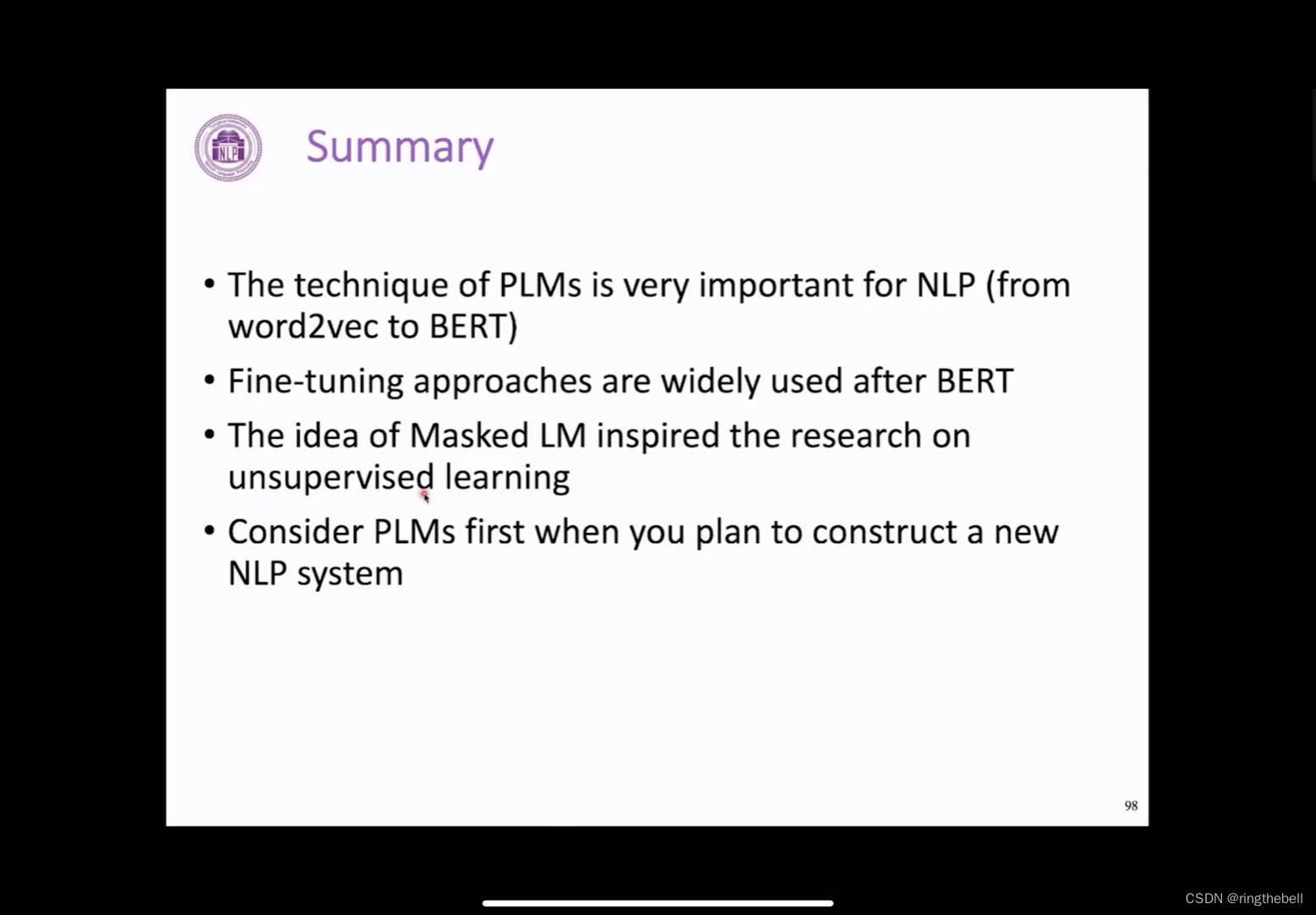

Transformer and Pretrain Language Models3-1

content

transformer

attention mechanism

transformer structure pretrained language models

language modeling

pre-trained langue models(PLMs)

fine-tuning approaches

PLMs after BERT

applications of masked LM

frontiers of PLMs …

ViT论文Pytorch代码解读

ViT论文代码实现 论文地址:https://arxiv.org/abs/2010.11929 Pytorch代码地址:https://github.com/lucidrains/vit-pytorch ViT结构图 调用代码

import torch

from vit_pytorch import ViTdef test():v ViT(image_size 256, patch_size 32, num_cl…

ModuleNotFoundError: No module named ‘SwissArmyTransformer‘

小问题,直接pip install pip install SwissArmyTransformer

但是,安装之后却还是提示,屏幕上依然标红 ModuleNotFoundError: No module named SwissArmyTransformer 查找环境目录发现, 这是因为新版的SwissArmyTransformer中&…

使用Swin-Transformer-Semantic-Segmentation训练自己的数据(语义分割,自己做数据)

使用Swin-Transformer-Semantic-Segmentation训练自己的数据系统配置代码链接针对MMCV 选择系统Windows环境要求:ubuntu 18.04安装swin segmentation制作VOC 数据集代码部分修改开始训练恭喜Swin Transformer拿到2021 ICCV Best Paper!MSRA再一次拿到Bes…

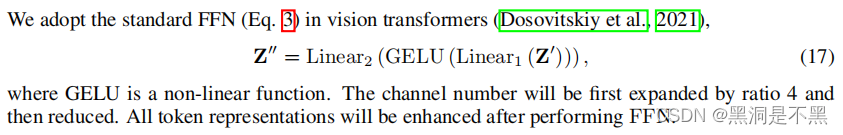

Uniformer: Unified Transformer for Efficient Spatial-Temporal Representation Learning

Unified Transformer for Efficient Spatial-Temporal Representation Learning1. Motivation2. Method2.1 MHRA:2.2 DPE2.3 FFN1. Motivation

高维视频具有大量的局部冗余和复杂的全局依赖关系,而该研究主要是由3D卷积神经网络和视觉Transformer驱动。…

图像分割(二)—— Segmenter: Transformer for Semantic Segmentation

Segmenter: Transformer for Semantic SegmentationAbstract1. IntroductionOur approach: Segmenter3.1. Encoder3.2. DecoderAbstract

图像分割往往在图像 patch 的级别上模棱两可,并需要上下文信息达成标签一致。本文介绍了一种用于语义分割的 transformer 模型…

R语言:ca和MASS包实现对应分析并绘图解释

文章目录 对应分析R语言求解案例ca包codeMASScode对应分析的问题对应分析 对应分析(correspondence analysis)是用于寻求列联表的行和列之间联系的一种低维图形表示法,它可以从直觉上揭示出同一分类变量的各个类别之间的差异,以及不同分类变量各个类别之间的对应关系。对应…

Transformer实战-系列教程1:Transformer算法解读

现在最火的AI内容,chatGPT、视觉大模型、研究课题、项目应用现在都是Transformer大趋势了

1、传统的RNN Transformer是基于RNN改进提出的,RNN不同于CNN、MLP是一个需要逐个计算的结构来进行分类回归的任务,它的每一个循环单元不仅仅要接受当…

transformer之KV Cache

一、为什么要研究KV Cache 非常有效的加速推理速度,效果如下所示: import numpy as np

import time

import torch

from transformers import AutoModelForCausalLM, AutoTokenizer

NAME_OR_PATH r***************

device "cuda" if torch.cu…

论文总结:3D Talking Face With Personalized Pose Dynamics

论文解决的问题:大多数现有的3D人脸生成方法只能生成静态头部姿势的3D面部,只有少数几篇文章关注头部姿势的生成,但这些文章也忽略了个体属性。 解决方法:框架由两个独立模块组成:PoseGAN和PGFace。给定输入音频,PoseGAN首先为3D头部生成一个头部姿势序列,然后PGFace利用…

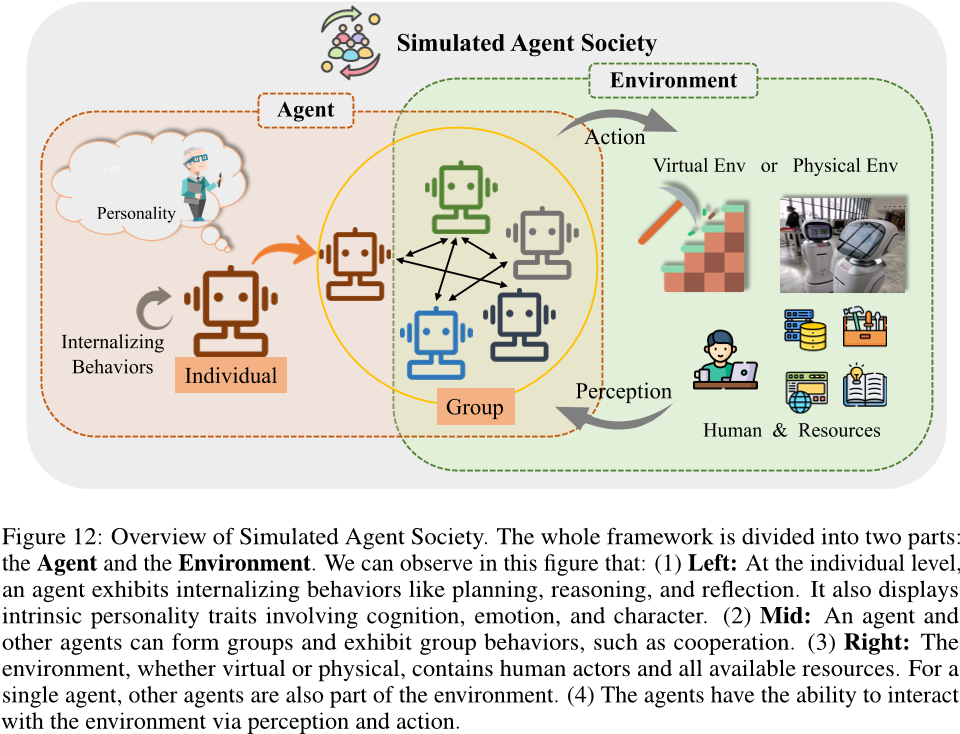

The Rise and Potential of Large Language Model Based Agents: A Survey 中文翻译

大型语言模型代理的崛起与潜力:综述

摘要

长期以来,人类一直追求与或超越人类水平的人工智能(AI),而人工智能代理被视为实现这一目标的有希望的方式。人工智能代理是感知环境、做出决策并采取行动的人工实体。已经有…

解析Transformer模型

原文地址:https://zhanghan.xyz/posts/17281/

进入Transformer

RNN很难处理冗长的文本序列,且很容易受到所谓梯度消失/爆炸的问题。RNN是按顺序处理单词的,所以很难并行化。 用一句话总结Transformer:当一个扩展性极佳的模型和一…

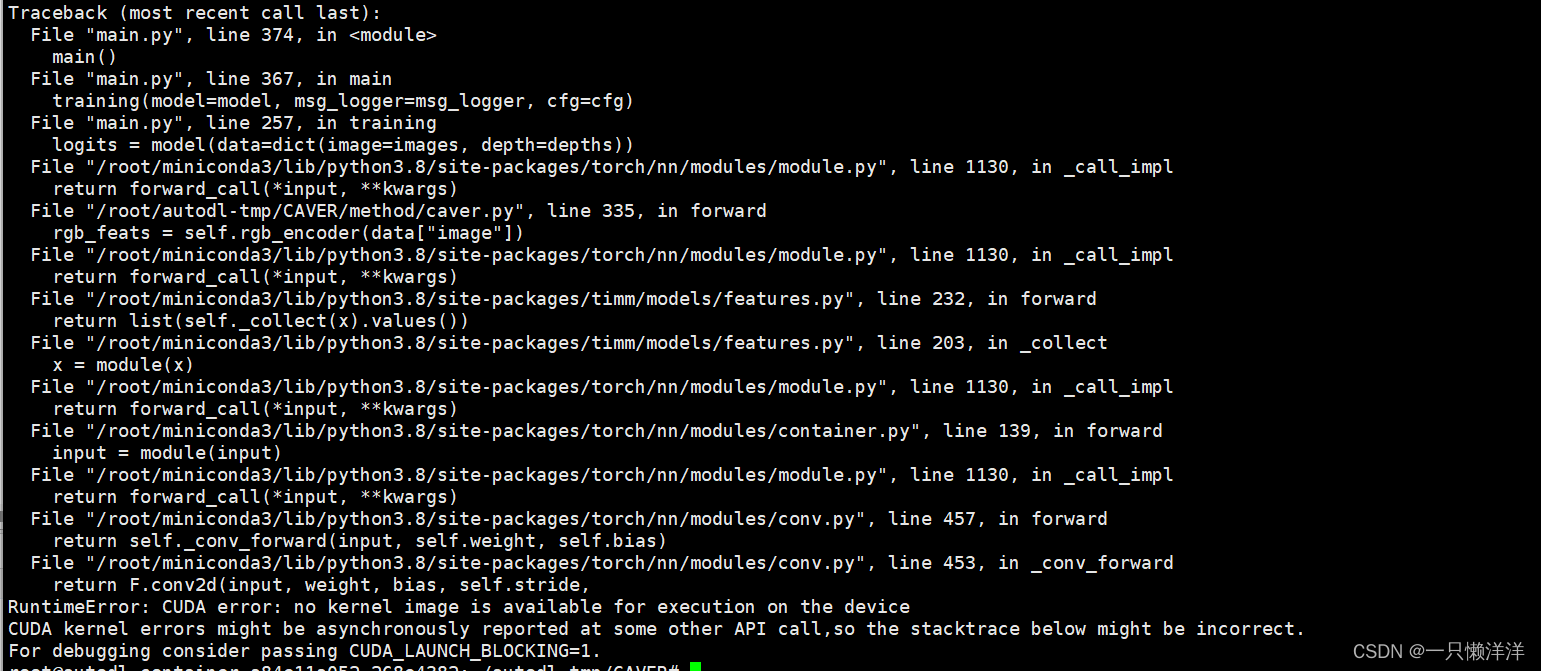

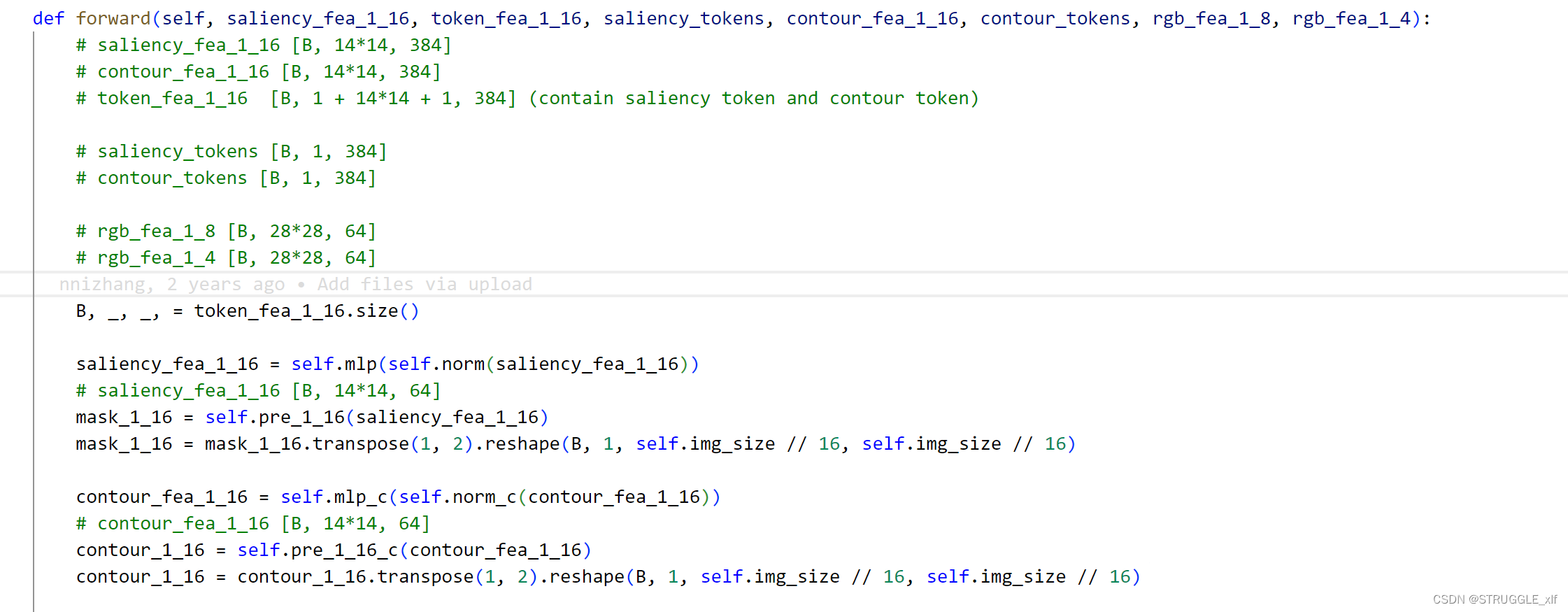

CAVER: Cross-Modal View-Mixed Transformer for Bi-Modal Salient Object Detection

目录

一、论文阅读笔记:

1、摘要:

2、主要贡献点:

3、方法:

3.1 网络的总体框架图:

3.2 Transformer-based Information Propagation Path (TIPP)

3.3 Intra-Modal/Cross-Scale Self-Attention (IMSA/CSSA)

Q1…

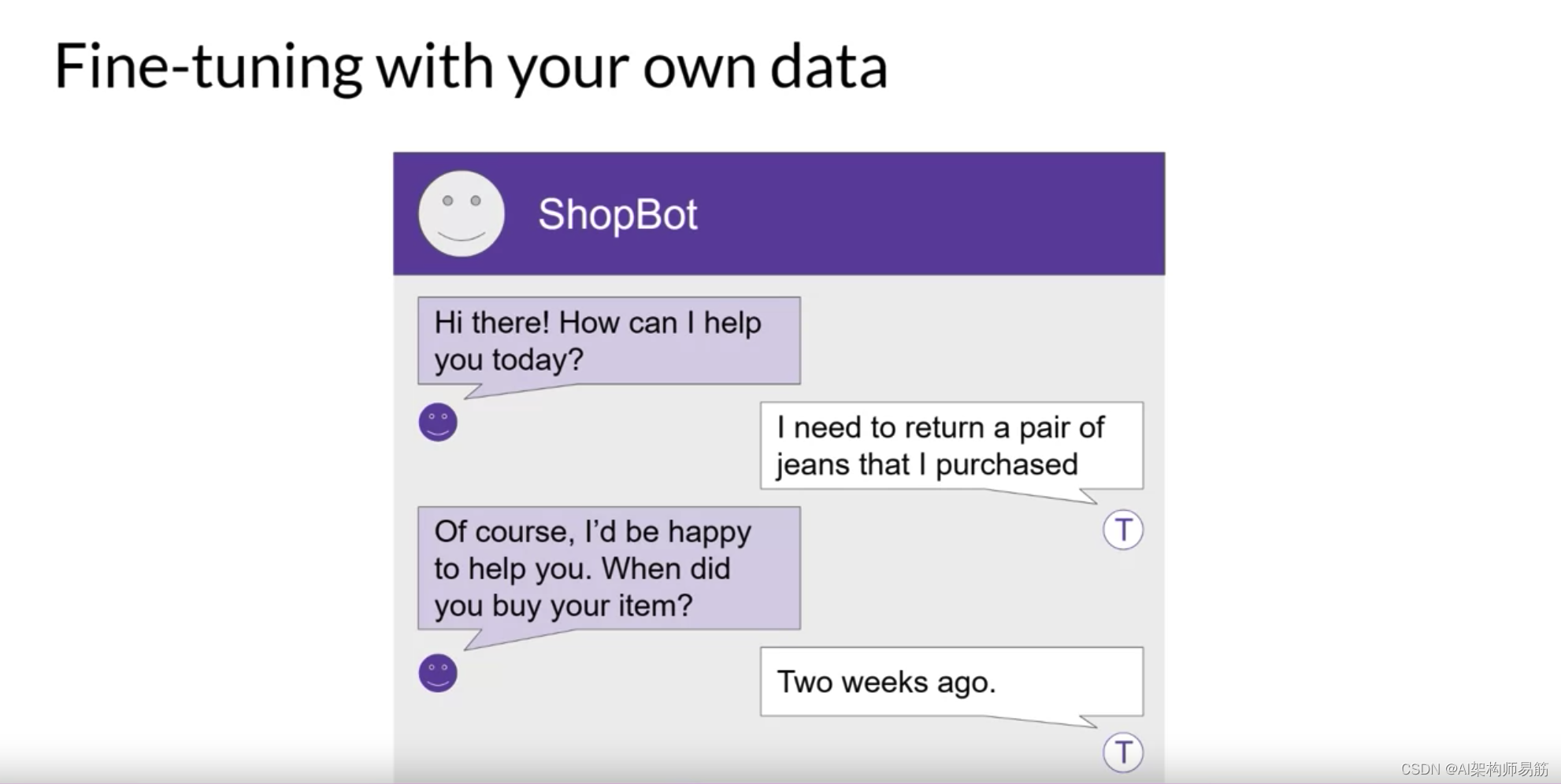

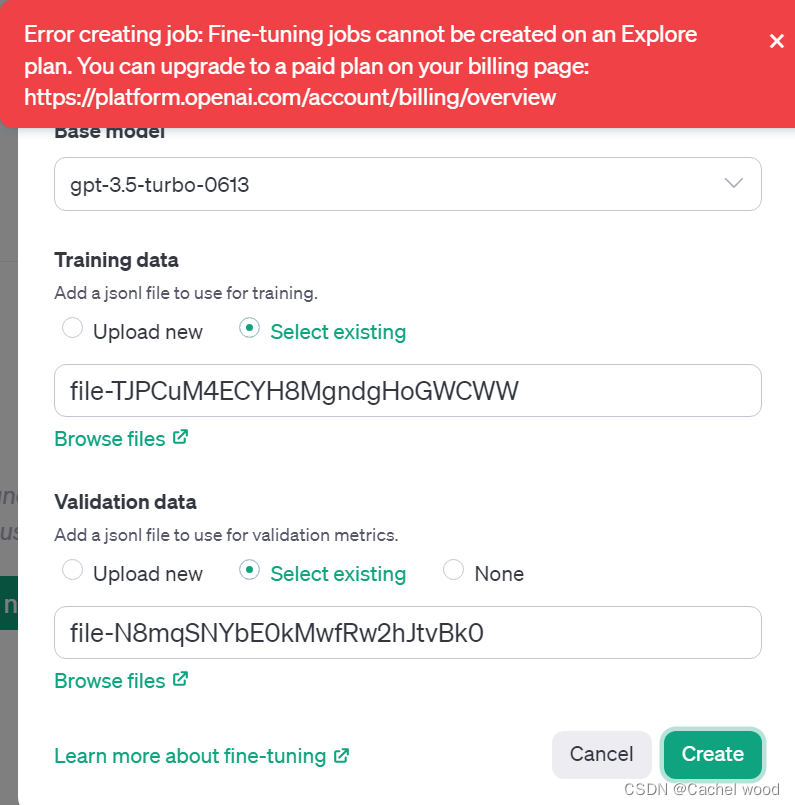

OpenAI开放gpt-3.5turbo微调fine-tuning测试教程

文章目录 openai微调 fine-tuning介绍openai微调地址jsonl格式数据集准备点击上传文件 openai微调 fine-tuning介绍

openai微调地址

网址:https://platform.openai.com/finetune jsonl格式数据集准备

使用Chinese-medical-dialogue-data数据集git clone进行下载 …

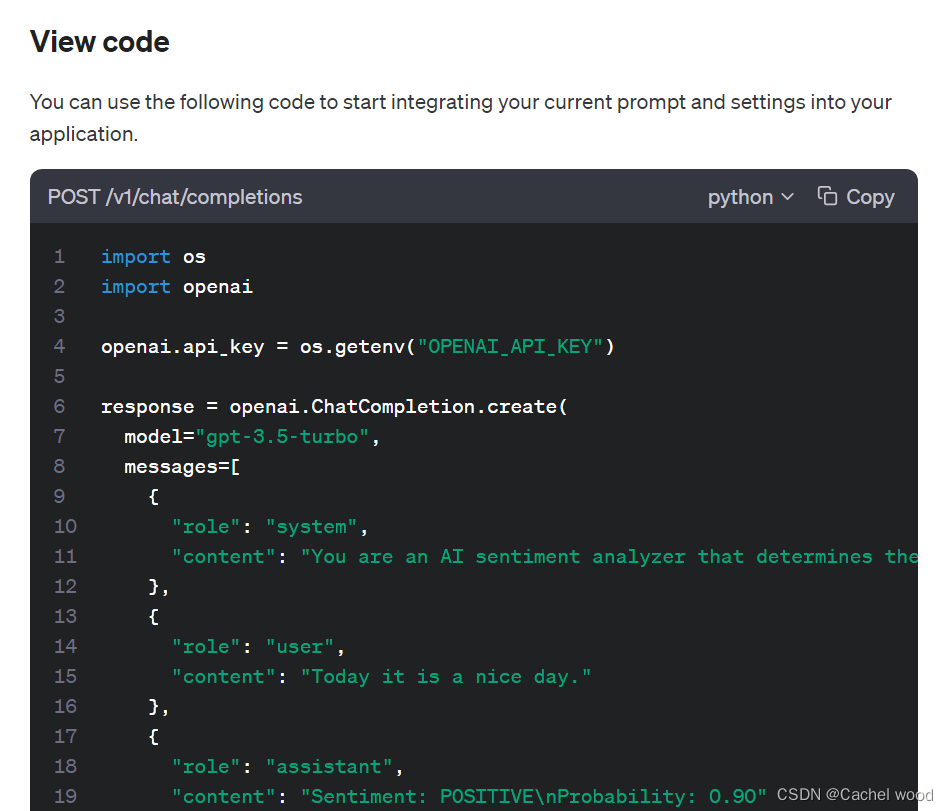

python openai playground使用教程

文章目录 playground介绍Playground特点模型设置和参数选择四种语言模型介绍 playground应用构建自己的playground应用playground python使用 playground介绍

OpenAI Playground是一个基于Web的工具,旨在帮助开发人员测试和尝试OpenAI的语言模型,如GPT-…

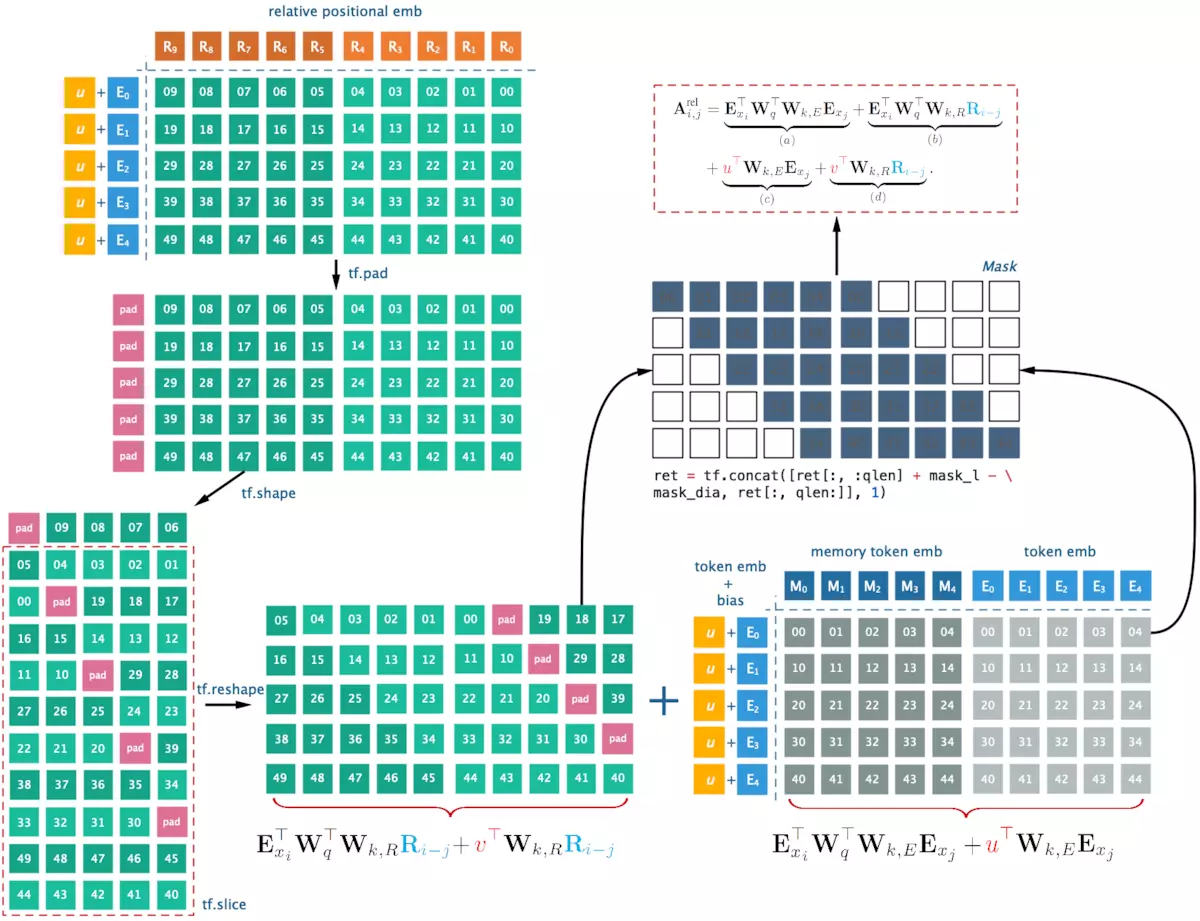

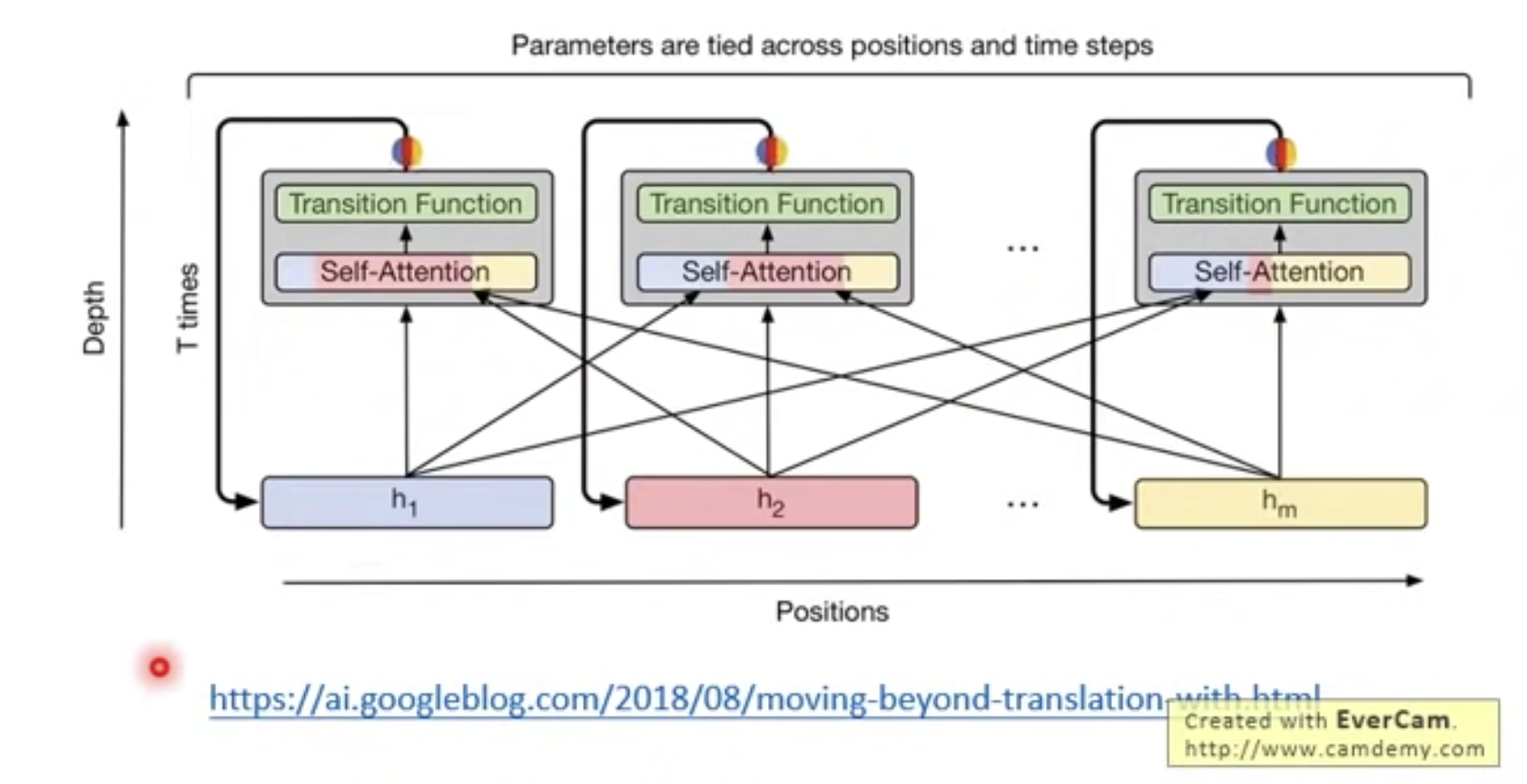

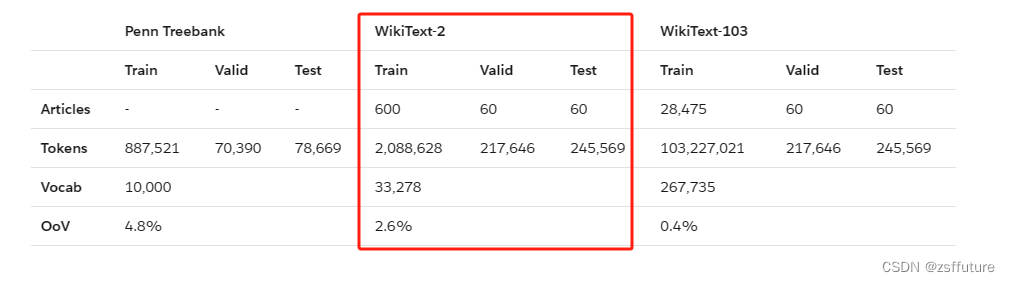

【自然语言处理】Transformer-XL 讲解

Transformer-XL

首先需要明确,Transformer-XL(XL 是 extra long 的简写)只是一个堆叠了自注意力层的 BPTT 语言模型,并不是 Transformer 原始论文中提到的编码器-解码器架构,也不是原始 Transformer 中的编码器部分或者解码器部分,根据其大致实现可以将其理解为丢弃 cro…

简单有趣的变形金刚网络(VIT) Vision Transformer(网络结构详解+详细注释代码+核心思想讲解)——pytorch实现

论文题目: An Image Is Worth 16x16 Words: Transformers For Image Recognition At Scale 原论文下载链接:https://arxiv.org/abs/2010.11929原论文对应源代码:mirrors / google-research / vision_transformer GitCode Transformer最先应用于在NIP领域,并且取得了巨大的…

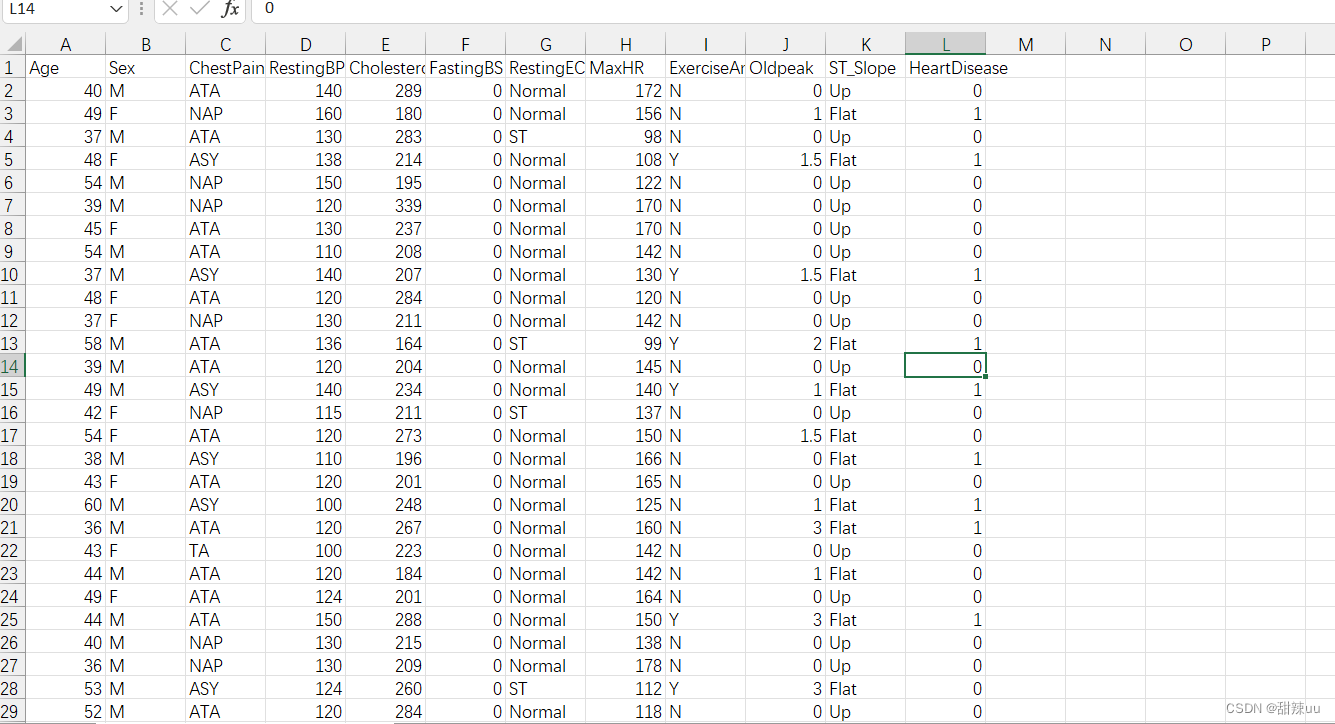

基于transformer的心脑血管心脏病疾病预测

视频讲解:基于transformer的心脑血管疾病预测 完整数据代码分享_哔哩哔哩_bilibili

数据展示: 完整代码:

# pip install openpyxl -i https://pypi.tuna.tsinghua.edu.cn/simple/

# pip install optuna -i https://pypi.tuna.tsinghua.edu.cn/simple/

import numpy as np

…

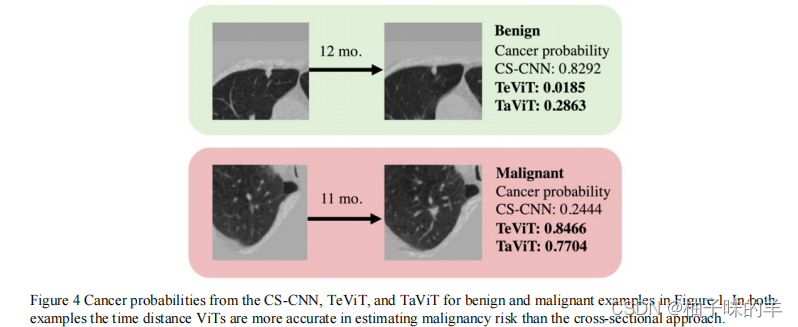

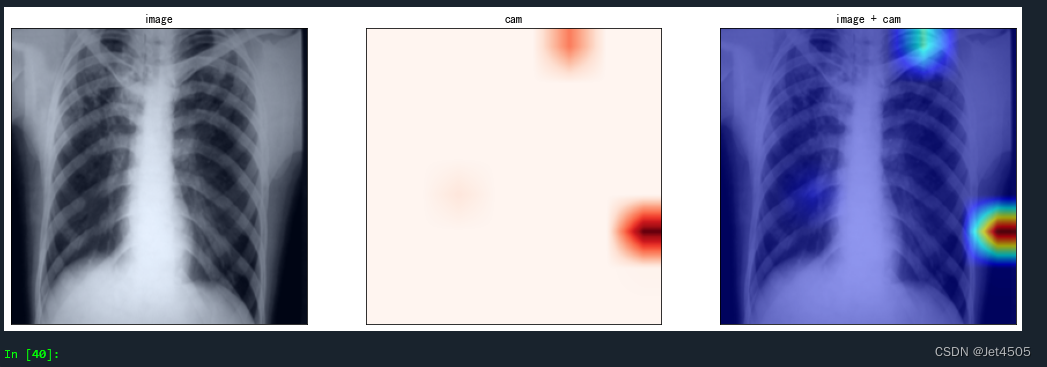

文献阅读(50)—— Transformer 用于肺癌诊断预测

文献阅读(50)—— Transformer 用于肺癌诊断预测 文章目录 文献阅读(50)—— Transformer 用于肺癌诊断预测先验知识/知识拓展文章结构背景文章方法1. 文章核心网络结构2. Time Encoding ViT (TeViT)3. Tim…

【YOLOv8/YOLOv7/YOLOv5系列算法改进NO.56】引入Contextual Transformer模块(为本人sci期刊创新点之一)

文章目录 前言一、解决问题二、基本原理三、添加方法四、总结前言

作为当前先进的深度学习目标检测算法YOLOv8,已经集合了大量的trick,但是还是有提高和改进的空间,针对具体应用场景下的检测难点,可以不同的改进方法。此后的系列文章,将重点对YOLOv8的如何改进进行详细…

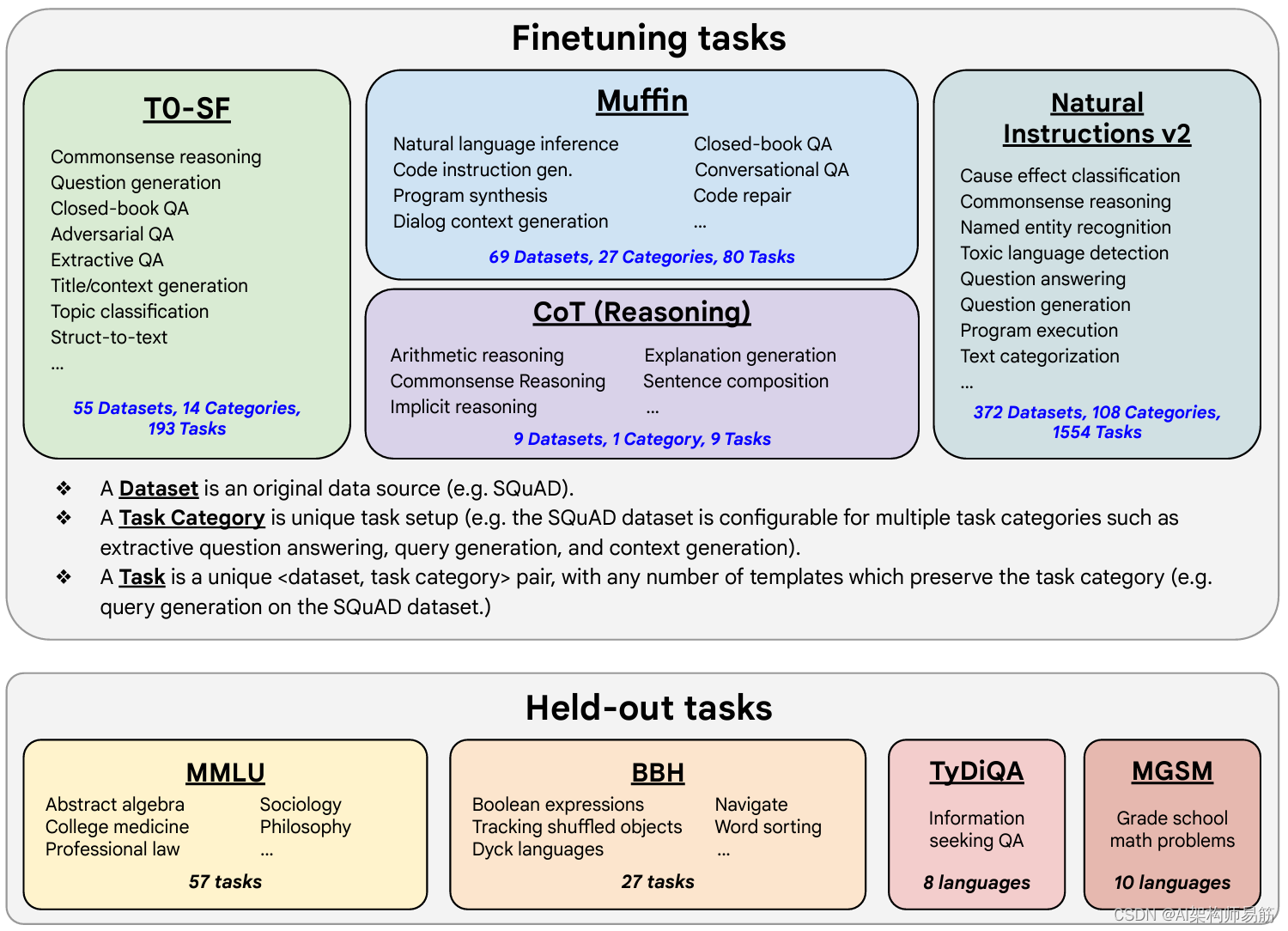

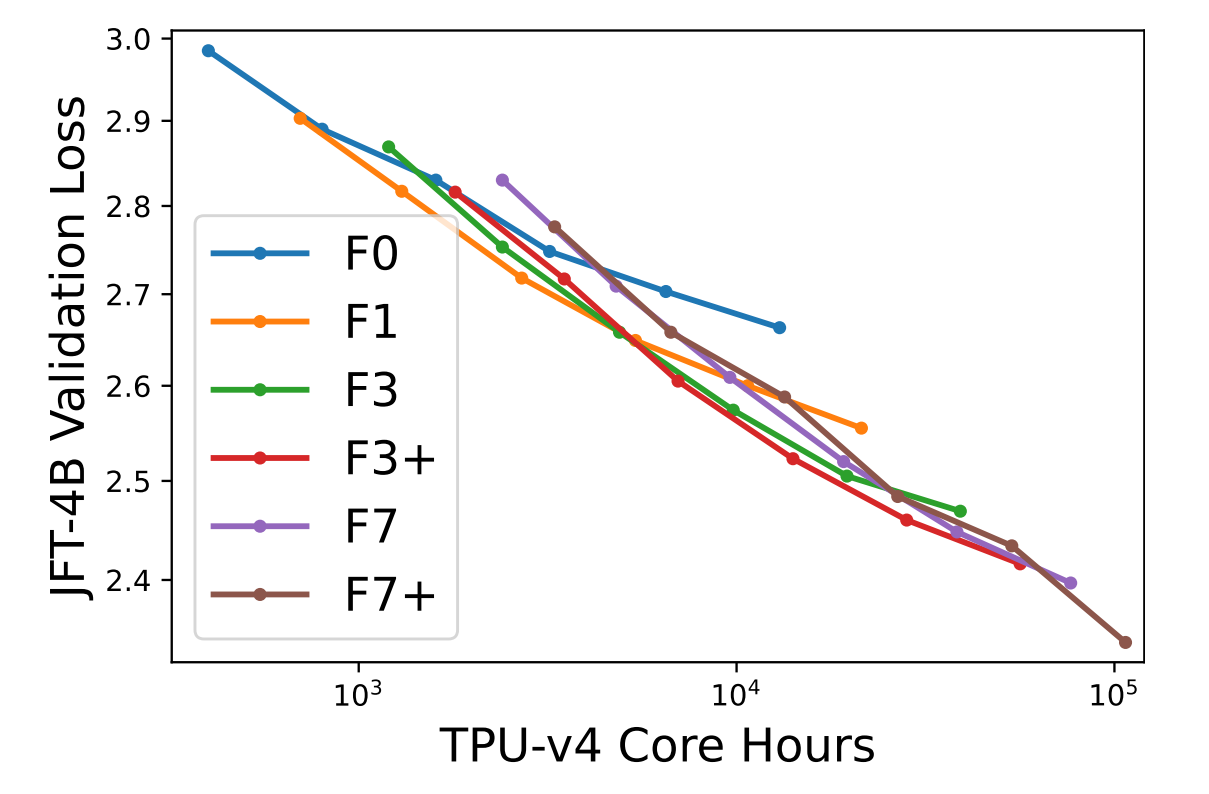

LLMs 缩放指令模型Scaling instruct models FLAN(Fine-tuned LAnguage Net,微调语言网络)

本论文介绍了FLAN(Fine-tuned LAnguage Net,微调语言网络),一种指导微调方法,并展示了其应用结果。该研究证明,通过在1836个任务上微调540B PaLM模型,同时整合Chain-of-Thought Reasoning&#…

案例系列:Movielens_预测用户对电影的评分_基于行为序列Transformer的推荐系统

文章目录 简介数据集设置准备数据下载并准备数据框将电影评分数据转换为序列 定义元数据为训练和评估创建 tf.data.Dataset创建模型输入编码输入特征创建一个二叉搜索树模型运行训练和评估实验结论 描述: 使用行为序列Transformer(BST)模型在…

【Transformer系列】关于Transformer的若干问题FAQ解析

一、参考资料

Transformer的细节到底是怎么样的?Transformer 18问

答案解析(1)—史上最全Transformer面试题:灵魂20问帮你彻底搞定Transformer 关于Transformer的若干问题整理记录 Transformer的细节与技巧

二、FAQ

Q:什么是Transformer&…

Transformer在视觉的应用

文章目录 Vison TransformerSwin TransformerVisual Attention Network Vison Transformer

transformer 在 cv 中最重要的算法

Linear Projection of Flattened Patches 对于标准的Transformer模块,要求输入的是token(向量)序列ÿ…

TRB 2024论文分享:一种基于Swin Transformer的车标识别新方法

TRB(Transportation Research Board,美国交通研究委员会,简称TRB)会议是交通研究领域知名度最高学术会议之一,近年来的参会人数已经超过了2万名,是参与人数和国家最多的学术盛会。TRB会议几乎涵盖了交通领域…

第一课:Transformer

第一课:Transformer 文章目录 第一课:Transformer1、学习总结:什么是语言模型?大语言模型(LLM)技术演变史注意力机制Transformer结构课程ppt及代码地址 2、学习心得:3、经验分享:4、…

15 Transformer 框架概述

博客配套视频链接: https://space.bilibili.com/383551518?spm_id_from=333.1007.0.0 b 站直接看 配套 github 链接:https://github.com/nickchen121/Pre-training-language-model 配套博客链接:https://www.cnblogs.com/nickchen121/p/15105048.html 1000*0.04=40–>10 …

DeiT:使用Attention蒸馏Transformer

题目:Training data-efficient image transformers & distillation through attention

【GiantPandaCV导语】Deit是一个全Transformer的架构,没有使用任何的卷及操作。其核心是将蒸馏方法引入VIT的训练,引入了一种教师-学生的训练策略&a…

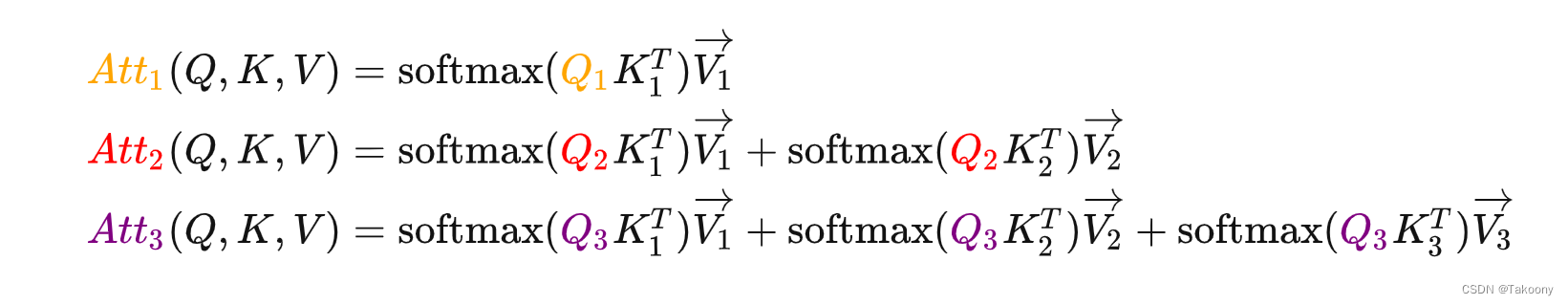

Transformer and Pretrain Language Models3-2

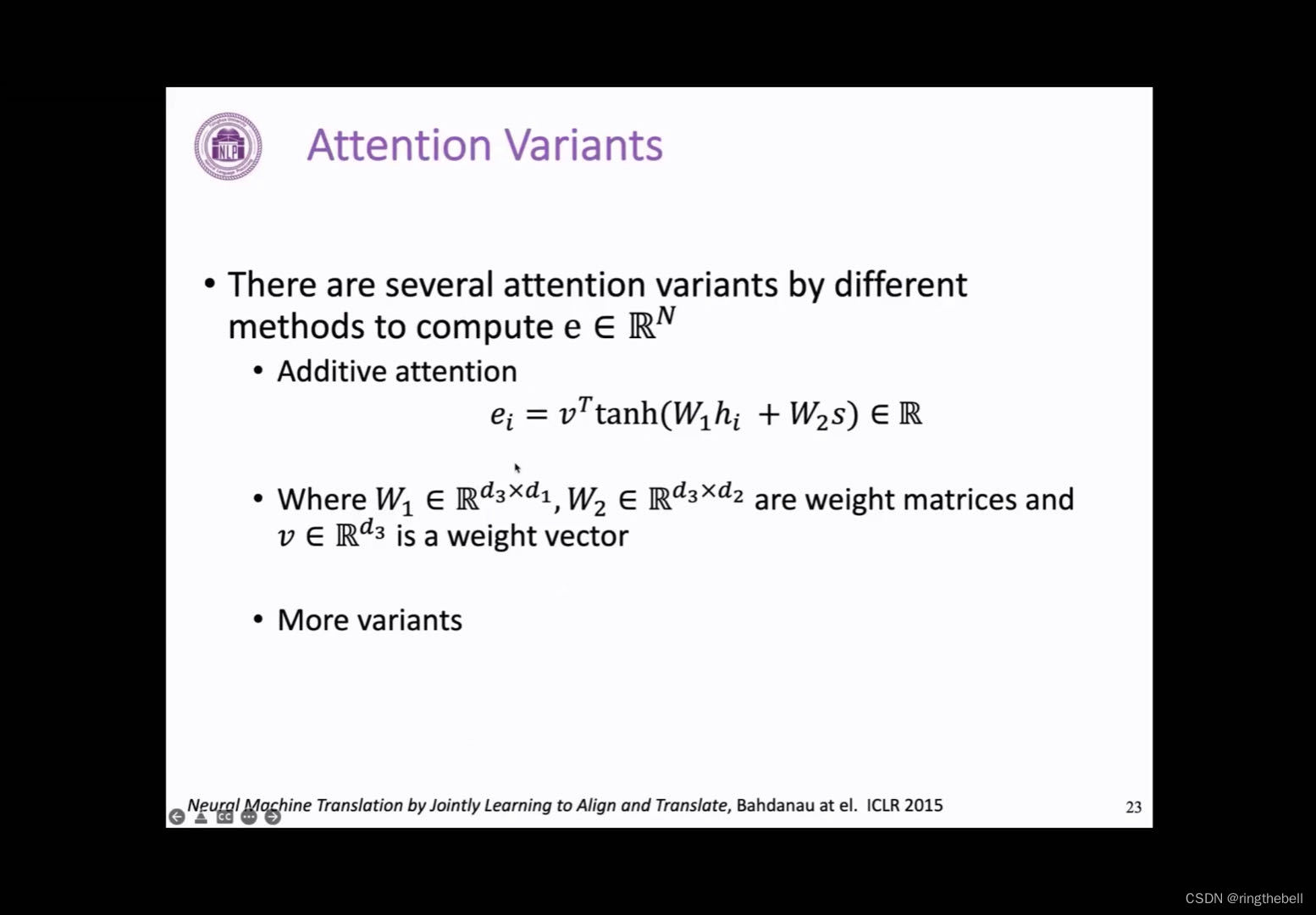

transformer structure注意力机制的各种变体

第二种变体:

如果两个向量的维度不一样,我们就需要在中间加上一个权重矩阵,来实现他们之间的相乘,然后最后得到一个标量

第三种变体:

additive attention

它和前面的有…

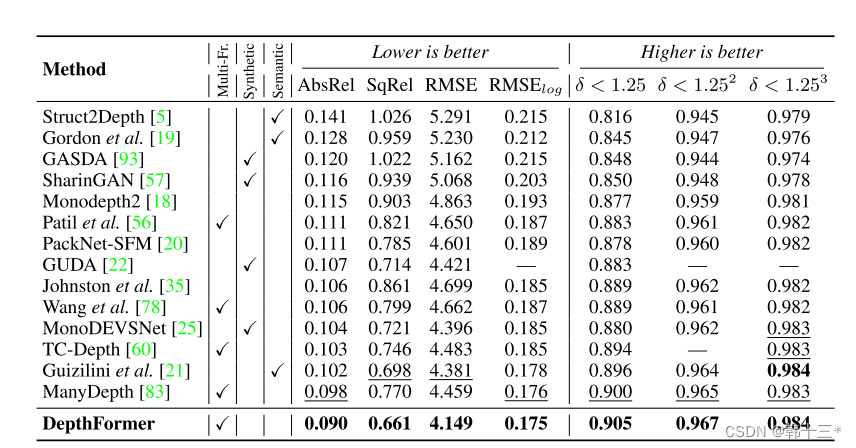

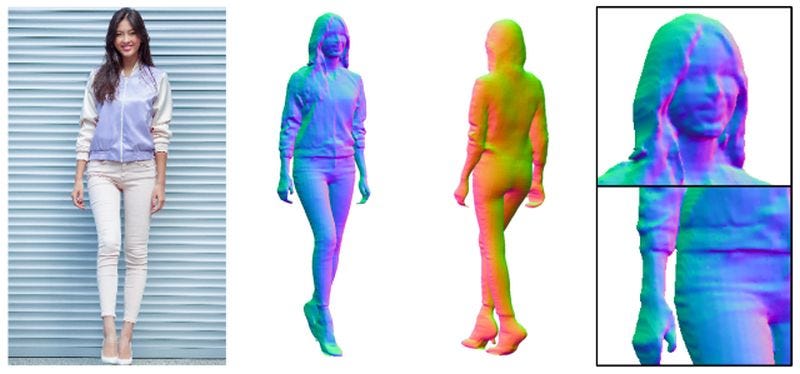

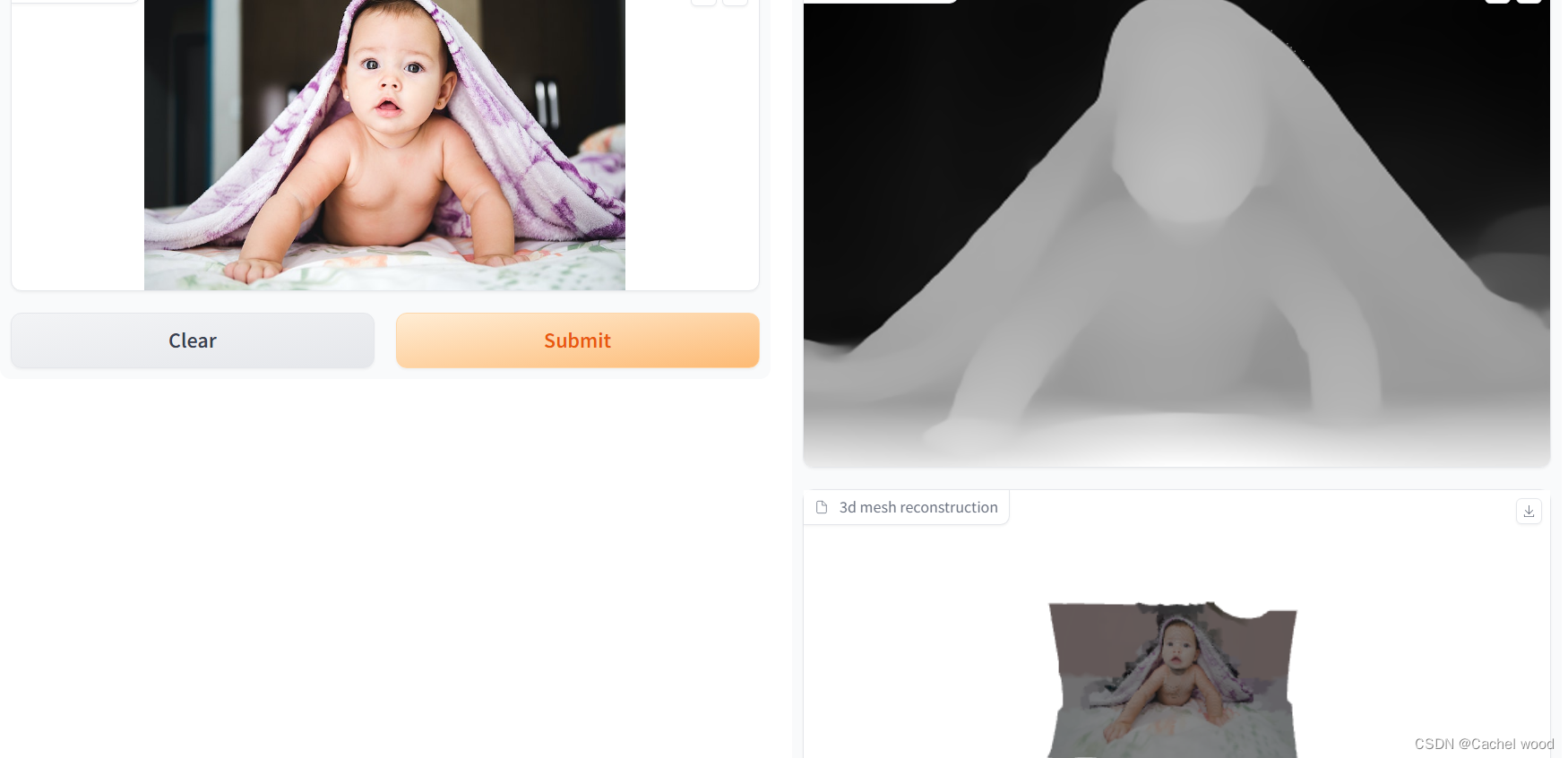

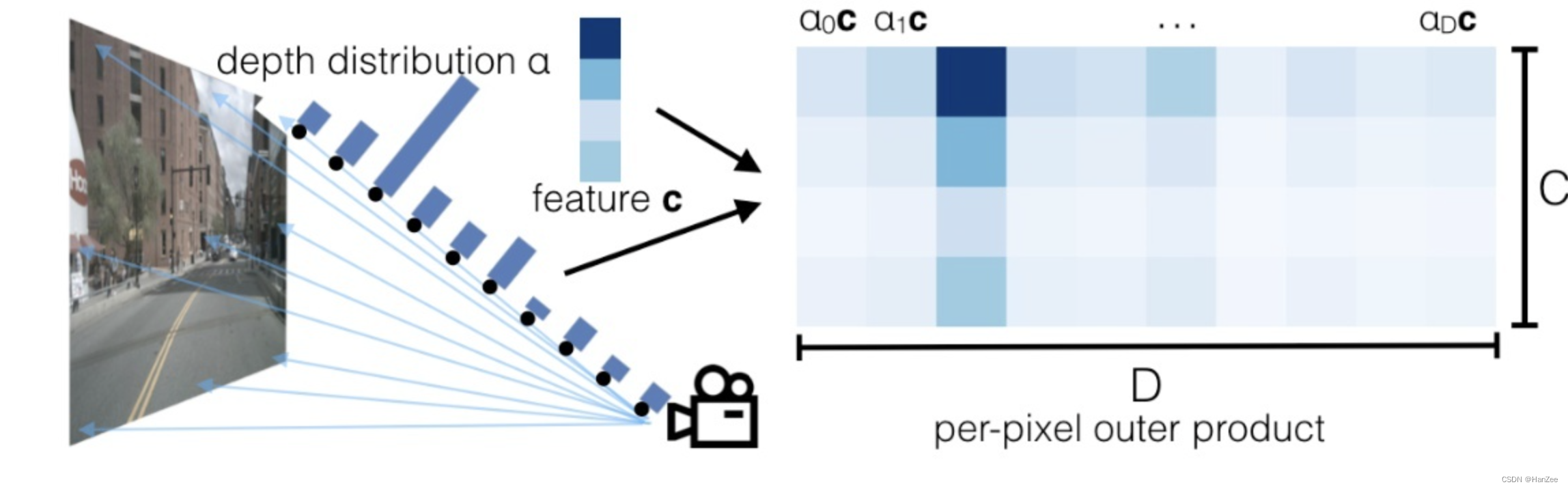

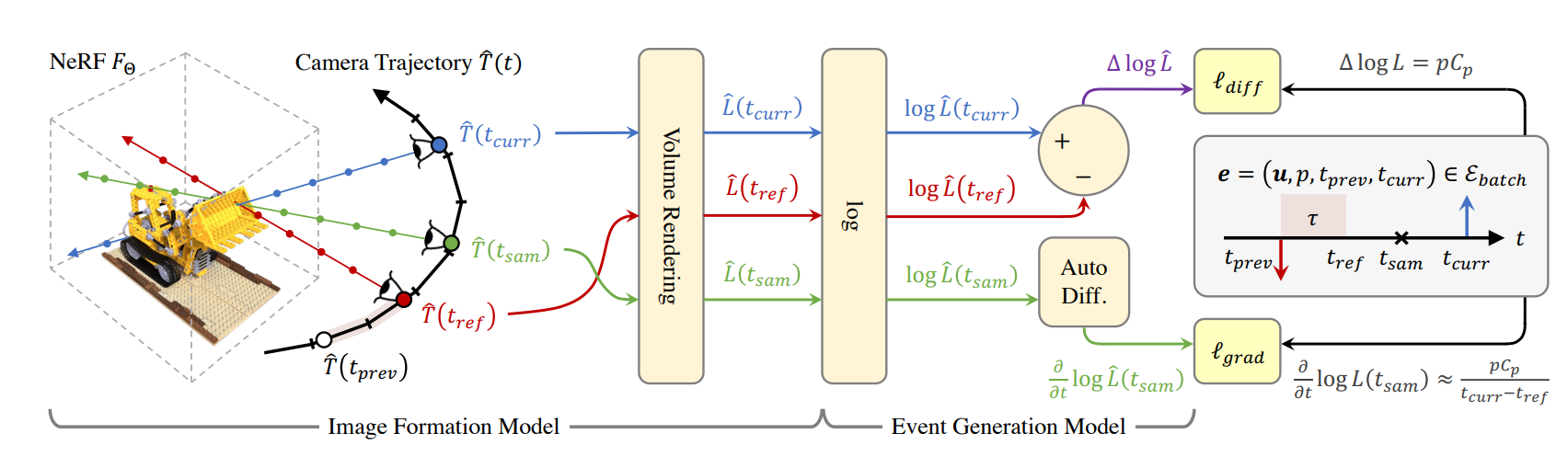

基于transformer的多帧自监督深度估计 Multi-Frame Self-Supervised Depth with Transformers

Multi-Frame Self-Supervised Depth with Transformers基于transformer的多帧自监督深度估计0 Abstract 多帧深度估计除了学习基于外观的特征外,也通过特征匹配利用图像之间的几何关系来改善单帧估计。我们采用深度离散的核极抽样来选择匹配像素,并通过一…

DETR解读,将Transformer带入CV

论文出处

[2005.12872] End-to-End Object Detection with Transformers (arxiv.org)

一个前置知识

匈牙利算法:来源于二部图匹配,计算最小或最大匹配

算法操作:在n*n的矩阵中 减去行列最小值,更新矩阵(此时行或者…

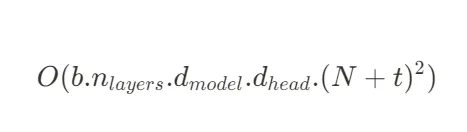

transformer系列5---transformer显存占用分析

Transformer显存占用分析 1 影响因素概述2 前向计算临时Tensor显存占用2.1 self-attention显存占用2.2 MLP显存占用 3 梯度和优化器显存占用3.1 模型训练过程两者显存占用3.2 模型推理过程两者显存占用 1 影响因素概述

模型训练框架:例如pytorch框架的cuda context…

机器学习笔记 - 对象/目标检测技术发展史概览

一、简述 物体检测算法的发展已经取得了长足的进步,从早期的计算机视觉开始,通过深度学习达到了很高的准确度。 我们首先回顾早期传统的目标检测方法:Viola-Jones 检测器、HOG 检测器和基于部件的方法,它们在该领域发展之初就被广泛使用。 然后,逐渐转向基于两阶段和一阶段…

TensorFlow的transformer类模型文件转换为pytorch

在进行transformer类模型的训练或开发时,我们会在GitHub、huggingface等平台上下载已有的模型文件。个人习惯用pytorch框架进行代码编写,然而很多时候在下载模型文件时,会遇到TensorFlow的模型,这是就涉及到转换的问题。

首先说一…

transfomer中Decoder和Encoder的base_layer的源码实现

简介

Encoder和Decoder共同组成transfomer,分别对应图中左右浅绿色框内的部分. Encoder: 目的:将输入的特征图转换为一系列自注意力的输出。 工作原理:首先,通过卷积神经网络(CNN)提取输入图像的特征。然…

transfomer的位置编码

什么是位置编码

在transformer的encoder和decoder的输入层中,使用了Positional Encoding,使得最终的输入满足: input_embeddingpositional_encoding 这里,input_embedding的shape为[n,b,embed_dim],positional_encoding和input_…

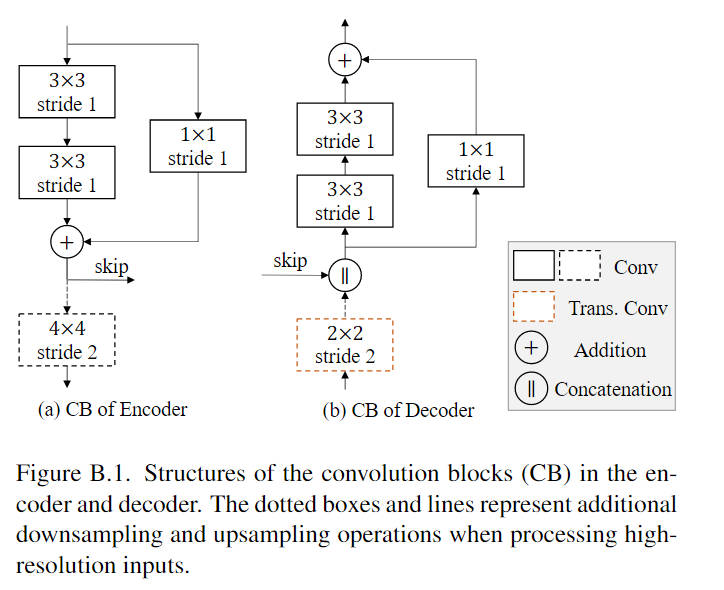

图像分割(七) —— Transformer and CNN Hybrid Deep Neural Network

Transformer and CNN Hybrid Deep Neural Network for Semantic Segmentation of Very-High-Resolution Remote Sensing ImageryAbstractMethodA. ArchitectureB. Swin Transformer-Based EncoderC. CNN-Based DecoderAbstract

本文提出了一种变压器和卷积神经网络(…

深入了解Transformer:从编码器到解码器的神经网络之旅

深入了解Transformer:从编码器到解码器的神经网络之旅

0.引言

自2017年问世以来,Transformer模型在自然语言处理(NLP)领域引发了一场革命。它的独特设计和高效性能使其成为了解决复杂语言任务的关键工具。

1.Transformer的核心…

YOLOv8优化策略:检测头结构全新创新篇 | RT-DETR检测头助力,即插即用

🚀🚀🚀本文改进:RT-DETR检测头助力YOLOv8检测,保持v8轻量级的同时提升检测精度 🚀🚀🚀YOLOv8改进专栏:http://t.csdnimg.cn/hGhVK

学姐带你学习YOLOv8,从入门到创新,轻轻松松搞定科研; 1.RT-DETR介绍 论文: https://arxiv.org/pdf/2304.08069.pdf

摘要:…

Transformer模型 | 基于Spatial-Temporal Transformer的城市交通流预测

交通预测已成为智能交通系统的核心组成部分。然而,由于交通流的高度非线性特征和动态的时空依赖性,及时准确的交通预测,尤其是长时交通流预测仍然是一个开放性的挑战。在这篇文章中,作者提出了一种新的时空Transformer网络(STTNs)模型,该模型联合利用了动态有向的空间依…

【李宏毅机器学习】Transformer 内容补充

视频来源:10.【李宏毅机器学习2021】自注意力机制 (Self-attention) (上)_哔哩哔哩_bilibili

发现一个奇怪的地方,如果直接看ML/DL的课程的话,有很多都是不完整的。开始思考是不是要科学上网。

本文用作Transformer - Attention is all you…

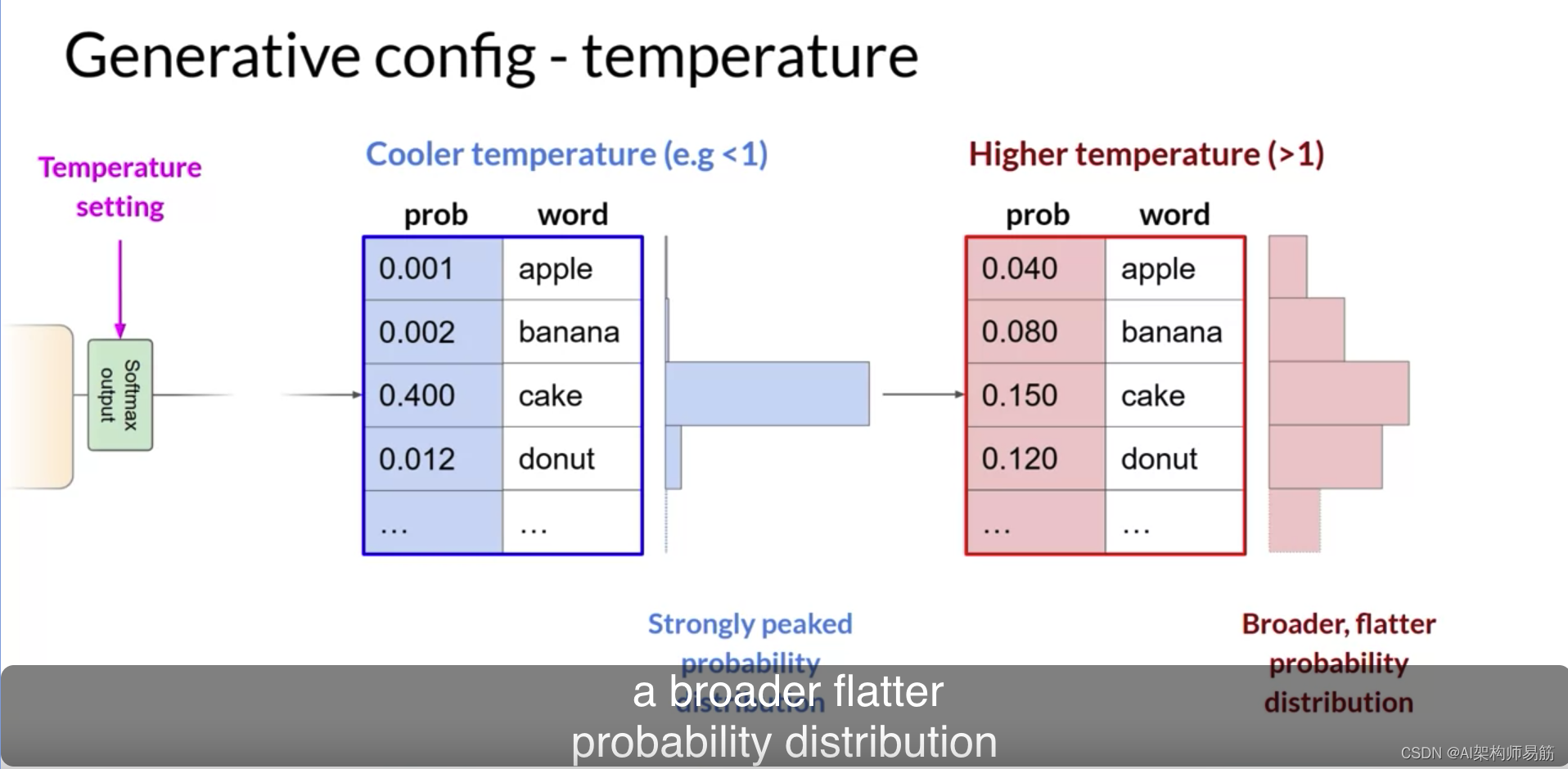

Elasticsearch:从头开始解释带有 Transformer 的生成式 AI 架构

作者:ARIS PAPADOPOULOS

这篇长篇文章解释了生成式人工智能的工作原理,从基础一直到注重直觉的生成式 transformer 架构。 这篇长篇文章解释了生成式人工智能的工作原理,从基础一直到生成式 transformer 架构。 重点是直觉,而不是…

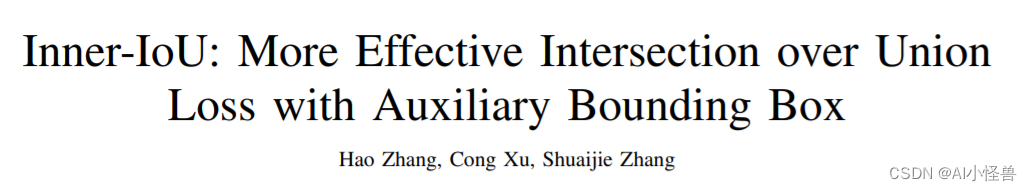

【RT-DETR改进】SIoU、GIoU、CIoU、DIoU、AlphaIoU等二十余种损失函数

一、本文介绍

这篇文章介绍了RT-DETR的重大改进,特别是在损失函数方面的创新。它不仅包括了多种IoU损失函数的改进和变体,如SIoU、WIoU、GIoU、DIoU、EIOU、CIoU,还融合了“Alpha”思想,创造了一系列新的损失函数。这些组合形式的…

为什么Transformer模型中使用Layer Normalization(Layer Norm)而不是Batch Normalization(BN)

❤️觉得内容不错的话,欢迎点赞收藏加关注😊😊😊,后续会继续输入更多优质内容❤️ 👉有问题欢迎大家加关注私戳或者评论(包括但不限于NLP算法相关,linux学习相关,读研读博…

RWKV论文燃爆!将RNN崛起进行到底!可扩百亿级参数,与Transformer表现相当!

深度学习自然语言处理 原创作者:鸽鸽 万众期待的RWKV论文来啦! 这股RNN崛起的“清流”,由民间开源组织发起,号称是第一个可扩展到百亿级参数的非transformer架构! RWKV结合了RNN和Transformer的优势:一方面…

Transformer升级之路:一种全局长度外推的新思路

©PaperWeekly 原创 作者 | 苏剑林 单位 | 追一科技 研究方向 | NLP、神经网络 说到 Transformer 无法处理超长序列的原因,大家的第一反应通常都是 Self Attention 的二次复杂度。但事实上,即便忽略算力限制,常规的 Transformer 也无法处…

RWKV – transformer 与 RNN 的强强联合

在 NLP (Natural Language Processing, 自然语言处理) 领域,ChatGPT 和其他的聊天机器人应用引起了极大的关注。每个社区为构建自己的应用,也都在持续地寻求强大、可靠的开源模型。自 Vaswani 等人于 2017 年首次提出 Attention Is All You Need 之后&am…

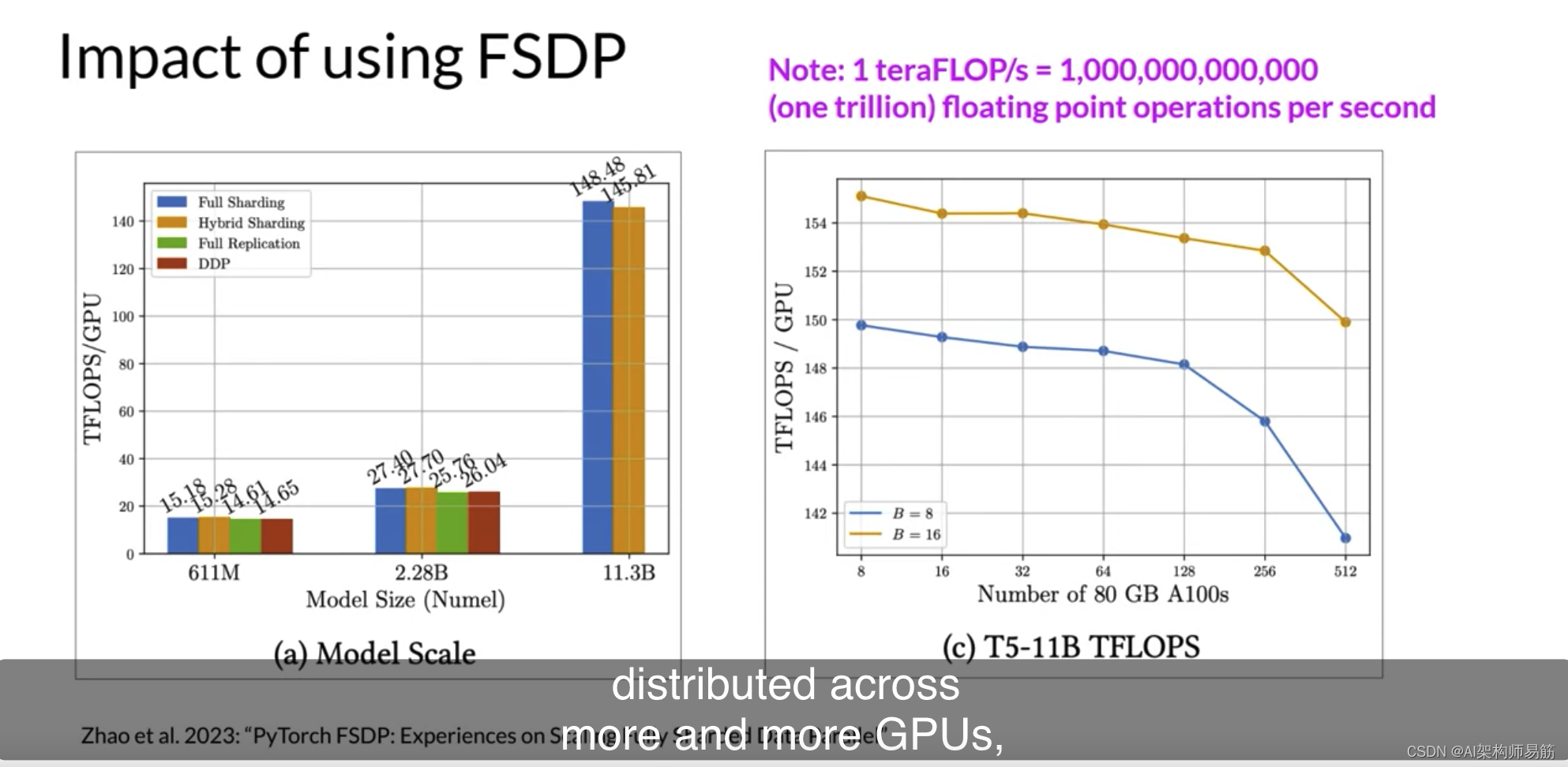

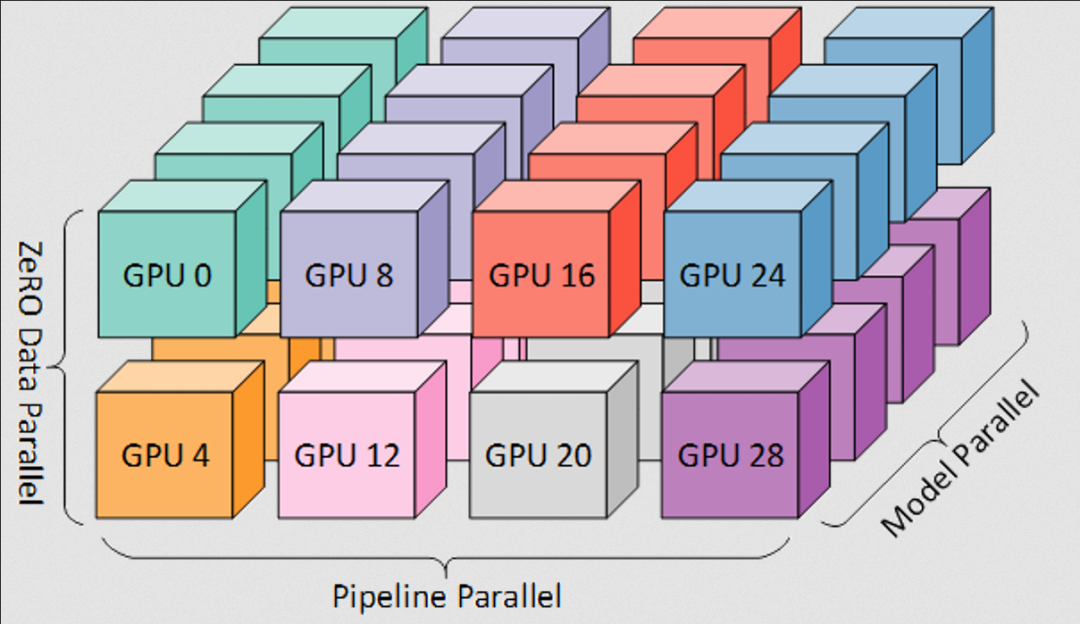

LLMs高效的多 GPU 计算策略Efficient multi-GPU compute strategies

很有可能在某个时候,您需要将模型训练工作扩展到超过一个GPU。在上一个视频中,我强调了当您的模型变得太大而无法适应单个GPU时,您需要使用多GPU计算策略。但即使您的模型确实适合单个GPU,使用多个GPU加速训练也有好处。即使您正在…

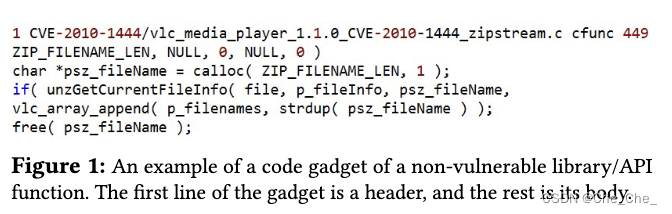

[论文分享] jTrans: Jump-Aware Transformer for Binary Code Similarity

jTrans: Jump-Aware Transformer for Binary Code Similarity [ISSTA 2022]

二进制代码相似性检测(Binary code similarity detection, BCSD)在漏洞检测、软件构件分析、逆向工程等领域具有重要应用。最近的研究表明,深度神经网络(DNNs)可以理解二进制代码的指令或…

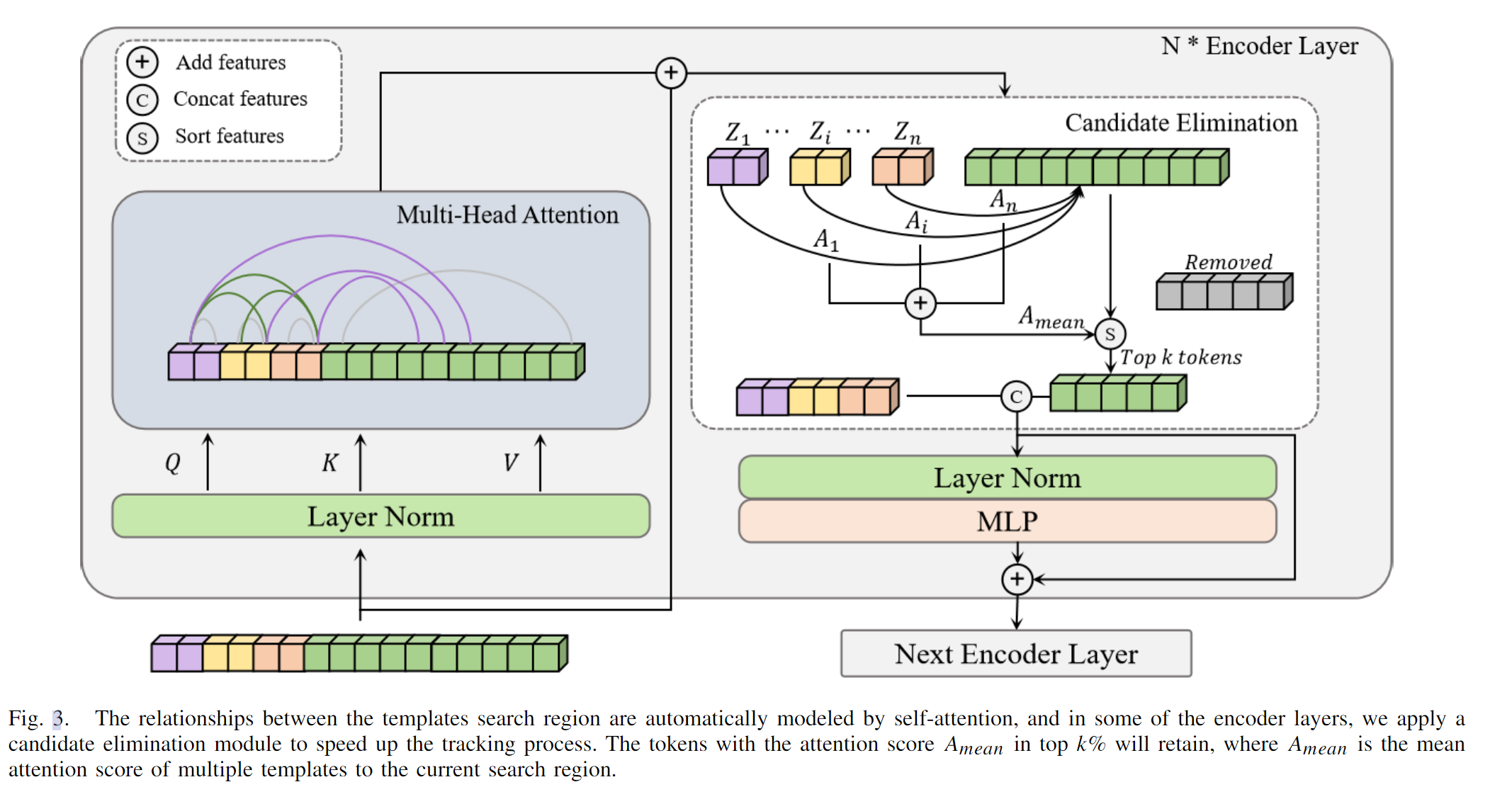

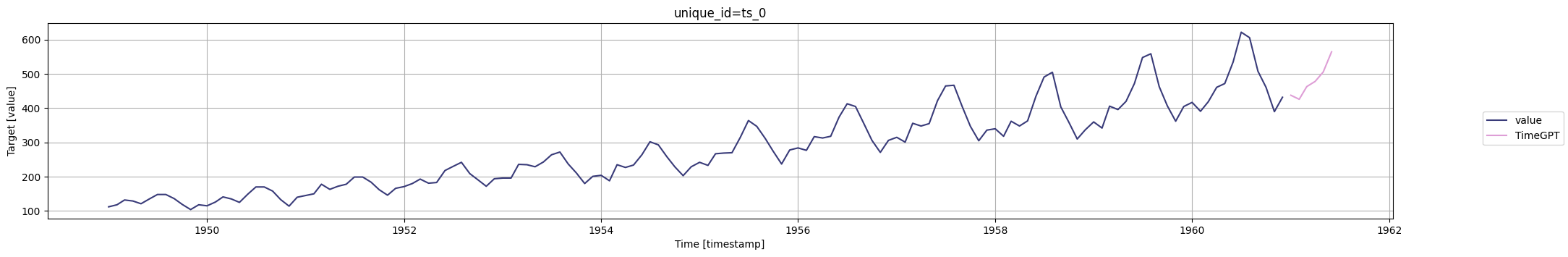

【时序分析】TimeGPT:首个时间序列分析基础大模型

TimeGPT:首个时间序列分析基础大模型 1. 论文解读1.1 研究背景1.2 TimeGPT详解1.2.1 时间序列预测问题基础1.2.2 TimeGPT架构1.2.3 训练数据集1.2.4 训练TimeGPT1.2.5 不确定性量化1.2.6 实验结果1.2.6.1 Zero-shot 推断1.2.6.2 Fine Tuning1.2.6.3 时间对比1.2.7 讨论2. Time…

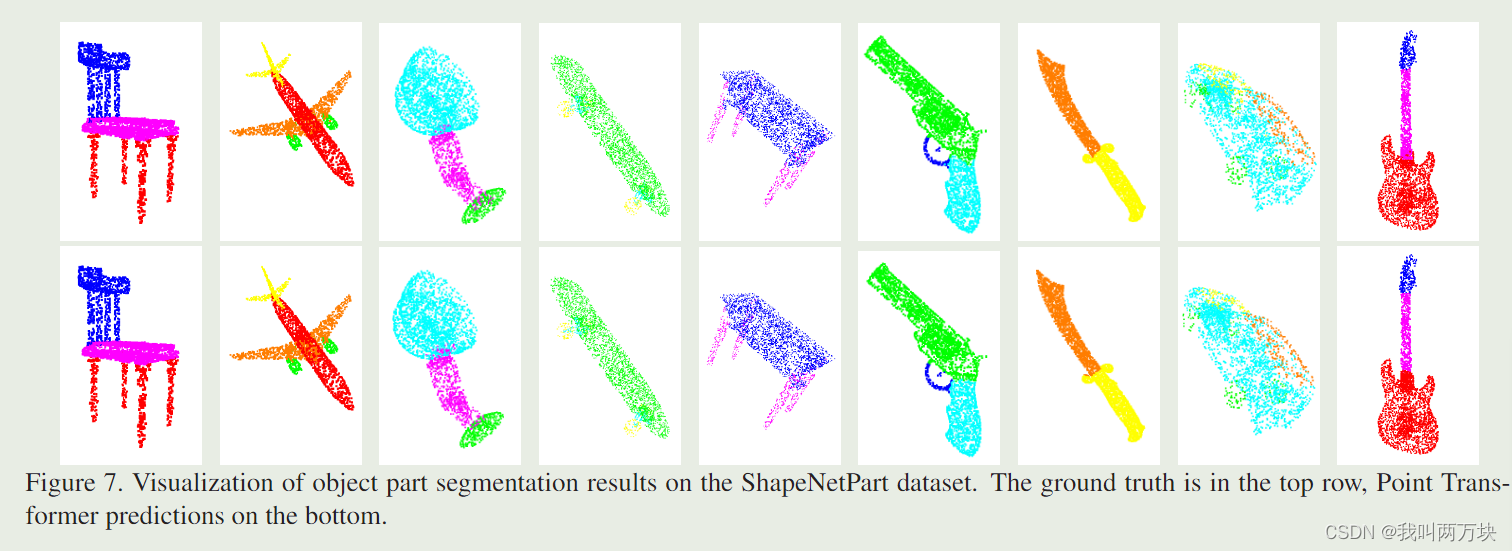

【论文解读】Point Transformer

Point Tranformer 摘要引言方法实验结论 摘要

自注意网络已经彻底改变了自然语言处理,并在图像分析任务(如图像分类和对象检测)方面取得了令人印象深刻的进展。受这一成功的启发,我们研究了自注意网络在三维点云处理中的应用。我…

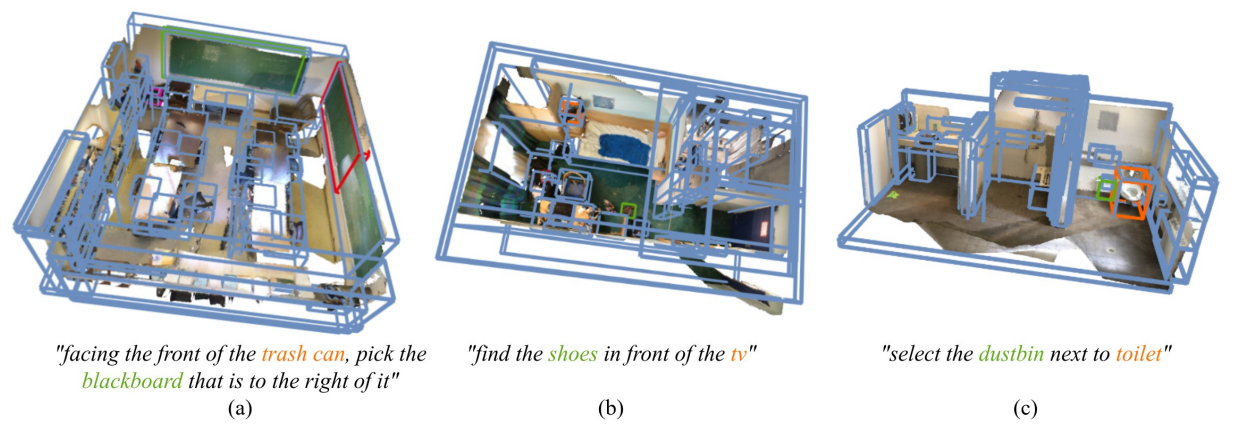

3D- vista:预训练的3D视觉和文本对齐Transformer

论文:https://arxiv.org/abs/2308.04352

代码: GitHub - 3d-vista/3D-VisTA: Official implementation of ICCV 2023 paper "3D-VisTA: Pre-trained Transformer for 3D Vision and Text Alignment"

摘要

三维视觉语言基础(3D- vl)是一个新兴领域&…

PVT(Pyramid Vision Transformer)学习记录

引言与启发

自从ViT之后,关于vision transformer的研究呈井喷式爆发,从思路上分主要沿着两大个方向,一是提升ViT在图像分类的效果;二就是将ViT应用在其它图像任务中,比如分割和检测任务上,这里介绍的PVT&a…

Transformer (Attention Is All You Need) 论文精读笔记

Transformer(Attention Is All You Need)

Attention Is All You Need

参考:跟李沐学AI-Transformer论文逐段精读【论文精读】

摘要(Abstract)

首先摘要说明:目前,主流的序列转录(序列转录:给…

The Annotated Transformer

我们不生产水,我们只是大自然的搬运工!

原文地址: The Annotated Transformer The Annotated Transformer The Annotated TransformerPrelimsBackgroundPart 1: Model ArchitectureOverall ArchitectureEncoder and Decoder StacksEncoderDecoderAttent…

vit细粒度图像分类(一)CADF学习笔记

1.摘要:

目的 基于Transformer架构的网络在图像分类中表现出优异的性能。然而,注意力机制往往只关注图像中的显著性特征,而忽略了其他区域的次级显著信息,基于自注意力机制的Transformer也是如此。为了获取更多的有效信息&#…

DETR纯代码分享(九)transformer.py

一、定义DETR Transformer用于DETR模型

"""

DETR Transformer class.Copy-paste from torch.nn.Transformer with modifications:* positional encodings are passed in MHattention* extra LN at the end of encoder is removed* decoder returns a stack of …

大模型的实践应用3-大模型的基础架构Transformer模型,掌握Transformer就掌握了大模型的灵魂骨架

大家好,我是微学AI,今天给大家介绍一下大模型的实践应用3-大模型的基础架构Transformer模型,掌握Transformer就掌握了大模型的灵魂骨架。Transformer是一种基于自注意力机制的深度学习模型,由Vaswani等人在2017年的论文《Attention is All You Need》中提出。它最初被设计用…

pandas教程:Reading and Writing Data in Text Format (以文本格式读取和写入数据)

文章目录 Chapter 6 Data Loading, Storage, and File Formats(数据加载,存储,文件格式)6.1 Reading and Writing Data in Text Format (以文本格式读取和写入数据)1 Reading Text Files in Pieces(读取一部分文本&…

自然语言处理24-T5模型的介绍与训练过程,利用简单构造数据训练微调该模型,体验整个过程

大家好,我是微学AI,今天给大家介绍一下自然语言处理24-T5模型的介绍与训练过程,利用简单构造数据训练微调该模型,体验整个过程。在大模型ChatGPT发布之前,NLP领域是BERT,T5模型为主导,T5(Text-to-Text Transfer Transformer)是一种由Google Brain团队在2019年提出的自然…

注意力机制和Transformer

注意力机制和Transformer

机器翻译是NLP领域中最重要的问题之一,也是Google翻译等工具的基础。传统的RNN方法使用两个循环网络实现序列到序列的转换,其中一个网络(编码器)将输入序列转换为隐藏状态,而另一个网络&…

【无标题】Transformer机制

这篇文章写得很详细,记录一下:

Transformer是什么?看完这篇你就醍醐灌顶_fs1341825137的博客-CSDN博客前言由谷歌团队提出的预训练语言模型BERT近年来正在各大自然语言处理任务中屠榜(话说学者们也挺有意思的,模型名都…

Illumination Adaptive Transformer

Abstract.

现实世界中具有挑战性的照明条件(低光、曝光不足和曝光过度)不仅会产生令人不快的视觉外观,还会影响计算机视觉任务。现有的光自适应方法通常单独处理每种情况。更重要的是,它们中的大多数经常在 RAW 图像上运行或过度…

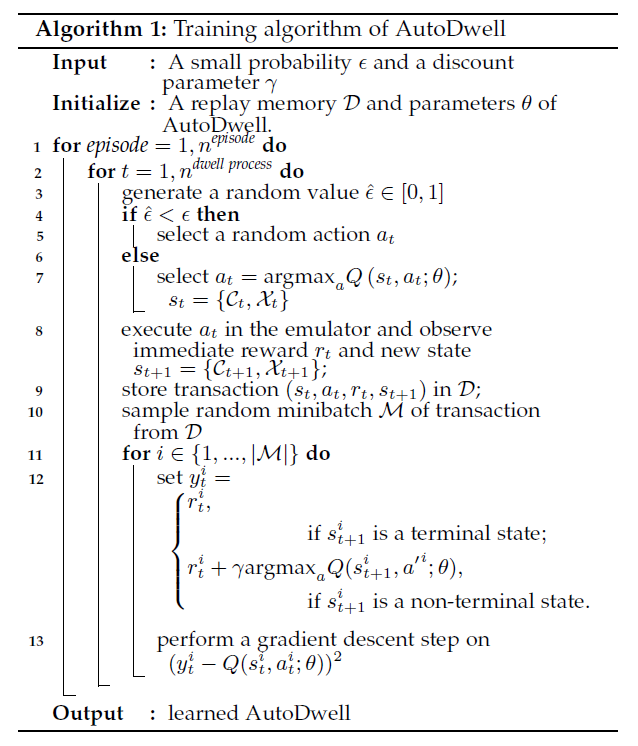

《Shortening passengers’ travel time A dynamic metro train scheduling approach using deep reinforcem》

本文目录1. 摘要2. AutoDwell系统架构2.1 离线学习程序2.2 在线部署程序3. AutoDwell3.1 列车特征提取器3.2 乘客特征提取器3.2.1 换乘站学习器3.2.2 普通站学习3.2.3 结论性循环网络3.3 融合组件3.4 算法优化1. 摘要

城市地铁已成为现代城市最重要的公共交通工具,…

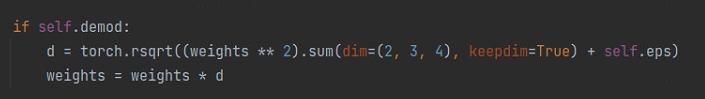

生成专题3 | StyleGAN2对AdaIN的修正

文章转自微信公众号:机器学习炼丹术作者:陈亦新(欢迎交流共同进步)联系方式:微信cyx645016617学习论文:Analyzing and Improving the Image Quality of StyleGAN 文章目录3.1 AdaIN3.2 AdaIN的问题3.3 weig…

transformer在计算机视觉中的应用

Transformer 在计算机视觉中的应用

论文地址: https://arxiv.org/abs/1706.03762 Vision Transformer

An Image is Worth 16x16 Words: Transformers for Image Recognition at Scale 代码地址: https://github.com/google-research/vision_transfor…

简单理解Transformer注意力机制

这篇文章是对《动手深度学习》注意力机制部分的简单理解。

生物学中的注意力

生物学上的注意力有两种,一种是无意识的,零一种是有意识的。如下图1,由于红色的杯子比较突出,因此注意力不由自主指向了它。如下图2,由于…

Restormer Efficient Transformer for High-Resolution Image Restoration

文章目录 Restormer代码训练和测试运行记录文章及代码地址环境安装下载数据集运行Demo训练测试 Restormer代码训练和测试运行记录

文章及代码地址

文章名称:Restormer: Efficient Transformer for High-Resolution Image Restoration(CVPR 2022&#x…

Transformer通俗笔记:从Word2Vec、Seq2Seq逐步理解到GPT、BERT

前言 我在写上一篇博客《22下半年》时,有读者在文章下面评论道:“july大神,请问BERT的通俗理解还做吗?”,我当时给他发了张俊林老师的BERT文章,所以没太在意。

直到今天早上,刷到CSDN上一篇讲B…

Yolov5轻量化:EMO,结合 CNN 和 Transformer 的现代倒残差移动模块设计,性能优于EdgeViT、Mobile-former等网络

论文: https://arxiv.org/pdf/2301.01146.pdf 🏆🏆🏆🏆🏆🏆Yolo轻量化模型🏆🏆🏆🏆🏆🏆 重新思考了 MobileNetv2 中高效的倒残差模块 Inverted Residual Block 和 ViT 中的有效 Transformer 的本质统一,归纳抽象了 MetaMobile Block 的一般概念。受这…

CvT: 如何将卷积的优势融入Transformer

【GiantPandaCV导语】与之前BoTNet不同,CvT虽然题目中有卷积的字样,但是实际总体来说依然是以Transformer Block为主的,在Token的处理方面引入了卷积,从而为模型带来的局部性。最终CvT最高拿下了87.7%的Top1准确率。

引言

CvT架…

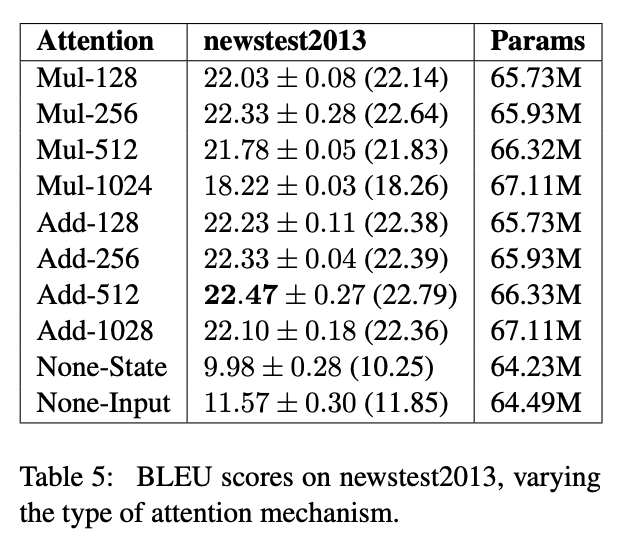

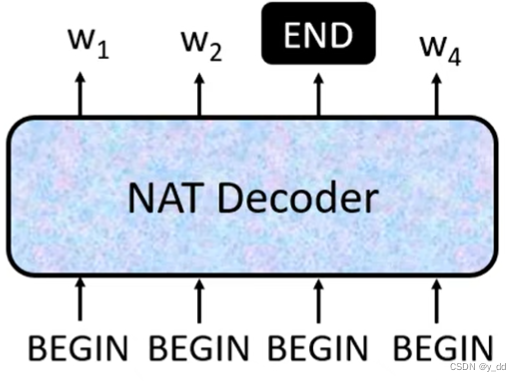

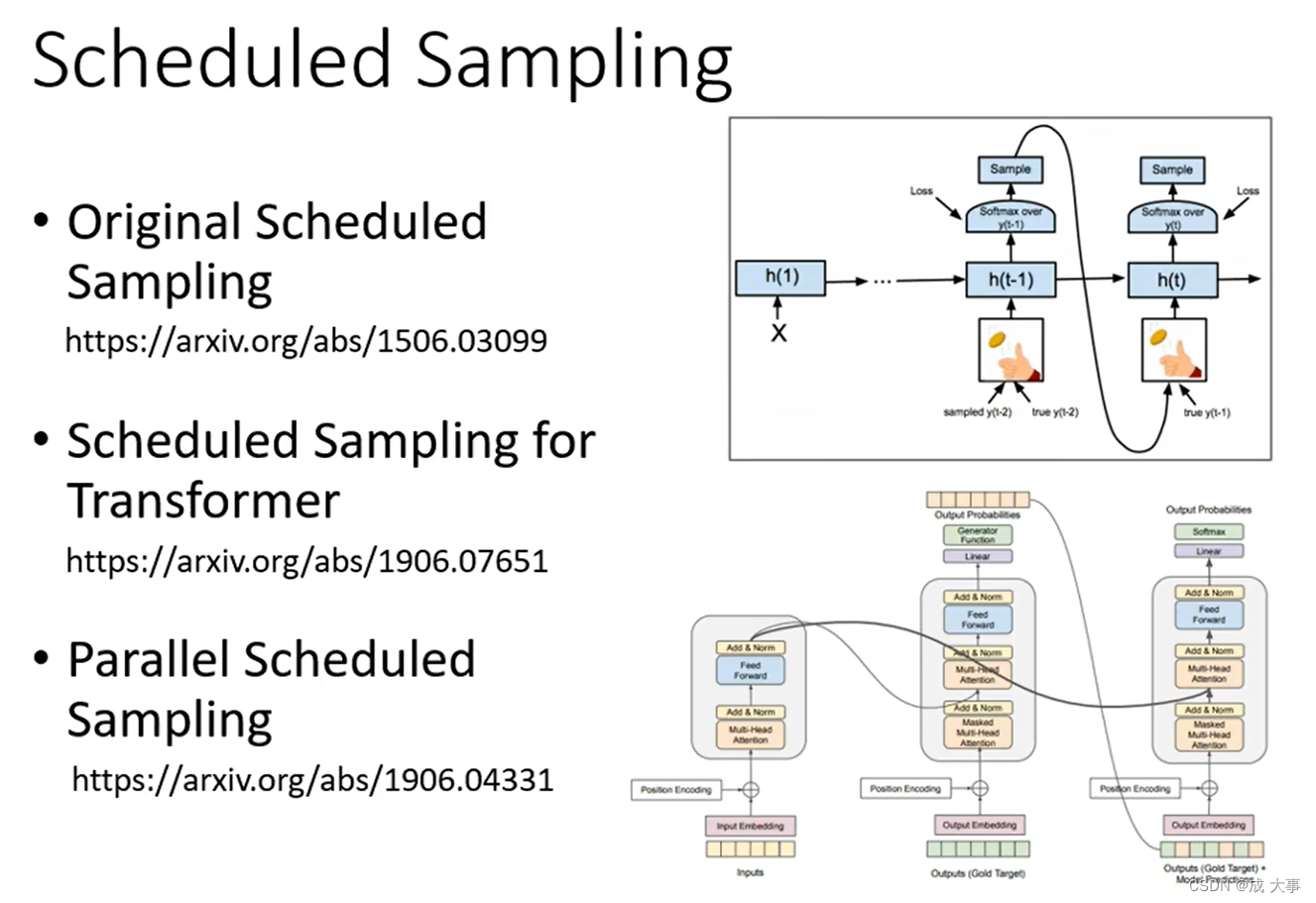

李宏毅2021春季机器学习课程笔记7: Seq2seq Transformer

文章目录1. Seq2seq2. Encoder2.1 Block2. Decoder2.1 Autoregressive(AT)2.2 Non-autoregressive(NAT)2.3 Cross attention4. Training4.1 Copy Mechanism4.2 Guided Attention4.3 Beam Search4.4 Cross entropy & BLEU scor…

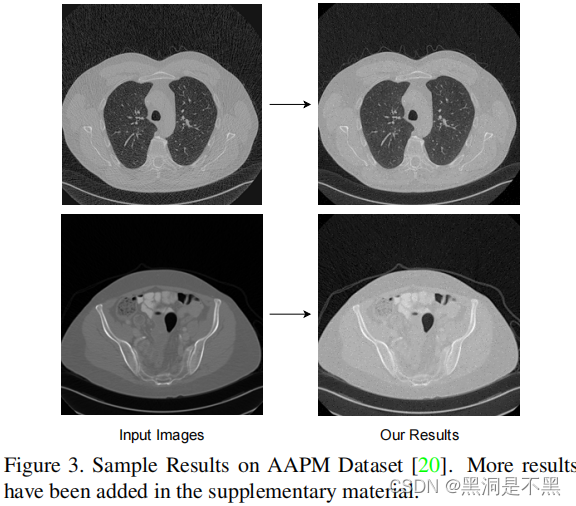

Eformer: Edge Enhancement based Transformer for Medical Image Denoising

Eformer:医学图像去噪Abstract1. Introduction2. Relate3.2 Transformer based Encoder-Decoder3.3. Downsampling & Upsampling3.4. Residual Learning3.5 Optimization3.6. Overall Network Architecture4. Results and DiscussionsAbstract

本文提出的Eform…

GPT-2(Transformer Decoder)的TensorFlow实现(附源码)

文章目录 一、GPT2实现步骤二、源码 一、GPT2实现步骤 机器学习模型的开发实现步骤一般都包含以下几个部分: 1. 遵照模型的网络架构,实现每一层(Layer/Block)的函数; 2. 将第1步中的函数组合在一起,…

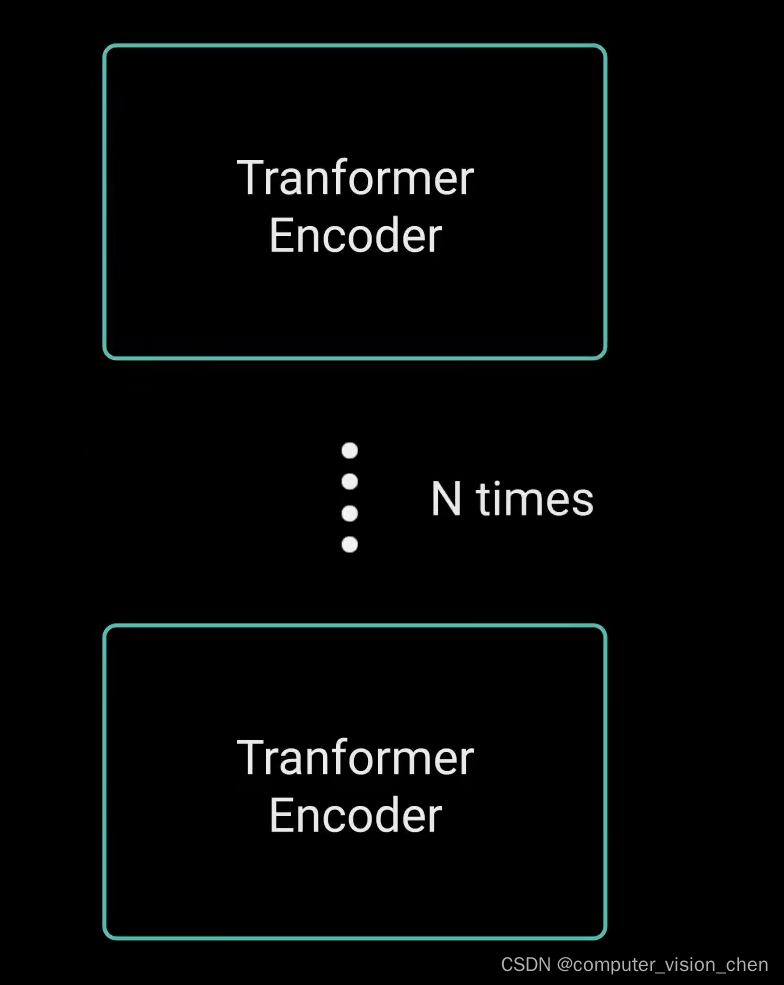

深入理解深度学习——Transformer:编码器(Encoder)部分

分类目录:《深入理解深度学习》总目录 Transformer中的编码器不止一个,而是由一组 N N N个编码器串联而成。一个编码器的输出作为下一个编码器的输入。在下图中有 N N N个编码器,每一个编码器都从下方接收数据,再输出给上方。以此…

IQT:使用Transformer进行感知图像质量评估(CVPRW)

目录📝论文下载地址🔨代码下载地址👨🎓论文作者📦模型讲解[背景介绍][Transformer][图像质量评估/IQA][衡量图像质量评估指标的准确性][模型解读][总体结构][特征提取backbone][Transformer编码器][Transformer解码器…

近80%企业首选——亚马逊云科技为中国企业出海保驾护航

随着全球数字化进程的不断加速,中国出海“大航海时代”已然到来。从#万企组团出国抢订单#到#苏州赴日包机抢单20亿元#,中国企业对海外市场的优势已经一步步建立了起来。

从卖小商品、卖鞋的“世界工厂”,到现在产业升级后的卖汽车、卖服务、…

相对位置编码(二) Relative Positional Encodings - Transformer-XL

1. Motivation

在Transformer-XL中,由于设计了segments,如果仍采用transformer模型中的绝对位置编码的话,将不能区分处不同segments内同样相对位置的词的先后顺序。

比如对于segmenti����&…

【NLP模型】文本建模(2)TF-IDF关键词提取原理

一、说明 tf-idf是个可以提取文章关键词的模型;他是基于词频,以及词的权重综合因素考虑的词价值刻度模型。一般地开发NLP将包含三个层次单元:最大数据单元是语料库、语料库中有若干文章、文章中有若干词语。这样从词频上说,就有词…

【Research】深度学习音乐生成

前言

音乐生成是音乐信息检索(MIR)的一个研究领域,旨在创造新的音乐。为了理解和比较音乐创作系统,理解人类如何感知、学习和创作音乐是至关重要的。由于不同的原因,不同的人对音乐的感知是不同的。人类音乐创作的工作流程主要由作曲家的文化背景、对音乐的理解和原创性决…

transformer的学习记录【完整代码+详细注释】(系列五)

文章目录1 解码器部分介绍2 解码器层2.1 解码作用2.2 解码器层的代码分析2.3 解码器层类的代码3 解码器3.1 解码器代码4 到目前为止完整的代码第一节:transformer的架构介绍 输入部分的实现 链接:https://editor.csdn.net/md/?articleId124648718 第二…

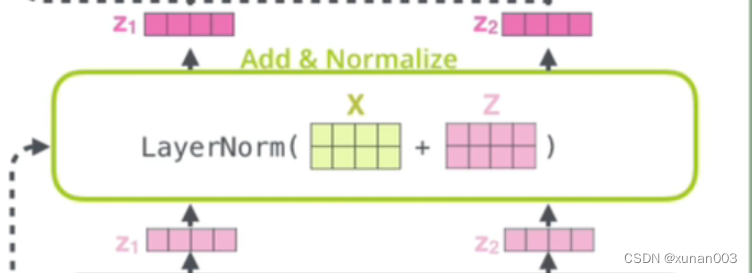

transformer的学习记录【完整代码+详细注释】(系列四)

文章目录1 子层连接结构1.1 子层连接结构的代码1.2 完整的代码就不放了,放在下一节2 编码器层2.1 编码器层的作用2.2 代码分析2.3 编码器层的代码3 编码器3.1 代码实现3.2 编码器的输出3 到目前为止的完整的代码3.1 输出第一节:transformer的架构介绍 输…

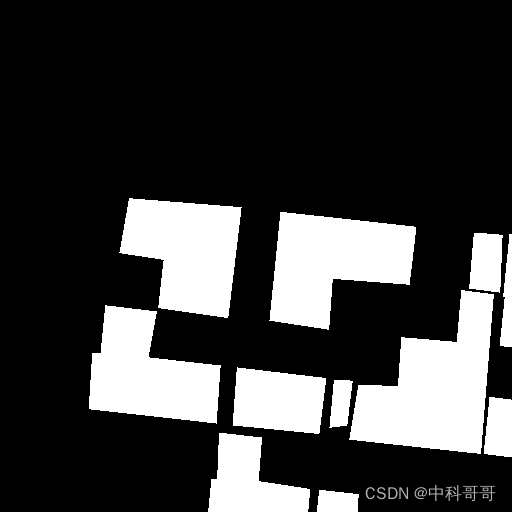

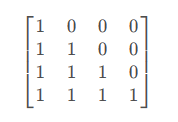

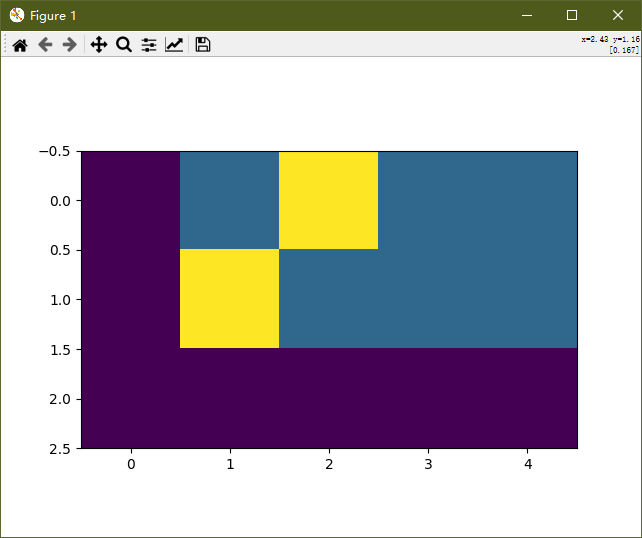

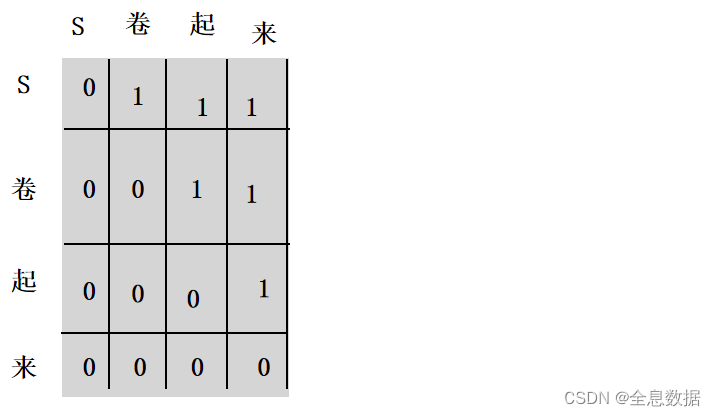

transformer的学习记录【完整代码+详细注释】(系列二)

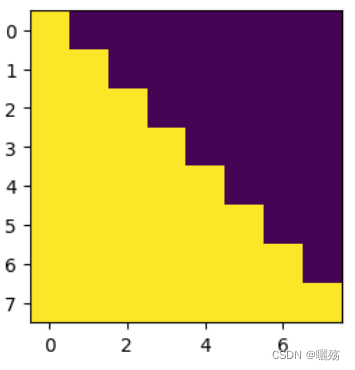

文章目录1 编码器部分实现1.1 掩码张量1.1.1 用 np.triu 生产上三角矩阵1.1.2 生成掩码张量的代码1.1.3 掩码张量可视化展示1.1.4 掩码张量学习总结1.2 注意力机制1.2.1 注意力机制 vs 自注意力机制1.2.2 注意力机制代码解读1.2.3 masked_fill 函数介绍1.2.3 注意力机制的实现代…

封神榜科技成果 - 国产训练大模型

封神榜科技成果 Fengshenbang 1.0: 封神榜开源计划1.0中英双语总论文,旨在成为中文认知智能的基础设施。 BioBART: 由清华大学和IDEA研究院一起提供的生物医疗领域的生成语言模型。(BioNLP 2022) UniMC: 针对zero-shot场景下基于标签数据集的统一模型。(EMNLP 2022)…

深入理解深度学习——Transformer:解码器(Decoder)部分

分类目录:《深入理解深度学习》总目录

相关文章: 注意力机制(Attention Mechanism):基础知识 注意力机制(Attention Mechanism):注意力汇聚与Nadaraya-Watson核回归 注意力机制&…

微调Hugging Face中图像分类模型

前言

本文主要针对Hugging Face平台中的图像分类模型,在自己数据集上进行微调,预训练模型为Google的vit-base-patch16-224模型,模型简介页面。代码运行于kaggle平台上,使用平台免费GPU,型号P100,笔记本地址…

timm使用swin-transformer

1.安装

pip install timm2.timm中有多少个预训练模型

#timm中有多少个预训练模型

model_pretrain_list timm.list_models(pretrainedTrue)

print(len(model_pretrain_list), model_pretrain_list[:3])3加载swin模型一般准会出错

model_ft timm.create_model(swin_base_pat…

改进YOLOv7系列:首发最新结合多种X-Transformer结构新增小目标检测层,让YOLO目标检测任务中的小目标无处遁形

💡该教程包含大量的原创首发改进方式, 所有文章都是原创首发改进内容🚀 降低改进难度,改进点包含最新最全的Backbone部分、Neck部分、Head部分、注意力机制部分、自注意力机制部分等完整教程🚀💡本篇文章基于 基于 YOLOv7、YOLOv7-Tiny 等网络 首发最新结合多种X-Trans…

一文看懂Transformer(详解)

文章目录Transformer前言网络结构图:EncoderInput EmbeddingPositional Encoderself-attentionPadding maskAdd & NormFeed ForwardDecoderinputmasked Multi-Head Attentiontest时的Decoder预测Transformer

前言

Transformer最初是用于nlp领域的翻译任务。

…

消除视觉Transformer与卷积神经网络在小数据集上的差距

摘要:本文通过多种操作构建混合模型,增强视觉Transformer捕捉空间相关性的能力和其进行通道多样性表征的能力,弥补了Transformer在小数据集上从头训练的精度与传统的卷积神经网络之间的差距。本文分享自华为云社区《[NeurIPS 2022] 消除视觉T…

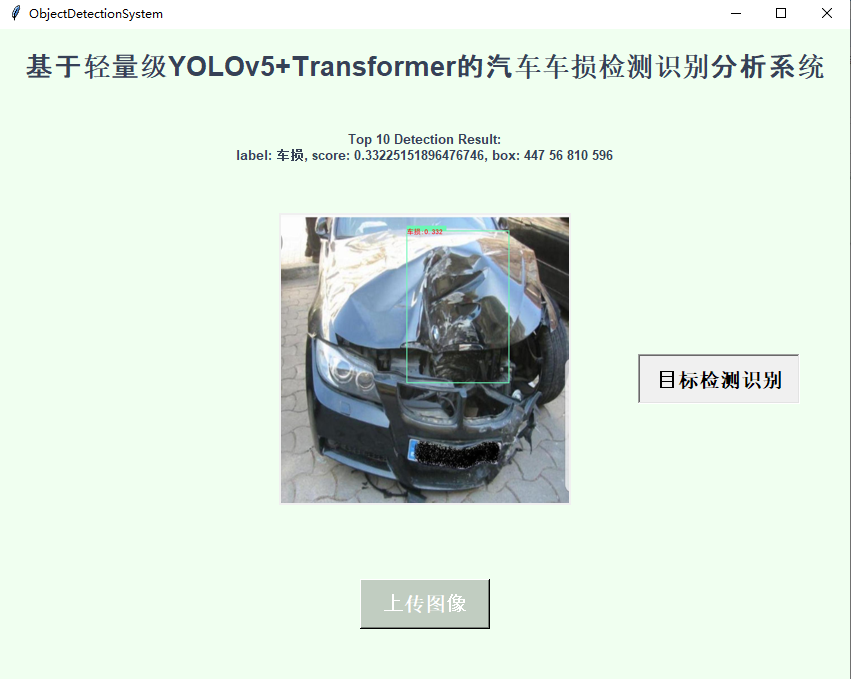

基于轻量级YOLOv5+Transformer的汽车车损检测识别分析系统

将传统NLP领域提出来的Transformer技术与yolo目标检测模型融合已经成为一种经典的做法,早在之前的很多论文里面就有这种组合应用的出现了,本文主要是借鉴前文的思路,开发基于yolov5transformer的汽车车损检测识别模型,首先看下效果…

RoFormer: Enhanced Transformer with Rotary Position Embedding论文解读

RoFormer: Enhanced Transformer with Rotary Position Embedding 论文:RoFormer: Enhanced Transformer with Rotary Position Embedding (arxiv.org)

代码:ZhuiyiTechnology/roformer: Rotary Transformer (github.com)

期刊/会议:未发表…

Transformer:开启CV研究新时代

来源:投稿 作者:魔峥 编辑:学姐 起源回顾

有关Attention的论文早在上世纪九十年代就提出了。

在2012年后的深度学习时代,Attention再次被翻了出来,被用在自然语言处理任务,提高RNN模型的训练速度。但是由…

基于Transformer的交通预测模型部分汇总【附源代码】

交通预测一直是一个重要的问题,它涉及到交通运输系统的可靠性和效率。随着人工智能的发展,越来越多的研究者开始使用深度学习模型来解决这个问题。其中,基于Transformer的交通预测模型在近年来备受关注,因为它们具有优秀的建模能力…

Transformer在CV上的应用-论文总结

年份会议/期刊标题内容领域架构图2017NIPSAttention is all you need(Transformer)贡献:提出了一种新的简单的网络架构Transformer,它完全基于注意力机制,完全不需要递归和卷积。 做法:Encoder and Decoder Stacks,self-attention…

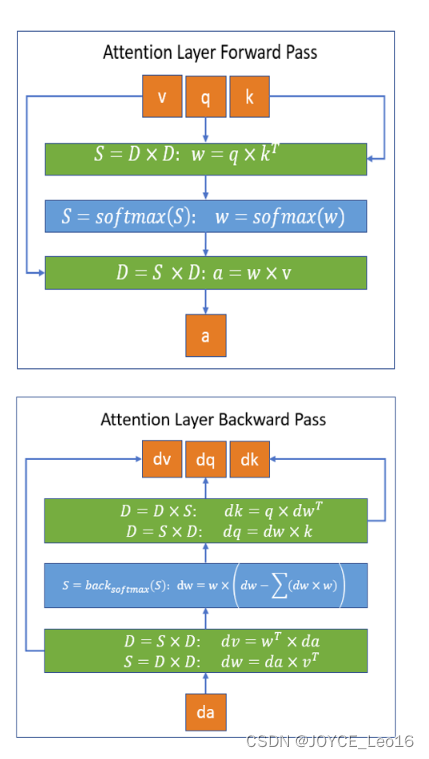

深度学习注意力机制(MHA)的训练(Eigen)

简介

本文使用Eigen3在Transformer模型中实现多头注意力的前向传播和反向传播。具体来说,这个eigenMHA (eigenDNN)【源码:https://github.com/jundaf2/eigenMHA】所对应了大致如下的cuDNN的api的功能:

cudnnCreateAttnDescriptor()cudnnSet…

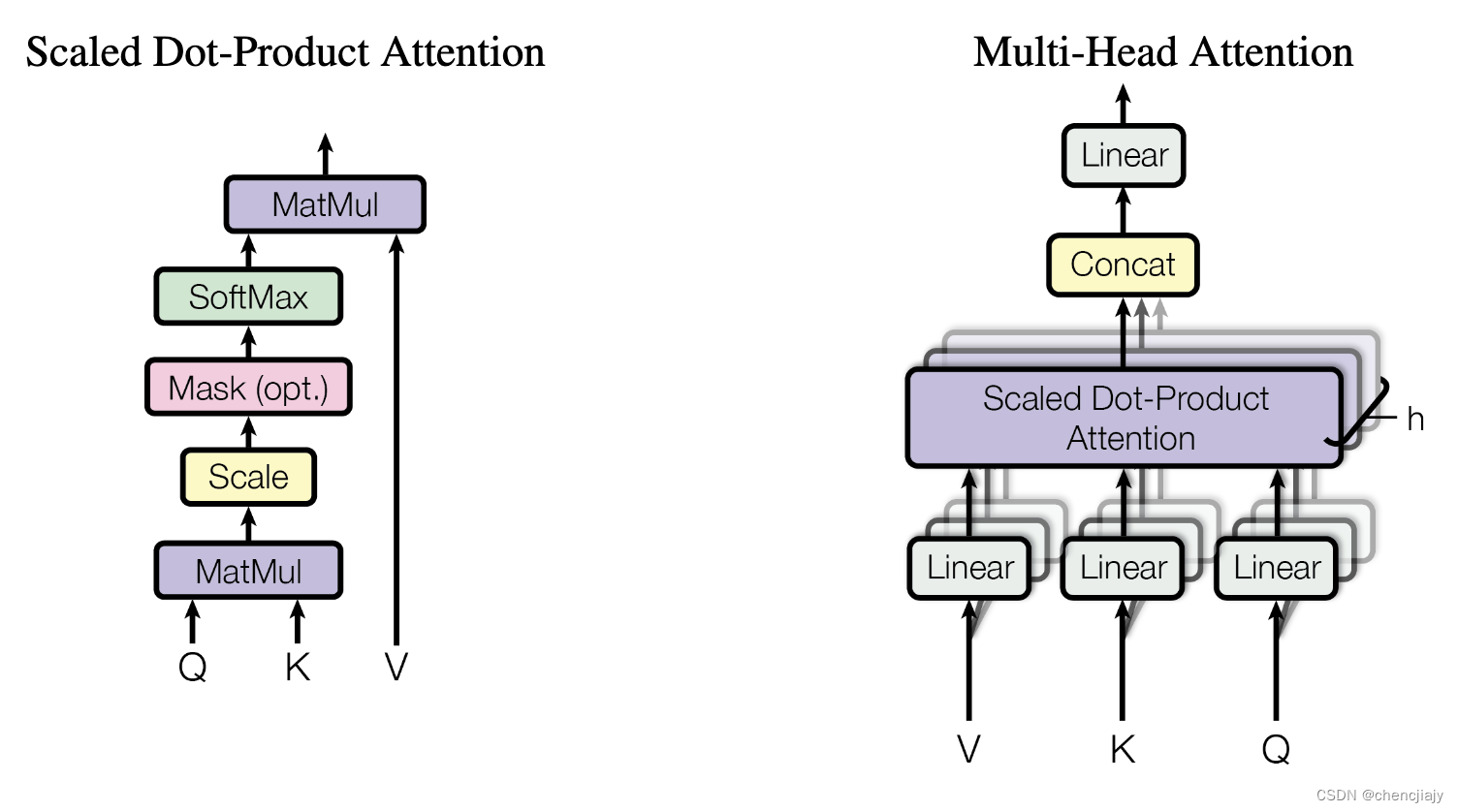

【Transformer】Self-Attention Multi-Head Attention 等解析

【Transformer】Self-Attention 、Multi-Head Attention、位置编码、Mask等解析 文章目录【Transformer】Self-Attention 、Multi-Head Attention、位置编码、Mask等解析1. 介绍2. 模型2.1 Self-Attention2.2 Multi-Head Attention2.3 Self-Attention与Multi-Head Attention 对…

一文理解Transformer整套流程

【备注】部分图片引至他人博客,详情关注参考链接

【PS】query 、 key & value 的概念其实来源于推荐系统。基本原理是:给定一个 query,计算query 与 key 的相关性,然后根据query 与 key 的相关性去找到最合适的 value。举个例…

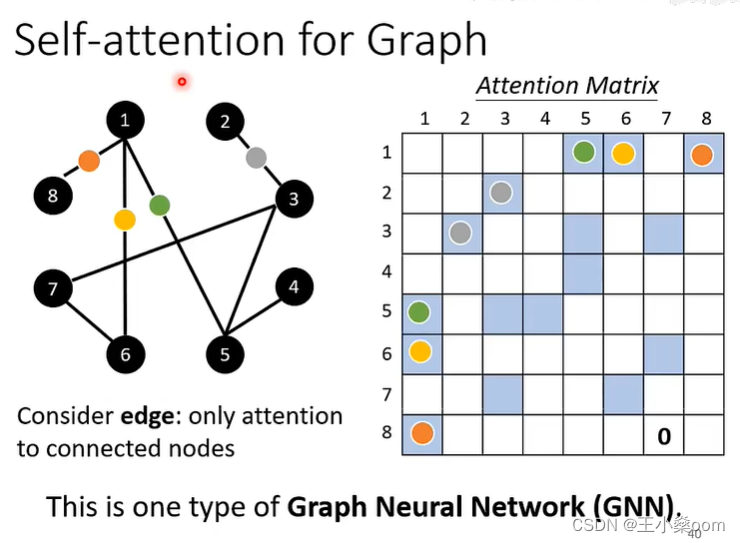

Graph Transformer系列论文阅读

文章目录research1.《Do Transformers Really Perform Bad for Graph Representation》【NeurIPS 2021 Poster】2.《Relational Attention: Generalizing Transformers for Graph-Structured Tasks》【ICLR2023-spotlight】survey推荐一个汇总Graph Transformer论文的项目&…

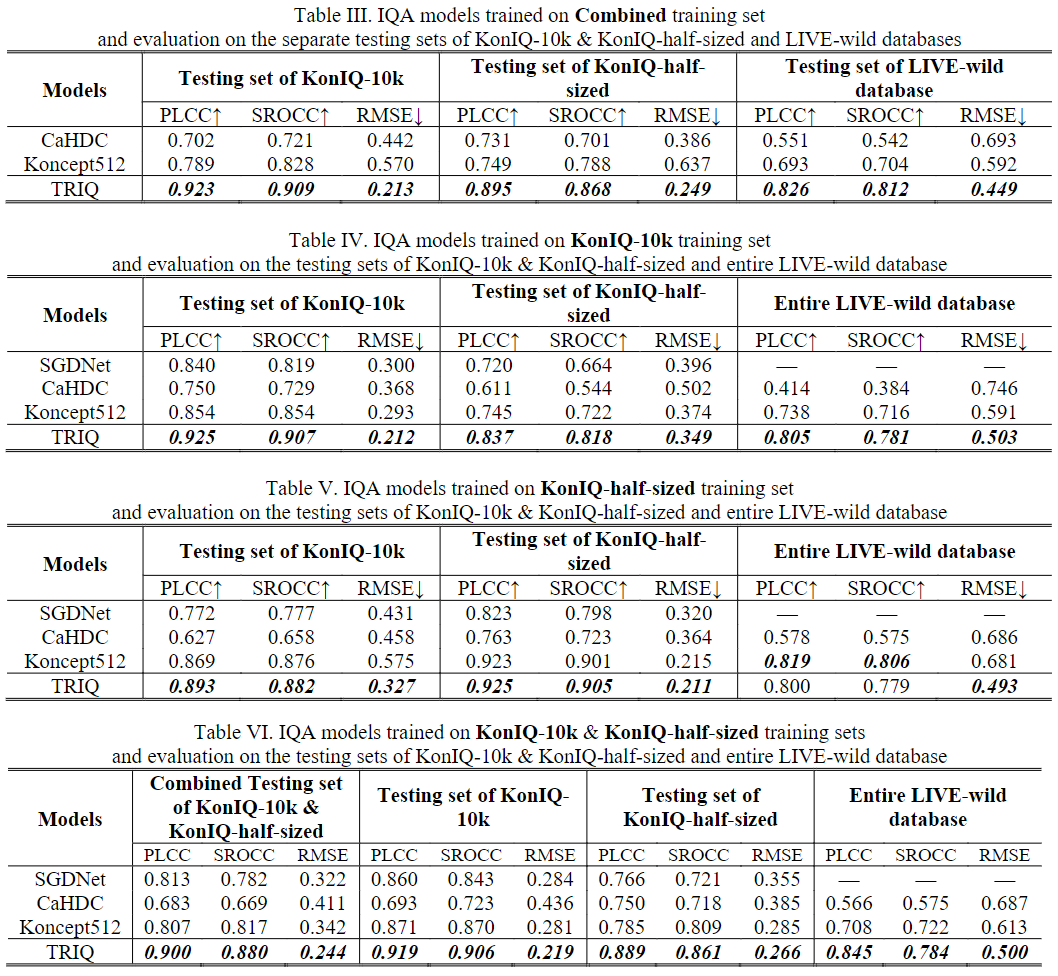

TRIQ:用于图像质量评估的Transformer(ICIP)

目录📝论文下载地址🔨代码下载地址👨🎓论文作者📦模型讲解[背景介绍][Transformer][图像质量评估/IQA][模型解读][总体结构][通用TRIQ模型][TRIQ的Transformer][结果分析]📝论文下载地址 [论文地址]

&am…

【NLP相关】Transformer模型:从Seq2Seq到自注意力机制(Transformer原理、公式推导和案例)

❤️觉得内容不错的话,欢迎点赞收藏加关注😊😊😊,后续会继续输入更多优质内容❤️👉有问题欢迎大家加关注私戳或者评论(包括但不限于NLP算法相关,linux学习相关,读研读博…

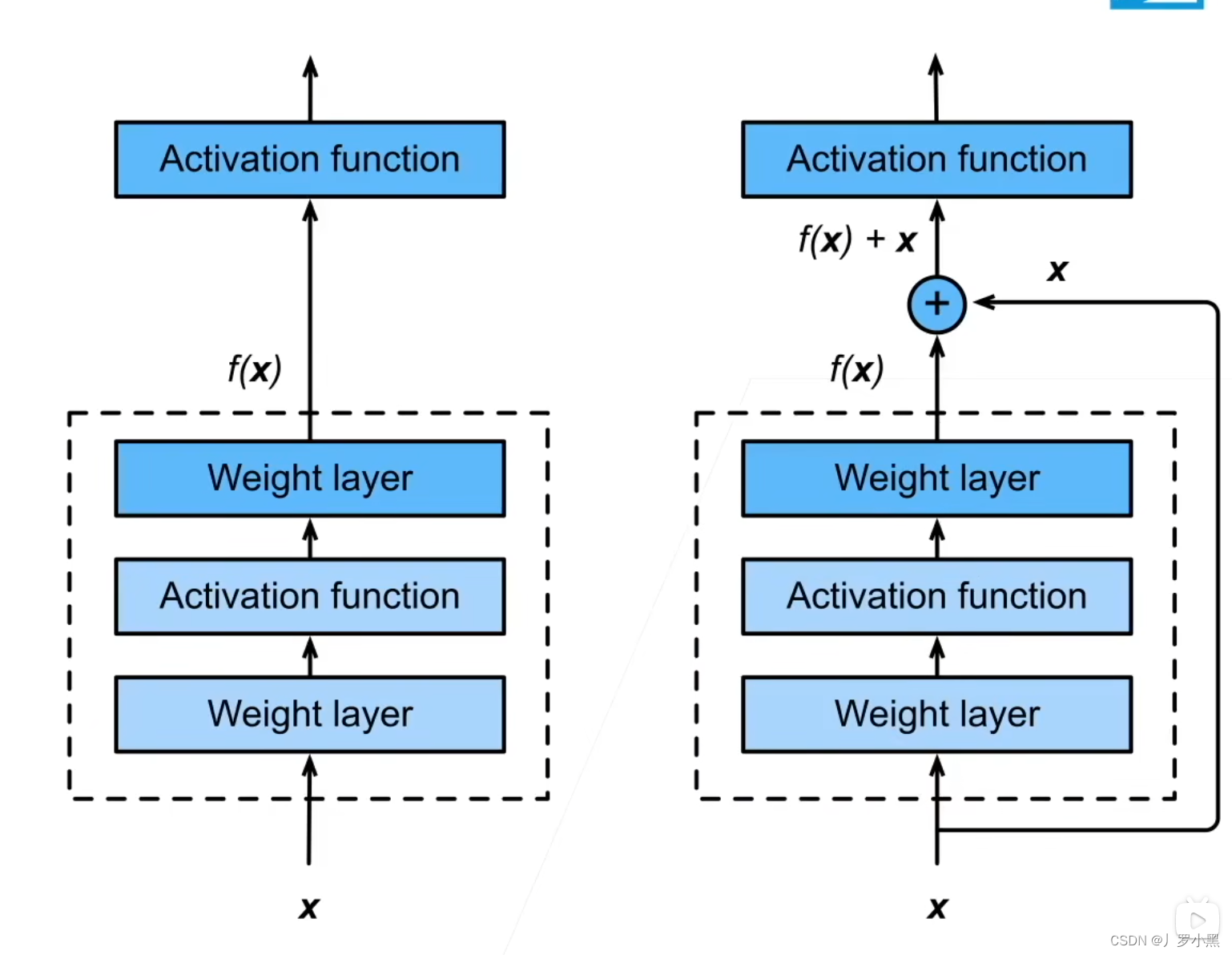

Transformer - Skip connection-解读

Transformer - Skip connection理解

skip connection是一种广泛应用于提高深度神经网络性能和收敛性的技术,它通过神经网络层传播的线性分量,缓解了非线性变化难以收敛的情况。在Transformer中,patch如果较小,就会出现spurious g…

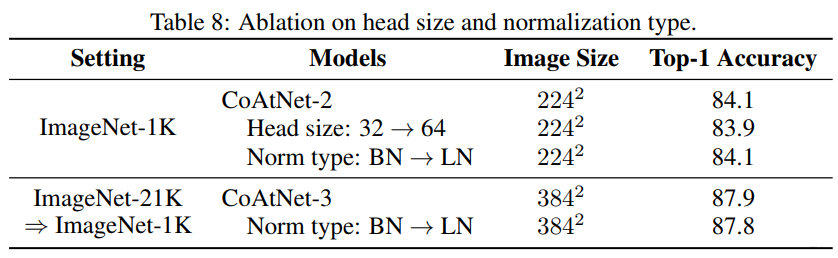

CoAtNet: 90.88% Paperwithcode榜单第一,层层深入考虑模型设计

【GiantPandaCV导语】CoAtConvolution Attention,paperwithcode榜单第一名,通过结合卷积与Transformer实现性能上的突破,方法部分设计非常规整,层层深入考虑模型的架构设计。 引言

Transformer模型的容量大,由于缺乏…

CeiT:训练更快的多层特征抽取ViT

【GiantPandaCV导语】来自商汤和南洋理工的工作,也是使用卷积来增强模型提出low-level特征的能力,增强模型获取局部性的能力,核心贡献是LCA模块,可以用于捕获多层特征表示。

引言

针对先前Transformer架构需要大量额外数据或者额…

CNN、Transformer、MLP的经验性分析

A Battle of Network Structures: An Empirical Study of CNN, Transformer, and MLP

【GiantPandaCV导语】ViT的兴起挑战了CNN的地位,随之而来的是MLP系列方法。三种架构各有特点,为了公平地比较几种架构,本文提出了统一化的框架SPACH来对比…

人工智能课程笔记:注意力机制 Transformer

文章目录 1.注意力机制2.Transformer模型3.Swin Transformer模型4.预训练语言模型4.1.ELMo模型4.2.GPT模型4.3.BERT模型 1.注意力机制

注意力机制应用于RNN网络的原理:加入了注意力机制的RNN网络会在接下来进行预测时重点关注序列中的一部分,重点基于关…

初识Transformer

参考:【NLP】Transformer模型原理详解 - 知乎 从RNN到“只要注意力”——Transformer模型 - 知乎 Attention机制提出后,加入attention的Seq2seq模型在各个任务上都有了提升,所以现在的seq2seq模型指的都是结合RNN和attention的模型。之后goog…

机器翻译——Seq2Seq模型到attention机制到Transformer

文章目录1 理论部分2 Seq2Seq (15-16年比较流行)2 基于attention的Seq2Seq3 Transformer1 理论部分

Seq2Seq模型Attention Seq2SeqTransformer

2 Seq2Seq (15-16年比较流行)

如下图所示,Encoder和Decoder部分&…

深度学习笔记之Transformer(二)关于注意力分数的总结

深度学习笔记之Transformer——关于注意力分数的总结 引言回顾: Nadaraya-Watson \text{Nadaraya-Watson} Nadaraya-Watson核回归再回首: Seq2seq \text{Seq2seq} Seq2seq中的注意力机制注意力机制的泛化表示加性注意力机制缩放点积注意力机制 引言

上一…

transformer的学习记录【完整代码+非常详细】(系列一)

文章目录1 transformer架构介绍1.1 简单介绍输入部分1.2 简单介绍输出部分1.3 简单介绍编码器部分1.4 简单介绍解码器部分2 输入部分实现2.1 Embedding 的介绍2.1.1 采用随机初始化2.1.2 采用word2vec2.1.3 采用随机初试化的实战代码2.2 位置编码器实现2.3 输出位置矩阵2.4 总结…

李宏毅transformer讲解;B站内测“搜索AI助手”功能

🦉 AI新闻

🚀 B站内测“搜索AI助手”功能

摘要:据反馈,B站正在内测“搜索 AI 助手”功能。用户在搜索框内输入问句或在搜索词中添加“?”即可体验此新功能。截图显示,该功能会为用户的搜索提供一个生成的答案&#…

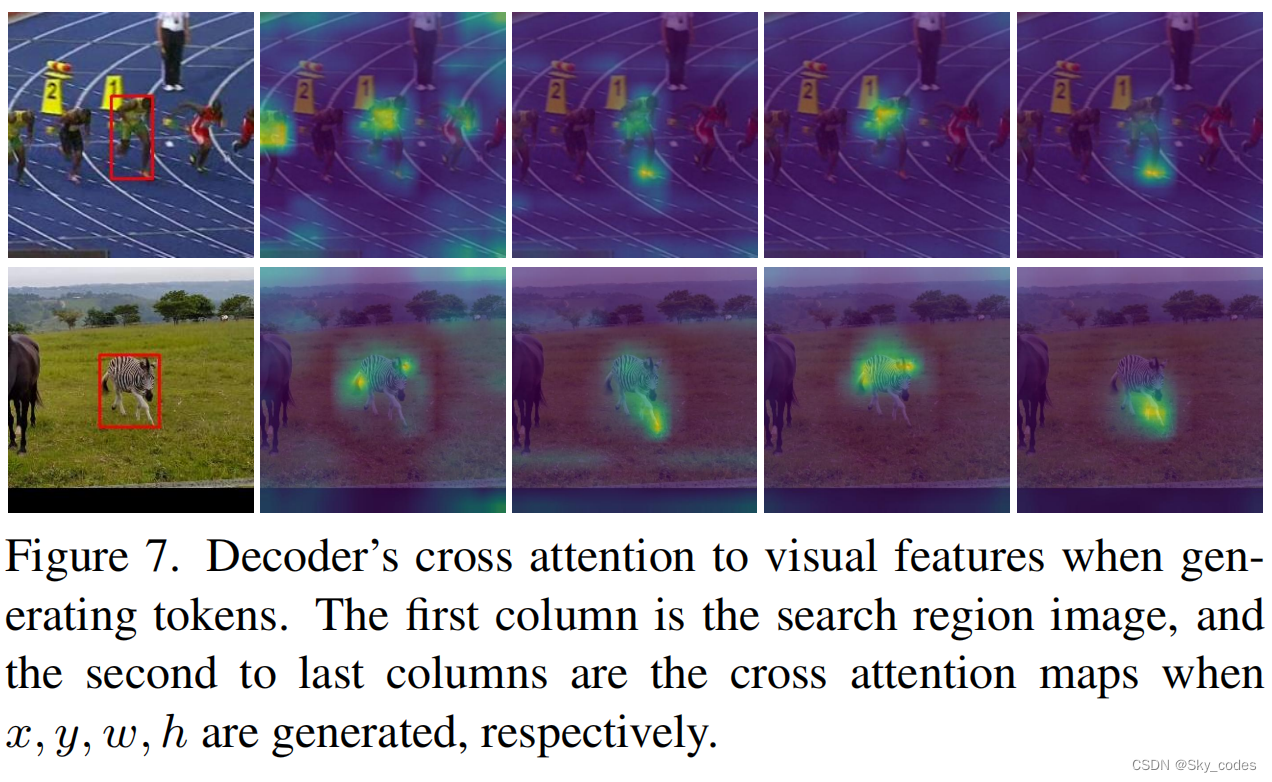

SeqTrack: Sequence to Sequence Learning for Visual Object Tracking

摘要

在本文中,我们提出了一种新的序列到序列学习框架的视觉跟踪,称为SeqTrack。它将视觉跟踪转换为一个序列生成问题,它以自回归的方式预测对象边界盒。这与之前的Siamese跟踪器和transformer跟踪器不同,它们依赖于设计复杂的磁…

【人工智能与深度学习】注意力机制和Transformer

【人工智能与深度学习】注意力机制和Transformer 注意力机制自我注意力 (I)硬注意力软注意力自我注意力 (II)高性能键-值存储查询,键和值[The Transformer](https://www.youtube.com/watch?v=f01J0Dri-6k&t=2114s)编码器-解码器结构编码模块自我注意力Add, Norm1D-卷积解…

简要介绍 | 深度学习中的自注意力机制:原理与挑战

注1:本文系“简要介绍”系列之一,仅从概念上对深度学习中的自注意力机制进行非常简要的介绍,不适合用于深入和详细的了解。 注2:"简要介绍"系列的所有创作均使用了AIGC工具辅助 深度学习中的自注意力机制:原…

pytorch笔记:transformer 和 vision transformer

来自B站视频,API查阅,TORCH.NN

seq2seq 可以是 CNN,RNN,transformer nn.Transformer 关键源码:

encoder_layer TransformerEncoderLayer(d_model, nhead, dim_feedforward, dropout,activation, layer_norm_eps, ba…

论文阅读 - SegFormer

文章目录 1 概述2 模型说明2.1 总体结构2.2 Hierarchical Transformer Encoder2.3 Lightweight All-MLP Decoder 3 SegFormer和SETR的比较参考资料 1 概述

图像分割任务和图像分类任务是非常相关的,前者是像素级别的分类,后者是图像级别的分类。基于分类…

YOLOv5-7.0添加BottleNet transformer

YOLOv5主干特征提取网络为CNN网络,CNN具有平移不变性和局部性,缺乏全局建模长距离建模的能力,引入自然语言领域的Transformer可以形成CNNTransFormer架构,充分结合两者的优点,提高目标检测效果。

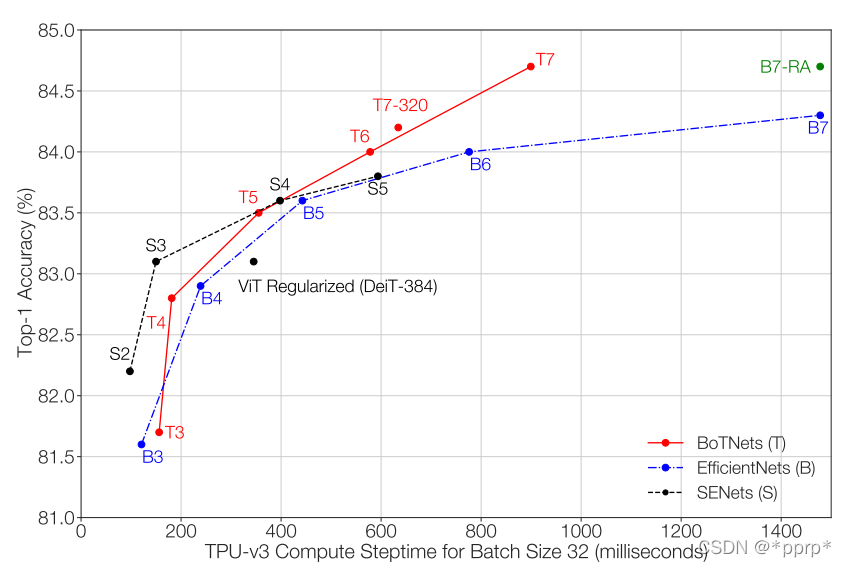

1. BoTNet

论文地址…

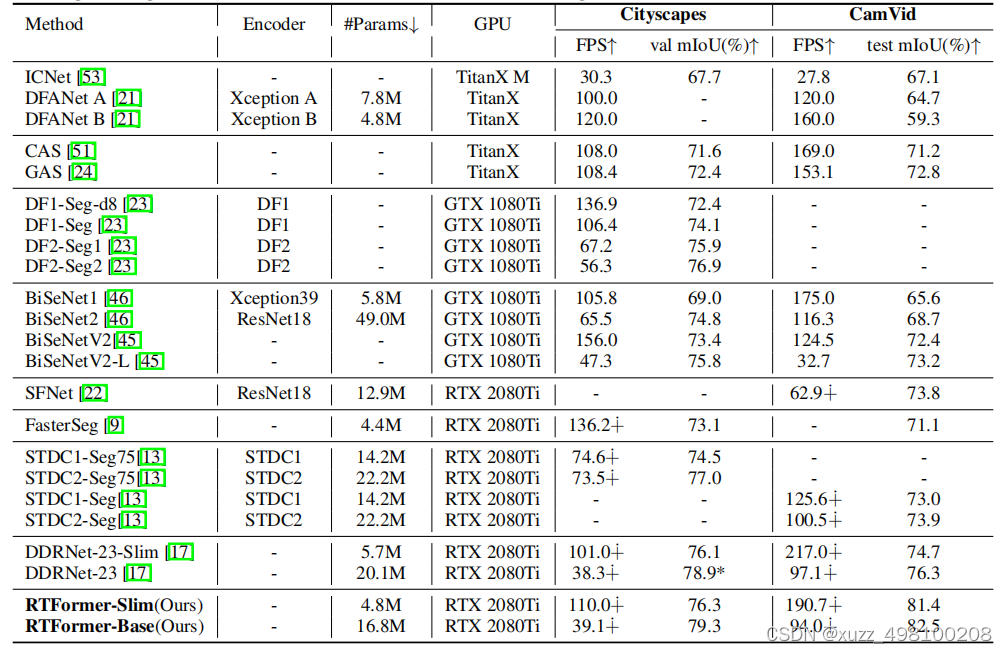

语义分割之RTFormer介绍

语义分割之RTFormer介绍

论文链接:https://arxiv.org/abs/2210.07124 代码地址:https://github.com/PaddlePaddle/PaddleSeg

ViT以来,Transformer作为特征提取器在语义分割领域证明了自己,但是由于Transformer的核心 muti-self-…

【跟着代码读论文】ViT(2021 ICLR)An image is worth 16x16 words: Transformers for image recognition at scale

论文: An image is worth 16x16 words: Transformers for image recognition at scale.

Github code(PyTorch Implementation):https://github.com/lucidrains/vit-pytorch 目录

Model Overview

Github Code Usage

Procedure …

Hugging Face 中文预训练模型使用介绍及情感分析项目实战

Hugging Face 中文预训练模型使用介绍及情感分析项目实战

Hugging Face 一直致力于自然语言处理NLP技术的平民化(democratize),希望每个人都能用上最先进(SOTA, state-of-the-art)的NLP技术,而非困窘于训练资源的匮乏"

其中,transformer库提供了NLP领域大量…

transformer库使用

Transformer库简介

是一个开源库,其提供所有的预测训练模型,都是基于transformer模型结构的。

Transformer库

我们可以使用 Transformers 库提供的 API 轻松下载和训练最先进的预训练模型。使用预训练模型可以降低计算成本,以及节省从头开…

Transformer结构解读

咱们还是照图讨论,transformer结构图如下,本文主要讨论Encoder部分:图一一、首先说一下Encoder的输入部分:在NLP领域,个人理解,这个inputs就是我们的句子分词之后的词语,比如“我,喜…

Transformer结构解读(Multi-Head Attention、AddNorm、Feed Forward)

咱们还是照图讨论,transformer结构图如下,本文主要讨论Encoder部分,从低端输入inputs开始,逐个结构进行:图一一、首先说一下Encoder的输入部分:在NLP领域,个人理解,这个inputs就是我…

Transformer的位置编码笔记(positional encoding)

一、为什么Transformer需要对输入进行位置编码因为Transformer的输入并没有内涵位置信息,同样的词在不同位置,或者同一个序列以不同顺序输入,对应的词间都会得到相同的注意力权重和输出,但是在NLP领域,词的顺序会极大地…

中文生成模型T5-Pegasus详解与实践

我们在前一篇文章《生成式摘要的四篇经典论文》中介绍了Seq2seq在生成式研究中的早期应用,以及针对摘要任务本质的讨论。

如今,以T5为首的预训练模型在生成任务上表现出超出前人的效果,这些早期应用也就逐渐地淡出了我们的视野。本文将介绍T…

【TimeSerias】Transformer

Sequence

1. rnn 和 cnn RNN 很难并行化CNN很难捕捉较远的信息

2. Self-attention 拿每个query q去对每个 key k做attention 计算输出

Self-attition 矩阵计算 qiWqaikiWkqiviWvaiQWqAKWkAVWvA(1.1)\begin{align*} q^i & W^q a^i \\ k^i & W^k q^i \\ v^i & W…

几何感知Transformer用于3D原子系统建模

基于机器学习的方法在预测分子能量和性质方面表现出很强的能力。分子能量至少与原子、键、键角、扭转角和非键原子对有关。以前的Transformer模型只使用原子作为输入,缺乏对上述因素的显式建模。为了减轻这种限制,作者提出了Moleformer,这是一…

【Transformer】自注意力机制Self-Attention | 各种网络归一化Normalization

1. Transformer 由来 & 特点

1.1 从NLP领域内诞生

"Transformer"是一种深度学习模型,首次在"Attention is All You Need"这篇论文中被提出,已经成为自然语言处理(NLP)领域的重要基石。这是因为Transfor…

DeepViT:Towards Deeper Vision Transform

论文笔记【1】-- DeepViT: Towards Deeper Vision Transformer CVPR 2021 DeepViT: Towards Deeper Vision Transformer DeepViT论文 DeepViT Code DeepViT:Can we further improve performance of ViTs by making it deeper, just like CNNs?——Re-attentio…

【Timm】create_model全面详实概念理解及实践篇

【Timm】搭建Vision Transformer系列实践,终于见面了,Timm库!

不久前,探究如何构建基于vision transformer的模型,发现,更多重点应该是放在如何有效利用现有库调用及构建模型,这篇就主要记录调…

认识Transformer:入门知识

视频链接: https://www.youtube.com/watch?vugWDIIOHtPA&listPLJV_el3uVTsOK_ZK5L0Iv_EQoL1JefRL4&index60 文章目录 Self-Attention layerMulti-head self-attentionPositional encodingSeq2Seq with AttentionTransformerUniversal Transformer Seq2Seq …

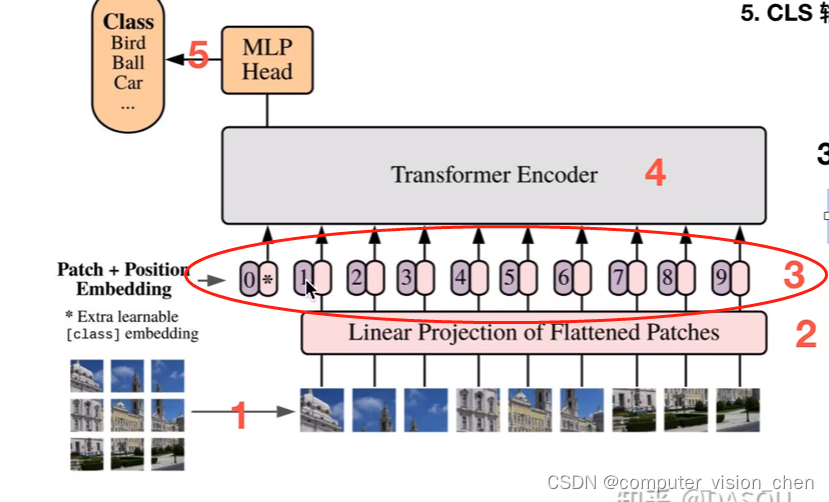

【DASOU视频记录】VIT (Vision Transformer) 模型论文+代码(源码)从零详细解读,看不懂来打我

文章目录 来源ViT和Transformer的关系朴素思路问题 ViT思路patch整体流程CLS位置编码编码器例子 代码 来源

b站视频

ViT和Transformer的关系

Vision Transformer(简称ViT)是Transformer在CV领域的应用ViT只使用了Transformer的编码器部分

朴素思路

…

Text-to-SQL小白入门(二)——Transformer学习

摘要

本文主要针对NLP任务中经典的Transformer模型的来源、用途、网络结构进行了详细描述,对后续NLP研究、注意力机制理解、大模型研究有一定帮助。

1. 引言

在上一篇《Text-to-SQL小白入门(一)》中,我们介绍了Text-to-SQL研究…

附代码 Vision Transformer(VIT)模型解读

AN IMAGE IS WORTH 16X16 WORDS: TRANSFORMERS FOR IMAGE RECOGNITION AT SCALE

该论文主要介绍了如何仅仅使用Trnsformers来进行图像分类。 Transformers lack some of the inductive biases inherent to CNNs, such as translation equivariance and locality, and therefor…

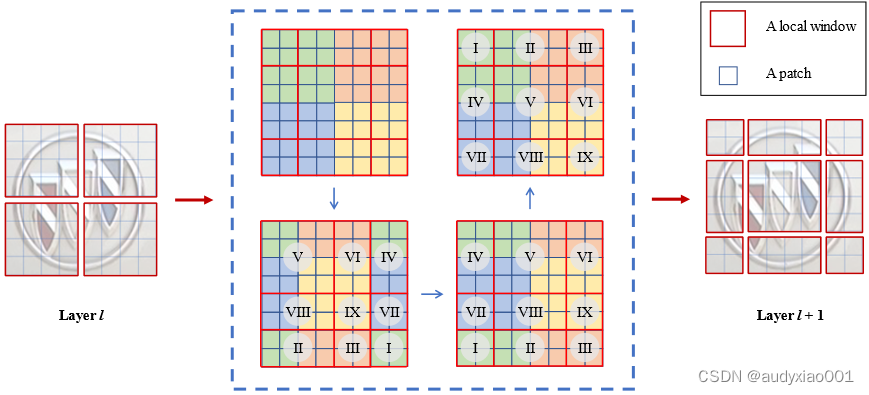

Swin Transformer中torch.roll()详解

torch.roll()这个函数看官方解释很懵,直接对照可视化来理解 参考:torch.roll 函数的理解

torch.roll(x, shifts(40, 40), dims(1, 2)) 这里img的shape是[1,56,56,96],即[B,H,W,C]格式。 dim1,shift40指的就是数据沿着H维度,将数据朝正反向滚…

Swin Transformer——细节详解

Swin Transformer——细节详解

划分窗口与合并窗口

举例: 默认情况下window_size7 划分窗口:将输入数据shape[4, 224, 224, 196]的数据reshape成[4*num_windows, 7, 7, 196] 合并窗口:将输入数据shape[4*num_windows, 7, 7, 196]的数据resh…

图解Transformer(完整版)

作者: 龙心尘 时间:2019年1月 出处:https://blog.csdn.net/longxinchen_ml/article/details/86533005

审校:百度NLP、龙心尘 翻译:张驰、毅航、Conrad 原作者:Jay Alammar 原链接:https://jala…

Vis-TOP:视觉Transformer叠加处理器

摘要

近年来,Transformer[23]在自然语言处理(NLP)领域取得了良好的效果,并开始向计算机视觉(CV)领域拓展。优秀的型号如Vision Transformer[5]和Swin Transformer[17]已经出现。同时,Transformer模型平台扩展到嵌入式设备,以满足…

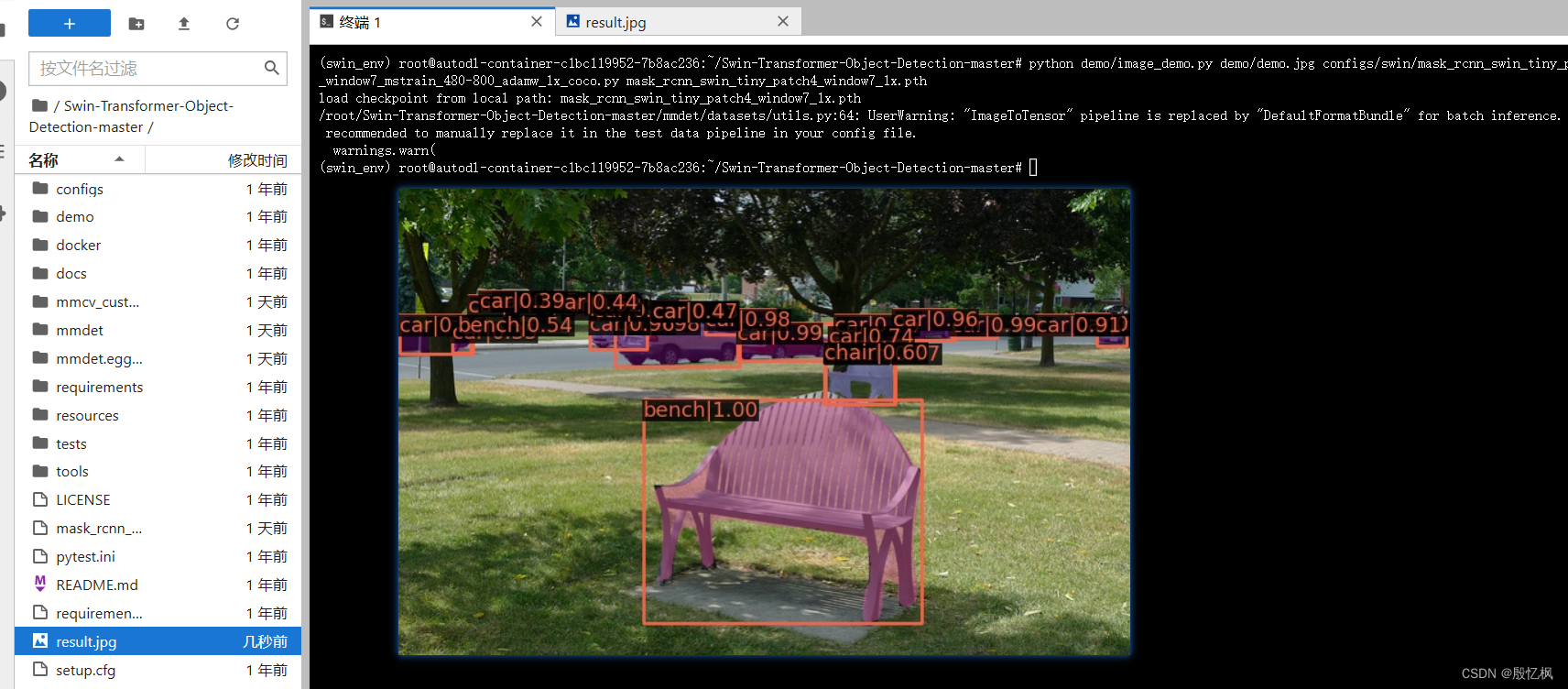

swing transformer中修改mmdetection预训练的mask-rcnn使类别数适应custom dataset

由于mmdetection封装程度较高,直接更改builder过程比较麻烦,所以recommend这种预处理的方式,先将模型权重文件处理好

import torchdef main():#gen coco pretrained weightnum_classes 6model_coco torch.load("./checkpoint/cascade…

swin-transformer安装mmcv-full

首先swin-T要求mmcv版本不能高于1.4.0,所以一些安装就不能像mmcv官网安装的那么随意,首先是查看自己的cuda,安装torch。在安装torch前,应该先参看此种cudatorch组合下是否有mmcv-full1.4.0的安装包。比如 https://download.openmm…

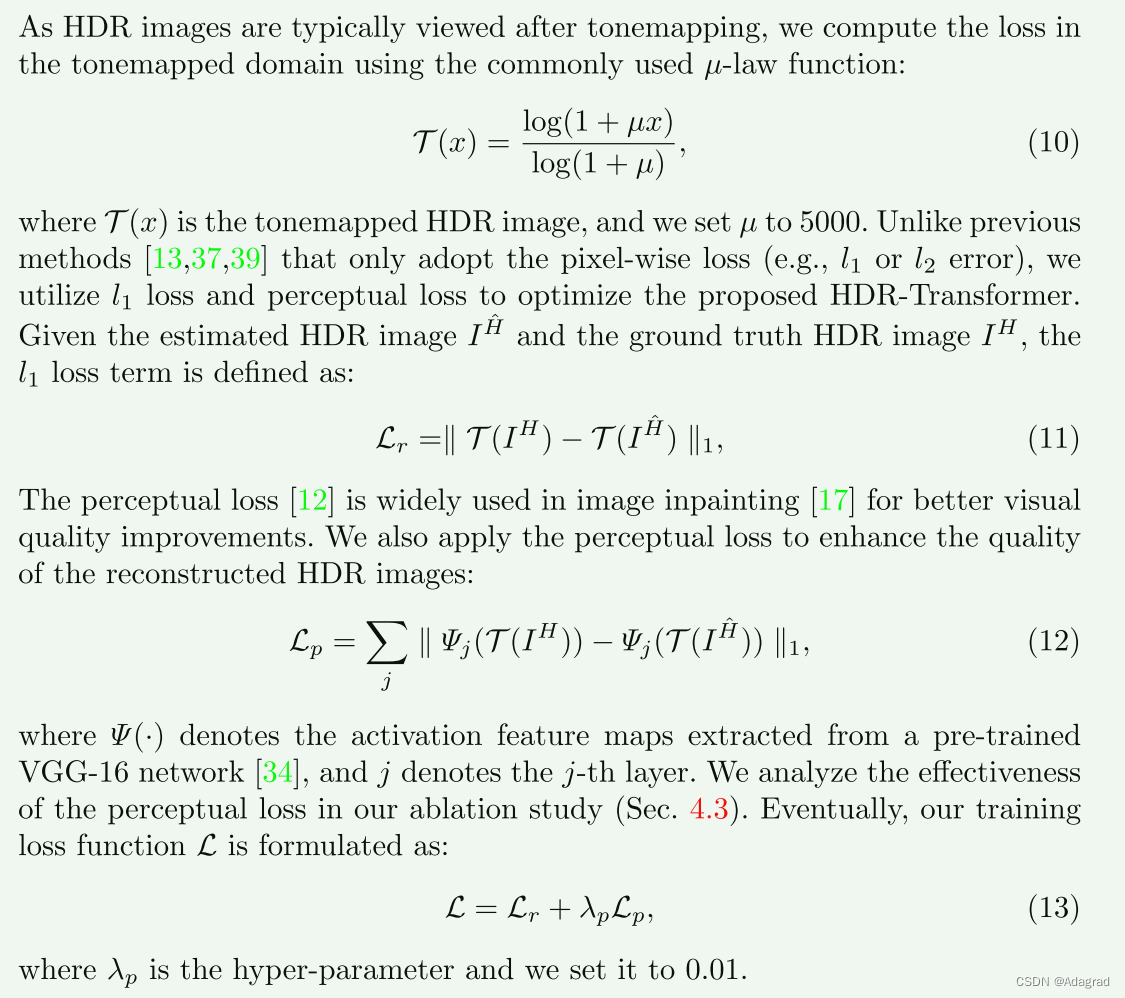

Ghost-free High Dynamic Range Imaging withContext-aware Transformer

Abstract

高动态范围(HDR)去鬼算法旨在生成具有真实感细节的无鬼HDR图像。 受感受野局部性的限制,现有的基于CNN的方法在大运动和严重饱和度的情况下容易产生重影伪影和强度畸变。 本文提出了一种新的上下文感知视觉转换器(CA-VIT)用于高动态…

YOLOv8改进Swin Transformer V2升级版本:在基础SwinTransformer v2 结构的基础上进行多种改进结构, 强大的视觉主干

💡本篇内容:YOLOv8改进Swin Transformer V2升级版本:在基础SwinTransformer v2 结构的基础上进行多种改进结构, 强大的视觉主干

💡🚀🚀🚀本博客 改进源代码改进 适用于 YOLOv8 按步骤操作运行改进后的代码即可

💡本文提出改进 原创 方式:二次创新,YOLOv8专属…

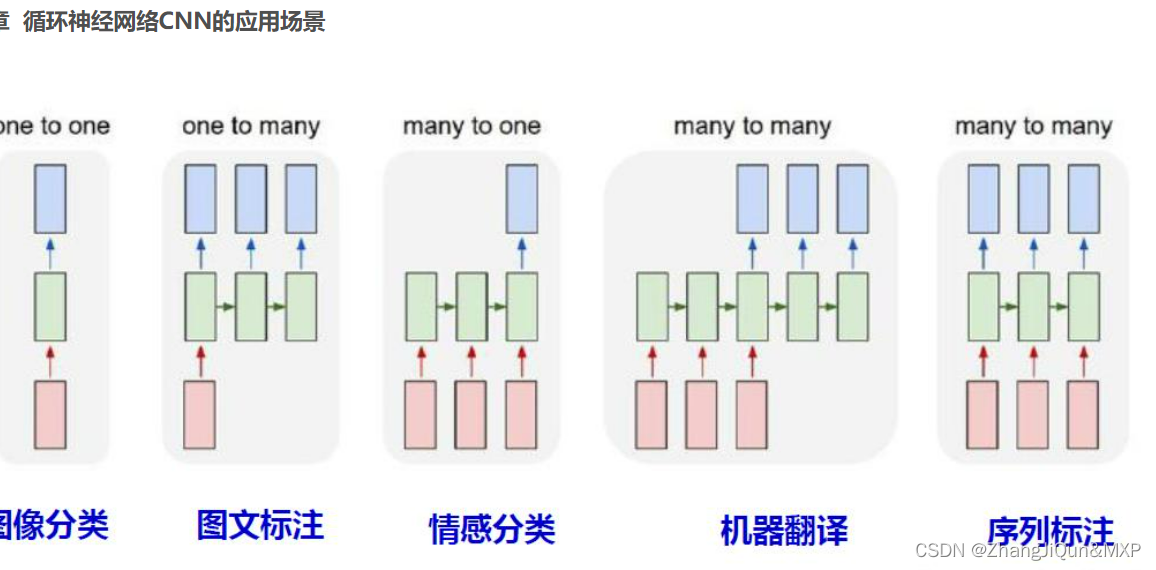

Transformer是什么,Transformer应用

目录

Transformer应用

Transformer是什么 Transformer应用:循环神经网络

语言翻译:注重语句前后顺序

RNN看中单个特征;

CNN:看中特征之间时序性

模型关注不同位置的能力

Transformer是什么

Transformer是一个利用注意力机制来提高模型训练速度的模型。关于注意力机…

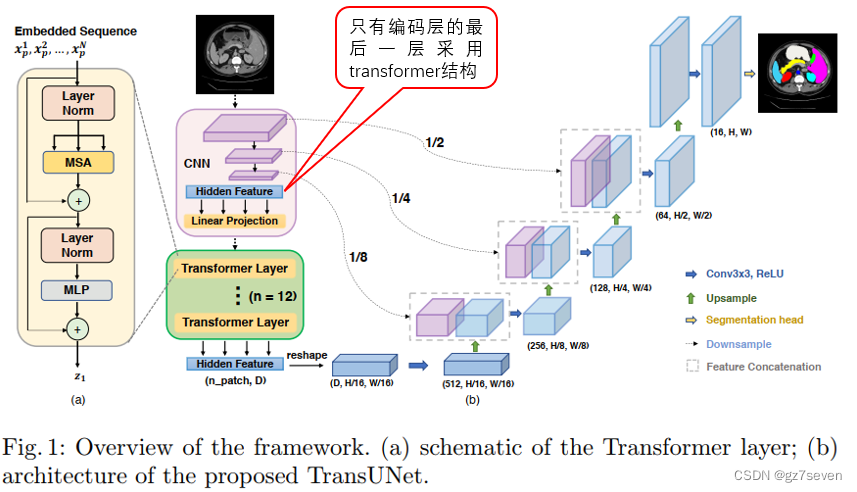

图像分割unet系列------TransUnet详解

图像分割unet系列------TransUnet详解 1、TransUnet结构2、我关心的问题3、总结与展望TransUnet发表于2021年,它是对UNet非常重要的改进,专为医学图像分割任务设计,特别用于在医学图像中分割器官或病变等解剖结构。 1、TransUnet结构 TransUNet在U-Net模型的基础上引入了混合…

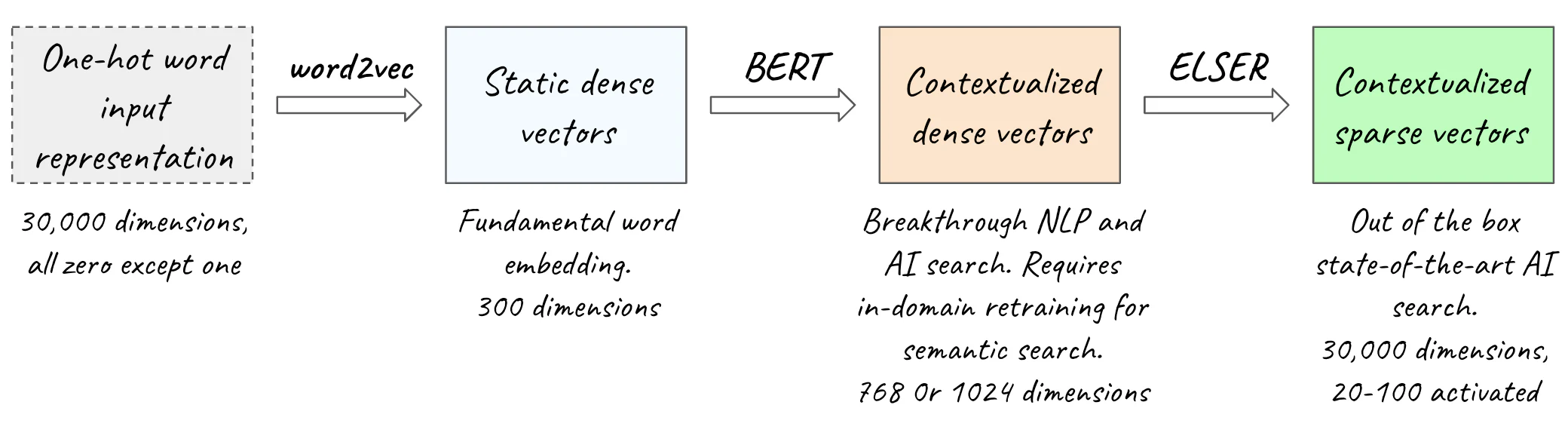

使用 Transformer 和 Amazon OpenSearch Service 构建基于列的语义搜索引擎

在数据湖中,对于数据清理和注释、架构匹配、数据发现和跨多个数据来源进行分析等许多操作,查找相似的列有着重要的应用。如果不能从多个不同的来源准确查找和分析数据,就会严重拉低效率,不论是数据科学家、医学研究人员、学者&…

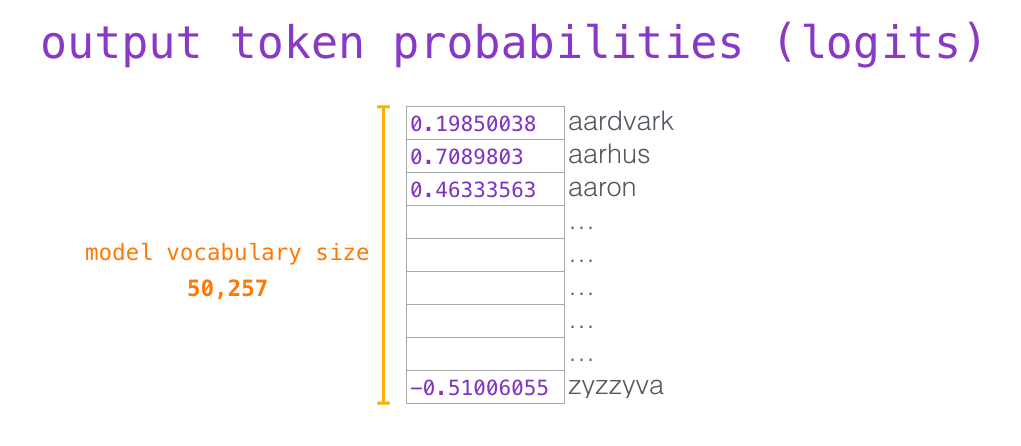

GPT2计算流程详解

GPT-2 就像传统的语言模型一样,一次只输出一个单词(token)。这种模型之所以效果好是因为在每个新单词产生后,该单词就被添加在之前生成的单词序列后面,这个序列会成为模型下一步的新输入。这种机制叫做自回归ÿ…

Attention is all you need 官方 tensorflow 1.x 实现

https://github.com/tensorflow/tensor2tensor/blob/master/tensor2tensor/models/transformer.py 1,搭建cuda10.0环境,

2,安装tensorflow 1.14.0

3,安装python3的 tensor2tensor 包 4,示例代码:

impor…

Transformer系列模型笔记

1.word2vec

1.1 CBOW(词袋模型)

根据上下出现的单词预测中间的单词,包括输入层、投影层、输出层。输入层包括上下出现单词的向量化表示;投影层是把输入层的向量累加求和后做映射;输出层(计算语料库中所有单词的概率,计算量大&am…

Transformer是否真正理解了自然语言的语义信息,还是单纯的模式识别

论文引用 此篇阅读笔记与思考主要针对以下两篇论文:

Climbing towards NLU: On Meaning, Form, and Understanding in the Age of Data

Transformer Feed-Forward Layers Are Key-Value Memories

本文将讨论第一篇论文所引发的思考(第一篇论文的详细解…

【论文学习】Transformer-XL

目录简介模型Vanilla Transformerrecurrence mechanism相对位置编码pytorch实现——batch_size为第一维度参考资料简介

RNN及其变体是训练语言模型(Language Modeling)的经典结构,其优点就是能够学习到序列之间的依赖关系,缺点&a…

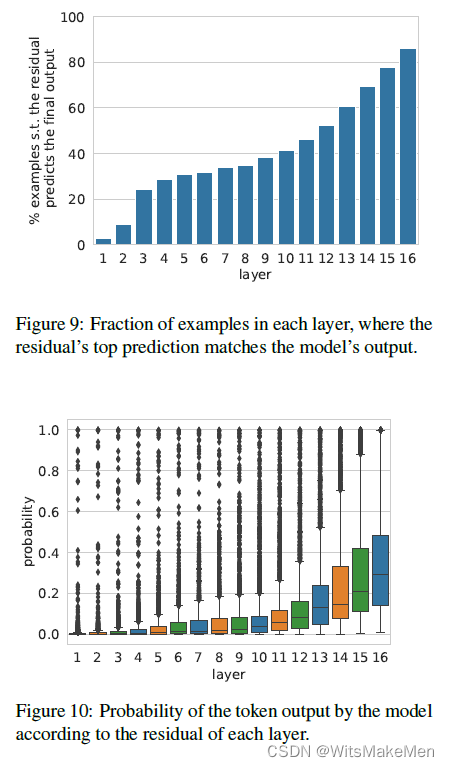

深入理解BERT Transformer ,不仅仅是注意力机制

作者: 龙心尘 时间:2019年3月 出处:https://blog.csdn.net/longxinchen_ml/article/details/89058309

大数据文摘与百度NLP联合出品 作者:Damien Sileo 审校:百度NLP、龙心尘 编译:张驰、毅航

为什么BERT…

用可视化解构BERT,我们从上亿参数中提取出了6种直观模式

作者: 龙心尘 时间:2019年1月 出处:https://blog.csdn.net/longxinchen_ml/article/details/89036531

大数据文摘联合百度NLP出品 审校:百度NLP、龙心尘 编译:Andy,张驰 来源:towardsdatascien…

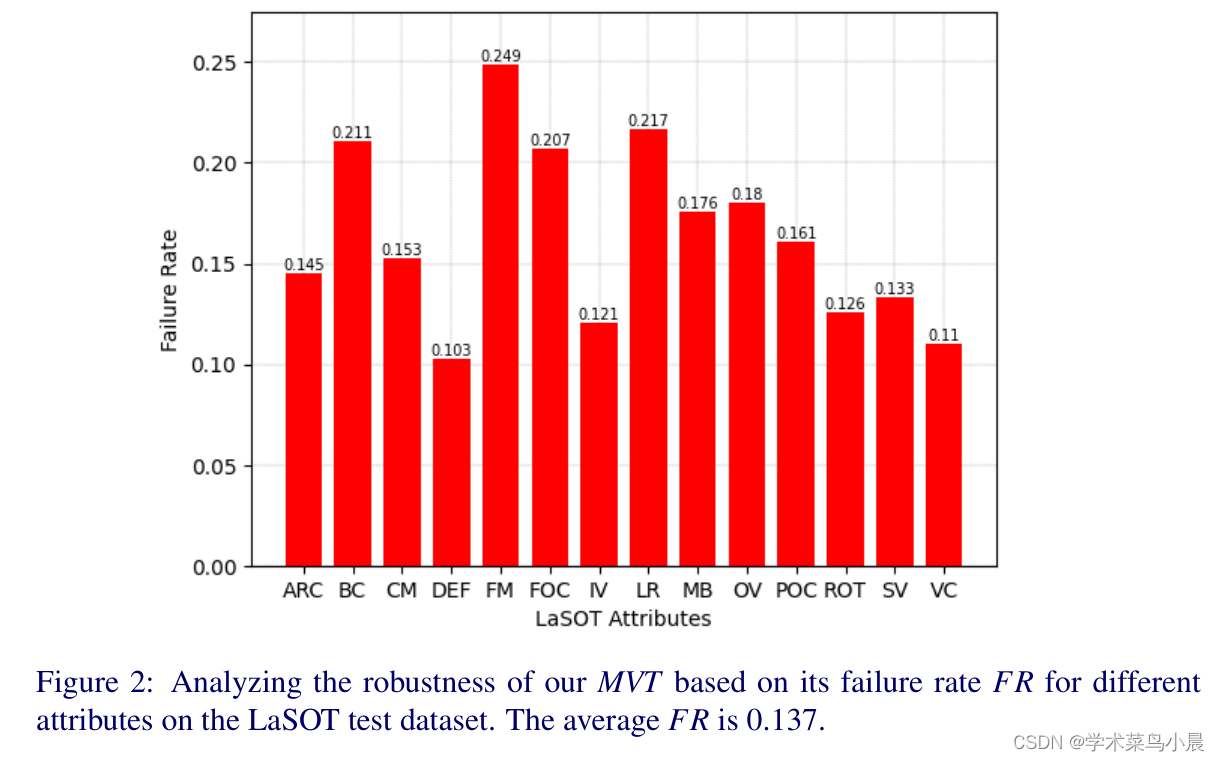

目标跟踪:Mobile Vision Transformer-based Visual Object Tracking

论文作者:Goutam Yelluru Gopal,Maria A. Amer

作者单位:Concordia University

论文链接:https://arxiv.org/pdf/2309.05829v1.pdf

项目链接:https://github.com/goutamyg/MVT

内容简介:

1)方向&#…

【Spring Boot】使用Spring Boot进行transformer的部署与开发

Transformer是一个用于数据转换和处理的平台,使用Spring Boot可以方便地进行Transformer的部署与开发。

以下是使用Spring Boot进行Transformer部署与开发的步骤:

创建Spring Boot项目

可以使用Spring Initializr创建一个简单的Spring Boot项目。在创…

NLP-D30-自注意力机制Transformer

—0526在啃黄瓜,已经看了一会沐沐叻。

1、Trandformer

看着看着简直要喷黄瓜了hhhhhhhh。 Tranformer也挺简单的,我一张ppt就讲完了。 不过这张ppt做的挺好的hhhh

-------0600看完了transformer,但对应代码还没看,看了多头的代…

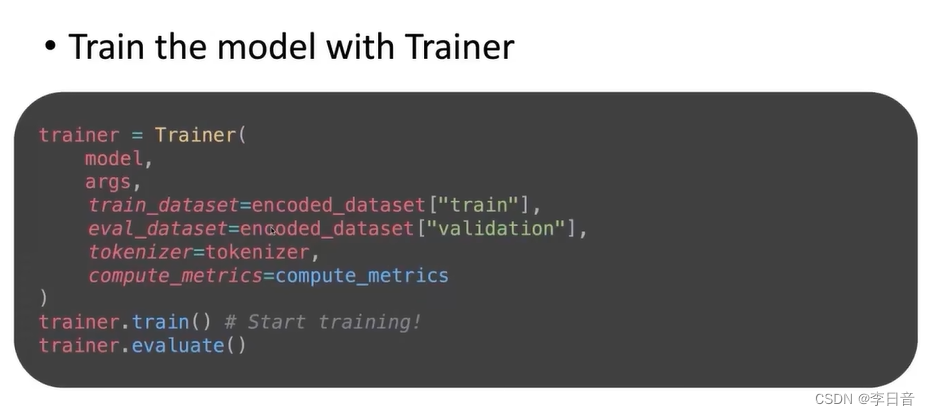

在PyTorch里面利用transformers的Trainer微调预训练大模型

背景

transformers提供了非常便捷的api来进行大模型的微调,下面就讲一讲利用Trainer来微调大模型的步骤

第一步:加载预训练的大模型

from transformers import AutoModelForSequenceClassificationmodel AutoModelForSequenceClassification.from_pr…

深度学习11:Transformer

目录

什么是 Transformer?

Encoder

Decoder

Attention

Self-Attention

Context-Attention

什么是 Transformer(微软研究院笨笨)

RNN和Transformer区别

Universal Transformer和Transformer 区别 什么是 Transformer? …

【NLP】手把手使用PyTorch实现Transformer以及Transformer-XL

手把手使用PyTorch实现Transformer以及Transformer-XL Abstract of Attention is all you need使用PyTorch实现Transformer1. 构建Encoder-Decoder模型1.1 导入依赖库1.2 创建Encoder-Decoder类1.3 创建Generator类 2. 构建Encoder2.1 定义复制模块的函数2.2 创建Encoder2.3 构…

Hugging Face--Transformers

pipeline 在这里插入图片描述

AutoClass

AutoClass 是一个能够通过预训练模型的名称或路径自动查找其架构的快捷方式. 你只需要为你的任务选择合适的 AutoClass 和它关联的预处理类。

AutoTokenizer AutoModel 保存模型 自定义模型构建 Trainer - PyTorch优化训练循环 参考资…

hugging face inference API返回内容太短的问题

hugging face的inference api返回的内容默认很短,可以通过参数max_new_tokens进行设置:

Detailed parameters

When sending your request, you should send a JSON encoded payload. Here are all the options

All parametersinputs (required):a str…

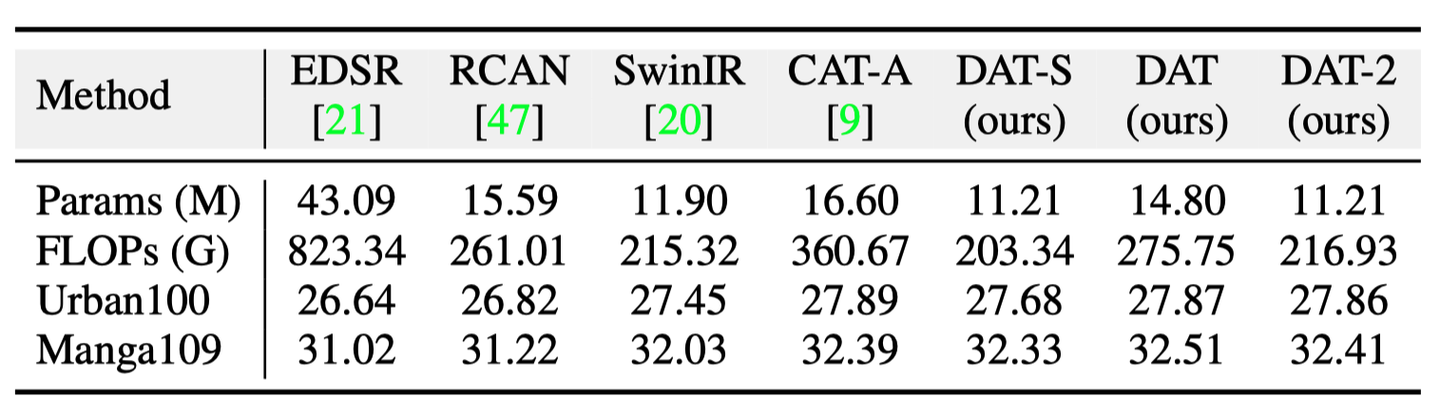

ICCV 2023 | 利用双重聚合的Transformer进行图像超分辨率

导读 本文提出一种同时利用图像空间和通道特征的 Transformer 模型,DAT(Dual Aggregation Transformer),用于图像超分辨(Super-Resolution,SR)任务。DAT 以块间和块内的双重方式,在空…

Self-Attention Transformer完全指南:像Transformer的创作者一样思考

本文从RNN到self-attention,再到Transformer来讲清楚整个算法。

近半年来有大量同学来找我问Transformer的一些细节问题,例如Transformer与传统seq2seq RNN的区别、self-attention层的深入理解、masked self-attention的运作机制;以及各种Tr…

Hugging Face 实战系列 总目录

PyTorch 深度学习 开发环境搭建 全教程

Transformer:《Attention is all you need》

Hugging Face简介 1、Hugging Face实战-系列教程1:Tokenizer分词器(Transformer工具包/自然语言处理) Hungging Face实战-系列教程1:Tokenize…

ChatGLM Pytorch从0编写Transformer算法

预备工作 # !pip install http://download.pytorch.org/whl/cu80/torch-0.3.0.post4-cp36-cp36m-linux_x86_64.whl numpy matplotlib spacy torchtext seaborn import numpy as np

import torch

import torch.nn as nn

import torch.nn.functional as F

import math, copy, tim…

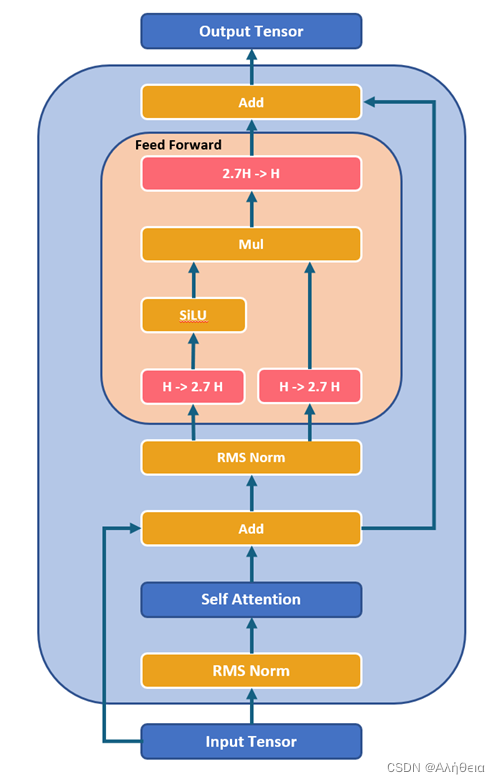

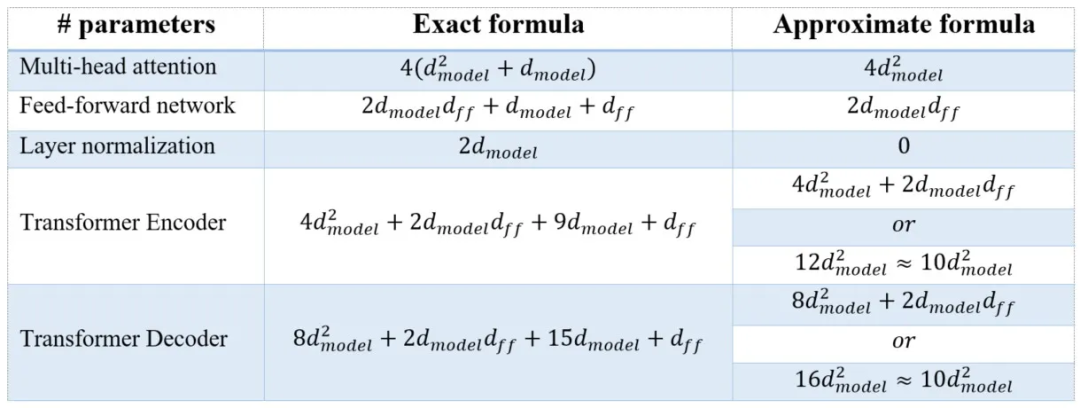

LLM各层参数详细分析(以LLaMA为例)

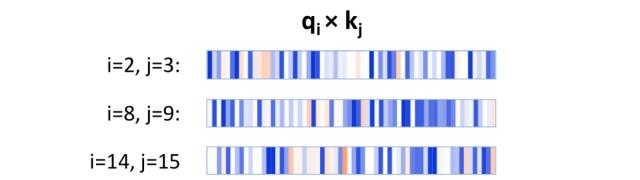

网上大多分析LLM参数的文章都比较粗粒度,对于LLM的精确部署不太友好,在这里记录一下分析LLM参数的过程。 首先看QKV。先上transformer原文 也就是说,当h(heads) 1时,在默认情况下, W i Q W_i^…

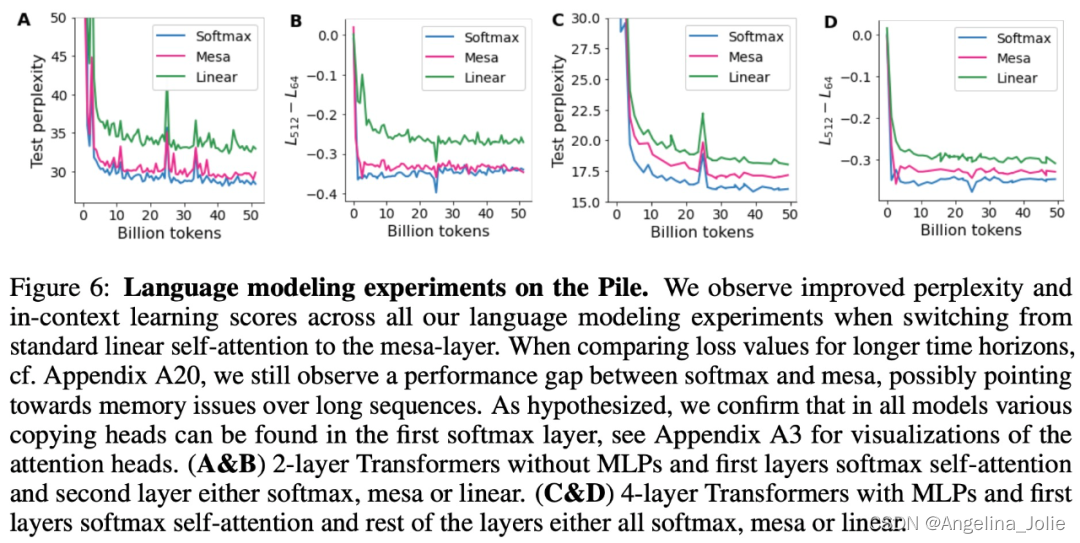

Transformer的上下文学习能力

《Uncovering mesa-optimization algorithms in Transformers》

论文链接:https://arxiv.org/abs/2309.05858

为什么 transformer 性能这么好?它给众多大语言模型带来的上下文学习 (In-Context Learning) 能力是从何而来?在人工智能领域里&…

Hugging Face实战-系列教程3:文本2分类

🚩🚩🚩Hugging Face 实战系列 总目录 有任何问题欢迎在下面留言 本篇文章的代码运行界面均在notebook中进行 本篇文章配套的代码资源已经上传 下篇内容: Hugging Face实战-系列教程4:padding与attention_mask

输出我…

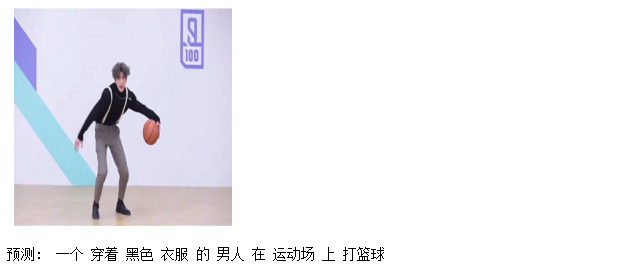

【Image captioning】 Collaborative Transformer for Image Captioning实现流程

Dual-Level Collaborative Transformer for Image Captioning实现流程(原始代码的readme)

作者:安静到无声 个人主页 目录 Dual-Level Collaborative Transformer for Image Captioning实现流程(原始代码的readme)实验设置数据准备训练评价参考致谢推荐专栏论文地址:https:/…

An Efficient Memory-Augmented Transformer for Knowledge-Intensive NLP Tasks

本文是LLM系列文章,针对《An Efficient Memory-Augmented Transformer for Knowledge 一种用于知识密集型NLP任务的高效内存增强转换器 摘要1 引言2 相关工作3 高效内存增强Transformer4 EMAT的训练流程5 实验6 分析7 结论局限性 摘要

获取外部知识对于许多自然语言…

基于transformer一步一步训练一个多标签文本分类的BERT模型

Bert(Bidirectional Encoder Representations from Transformers)是一种基于Transformer架构的预训练语言模型,由Google在2018年提出。Bert模型在自然语言处理领域取得了重大突破,被广泛应用于各种NLP任务,如文本分类、命名实体识别、问答系统等。

Bert模型的核心思想是通…

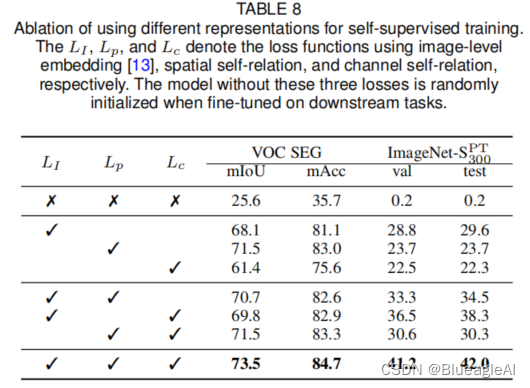

论文阅读:SERE: Exploring Feature Self-relation for Self-supervised Transformer

Related Work

Self-supervised 学习目的是在无人工标注的情况下通过自定制的任务(hand-crafted pretext tasks)学习丰富的表示。

Abstract

使用自监督学习为卷积网络(CNN)学习表示已经被验证对视觉任务有效。作为CNN的一种替代…

【ViT(Vision Transformer)】(二) 阅读笔记

简介

ViT是2020年Google团队提出的将Transformer应用在图像分类的模型,虽然不是第一篇将transformer应用在视觉任务的论文,但是因为其模型“简单”且效果好,可扩展性强(scalable,模型越大效果越好)&#x…

【论文+代码】1706.Transformer简易学习笔记

Transformer 论文: 1706.attention is all you need! 唐宇迪解读transformer:transformer2021年前,从NLP活到CV的过程 综述:2110.Transformers in Vision: A Survey 代码讲解1: Transformer 模型详解及代码实现 - 进击的程序猿 - 知乎 代码讲…

esbuild中文文档-语法转换(Transformation - Supported、Target)

文章目录 语法转换 Transformation配置支持的语法 Supported构建目标 Target 结语 哈喽,大家好!我是「励志前端小黑哥」,我带着最新发布的文章又来了! 老规矩,小手动起来~点赞关注不迷路! esbuild简单介绍 …

[异构图-论文阅读]Heterogeneous Graph Transformer

这篇论文介绍了一种用于建模Web规模异构图的异构图变换器(HGT)架构。以下是主要的要点:

摘要和引言 (第1页) 异构图被用来抽象和建模复杂系统,其中不同类型的对象以各种方式相互作用。许多现有的图神经网络(GNNs)主要针对同构图设计,无法有效表示异构结构。HGT通过设计…

【transformer】自注意力源码解读和复杂度计算

Self-attention A t t e n t i o n ( Q , K , V ) s o f t m a x ( Q K T d k ) V Attention(Q,K,V) softmax(\frac{QK^T}{\sqrt{d_k}})V Attention(Q,K,V)softmax(dk QKT)V

其中, Q Q Q为查询向量, K K K和 V V V为键向量和值向量,…

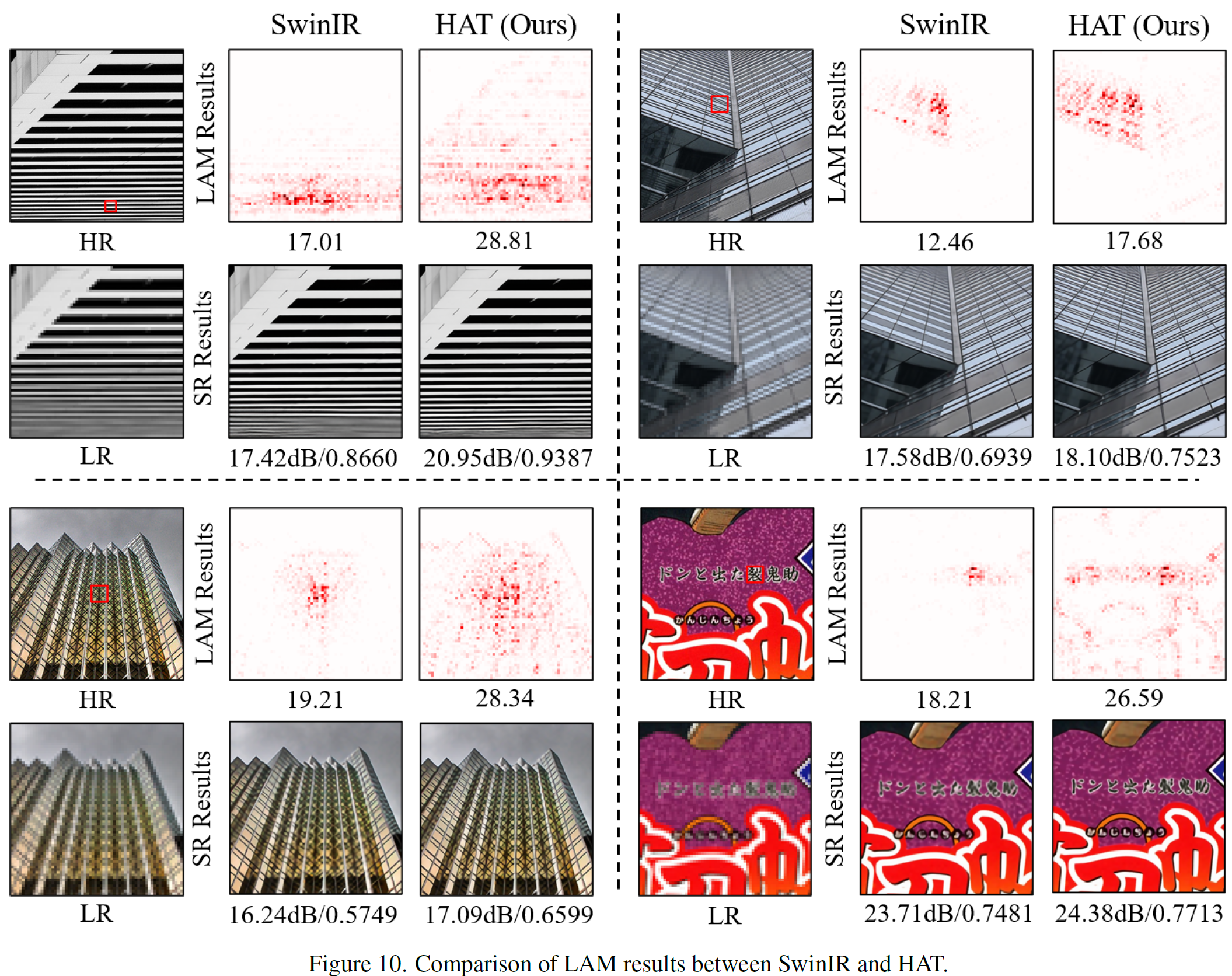

Activating More Pixels in Image Super-Resolution Transformer(HAT)超分

摘要

基于Transformer的方法在低级视觉任务(如图像超分辨率)上表现出令人印象深刻的性能。然而,我们发现这些网络只能通过归因分析利用有限的输入信息空间范围。这意味着Transformer的潜力在现有网络中仍未得到充分利用。为了激活更多输入像…

深度学习原理学习小结 - Self-Attention/Transformer

文章目录深度学习原理学习小结 - Self-Attention/TransformerSelf-Attention基本原理引入核心概念计算方法Transformer基本原理知识补充编码器(Encoder)与 解码器(Decoder)Transformer关键代码解读多头注意力Transfomer深度学习原…

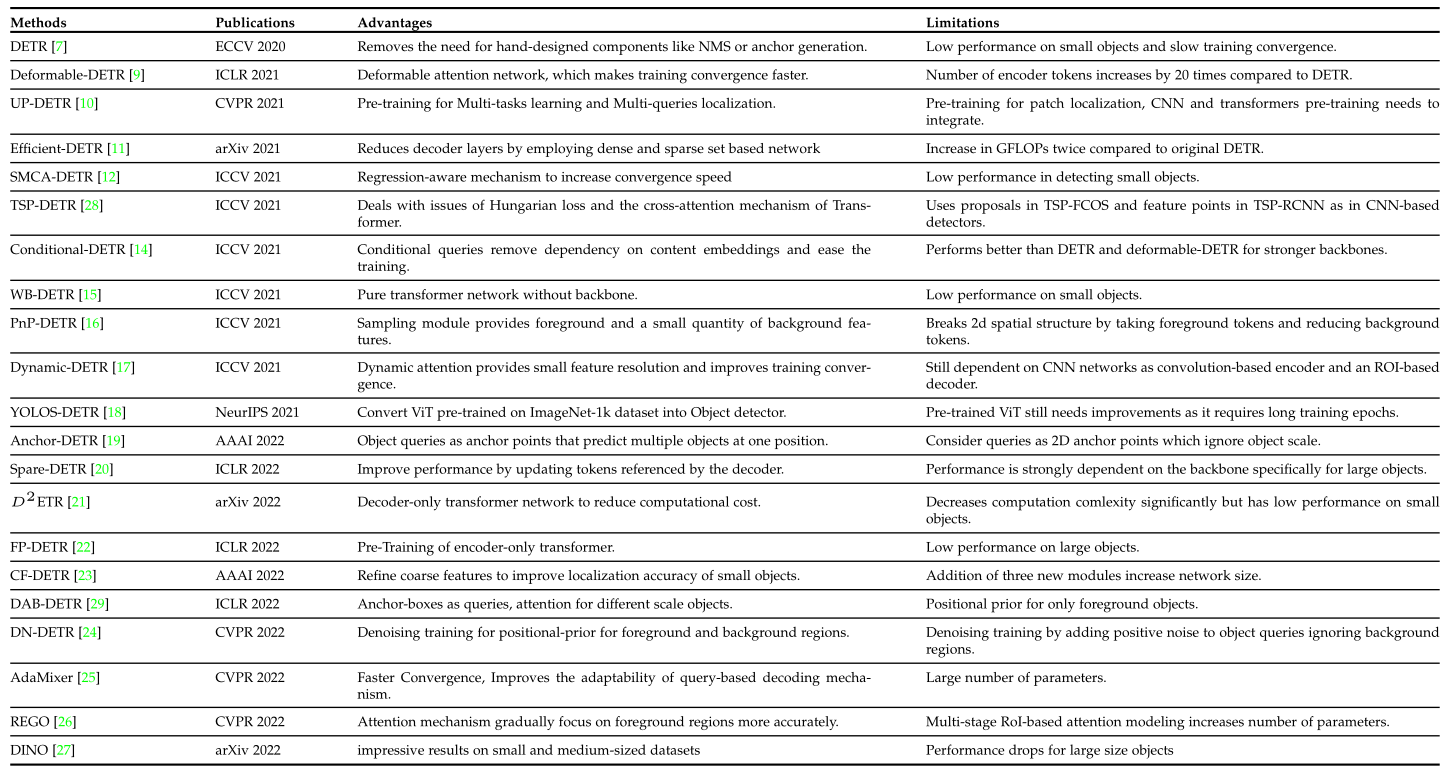

【计算机视觉】DETR 系列的最新综述!

论文地址:

https://arxiv.org/pdf/2306.04670.pdf项目地址:

https://github.com/mindgarage-shan/trans_object_detection_surveyTransformer在自然语言处理(NLP)中的惊人表现,让研究人员很兴奋地探索它们在计算机视觉任务中的应用。与其他…

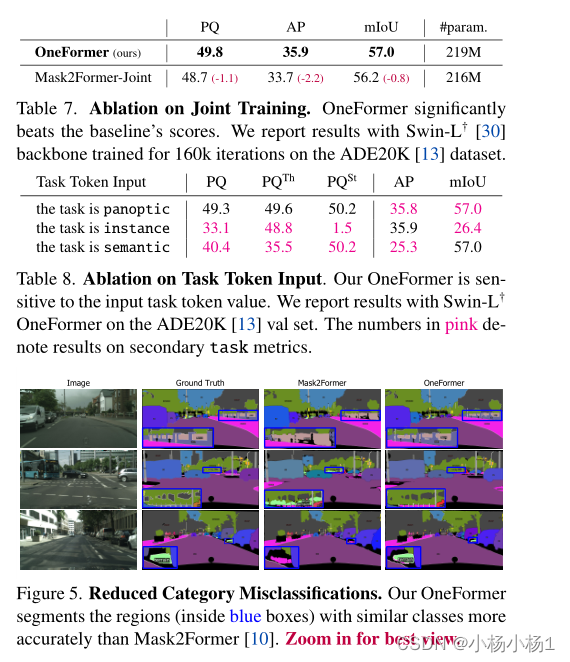

OneFormer: One Transformer to Rule Universal Image Segmentation论文笔记

论文https://arxiv.org/pdf/2211.06220.pdfCodehttps://github.com/SHI-Labs/OneFormer 文章目录 1. Motivation2. 方法2.1 与Mask2Former的相同之处2.2 OneFormer创新之处2.3 Task Conditioned Joint Training2.4 Query Representations2.4 Task Guided Contrastive Queries 3…

读书笔记:多Transformer的双向编码器表示法(Bert)-1

多Transformer的双向编码器表示法

Bidirectional Encoder Representations from Transformers,即Bert; 本笔记主要是对谷歌Bert架构的入门学习:

介绍Transformer架构,理解编码器和解码器的工作原理;掌握Bert模型架构…

Attention is all you need ---Transformer

大语言模型已经在很多领域大显身手,其应用包括只能写作、音乐创作、知识问答、聊天、客服、广告文案、论文、新闻、小说创作、润色、会议/文章摘要等等领域。在商业上模型即产品、服务即产品、插件即产品,任何形态的用户可触及的都可以是产品,…

大语言模型之一 Attention is all you need ---Transformer

大语言模型已经在很多领域大显身手,其应用包括只能写作、音乐创作、知识问答、聊天、客服、广告文案、论文、新闻、小说创作、润色、会议/文章摘要等等领域。在商业上模型即产品、服务即产品、插件即产品,任何形态的用户可触及的都可以是产品,…

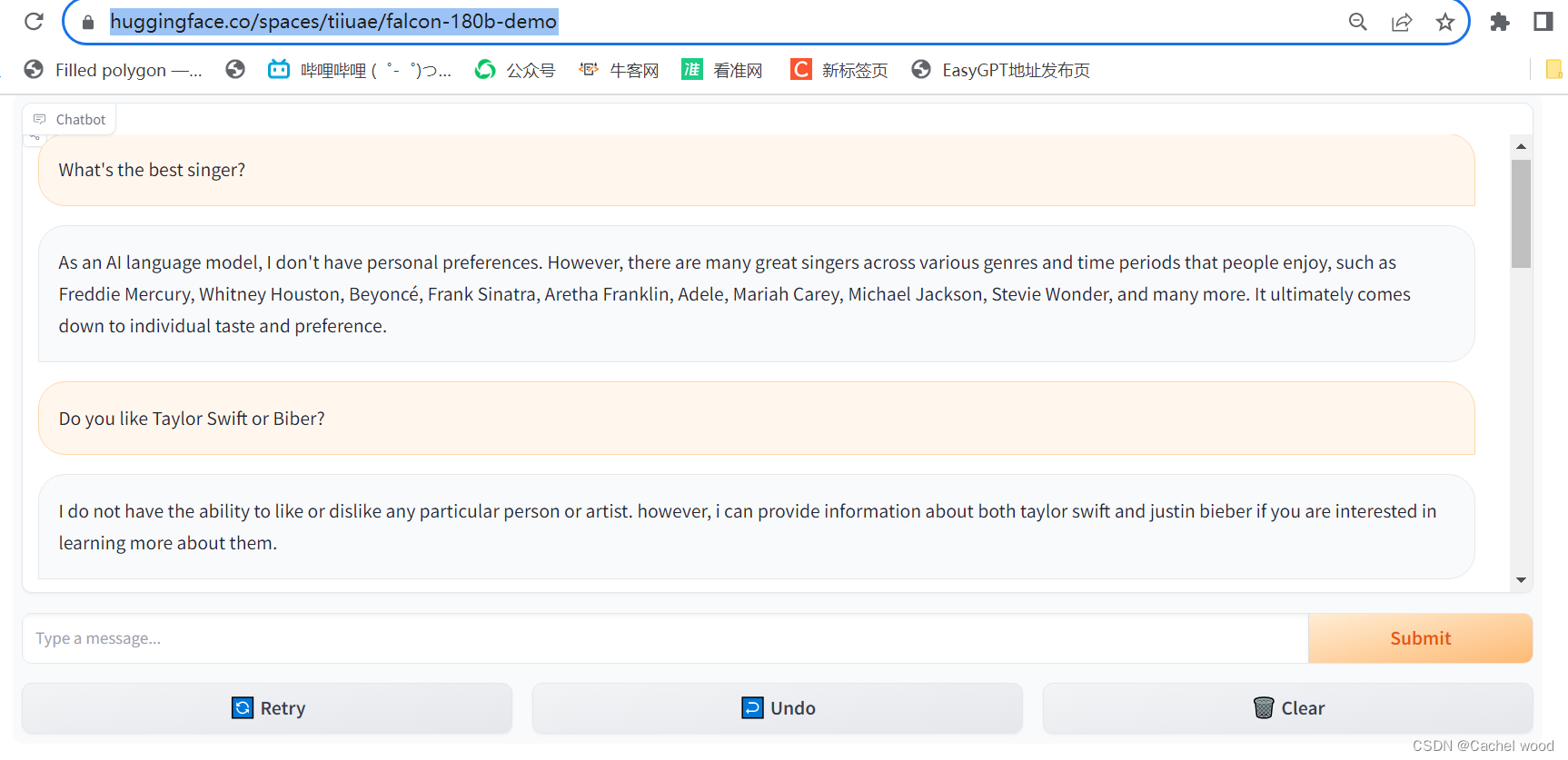

180B参数的Falcon登顶Hugging Face,最好开源大模型使用体验

文章目录 使用地址使用体验test1:简单喜好类问题使用地址

https://huggingface.co/spaces/tiiuae/falcon-180b-demo

使用体验 相比Falcon-7b,Falcon-180b拥有1800亿的参数量,在智能问答领域做到了Top 1。在回答问题的深度和广度上都明显优于只有70亿参数量的Falcon-7b,并…

transformer 总结(超详细-初版)

相关知识链接

attention1attention2

引言

本文主要详解 transformer 的算法结构以及理论解释,代码实现以及具体实现时候的细节放在下一篇来详述。 下面就通过上图中 transformer 的结构来依次解析

输入部分(Encode 侧)

input 输出主要包含 两个部分:…

Transformer貌似也是可以使用state递归解码和训练的

import paddle

import numpy as npclass HeadLoss(paddle.nn.Layer):def __init__(self):super(HeadLoss, self).__init__()

人工智能AI知多少?

摘要

人工智能(Artificial Intelligence,简称AI)是一项前沿技术,正在快速发展并渗透到各个领域。然而,对于大多数人来说,人工智能仍然是一个陌生而复杂的概念。本文旨在对人工智能进行扫盲,介绍其基本概念、应用领域以及当前热门的人工智能模型。通过具体的例子,读者将…

HSN:微调预训练ViT用于目标检测和语义分割,华南理工和阿里巴巴联合提出

今天跟大家分享华南理工大学和阿里巴巴联合提出的将ViT模型用于下游任务的高效微调方法HSN,该方法在迁移学习、目标检测、实例分割、语义分割等多个下游任务中表现优秀,性能接近甚至在某些任务上超越全参数微调。 论文标题:Hierarchical Side…

手动实现Transformer

Transformer和BERT可谓是LLM的基础模型,彻底搞懂极其必要。Transformer最初设想是作为文本翻译模型使用的,而BERT模型构建使用了Transformer的部分组件,如果理解了Transformer,则能很轻松地理解BERT。

一.Transformer模型架构 1…

计算机视觉与深度学习-Transformer-【北邮鲁鹏】

目录 引入基本组成编码器多头自注意力机制(Multi-Head Self-Attention)多头自注意力的计算过程头数与维度关系前馈神经网络(Feed-Forward Neural Network) 编码器中的ADD&NORM加法操作(Addition)归一化…

【Transformer系列】深入浅出理解ViT(Vision Transformer)网络模型

一、参考资料

极智AI | 详解 ViT 算法实现 MobileViT模型简介 ECCV 2022丨力压苹果MobileViT,这个轻量级视觉模型新架构火了 ECCV 2022丨轻量级模型架构火了,力压苹果MobileViT(附代码和论文下载) 再读VIT,还有多少细…

Transformer 中 Positional Encoding 实现

参考博文:

https://www.cnblogs.com/nickchen121/p/16470736.html

解决问题

位置编码的主要目的是确保模型能够理解序列中的元素之间的相对位置和顺序,从而更好地捕捉到语义信息。在Transformer模型中,位置编码通常与词嵌入(w…

transformer_01

一、传统RNN存在的问题 1.序列前序太长,每个xi要记住前面的特征,而且一直在学,没有忘记,可能特征不能学的太好

2.串行,层越多越慢,难以堆叠很多层;

3.只能看到过去,不能看到未来 搞…

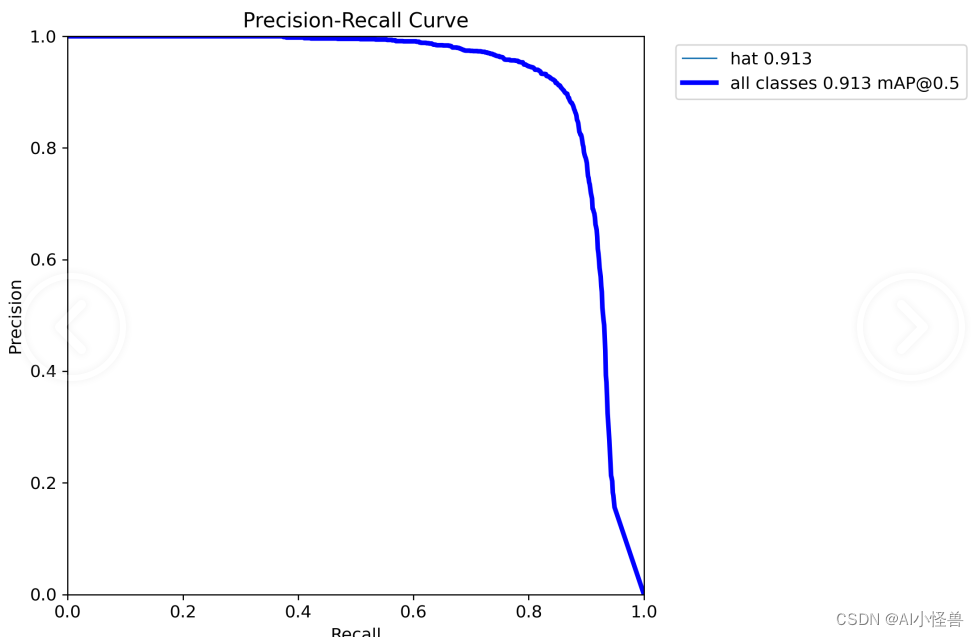

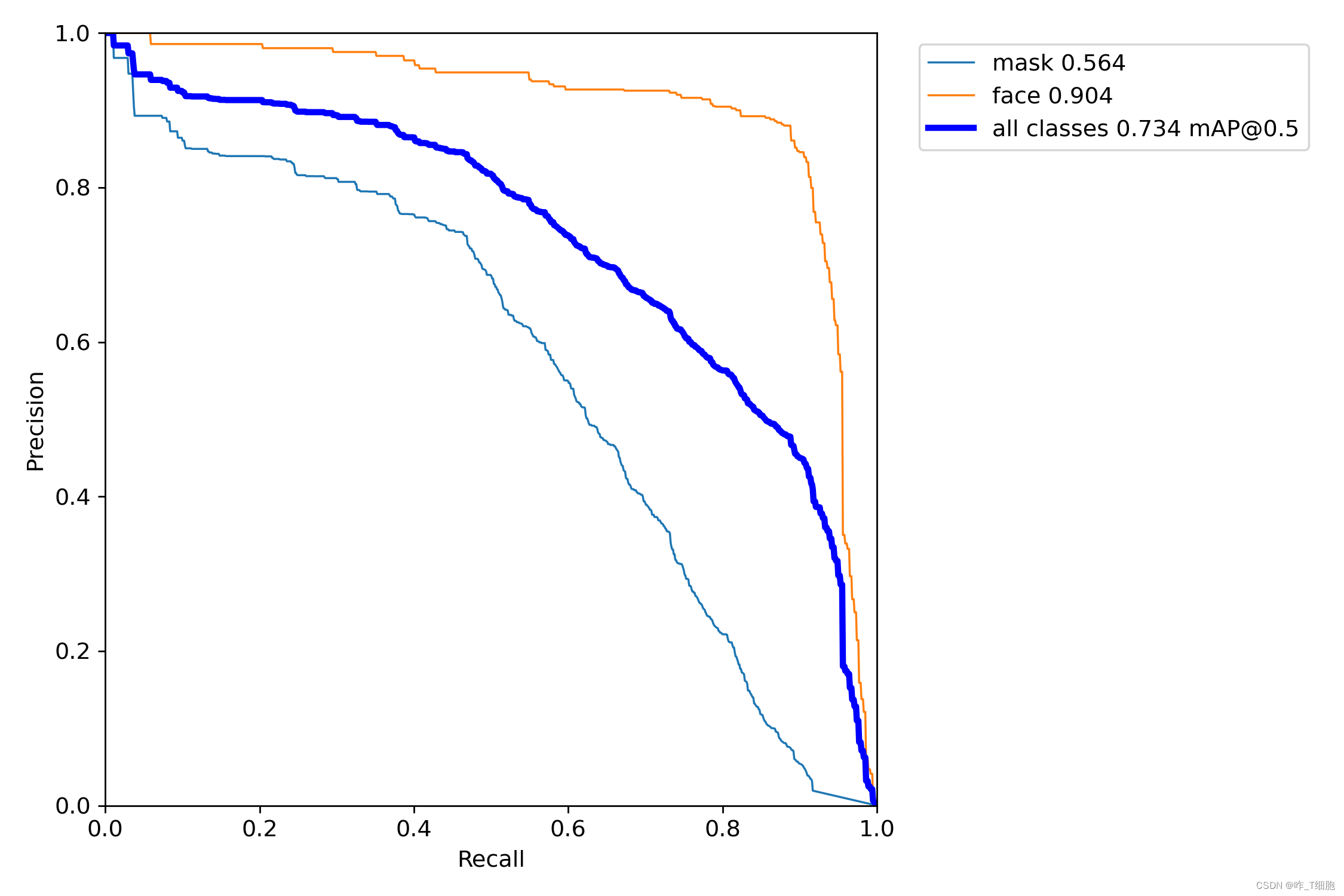

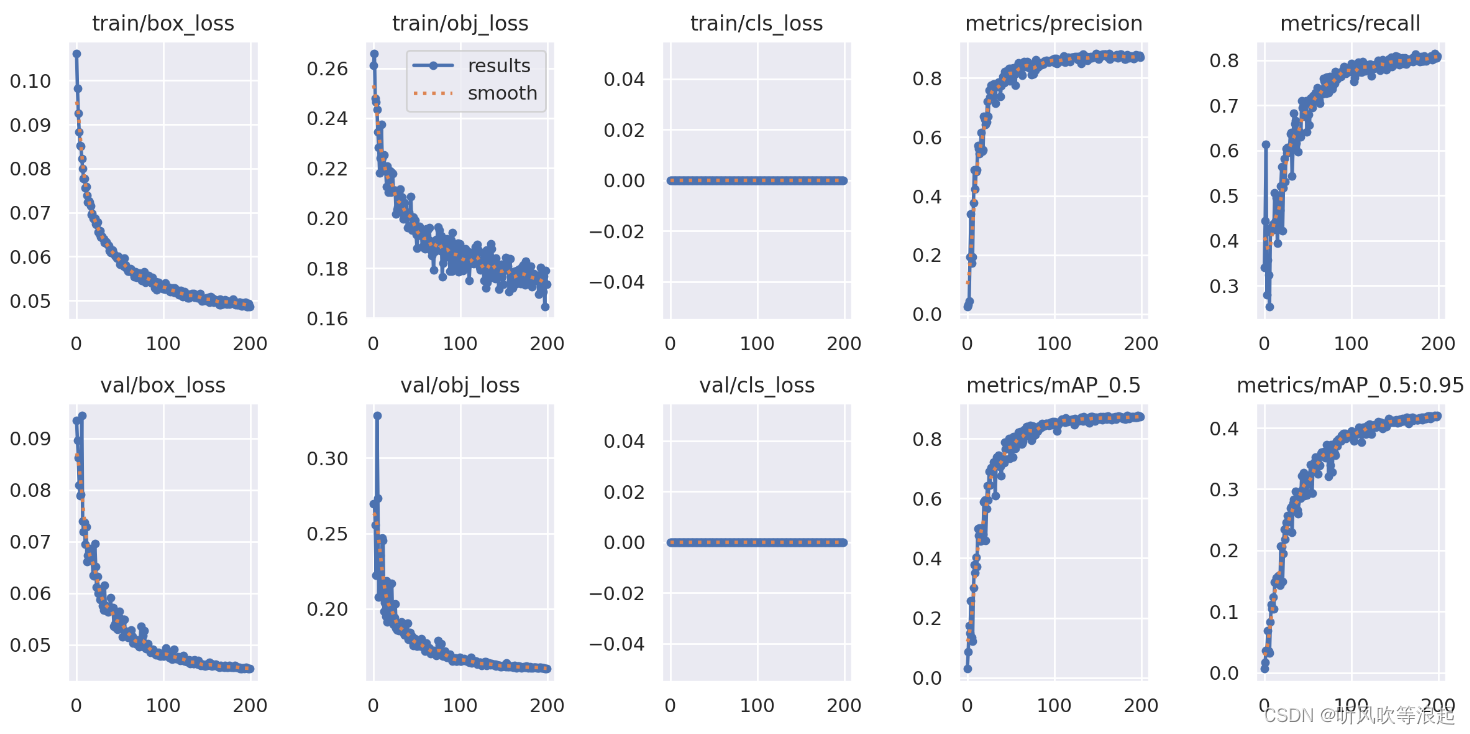

基于YOLOv8的安全帽检测系统(2):Gold-YOLO,遥遥领先,助力行为检测 | 华为诺亚NeurIPS23

目录 1.Yolov8介绍

2.安全帽数据集介绍

3.Gold-YOLO

4.训练结果分析 1.Yolov8介绍 Ultralytics YOLOv8是Ultralytics公司开发的YOLO目标检测和图像分割模型的最新版本。YOLOv8是一种尖端的、最先进的(SOTA)模型,它建立在先前YOLO成功基础上…

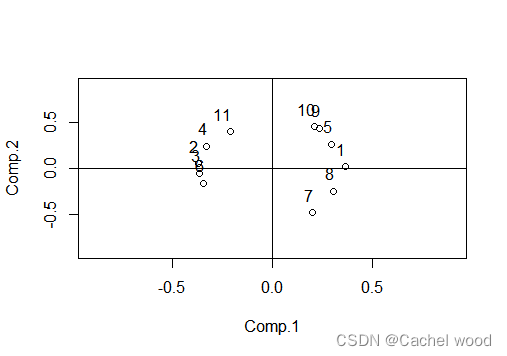

R语言:主成分分析PCA

文章目录 主成分分析处理步骤数据集code 主成分分析

主成分分析(或称主分量分析,principal component analysis)由皮尔逊(Pearson,1901)首先引入,后来被霍特林(Hotelling,1933)发展…

Transformer学习-self-attention

这里写自定义目录标题 Self-attentionMulti-head self-attention用self-attention解决其他问题 Self-attention

用Wq、Wk、Wv分别乘输入向量得到q、k、v向量 用每个q向量乘所有的k向量得到对应项的attention,即用每项的query向量去匹配所有的key向量,得…

逐行代码学习ChatGLM2-6B大模型SFT微调,项目中的ptune/main.py文件

项目地址

#!/usr/bin/env python

# codingutf-8

"""

Fine-tuning the library models for sequence to sequence.

下面给出了一个命令行运行微调main.py的例子#1.激活环境#2.执行torchrun

#--standalone 这个标志指定使用“standalone”模式运行分布式训练。这…

[paper] Attention is all you need 论文浅析

Base

Title: 《Attention Is All You Need》 2023

paper:arxiv

Github: None

Abstract

This paper proposed a new simple network architecture, the Transformer based solely on attention mechanisms. Model Architecture

模型包括 encoder-decoder struc…

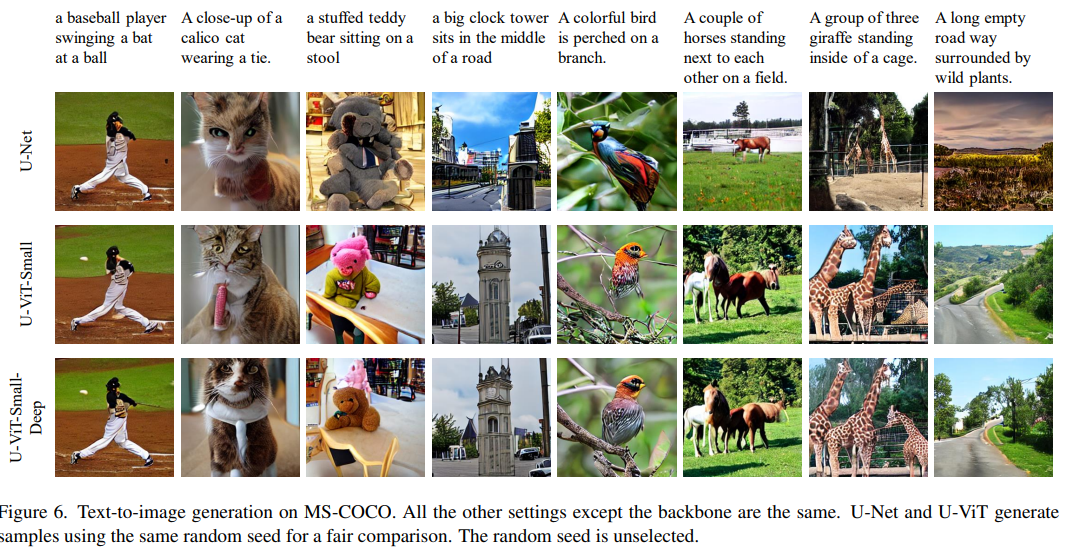

【CVPR 2023】 All are Worth Words: A ViT Backbone for Diffusion Models

All are Worth Words: A ViT Backbone for Diffusion Models, CVPR 2023

论文:https://arxiv.org/abs/2209.12152

代码:https://github.com/baofff/U-ViT

解读:U-ViT: A ViT Backbone for Diffusion Models - 知乎 (zhihu.com)

All are W…

MobileViT v2导出onnx模型时遇Col2Im算子无法导出问题

相关error log索引

onnxruntime.capi.onnxruntime_pybind11_state.InvalidGraph: [ONNXRuntimeError] : 10 : INVALID_GRAPH : This is an invalid model. In Node, ("/classifier/classifier.0/ReduceMean", ReduceMean, "", -1) : ("/layer_5/laye…

自然语言处理---Transformer机制详解之BERT模型特点

1 BERT的优点和缺点

1.1 BERT的优点

通过预训练, 加上Fine-tunning, 在11项NLP任务上取得最优结果.BERT的根基源于Transformer, 相比传统RNN更加高效, 可以并行化处理同时能捕捉长距离的语义和结构依赖.BERT采用了Transformer架构中的Encoder模块, 不仅仅获得了真正意义上的b…

LLM 系列之 Transformer 组件总结

本系列为LLM 学习博客,会一一记录各个模块解读。 以下内容参考:大语言模型综述 https://github.com/RUCAIBox/LLMSurvey

主流架构

大语言模型,主要的核心组件是Transformer。不同的模型选择的架构不一样,目前主流架构有:

编码器…

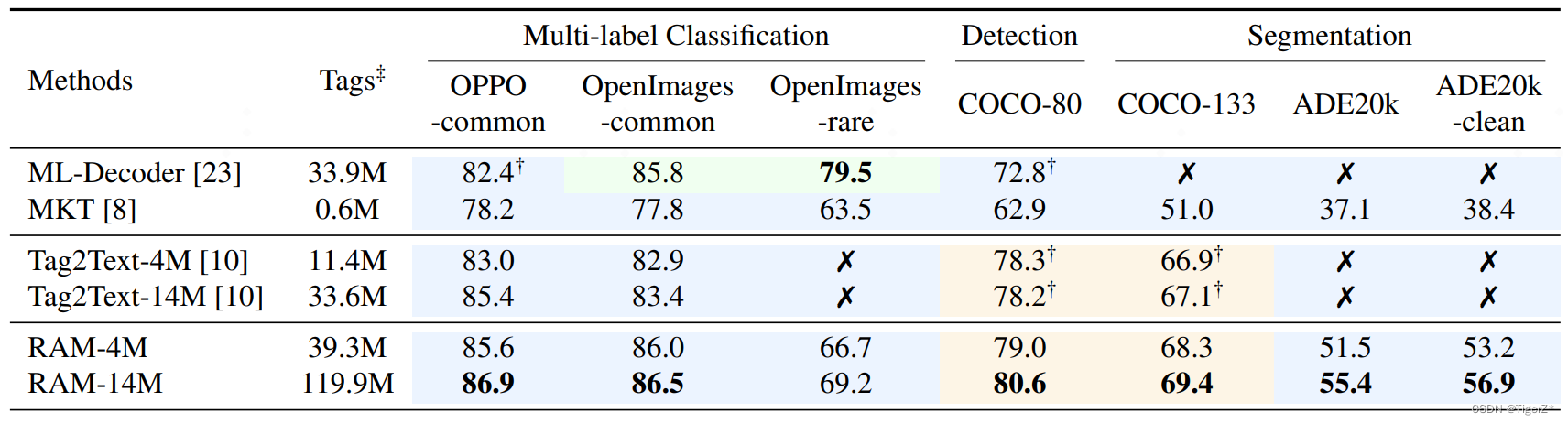

RAM(recognize anything)—— 论文详解

一、概述

1、是什么 RAM 论文全称 Recognize Anything: A Strong Image Tagging Model。区别于图像领域常见的分类、检测、分割,他是标记任务——即多标签分类任务(一张图片命中一个类别),区分于分类(一张图片命中一个…

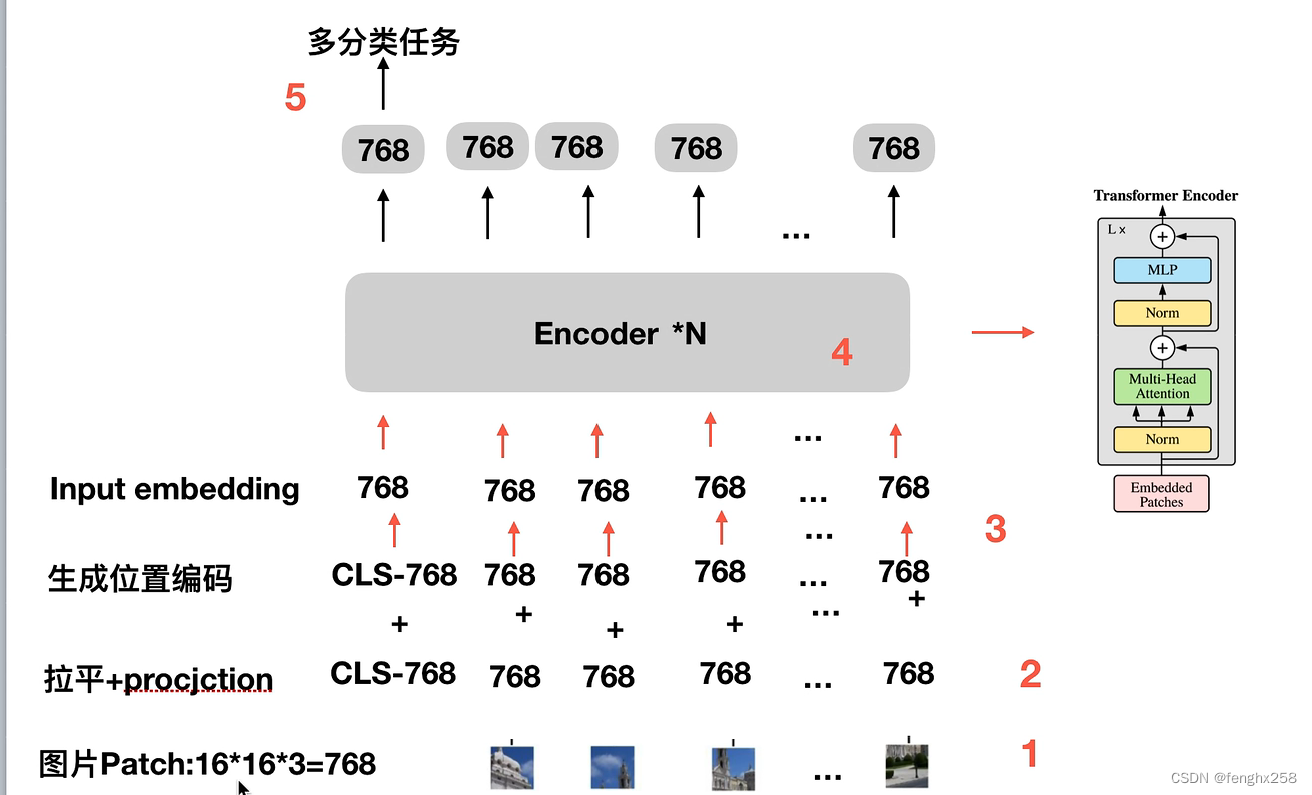

VIT(Vision Transformer)学习(一)- 基础模型理解

如果想了解细一点,可以直接照着第二个链接学习,第二个有哔哩哔哩和csdn,而且讲的更细

如果粗略了解,可以跟着第一个学习

VIT (Vision Transformer) 模型论文代码(源码)从零详细解读,看不懂来打我_哔哩哔哩_bilibili…

由浅到深 : Self-Attention (自注意力机制)

Self-Attention

看到下面的第一个saw是动词,第二个saw是名词。 因为第一个saw和第二个saw在形式上没有任何差别。如果任务是进行词性的判断,把上面的词直接输入给神经网络,那么它肯定不能够正确分析。 想要正确分析词性,那么该…

「解析」Attention机制

Attention函数的本质可以被描述为一个 Query 到 Key-Value对 的映射,这个映射的目的:为了给重要的部分分配更多的概率权重。

计算过程主要分为以下三步:

通过点乘、加法等其他办法计算 Q:query 和 每个K:key 之间的相似度 s i m ( Q , K i…